一种基于ROS的多传感器融合地图构建方法

李明明 张龙

摘 要:为研究移动机器人室内传统单激光雷达建图方法对环境中镂空物体存在的漏扫问题,采用一种多传感器数据融合的方法,在轮式移动机器人上集成激光雷达、深度相机、轮式里程计和IMU等传感器,使用机器人操作系统开源的深度图像转激光数据功能包对摄像头采集的深度图像数据进行二维转换,将转换后的数据与激光数据融合;由于轮式里程计实际使用时轮子会打滑漂移,影响建图效果,需要将轮式里程计和IMU数据融合进行位姿估计,搭配融合后的激光数据,共同传给建图算法完成建图。结果表明:优化后的融合算法使得室内移动机器人对镂空物体建图更加清楚,障碍物识别更加准确,机器人的绝对位姿误差约0.15 m。多传感器融合的建图方法有效提高了移动机器人在室内环境中识别镂空障碍物的能力和机器人运动精度,为后续移动机器人地图构建提供一定参考。

关键词:传感器融合;即时定位与建图;机器人操作系统;激光雷达;深度相机

中图分类号:TP 242.6 文献标志码:A

文章编号:1672-9315(2023)03-0613-09

DOI:10.13800/j.cnki.xakjdxxb.2023.0319开放科学(资源服务)标识码(OSID):

A multi-sensor fusion map construction method based on ROS

LI Mingming,ZHANG Long

(College of Communication and Information Engineering,Xian University of Science and Technology,Xian 710054,China)

Abstract:A multi-sensor data fusion method was adopted to investigate the problem of the traditional single lidar mapping method for mobile robots in indoor environment.In this method,sensors such as lidar,depth camera,wheeled odometer and IMU are integrated on the wheeled mobile robot.The depth image data collected by camera is converted into two dimensional image data by using the open source depth image to lidar data function pack of the robot operating system,and the converted data is fused with lidar data.Since the wheel odometer will slip and drift when it is actually used,which affects the effect of map construction,the wheel odometer and IMU data are fused for pose estimation,and the fused lidar data is sent to the map building algorithm to complete map construction.The results show that the optimized fusion algorithm makes the indoor mobile robot clearer in the hollow-out object mapping,more accurate in obstacle recognition,and more accurate in robot trajectory,and the absolute pose error of the robot is about 0.15 m,the multi-sensor fusion mapping method effectively improves the mobile robots ability to identify hollowed-out obstacles in indoor environment and the robots motion accuracy,which provides a certain reference for the subsequent mobile robot map construction.

Key words:sensor fusion;simultaneous localization and mapping;robot operating system;lidar;RGB-D camera

0 引 言

從20世纪的50,60年代开始,科学家开始对机器人技术进行研究。王天然院士指出,本世纪以来机器人的应用越来越广泛,对生产力的推动作用越来越突出,机器人领域的各项技术也在快速进步,发展形式多样化[1]。

工业级机器人大多是采用固定式机器人为主,在处理简单事件时有很高的效率,杨琨等在其研究中提出当前机器人自身的缺陷使其应用范围具有一定的局限性[2]。在对机器人进一步研究之后,李成进等也提出移动机器人存在的一些重要缺陷,由于它的分层结构设计,其分序需要很长的时间,导致反应速度变慢[3]。与此同时,由于机器人技术发展缓慢与周围环境复杂,其在执行任务中难免会遇到各种各样的问题。随着移动机器人技术迅速发展,其复杂多变的使用场景也越来越多,故提高移动机器人在面对未知环境时处理遇到的障碍物的能力显得尤为重要。TAHERI等在其研究中提出使用基于同时定位与建图(Simultaneous Localization and Mapping,SLAM)的静态地图构建方法,其作用是先控制机器人对周围静态环境感知,将周围的障碍物等信息扫描识别[4],然后标注到杨蕴秀等所构建的二维栅格地图里面[5],其好处是机器人在特定环境的场景中进行作业更加方便,可以提高后续路径规划与导航的效率。但由于机器人周围环境障碍物结构复杂,使用传统方法在室内建图经常会漏扫一些特征不明显,形状多样的障碍物,如桌椅等镂空障碍物。这些镂空障碍物体积较大,在室内环境中经常出现。同时,沈斯杰等在其研究中指出,传统激光雷达建图受制于激光雷达扫描单一平面的缺点,在扫到镂空障碍物时,识别的激光数据较少而无视此处的障碍物[6]。这样的错误显然是很致命的,因为如果建好的地图中未标出障碍物,而实际环境中存在障碍物,这对移动机器人后续的自动避障作业是很麻烦的。

因此,为了解决漏扫镂空障碍物的问题,文中在静态建图的条件下,给移动机器人安装多传感器,融合激光雷达数据和深度相机数据,弥补单激光雷达建图漏扫的缺点;为纠正轮式里程计实际使用时轮子打滑导致建图不准确的问题,将轮式里程计和惯性测量单元(Inertial Measurement Unit,IMU)融合提供位姿估计的定位数据,搭配融合后的激光数据,共同传给建图算法完成建图。利用本方法在固定障碍物的场景下能有效识别镂空障碍物,实现准确建图,帮助移动机器人完成之后的作业与任务。

1 开源建图算法

1.1 Gmapping算法原理

Gmapping[7]算法是一种基于粒子滤波(Rao Blackwellized Particle Filter,RBPF)[8]框架的开源算法,能够即时构建周围环境的栅格地图,在小场景内具有计算量小,精度高的优点。其对RBPF算法进行了提议分布改进,主要是将里程计数据同激光数据联合起来提议,校准后的提议分布与真实分布更为相似。因此,将二者联合起来,则RBPF算法[9]改进提议分布见式(1)。

p(x1∶t,|z1∶t,u1∶t-1)=p(m|x1∶t,z1∶t)·

p(x1∶t|z1∶t,u1∶t-1)(1)

式中 x1∶t为位姿信息;m为地图信息;u1∶t-1为里程计数据;z1∶t为观测数据。使用最近一次观测数据改进后,提议分布见式(2)。

粒子权重ω(i)t递推见式(3)。

最后对权重粒子进行改进提议分布计算。

通常目标分布是机器人在t时刻位置的真实分布,只能使用提议分布来描述该分布。由于改进的提议分布发现激光具有单峰值特性,在其附近采样就能减少其他噪声的数据[10]。因此,在激光峰值附近采集K个样本数据后,结合高斯函数模拟提议分布。模拟好提议分布后就可以获取其位姿信息,再结合激光信息構建局部地图信息,最后生成二维栅格地图。

在实际环境中,单激光雷达建图的鲁棒性较差,地图噪声较多,与实际场景中的障碍物位置情况不符合。激光雷达建立的二维栅格地图,更重要的应用是为了移动机器人在建好的地图中自主移动并且提高它在静态环境中的避障成功率。

1.2 Cartographer算法原理

基于粒子滤波算法的SLAM的局限性就在于滤波所用的粒子在经过一次计算后就会被丢弃,下次计算再次重新选取粒子,导致SLAM的计算效率低下。THRUN等针对此问题,在2006年提出了Graph-SLAM(图优化),试图将激光雷达或摄像头采集到的数据以位姿变化的方式呈现,并将稠密点云稀疏化以降低计算消耗,根据位姿间的约束关系绘制工作环境地图,并最终将定位问题通过降维方法简化为最小二乘问题[11]。

从图1可以看出,图优化问题可以用图的方式表示,节点P是需要优化的变量,边是优化变量之间的约束。X节点可以是位姿,也可以是路标;边可以是位姿之间的关系也可以是观测量;图优化是把位姿和空间点一起,进行优化。随着轨迹增多,特征点的增长也很快。因此位姿图优化的意义是再优化几次以后将特征点固定住不再优化,只当作位姿估计的约束,之后主要优化位姿。

Google基于机器人操作系统(Robot Operating System,ROS)开源Cartographer算法就是基于图优化方式进行建图的[12]。优点在于基于图优化的方法,在建图中加入了回环检测与闭环纠正改进,能够很好地完善全局建图[13],对于室内镂空障碍物建图具有很好的校正作用。缺点是对计算机硬件性能要求较高,低配平台会降低回环与闭环的运行效率。

在实际仿真与建图中,基于图优化的算法相比于粒子滤波算法,由于加入了闭环检测和回环纠正,得到的地图更加完整清楚。后将会在实验部分进行具体的建图效果对比。

2 传感器原理

2.1 单线激光雷达

目前,多线激光雷达价格昂贵,均在万元级别以上,一般企业难以承受如此高昂的价格。相比来说,单线激光雷达[14]成本就低得多,可以帮助机器人规避障碍物,扫描速度快、分辨率强、可靠性高。相比多线激光雷达,单线激光雷达在角频率及灵敏度上反应更快捷,所以,在测试周围障碍物的距离和精度上更加精准。但单线雷达只能平面式扫描,不能测量物体高度,由于激光数据的特性导致它需要大量的扫描数据,所建地图无法进行大范围闭环检测[15]。

研究使用的杉川3irobotix Delta 3A激光雷达是一种三角测距原理的单线激光雷达,原理和TOF激光雷达不同。TOF激光雷达[16]是根据测量光的飞行时间来计算距离的,而三角测距激光雷达是通过摄像头的光斑成像位置来解三角形的。

从图2可以看出,O1是激光发射器,射出去的激光由虚线表示,A,B,C是3个反射点。O2是摄像头光心轴,三角形代表用来捕捉反射光斑的相机模型。A,B,C的成像点分别是A′,B′,C′。由于激光发射器和相机安装的相对位置是已知的,也就是说相机的光心轴和激光(线)的角度已知,线段O1到O2长度已知,角(O1,O2,A)也已知,根据角边角定理,三角形有唯一解,于是(O1,A)的长度是可以算出来的。同理B,C这2点距离O1的距离也是可解的。这样就获取到了障碍物到激光雷达点的测量距离。

在ROS系统中,将激光雷达数据封装为sensor_msg/LaserScan的自定义雷达专用消息包,方便各个厂家在制作自己的激光雷达时,能够有统一的格式。

2.2 深度相机数据转激光数据原理

由于激光雷达价格不菲,而摄像头价格相对便宜。使用ROS官网开源的depthimage_to_laserscan功能包能够将深度摄像头和多线程激光雷达采集的三维图像信息转换为单线激光雷达的二维点云信息,并且发布/scan话题消息供建图算法使用[17]。该方法存在的问题是,雷达数据是二维的、平面的,深度图像数据是三维的,如果将三维的数据转换成二维数据,只需要取深度图的某一层即可。由于摄像头对光线感知较为明显,在室内环境下,可以对摄像头采集到的图像进行处理,将障碍物的缺陷点提取出来再转换,可以减小转换计算量。因此,深度相机较之于激光雷达无论是检测范围还是精度都有不小的差距。

如图3所示,其主要转换步骤如下。

步骤1:将深度图像的点p(u,v,z)转换到深度相机坐标下的点P(x,y,z)。

步骤2:计算夹角AOC见式(4)。

θ=atan(x/y)(4)

步骤3:将AOC角投影到对应的激光数据槽中,已知激光的范围[α,β],激光束细分为N份,则可用laser[n]表示激光数据。点P投影到数组laser中的索引值n,见式(5)。

laser[n]的值为P在x轴上投影点C到相机光心O的距离r,见式(6)。

2.3 惯性测量单元

IMU传感器[18]是加速度计和陀螺仪传感器的组合。它被用来检测加速度和角速度以表示运动速度和运动强度。陀螺仪是用于测量或维护方位和角速度的设备。它是一个旋转的轮子或圆盘,其中旋转轴可以不受影响地设定在任何方向。当旋转发生时,根据角动量守恒定律,该轴的方向不受支架倾斜或旋转的影响。

实验平台所使用的是MPU6050传感器[19],它是一个6轴运动处理传感器,集成了3轴MEMS陀螺仪,3轴MEMS加速度计以及一个可扩展的数字运动处理器(Digital Motion Processor,DMP),可用I2C接口连接一个第三方的数字传感器,比如磁力计。扩展之后就可以通过其I2C接口输出一个6轴信号。DMP通过调用函数对获取的数据进行四元数求解,即可得到所需姿态角。MPU6050对陀螺仪和加速度计分别用了3个16位ADC,将其测量的模拟量转化为可输出的数字量。为了精确跟踪快速和慢速的运动,传感器的测量范围都是用户可控的。

2.4 轮式里程计

机器人可以基于码盘数据和底盘运动学模型进行航迹推演,从而得到机器人的轨迹。对于移动机器人来说,假定机器人的初始位置已知,在一个行驶维度为一维的环境,机器人可以根据轮子的圈数实时估计自己在这个一维行驶环境的何处。在二维平面情况下,通过左右轮的转速测量单元可以推知左右轮的转圈数,显然,当左右轮的转圈数不同时,移动机器人会向左或者向右转。

目前的差分两轮轮式里程计[20]普遍使用的是光电码盘,经过光电管后,每次码盘转动都会产生一次脉冲,微控制单元(Microcontroller Unit,MCU)可以通过中断记录2次脉冲之间的时间t,已知这个时间,已知2个码盘间的距离,就可以算出来这段时间的真实速度。实际使用中,轮式里程计的轮子容易受环境因素影响出现打滑和漂移的问题,出现累计误差增大从而影响定位效果。

3 激光与摄像头融合建图方法

3.1 激光雷达数据与深度相机数据融合

基于激光雷达与深度相机各自建图的优缺点,文中提出激光雷达与深度相机融合建图方法,通过均值滤波算法将二者优势结合互补,能够很大地优化移动机器人在实际环境中的建图效果,使得其扫描到的障碍物信息更加完善,建立完整的可用于导航的静态二维栅格地图。

目前,二者融合的方案有许多,大致分为2种。一种是[21]在采集前端直接对传感器数据融合,主要对传感器中的障碍物信息加以滤波,选取确定的障碍物信息。这種方法能够将2个传感器识别的障碍物都储存起来,与融合前的相比,可识别的障碍物信息增加。

另一种方法[22]是在采集后端对SLAM生成的局部地图数据进行融合。这种方法需要反复对同一场景进行移动建图才能达到比较好的效果,比较繁杂。

文中采用前端传感器数据融合方法。由于深度相机输出的是三维深度数据;最后建图算法需要的是二维激光数据,因此,融合算法首先利用ROS官网的三维深度相机数据转二维激光数据功能包,将三维深度相机数据转成二维激光数据,然后再利用均值滤波算法[23]进行激光和相机数据融合。均值滤波融合算法描述如下。

1)分别选取激光与相机的初始激光帧。

Li={xi|x>0,i∈N*}

Ci={yi|y>0,i∈N*}(7)

式中 Li和Ci分别为获取的激光数据;xi和yi为该点角度上的距离值。

2)对激光与相机数据融合,若选取范围内的激光雷达数据中存在无效值,则替换为该处相机对应的值;若该处激光雷达存在有效值,则对比该处激光与相机有效值的误差,大于阈值则替换为该处相机对应的有效值。

3)检查最后固定范围内的激光数据,并作为新的激光帧进行发布。

通过把二者激光帧的障碍物信息通过均值滤波算法融合,所产生的新激光数据中就拥有周围环境真实的障碍物信息。

3.2 轮式里程计与IMU数据融合

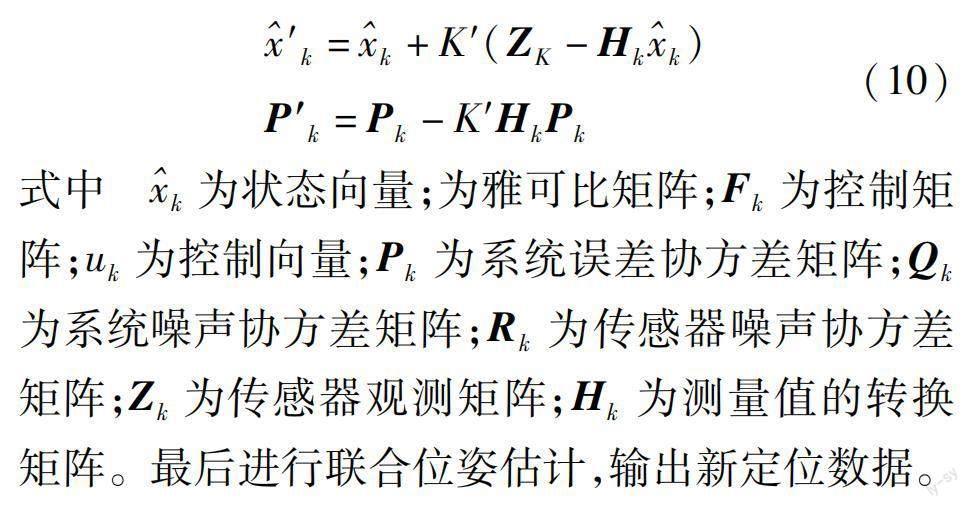

为了获得更准确的建图效果,需要将里程计和IMU通过扩展卡尔曼滤波[24]融合输出定位[25]信息,融合过程如下。

1)构建系统预测模型,初始化传感器状态矩阵与误差协方差矩阵。

2)然后获取传感器数据和对应的协方差矩阵,并计算系统的卡尔曼增益K′。

K′=PkHTk(HkPkHTk+Rk)-1(9)

3)更新系统状态矩阵和误差协方差矩阵,完成迭代,并输出融合后的位姿估计信息。

式中k为状态向量;为雅可比矩阵;Fk为控制矩阵;uk为控制向量;Pk为系统误差协方差矩阵;Qk为系统噪声协方差矩阵;Rk为传感器噪声协方差矩阵;Zk为传感器观测矩阵;Hk为测量值的转换矩阵。最后进行联合位姿估计,输出新定位数据。

激光通过图2方式采集周围平面中的障碍物信息,深度相机通过采集三维环境中的障碍物数据,并通过式(6)将深度图像三维投影转换为二维激光数据,然后通过式(7)均值滤波算法将二者所采集数据融合,输出包含二者障碍物信息的新激光数据,最后结合里程计与IMU传感器通过式(10)融合定位数据,与第1章的Gmapping或Cartographer开源SLAM算法,构建完整的二维栅格地图。多传感器融合框架如图4所示。

4 融合建图实验

实验搭建的实物平台如图5所示,为长0.42 m,宽0.42 m,高0.88 m的轮式机器人,图中标注出各个传感器相对位置,图5(b)为机器人硬件框架图。机器人使用的主要传感器有杉川3irobotix Delta 3A激光雷达、乐视Letv Pro Xtion体感摄像头和轮式里程计,工控机使用英特尔酷睿i7-4500U中央处理器,拥有1.80 GHz主频,8 GB内存的工业控制机,下位机使用意法半导体STM32F407VG底层控制板,移动底盘采用轮式差速电机底盘。上位机使用基于Ubuntu16.04的ROS-kinetic的机器人操作系统,使用C++语言编写融合代码,在室内条件下进行实验。

由于激光雷达与深度摄像头分别建图时,其采集到的激光数据处在不同图层,在不做任何处理时,建图算法只能接收到频率高的激光数据。因此,该方法对二者的激光数据进行C++代码重构,使用时间同步函数同时订阅二者/scan话题,使用回调函数对二者/scan话题数据进行处理并发布一个新的/scan话题。新话题成功解决了二者建图数据不在同一图层的问题,在实验中也取得了良好的建图效果。

图6为Gazebo仿真环境,有2块镂空桌子分别用A、B表示镂空障碍物。融合前后对比如图7所示,图7(a)、图7(b)是Gmapping建图算法使用数据融合前后对比建图,图中的红框处并不能识别出镂空障碍物;融合深度相机后,能识别出仿真环境中的障碍物A、B。图7(c)、图7(d)是Cartographer算法融合深度相机前后的对比图,之前识别不出来的桌子障碍物,在融合深度相机后,二者均能识别出镂空障碍物A,B的具体位置。

图8为移动平台真实室内环境,室内场景为7.6 m×3.8 m(长×宽),有2张0.48 m×0.41 m×0.76 m(长×宽×高)的镂空椅子充当镂空障碍物。融合前后的机器人建图如图9所示,图9为二维栅格地图俯视图,地图分辨率为0.05 m,图9(a)、图9(c)是未融合的2种算法建图,图中红色方框并不能识别机器人前方的镂空障碍物,且圆形红框也显示出2种算法都有不同程度的漫反射现象;图9(b)、图9(d)是融合深度相机后的2种算法建图,之前识别不出来的椅子障碍物,也能成功识别出来,并标识出镂空障碍物A、B的具体位置。深度相機采集的是环境深度信息,由于移动机器人尺寸较高,讲台高0.22 m,激光雷达距地0.28 m,相机距地面0.88 m,激光雷达只能识别同位置水平平面的物体,深度相机对不在同一平面的特征点识别较少,且物体特征点集中,与物体颜色关系不大,因此其主要特征点在镂空障碍物上,所以未识别出特征点单一的讲台。圆形红框处的激光雷达漫反射也得到改善,建图更加准确,达到了该方法识别镂空障碍物的目的,提高了对周围镂空障碍物的识别能力。

移动平台的建图精度可以转换为其在环境中运动轨迹的精度测试。平台在室内环境下的建图移动轨迹对比如图10(a)所示,为数据融合前后移动平台运动轨迹对比图;从图10(b)可以看出,数据融合后的移动机器人运动轨迹优于融合之前,室内环境下融合前比融合后平均存在15 cm左右的轨迹误差,且融合后的轨迹更加平滑和稳定,表明了数据融合后的地图更符合真实环境,从而验证了融合方法的有效性。

5 结 论

1)通过仿真实验验证,相比于单激光扫描,数据融合方法能够在仿真环境下识别桌子等镂空障碍物,在建立的二维栅格地图中有清晰的障碍物轮廓,边缘平滑,建图鲁棒性有明显改善。

2)在真实环境中,通过深度相机和激光雷达的数据融合方式,成功解决了传统单激光雷达室内环境建图漏扫镂空障碍物的问题。多传感器融合的移动机器人实验平台,能够在真实环境中进行更加准确的定位,更好地识别周围环境障碍物,也互补了不同传感器之间的优点。

3)优化后的融合算法相比于单激光雷达SLAM,机器人运动轨迹更准确,障碍物识别精度明显改善,可以为后续移动机器人自主导航与避障提供一定参考。

4)目前随着传感器性能的发展和SLAM系统实时性的要求,使用神经网络等融合算法也在SLAM未来发展中有了一定的尝试。

参考文献(References):

[1] 王天然.机器人技术的发展[J].机器人,2017,39(4):385-386.

WANG Tianran.Development of robot technology[J].Robot,2017,39(4):385-386.

[2]杨琨,夏信凯,马环洲,等.工业机器人主动安全控制技术研究现状与展望[J].机器人技术与应用,2021,201(3):9-19.

YANG Kun,XIA Xinkai,MA Huanzhou,et al.Research status and prospect of industrial robot active safety control technology[J].Robot Technique and Application,2021,201(3):9-19.

[3]李成进,王芳.智能移动机器人导航控制技术综述[J].导航定位与授时,2016,3(5):22-26.

LI Chengjin,WANG Fang.Review of navigation control technology of intelligent mobile robot[J].Navigation Positioning and Timing,2016,3(5):22-26.

[4]TAHERI H,ZHAO C X.SLAM;Definition and evolution[J/OL].Engineering Applications of Artificial Intelligence,97,104032.Https://doi.org/10.1016/j.engappai.2020.104032.

[5]杨蕴秀,韩宝玲,罗霄.移动机器人同时定位与建图室内导航地图研究[J].科学技术与工程,2021,21(18):7597-7603.

YANG Yunxiu,HAN Baoling,LUO Xiao.Research on simultaneous localization and mapping of indoor navigation map for mobile robot[J].Science Technology and Engineering,2021,21(18):7597-7603.

[6]沈斯杰,田昕,魏国亮,等.基于2D激光雷达的SLAM算法研究综述[J].计算机技术与发展,2022,32(1):13-18,46.

SHEN Sijie,TIAN Xin,WEI Guoliang,et al.Review of SLAM algorithm based on 2D lidar[J].Computer Technology and Development,2022,32(1):13-18,46.

[7]MONTEMERLO M,THRUN S.Simultaneous localization and mapping with unknown data association using FastSLAM[C]//IEEE International Conference on Robotics and Automation.TaiPei,Taiwan,Sep.14-19,2003:1985-1991.

[8]LUO Y,SU Q,ZHANG Y,et al.Improved rao-blackwellized H∞ filter based mobile robot SLAM[J].The Jounnal of China Universities of Postsand Telecommunications,2016,23(5):47-55.

[9]孙弋,张笑笑.结合退火优化和遗传重采样的RBPF算法[J].西安科技大學学报,2020,40(2):349-355.

SUN Yi,ZHANG Xiaoxiao.RBPF algorithm combining annealing optimization and genetic resampling[J].Journal of Xian University of Science and Technology,2020,40(2):349-355.

[10]王险峰,邱祖泽,丁子琳,等.基于改进RBPF算法的轮式机器人SLAM导航系统设计[J].计算机测量与控制,2022,30(4):172-176.

WANG Xianfeng,QIU Zuze,DING Zilin,et al.Design of wheeled robot SLAM navigation system based on improved RBPF algorithm[J].Computer Measurement & Control,2022,30(4):172-176.

[11]THRUN S,MONTEMERLO M.The graph SLAM algorithm with applications to large-scale mapping of urban structures[J].International Journal of Robotics Research,2006,25(5-6):403-429.

[12]HESS W,KOHLER D,RAPP H,et al.Real-time loop closure in 2D lidar SLAM[C]//IEEE Internationl Conference on Robotics and Automation.Stockholm,Sweden,May.16-21,2016:1271-1278.

[13]张亮,刘智宇,曹晶瑛,等.扫地机器人增强位姿融合的Cartographer算法及系统实现[J].软件学报,2020,31(9):2678-2690.

ZHANG Liang,LIU Zhiyu,CAO Jingying,et al.Cartographer algorithm and system implementation based on enhanced pose fusion of sweeping robot[J].Journal of Software,2020,31(9):2678-2690.

[14]师瑞卓,张小俊,孙凌宇,等.基于单线激光雷达的三维形貌重建方法研究[J].激光与红外,2022,52(2):188-195.

SHI Ruizhuo,ZHANG Xiaojun,SUN Lingyu,et al.Research on 3D shape reconstruction method based on single-line lidar[J].Laser & Infrared,2022,52(2):188-195.

[15]尹磊,彭建盛,江国来,等.低成本激光和视觉相结合的同步定位与建图研究[J].集成技术,2019,8(2):11-22.

YIN Lei,PENG Jiansheng,JIANG Guolai,et al.Research on simultaneous localization and mapping fusion with low-cost laser sensor and vision[J].Journal of Integration Technology,2019,8(2):11-22.

[16]赵捷,赵野,童纪昀,等.一种用于TOF激光雷达的多通道时数转换芯片设计[J].半导体光电,2021,42(3):342-347.

ZHAO Jie,ZHAO Ye,TONG Jiyun,et al.A design of multi-channel time-to-digital converter for TOF lidar[J].Semiconductor Optoelectronics,2021,42(3):342-347.

[17]KAMARUDIN K,MAMDUH S M,SHAKAFF A Y M,et al.Method to convert Kinects 3D depth data to a 2D map for indoor SLAM[C]//IEEE 9th International Colloquium on Signal Processing and Its Applications.Kuala Lumpur,Malaysia,Mac.8-10,2013:247-251.

[18]姚星,李海英.基于微惯性测量单元的矿用定向钻孔轨迹绘制[J].传感器与微系统,2022,41(8):112-115.

YAO Xing,LI Haiying.Directional drilling track drawing for mine based on micro inertial measurement unit[J].Transducer and Microsystem Technologies,2022,41(8):112-115.

[19]卓从彬,杨龙频,周林,等.基于MPU6050加速度传感器的跌倒检测与报警系统设计[J].电子器件,2015,38(4):821-825.

ZHUO Congbin,YANG Longpin,ZHOU Lin,et al.Design of fall detection system based on MPU6050 acceleration transducer[J].Chinese Journal of Electron Devices,2015,38(4):821-825.

[20]张书亮,谭向全,吴清文.基于多传感器融合技术的室内移动机器人定位研究[J].传感器与微系统,2021,40(8):53-56.

ZHANG Shuliang,TAN Xiangquan,WU Qingwen.Indoor mobile robot localization based on multi-sensor fusion technology[J].Transducer and Microsystem Technologies,2021,40(8):53-56.

[21]陈凯.基于多传感器融合的同时定位和地图构建研究[D].淮南:安徽理工大学,2021.

CHEN Kai.Research on simultaneous localization and map construction based on multi-sensor fusion[D].Huainan:Anhui University of Science and Technology,2021.

[22]張粤.基于激光和深度相机的移动机器人建图导航与定位的研究和实现[D].广州:华南理工大学,2020.

ZHANG Yue.Research and implementation of mapping navigation and positioning of mobile robot based on laser and RGB-D camera[D].Guangzhou:South China University of Technology,2020.

[23]NAIR P,CHAUDHURY K N.Fast high-dimensional bilateral and nonlocal means filtering[J].IEEE Transactions on Image Processing,2019,28(3):1470-1481.

[24]高沛林,高赟.移动机器人多信标SLAM技术[J].西安科技大学学报,2019,39(5):905-911.

GAO Peilin,GAO Yun.SLAM navigation of mobilerobots based on multi-beacons[J].Journal of Xian University of Science and Technology,2019,39(5):905-911.

[25]薛旭升,张旭辉,毛清华,等.基于双目视觉的掘进机器人定位定向方法研究[J].西安科技大学学报,2020,40(5):781-789.

XUE Xusheng,ZHANG Xuhui,MAO Qinghua,et al.Localization and orientation method of roadheader robot based on binocular vision[J].Journal of Xian University of Science and Technology,2020,40(5):781-789.

(责任编辑:刘洁)