无人地面车辆感知技术综述

李 飞 呼 斌 孔祥辉 段芳芳

(西安电子工程研究所 西安 710100)

0 引言

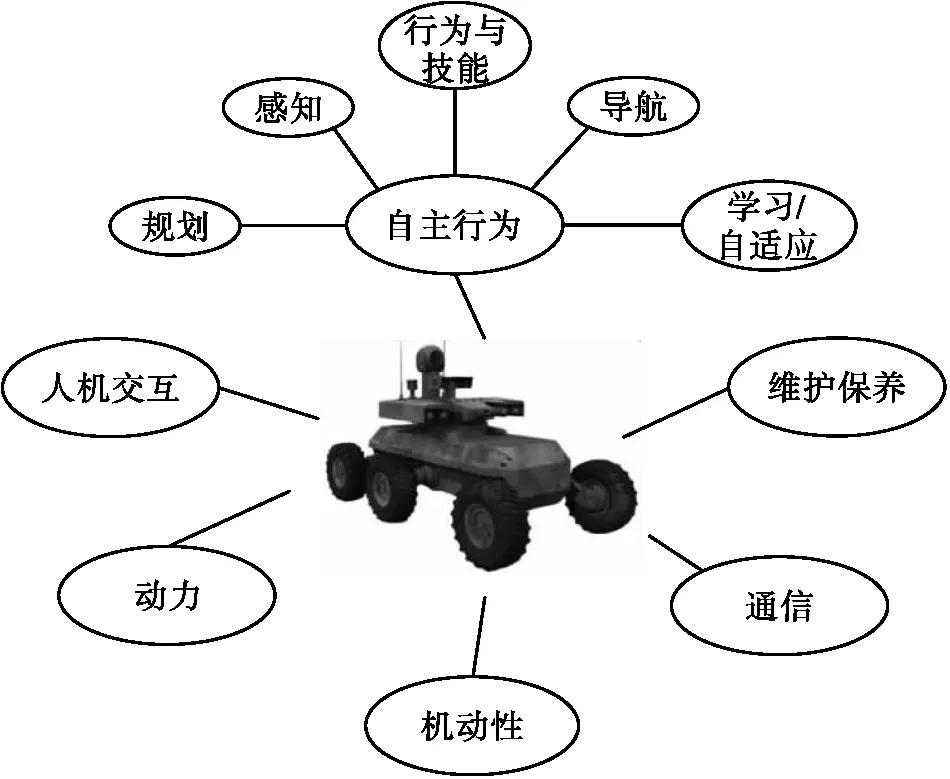

在现代战争中,陆军从以重装甲、强火力为特征的军事力量向更轻便、反应更迅速、具有高杀伤力与高生存性的目标部队转型,具有实用性的无人地面车辆系统的发展成为未来的趋势[1-2]。与空中无人飞行器(UAV)相比,无人地面车辆(UGV)的运行环境则要复杂得多,在技术发展和系统集成等方面所面临的挑战也将是巨大的。无人地面车辆感知系统涉及广泛的技术领域,如图1所示。

图1 UGV研究所涉及的技术领域

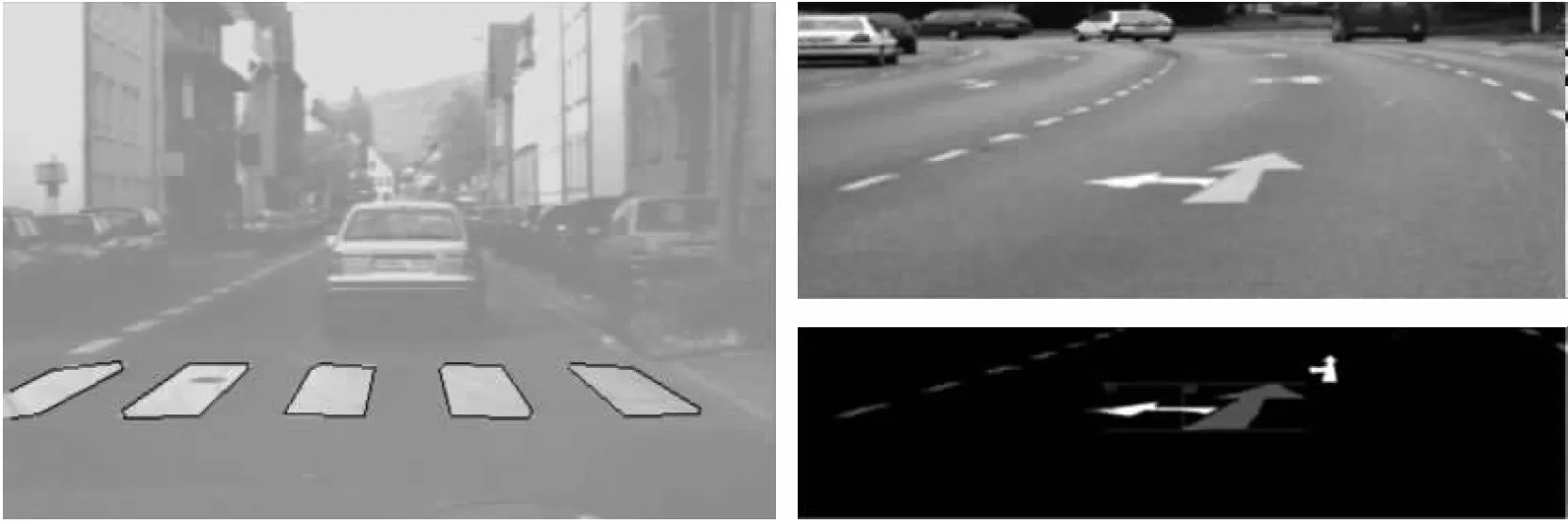

图2 被检测出的路面指示标志

1 无人平台任务管理

军用无人平台可以执行侦察、监视乃至作战任务,是一种用途非常广泛的武器系统。由此,美国有关部门根据未来的军事战略构想,针对军事专家就无人平台的使用范围及其优先顺序开展了调查研究,其结果如表1所示。

表1 各种无人平台的使用范围和优先顺序

由表1可以看出:UGV的任务范围涵盖了所有重大军事领域,但主要任务被认为是“侦察”。美国军事专家认为无人平台执行侵入敌方领域执行情报搜集任务是最有发展前途的。

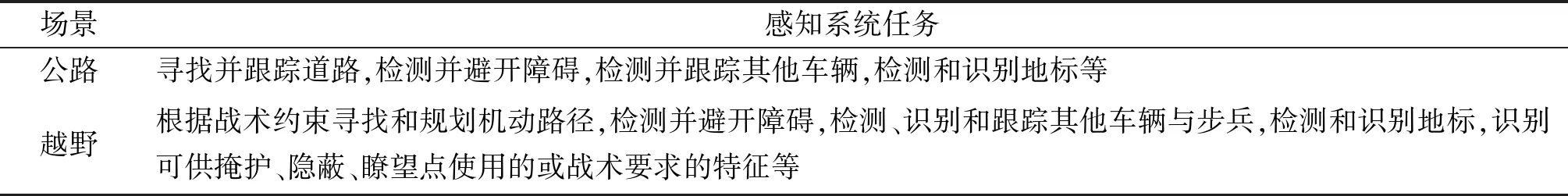

由于地貌、地形和人工的影响,UGV工作在一个极为复杂的环境中。未来作战系统UGV很可能运行在任何气候条件下(雨天、雾天及雪天等),不分昼夜,有沙尘或其他干扰战场的因素存在,也要与友军配合对抗敌军。表2总结了UGV在公路和越野场景中行驶时感知系统的任务,可以看到,由于野外环境的复杂性,感知系统的任务要比公路行驶时要繁重得多。

表2 感知任务表

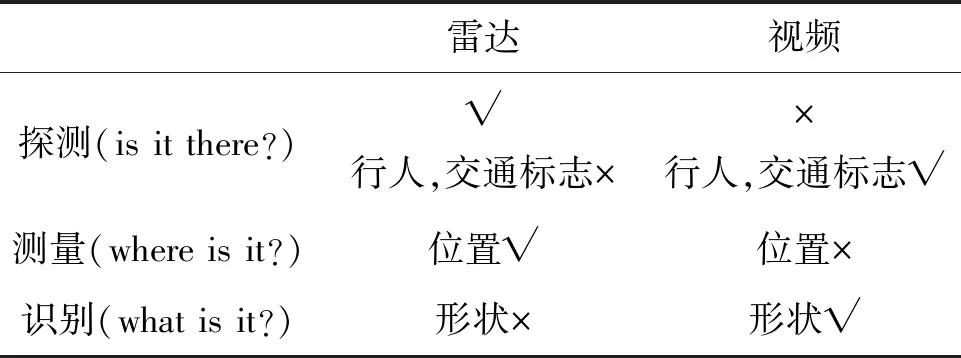

表3 毫米波雷达和视频传感器性能对比

UGV在行驶中可能会面临各种不同的地形和植被(沙漠、林地、灌木丛、草地、公路和城市等);需要避开各种类型和大小的正障碍(岩石、倒了的树、倒塌的砖墙和过于陡峭的坡等)和负障碍(壕沟和沼泽地等);并且还可能遇到有战术意义的其他特征(森林边界和山脊等)。当UGV沿公路行驶时,需要检测道路特征;而越野行驶时,则需检测符合战术约束(隐蔽、可通过)的机动通道特征。UGV还需要检测、分类和定位各种自然和人造特征(作为地标),以便精确确定自身位置和规划战术路径。

2 无人地面车场景感知技术发展现状

2.1 单传感器场景感知

2.1.1 道路和障碍检测

对于公路环境,在结构化的开阔道路(例如,已知宽度和转弯半径等几何特征的干道和高速公路,车道标记明显,有确定的边缘)上的车道检测已经有了相当多的研究。通常是将事先已知的关于道路几何特征和其他性质的知识与通过感知系统检测到的特征(例如,车道标记,路边)相结合,用以确定车道和其中车辆的位置。用于车道检测和跟踪的传感器包括立体[3]和单目[4]彩色摄像机,还有在夜间和能见度有限情况下使用的前视红外雷达(Forward Looking Infrared Radar,FLIR)。与结构化的开阔道路不同,城市环境中的车辆、行人或建筑物等很有可能遮断开阔道路环境中用于确定车道的很多线索。Franke等人[5]通过检测车道线、路边、停车线、人行横道线、交通标志牌等,进行车道检测和跟踪。

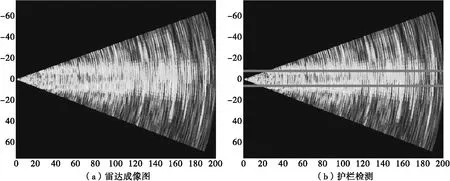

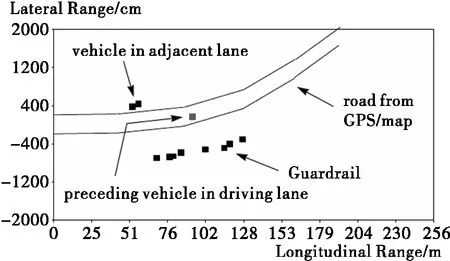

对于大多数的道路,由于道路边缘存在护栏,防护障,绿化带等具有强雷达回波的物体。因此,可以根据这些物体的回波来检测道路边缘。图3所示为道路边缘的场景成像效果图:图3(a)所示为在具有护栏的道路场景下雷达的成像结果。从中可以看出有两串明显的强回波点,就是护栏所成的像。在进行护栏检测时,可以参考在视觉系统中道路边缘检测的方法,使用霍夫变换寻找图中的两条最明显的直线,图3(b)所示。

图3 道路边缘的场景成像效果图

图4 基于HSI彩色空间的道路检测

图5 立体视觉检测障碍物

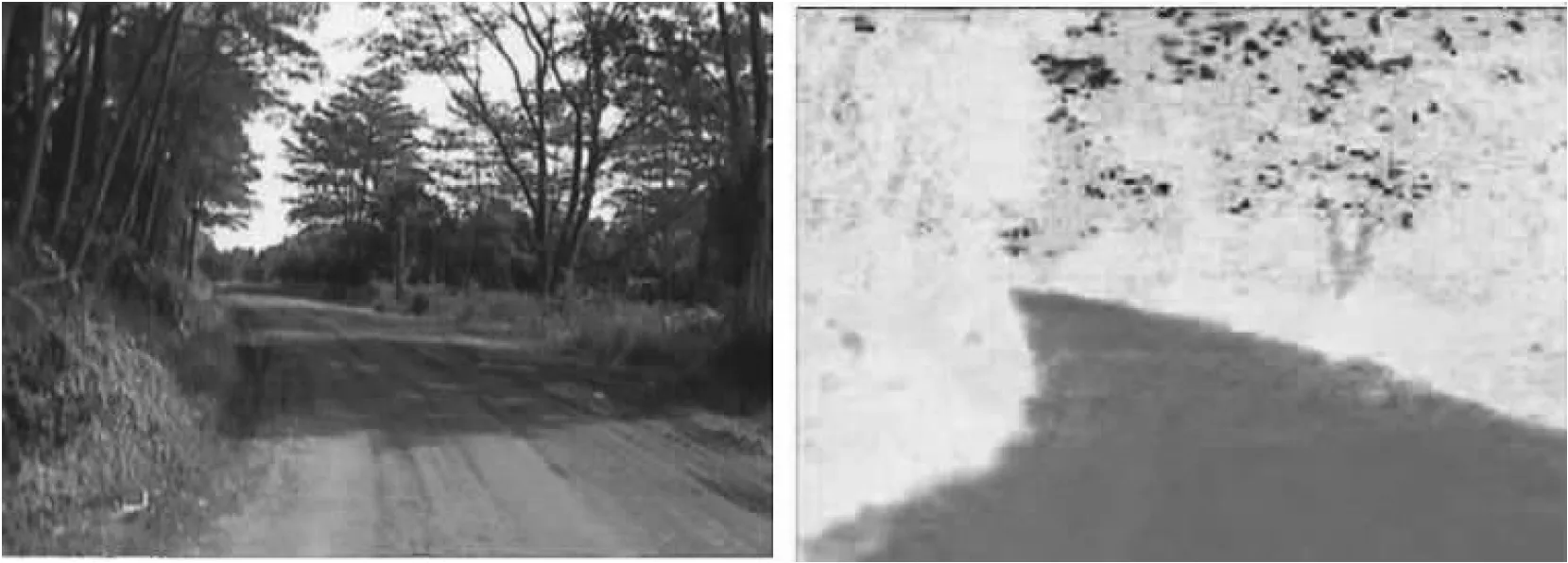

而对于越野环境,Chaturvedi等人[6]用贝叶斯分类器将路段从彩色图像背景中分割出来。他们的研究主要针对由红色泥土道路和绿色植被构成的场景,并在二者区分度较好的HSI(色相,饱和度和亮度)彩色空间展开。虽然此算法受到红色道路的限制,但它表明彩色分割可用于非结构化道路的检测和跟踪。

对于障碍检测,Williamson[7]在结构化道路上开展了对静态正障碍的研究,他搭建的三相机立体视觉系统能够检测位于110m处的高度为14cm的物体。在非结构化道路上检测障碍的研究还很少,事实上,坡度的突变往往会导致障碍检测算法的虚警。路上障碍检测的很多技术都采用摄像机作为传感器。尽管通过采用外部照明,它们也可用于夜间,但在雾天、烟雾及其他能见度受限情况下效果则不佳。采用FLIR和LIDAR传感器可提高系统在夜晚和有限能见度时的性能,但价格昂贵,LIDAR还受到作用距离的限制。

通过雷达对真实场景的大量实地观测表明,可以通过回波特征进行陷阱识别。陷阱识别可以采用特征匹配的方法,陷阱的特征包括:一是陷阱后壁有较强回波;二是陷阱区域内的地杂波较弱。根据陷阱的特征,选择距离上前弱后强的模板进行匹配,可以有效提取陷阱的后壁位置,最后在雷达原始成像图中提取陷阱,图6为陷阱检测提取的陷阱检测效果图。

图6 陷阱检测效果图

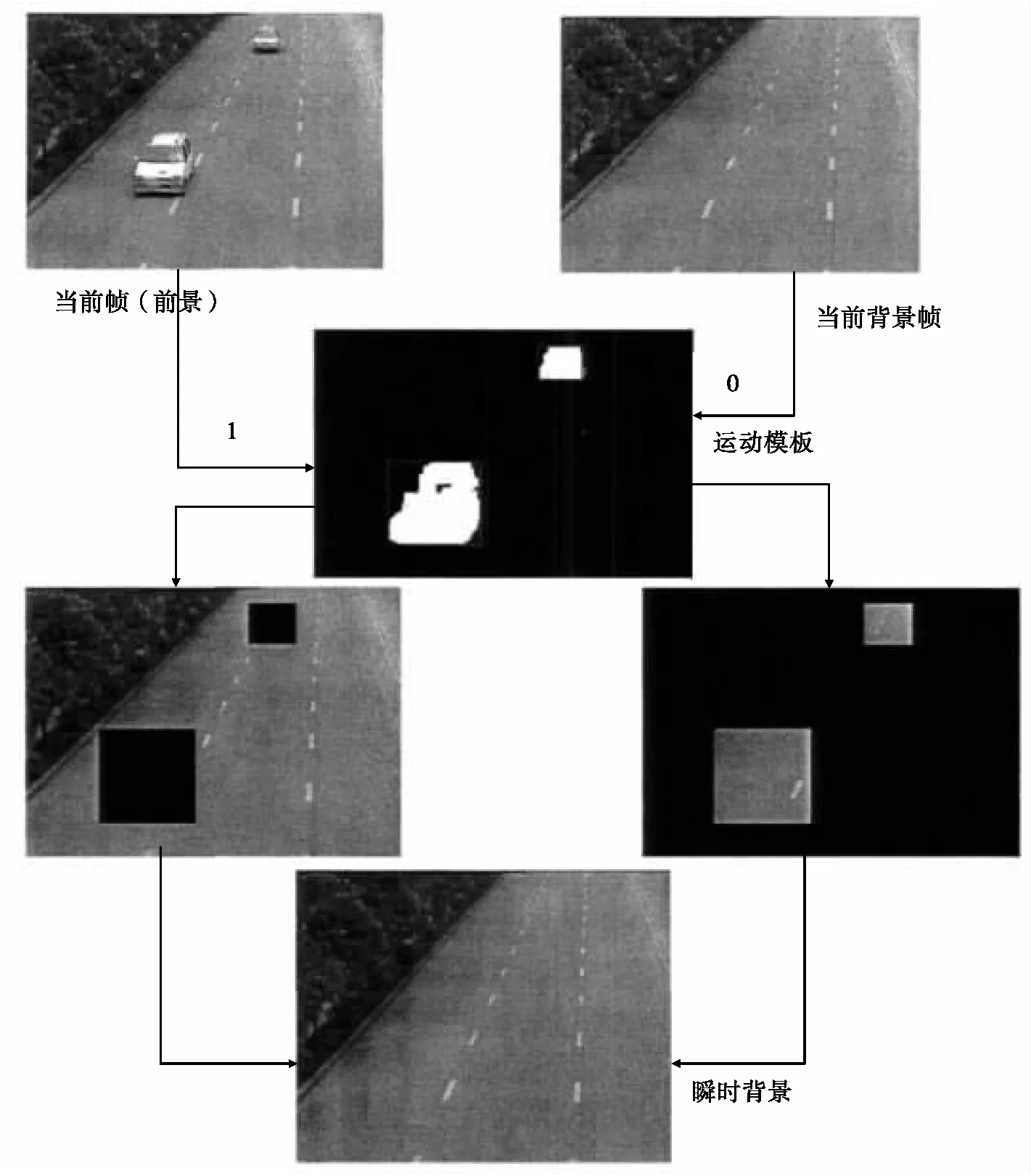

图7 背景差法示意图

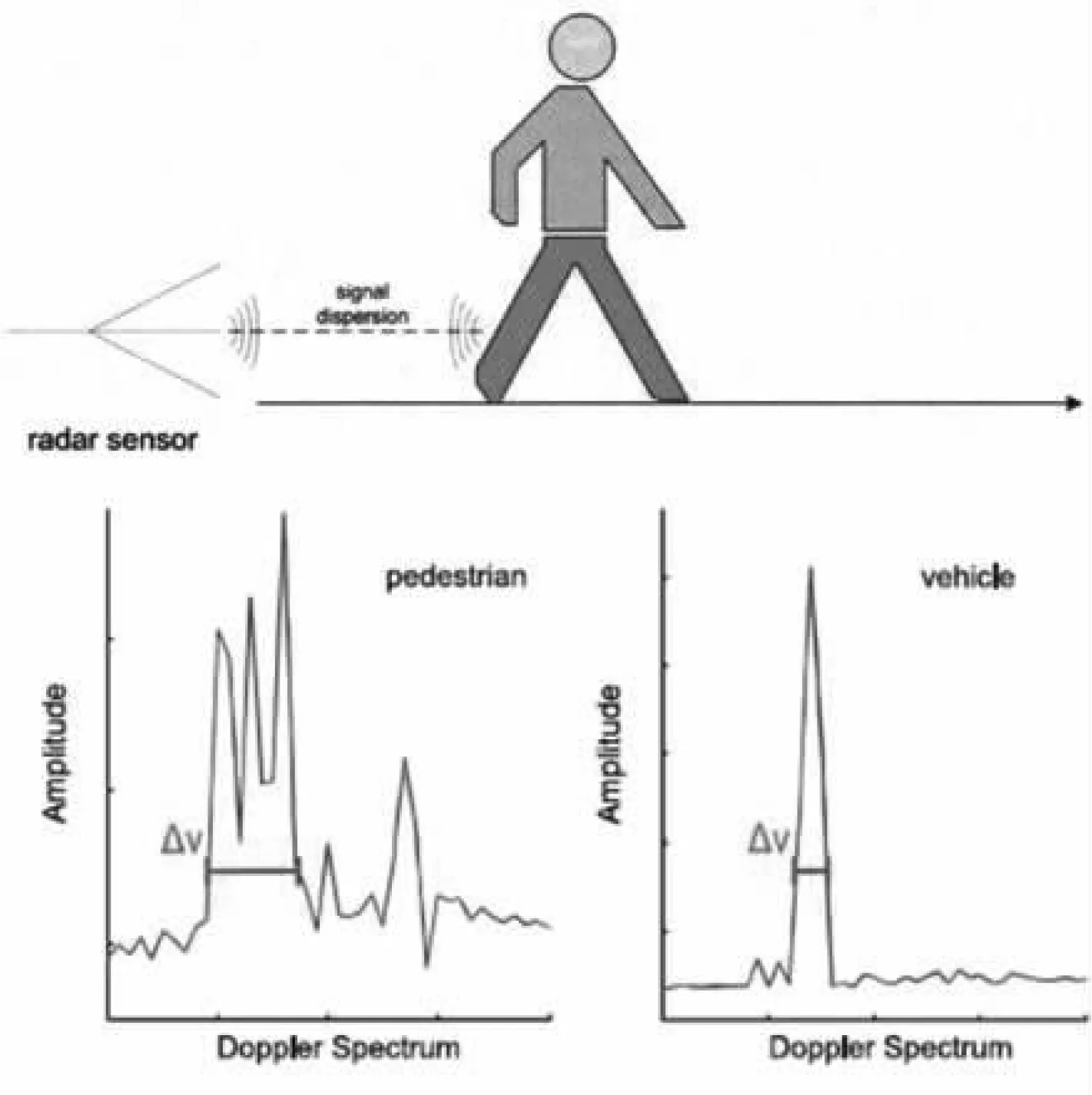

图8 行人与车辆多普勒谱对比

图9 Langer搭建的车辆行驶环境感知系统

图10 机器车Stanley比赛中的照片

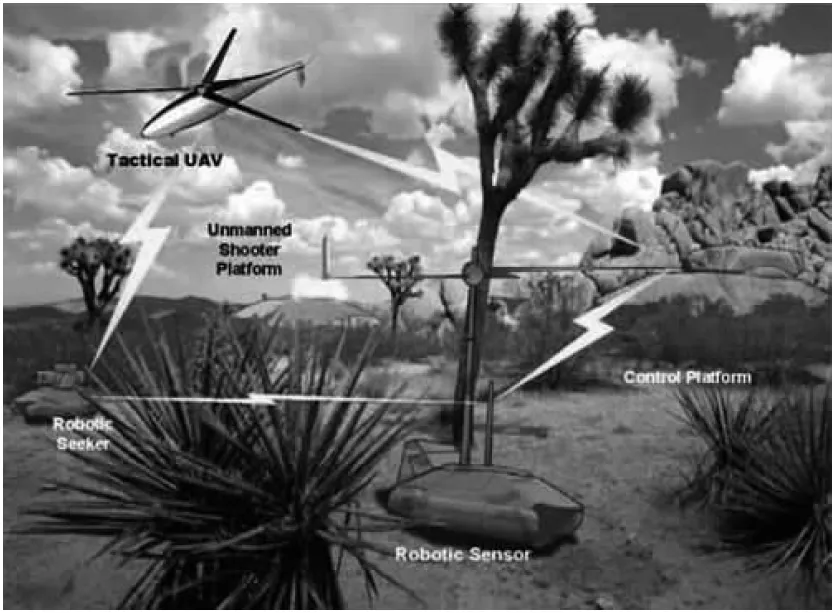

图11 美军未来作战系统

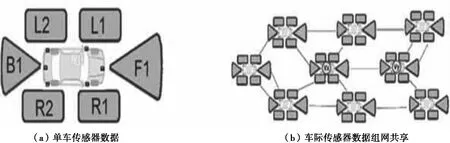

图12 单车数据与车际组网数据共享

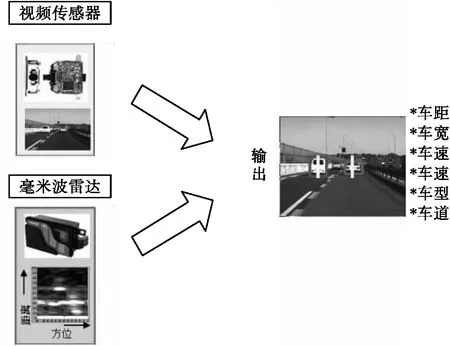

图13 多传感器数据融合示例:毫米波雷达+摄像机

图14 多传感器数据融合示例:毫米波雷达+电子地图

图15 负障碍的检测挑战

图16 窄波束长距离/宽波束短距离雷达

图17 双目雷达示意图

2.1.2 车辆和行人检测

对运动车辆的提取,在视频图像处理中可以采用帧间差法或当背景差法[8]。帧间差法是将相邻的图像帧进行差分,有运动目标的区域由于相邻两帧的不同会显现出来。帧间差法实现容易,计算速度快,但对目标的提取不完整,并且提取运动速度较慢的目标难度较大。背景差法需要先得到一个背景图像,通过当前图像帧与背景图像的相减提取出运动的目标,同时更新背景图像。

对运动车辆的检测也可以采用毫米波雷达测速实现,通过发射多个具有不同调频率的线性调频连续波(Linear Frequency Modulated Continuous Wave, LFMCW)波形来获得目标距离和速度的不同线性组合,进而解出目标的距离和速度,也可以利用各个波形发射周期间的相位变化来检测多普勒频率,进而获得目标的速度。

对于行人检测,Franke等人在摄像机获取的图像中通过检测运动的双腿来检测行人。考虑到行人在走动过程中身体各个部位间的相对运动要比运动车辆复杂得多,因此在多普勒谱上与运动车辆相比会有较大的展宽,根据这一特征,Rohling等人[9]从24GHz毫米波雷达获取的回波数据中提取多普勒谱和一维距离像,进行运动车辆和行人的区分。

2.2 多传感器融合技术

事实上,一种传感器不管处理得多么高明也不可能做各种事,人们逐渐考虑采用多传感器模式,将不同传感器的结果组合起来以实现全天候的鲁棒检测[10]。应用于UGV上的传感器(彩色摄像机、前视红外、激光雷达和雷达)各自的优缺点总结如下:

1)彩色摄像机:视频传感器是使用摄像机采集视频信息,通过图像处理的方式感知目标和道路场景的信息,视频传感器的优势在于成像分辨率较高,目标识别比较容易,而且数据采集方式简单。其缺点是作用距离较近,受天气,光照等因素影响明显,在夜晚环境无法正常工作。

2)前视红外:红外热像仪采集目标红外辐射的能量进行成像,克服了视频传感器在夜晚和光照不足时无法工作的缺点,由于车辆的热辐射较强,所以在红外成像图中车辆有比较明显的特征。红外热像仪的缺点是成像质量不如视频传感器,道路特征不容易识别,而且造价较高。

3)激光雷达:激光雷达通过主动的发射激光光束,通过接收目标反射光来测定目标的信息。且由于激光束的波束很窄,激光雷达可以达到很高的距离和方位分辨力,而且能达到较远的作用距离。激光雷达面临的问题是云雾,雨雪天气无法工作。

4)雷达:波长最长,作用距离最远,具有全天候工作能力。随着在汽车应用上的普及,价格相对较低而且可靠。通过选择适当的频率有可能探测到树叶和草丛中的障碍,可依据回波强度的不同对目标材质做有限的分类,可检测围栏、路标、护栏和电线,对于运动物体、车辆和行人具有良好的检测性能。缺点是分辨率低,目标识别有一定难度。

2.2.1 民用多传感器平台

Langer[11]开发了一套将77GHz雷达数据、摄像机和电子地图数据组合的系统。雷达用于检测和定位其他车辆,使得RALPH可以通过自主控制车速与前车保持安全距离;摄像机检测到的道路几何特征提供给RALPH道路跟踪系统,用于保持车辆横向位置;来自RALPH的道路几何信息被用于抑制雷达杂波和减少虚警。

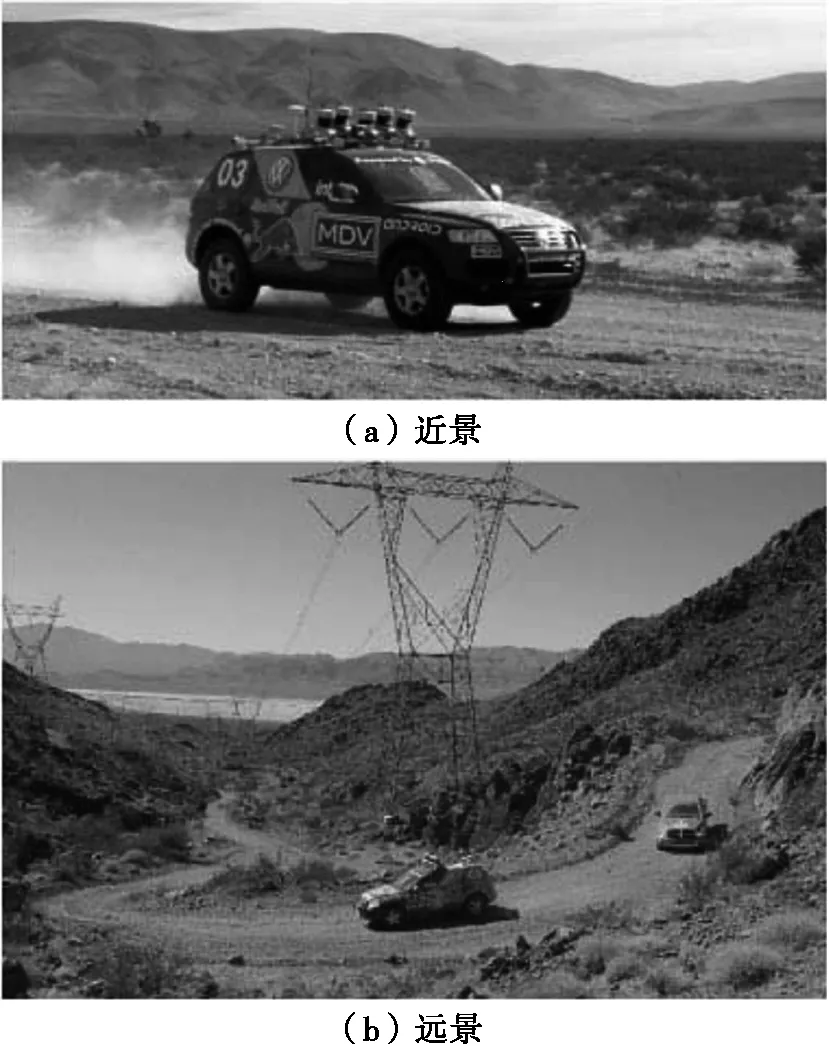

2005年DARPA主办的机器车挑战大赛(Grand Challenge)冠军由斯坦福大学研制的机器车Stanley[12]获得。Stanley装备了激光雷达、摄像机和24GHz毫米波雷达。激光雷达负责感知距离车辆25m以内的场景,可以绘制出详细的地形;摄像机作用距离较远,主要用以识别道路;24GHz毫米波雷达作用距离最远,达200m,可用以探测障碍物等。随着车辆的驶近,摄像机和毫米波雷达的远距离探测结果可用以辅助激光雷达的判决。

2.2.2 军用战场侦察系统

波音公司设计、研制和演示了无人作战系统最大的无人车ARV。ARV分为两个型号:用于执行侦察、监视和目标捕捉任务的侦察型车(ARV-R)和通过遥控操作执行直瞄或者间瞄射击任务以支援士兵乘车作战和徒步作战的攻击型车(ARV-A)。ARV-R为城市作战和其他战场提供远程侦察能力,将传感器、直瞄武器和特种弹药部署到建筑物、掩体、隧道和其他城市地形中,并能够提供通信中继和战斗毁伤评估。装备了一个5m高的可伸缩桅杆,其上装备了光电、红外、激光传感器组件、多功能Ka波段雷达,能够实现对目标的侦察、监视等侦察能力。

新加坡南洋理工大学研制的感知周围环境的无人车辆环境感知系统具备了先进的传感器系统,包括雷达、激光探测器、三维相机、超声波传感器和GPS定位系统,能够识别静态目标、捕捉动态目标,具有自动驾驶的能力。

“阿韦多-2004”是以色列研制的一部无人地面战车系统,其上安装了用于障碍物探测的和道路识别的电视、激光、超声装置和雷达传感器,以及基于地理信息技术、差分全球定位系统(DGPS)和综合导航系统(INS)的地面与空中地图系统的定位系统,用于停留处目标的跟踪。

3 无人平台场景感知技术的发展方向

3.1 空地结合

UGV的场景感知受到诸多条件的限制。首先,传感器作用距离有限,即使是作用距离最远的毫米波雷达也一般不超过250m,作用距离还会因为灌木草丛、墙壁土坡等的遮挡而进一步减小;其次,UGV的成本、最大载荷等的限制也使得UGV不一定能够装备所有类型的传感器,因此只能获得有限的感知能力;此外,作战环境的限制(夜晚、雨雾等)也会使得UGV感知能力下降。

未来战争将是海陆空军多兵种联合作战的立体战争,精确打击空中力量和无人驾驶飞行器正在改写着作战的规则。无人机在空中作战,有着作战半径大、机动能力强、视野宽广等优点,但容易受到复杂地形(高山、峡谷等)和恶劣天气的影响,不能很好地完成作战目标。在制空权未完全取得的情况下,容易受到来自敌方空中力量和地面防空火力的攻击。通过无人机投放UGV,并将无人机传感器数据(合成孔径雷达成像、高空摄像等)融合后提供给UGV,可以提高UGV场景感知效率和感知范围,帮助其在复杂环境中更有效行驶,与无人机形成配合侦查和作战。

3.2 数据共享

UGV在编队或小组行进时,可以通过组网实现传感器数据共享和协同工作,根据各个UGV所处位置的不同为其传感器分配不同的任务,例如位于队伍首尾的UGV可以承担较多的场景感知任务,而位于队伍中间的UGV则可以承担较多数据中继任务,可以达到资源优化配置的目的。不同位置的UGV传感器数据共享也有利于建立对场景更全面的认知,部分传感器缺失或损耗的UGV也可以利用其它UGV分享的场景感知信息继续工作。此外,组网协同工作也可以避免各UGV的主动传感器(激光雷达和毫米波雷达)之间的相互干扰。

UGV编队的传感器数据共享还可用于实现编队中的自动车辆跟踪。数项汽车研究了使车辆能够在公路上以短间距自动相互跟踪的方法。它可用于在公路上甚至越野运行的陆军补给车队,使车辆紧靠着行驶,以节约燃料和提高公路基础设施的运输效率。而在战场环境中,出于躲避敌方火力等的需要,可能会反其道而行之,希望车辆分散行驶。UGV编队的紧靠和分散行驶都需要通过传感器数据共享确定各成员车辆间的相对和绝对位置以后才能得以实现。

多平台协同[13]是将不同的信息节点采用高速、宽带数据传输网络进行数据链接,具备复合跟踪和识别、精确提示和协同联合作战等三大功能,可实现一致的图像传输;采用无中心的对等网络结构,支撑大容量数据的高可靠传输,支持动态组网。多平台协同技术包含大协同技术和小协同技术两个方面:大协同技术是将整个战场区域上的作战设备,包括有人设备、卫星、无人机、无人车通过信息传输实现信息共享和作战协同;小协同为在某个作战区域内无人平台和有人设备通过通信和信息网络实现人机互动。

3.3 数据融合

多传感器模式,只有通过数据融合,把多传感器的结果有效组合起来才可实现全天候对场景的鲁棒感知。事实上,不同传感器的优势和劣势可以互补,以毫米波雷达和视频传感器为例,它们的性能对比如表 3所示。

因此,可以采用雷达传感器首先获取道路中车辆的位置和速度信息,再通过坐标变换,定位车辆在视频图像中的位置,进而进行车型和车道识别,就可以实现车辆防撞预警和车速控制,更进一步地,如果利用GPS和电子地图,还可以实现路径规划。采用多传感器数据融合的场景感知系统,通过优势互补,可以有效提高数据处理速度,与依赖单一传感器的感知系统相比鲁棒性也大大加强。

3.4 认知传感器

负障碍的检测受到几何条件的限制,如果传感器的高度不够高,将无法观测到负障碍后壁的回波(这是立体视觉和雷达检测负障碍的主要依据),造成负障碍的检测性能不佳。解决该问题的途径有:一是采用可垂直升降的长杆架高雷达,并辅以俯仰角的调整来达到对负障碍的最佳观测位置和姿态;二是改变雷达工作波长至厘米波段,该波段电磁波可以穿透地表一定深度,常用于探地和穿墙雷达,从而能够在一定程度上削弱负障碍前沿对后壁的遮挡,甚至有可能观测到被木板或草皮覆盖的负障碍。

考虑到道路弯曲和多车道的影响,为了保证雷达能够照射到前方道路上的障碍物和行驶车辆,方位波束宽度也不能设计得太小。为了解决此问题,可通过雷达发射功率和发射波束的搭配切换,采用窄波束长距离雷达和宽波束短距离雷达相结合,达到在抑制远处杂波情况下雷达对全场景的覆盖。

3.5 毫米波雷达

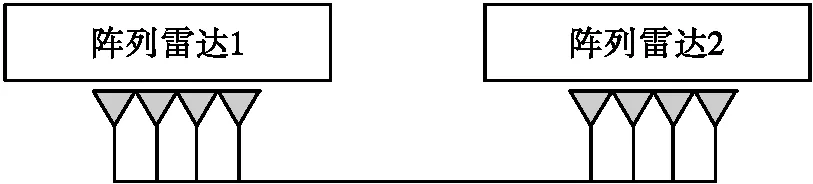

在各种传感器中,仅有毫米波雷达传感器具有可全天候工作的特点,因此进一步研究毫米波雷达传感器,并克服毫米波雷达方位分辨力较低,目标识别难度较大的问题具有较大的意义。为了获得较高的分辨力,可以尝试使用双目雷达的方法,即在车头的两边各安装两部连续波阵列雷达,在后续的处理中对两部雷达的信息得到融合,以达到高分辨的效果。双目雷达的示意图如图 17所示。

对双目雷达的信息融合,可以分为波束层的双目融合和信号层的双目融合。波束层面的融合,即对两个雷达获得不同视角的目标信息的融合。信号层面的融合,即这样的结构可以获得更大的雷达孔径,提高方位分辨力,但同时由于稀疏阵列产生较强的栅瓣,需要克服栅瓣的影响。

此外,在信号处理阶段也有着提高雷达方位分辨力的手段,如MUSIC、Capon等高分辨谱估计算法、FOCUSS、clustering FOCUSS[14]等稀疏恢复算法等。但是,这些算法都存在计算量大,难以满足实时性的要求,以及鲁棒性差,在噪声和杂波存在的情况下性能急剧恶化的问题。

4 结束语

随着信息技术的不断发展,UGV越来越广泛地应用于军事领域,进行侦察监视、警戒巡逻、高危作业、特种作战等任务。而场景感知系统作为UGV的“眼睛”,直接影响着UGV能否在复杂的作战环境中快速寻找和规划出合理的行驶路径,是决定UGV性能的关键技术之一。本文从单传感器检测和多传感器融合技术两方面介绍了UGV场景感知技术的发展现状,并对UGV场景感知技术的发展进行了展望。目前对场景的感知利用更多的往往是分辨力较高的视频传感器和激光雷达,毫米波雷达仅仅作为一种辅助手段,用于道路上车辆的检测和跟踪。通过自行研制具有测距和测角能力的毫米波雷达传感器,我们发现可以从雷达对于场景的原始距离/方位成像结果中挖掘更多的信息(道路边缘、正负障碍等),结合毫米波雷达作用距离远、可全天候工作的优点,将有可能大大提升现有场景感知系统的感知能力。接下来,提高雷达的分辨力,将雷达传感器获取的信息(特别是地形等)与其他传感器进行有效融合,根据测量结果有目的地调整传感器位置、姿态甚至是工作方式,以达到对感兴趣目标实现更有效的观测,是值得进一步研究的方向。