基于状态信息的红外小目标跟踪方法

唐 鑫,彭 博,滕 飞

(西南交通大学 计算机与人工智能学院,成都 611756)

0 引言

红外成像具有抗干扰能力强、成像清楚,精确率高等优点,被广泛应用于飞机制导、夜视导航和遥感等军事和民用领域。当目标距离较远时,在生成的红外图像中通常呈现像素数小于9×9的小目标;同时由于红外图像的特性,红外小目标具有信噪比低、缺乏有效的颜色、纹理、形状等特征的问题,而且在实际应用过程中,红外小目标夹杂在戈壁、海洋、云层等复杂背景中,这都给红外小目标的跟踪带来了较大的挑战。

目前红外小目标跟踪算法可以分为生成式法、判别式法和基于深度学习的方法[1]。生成式法是对待跟踪目标建立特征模型并在下一帧中寻找目标模型的最优匹配,代表算法有卡尔曼滤波[2]、粒子滤波[3]、均值漂移[4]等。这些算法对变化场景中的运动目标处理能力较差,实际跟踪效果不理想。判别式法是将目标区域和背景区域划分为正负样本,训练分类器将目标和背景进行区分,代表算法有相关多示例学习[5]、随机森林[6]等。判别式法的缺点是在跟踪轮廓模糊的小目标时容易丢失目标。

近年来,基于深度学习的小目标跟踪方法因独特的深度特征、稳定的跟踪效果、弱边界效应等优点引起了人们的广泛关注。Liu 等[7]提出区域卷积 神经网络(Convolutional Neural Network,CNN)框架,利用候选区域提取深度特征完成对小目标的跟踪。Li 等[8]提出孪生候选区域生成网络(Siamese Region Proposal Network,SiamRPN),将整体的跟踪任务分解为多个局部性检测任务。胡阳光等[9]提出基于多域学习的神经网络框架,将长宽比和均值对比度与深度特征进行融合,在单一特征的小目标跟踪中具有良好的精度。Gazzaley 等[10]提出一种自顶向下的调制机制(Top-Down Modulation,TDM),对多层特征图进行选择和融合,这些特征继承了局部更大的感受野,极大地改善了小目标的跟踪效果。总之,卷积网络感知目标的结构和内部几何分布信息是有效的,但由于红外小目标成像面积小、特征不明显、噪声干扰等,现有的大多数方法在面对红外小目标时难以满足跟踪稳定性的要求。

一些基于低秩稀疏矩阵分解的方法[11-12]认为红外弱小目标本身是稀疏的,相对的背景则是低秩的。针对红外小目标跟踪,关注目标的周围环境信息与目标本身是同等重要的。对此,本文提出一种新的针对红外小目标的跟踪方法。对于红外小目标,本文方法不仅关注目标本身,也关注小目标及其周围场景这个整体。它可以提取当前帧有用的状态信息并按序列传播到下一帧,该状态信息表示待跟踪目标周围的其他对象在连续帧中的运动情况。状态信息与分类器得分一起用于预测每一帧的目标状态与位置。本文主要工作如下。

1)提出了一种针对红外小目标的跟踪方法,利用传播的状态信息对红外小目标进行跟踪。提出了一种新的分类器,通过当前帧和上一帧的特征信息区分目标与背景。

2)提出了一个分数融合模块,能有效地将分类器的分类结果和状态信息结合起来,输出最后的分数以确定待跟踪目标最终的位置。

3)在DIRST(Dataset for Infrared detection and tRacking of dim-Small aircrafT)数据集[13]上进行实验,对比了通用目标跟踪方法和红外小目标跟踪方法,取得了96.2%的召回率和97.3%的精确率。

1 本文方法

由于红外小目标缺乏纹理和形状信息,只依赖外观模型对单独某一帧进行处理是不全面的,所以本文提出一种新的跟踪方法,结合前一帧的状态信息对红外图像中的小目标进行跟踪。

1.1 整体结构

本文方法的整体结构如图1 所示,由特征提取器、分类器、融合模块、传播模块和IoU-Net[14]组成。跟踪不仅仅依赖分类器的分类结果,还利用了传播的状态信息,通过为目标领域中的每个区域维护一个状态向量实现传播状态信息;通过对该区域存在的目标、背景、干扰物信息编码得到状态向量。当目标对象在序列中移动时,首先通过估计连续帧之间的密集对应关系修正状态向量,传播相应的状态向量。然后将传播的状态向量与目标外观模型结合,预测目标最终位置的置信度,再利用IoU-Net 获取目标的边界框。最后通过卷积门控循环单元(Convolutional Gated Recurrent Unit,ConvGRU)神经网络[15]更新状态向量,使之能够在连续帧中传播。

图1 本文方法的整体结构Fig.1 Overall structure of the proposed method

本文方法的输入为连续序列中第0 帧~第N帧的红外图像和初始标签信息。红外图像输入到以ResNet(Residual Network)-50[16]为基础的骨干网络中提取特征信息。对于初始帧,先通过一个小型网络γ将初始帧图像中目标位置的标签b0初始化为初始状态向量,然后通过分类器、状态传播、融合模块预测待跟踪目标的中心点,同时更新当前帧的状态信息,最终通过IoU-Net 输出每一帧中待跟踪目标的边界框(x1,y1,x2,y2),其中x1,y1为边界框左上角坐标,x2,y2为边界框右下角坐标。

1.2 分类器

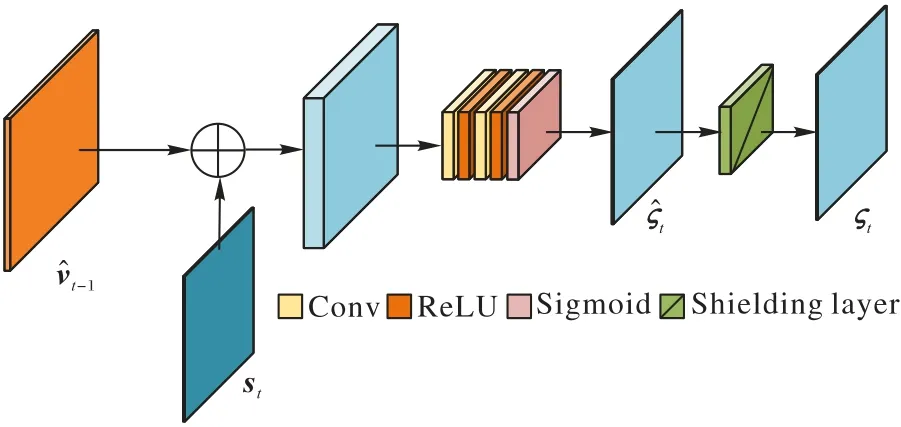

虽然红外小目标的像素较少,但它的外观特征信息也可以作为跟踪的一个重要线索。为了使本文方法更具有鲁棒性,设计基于两个线索完成对于红外小目标的跟踪,即使用当前帧中目标与背景的大致分布和随帧数传播的状态信息。分类器的作用是区分目标和背景。在使用分类器C 之前,需要先通过特征提取器提取当前帧的特征信息ft,本文选择ResNet-50 作为骨干网络提取特征。分类器C 的网络结构如图2 所示。

图2 分类器C的网络结构Fig.2 Network structure of classifier C

图3 融合模块M中分数融合部分的网络结构Fig.3 Network structure of score fusion part in fusion module M

分类器C 的设计参考DiMP(Discriminative Model Prediction)追踪器[17],DiMP 作为一个端到端的网络结构,在图像跟踪方面有良好的表现。但由于红外小目标的像素少,缺乏纹理颜色等信息,直接使用外观模型区分目标与背景效果不够明显。为了使分类器更适应于红外小目标,将单个卷积层的权重重新进行参数化。由于红外小目标的像素少,仅仅使用当前帧的特征信息不利于区分目标与背景。考虑到小目标在两帧图像之间移动的相对距离较小,在实际预测时,保留上一帧的特征信息ft-1,结合当前帧与上一帧的特征信息输入空间相关性取样器中得到相关特征,将该相关特征输到卷积层中得到分类输出,即置信度st。表示在第t帧图像中的位置r∈Ω:={0,1,…,W-1}×{0,1,…,H-1}的得分,其中Ω表示一维向量空间。该位置为目标中心的可能性,用于区分位置r是目标还是背景。

由于初始帧图像带有人工标注的目标位置框,实际运用分类器是从第二帧图像开始的,此时上一帧的特征信息来自初始帧。使用损失函数式(1)对模型参数进行优化:

其中y=由训练图像中所提取的深度特征ft和相应的目标标签cj的映射组成;残差函数r(sω,c)计算分类器C的预测值sω与真实值c的误差;λ是正则化参数。

1.3 状态传播

1.4 融合模块

对于目标跟踪问题,需要确定待跟踪目标的中心点。参考Bhat 等[18]的工作,对目标置信分数预测模块重新设计使之更适用于红外小目标的跟踪。

在获得当前帧目标分数后,还需要更新当前帧的状态向量供下一帧使用,利用ConvGRU 实现状态更新。如图4 所示,将分类器C 的预测分数st与ςt按最大值进行连接,得到εt∈RW×H×4。前一帧的状态向量和εt作为ConvGRU 的输入,得到当前帧的状态向量vt。

其中:Ns为当前连续序列的帧数总和;zt是通过标签获取的真实分数;α为超参数,确定L′对整个损失函数的影响。

2 实验与结果分析

为了验证本文方法的可行性,使用国防科技大学ATR实验室于2019 年发布的红外小目标数据集DIRST[13]进行对比和消融实验。所有实验均在单张NVIDIA GTX 2080 GPU上进行。

本章先介绍实验所用到的DIRST 数据集以及针对红外小目标的评价体系,再分别介绍对比实验和消融实验。

2.1 数据集和评价体系

DIRST 数据集由22 个数据段构成,共包含 30 条运动轨迹和 16 177 张红外图片,每个数据段包含红外图像序列和与之对应的标注文件,标注主要记录小目标中心点的横纵坐标。DIRST 数据集包含30 条运动轨迹和16 177 张红外图片。DIRST 所包含的复杂场景有:天空、山脉、森林、平原、丘陵和房屋建筑,其中包含多个目标交叉飞行、地面丛林干扰和地面车辆干扰。由于该数据集没有单独划分训练集和测试集,为了使对比实验更加公平,本文训练集和测试集的划分和文献[19]中划分保持一致。

小目标最终的边界框小于9×9,而交并比(Intersection over Union,IoU)和ROC(Receiver Operating Characteristic)曲线下面积(Area Under the ROC Curve,AUC)评价体系主要用于大目标,所以该评价体系并不适用于小目标。将预测得到的小目标边界框中心点与小目标真实中心点作比较,如果预测的中心点在真实中心点的3×3 范围内,认为该预测是有效的。使用召回率(Recall,R)、精确率(Precision,P)和综合评价指标(F-Measure,F1)(其中取参数α=1)作为指标衡量本文方法的有效性。

2.2 与其他方法的比较

为了验证本文方法对红外小目标的跟踪具有较好的性能,选用的几种对比方法包括:1)通用检测方法YOLOv3(You Only Look Once version 3)[20],在anchor box 的选择上YOLOv3更适用于小目标的检测;2)通用跟踪方法KeepTrack[21],KeepTrack 作为state-of-the-art 的通用跟踪方法在众多跟踪基准数据集上有优秀的表现;3)针对红外小目标的检测方法ISTDet[22],ISTDet是一种基于CNN 的检测方法,用来检测红外小目标;4)针对红外小目标的跟踪方法SSD-ST(Single Shot multiBox Detector for Small Target)-1+APF(Adaptive Pipeline Filter)和SSD-ST-2+APF[23],其中APF 是用于多帧滤波阶段的一个自适应管道滤波器。实验对比结果如表1所示。

表1 不同方法的评估结果 单位:%Tab.1 Evaluation results of different methods unit:%

从表1 可以看出,本文方法在DIRST 数据集上的R 相较于 YOLOv3、ISTDet、SSD-ST-1+APF、SSD-ST-2+APF、KeepTrack 分别提高了10.0、4.0、6.4、6.1 和3.7 个百分点;P分别提高了8.9、4.3、2.2、2.3 和3.7 个百分点;F1分别提高了9.4、4.1、4.3、4.2 和3.7 个百分点。最高达到97.3%的精确率,这表明本文所提出的针对红外小目标的跟踪方法比通用的检测、跟踪以及其他针对红外小目标的检测跟踪方法具有更好的性能。

由于红外小目标自身像素少,最后包含目标的边界框小,所以直接将跟踪得到的边界框与真实标签进行比较不够直观。为了更直观地展示本文方法对红外小目标进行跟踪的优秀性能,提供图5 所示的红外小目标中心点真实轨迹与跟踪轨迹对比。DIRST 数据集包括22 个数据段,数据段1 对应的是数据包中名为data1 的文件夹,数据集2 对应的是名为data2 的文件夹,以此类推,数据段22 对应data22,故图5中data 后数字代表第几个数据段。本文通过计算连续序列中所有帧的边界框的中心点,然后将全部中心点放在画布上形成一条中心点轨迹。图5 中包含较复杂的轨迹,本文方法预测的结果与真实轨迹基本一致,表明即使在复杂的背景和轨迹下仍能准确地完成对红外小目标的跟踪。综上所述,本文方法针对红外小目标具有良好的跟踪性能。

图5 红外小目标真实轨迹与本文方法跟踪的轨迹对比Fig.5 Comparison between real trajectories and trajectories tracked by the proposed method for infrared small targets

2.3 消融实验

为分析各个组件对本文方法的影响,在DIRST 数据集上进行消融实验,结果如表2 所示。

表2 消融实验结果 单位:%Tab.2 Ablation experiment results unit:%

在分类器输入中加入上一帧特征信息的作用 分类器的设计是为了区分背景与目标。为了判断上一帧特征信息在分类过程中是否起作用。本节设计了一个仅将当前帧的特征信息输入分类器的实验跟踪方法。在这种方法下得到置信度st,此置信度与上一帧特征信息无关。如表2 所示,如果不将上一帧特征信息输入分类器,跟踪性能将下降,表明将上一帧特征信息加入到分类器中有助于获得更好的跟踪表现。

传播模块的作用 传播模块的作用是将上一帧状态向量vt-1针对当前帧进行修正,使得修正后的状态向量输入融合模块时更能准确描述当前帧的状态信息。为了验证传播模块的有效性,将未修正的状态向量vt-1直接输入融合模块进行对比,结果如表2 所示。结果显示,不使用传播模块进行修正的情况下F1下降了9.3 个百分点,表明利用连续帧之间的密集对应关系将上一帧的状态向量进行修正是有必要的。

屏蔽层的作用 屏蔽层的作用是当待跟踪小目标被遮挡或者多个目标出现交叉时,避免最后的融合分数ςt将遮挡物或其他目标误认为该目标的中心点。为了验证屏蔽层在融合模块的作用,本节去掉屏蔽层,直接将中间分数ς^t输入Iou-Net 中得到边界框。结果如表2 所示,通过屏蔽层能有效减少跟踪方法的误检率,提高召回率,引入屏蔽层后召回率提高了3.7 个百分点。

3 结语

本文提出一种基于状态信息的红外小目标跟踪方法,该方法用于连续序列中红外小目标的跟踪。首先利用相邻两帧的深度特征信息区分待跟踪目标与背景,然后结合连续帧之间的状态向量定位小目标,最后在整个序列中传播这些状态向量,完成对整个序列的跟踪。在包含天空、山脉、森林、平原、丘陵和房屋建筑等复杂场景的DIRST 数据集上评估本文方法,并与其他5 种方法进行比较。实验结果表明,本文方法在各种复杂场景中具有良好的鲁棒性,可达到96.2%的召回率和97.3%的精确率。验证了本文方法能够很好地完成对连续序列中红外小目标的跟踪任务。本文方法在复杂的红外图像场景中跟踪速率较慢,并且模型的空间占用较大,未来可以从这两方面入手优化模型。