眼动仪在外科医学教育中的应用及进展

潘琳 段晓琴

摘 要 随着红外技术、图像处理技术和微电子技术的不断发展与进步,眼动仪作为一种实用性设备出现在众多机构中,在阅读、图画观看、广告设计等方面得到了广泛应用。目前眼动仪也被用于外科医学教育领域,但国内研究较少。本文着重从技能评估、技能培训、外科器械的优化设计三个维度对眼动仪在外科医学教育中的应用现状及进展进行综述,旨在为外科医学教育的发展、医工交叉研究新思路的探索提供参考。

关键词 眼动仪;眼动追踪技术;外科;医学教育

中图分类号 R494 文献标识码 A 文章编号 2096-7721(2023)01-0074-05

Abstract With the continuous development of infrared technology, image processing technology and microelectronic technology, eye tracker has gradually appeared in many fields as a kind of practical equipment, such as reading, picture viewing, advertising design and so on. At present, eye trackers are also used in the field of surgical education, but few studies in China have been reported. The application status and progress of eye tracker in surgical education from three aspects were reviewed in this paper, including surgical skill evaluation, surgical skill training and optimal design of surgical instruments, with the purpose of providing reference for surgical education and exploring new ideas for further researches on medical-industrial interdiscipline.

Key words Eye tracker; Eye tracking technology; Surgery; Medical education

眼动仪是一项用于心理学基础研究的仪器,它的问世使眼動跟踪成为可能。眼动仪能够记录人的眼球运动轨迹,包括注视时间、注视点个数、热点图、注视率、眼动轨迹图、瞳孔大小等多个指标,有利于研究个体视觉信息认知加工的心理学机制。因此,眼动仪被广泛应用于研究个体心理活动和内在认知过程。近年来,信息化教育在世界领域内掀起了热浪,眼动仪也被应用于外科医学教育领域,但国内相关报道较少。本文通过综述眼动仪在外科教育研究中的应用及进展,旨在为广大医学教育工作者、医工交叉领域的研究者提供新的视角,推动我国外科人才培养体系的发展。

1 眼动仪在外科医学教育中的应用

1.1 技能评估

眼动跟踪和凝视模式研究被用于评估人类行为已有几十年[1]。众所周知,高效成熟的技能训练方案需要一套精确、客观的评估方法[2],而眼动追踪技术可以作为外科医师技能水平评估的一种手段,能够帮助学员更好地学习外科技能。

近年来,眼动分析逐渐应用于微创手术(腹腔镜/内镜手术)的考核及培训,以评估外科医生的技能水平。研究发现,不同利手操作时的眼动数据是不一样的[3]。通常情况下,使用优势手时,任务完成时间更短,手术效果更好;而使用非优势手或双手时,执行任务的时间会增加。此外,随着3D成像技术的逐渐发展,立体镜、立体图像逐渐被引入手术室,深度知觉(个体看到和放置不同距离物体的能力)成为三维模式下的外科手术焦点。对于一名外科医生来说,具有正确的深度知觉能力是保证手术操作准确和患者安全的关键因素。国外研究人员采用Tobii眼动仪进行深度知觉测量,通过眼动仪对外科医生在3D手术模式下的眼动轨迹进行追踪,计算手术过程中的视线变化和凝视轨迹,从而帮助初学者了解自己操作的缺陷或薄弱环节,有利于复杂手术技能的学习及提升[4]。由此可见,眼动分析能够从多个视角评估外科技能,帮助外科医生找到适合自己的最佳提升途径,从而实现高效的技能提高。

此外,眼动跟踪技术已被运用于记录评估外科专家、新手的眼动特征,通过对比分析,可以精准评定外科医生、医学生的技能水平。无论是在手术操作过程中,或是在模拟手术培训时,新手和外科专家的注视模式差异较大。研究显示,在进行腹腔镜胰十二指肠切除术时,专家的平均注视时间较新手高,而凝视次数较新手少,表明专家能够更快地识别手术的关键步骤[5]。近期的一项结肠镜模拟手术研究表明,专家的主要观察区域在肠腔中心,而新手则在屏幕边缘;当肠腔移出中心视野时,专家的扫视频率增加,而新手却没有此类动作[6]。此外,由于瞳孔的大小能够反映受试者的心理负荷,眼动仪也被运用于外科新手和专家医生心理负荷的评估[2]。一项研究表明,在手术过程中,新手的瞳孔大于专家的瞳孔,专家在手术关键区域的注视次数更高、注视时长更长,能够更快地收集到必要的信息[3]。对于外科医生来说,手术过程中的眨眼次数与注意力息息相关,眨眼次数越少,注意力越集中。Erridge S等人[7]发现,在腹腔镜胃分流手术中,专家的眨眼频率(0.30~0.40次/s)较新手(0.40~1.70次/s)低,在每个手术关键节点的停留时间更长。加拿大不列颠哥伦比亚省的一项研究表明,与新手外科医生相比,专家外科医生对患者生命体征的注视次数更高[8]。因此,眼动分析结果能够协助判断外科医生的技能操作水平及心理负荷水平,可以客观评价外科医生,帮助他们调试自身心理状态,不断提升操作技能。

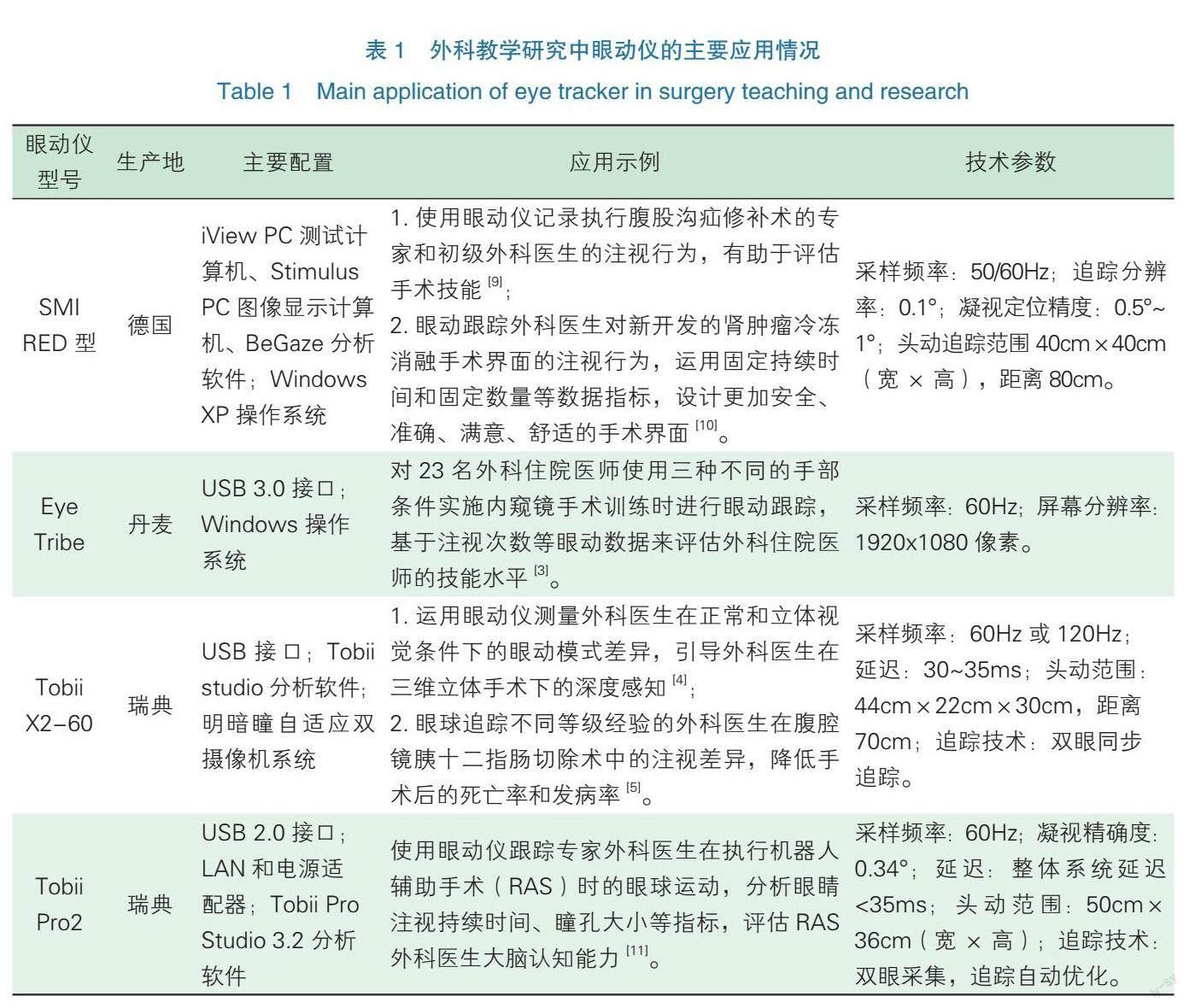

根据上述研究及近年外科教学领域的相关研究,眼动仪的主要应用情况(如选型、配置、技术参数设置等)见表1。

1.2 技能培训

有经验医生的临床思维和手术技能是通过多年临床实践形成的。通过眼动仪,可以记录专家手术期间的眼动轨迹,为新手的技能培训提供了客观、精准的指导[12]。Khan R S等人[12]的研究发现,外科新手医生与专家之间的凝视行为差异,并证明了新手在学习专家的眼动轨迹后,他们的学习曲线明显改善。Chetwood A S等人[13]将外科专家操作时的注视点传输到初级外科医生的显示屏上,在注视点的指引下,初级医生完成任务的准确率提高、反应速率提升。因此,眼动仪能够用于记录并分析专家外科医生和初级外科医生手术行为的差异,通过获得有经验医生的视觉策略,为外科年轻医生的培养提供了一种新思路、新方法。

此外,眼动仪为探讨不同技能训练模式下的培训效果提供了可能。上海理工大学对不同学习模式下的腹腔镜模拟训练者的眼动数据进行分析,结果表明,无指导组的任务完成时间(145.5±37.7)s和操作错误数(11.0±1.2)个均大于视频指导组[(112.0±15.7)s,(5.0±0.7)个]和专家指导组[(112.1±19.3)s,(1.0±0.2)个]。和无指导组相比,专家指导组中被测试者的平均操作速度提高20%,任务完成时间明显降低,错误数降低91%,由此表明视频学习和专家指导下的学习效果比无指导时更好[14]。Di Stasi L L等人[15]的研究提到了外科医生的注视模式在手术训练中的潜在好处。除此之外,眼动追踪技术下的首次注视时间和注视模式有利于发掘更好的训练方法[16]。因此,在外科医生的模拟手术技能训练过程中,不同训练方案下的眼动特征数据为探索新的训练模式提供了新的视角,有利于外科医生的培养。

1.3 外科器械的优化设计

眼动仪被逐步应用于远程手术、手术机器人系统的研发中,大大促进了外科学技术的进步与发展。早在2012年,远程手术TELELAP Alf-X系统就通过添加眼动追踪系统,精准测试了外科医生手眼协调性、手灵巧度、景深及最佳缝合和打结的能力,为远程操作的3D内窥镜操作提供了新方法[17]。近两年推出的Senhance TM机器人系统集合了眼动追踪、改进的人体工程学、触觉反馈及标准腹腔镜设备,研究显示,其辅助下的胆囊切除术安全、可行且有效[18]。此外,根据人体工程学理论,良好的界面设计不仅兼具可用性、功能性和美感[19],还能引领交互过程的顺利完成。一方面,通过眼动指标分析,可以识别外科医生的注意力焦点、人机交互界面中感兴趣的地方,也可以了解人机交互界面的布局方式对视觉优先顺序的影响,从而用于改善外科视觉系统的设计,也为初级外科医生的技能训练提供便利。最近開发出来的被称为“肝脏医生”的虚拟肝脏手术系统是针对初级外科医生设计出来的,易用性和安全性显著增加,还能够帮助医生进行模拟训练[20]。另一方面,数字手术室中越来越多的医疗设备的使用增加了手术人员的交互需求,为降低设备交互引起的细菌污染风险,学者们基于眼动追踪眼镜系统开发了非接触式交互技术。实验室环境评估的研究显示,注视手势识别准确率为97.9%,参与者满意度高[21]。因此,眼动仪对于外科远程手术、手术机器人、手术操作设备乃至手术学科的发展有着广阔的应用前景,值得进一步研究推广。

2 总结与展望

虽然目前眼动仪在外科医学教育中的应用尚处于研究阶段,随着眼动追踪技术的日趋成熟,眼动仪在外科医学教育中发挥的作用将逐渐凸显出来。近年来,虚拟现实技术(Virtual Reality,VR)与眼动跟踪技术的结合显示出了很好的前景,未来可能彻底改变外科领域的培训方式[22]。Williams A M等人[23]认为,为了达到技能训练的目的,必须要有一定逼真程度的模拟。而VR则为更生态有效的技能练习方式提供了可能[24]。目前,VR已经被应用到医学培训、实习和研究中,甚至一些医学院已经将VR用于尸体解剖和各种手术练习。此外,利用眼动仪对外科医生在虚拟环境下的视觉轨迹进行跟踪,通过眼动分析,有利于完善虚拟系统的性能、提高人机交互性能、增强用户体验感、促进外科医学教育事业的发展。但有研究发现,外科医生在VR培训中存在感知困难,并企图从VR培训的眼动数据中得到答案。在未来,虚拟现实眼动仪将成为外科医学教育研究领域的明星。

总之,眼动仪在外科医学教育中具有广阔的临床应用前景,值得进一步研究推广。

参考文献

[1] Giovinco N A, Sutton S M, Miller J D, et al. A passing glance? Differences in eye tracking and gaze patterns between trainees and experts reading plain film bunion radiographs [J]. J Foot Ankle Surg, 2015, 54(3): 382-391.

[2] Gonca G?k?e M D, Nergiz C, Erol O, et al. Simulation-based environments for surgical practice [C] // 2017 4th International Conference on Control, Decision and Information Technologies (CoDIT). [s.n.], 2017: 1153-1156.

[3] Gonca Gokce M D, Nergiz Ercil C. Insights from surgeons eye-movement data in a virtual simulation surgical training environment: effect of experience level and hand conditions [J]. Behav Inform Tech, 2018, 37(5): 23-28.

[4] Bogdanova R, Boulanger P, Zheng B. Three-dimensional eye tracking in a surgical scenario [J]. Surg Innov, 2015, 22(5): 522-527.

[5] Brinkman D, vander Vliet W, Besselink M, et al. Eye-tracking to differentiate viewing behavior of surgeons and trainees during laparoscopic pancreatoduodenectomy [J]. HPB, 2018, 20(Suppl 2): S650.

[6] He W, Bryns S, Kroeker K, et al. Eye gaze of endoscopists during simulated colonoscopy [J]. J Robot Surg, 2020, 14(1): 137-143.

[7] Erridge S, Ashraf H, Purkayastha S, et al. Comparison of gaze behaviour of trainee and experienced surgeons during laparoscopic gastric bypass [J]. Br J Surg, 2018, 105(3): 287-294.

[8] Zheng B, Tien G, Atkins SM, et al. Surgeons vigilance in the operating room [J]. Am J Surg, 2011, 201(5): 673-677.

[9] Tien T, Pucher P H, Sodergren M H, et al. Differences in gaze behaviour of expert and junior surgeons performing open inguinal hernia repair [J]. Surg Endosc, 2015, 29(2): 405-413.

[10] Erol Barkana D, A??k A, Duru D G, et al. Improvement of design of a surgical interface using an eye tracking device [J]. Theor Biol Med Model, 2014. DOI: 10.1186/ 1742-4682-11-S1-S4.

[11] The Journal of Urology? Home Study Course 2018 Volume 199/200 [J]. J Urol, 2018, 200 (3): 662-663.

[12] Khan R S, Tien G, Atkins M S, et al. Analysis of eye gaze: do novice surgeons look at the same location as expert surgeons during a laparoscopic operation?[J]. Surg Endosc, 2012, 26(12): 3536-3540.

[13] Chetwood A S, Kwok K W, Sun L W, et al. Collaborative eye tracking: a potential training tool in laparoscopic surgery [J]. Surg Endosc, 2012, 26(7): 2003-2009.

[14] 葉莎莎, 王殊轶, 张燕群, 等. 基于腹腔镜手术训练的眼动特征研究[J]. 生物医学工程研究, 2016, 35(2): 93-97.

[15] Di Stasi L L, Díaz-Piedra C, Ruiz-Rabelo J F, et al. Quantifying the cognitive cost of laparo-endoscopic single-site surgeries: gaze-based indices [J]. Appl Ergon, 2017. DOI.org/10.1016/j.apergo.2017.06.008.

[16] Merali N, Veeramootoo D, Singh S. Eye-Tracking technology in surgical training [J]. J Invest Surg, 2019, 32(7): 587-593.

[17] Gidaro S, Buscarini M, Ruiz E, et al. Telelap Alf-X: a novel telesurgical system for the 21st century[J]. Surg Technol Int, 2012. DOI: 10.1016/j.juro.2013.02.2759.

[18] Aggarwal R, Winter Beatty J, Kinross J, et al. Initial experience with a new robotic surgical system for cholecystectom [J]. Surg Innov, 2020, 27(2): 136-142.

[19] 大卫·伍德(著), 孔祥富(译). 国际经典交互设计教程: 界面设计[M]. 北京: 电子工业出版社, 2015: 11-16.

[20] YANG X P, Wonsup L, Younggeun Choi, et al. Development of a user-centered virtual liver surgery system for preoperative liver surgery planning [D]. Korea: Pohang University of Science and Technology, 2014: 64-67.

[21] Unger M, Black D, Fischer N M, et al. Design and evaluation of an eye tracking support system for the scrub nurse [J]. Int J Med Robot, 2019, 15(1): e1954.

[22] Moglia A, Ferrari V, Morelli L, et al. A systematic review of virtual reality simulators for robot-assisted surgery [J]. Eur Urol, 2016, 69(6): 1065-1080.

[23] Williams A M, Jackson R C. Anticipation and decision making in Sport [M]. London: Routledge, 2019: 341-358.

[24] Harris D, Hardcastle K J, Wilson M R, et al. Assessing the learning and transfer of gaze behaviours in immersive virtual reality [J]. Virtual Reality, 2021. DOI: org/10.1007/s10055-021-00501-w.