基于COSNet的伪装目标分割

蒋昕昊, 蔡伟, 张志利, 姜波, 杨志勇, 王鑫

(火箭军工程大学 导弹工程学院, 陕西 西安 710025)

0 引言

在自然界,部分生物为了提升生存能力,可以对自身外形特征进行自适应伪装,或者根据适者生存的原则保留与栖息地环境更融合的外形特征,从而避免被攻击者捕食以及更好地埋伏猎物[1]。前者如变色龙,身体表皮颜色可以随外界环境做出变化[2],后者如白蛾与黑蛾的适者生存实例。

近年来,随着科学技术的进步,仿生动物伪装技术在高科技战争中得到了广泛应用,如不断推陈出新的军用迷彩服和伪装网[3],根据战场环境的差异针对性设计出的荒漠迷彩、丛林迷彩等具有高伪装性能的伪装装备。狙击手可以利用伪装技术躲避敌方搜索,特种车辆、装甲车可以利用伪装技术骗过敌方可见光侦察。图1所示士兵和坦克凭借迷彩服、迷彩涂层以及地物遮挡等因素,近乎完美地达到了与背景融为一体的效果。

图1 军用伪装目标示例Fig.1 Example of military camouflaged object

但是,现阶段的可见光COS研究寥寥无几。在军事领域中,往往会通过借助红外、高光谱、偏振等其他技术识别伪装目标[4-6],虽然在一定程度上缓解了可见光识别伪装目标的局限性,却忽略了可见光波段下如何精准分割伪装目标这一科学问题的研究。可见光波段的伪装目标精确分割仍是需要解决的技术难题。因此,必须提出一种可提高可见光波段伪装目标分割(COS)准确率的算法。

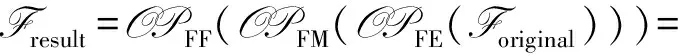

针对现实需求,本文提出了一种基于人类视觉系统的COS网络—COSNet的可见光波段COS算法。首先,根据场景多样、类别多样、目标伪装效果多样的数据集构建原则,构建出数据集MiCOD。然后针对性地构建出COSNet网络模型,模型由特征提取模块、聚焦放大模块和多尺度特征图融合模块3部分组成。其中,针对伪装目标与背景融合度高的特点设计的聚焦放大模块为模型关键模块,通过模拟人类视觉系统以提高分割精度。包含两个关键串行模块,即关键点聚焦模块和感受野放大模块。关键点聚焦模块通过模拟人类注意力高度集中的观察过程降低虚警率,而感受野放大模块用以增大观测感受野以提升分割精度。最后为COS设计了更加适用的关键点区域加权感知损失,通过权重给予伪装目标更高的关注度。

本文的主要贡献如下:

1)构建了以模拟真实战场环境为基础,具有多样性场景和目标的MiCOD,通过大量实验证明可为COS的研究提供有效的数据支撑。

2)基于人类视觉系统提出了一种可见光波段COSNet,针对性设计了关键点聚焦模块和感受野放大模块的串行结构,提出了关键点区域加权感知损失以提升分割效果。

3)所提出的COSNet网络在自建数据集上和通用数据集上均有最好的表现性能,各项指标均优于已公开的优秀算法。

1 相关工作

本节主要对与本文相关的可见光COS算法和语义分割算法进行梳理。

1)可见光COS算法。2020年可以作为基于深度学习的可见光伪装目标识别的研究元年,有许多学者对此开展了研究。周静等[7]提出了基于光流场分割的伪装色运动目标传统检测算法。Fan等提出了比较完备的通用伪装目标数据集COD10K,并提出了相应的COS网络SINet,推动了伪装目标识别的快速发展[8],但该数据集未收录军用伪装目标。2021年,Mei等模拟动物捕食过程,提出了基于分心挖掘的COS网络PFNet[9],但该算法由粗到细的定位聚焦比较耗时。总结来看,现有的COS模型在设计原理和网络结构上都比较复杂。

2)基于深度学习的图像分割算法。近年来,通过逐像素进行图像分类的语义分割技术作为图像理解的高级任务,得到了广泛的研究[10-12]。大量基于深度学习的语义分割工作相继被提出[13-16]。目前主要可以分为基于全卷积网络(FCN)[17]、卷积神经网络(CNN)[18]、循环神经网络(RNN)[19]和对抗神经网络(GAN)[20]4种。与此同时,还衍生出基于深度学习的显著目标分割和医学图像分割等应用。

2 MiCOD数据集的构建

2.1 数据集构建的必要性

数据集的质量直接决定了网络模型训练的优劣,在极大程度上影响着模型的落地应用。而伪装目标数据集的制作十分困难,因为伪装目标和背景有较高的“融合度”,相似性极强,难以区分目标和背景的分界线。当前使用量最多的通用伪装目标数据集主要有2个:1)CAMO数据集包含8个种类的 1 250张伪装图像[21];2)COD10K通用伪装目标数据集,具有78子类的10 000张图像,该数据集标注十分精细,具有相当大的挑战性[8]。

军用伪装目标由于价值极高,难以获取公开的图像和数据,制备难度极大,并且在真实的战场环境中伪装目标并不是时时刻刻出现的,大量不含伪装目标的自然场景是对网络模型的极大挑战。使用通用伪装目标数据集难以保证适用于军用伪装目标的分割,因此收集构建完备的军用伪装数据集具有极高的军事意义[22]。

2.2 数据集构建原则和方法

军用伪装数据集的构建需要满足以下原则:

1)军用伪装目标类别多样;

2)采集场景多样;

3)环境条件多样。

遵循以上条件构建的多样性军用伪装目标数据集,既能满足图像分割的基本条件,又可以防止数据量少带来的过拟合现象,还能提升网络模型的分割鲁棒性。

需要注意的是,在现实环境中伪装目标并不总是存在于所有图像中。因此在数据集中添加了大量的真实场景不含伪装目标实例的图像,以更加符合真实的战场环境,减小虚警率。

综上所述,军用伪装数据集使用可见光摄像机实地采集、网络搜集典型军用伪装目标数据相结合的方式进行构建。

2.3 数据集处理

首先对采集到的所有数据按照构建原则进行二次筛选,保留拍摄效果好、应用价值高的影像资料,剔除无用数据。编程实现视频取帧,生成连续的图像数据。

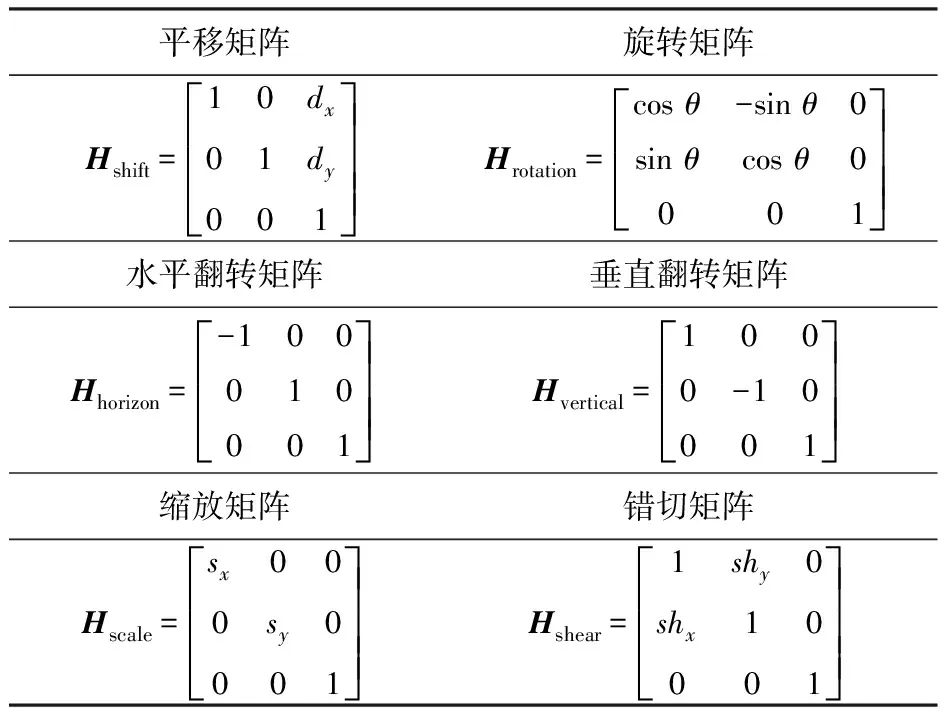

其次通过数据增广缓解样本数量少、分布不均衡的情况。为保证增广后的数据满足实际环境,内容自然,采用随机增广策略,按照随机概率对数据进行平移、水平/垂直翻转、旋转、缩放、裁剪、剪切、对比度处理、色彩抖动处理等操作。对比度和色彩变化等操作通过Pytorch函数实现。图像变换公式为

(1)

式中:xorg和yorg表示变换前的图像坐标;xpro和ypro表示变换后的图像坐标;H表示变换矩阵,包括但不限于表1内的变换矩阵。表1中,Hshift为平移矩阵,dx和dy为横纵坐标移动的距离常数,Hrotation为旋转矩阵,θ为顺时针旋转角,Hhorizon为水平翻转矩阵,Hvertical为垂直翻转矩阵,Hscale为缩放矩阵,sx和sy为水平缩放因子和垂直缩放因子,Hshear为错切矩阵,shx和shy为水平错切角和垂直错切角。此外,数据增广还可采用组合增广(多矩阵相乘)的方式。

表1 变换矩阵

而后通过标注工具Labelme对数据集进行像素级分割标注,获取数据集中所有的分割真值图(GT),用于模型的分割训练和测试结构的精确验证。

2.4 数据集概述

通过2.3节的数据集处理步骤,最终构建出所需的MiCOD,数据集的概况如表2所示,共4 000张。数据集处理后按照一一对应命名放置,每一类的示例图如图2所示。

图2 数据集示例(左为RGB图像,右为真值图)Fig.2 Example of dataset (RGB images on the left, GT maps on the right)

表2 数据集概况

3 COSNet目标分割模型

Hall等[23]通过实验证明,识别图像中的伪装目标与注意力集中程度和观测时间呈正比。这是因为当人观测一幅图像时,往往会首先关注图像中的显著区域,但当集中注意力避免分心时,便可以聚焦搜索到图像中的可疑区域,进而以此为中心,逐步增大观测面积直至确定目标。

图3 COSNet目标分割模型网络结构聚焦放大模块真值图Fig.3 Network structure of COSNet object segmentation model

(2)

下面分别对3个组成部分和损失函数的设计思路和具体实现进行详细论述。

3.1 特征提取模块

3.2 聚焦放大模块

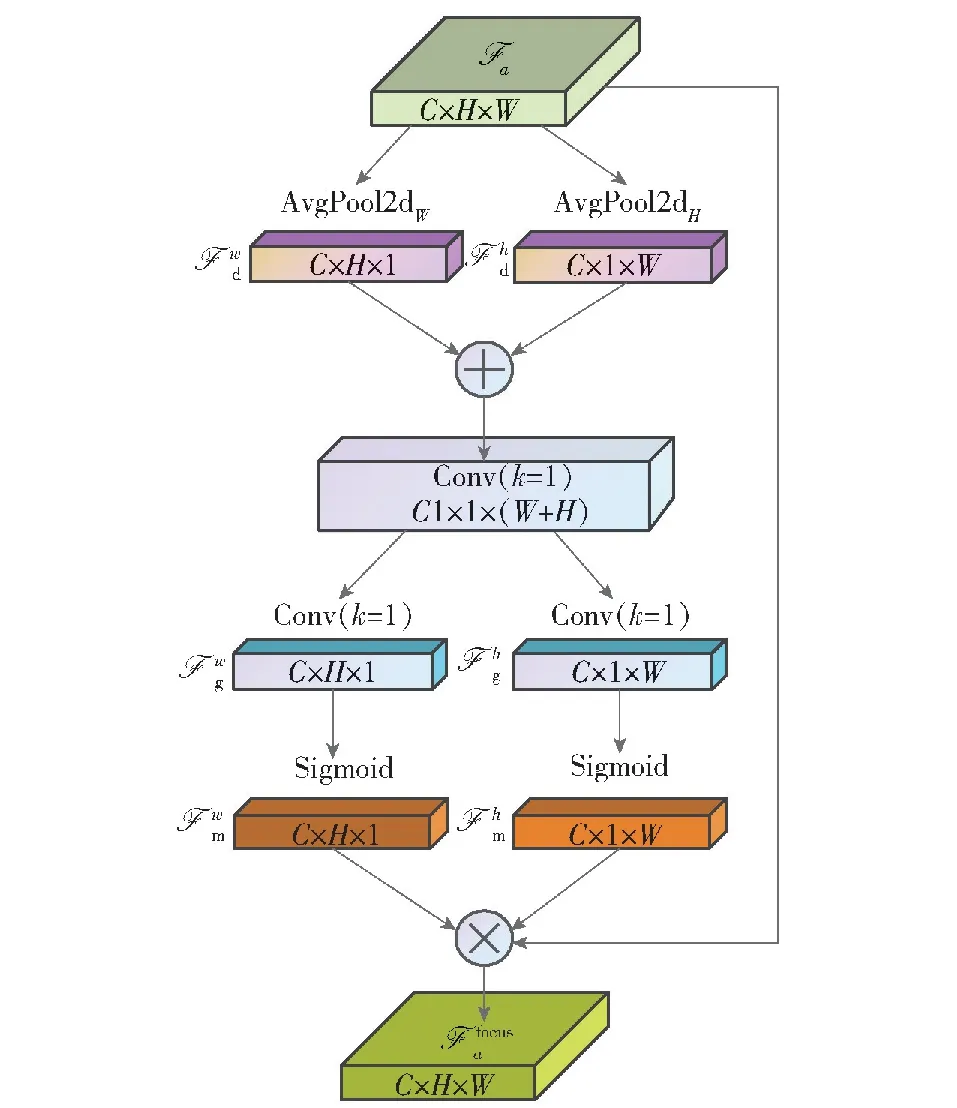

3.2.1 关键点聚焦模块KPFM

图4 关键点聚焦模块结构图Fig.4 Diagram of KPFM structure

(3)

(4)

(5)

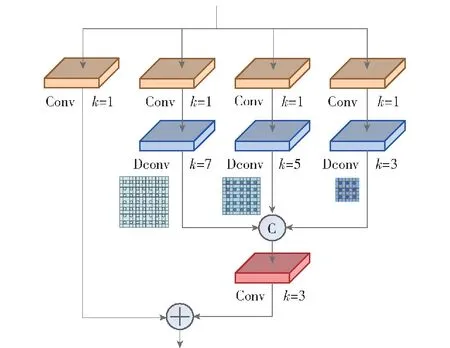

3.2.2 感受野放大模块RFAM

图5 感受野放大模块结构图Fig.5 Diagram of RFAM structure

3.3 多尺度特征图融合模块

(6)

算法1多尺度特征图融合模块。

# 1.首轮融合操作

# 2.次轮融合操作

# 3.末轮生成操作

3.4 关键点区域加权感知损失函数

在大量的目标分割算法中,二元交叉熵(BCE)函数和交并比(IOU)损失最为常见[25]。然而BCE损失和IOU损失平均处理每个像素点的方式不能适用于伪装目标检测。在图像中,伪装物体相比于其他物体(尤其是显著性物体),由于其难以分辨的特性,需要更加关注。

结合设计的聚焦放大模块,本文提出一种关键点区域加权感知损失Lkawa,在BCE损失和IOU损失的基础上,加入关键点区域感知权重,联合得到Lkawa损失函数:

Lkawa=Lwbce(P,GT)+Lwiou(P,GT)

(7)

(8)

(9)

式中:P为预测图;GT为真值图;Lbce(P,GT)为原始BCE损失函数;wij为关键点区域感知权重,

(10)

2)范围越大越需要更大的计算量,意味着训练速度越慢,因此应使用保证有效的最小值;

3) 应避免出现权重等于1/2的情况,故选取奇数。

总结以上3点,本文选取17×17大小的区域范围。从式(10)中可以看出,无论伪装目标在该区域的占比如何,关键点区域感知权重均能给予伪装目标较高的关注度,从而使得模型训练朝着有利于分割伪装目标的方向进行。

4 实验结果与分析

4.1 实验平台配置

实验训练测试阶段使用的硬件平台配置为:显卡为NVIDIA Quadro GV100,显存为32 GB,使用Pytorch深度学习开发框架。CPU为Inter Xeon Silver 4210,操作系统为Windows 10操作系统。训练时使用Adam优化器进行网络优化,图片输入大小设置为352×352,学习率设置为0.000 1。

4.2 数据集设置

采用3种设置方式对网络和训练方式进行综合性评估:

1)遵循通用伪装目标数据集的设置方式,假设每幅图像均含有伪装目标。即只在包含伪装目标的图像上进行训练和测试。将2 700张含有伪装目标的图像采用6∶2∶2的比例划分为训练集、验证集和测试集。此种训练方式更能证明网络的分割准确性的高低。

2)模拟真实的战场环境,即伪装目标并不总是在视场中出现,即在所有图像上进行训练和测试。将4 000张图像采用6∶2∶2的比例划分为训练集、验证集和测试集。此种训练方式更能证明网络的分割虚警率的高低。

3)为证明COSNet算法的泛化性,使用公开的通用伪装目标数据集进行综合性评估。通用伪装目标数据集选取CAMO[21]以及COD10K数据集[8],CAMO有1 250张图像,COD10K有5 066张伪装图像,一共组合为6 316张图像,按照6∶2∶2的比例划分为训练集、验证集和测试集。

4.3 评价指标

目前适用于COS的指标很多,各项指标关注点均不同,选取了8种常用的评价指标。平均绝对误差(MAE)计算的是预测图和真值对应位置之间的像素差异的绝对值之和[26];结构度量Sm是一种结构相似性评价指标,着重评估预测图的结构信息[27];自适应E-MeasureadpEm可以评估像素级相似效果,也可以获取图像级统计信息[28];自适应F-MeasureadpFm是一种综合的关于预测图精确度和召回率的评估方法[29];平均dice系数Dicmean用以计算分割准确的面积占GT图像中真实面积的百分比[30];平均交并比IOUmean计算的是分割预测图和GT图之间的交集与并集的面积比;平均灵敏度Senmean可以衡量实际为正样本的结果有多少被预测为了正样本,灵敏度越高则漏检率越低;平均特异度Spemean可以衡量实际为负样本的结果有多少被预测为了负样本,特异度越高,虚警率就越低。

4.4 对比算法

为了证明本文COSNet算法的有效性,选取8个经典算法以及最新算法进行比较。其中包括医学图像分割算法UNet++[31]、PraNet[32]、UACANet-L[33],显著性目标分割算法BASNet[34]、SCRN[35]、F3Net[25]和COS算法SINet-V1[8]、PFNet[9]。

为了公平地比较算法的分割性能,所有算法均采用4.1节提出的实验配置平台和实验参数设置,输入尺寸均设置为352×352。此外,评价指标的计算均采用同一套代码。评测代码、测试图片及评测结果将公布在:https:∥github.com/jiangxinhao2020/COD-eval。

4.5 对比实验结果分析

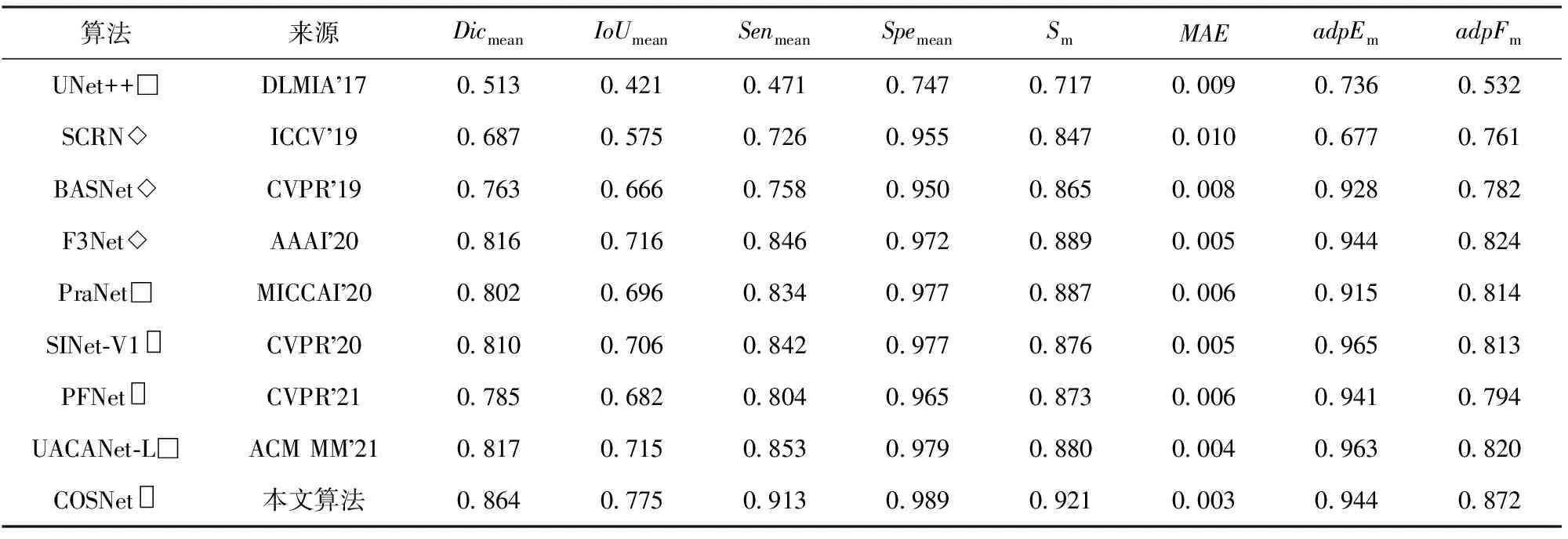

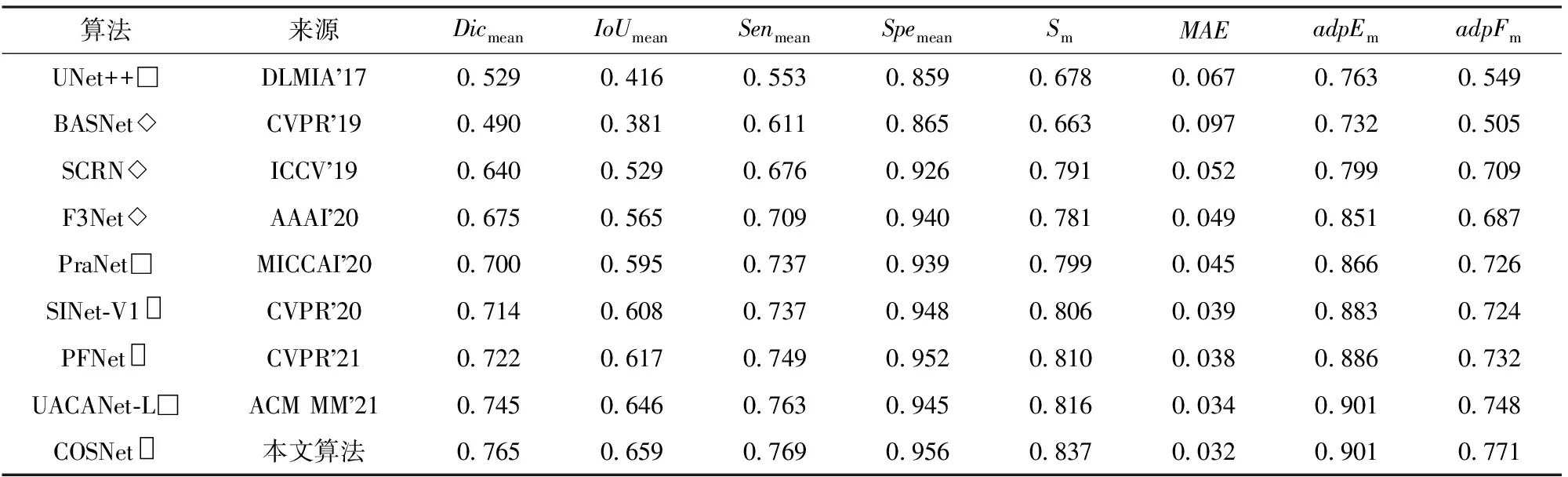

4.5.1 对比结果1(每幅图片均含有伪装目标)

表3为本文COSNet算法与其他8种算法在MiCOD数据集上的实验对比结果。由于每张图像上均有伪装目标,对于各种优秀网络的挑战性不强,主要体现了网络本身的特征提取能力和分割精准度。由表3可以看出,COSNet算法在7项指标上达到最优,综合分割能力最好,尤其是平均灵敏度Senmean较最新算法UACANet-L提升了6%,这意味着COSNet算法具有最低的漏检率。由于每张图像均有伪装目标,故每种模型的平均特异度Spemean值均比较高,而COSNet算法仍高出1%,即说明COSNet算法同时具有最低的虚警率。漏检率和虚警率的平衡在实际应用中尤为重要,代表了网络模型的稳定性。

表3 在自建MiCOD数据集上的对比实验结果1(每幅图片均含有伪装目标)

注:□表示医学图像分割算法,◇表示显著性目标分割算法,▯表示COS算法。

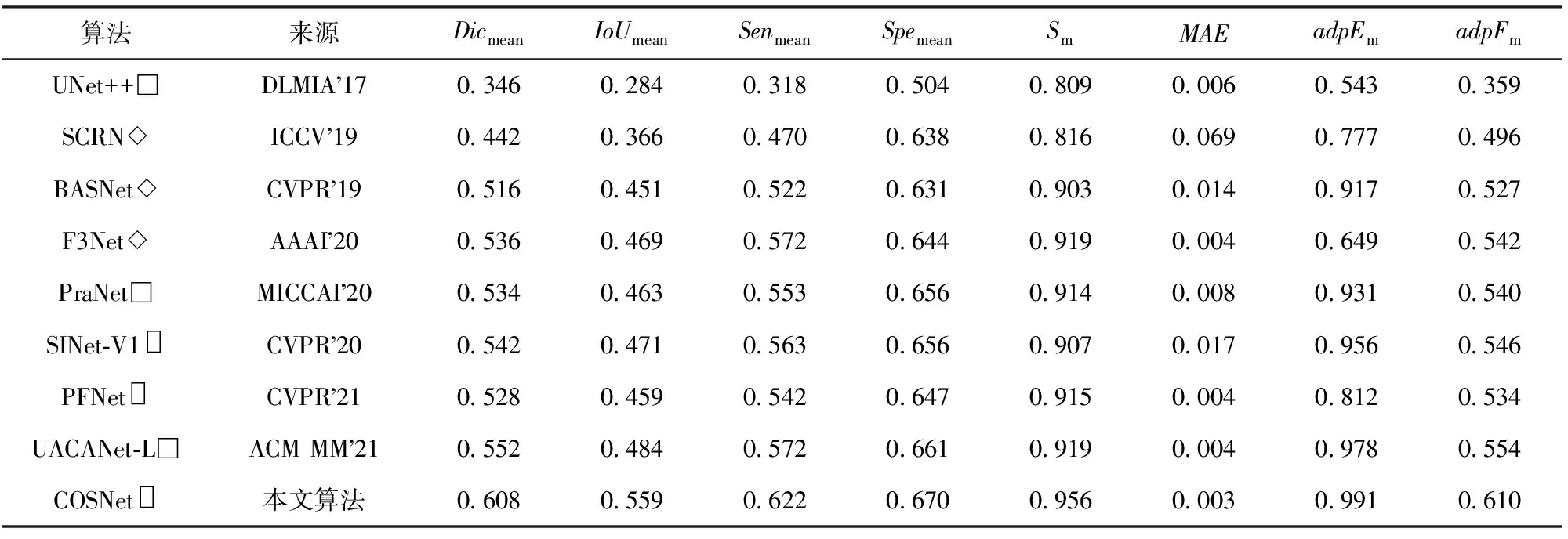

4.5.2 对比结果2(模拟真实环境,每幅图片不总是含有伪装目标)

表4为模拟真实环境,数据集4 000张图片全部参与训练测试时的实验结果。从表4中可以看出,相较于设置方式1的评价结果,仅有Sm和adpEm整体有所提升,这是因为Sm评估的是预测图和真值图之间的结构相似性,adpEm的评价计算中则涉及全局统计平均值,大量不含伪装目标的图像使得这两项指标平均下来得分较高。而其他评价指标下降较大,表明模拟真实环境的MiCOD数据集对于目标分割网络模型十分具有挑战性。但在本文实验中,COSNet算法在8项指标上均优于其他算法,其中,平均交并比IOUmean提升最为明显,较最新算法UACANet-L大幅提升了7.5%,实现了性能的显著增强,证明了本文提出的COSNet算法在MiCOD数据集上的有效性和精准性。

表4 在自建MiCOD数据集上的对比实验结果2(每幅图片不总是含有伪装目标)

表5为本节在自建MiCOD数据集对比实验的可视化对比结果。由表5可以看出,COSNet算法能够更加精准地分割出伪装目标。关键点聚焦模块通过模拟人类视觉注意力机制,可以获取通道上和空间上更为重要的信息,从而可以精准分割出伪装目标的细节区域(如图像5坦克顶部的细节区域)。感受野放大模块通过放大感受野和融合多尺度特征可以较好地识别出隐藏在复杂背景中的小目标和细长目标(如图像1中士兵手持的武器)。关键点区域加权感知损失函数的引入使得网络模型更加关注伪装目标关键点附近区域,从而减少分割虚警率(如最后一列不含伪装目标的背景图)。

表5 在自建MiCOD数据集上的可视化对比结果

4.5.3 对比结果3(通用伪装目标数据集)

COSNet算法与其他8种算法在通用伪装目标数据集上的实验结果对比如表6所示。由表6可以看出,通用伪装目标数据集类别比较复杂,但COSNet算法仍能在7项指标上优于其他算法,其中提升最明显的是adpFm,比UACANet-L算法提升了2.3%,仅有adpEm指标与UACANet-L算法持平。综合分析来看,COSNet在通用COS数据集上的泛化性能良好,证明了COSNet算法在COS这一任务上的优势。

表6 在通用伪装目标数据集上的对比实验结果

表7为通用伪装目标数据集全部对比实验的可视化结果。由表7可以看出,COSNet算法可以较好地排除其他干扰,精准定位伪装目标关键点,且能够清晰地识别出目标轮廓。依赖于关键点聚焦模块,模型可以精准分割出如图像1中昆虫触须等细节区域,感受野放大模块则使得模型可以适用于各个尺度的伪装目标,如图像4中的小目标也能较好地分割出来。关键点区域加权感知损失函数则通过权重的变化使得网络模型能够处理如图像3伪装目标被部分遮挡的情况。

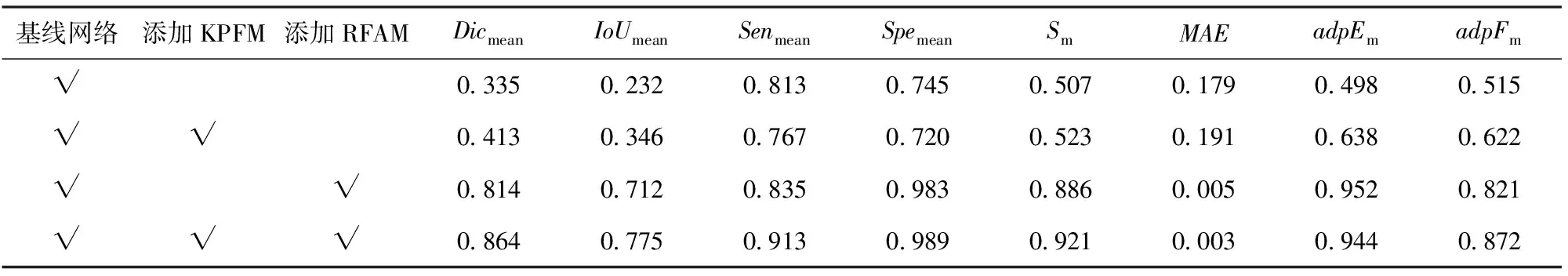

4.6 模块消融实验结果分析

为验证针对性设计的两个仿生模块(即关键点聚焦模块KPFM和感受野放大模块RFAM)的有效性,在数据集第1种设置方式(即每幅图片均含伪装目标)的条件下进行了消融实验。

表8全面展示了COSNet算法的消融实验结果(√表示使用该模块)。从表8中可以发现,分别单独添加两个模块后,对模型性能均有不同程度的提高。其中,单独添加关键点聚焦模块KPFM,对各项指标虽提高不明显,但该模块的效果主要体现在对辨别特征图的重要程度上(见定性分析);而单独添加感受野放大模块RFAM后,使得adpEm达到最优,这是因为RFAM的感受野放大机制起了作用,提升了像素级相似效果,通过多尺度特征提取,实现了全局图像级统计信息的高效利用。最终的融合图则达到了性能上的综合最优效果。

表8 在自建MiCOD数据集上的消融实验结果

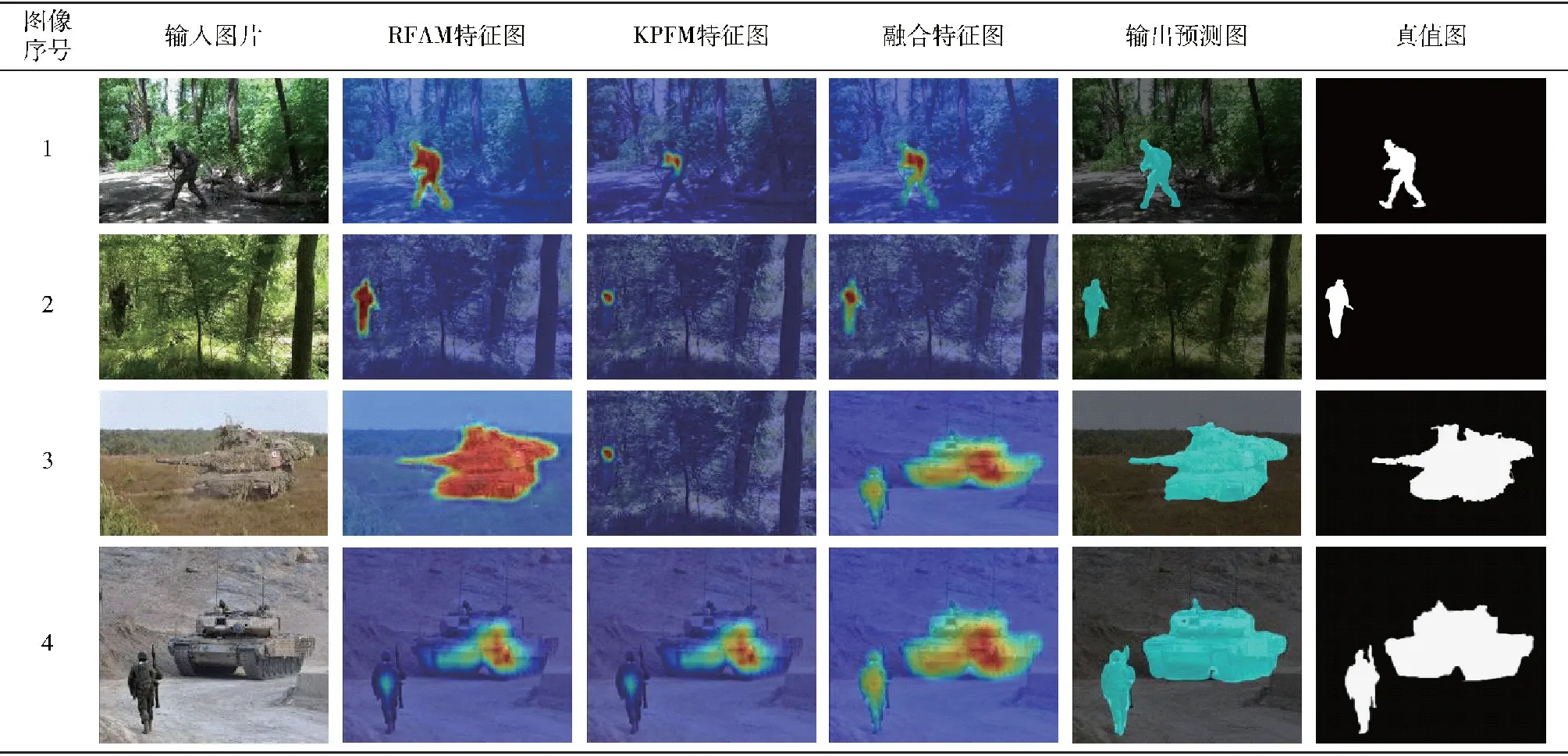

将关键点聚焦模块KPFM和感受野放大模块RFAM输出的特征图进行可视化,并与最终融合后的特征图进行对比,结果如表9所示。KPFM输出的特征图证明了该模块更加关注伪装目标的关键点,即目标中心区域,确保模型能够找到正确的伪装目标,从而降低复杂环境下目标分割的虚警率;而RFAM模块在找到关键点的基础上,通过增大观测感受野,从全局出发寻找伪装目标,从而保留更多伪装目标的重要信息,可以有效解决多尺度目标分割的难题。融合后的输出伪装特征图结合了两个模块的特点,实现了仿生人类视觉系统探测目标的过程,可以以伪装目标中心为关键点,通过放大感受野,精准寻找关键点附近伪装目标的重要信息,以提高分割的准确性,使得分割的漏检率和虚警率实现较好的平衡。

表9 在自建MiCOD数据集上的消融实验可视化对比结果

5 结论

为了实现更加精准的COS,本文从数据集和网络模型两方面入手开展研究。首先依据现实需求和真实战场环境,构建了军用伪装目标数据集MiCOD,共4 000张图片,均为像素级标注。然后通过仿生人类视觉系统构建了COS网络—COSNet,针对性设计了串行的关键点聚焦模块和感受野放大模块,且提出了更加适用的关键点区域加权感知损失函数。

在自建的MiCOD数据集和通用伪装目标数据集上进行了充分的对比实验,证明了COSNet在COS方面的综合性性能优势,8项指标均达到最优效果,且通过消融实验证明了COSNet关键模块的作用原理和仿生效果。

使用模拟真实战场环境的数据集时,COSNet平均灵敏度Senmean为0.622,平均特异度Spemean为0.670,表明自建的MiCOD数据集具有一定的挑战性,各项指标仍有很大的提高空间,可为后续COS的研究提供较好的数据支持。