ChatGPT背后的黑科技,主宰高算力的CPO技术

郭勇

ChatGPT引爆算力需求

作为人工智能三大核心要素之一,算力也被誉为人工智能“发动机”。

ChatGPT用户数快速增长,需求量火爆引发宕机。ChatGPT自发布以来用户数量快速增长。在庞大用户群涌入的情况下,ChatGPT服务器2天宕机5次,火爆程度引人注目的同时也催生了对算力基础设施建设更高的要求。以ChatGPT为例,其在模型训练阶段每次升级需要投入约3422万元,该笔投入相较于运营阶段来说规模较小。在模型上线运营阶段,机构测算每亿活跃用户将带来13.5EFlops的算力需求,需要6.9万台NVIDIADGXA10080G服务器支撑。

根据中国信通院数据,2021年全球计算设备算力总规模达到615EFlops,其中超算算力规模为14EFlops。换而言之,在每个用户每天收到1500字回答的情况下,以2021年全球超算算力的规模,仅能支撑ChatGPT最多拥有1亿日均上线人数。假设全球6家科技巨头能够在未来3年内各自拥有一款活跃人数2亿的ChatGPT类应用,则有望带来162EFlops超算算力需求,超算算力需求较目前提升空间超过10倍。

打破算力瓶颈的CPO技术

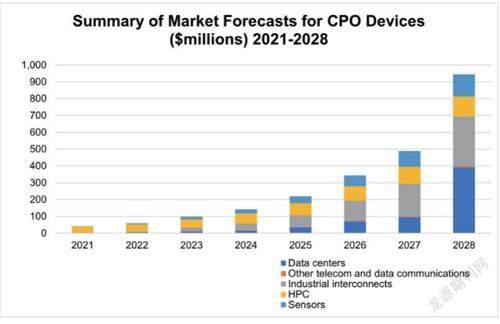

不同服务器之间需要频繁的大量数据交换,数据互联的带宽往往会限制整体任务的性能,这成为数据中心引入超高带宽基于硅光子的数据互联的主要理由。而CPO共同封装光子是业界公认未来高速率产品形态,是未来解决高速光电子的散热和功耗问题的最优解决方案之一。

共封装光学CPO(co-packagedoptics),指的是将光引擎和交换芯片共同封装在一起的光电共封装。较之传统方案中(实现光电转换功能的)可插拔光模块插在交换机前面板的形式,CPO方案显著缩短了交换芯片和(实现光电转换功能的)光引擎之间的距离,使得损耗减少,高速电信号能够高质量地在两者之间传输,同时提升了集成度并能够降低功耗,整体优势显著。在最新的OCP峰会上,英伟达代表表示AI所需的网络连接带宽将增加32倍,当前光模块速率已无法满足这一带宽提升需求。继续使用光模块会带来成本翻倍和20%-25%的额外功耗。为此需要新的激光器和调制器设计,并且CPO方案可能将功耗降低50%。

提前布局的科技巨头

技术和经济上的双重优势,让科技巨头们争相涌入CPO赛道,目前AWS、微软、Meta、谷歌等云计算巨头,思科、博通、Marvell、IBM、英特尔、英伟达、AMD、台积电、格芯、Ranovus等网络设备龙头及芯片龙头,均前瞻性地布局CPO相关技术及产品,并推进CPO标准化工作——

在数据中心领域,CPO技术可以实现更高的数据密度和更快的数据传输速度,可以应用于高速网络交换、服务器互联和分布式存储等领域。例如,Facebook在其自研的数据中心网络FabricAggregator中采用了CPO技术,将光模块和芯片封装在同一个封装体中,从而提高了网络的速度和质量。

在云计算领域,CPO技术可以实现高速云计算和大规模数据处理。例如,微软在其云计算平台Azure中采用了CPO技术,将光模块和芯片封装在同一块PCB板上,并使用微型化的线缆连接光模块和芯片。

在5G通信领域,CPO技术可以实现更快的无线数据传输和更稳定的网络连接。例如,华为在其5G通信系统中采用了CPO技术,将收发器和芯片封装在同一个封装体中,从而实现了高速、高密度、低功耗的通信。

争夺算力霸权时代话语权

AIGC热潮驱动下,全球科技龙头的军备竞赛已经打响,CPO正站在风口的风口,既处在未来“卡脖子”数据传输通道,有着大厂们的集体背书,也有多个大赛道的加持,这背后除需要企业投入资源竞争外,更需要管理层的支持。

2020年,业界开始对发展CPO标准形成共识。国外COBO和OIF等行业组织成立了工作组,国内中科院计算所牵头成立CCITA联盟(中国计算机互联技术联盟),为制订前沿互聯技术标准筹备相关工作。现阶段,国内外CPO标准进程基本相近,均已初步完成规格草案的撰写。CCITA联盟于2021年5月启动在中国电子标准化协会的国内CPO标准立项工作,联合了超过40家会员厂商,规划交换机及网卡CPO应用场景的规格标准。

不过我国光芯片产业起步较晚,技术实力与国外企业相比有一定差距,国内相关企业仅在2.5G和10G光芯片领域实现核心技术的掌握,根据ICC的数据,2.5G及以下速率光芯片国产化率超过90%;10G光芯片国产化率约60%,II-VI、Lumentum等外企牢牢占据高功率光芯片主要市场份额,而近年来随着天孚通信、新易盛、联特科技等布局“CPO技术”的核心企业崛起,我国有望在硅光、CPO等前沿技术领域取得突破。