基于可见光与红外卫星图像融合的舰船目标检测

赵炜东,郭鹏宇,刘 勇,曹 璐,杨伟丽,季明江

(军事科学院 国防科技创新研究院,北京 100071)

0 引言

舰船目标检测具有很高的民用与军用价值。我国是一个海洋大国,拥有丰富的海洋资源,随着经济贸易的发展,我国的水上交通越来越发达,舰船的数量快速增长,对港口航道等区域进行舰船监控管理,有利于我国水运资源的合理运用[1]。同时,舰船目标作为战场侦察的重要目标,需要获取舰船目标的准确信息以进行军事部署,舰船目标的精确检测对维护我国海洋安全与实现走向深蓝的海军战略具有重大意义[2]。随着科学技术的发展,卫星图像的分辨率不断提高,不同种类的卫星图像为舰船目标的检测提供了有力的数据支撑[3]。同时,在区域卷积神经网络(Region-Convolutional Neural Network,R-CNN)[4]提出之后,深度学习逐渐成为了目标检测领域的主流工具,研究基于深度学习的舰船目标检测方法,可以提高舰船检测的准确性、实时性和鲁棒性,满足舰船目标智能检测的需求[5]。

研究人员针对舰船目标的检测,开展了大量的工作。文献[6]将注意力机制引入多尺度特征融合网络精炼模型,通过旋转锚框缓解舰船密集排列引起的噪声问题,并且设计特征重建模块缓解特征不对齐的问题,在公开数据集上验证了算法有效性;文献[7]通过在单射检测器(Single-Shot Detector,SSD)[8]网络的浅层添加串行修正线性单元(Concatenated Rectified Linear Units,CReLU)[9],提升了网络传递浅层特征的效率,并且采用特征金字塔网络(Feature Pyramid Network,FPN)[10]融合多尺度特征图,在舰船小目标检测上取得了10%的检测精度提升;文献[11]在检测框架中引入场景分割,通过排除非目标区的错误候选目标,减小了复杂场景对舰船目标检测的干扰。文献[12]使用稠密网络模块代替用于提取中小尺度特征的残差网络模块,实现端到端的目标检测,提升了舰船目标检测算法的泛化能力。

但是,以上工作都在单一模式图像的基础上开展研究,算法的检测性能由于图像自身的特点受到限制,传统的单一模式图像检测在复杂场景下面临着巨大的挑战。目前卫星遥感成像手段呈现多样化的趋势,有多光谱、高光谱、红外、合成孔径雷达、夜光等多种卫星遥感影像[13]。在同一场景下,同一地物对象的卫星遥感影像由于类型不同,目标的空间特征和谱段特征存在差异,多源信息具有互补性和合作性,同时也具有冗余性[14]。研究人员逐渐将目光聚焦于构建多模态输入的神经网络用于目标检测,探索了可见光+热图像、可见光+深度图、可见光+激光雷达等多种模态融合方式[15]。可见光卫星图像具有分辨率高且获取代价低、颜色纹理特征清晰的优点,但是易受天气干扰,在背景复杂、有云雾遮挡的情况下,会出现舰船目标的错检、漏检[16]。红外卫星图像相较于可见光卫星图像,分辨率较低,舰船目标边缘纹理不清晰,但具有不易受干扰、可全天候观测、云雾穿透能力强等优点[17]。

不同情况下可见光图像与红外图像如图1 所示。分别对比了在一般场景、云雾遮挡、海岸干扰情况下针对同一场景拍摄的舰船目标可见光遥感图像与红外遥感图像,显著舰船目标用红色方框标记,模糊舰船目标用红色圆框标记。可以看出在一般场景下,可见光遥感图像中的舰船目标颜色纹理信息更清晰;在云雾干扰下,可见光遥感图像中的舰船目标被云雾遮挡,难以观测,红外遥感图像可穿透云雾,使得舰船目标更加显著;在海岸干扰下,可见光遥感图像中的舰船目标紧贴海岸难以区分,红外遥感图像中的舰船目标与背景的区分度更高,特征更为显著。

图1 不同情况下可见光图像与红外图像的对比Fig.1 Comparison of visible images and infrared images under different conditions

目前,国内外已有多颗卫星可以实现可见光与红外波段的覆盖,如国外的Sentinel-2、Landsat8 等,国内的高分五号、资源一号02D 等,在农业、减灾、国家安全、海洋监视等领域发挥了重要作用[18]。利用可见光图像与红外图像之间的互补性,可以实现对舰船目标的联合监视,是未来天机海洋监视的重要发展趋势之一,具有广阔的应用前景。文献[19]提出了一种改进的YOLOv3[20]舰船目标检测方法,在数据集中引入舰船目标的红外图像弥补夜晚场景下可见光图像的目标信息缺失,在简化后的YOLOv3 网络中加入空间金字塔池化(Spatial Pyramid Pooling,SPP)[21]模块,提高了网络在特征提取方面的性能,提高了舰船目标的检测精度。虽然文献[19]通过在数据集中引入红外图像提高了舰船目标的检测精度,但没有进一步对可见光与红外图像之间的联合目标检测展开研究,且文中所用数据集均为安防相机拍摄的舰船目标图像,提出的算法并不适用于天基舰船目标检测。

为探究可见光与红外卫星图像的互补性,提升舰船目标检测算法的性能,本文开展了基于可见光与红外卫星图像的舰船目标检测算法研究。由于公开数据中,没有已配准的可见光/红外舰船目标数据集,制作了可见光和红外舰船目标(Visible and Infrared Ship,VI-ship)数据集。本文提出了基于可见光与红外卫星图像融合的舰船目标检测算法VIYOLOv5,以YOLOv5 中的CSP-Darknet53 网络为骨干网络,构建了可见光+红外卫星图像的双模态融合网络,同时提取目标空间特征与谱段特征;加入快速空间金字塔池化(Spatial Pyramid Pooling FAST,SPPF)模块,在增强网络特征提取能力的同时提升了检测精度和检测速度;通过引入SIoU[22]损失函数,降低了网络回归的自由度,加快了网络收敛,提升了回归精度。在VI-ship 数据集上的实验结果表明VI-YOLOv5 算法具有较好的检测性能,验证了可见光与红外卫星图像联合的舰船目标检测算法的有效性。

1 算法设计

本文设计算法VI-YOLOv5 在输入端构建可见光与红外图像融合输入网络,在骨干网络中引入了受跨阶段局部网络(CSPNet)[23]启发的CSP 结构,将基础层的特征映射划分为两部分,然后通过跨阶段层次结构将它们合并,在减少计算量的同时保证了准确率。在网络颈部引入SPPF 模块以及特征金字塔网络(FPN)+像素聚合网络(Pixel Aggregation Network,PAN)[24]的特征融合结构,加强了网络的特征融合能力。在继承YOLO[25]系列网络的基础上实现了进一步的性能提升,网络结构如图2 所示。图中,CBS 是由卷积层(Conv)、批归一化层(BN)和双弯曲线性单元(SiLU)组成的模块,CSP 是由若干CBS 模块和拼接层(Concat)组成的模块。

1.1 可见光与红外卫星图像双模态融合输入网络

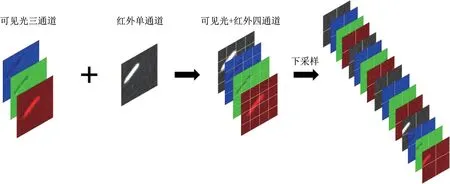

原始的YOLOv5 网络输入为可见光三通道图像,随着网络层数不断加深,深层网络会不断丢弃目标的细节特征,在复杂场景下由于舰船目标特征严重损失将导致检测性能的下降。为了弥补这一过程中的舰船目标特征损失,将红外卫星图像引入检测网络,在原有的可见光输入通道基础上,增加红外输入通道,将红外图像与可见光图像合并为一个四通道图像后送入网络。经过一系列数据增强操作后,将送入网络中的原始数据切分为4 份,相当于对原始数据进行2 倍下采样,之后在channel 维度进行拼接。最后进行卷积操作,得到了没有信息丢失情况下的2 倍下采样特征图,在不影响计算速度的情况下引入了红外卫星图像。图像融合过程如图3 所示。

图3 图像融合Fig.3 Schematic diagram of image fusion

网络将输入图像划分为s×s个网格单元,每个网格单元产生n个预测框、预测框的置信度以及分类概率,每个预测框有6 个预测值,即x、y、w、h、置信度得分和分类概率。坐标(x,y)表示预测框的中心相对于网格单元的位置,框尺寸(w,h)是预测框的宽度和高度,置信度分数表示预测框的正确性,最终检测输出张量的大小为s×s×6。

1.2 引入SPPF 模块的特征融合网络

为了缓解图形畸变引起的信息丢失,减少卷积运算,YOLOv5 网络引入了空间金字塔池化模块,其工作原理是对接收到的特征图进行三种不同尺度的最大池化后对特征向量进行拼接,得到固定大小的特征向量,可将任意尺寸的特征图转换成固定大小的特征向量,进而实现局部特征和全局特征的融合,丰富了特征图的表达能力。当待检目标大小差异较大时,可以提高检测的精度。本文引入的快速空间金字塔池化(SPPF)结构相较于空间金字塔池化结构,改变了池化层的下采样倍数,用三个串行的卷积核尺寸为5×5 的最大池化层代替了原本并行的卷积核分别为5×5、9×9 和13×13 的三个最大池化层。当输入为一个64×64×3×1 的张量时,空间金字塔池化模块和快速空间金字塔池化模块最终会输出一个结果相同的64×64×3×1的张量,对精度不会产生影响,但是快速空间金字塔池化具有更少的计算量和更快的速度,在多尺度特征提取中保留了更多信息,空间金字塔池化模块与快速空间金字塔池化模块的结构如图4 所示。

图4 SPP 和SPPF 结 构Fig.4 Diagram of SPP and SPPF structures

1.3 引入向量角度的SIoU 损失函数

VI-YOLOv5 的损失函数由定位损失、分类损失和置信度损失三部分构成,其中定位损失采用SIoU 损失函数描述,分类损失和置信度损失采用二元交叉熵损失函数描述。相较于YOLOv5 用于描述定位损失的CIoU 损失函数,SIoU 损失函数进一步引入检测框与目标框之间的向量角度,利用了更多位置信息。添加向量角度约束之后,抑制了检测框位置在平面上的自由变化,使得检测框在一个更合理的范围内向目标框逼近,加快网络收敛的同时提升了网络精度。向量角度对定位的贡献如图5 所示,图中,B为检测框,BGT为目标框,α为向量角度。

图5 向量角度Fig.5 Schematic diagram of the vector angle

SIoU 定位损失的计算公式如下:

式中:IoU 为检测框与目标框之间的交并比;Δ为距离损失;Ω为形状损失;Λ为角度损失;α为检测框与目标框中心连线与水平轴的夹角;bcx、bcy分别为边界框中心点的横纵坐标;cw、ch为两边界框外接矩形的宽与高;θ定义形状成本,控制对形状损失的注意力;wb、hb分别为边界框的宽与高。

由公式可知,当α→0 时,距离损失趋于常数,降低了网络回归的自由度,加快了网络收敛,提升了回归精度。

分类损失与置信度损失的表达式如下:

式中:m为每个网格产生的候选框数目;p(c)为类c的分类概率;C为置信度,将定位损失、分类损失与置信度损失三者相加即为总的损失函数。

2 实验内容及结果分析

本文实验环境为图像工作站,包含一块NVIDIA RTX3090GPU,CUDA 版本为11.5,CUDNN 版本为8.3.0,处理器为Intel I7 7800X。舰船目标数据来自于自主标注的Sentinel-2 卫星图像,包含一一对应的可见光与红外图像共2 280 张,按照7∶2∶1 的比例划分为训练集、验证集与测试集。评价指标选择VOC2007 平均精度(mAP_0.5)、精 度、召回率、F1 值及检测速度,选用SGD 优化器,设置初始学习率为0.01,动量为0.937,权重衰减为0.000 5。

2.1 VI-ship 数据集制作

目前公开的舰船目标光学遥感图像数据集均由可见光遥感图像构成,不包含本文研究所需的舰船目标红外遥感图像,无法满足本文的研究需求,需要自行制作同时包含可见光与红外遥感图像的舰船目标联合数据集。

Sentinel-2 是欧空局的高分辨率多光谱成像卫星,且数据公开,卫星包含13 个光谱波段,通过对卫星多光谱遥感图像的处理可以得到一一对应的可见光遥感图像与红外遥感图像,进而可以得到满足本文实验所需的舰船目标可见光和红外遥感图像联合数据集。选取多张Sentinel-2 卫星图像,包含多云、海岸等多个复杂场景。在ENVI 软件中对卫星图像进行处理,将可见光三通道数据融合得到原始可见光遥感图像,提取短波红外通道数据得到原始红外遥感图像。

设置重叠间距为64 像素值,将原始图片切割为256×256 的图片,进行筛选后得到可见光与红外遥感图像一一对应的共2 280 张舰船目标遥感图像,利用LabelImg 软件对图片中的舰船目标进行矩形框标注,共标注7 500 多个舰船目标,大部分为像素值小于30×30 的舰船目标,VI-ship 数据集中一般场景、云层干扰以及海岸干扰下的可见光与红外图像如图6 所示。

图6 VI-ship 数据集中的典型样本Fig.6 Typical samples in the VI-ship dataset

2.2 对比实验

对比VI-YOLOv5可见光+红外融合检测网络在损失函数分别为SIoU 和CIoU 下的mAP_0.5、精度、召回率、F1值以及检测速度,结果见表1。

表1 SIoU 与CIoU 性能对比Tab.1 Comparison of the performances of SIoU and CIoU

实验结果表明,SIoU 损失函数相较于CIoU 损失函数同时提升了网络精度与速度,与理论分析结果一致。

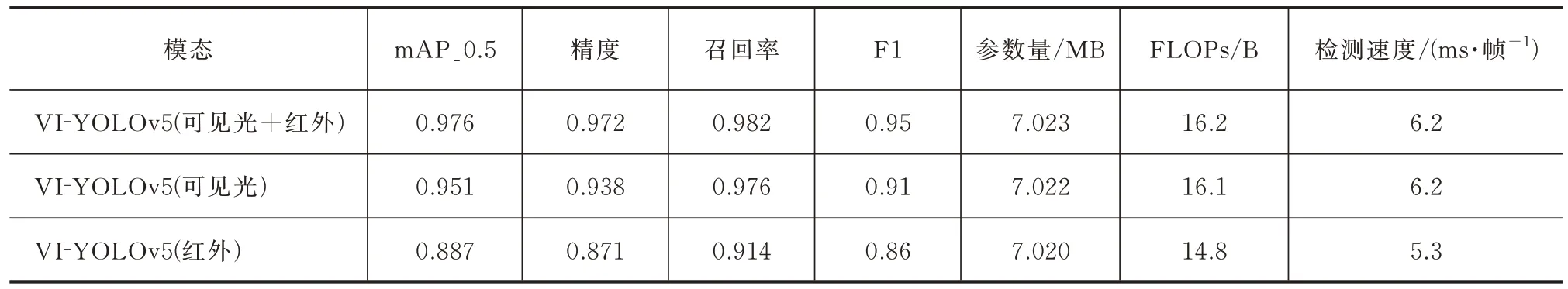

本文还对比了VI-YOLOv5 可见光+红外融合检测网络、可见光检测网络与红外检测网络的mAP_0.5、精度、召回率、F1 值、参数量、FLOPs 和检测速度。结果表明,可见光+红外双模态融合检测网络的mAP_0.5、精度、召回率和F1 值均优于单模态检测网络,三组网络的参数量均在7 MB 左右,融合检测网络由于增添了红外通道输入,参数量和FLOPs最大,但与单模态检测网络相比,性能差距不大,检测速度可达6.2 ms/帧,在保持较快检测速度的同时取得了最好的精度指标,融合检测网络的mAP_0.5 可达0.976,精度为0.972,召回率为0.982,结果见表2。

表2 融合网络与单模态网络性能对比Tab.2 Comparison of the performances of the fusion network and single-mode networks

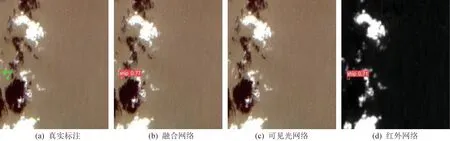

海岸干扰下的检测结果、云层干扰下的检测结果如图7 和图8 所示。结果表明,在海岸干扰下可见光网络出现了漏检,红外网络出现了错检,而融合网络正确检测出了岸边的舰船目标,且检测置信度大于红外网络;在云层干扰下,可见光网络出现了漏检,融合网络和红外网络正确检测出了舰船目标,融合网络对舰船目标的检测置信度大于红外网络。以上结果说明双模态融合网络的检测性能优于单模态网络,验证了本文提出的VI-YOLOv5 融合检测网络的有效性。

图7 海岸干扰下的检测结果对比Fig.7 Comparison of the detection results under coastal interference

图8 云层干扰下的检测结果对比Fig.8 Comparison of the detection results under cloud interference

对比VI-YOLOv5 融合检测网络与其他经典目标检测网络的各项性能指标,结果表明VI-YOLOv5融合检测网络相较于YOLOv5 平均精度提高了3.9%,且各项性能指标优于其他网络,结果见表3。

不同网络的部分检测结果如图9和图10所示。结果表明,VI-YOLOv5相较于其他网络在一般场景下可以取得最好的检测结果,在云层干扰下算法仍能保持良好的检测性能,具有较强的稳定性和抗干扰能力。

图9 一般场景下的不同网络检测结果对比Fig.9 Comparison of the detection results of different networks in general scenarios

图10 云层干扰下的不同网络检测结果对比Fig.10 Comparison of the detection results of different networks under cloud interference

3 结束语

本文针对云层遮挡、海岸干扰等复杂场景下基于光学遥感图像单模态舰船目标检测方法性能下降的问题,以YOLOv5 为基础框架,提出了VI-YOLOv5 双模态舰船目标检测网络。该网络在输入端将可见光与红外卫星图像合并,同时提取了舰船目标的空间特征和谱段特征,保留了更多目标信息,通过引入SPPF 模块与SIoU 损失函数,增强了网络的特征提取能力,提高了网络的检测性能。在自主标注舰船目标数据集VI-ship 上,VI-YOLOv5 可见光+红外融合网络的平均精度可达0.976,性能优于可见光检测网络和红外检测网络,且本文提出的网络相较于其他经典网络,检测性能也有一定的提升。实验结果表明:可见光与红外图像联合目标检测可以缓解舰船目标在云层和海岸干扰下的错检漏检问题。后续将进一步丰富数据集,增添更多复杂场景,更好地利用可见光与红外图像之间的互补性,提升算法在不同光照、天气、地形下的检测性能。