基于深度强化学习的混合动力汽车能量管理策略

陈泽宇 方志远 杨瑞鑫 于全庆,3 康铭鑫

基于深度强化学习的混合动力汽车能量管理策略

陈泽宇1,2方志远1杨瑞鑫2于全庆2,3康铭鑫1

(1. 东北大学机械工程与自动化学院 沈阳 110819 2. 北京理工大学机械与车辆学院 北京 100081 3. 哈尔滨工业大学(威海)汽车工程学院 威海 264209)

针对混合动力汽车能量管理策略在线运行时对工况适应性差的问题,提出一种具有深度强化学习能力的能量管理策略设计方法。该方法基于深度确定性策略梯度算法来确定发动机功率最佳变化率,进而建立车载能源功率分配策略。所建立的控制策略包含离线交互学习与在线更新学习双层逻辑框架,根据车辆运行特性对控制参数进行动态更新,以提高在线运行时车辆的节能效果。为了验证所提出的控制策略,以沈阳实车测试数据对算法有效性进行分析,并与粒子群优化算法的控制效果进行对比。结果表明,所提出的深度强化学习能量管理策略可以实现优于粒子群优化策略的节能效果,尤其当车辆行驶特性发生突然变化时,深度强化学习控制策略具备更强的适应性。

混合动力汽车 电源系统 能量管理策略 深度强化学习 机器学习

0 引言

混合动力汽车兼具纯电动车的清洁性与燃油汽车的动力性特点,在当前新能源汽车的产业化发展中占据重要地位[1-6]。能量管理策略(Energy Management Strategy, EMS)直接影响车辆的动力性与经济性,是混合动力汽车的关键技术之一。因此设计合理有效的EMS对于提高混合动力汽车的性能至关重要。

早期研究主要集中在基于规则的EMS与基于优化的EMS两类。其中,基于规则的EMS依靠既定控制逻辑来进行控制模式的切换,最具代表性的是能量消耗维持策略(Charge Deplete - Charge Sustain, CD-CS)方法,该方法根据电池荷电状态(State of Charge, SOC)来决策发动机的工作状态,在电池容量较高时优先使用纯电动模式,电池容量不足时开启发动机予以补充[7-9]。基于规则的控制策略简单、易于实现,但是控制效果不具备最优性。而基于优化的EMS则是通过优化控制率使车辆运行的能量消耗最小[10-11],例如文献[12]提出了一种基于动态规划(Dynamic Programming, DP)的混合动力系统EMS;文献[13]则针对DP存在的插值泄露、维度灾难等问题,改进了DP方法;文献[14]提出了一种基于模糊控制与粒子群优化(Particle Swarm Optimization, PSO)的混合动力汽车EMS;文献[15]研究了基于遗传算法(Genetic Algorithm, GA)的EMS;文献[16]提出了一种基于庞特里亚金极小值原理算法的随机模式预测控制EMS。上述基于优化的方法可以实现全局最优的控制效果,但是需要依赖已知行驶工况。文献[17]提出了一种根据地理位置信息的可变等效因子瞬时油耗最小化策略,实现次优的实时控制效果,不依赖于既定工况,但是其等效因子对控制效果影响显著,如何在实车工况下确定最佳等效因子是难点问题。

近年来随着机器学习技术的日益成熟[18-20],基于强化学习的EMS引起了广泛关注[21]。强化学习是机器学习的一个分支,通过智能体与环境的交互学习来更新策略,对复杂多变工况具有极强的学习和适应能力[22-23]。文献[24]提出了一种可以提高混合动力汽车燃油经济性的深度强化学习框架;文献[25]提出了一种新颖的基于深度Q学习(Q-learning)算法的串联式混合动力汽车EMS,通过构造两个相同结构和权值的深度Q-learning网络去逼近动作值函数,提高了整个模型的鲁棒性。文献[26]提出了一种基于双深度Q-learning的混合动力履带车辆的EMS,可以实现接近于DP的燃油经济性,并且在不同的初始SOC下也可以保持很好的性能。文献[27-28]使用仿真模拟实时行驶路线,展示了强化学习具备良好的可实现性,且可以达到与DP相近的控制效果。文献[29]提出了一种基于策略网络-评价网络算法的混合动力汽车的EMS,并在不同工况下进行了验证,可以实现较DP更低的油耗和计算成本。文献[30-31]基于深度确定性策略梯度(Deep Deterministic Policy Gradient, DDPG)算法分别提出了一种集成地形信息的混合动力公交车EMS和集成历史累积行驶信息的串联混合动力汽车EMS。

上述研究验证了深度强化学习算法可以有效用于EMS设计,但已有研究缺乏对不确定性工况的充分考虑。行车过程中驾驶员的驾驶场景经常发生变换,例如当车辆在不同道路、不同时段或不同城市运行时,EMS对工况变化的适应性十分重要。针对此,本文基于DDPG算法建立了一种具有在线更新学习机制的插电式混合动力汽车(Plug-in Hybrid Electric Vehicle, PHEV)深度强化学习EMS,并基于实车数据进行分析验证。结果表明,所提出的控制策略具备对不确定性工况的良好适应性,且在行驶条件发生变化时具备在线学习能力,能够显著改善车辆全工况条件下的节能效果。

1 系统模型

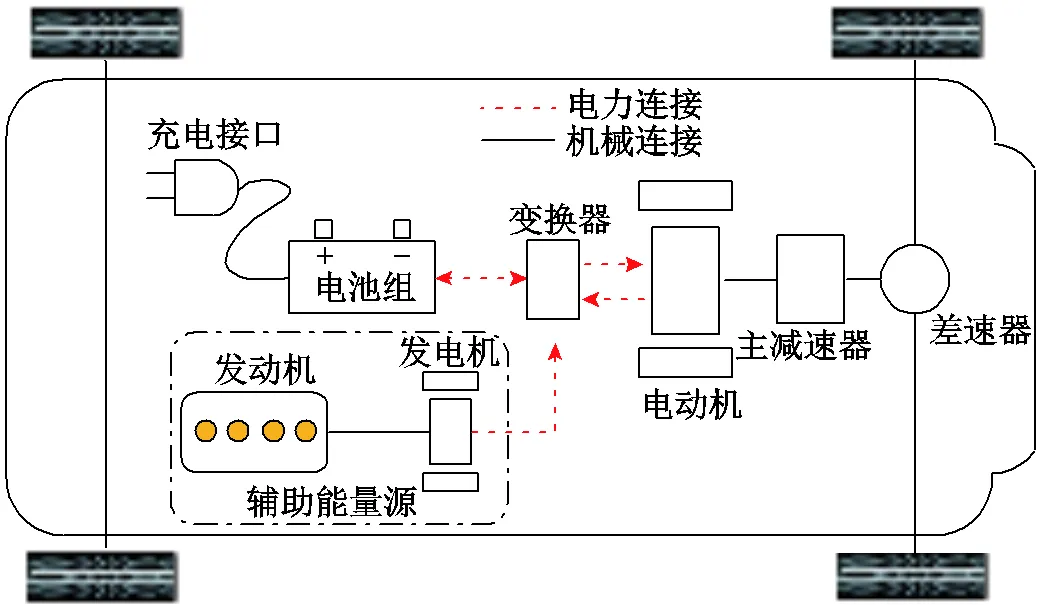

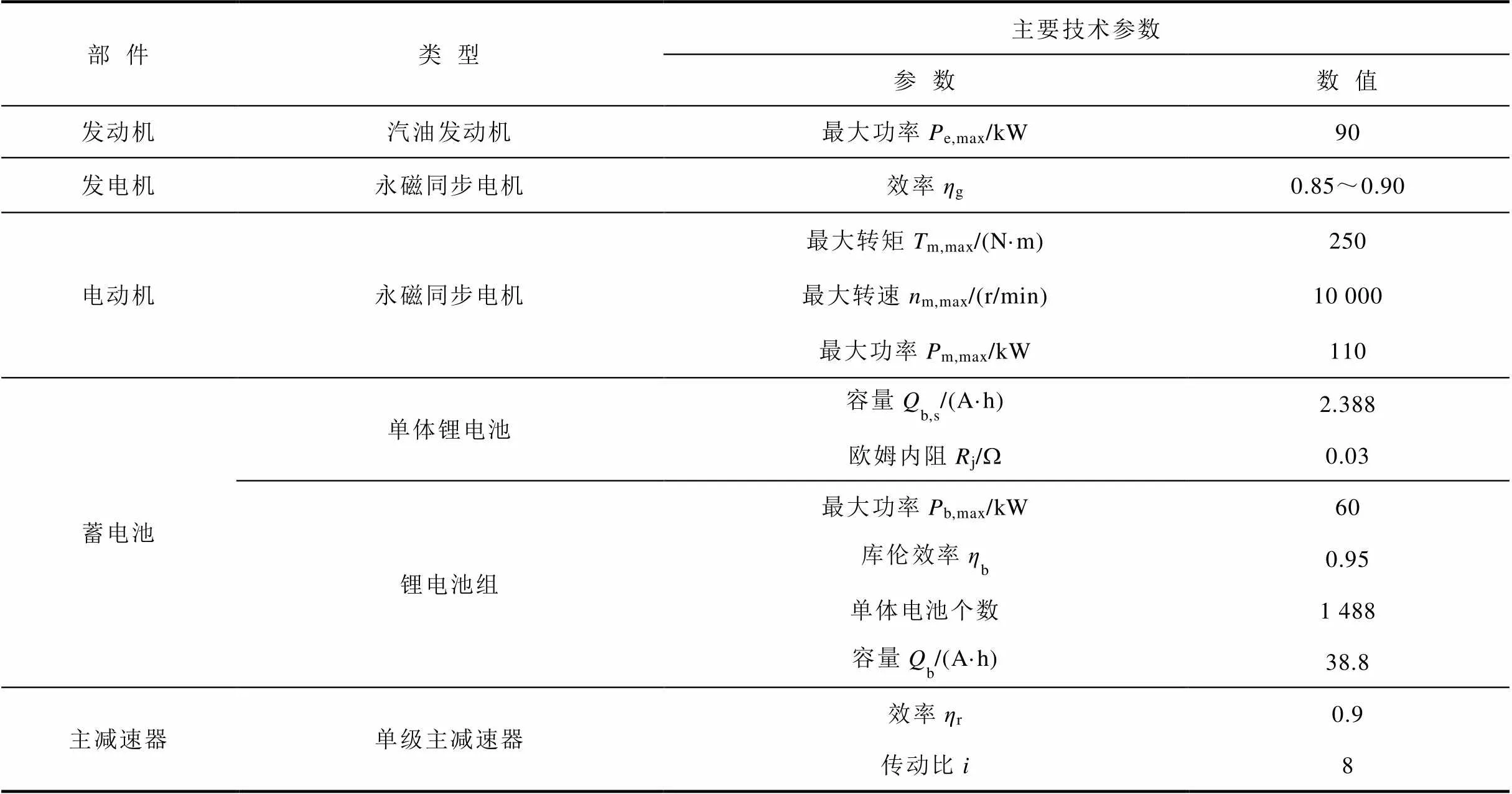

本文针对插电式混合动力汽车开展研究,其动力系统结构如图1所示,主要由发动机、发电机、电池组、电动机、变换器及机械传动装置(主减速器、差速器)组成。其中,电池组作为主要车载能量单元,可以为电动机提供电能,且能够外接电网进行充电,发动机与发电机共同组成辅助能量源,电动机负责产生驱动车辆所需的机械能,当车辆制动时电动机则用作发电机,将车辆动能转变为电能存储在电池组中,实现再生制动功能。该动力系统的主要部件及参数见表1。

图1 PHEV动力系统结构

表1 PHEV主要部件及参数

Tab.1 Main components and parameters of PHEV

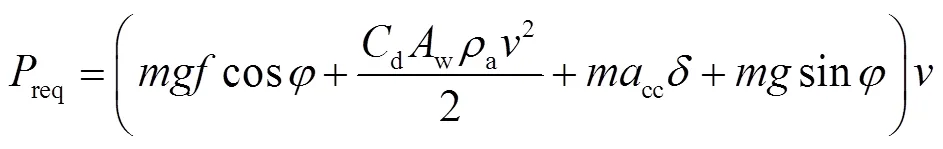

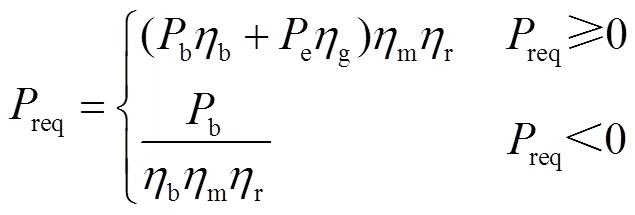

根据车辆纵向动力学方程,建立动力系统的需求功率[32]为

式中,为整车质量;为重力加速度;为滚动阻力系数;为道路坡度(本文不考虑道路坡度的影响);d为风阻系数;w为车辆迎风面积;a为空气密度;为车辆行驶速度;cc为车辆加速度;为旋转质量转换系数。车辆的电池组和发动机提供车辆行驶的需求功率,平衡方程为

式中,b为电池组功率;e为发动机功率;b、g、m和r分别为电池组、发电机、电动机和主减速器的工作效率。EMS通过调整电池组和发动机的动力分配,以达到不同的控制效果。

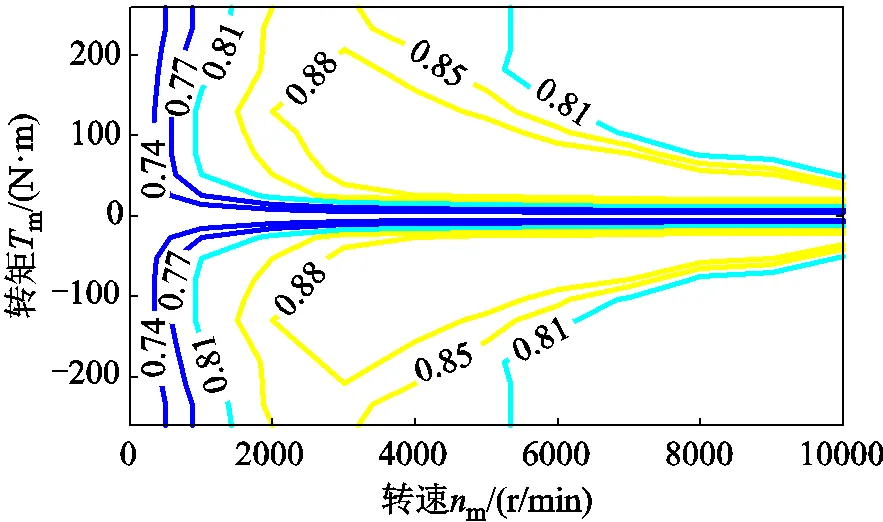

1.1 电动机模型

电动机作为主要执行机构负责提供车辆行驶的机械能,因此电动机的转速与车速存在直接耦合关系,而电动机的需求功率即为车载电源系统的负载。采用准静态模型对电动机驱动系统的动态特性进行建模,电动机效率如图2所示,即电机转速-转矩平面上任意电机工作点所对应的效率值(输出机械功率与输入电功率之比)。图中所示的等效率曲线对应效率值相同的工作点,从图中可以看出电机大部分工作区域为效率大于80%的高效区间,电机输出转矩为目标转矩的一阶延迟,模型计算时根据电机需求力矩与转速结合电机效率可得系统负载功率。

图2 电动机效率

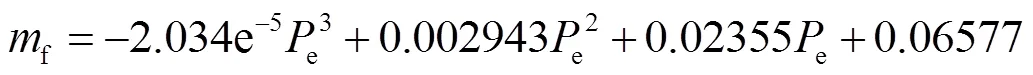

1.2 发动机模型

式中,为发动机瞬时燃油消耗率。经计算,该拟合结果的方均根误差为0.13g/s,可以满足后续EMS的研究需要。

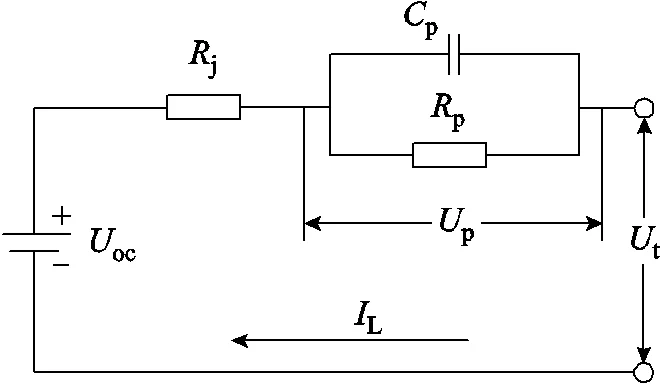

1.3 电池模型

为了便于系统分析,忽略电池组内部单体电池的不一致性,将动力电池视为一个整体系统进行建模,电池等效电路如图4所示。其中,oc表示电池的开路电压,j表示电池欧姆内阻,p表示电池的极化内阻,p表示电容,p为极化内阻两端的电压,t为电池端电压,L为电池输出电流。

图4 电池等效电路

基于上述模型,可得极化内阻两端的电压变化量为

电池端电压为

2 能量管理策略

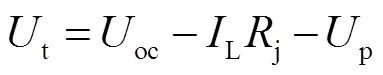

本文所提出的深度强化学习EMS原理如图5所示。所研究的PHEV共有四种控制模式,分别为纯电动模式、纯发动机模式、混合驱动模式及再生制动模式。控制策略并不设置其模式切换的逻辑门限,而是采用一个具有动态学习能力的智能体与实车行驶环境及系统状态进行信息交互,实现使奖励值函数最大化的决策动作,即最优功率分配律。

图5 基于深度强化学习的能量管理策略原理

由于发动机与驱动轮之间并无机械耦合,因此理论上发动机可以一直工作在最优效率点,但是考虑到电池容量及功率的限制,发动机适当偏离最优点以兼顾电池组工作状态,从而获得整个系统的集成优化是必要的。在解决混合动力汽车能量管理问题时,将系统模型和行驶工况视为环境,能量管理控制器视为智能体,则车辆行驶过程就是智能体与环境的不断交互过程。深度强化学习算法融合了深度学习的感知能力和强化学习的决策能力,以实现累积奖励值最大化为目标。在每一时刻,智能体采用深度学习的方法感知到环境中的状态向量,然后基于目标网络所产生的预期收益来评价当前状态下的动作,将当前状态映射为相应的动作并作用到环境中得到下一时刻的状态,不断循环以上过程来改进策略,从而得到累积收益最大化的策略,进而得到控制算法的最优化。

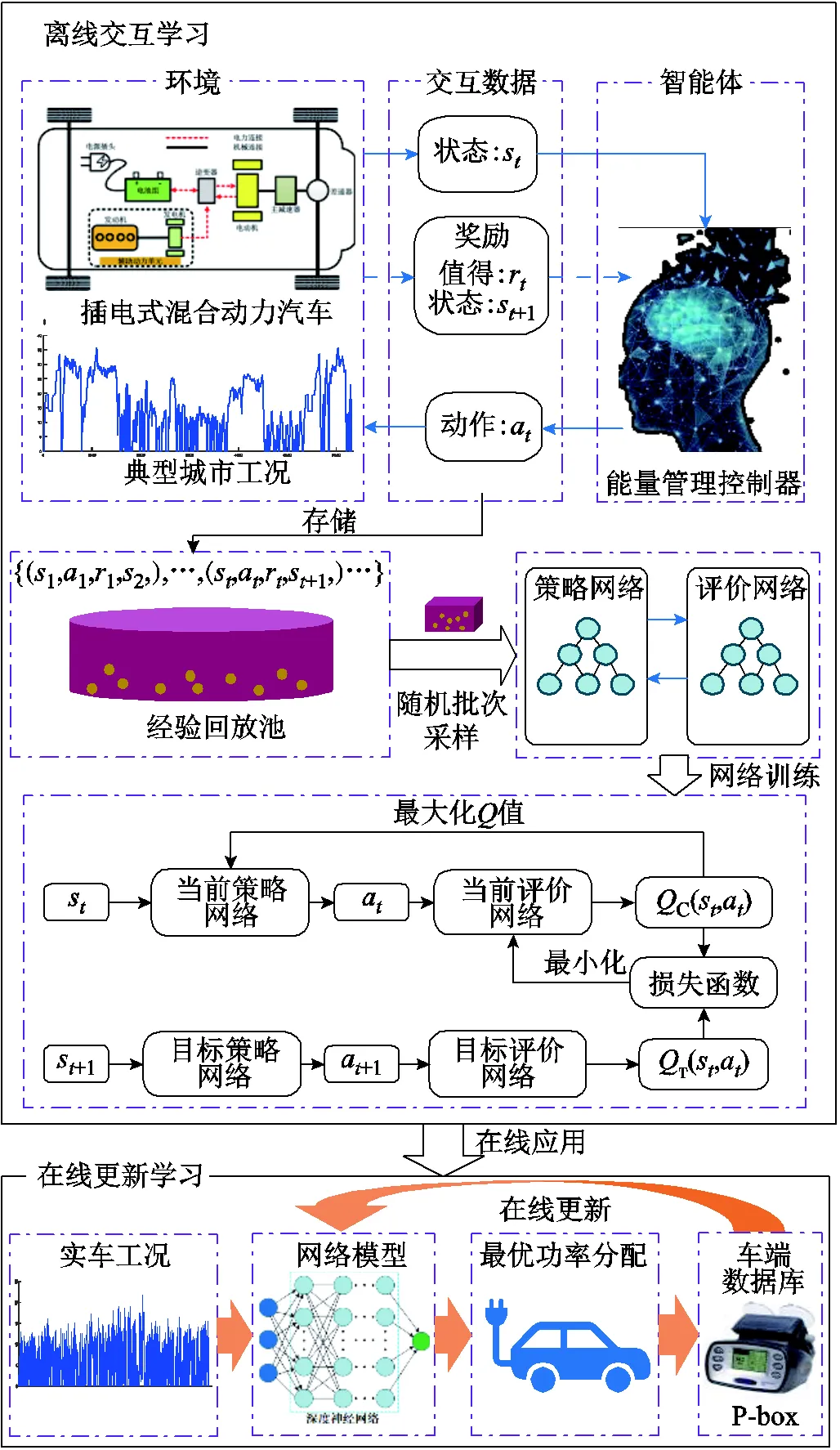

深度强化学习EMS构架包括两个层,即离线交互学习与在线更新学习,车辆的运行特性对控制策略有显著影响,本文使用如图6所示的七个典型城市工况统计得到的车速数据,来刻画车辆的运行特性,用于进行控制策略的离线交互学习。行驶总里程和平均速度分别为97.38km和55.47km/h,所建立的网络可以直接用于在线运行。在线运行时根据车辆运行特性对控制策略进行更新学习,以进一步提高控制算法对实际环境下车辆运行特性的适应性。

图6 车辆运行特性数据

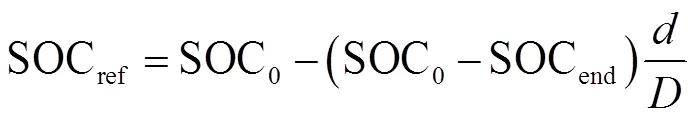

对上述构架进行进一步描述如下:智能体学习过程中通过在环境中的行为动作选择来寻求最大奖励,在每一时刻智能体感知到状态s(s∈),={SOC,req, SOCref, ΔSOC,cc}为状态空间,SOCref为参考SOC值,表达式为

式中,SOC0为初始SOC值;SOCend为里程终止时的预期SOC值;为汽车当前的行驶距离;为总的行驶里程。

ΔSOC为SOC变化量的预估值,为

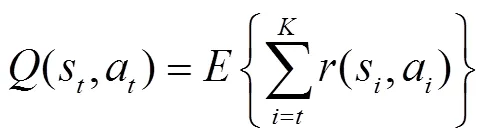

智能体在到达最终状态所获得奖励总和的期望值称为状态动作值函数,即

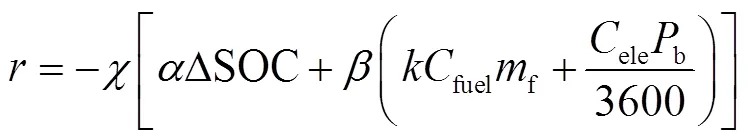

式中,为当前时刻;为数学期望;为奖励函数,其表达式为

式中,为激活函数;为燃油价格转换系数;fuel为燃油价格;ele为电价;和为权重因子。

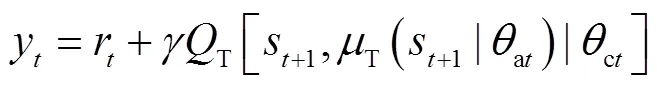

进一步,采用DDPG算法构建智能化EMS。该算法包含策略网络与评价网络,其中策略网络用来生成策略,评价网络生成值来评价当前策略。经验回放池中储存了每一次智能体与环境交互所产生的网络参数(s,a,r,s+1),进行随机批次抽样学习。当前策略网络根据当前时刻状态s选择当前时刻动作a,用于和环境交互产生下一时刻的状态s+1和奖励值r;目标策略网络负责根据下一状态s+1选择下一动作a+1。由于目标网络的权重周期性地从当前网络进行更新,因此在训练过程中值的目标值可以被暂时固定,使得学习更加稳定。值的目标值为

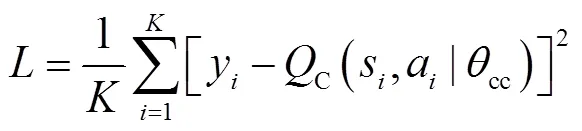

当前评价网络的目标是最小化损失函数,网络训练时采用的损失函数定义为

式中,C为当前评价网络产生的值;cc为当前评价网络的权重。

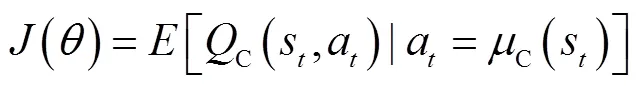

当前策略网络的目标是最大化期望收益,即

式中,C为当前策略网络的策略函数。

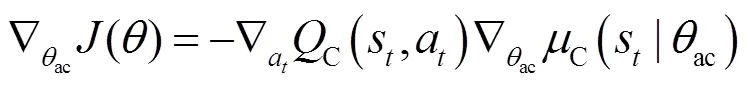

当前策略网络的权重ac梯度为

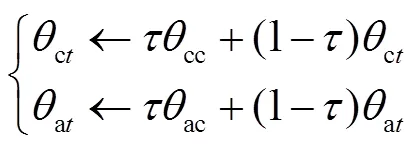

采用自适应矩估计优化器[33]更新当前策略网络的权重ac和当前评价网络的权重cc,然后采用软更新的方式分别更新两个目标网络的权重,即

式中,为软更新参数。

3 仿真结果与分析

3.1 仿真结果

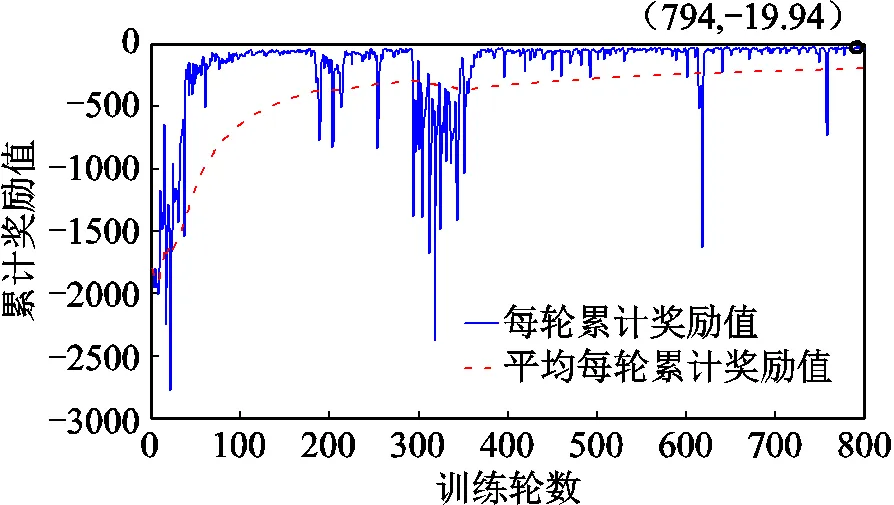

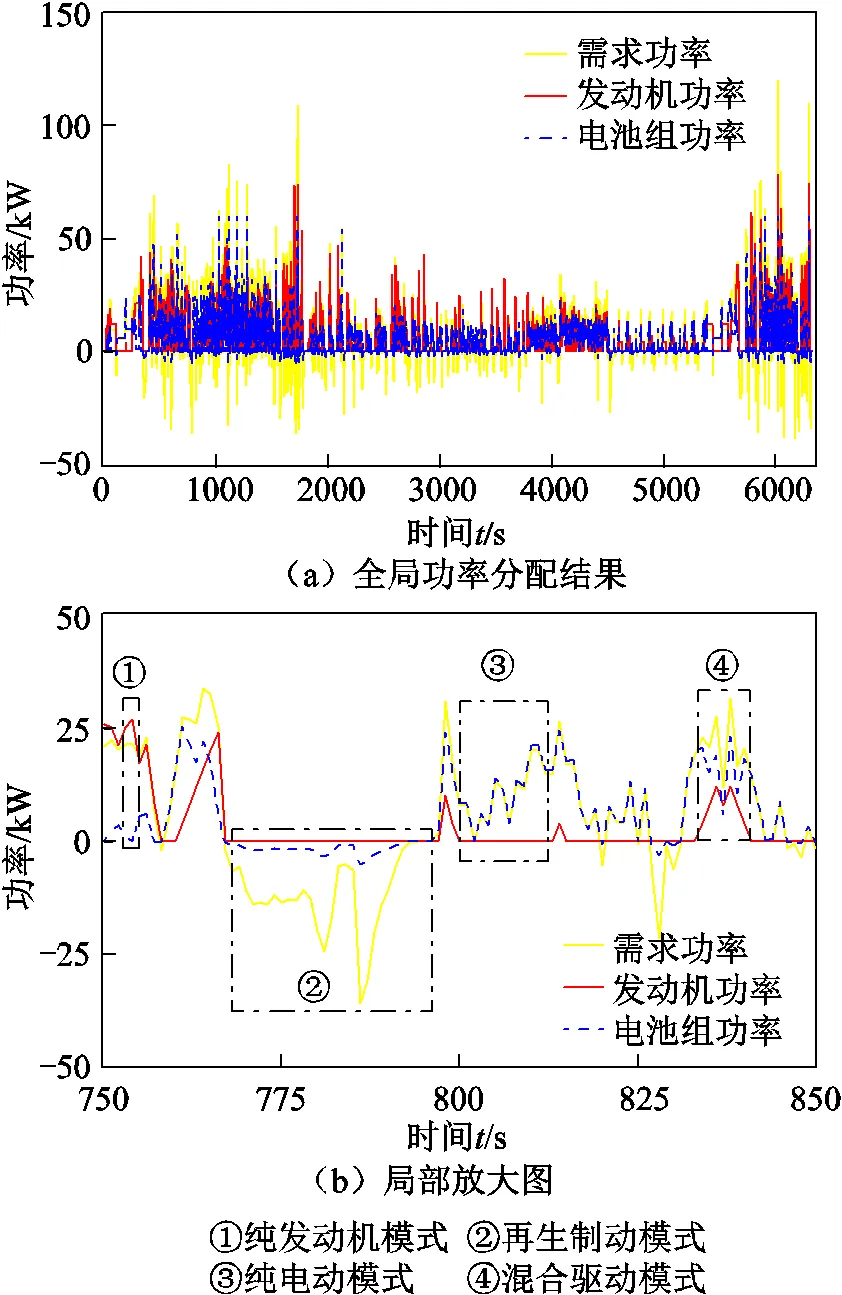

对上述控制算法进行仿真分析,仿真过程中动力电池组的初始SOC设置为0.9。策略网络和评价网络各设置有两个隐含层和一个输出层,第一个隐含层设置有100个神经元,第二个隐含层设置有50个神经元。算法训练过程中的每轮累计奖励值和平均每轮累计奖励值的变化结果如图7所示,最大奖励值所对应的功率分配率如图8所示。

图7 网络训练过程奖励值

图8 控制策略仿真结果

从深度强化学习算法所得到的功率分配决策可以看出,在整个全局工况中控制算法动态分配发动机与电池组功率以实现整体的节能效果最优,在控制过程中体现出了四种控制模式:①纯发动机工作模式;②再生制动模式;③纯电动模式;④混合驱动模式。这一控制结果与逻辑门限控制有相似效果,说明深度强化学习具备在执行过程中确定最佳控制模式的学习能力,同时能够根据全局能耗分布进行最优分配律的决策。

接下来进一步对深度强化学习控制策略的最优性及动态学习效果进行综合评价,评价过程分为三个部分:首先,对离线初始训练结果进行最优性验证,以评价所建立的深度强化学习算法在全局寻优方面的训练效果;其次,以沈阳城市工况实车运行数据对控制策略的在线应用进行验证,评价离线训练的控制算法在实际工况下的控制效果;最后,改变道路条件,对控制算法在线更新学习能力进行验证,评价其在行驶环境发生变化的情况下对控制率的更新学习和动态调节能力。

3.2 离线控制效果最优性分析

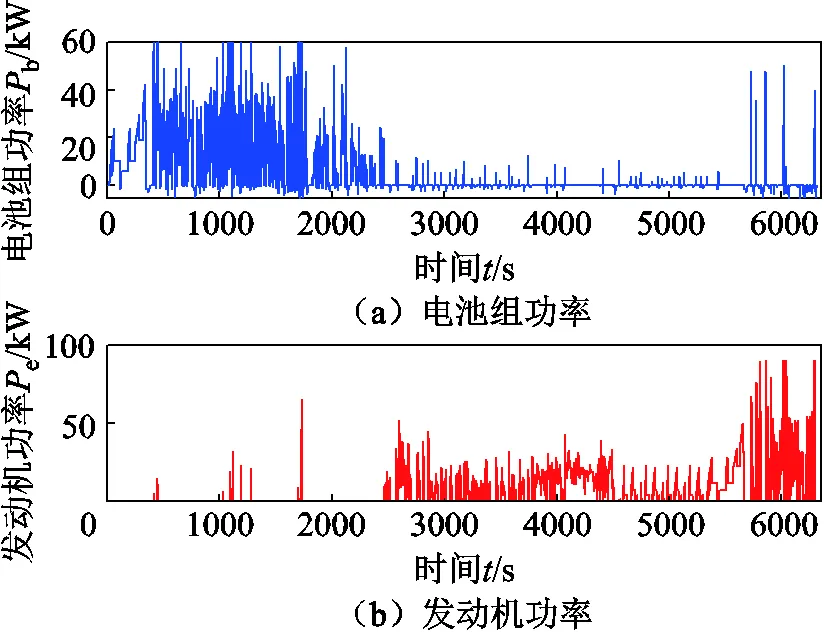

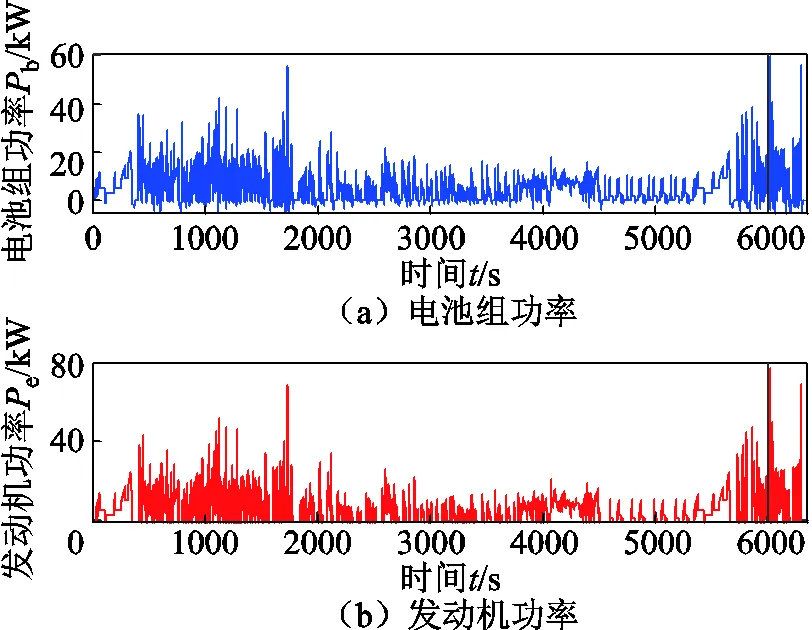

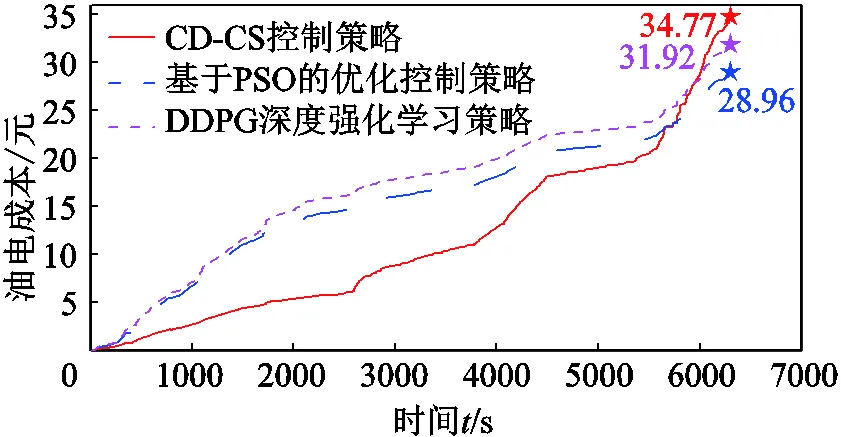

为了验证所提出的深度强化学习EMS的最优性控制效果,在相同的行驶工况下采用CD-CS控制策略与基于PSO的最优EMS进行仿真。CD-CS策略优先采用纯电动模式,发动机功率仅作为补充,电池SOC到达下限后切换为发动机为主的工作模式以维持电池电量;基于PSO算法的能量管理策略是一种全局优化策略,其算法执行步骤详见文献[14],此处不再赘述。电池组与发动机功率分配结果分别如图9、图10所示;图11给出了三种控制策略的成本对比。可以看出,CD-CS控制策略由于在前期优先使用电池功率,因此前半阶段成本较低,但是全局的总成本最高;基于深度强化学习的控制策略与基于PSO优化的控制策略的控制结果变化趋势较为接近。三种控制策略所对应的油电成本及燃油成本对比结果见表2,可知PSO控制策略实现了最低的油电消耗,其油电成本比CD-CS控制策略降低了16.71%;所提出的深度强化学习EMS在初始离线训练之后,虽然未能完全逼近理论上的最优值,但可以实现次优的控制效果,其油电成本较CD-CS控制策略降低了8.20%。上述结果证明了所提出的DDPG算法的有效性。

图9 CD-CS控制策略结果

图10 PSO控制策略优化结果

图11 三种控制策略优化的油电成本对比

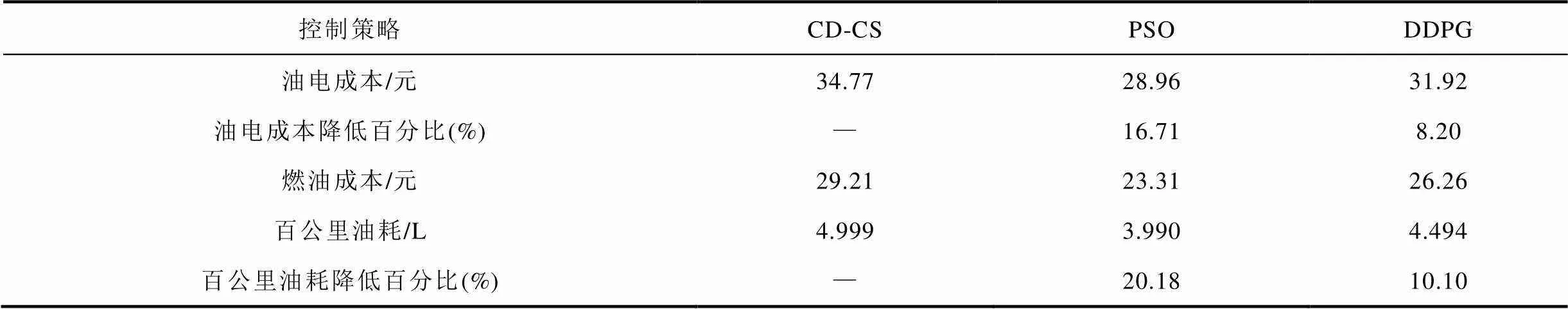

表2 不同控制策略的能耗成本对比结果

Tab.2 Comparison results of energy consumption costs of different control strategies

3.3 在线应用控制效果

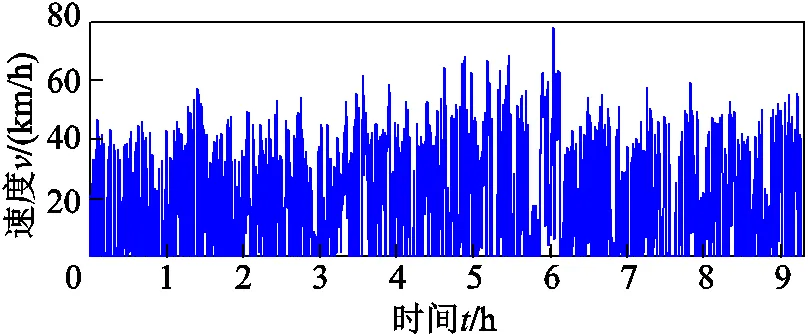

为了评价离线优化之后的EMS在实车运行的在线控制效果,采用实车数据对所提出的EMS进行测试与评价,车辆行驶工况来自于辽宁省沈阳市主干道青年大街,所采集的数据总里程和平均速度分别为180.93km和19.51km/h,如图12所示。通过实车数据对CD-CS控制策略、基于PSO的优化控制策略、本文所提出的深度强化学习控制策略进行验证,需要注意的是,这里使用的PSO控制策略和深化强化学习控制策略均是采用前述典型工况离线训练。

图12 沈阳城市道路实车数据

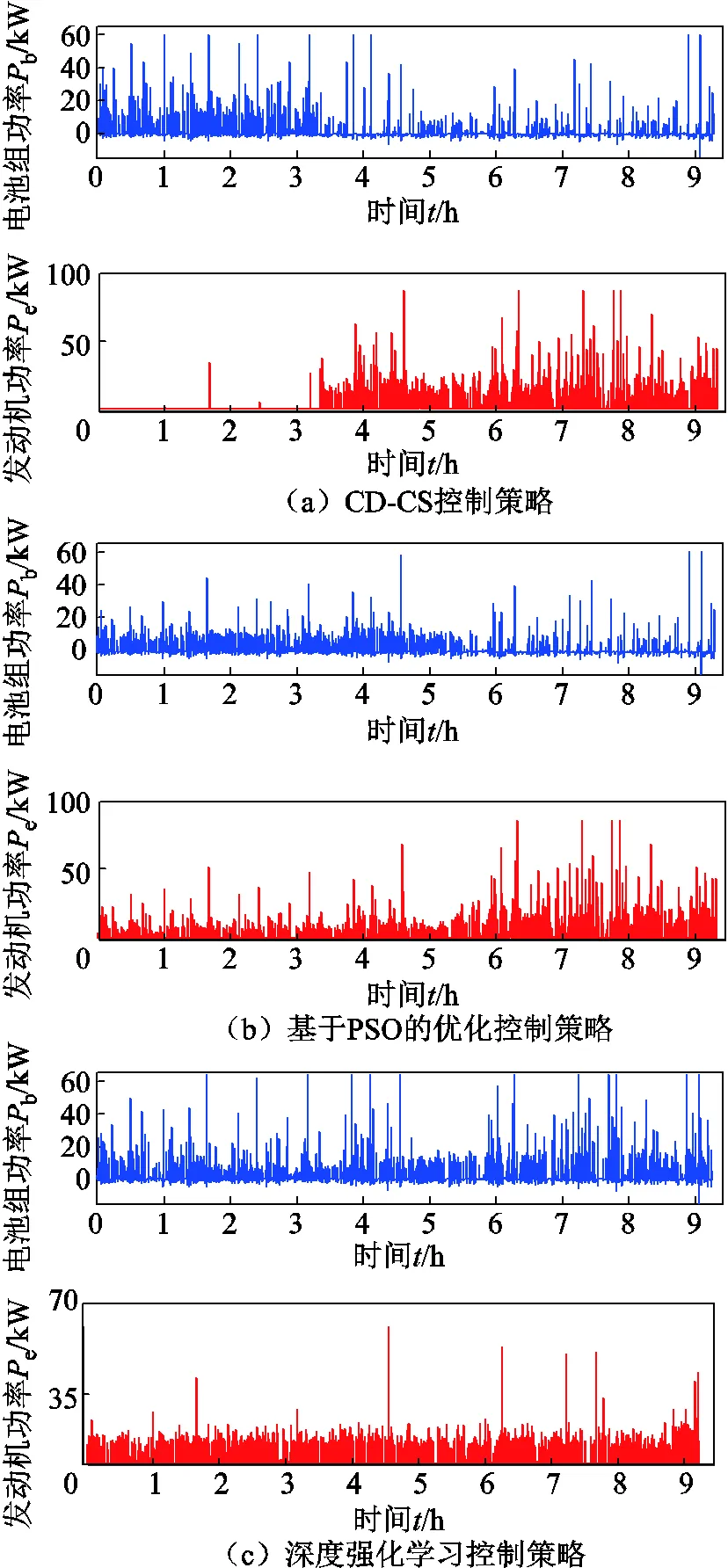

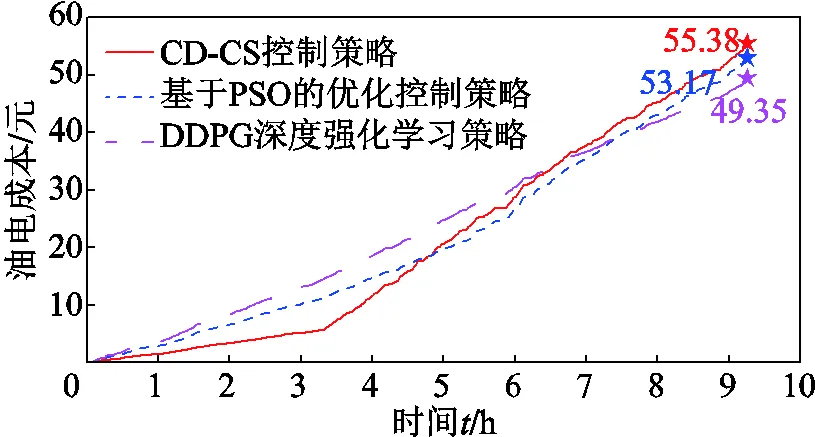

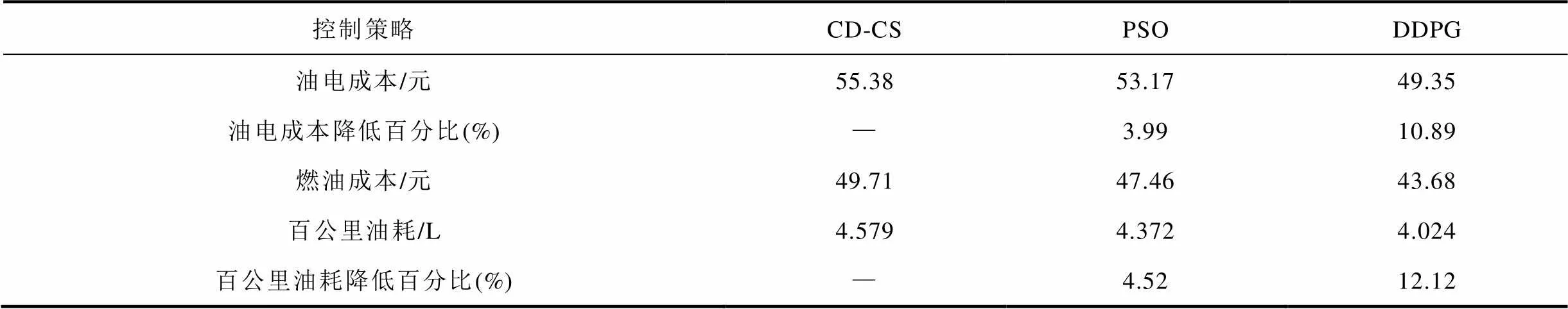

实车数据对应的功率分配结果如图13所示,其中CD-CS控制策略与离线结果基本一致,即早期仍然主要使用电能,在行驶里程增加之后开始启用发动机;PSO控制策略与深度强化学习控制策略则全程范围内对功率进行分配。结果可以看出,深度强化学习所得到的功率分配更为均匀,发动机大功率输出的情况明显较少。图14所示为三种控制策略所得到的油电成本,其中CD-CS控制策略的节能效果最差;PSO控制策略虽然在离线时效果最佳,但是在线运行时的效果并不理想;深度强化学习控制策略实现了最低的能耗。不同控制策略优化的能耗成本见表3。由表3可知,与CD-CS控制策略相比,PSO控制策略在实车工况下油电成本和油耗分别降低了3.99%和4.52%,而深度强化学习控制策略则分别降低了10.89%和12.12%,表明基于深度强化学习的EMS在面对不确定性行驶工况时可以实现很好的控制效果。

图13 DDPG控制策略优化结果

图14 不同控制策略优化的总成本随时间变化的对比

表3 不同控制策略优化的能耗成本

Tab.3 Energy consumption cost optimized by different control strategies

3.4 更新学习效果分析

当驾驶环境发生较大改变时,在线学习与策略更新对于提高车辆实际控制效果至关重要。为了验证所提出控制策略的在线学习效果,采用沈阳青年大街与二环路的实车数据进行分析[34],如图15a所示,场景设计描述如下。

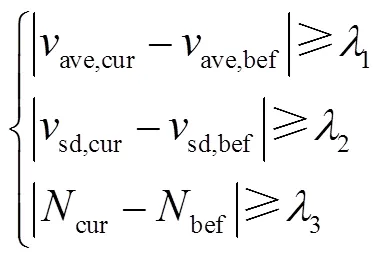

如图15a所示,车辆由沈阳青年大街行驶到二环路,其中青年大街路况缓慢且起停频繁,而二环路车速偏高且起停较少,行驶工况发生了明显改变。车辆前期在青年大街运行时,控制策略已经完成了该路况的学习,当车辆行驶在二环路时控制策略并非最优,需要进行在线更新学习。系统实时记录车辆速度信息并与之前的速度工况特征进行对比,所采取的对比特征包括平均车速、速度标准差、起停频率,并依据式(15)判断行驶工况是否有了明显改变,即

式中,vave,cur和vave,bef分别为当前窗格的平均速度和前一窗格的平均速度;vsd,cur和vsd,bef分别为当前窗格的速度标准差和前一窗格的速度标准差;Ncur和Nbef分别为当前窗格的起停次数和前一窗格的起停次数;、和为设定的阈值。

当式(15)中至少两个条件被满足时进行算法的更新学习。在本例中,每隔5km进行一次工况变换识别,如果判定工况改变,则进一步使用30km的数据进行更新学习,如图15a所示,其中,阈值设置为1=20、2=4、3=40。算法的更新学习需要一定的时间,以本文采用的处理器Intel(R) Core(TM) i7—8700 CPU@3.20GHz为例,模型更新训练的时间为554s,控制策略仅在行驶工况发生较大改变的情况下才进行更新学习,在更新完成之前仍然采用之前的算法。随着汽车智能化、车联网及云端大数据技术的发展,深度强化学习策略完全具备实时应用的可行性和更加便利的在线更新能力。

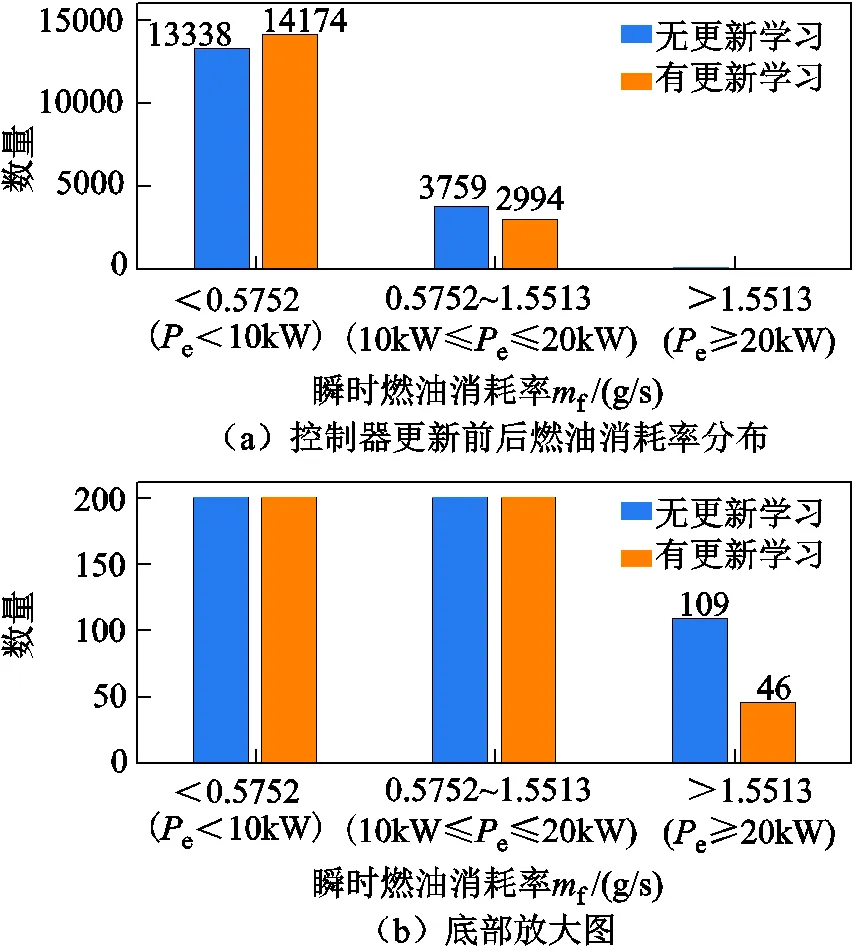

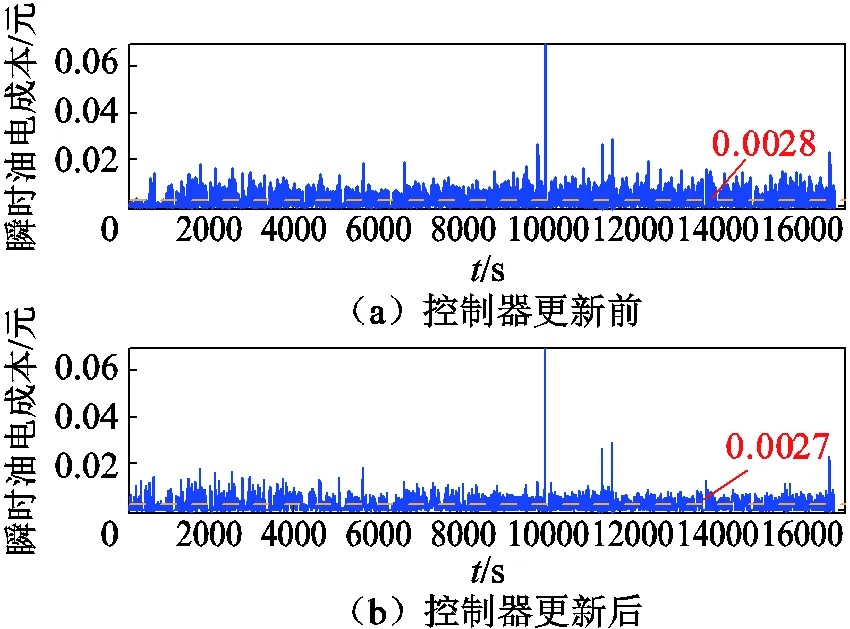

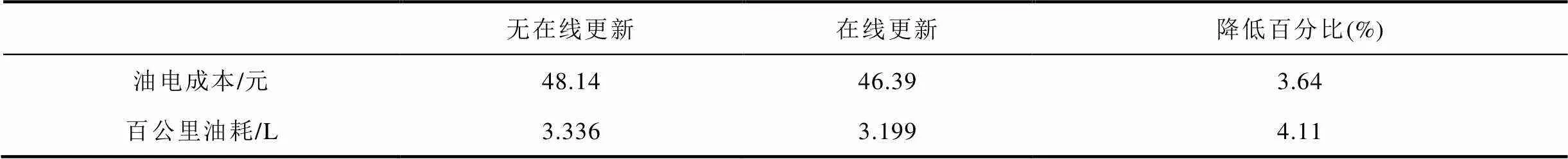

将更新后的控制算法和没有更新的情况进行对比分析。控制策略在线更新后的功率分配结果及其与无在线更新机制的控制策略对比结果如图15b、图15c所示。算法经过学习更新之后,发动机工作时间占比有所提高,以更好地适应新的行驶工况,而功率数值有轻微下降。为了更清晰地观察改进效果,对更新之后的二环路工况(图15a中③区域)的瞬时燃油消耗率进行了统计分析,结果如图16所示。可以看出,算法更新之后,瞬时燃油消耗率更多地分布在低区间(<0.575 2),而更新前的瞬时燃油消耗率更多地分布在中(0.575 2~1.553 1)、高(>1.553 1)区间。瞬时油电成本的统计结果如图17所示,可以看出,在控制策略进行更新学习之后,整个行驶路程分布上的瞬时油电成本有了明显下降。油电成本与油耗对比的结果见表4,控制器更新后油电消耗成本进一步降低了3.64%,百公里油耗进一步降低了4.11%。上述分析结果表明,本文提出的深度强化学习控制策略在线运行时可实现较PSO算法更优的结果,且通过更新学习可以进一步提高控制效果。

图16 控制器更新前后燃油消耗率分布对比

图17 控制器更新前后瞬时油电成本对比

表4 控制器更新前后能耗对比结果

4 结论

本文基于DDPG深度强化学习算法,提出了一种具有在线学习能力的插电式混合动力汽车EMS设计方法,以发动机功率变化量为动作空间建立了自适应最优功率分配律,进而建立了离线交互学习+在线更新学习的算法框架。所提出的深度强化学习EMS可以有效提高PHEV在线运行时的节能效果,且具备对行驶特性突变情况的适应性。以沈阳实车数据为例对所提出的控制策略进行了验证与分析,结果表明,与PSO优化控制策略相比,深度强化学习策略可以使在线运行时的车辆油电综合成本降低6.9%;当车辆行驶路况发生明显改变之后,所建立的深度强化学习EMS具有良好的路况适应性,与不具备在线学习能力的情况相比,可以使车辆油电综合成本进一步降低3.64%。

[1] 安小宇, 李元丰, 孙建彬, 等. 基于模糊逻辑的电动汽车双源混合储能系统能量管理策略[J]. 电力系统保护与控制, 2021, 49(16): 135-142.

An Xiaoyu, Li Yuanfeng, Sun Jianbin, et al. Energy management strategy of a dual-source hybrid energy storage system for electric vehicles based on fuzzy logic[J]. Power System Protection and Control, 2021, 49(16): 135-142.

[2] 姚颖蓓, 陆建忠, 傅业盛, 等. 华东地区电动汽车发展趋势及用电需求预测[J]. 电力系统保护与控制, 2021, 49(4): 141-145.

Yao Yingbei, Lu Jianzhong, Fu Yesheng, et al. Electric vehicle development trends and electricity demand forecast in East China[J]. Power System Protection and Control, 2021, 49(4): 141-145.

[3] 程杉, 杨堃, 魏昭彬, 等. 计及电价优化和放电节制的电动汽车充电站有序充放电调度[J]. 电力系统保护与控制, 2021, 49(11): 1-8.

Cheng Shan, Yang Kun, Wei Zhaobin, et al. Orderly charging and discharging scheduling of an electric vehicle charging station considering price optimization and discharge behavior control[J]. Power System Protection and Control, 2021, 49(11): 1-8.

[4] 陈嘉鹏, 汤乃云, 王雪松. 基于电动汽车入网特性的电网经济调度研究[J]. 电气技术, 2019, 20(3): 24-30, 36.

Chen Jiapeng, Tang Naiyun, Wang Xuesong. Research on economic dispatch of power grid based on vehicle to grid characteristics of electric vehicle[J]. Electrical Engineering, 2019, 20(3): 24-30, 36.

[5] 郭国太. 电动汽车充电站负荷计算及影响因素[J]. 电气技术, 2019, 20(3): 93-97.

Guo Guotai. Load calculation and influence factors of electric vehicle charging station[J]. Electrical Engineering, 2019, 20(3): 93-97.

[6] 宋健, 李梦佳, 刘囡, 等. 基于聚类算法的电动汽车充放电分时电价优化[J]. 电气技术, 2018, 19(8): 168-173.

Song Jian, Li Mengjia, Liu Nan, et al. The time-of-use price optimization of electric vehicle charging and discharging based on clustering algorithm[J]. Electrical Engineering, 2018, 19(8): 168-173.

[7] 周美兰, 冯继峰, 张宇, 等. 纯电动客车复合储能系统功率分配控制策略研究[J]. 电工技术学报, 2019, 34(23): 5001-5013.

Zhou Meilan, Feng Jifeng, Zhang Yu, et al. Research on power allocation control strategy for compound electric energy storage system of pure electric bus[J]. Transactions of China Electrotechnical Society, 2019, 34(23): 5001-5013.

[8] 石庆升, 张承慧, 崔纳新. 新型双能量源纯电动汽车能量管理问题的优化控制[J]. 电工技术学报, 2008, 23(8): 137-142.

Shi Qingsheng, Zhang Chenghui, Cui Naxin. Optimal control of energy management in novel electric vehicles with dual-source energy storage system[J]. Transactions of China Electrotechnical Society, 2008, 23(8): 137-142.

[9] 王琪, 孙玉坤, 罗印升. 混合动力电动汽车的复合电源功率分配控制策略[J]. 电工技术学报, 2017, 32(18): 143-151.

Wang Qi, Sun Yukun, Luo Yinsheng. A power distribution control strategy of hybrid energy storage system in hybrid electric vehicles[J]. Transactions of China Electrotechnical Society, 2017, 32(18): 143-151.

[10] 李家祥, 汪凤翔, 柯栋梁, 等. 基于粒子群算法的永磁同步电机模型预测控制权重系数设计[J]. 电工技术学报, 2021, 36(1): 50-59, 76.

Li Jiaxiang, Wang Fengxiang, Ke Dongliang, et al. Weighting factors design of model predictive control for permanent magnet synchronous machine using particle swarm optimization[J]. Transactions of China Electrotechnical Society, 2021, 36(1): 50-59, 76.

[11] Wu Jiangling, Sun Xiaodong, Zhu Jianguo. Accurate torque modeling with PSO-based recursive robust LSSVR for a segmented-rotor switched reluctance motor[J]. CES Transactions on Electrical Machines and Systems, 2020, 4(2): 96-104.

[12] Liu Jichao, Chen Yangzhou, Li Wei, et al. Hybrid-trip-model-based energy management of a PHEV with computation-optimized dynamic programming[J]. IEEE Transactions on Vehicular Technology, 2018, 67(1): 338-353.

[13] Zhou Wei, Yang Lin, Cai Yishan, et al. Dynamic programming for new energy vehicles based on their work modes part Ⅰ: electric vehicles and hybrid electric vehicles[J]. Journal of Power Sources, 2018, 406: 151-166.

[14] Chen Zeyu, Xiong Rui, Cao Jiayi. Particle swarm optimization-based optimal power management of plug-in hybrid electric vehicles considering uncertain driving conditions[J]. Energy, 2016, 96: 197-208.

[15] Lü Xueqin, Wu Yinbo, Lian Jie, et al. Energy management of hybrid electric vehicles: a review of energy optimization of fuel cell hybrid power system based on genetic algorithm[J]. Energy Conversion and Management, 2020, 205: 112474.

[16] Xie Shaobo, Hu Xiaosong, Xin Zongke, et al. Pontryagin's minimum principle based model predictive control of energy management for a plug-in hybrid electric bus[J]. Applied Energy, 2019, 236: 893-905.

[17] Yang Ye, Zhang Youtong, Tian Jingyi, et al. Adaptive real-time optimal energy management strategy for extender range electric vehicle[J]. Energy, 2020, 197: 117237.

[18] 陈剑, 杜文娟, 王海风. 采用深度迁移学习定位含直驱风机次同步振荡源机组的方法[J]. 电工技术学报, 2021, 36(1): 179-190.

Chen Jian, Du Wenjuan, Wang Haifeng. A method of locating the power system subsynchronous oscillation source unit with grid-connected PMSG using deep transfer learning[J]. Transactions of China Electrotechnical Society, 2021, 36(1): 179-190.

[19] 李超然, 肖飞, 樊亚翔, 等. 基于卷积神经网络的锂离子电池SOH估算[J]. 电工技术学报, 2020, 35(19): 4106-4119.

Li Chaoran, Xiao Fei, Fan Yaxiang, et al. An approach to lithium-ion battery SOH estimation based on convolutional neural network[J]. Transactions of China Electrotechnical Society, 2020, 35(19): 4106-4119.

[20] 徐建军, 黄立达, 闫丽梅, 等. 基于层次多任务深度学习的绝缘子自爆缺陷检测[J]. 电工技术学报, 2021, 36(7): 1407-1415.

Xu Jianjun, Huang Lida, Yan Limei, et al. Insulator self-explosion defect detection based on hierarchical multi-task deep learning[J]. Transactions of China Electrotechnical Society, 2021, 36(7): 1407-1415.

[21] 张甜, 赵奇, 陈中, 等. 基于深度强化学习的家庭能量管理分层优化策略[J]. 电力系统自动化, 2021, 45(21): 149-158.

Zhang Tian, Zhao Qi, Chen Zhong, et al. Hierarchical optimization strategy for home energy management based on deep reinforcement learning[J]. Automation of Electric Power Systems, 2021, 45(21): 149-158.

[22] 叶宇剑, 王卉宇, 汤奕, 等. 基于深度强化学习的居民实时自治最优能量管理策略[J]. 电力系统自动化, 2022, 46(1): 110-119.

Ye Yujian, Wang Huiyu, Tang Yi, et al. Real-time autonomous optimal energy management strategy for residents based on deep reinforcement learning[J]. Automation of Electric Power Systems, 2022, 46(1): 110-119.

[23] 赵冬梅, 陶然, 马泰屹, 等. 基于多智能体深度确定策略梯度算法的有功-无功协调调度模型[J]. 电工技术学报, 2021, 36(9): 1914-1925.

Zhao Dongmei, Tao Ran, Ma Taiyi, et al. Active and reactive power coordinated dispatching based on multi-agent deep deterministic policy gradient algorithm[J]. Transactions of China Electrotechnical Society, 2021, 36(9): 1914-1925.

[24] Zhao Pu, Wang Yanzhi, Chang N, et al. A deep reinforcement learning framework for optimizing fuel economy of hybrid electric vehicles[C]//2018 23rd Asia and South Pacific Design Automation Conference (ASP-DAC), Jeju, Korea (South), 2018: 196-202.

[25] He Dingbo, Zou Yuan, Wu Jinlong, et al. Deep Q-learning based energy management strategy for a series hybrid electric tracked vehicle and its adaptability validation[C]//2019 IEEE Transportation Electrification Conference and Expo (ITEC), Detroit, MI, USA, 2019: 1-6.

[26] Han Xuefeng, He Hongwen, Wu Jingda, et al. Energy management based on reinforcement learning with double deep Q-learning for a hybrid electric tracked vehicle[J]. Applied Energy, 2019, 254: 113708.

[27] Zhu Zhaoxuan, Liu Yuxing, Canova M. Energy management of hybrid electric vehicles via deep Q-networks[C]//2020 American Control Conference (ACC), Denver, CO, USA, 2020: 3077-3082.

[28] Du Guodong, Zou Yuan, Zhang Xudong, et al. Deep reinforcement learning based energy management for a hybrid electric vehicle[J]. Energy, 2020, 201: 117591.

[29] Tan Huachun, Zhang Hailong, Peng Jiankun, et al. Energy management of hybrid electric bus based on deep reinforcement learning in continuous state and action space[J]. Energy Conversion and Management, 2019, 195: 548-560.

[30] Li Yuecheng, He Hongwen, Khajepour A, et al. Energy management for a power-split hybrid electric bus via deep reinforcement learning with terrain information[J]. Applied Energy, 2019, 255: 113762.

[31] Li Yuecheng, He Hongwen, Peng Jiankun, et al. Deep reinforcement learning-based energy management for a series hybrid electric vehicle enabled by history cumulative trip information[J]. IEEE Transactions on Vehicular Technology, 2019, 68(8): 7416-7430.

[32] Geng Wenran, Lou Diming, Wang Chen, et al. A cascaded energy management optimization method of multimode power-split hybrid electric vehicles[J]. Energy, 2020, 199: 117224.

[33] Fei Zhigen, Wu Zhiying, Xiao Yanqiu, et al. A new short-arc fitting method with high precision using Adam optimization algorithm[J]. Optik, 2020, 212: 164788.

[34] Chen Zeyu, Zhang Qing, Lu Jiahuan, et al. Optimization-based method to develop practical driving cycle for application in electric vehicle power management: a case study in Shenyang, China[J]. Energy, 2019, 186: 115766.

Energy Management Strategy for Hybrid Electric Vehicle Based on the Deep Reinforcement Learning Method

Chen Zeyu1,2Fang Zhiyuan1Yang Ruixin2Yu Quanqing2,3Kang Mingxin1

(1. School of Mechanical Engineering and Automation Northeastern University Shenyang 110819 China 2. School of Mechanical Engineering Beijing Institute of Technology Beijing 100081 China 3. School of Automotive Engineering Harbin Institute of Technology at Weihai Weihai 264209 China)

To resolve the problem of poor adaptability to varying driving cycles when energy management strategy for hybrid electric vehicles is running online, a design method of energy management strategy (EMS) with deep reinforcement learning ability is proposed. The presented method determines the optimal change rate of engine power based on the deep deterministic policy gradient algorithm and then establishes the power management strategy of the onboard energy system. The established control strategy includes a two-layer logical framework of offline interactive learning and online update learning. The control parameters are dynamically updated according to the vehicle operation characteristics to improve the vehicle energy-saving effect in online applications. To verify the proposed control strategy, the effectiveness of the algorithm is analyzed with the practical vehicle test data in Shenyang, and compared with the control effect of the particle swarm optimization algorithm. The results show that the proposed deep reinforcement learning EMS can achieve energy-saving effects better than particle swarm optimization-based strategy. Especially when the driving characteristics of vehicles change suddenly, deep reinforcement learning control strategy can achieve better adaptability.

Hybrid electric vehicle, power system, energy management strategy, deep reinforcement learning, machine learning

10.19595/j.cnki.1000-6753.tces.211342

U469

国家自然科学基金项目(51977029)、中央高校基本科研业务专项资金资助项目(N2003002)、辽宁省科技计划项目(2021JH6/10500135)和中国博士后科学基金资助项目(2021M690395)资助。

2021-08-25

2021-12-24

陈泽宇 男,1982年生,副教授,博士生导师,研究方向为新能源汽车与电驱动技术、车用电池安全与故障诊断技术和电池智能化管理系统等。E-mail:chenzy@mail.neu.edu.cn

杨瑞鑫 男,1988年生,博士,研究方向为新能源汽车动力电池管理。E-mail:yangruixin@bit.edu.cn(通信作者)

(编辑 李冰)