基于深度学习的合成孔径雷达图像去噪综述

雷 钰,刘帅奇,3,张璐瑶,刘 彤,赵 杰

(1.河北大学 电子信息工程学院, 河北 保定 071002; 2.河北省机器视觉技术创新中心, 河北 保定 071002; 3.中科院自动化所 模式识别国家重点实验室, 北京 100190)

1 引言

散斑是SAR图像中常见的一个问题,其主要来源于图像采集,与高斯噪声不同,散斑噪声是空间相关和信号相关的乘性噪声,严重影响了SAR图像的分析和解译[1-5]。因此,降低噪声以提高SAR图像质量对后续SAR图像处理任务至关重要。近年来,随着深度学习在自然图像去噪和复原等任务中的成功应用,如何将其应用在SAR图像去噪领域引起学术界广泛关注。

本文对现有基于深度学习方法的SAR图像去噪进行概述与分析,目的在于深入了解该领域的研究现状,对迄今为止基于深度学习的SAR图像去噪方法进行评估,分析其优势和局限性,并展望SAR图像去噪的发展前景。

2 SAR图像中相干斑形成机理模型

SAR图像中的相干斑噪声是在雷达回波信号由于信号的衰落引起的,其形成过程与数字图像处理中的噪声有本质区别。从空域角度来分析可将乘性相干斑噪声建模为[1]:

I=MN

(1)

式中:I表示含有相干斑噪声的SAR图像;M表示未受到噪声影响的理想地物目标测量值;N表示SAR系统成像时产生的相干斑噪声,且M和N相互独立。

通常假设乘性随机噪声N服从L阶均值为1,方差为1/L的Gamma分布[2],则噪声的概率密度分布函数为:

(2)

式中:L表示等效视数;Γ(·)表示Gamma函数。

由于乘性噪声模型难以分析,通常将乘性噪声转化为加性模型进行分析。通常采用同态滤波将式(2)转化为加性模型[3]。首先,对式(1)两边进行对数变换,可得:

Log(I)=Log(M)+Log(N)

(3)

显然,式(3)为加性噪声模型。在进行去噪完以后需要将去噪后的图像再指数化返回原有的空间。这一过程中需要对图像的均值漂移进行调整。

当然,也有学者采用构造法将乘性噪声模型转化为加性噪声模型[4],其构造过程如式(4)所示:

I=MN=M+[N-1]M=M+UM=M+V

(4)

因为M和N不相关,所以和N-1也不相关,因此V表示和真实图像分布相关的噪声。在上述模型中,噪声均值从1变为0,方差变成随M变化而变化的参数。V=M(N-1)表示一种与信号不独立且均值为0的非平稳加性噪声。因此噪声图像可以表示为I-M,因此在神经网络中可以通过残差学习策略进行噪声去除,即得到R(i)≈V,然后得到干净图像M=I-R(i)。

3 基于深度学习的SAR去噪算法分析

深度学习方法主要是通过网络对大量数据的特征进行学习,然后对新数据进行预测的过程。深度学习在图像处理领域得到了广泛的应用,如图像分割、图像识别、图像超分辨率及图像去噪等。其中,卷积神经网络(convolutional neural networks,CNN)是最有力的工具之一,也是最早应用于SAR图像去噪的工具。根据近年来深度学习在SAR图像中的应用,本文将其主要归为两类:基于监督学习的SAR图像去噪算法和基于自监督学习SAR图像去噪算法。

3.1 有监督学习的SAR图像去噪

1) 基于对数变换的SAR图像去噪算法

Chierchia等[3]提出了第一个使用深度学习方法的SAR图像去噪算法——SARCNN。此外,Liu等[6]提出一种基于CNN与引导滤波的SAR图像去噪算法,该算法的泛化能力有所欠缺。Dalsasso等[7]利用19个卷积层对乘性噪声图像进行训练及特征处理,提出一种新的散斑抑制算法。Zhang等[8]为解决神经网络训练数据量较大的问题,通过卷积去噪自编码器(convolutioal denoising autoencoder,C-ADE)重建无斑点SAR图像。Pan等[9]利用预训练网络(FFDNet)和MuLoG算法进行SAR图像去噪。而Liu等[10]则提出一种将非下采样剪切波与CNN相结合的SAR图像去噪算法。

2) 基于直接残差学习的SAR图像去噪算法

上述算法需要对SAR图像先进行对数变换,这使得网络不能进行端对端训练,并带来一定的复杂性,因此研究人员提出了直接通过网络训练利用残差进行SAR图像去噪的思想,此类方法可以提高网络模型的运算效率,同时更方便处理。例如,Zhang等[4]提出了SID-CNN算法;受编解码网络的启发,Gu等[11]针对SAR去噪问题提出一种基于残差编解码器的去噪算法——REDNet。通过对原始噪声图像和网络学习到的噪声图像进行直接相除的ID-CNN算法[12];Zhang等[13]将7个膨胀卷积引入到一般卷积去噪网络中,提出了SAR-DRN网络。与SAR-DRN类似的网络还有Ma等[14]提出的5层膨胀卷积和残差学习构成的去噪网络,相比于SAR-DRN该网络更为简单,网络层数更浅,效果更好。Zhou等[15]提出了一种用于SAR图像降斑的端到端深度多尺度递归网络——MSRNet。2015年,用于图像分割的U-Net网络被提出[16]。Lattari等[17]依据SAR-DRN与U-Net网络结构,将两者进行结合改进,提出了一种基于对称式编解码器的U-Net残差去噪网络。由于密集连接丰富了卷积层间的信息,因此其被广泛应用到图像去噪领域[18]。例如,Gui等[19]提出一种膨胀密集连接散斑抑制网络——SAR-DDCN。

在抑制散斑的同时如何能更好地保留纹理细节是研究者一直致力于解决的问题,Gu等[20]提出了一种双分量网络以解决上述的问题,该网络训练简单,且对细节保持有一定提高。同样为应对上述问题,Vitale等[21]提出考虑空间和统计特性的代价函数,构造了10层卷积网络(KL-DNN)。随后Vitale等[22]又在KL-DNN的基础上提出了新的代价函数,效果优于KL-DNN。同年又提出了MONet[23],将17层的卷积与一个创新的多视代价函数相结合进行去噪,获得了很好的图像细节保持能力。

3) 基于注意力网络的SAR图像去噪算法

注意力网络能够区别对待图像中的信息,重点关注重要信息而忽略掉不重要信息,因此被广泛地应用于SAR图像去噪中。例如,Li等[24]将注意力应用于SAR图像去噪,提出了一种膨胀残差注意力网络——HDRNet。得益于注意力强大的特征关注能力,去噪图像在图像细节上得到一定提升。而Lei等[25]将通道注意力与多层递归块结构相结合,提出多级残差注意力网络,对真实和模拟数据进行去噪和细节保存有显著提升。此外,Liu等[26]将密集连接与双注意力相结合构建新的SAR去噪网络,在运行时间和去噪性能上达到一种平衡。

4) 基于生成对抗网络的去噪算法

生成对抗网络(generative adversarial networks,GAN)作为深度学习中非残差学习的一种模型,它主要由两部分构成:生成器和判别器[27],两者会随着网络的训练达到一种平衡。Wang等[28]首先将GAN应用于SAR图像去噪,提出了ID-GAN算法。为解决大多数滤波方法需要复杂的参数调整才能达到所需的视觉效果的问题,Gu等[29]提出基于GAN的散斑抑制网络。Liu等[30]为解决同态区域散斑噪声抑制与细节保存问题,采用GAN思想进行网络构建,生成器部分采用8个卷积层实现,判别器网络采用四个步长卷积和一个全连接层实现。

5) 基于混合模型的SAR去噪算法

为解决应用深度学习网络可能会带来的过平滑问题,Kim等[31]提出一种将静态小波变换与CNN相结合的散斑抑制算法。一些学者尝试将预训练好的网络模型直接与基于模型的方法相结合用于SAR图像去噪。Yang等[32]将DnCNN已训练好的模型迁移到SAR图像中,提出一种使用预训练模型的MuLoG-CNN去噪网络。Denis等[33]将基于块的非局部滤波和深度学习相结合进行去噪处理。

受SAR-BM3D算法中非局部滤波强大去噪能力的影响[34],Cozzolino等[35]将非局部滤波与深度学习相结合,提出一种CNN-NLM去噪算法,通过利用图像间的局部相似性评估隐藏信息,提高网络性能。该算法在图像细节保存方面具有一定优势。但在去噪性能上还存在一定不足。其原因在于缺乏可靠的参考图像。Liu等[10]通过在非下采样剪切波变换域(non-sub sample shearlet transform,NSST)应用连续循环平移算法和CNN相结合提出一种新的混合去噪算法。在轮廓线的帮助下,Liu等[36]提出CCNN去噪算法。

3.2 基于自监督学习的SAR图像去噪

自监督学习的思想非常简单,输入的是一堆无监督的数据,但通过数据本身的结构或者特性,人为构造标签出来。有了标签之后,就可以类似监督学习一样进行训练。基于自监督思想,Yuan等[37]提出一种用于SAR图像盲去噪自监督密集膨胀卷积网络——BDSS,训练过程不需要干净图像,通过优化L2损失学习噪声,其网络结构通过采用3个增强密集块,并加入膨胀卷积以扩大感受野,较好的保存了图像信息。Molini等[38]采用自监督贝叶斯去噪网络,直接对噪声图像进行训练,学习真实图像特征,然后进行测试,从而避免通过模拟噪声图像学习的不准确特征信息,产生信息丢失现象,进一步提高了真实SAR图像的去噪效果。Molini等[39]又提出盲点卷积神将网络——Speckle2Void,通过建立贝叶斯模型来描述干净的SAR图像中的散斑和像素的先验分布,文中提出该算法的非局部和局部版本,通过实验发现,该算法优于基于模型的去噪算法。在noise2noise模型基础上[40],Dalsasso等[41]通过将时间变化补偿并采用自监督损失函数,提出了一种新的去散斑网络:SAR2SAR获得了较好的去噪效果。由于自监督学习去噪算法近两年刚应用于SAR图像去噪,所以相关的算法还不够成熟,因此,也成为该方向未来发展趋势。

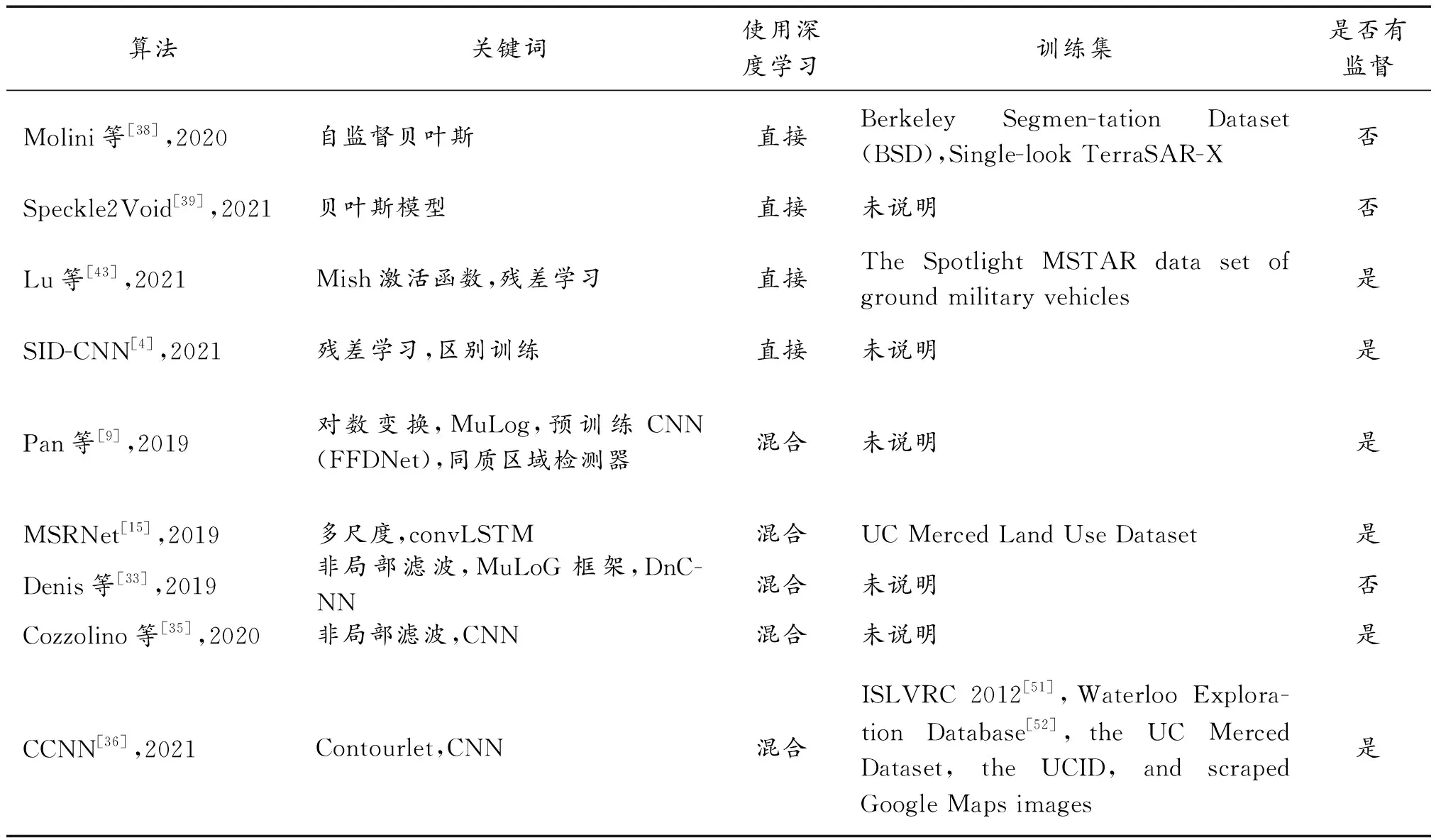

本文将上述所提到的SAR图像去噪算法进行分类总结,罗列出各种算法是否使用监督学习策略,算法中的核心关键词及用到的训练集汇总于表1中,便于读者更清晰快捷的了解算法相关信息。由表1可知,常用的训练数据集主要为UC Merced Land Use Dataset、UCID和BSD,而测试数据集包含两大类:一类是模拟图像,一类是真实SAR图像。另外,从表1中可知,传统的单一种类的深度学习在SAR图像去噪中已经逐渐减少,目前更多是结合多种网络结构(注意力、膨胀卷积、GAN等)或结合图像的先验知识(非局部相似性、低秩性等)进行去噪。由于训练数据集较少,因此,基于无监督深度学习的SAR图像去噪也是未来的热点研究方向。

表1 不同去噪算法

续表(表1)

4 训练与测试

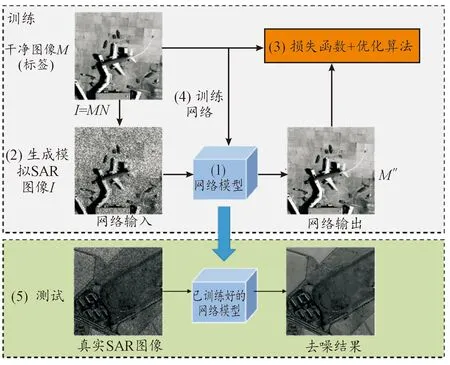

该部分首先对网络训练及测试的整体流程图进行描述,如图1所示。然后对实验所用数据集的数据获取方式和详细信息进行介绍,同时对网络训练过程中常用的损失函数及性能测试时常用的去噪指标进行总结。图1展示了采用监督学习进行训练及测试的一般网络结构的实现流程。具体实现步骤如下:

1) 根据所提出的网络框架设计出具体可行的网络结构,并对网络中的参数进行初步确定。

2) 训练集是从公开的数据集中选择一定量的干净图像作为标签,将训练集中未使用的图像作为网络训练过程中的测试集,并依据乘性噪声的产生方式,对其加入一定的乘性噪声得到模拟SAR图像。

3) 依据不同的侧重点,确定出网络训练过程中所需要的损失函数及优化算法。

4) 将噪声-干净图像对输入卷积神经网络中进行训练,得到一个初步处理后的去噪图像,在这期间,损失函数和优化算法会对标签和去噪图像进行比较分析,使二者尽可能的接近,即损失函数尽可能的接近于0,表明两者区别最小,模型产生最好的结果。然后保存训练好的模型,并进行测试。

5) 测试阶段,将模拟及真实的SAR图像输入到已训练好的网络模型中,得到散斑抑制后的干净图像,然后通过相应的指标进行性能测试。

图1 图像去噪流程示意图

下面将对训练及测试中用到的数据集,损失函数和评价指标进行分析。

4.1 SAR数据集

基于深度学习的SAR图像去噪需要大量的数据来训练网络,这是所有基于深度学习的方法中非常重要的一个环节。因此,SAR图像数据集的可用性亦是值得关注的。与以往合成孔径雷达数据的可使用区域受限或保密性问题导致获取受到限制不同,目前一些大型的合成孔径雷达数据集已经广泛免费提供。我们总结了基于深度学习的SAR图像去噪任务中常用的训练数据集,介绍了其主要特征及数据获取路径。

1)训练数据集:分别从以下几个常用的数据集进行描述Berkeley Segmentation Dataset:BSD数据集,也称伯克利分割数据集(berkeley segmentation dataset,BSD),于2001年由加州大学伯克利分校发布。BSDS300数据集分为包含200张图像的训练集和100张图像的测试集。

UC Merced land-use dataset:该数据集是一个可用于目标检测和图像分类研究的21类土地利用图像遥感数据集,每类含有100张图像,每张图像分辨率为256*256,共有2 100张。该数据集可从以下网址下载获取:http://weegee.vision.ucmerced.edu/datasets/landuse.html

The Uncompressed Colour Image Database (UCID):该数据集为一个彩色未压缩数据集,其中包含1 338幅干净图像,包括自然场景和室内室外的人造物体。通过以下网址下载:http://vision.doc.ntu.ac.uk/.

ISLVRC 2012:该数据集中包含训练数据、验证数据和测试数据。3组数据都包含1 000类对象的图像,总共有1 281 167张训练图像、50 000张验证图像和10万张测试图像。可由https://image-net.org/challenges/LSVRC/2012/下载。

Waterloo Exploration Databas:Ma等[52]构建了一个大型数据集,其中包含4 744幅原始干净自然图像和94 880幅受损的图像,主要包含七种类别,分别是:人、动物、植物、自然景观、城市景观、静物画和交通运输。可通过以下网址下载https://ece.uwaterloo.ca/~k29ma/exploration/

2) 真实数据集

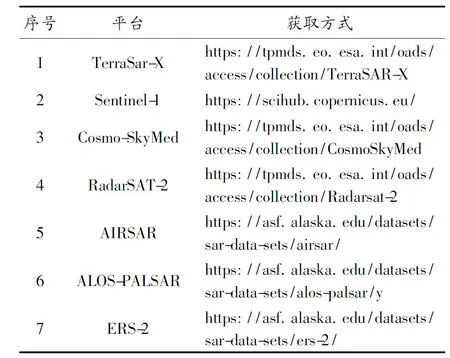

SAR数据集的获取比较困难,一些数据集往往需要进行支付才可以获取。很多情况下,由于保密等问题,它们的访问受到了限制。为了方便读者检索和下载SAR数据集,本文于表2中列出了常用真实图像测试数据集及获取方式。

表2 SAR数据获取方式

表2中给出这些数据都是真实的SAR图像数据集。这些网址也给出了数据集的描述,包括是否是星载卫星、成像的参数等。常用的数据集为Sentinel-1和TerraSar-X,它们提供了在不同的时间时刻获取相同的场景,并允许创建大型的多时间数据集。

4.2 损失函数

在深度学习中,损失函数的选择会影响网络训练的收敛速度和优化程度。通过梳理基于深度学习的SAR图像去噪方法中所用到的损失函数,我们发现大多数方法都含有一个数据保真度损失项,其大多数采用的是L1损失或L2损失。另外,在一些方法中,损失函数会包含附加项损失,一般选择总变分损失或感知损失。依赖于生成对抗网络的方法包含对抗损失。

1)L1范数损失

L1范数损失用于计算同样大小的干净参考和模型输出(估计值)之间的绝对值误差,公式如下:

(5)

在SAR图像去噪任务中,一般来讲,M表示SAR图像的干净参考,M″表示去噪后的图像,它们的大小都是W×H。L1范数损失函数是非凸函数,实现次优化,与L2范数损失相比,对噪声异常值的惩罚较小。

2)L2范数损失

L2范数损失用于有监督的训练过程,利用最小二乘法旨在计算干净参考图像与估计图像之间的距离,定义为:

(6)

可以观察到,L2范数损失是一个可微的凸函数,可使网络实现全局最优,可以评价数据的变化程度。但它对噪声异常值惩罚太大,易导致网络梯度爆炸。另外,将L2作为损失函数,预测的干净图像可能会出现伪影。

3) 总变分(total variation,TV)损失

总变分在图像去噪及复原任务上有着最直接和最有效的应用。受到噪声污染的图像的总变分比无噪声图像的总变分大,因此图像噪声可能就会对网络学习的结果产生非常大的影响。因此我们需要在最优化问题的模型中添加一些正则项来保持图像的光滑性,总变分损失是常用的一种正则项,配合其他损失来约束噪声,可通过以下公式计算:

(7)

该损失在一定程度上可以最小化相邻像素值之间的绝对差异,在保持图像边缘细节的同时增强图像的平滑度。

4) 感知损失

L1或L1范数损失是在像素层面对干净图像和估计图像进行约束,但真实视觉感知更依赖于图像的特征。感知损失常用于生成对抗网络GAN中,计算的是输入的噪声图像Y和干净参考图像M相对应的深层特征的之间的距离,由选取的神经网络来提取深层特征。通过最小化感知损失,使得估计的图像M″中含有更丰富的细节信息。其定义为:

(8)

式中:φ(·)表示预训练好的特征提取网络模型;k表示该网络的第k层。如在ID-GNN[28]中,作者选用预训练好的VGG16模型的ReLU7层来提取所需的特征图。

4.3 评价指标

1) 模拟SAR图像的评价指标

模拟SAR图像存在干净参考图像,一般采2个全参考指标——峰值信噪比(peak signal-to-noise ratio,PSNR)和结构相似性指数度量(structural similarity index,SSIM)评估去散斑性能和图像细节保存能力。

PNSR主要用于衡量去噪算法去除噪声的能力,PNSR值越高,表明去噪算法的散斑抑制性能越好[53]。其定义为:

(9)

式中:M表示干净参考图像;M″表示去噪后的图像。

SSIM主要用于衡量去噪算法对图像纹理结构的保持能力[54],SSIM值越接近于1,表明去噪算法去噪后图像的纹理信息越接近于参考图像。其计算公式为:

(10)

式中:μM″为去噪图像M″的平均值;μM为参考图像M的平均值;σM为M的标准偏差;σM″为M″的标准偏差;C1和C2为数值较小的2个正值,用来维持稳定。

2) 真实SAR图像的评价指标

由于真实图像不存在参考图像,因此选用无参考指标——等效视数(equivalent number of looks,ENL),基于平均比的边缘保持度(edge preservation degree based on the ratio of average,EPD-ROA),散斑抑制指数(speckle suppression index,SSI),散斑抑制和平均保持指数(speckle suppression and mean preservation index,SMPI)进行评价。

ENL是去噪图像同质区域噪声抑制指标[55],ENL值越高,表明去噪算法散斑抑制效果越好。其定义为:

(11)

式中:μM″和σM″分别表示M″同质区域的均值和标准偏差。

EPD-ROA值越接近1,表明去噪图像细节保存能力越强[56]。EPD-ROA计算公式如下:

(12)

SSI用于测量SAR图像中噪声的强度[57],表示为:

(13)

式中:σM″表示去噪图像的标准偏差;μI表示噪声图像的均值;μM″表示去噪图像的均值;σI表示噪声图像的标准偏差。SSI值越小,表明去噪算法散斑噪声的抑制能力越好。

SMPI被用于同时估计散斑抑制和平均保持能力,SMPI值越小越好[58],表示为:

(14)

式中:σM″表示去噪图像的标准偏差;σI表示噪声图像的标准偏差;Q=1+|μI-μM″|,μI表示噪声图像的均值,μM″表示去噪图像的均值。

5 实验结果与分析

为了说明基于深度学习去噪算法的去噪性能,通过对表1中基于深度学习的算法进行分析,从去噪能力强、细节保持能力强以及在两者之间最大程度实现平衡这三方面进行考虑,本文选用7种算法进行对比,在Sentinel-1数据集中选择200张图像进行测试,将其结果绘制成图2。

图2 200张Sentinel-1数据集测试结果平均值直方图

在视觉图展示上选择两幅真实SAR图像进行测试,其中图3(a)是L=3的FIXME图像;图4(a)是L=1的TerraSar-X图像,其为X波段,分辨率为1.10 m×1.04 m。每种算法的运行环境如下:IDCNN、SARDRN、NeighCNN[59]、CNN-GFF、CCSNet采用MATLAB(MatConvNet工具包);MRANet、MRDANet采用Python(Pytorch框架),为了方便,将测试图像命名为SAR1和SAR2,测试结果如图2和图3所示。

通过图3和图4的视觉效果可知,IDCNN、SARDRN和NeighCNN算法去噪效果较为明显,但是图像细节损失严重,重要信息被滤除;而CNN-GFF算法能够保留图像中的细节信息,但去噪能力不强;CCSNet算法算法能够在两者之间折中,但引入伪影;MRANet算法和MRDANet算法能够在去除噪声的同时保存更多图像细节信息。

图3 SAR1图像去噪结果图

图4 SAR2图像去噪结果图

6 结论

1) 基于深度学习的SAR图像去噪算法正在不断获得研究者的关注,在深层去噪网络架构中,采用噪声-干净图像对作为训练集的监督学习方式与传统方式的结合可提升网络的局部和全局特征提取能力,在自监督无监督等方面不断探索,提升去噪性能。

2) 基于深度学习的方法进一步探索确保去噪结果在性能和细节信息上的平衡,获得更好的视觉效果。一方面,研究者不断向无监督学习和自监督学习探索,或利用GAN中的生成器学习真实图像噪声进行模拟;另一方面,在各领域出现了许多新颖有效的网络模型,将这些网络模型应用到SAR图像去噪中,并很好地权衡去噪性能与细节保留之间的关系。