用于虚拟现实系统的眼动交互技术综述

侯守明,贾超兰*,张明敏

用于虚拟现实系统的眼动交互技术综述

侯守明1,贾超兰1*,张明敏2

(1.河南理工大学 计算机科学与技术学院,河南 焦作 454003; 2.浙江大学 计算机科学与技术学院,杭州 310027)(∗通信作者电子邮箱932503728@qq.com)

眼动人机交互利用眼动特点可以增强用户的沉浸感和提高舒适度,在虚拟现实(VR)系统中融入眼动交互技术对VR系统的普及起到至关重要的作用,已成为近年来的研究热点。对VR眼动交互技术的原理和类别进行阐述,分析了将VR系统与眼动交互技术结合的优势,归纳了目前市面上主流VR头显设备及典型的应用场景。在对有关VR眼动追踪相关实验分析的基础上,总结了VR眼动的研究热点问题,包括微型化设备、屈光度矫正、优质内容的匮乏、晕屏与眼球图像失真、定位精度、近眼显示系统,并针对相关的热点问题展望相应的解决方案。

计算机视觉;虚拟现实系统;眼动跟踪;人机交互

0 引言

虚拟现实(Virtual Reality, VR)利用传感器、多媒体、计算机仿真、计算机图形学等技术,提供一个虚拟的3D世界,已广泛应用在军事、游戏、旅游、教育、安全培训等领域。在虚拟世界中,设备需要识别用户输入的信息,并将信息及时反馈,以实现人机互动。虚拟世界的交互方法主要有:行为捕捉、肌电模拟、手势交互、眼动交互、触觉反馈、方向追踪、语音响应、传感器等。其中,眼动交互技术又名视线跟踪技术,用于检测用户注视特定目标时的眼睛行为和视线方向,使用者无需接触界面便可完成交互,能帮助用户获取物体位置,进而得到所观察事物的深度。在古希腊时期人们就开始研究眼动跟踪,而眼动跟踪概念却在20世纪30年代才出现,直到1901年,Doge和Cline才开发出第一台精确的、非强迫式的眼动追踪设备[1-3]。眼动交互作为一种重要的交互方式,可广泛应用于VR和增强现实(Augmented Reality, AR),为用户提供更好的沉浸感[4]。Brendan Iribe认为眼动跟踪是VR的心脏,通过对人眼位置的检测可以获得最佳的视觉效果,且基于VR的眼动跟踪技术是近年来的研究热点之一。眼动追踪可以获知虚拟物体的景深,故大部分从业者认为该技术将成为解决VR问题的重要突破口。除此之外,潜在的市场需求是促进在VR系统中使用眼动跟踪技术的原因之一。使用眼动跟踪技术的VR系统可广泛应用于教育、游戏、医疗、社交、产品测试及文化遗产保护等领域。可见,眼动跟踪技术将给人类的生活带来极大的改变。

本文通过梳理VR眼动人机交互技术的相关内容,总结了主流方法、技术原理、头显设备和应用场景,探讨研究了相关的热点问题和相应解决方案,以期为该领域的研究人员提供参考。

1 VR眼动交互技术

1.1 VR眼动交互技术原理

一般来说,人眼运动可以表征人的认知活动[5]。眼动主要可以分为两种模式:静态眼动模式和动态眼动模式[6]。静态眼动模式主要包括:注视和眨眼[7]。眨眼指飞快闭眼的动作,分为反射性眨眼和不自主眨眼[8]。动态眼动模式包括:平滑尾随运动和跳动[9]。人机交互技术指利用计算机的输入、输出设备(如:鼠标、键盘)来完成计算机与人之间信息的交互[10]。纵观人机交互的发展历程,从命令语言阶段、图形用户界面到现在的多方式交互,就是用户与计算机之间带宽减小的时期[11]。眼动人机交互指眼动设备在“理解”眼动信息的基础上做出相应操作,实现交互。首先,眼动设备中需要建立人机交互系统,实现设备与人的通信;其次,利用相关算法,如图像处理算法,将眼动信息转化为眼动设备能够“理解”的计算机信息,实现信息传递。其中,眼动追踪方法从早期的直接观察法、主观感知法、机械记录法逐步演变为基于瞳孔‒角膜反射向量法(Pupil Center Cornea Reflection, PCCR)[12]、眼电图法(Electro‑OculoGraph, EOG)[13]、虹膜检测法、角膜反射法[14]、三维模型重建法、反射光强度建模法、双普金野象法。

1.2 VR眼动交互流程

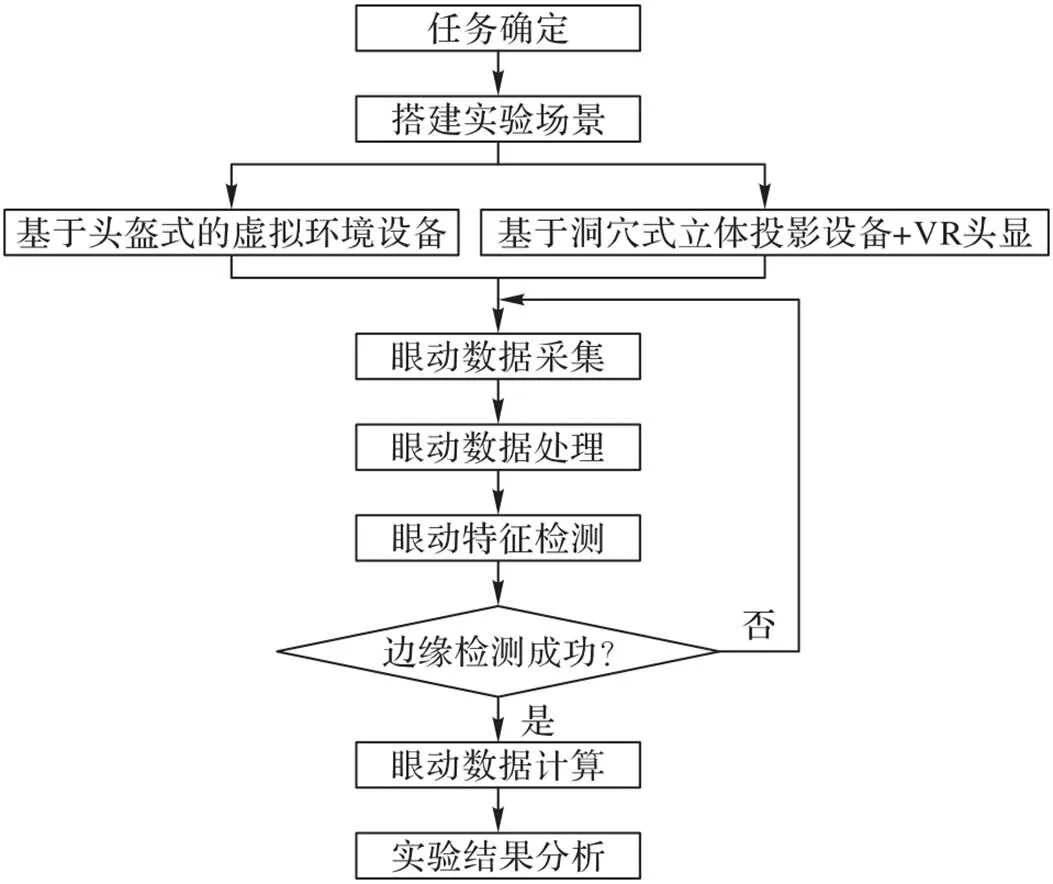

VR眼动交互技术设计主要分为以下部分,具体过程如图1所示。

1)搭建实验场景:首先创建模型,再将该模型导入到场景搭建软件中,如Unity3D。

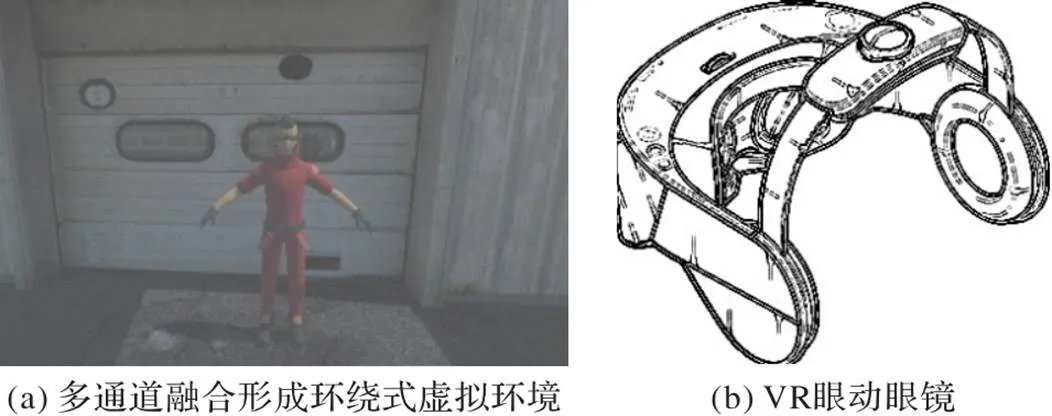

2)选择实验设备:目前,根据VR实验环境的不同,可从两个方面选择VR设备。当对实验环境要求较低、实验过程较为简单时,选择集成虚拟环境的VR头盔,即:基于头盔式虚拟环境设备,并使用注视点分布热图来表示元素的受关注度情况,如图2所示。当对环境要求较高,对实验结果要求更为精确时,选择使用通道融合的立体环绕式虚拟环境与VR眼动眼镜,即:基于洞穴式立体投影虚拟环境[15],如图3所示。

3)眼动数据采集:利用VR眼动设备自身携带的软件开发工具获得眼动数据。大致分为三步:获取清晰的眼睛图像、识别角膜反射点以及识别瞳孔。

4)眼动数据处理:对利用红外摄像装置收集的信息进行处理,包括图像滤波和二值化处理。图像线性滤波主要分为三种:均值滤波、方框滤波和高斯滤波[16],通常情况下,都使用滤波损失较小、滤波性能优良的高斯滤波;在图像的二值化处理中,由于虹膜与瞳孔的反射、吸收率和眼部图像灰度的差异,通过阈值函数选择不同的阈值对图像进行二值化处理。

5)眼动特征检测:眼动特征检测主要是对瞳孔和普尔钦斑进行检测,其中瞳孔检测指瞳孔定位,普尔钦斑检测是为了进行模板匹配[17]。

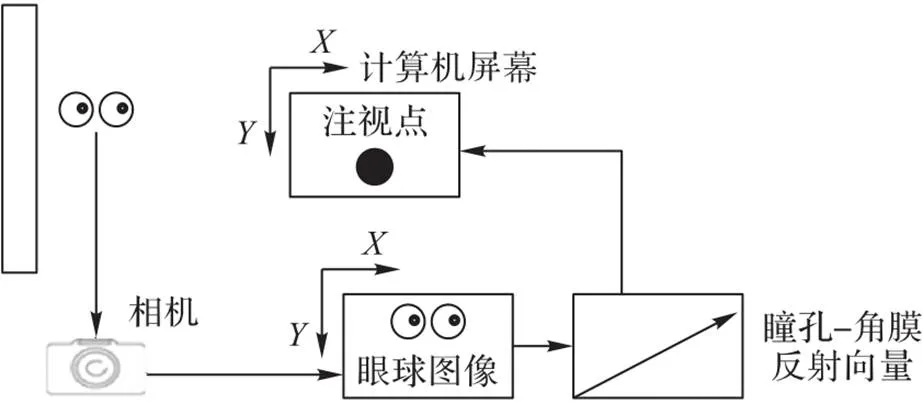

6)眼动数据计算:为准确定位注视点的坐标,首先建立瞳孔‒角膜反射向量,并将之映射为计算机屏幕上的坐标,该坐标通过注视点标定技术求解,如图4。

图1 VR眼动设计流程

图2 注视点分布热图

图3 洞穴式立体投影虚拟环境体验与VR眼动眼镜

图4 注视点标定技术[18]

1.3 VR眼动追踪方法

近年来,随着VR和眼动追踪的发展,研究人员将眼动追踪应用于VR领域,并基于瞳孔角膜反射法(Pupil Center Corneal Reflection,PCCR)、眼电图(Electro‑Oculogram,EOG)、三维模型重建等方法进一步探求更优的VR眼动融合算法。研究VR眼动追踪最具代表性的企业有Google、Facebook和Oculus等。

1.3.1眼睛影像捕获法

眼睛影像捕获法使用内置摄像装备去捕获通过光反光镜、光波导等传输的眼睛影像,该方法适用于摄像头正对着眼睛,且必须要拍摄到眼睛图像。目前,对该技术研究较多的企业有SMI、Apple、Google和TOBII。Zhu等[19]使用传感器捕获眼睛影像到头戴式显示器,再通过模型预测当前视野;Zhu等[20]通过捕获传感器记录所捕获的眼底影像的全景;Lee等[21]开发了一种头戴式设备来跟踪眼睛的凝视方向并估计用户视觉平面上的注视点;Apple[22]利用眼部跟踪摄像头捕获低分辨率图像,进而在高分辨率帧之间追踪用户眼睛的运动情况。

1.3.2利用捕获影像调整显示内容法

利用捕获影像调整显示内容法可以根据内置摄像装备所采集的虹膜、巩膜和视网膜特征去计算眼睛注视方向,适用于含有摄像头和光波导的设备,并通过光波导来计算视网膜影像,目前,对此研究较为深入的企业是LUMUS、DIGILENS、Magic Leap(第二代或者第三代)、Facebook和三星。Cui等[23]提出使用波导和几何相位透镜(Geometric Phase Lens, GPL)的超紧凑型光学组合来增强捕获内容;Magic Leap[24]设计出了一种可以根据凝视方向、眼部运动来计算显示器内容的头戴式设备;Facebook[25]设计了一种用于将光重定向到波导中,并可以提供更高阶相差矫正的多功能衍射光学元件(Multifunctional Diffractive Optics Element,MDOG);Apple[26]提出在头戴式设备中加入光投射显示元件来实现注视点对准。

1.3.3重建眼球为三维模型法

重建眼球为三维模型法使用光场相机和结构光等设备将眼球重建为三维模型,再通过该三维模型计算眼球追踪方向,适用于有光场摄像头或全光摄像头并采用模型重建算法的情况。目前,Facebook、Microsoft和Oculus对此研究较为深入。另外,Yeh等[27]提出一种基于深度学习的高动态范围(High Dynamic Range,HDR)方法来提高3D重建的精度;Li等[28]研究了一种从二维组织显微镜图像中估计3D眼球球体的新方法;Microsoft[29]提出使用光场相机来获取视点数据;Oculus[30]在头戴式显示器上使用了光场相机进行眼动跟踪。

1.3.4反射法

反射法主要分为瞳孔角膜反射法、视网膜反射法和角膜反射法,适用于设备中含有反射功能的反射装置,如:MSMS反射镜。代表企业有Magic Leap、Digilens、Tobii 、SMI、Apple、Google和Sony,并且,国内外研究人员针对该方法也进行了一系列探索。曹奕铖等[31]利用瞳孔角膜反射法设计出一种对用户友好的视线跟踪系统;Naqvi等[32]在分析瞳孔角膜反射法的基础上,研究一种在驾驶员注意力不集中的情况下也可以安全驾驶的系统;Liu等[33]利用全息波导技术连接瞳孔中心和角膜反射向量来计算眼睛位置;Lee等[34]提出了一种基于模糊系统的方法,用于提高瞳孔和角膜检测的精度;Mestre等[35]提出了一种用于精确眼睛跟踪图像的注视估计方法;Ebisawa等[36]开发了一种基于瞳孔角膜反射法的凝视检测系统,该系统允许较大的头部运动并可以实现轻松的凝视校准;Hennessey等[37]使用多次角膜反射和点模式匹配对头部位移的PCCR矢量进行缩放校准;Ogawa等[38]使用角膜表面反射和全景相机进行注视点估计。

1.3.5多视角跟踪法

菲涅尔透镜是多视角跟踪法的重要设备,多视角跟踪法可以通过菲涅尔透镜去捕获眼睛的多个状态图以追踪眼睛姿势,该方法常用于含有多视角摄像机的场景。目前,Google、Facebook、Sony和Magic Leap都对该方法进行了深入研究。Magic Leap[39]提出了一种向用户显示虚拟内容的方法,该方法通过多波导前曲率来确定眼睛焦距;Bertel等[40]使用360°相机快速、随意捕获全景图,可从多个视角提高各个场景的结果。

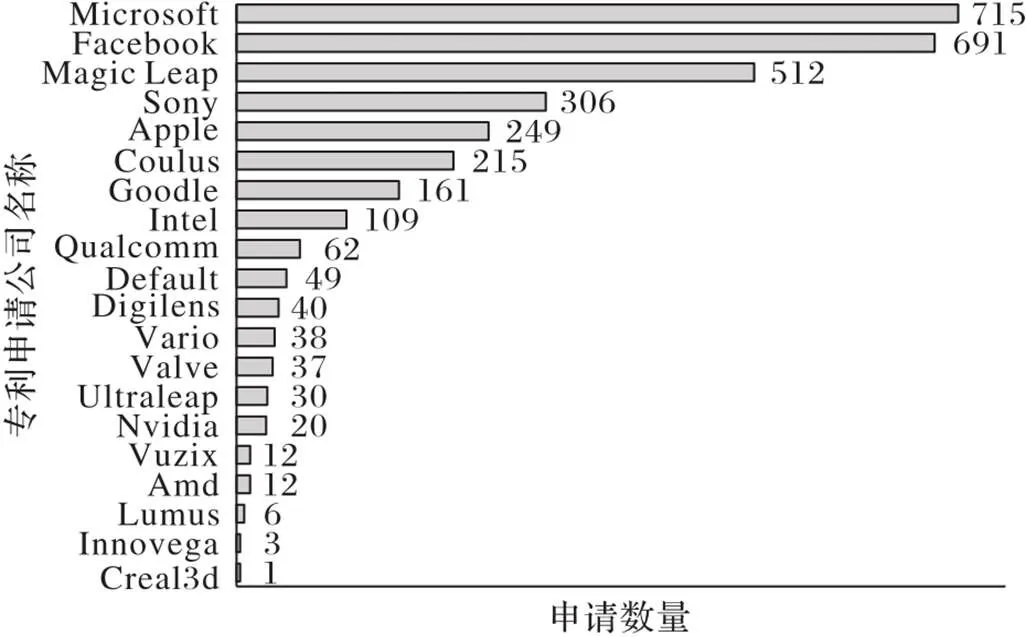

1.4 VR眼动专利申请量

目前,随着VR技术的不断发展,全球各大公司申请的相关专利数也在递增,图5中展示了在映维网上检索统计到的2016―2021年全球主流VR眼镜公司发布的眼球追踪技术相关专利的申请数量。可以看出,位列全球前五的申请人为:Microsoft、Facebook、Magic Leap、Sony和Oculus。

图5 VR眼动追踪技术专利申请数量

接下来,本文对Microsoft、Facebook、Magic Leap、Sony等公司近三年申请的VR眼动追踪的部分专利的技术原理进行梳理和综述。

Multi‑perspective eye‑tracking for VR/AR systems[41]由Google公司申请,该专利的显示系统使用小透镜阵列或菲涅尔透镜作为分段光学阵列来捕获眼睛的多视角图像,并使用神经网络选择眼睛视角,根据选择的多视角组合来跟踪用户眼睛的姿势。

Adaptive VR/AR viewing based on a users eye condition profile[42]由Disney公司申请,该专利为解决用户因近视、远视、散光等因素带来的不适,软件应用程序基于用户的眼睛状况数据(包括:为矫正近视或远视而使用的镜片度数、色盲数据等)映射到视频渲染参数(包括:亮度、对比度、颜色等),将呈现的数据通过光学部件的矫正用于VR/AR头戴式显示器。

Display with eye tracking and adaptive optics[43]由Microsoft公司申请,该专利使用自适应光学组件作为光学设备来矫正入射到眼睛的光线,使用户眼睛注视方向与瞳孔位置可以平行。

Selecting a text input field using eye gaze[44]由Apple公司申请,该专利描述了眼睛与电子设备进行交互的过程,首先通过注视传感器来确定眼睛注视的特性,然后确定眼睛的注视位置。

Eye tracking system for head‑mounted display devices[45]由Valve公司申请,该专利描述在VR/AR等头戴式设备中,能够通过光源、光检测器和偏振器实现眼动追踪系统,并使用机器来追踪眼睛的凝视方向。

Method and system for eye tracking using speckle patterns[46]由Magic Leap公司申请,该专利使用眼睛的预校准散斑图来确定眼睛的初始位置,主要方法是先将光束照向眼睛,接着检测由眼睛反射的光束形成的散斑图案,最后使用帧跟踪眼睛来计算起始位置。

Eye tracking system with holographic film decoder[47]由Sony公司申请,该专利设计了一种带有全息胶片解码器的眼动追踪系统。该系统使用预先记录的有图案的全息薄膜将来自眼睛的发光二极管(Light Emitting Diode,LED)编码转化为二进制图案,该二进制图案能够将低分辨率单声道图像转换为眼睛姿势。

1.5 眼动交互技术分类

眼动人机交互是指计算机利用眼部信息来完成交互。目前,眼动交互技术可分为视线反馈技术和视线输入技术[48]。其中,视线反馈技术主要有附加信息反馈技术;视线输入技术主要有单一视线输入方式、多方式交互输入技术[49]。

1.5.1视线反馈技术

1)附加信息反馈技术:基于收集到的附加信息和眼动系统收集到的自然眼动信息帮助用户完成交互。

1986年,Kleinke[50]通过研究凝视、经验和情景前因的关系,提出了凝视和生理反应之间的关系。

2010年,Nakano等[51]通过实时收集用户凝视数据,提出一种基于凝视转换的3‑gram模式和参与敏感代理来判断听者是否参与对话及参与程度。

2014年,Engel等[52]使用单目同步定位与建图(Monocular Simultaneous Localization And Mapping, MSLAM)系统作为视觉传感器,通过卡尔曼滤波进行视觉和其他信息的融合。

2018年,Massiceti等[53]提出模拟回声定位和距离相关的嗡嗡声音音量调制方法,并让参与者在没有蒙住眼睛和蒙住眼睛的两种情况下在VR环境中实验。结果表明,在视觉信息指导下,参与者的速度更快且碰撞次数更少,但蒙住眼睛的实验有助于帮助盲人进行独立行动。

2021年,Gao等[54]提出基于投影仪的手术指导系统,该系统通过格雷码标定方法使投影仪能够通过摄像头进行标定,并基于光学空间定位器将附加信息可视化到手术场景中,有助于外科医生集中精力做手术。

2)信息呈现方式反馈技术:通过改变视觉信息的呈现方式完成交互。

2006年,Waddingham等[55]通过在VR系统中的一组实验,让弱视儿童观看具有流式双目呈现能力的视频和游戏,以达到治疗弱视的效果。

2019年,Forlim等[56]使用立体护目镜为用户呈现VR游戏场景,以解决VR刺激和虚拟机的连接不匹配问题。2019年,Vancleef等[57]为眼科诊所设计了一种在自动立体平板电脑上运行的游戏实验,该实验首先通过修改贝叶斯自适应梯度来调整目标差异,接着动态调整屏幕视差以达到所需的视网膜视差。

2020年,Lee等[58]针对大脑区域检测到的脑电波,以评估屏幕尺寸(智能手机、平板、电脑)和视觉呈现模式(2D、3D、AR、VR)对视觉疲劳的影响,有助于降低眼睛受伤和患病概率。

1.5.2视线输入技术

1)单一视线输入技术:由用户仅利用自主性移动视线完成字符输入工作。

2003年,Lin等[59]使用电荷耦合器件(Charge Coupled Device, CCD)作为输入源,在四种头戴式显示器的控制下测试了视网膜显示器的敏锐度,验证了视网膜光扫描在可穿戴低视力辅助设备中的独特性。

2012年,Lim等[60]开发了注视跟踪界面来控制3D游戏、远程手术、军事训练和飞行员模拟在内的3D内容,与仅通过鼠标、键盘控制的方法相比,更加自然有效。

2020年,Chi等[61]提出一种基于虹膜半径的角膜半径标定方法,用于远程单机双光源系统中的3D注视估计。该方法首先基于双目策略校准虹膜半径,使用校准后的虹膜半径估计空间虹膜中心,然后在角膜与虹膜间距离的约束下,通过非线性方程校准角膜边缘点。

2)多方式交互输入技术:用户通过自动移动眼球,并使用视线与鼠标键盘等相结合的方法完成交互。

2015年,Skodras等[62]首先从感官数据中提取面部特征,接着从中导出与凝视距离相关的距离向量,并使用附加信息改进垂直方向上细微眼睛运动的建模,提高了在自然条件下注视跟踪的准确性。

2020年,Pan等[63]基于空间定位、触觉刺激、场景感知等方式,提出了融合多方式的多轴VR感知机制系统,该系统可以极大增强用户体验感。

2020年,才华等[64]设计了一种基于多模态融合方法的VR模型。该模型通过输入不同学生的互动信息,让学生可以根据自己的需要,选择VR空间教室内各虚拟物体的状态进行学习。

2021年,黄君浩等[65]基于卷积神经网络估计人眼注视点位置,并使用眼动鼠标与眼动打字功能相结合来完成交互。

1.6 VR系统中融入眼动技术的优势

VR与眼动技术融合主要有以下几个优势:增加用户的沉浸感;降低疲劳、减小追踪误差;增强系统图形渲染能力并降低VR头显价格[66]。

1.6.1增强用户沉浸感

VR是虚拟事物在虚拟世界中的呈现,融合了立体显示、传感器和动态环境建模技术[67]。沉浸感是VR的三大特征中最主要的特征[68],用户的沉浸感取决于用户本身的体验,当用户感受到来自虚拟世界的刺激时,便会产生与真实世界一样的感受。眼动跟踪技术相较于手势、语音等其他交互方式,能够给用户带来更强的沉浸感与更优质的体验。

1.6.2降低疲劳并减少追踪误差

VR交互界面的发展经历了命令语言界面、直接操作界面、多媒体用户界面和多通道用户界[69]。语音控制、头部转动、手势交互都会使用户感到疲劳,在交互界面中加入眼动跟踪技术,通过传感器跟踪眼睛运动,采用视线点击完成信息交互,能够减轻用眼疲劳并提高用户对网上资源利用率和追踪精度,进而提升虚拟世界的社交化程度。

1.6.3增强图形渲染能力并降低头显成本

通常,利用视觉呈现的景物都是三维的,要在虚拟世界中看到立体、有景深的画面,对图像渲染能力要求极高。眼睛注视物体时,视觉中心的影像比较清晰,周围的影像比较模糊。注视点渲染技术利用眼动追踪能够获取人眼注视位置,并实现渲染位置随眼球运动而变化。中间区域使用高分辨率渲染,边缘区域利用低于高分辨率一半的低分辨率渲染,以减小产品负荷,降低VR头显的成本。

2 集成眼动技术的VR头显

VR头显内置高精度眼动追踪设备,可捕获到受试者的眼动踪迹,并将其转化为人眼可观察到的图形[70]。通常,VR眼动追踪系统由虚拟环境处理器、头盔显示器、身体姿态追踪器、高性能传感器以及感官系统组成,常用的高性能传感器主要有:SteamVR追踪传感器、定位传感器、触摸传感器、矫正传感器等。

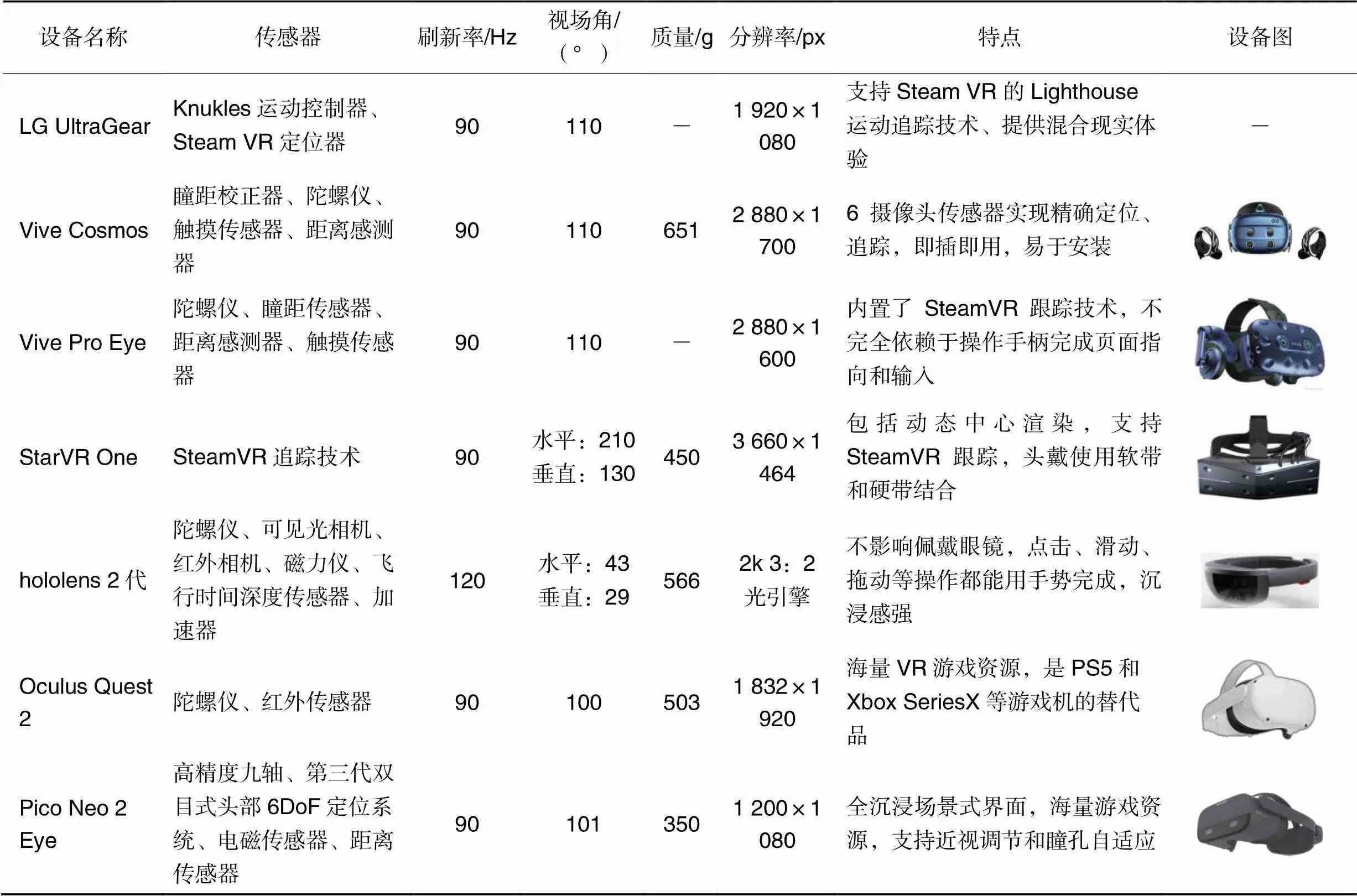

VR眼动设备是用于测量虚拟世界中人眼浏览信息情况和研究有关教育、医疗、社交、游戏等过程的专用仪器。目前,市面上出现了许多集成眼动跟踪系统的VR头显设备,如:LG UltraGear、Vive Cosmos、Vive Pro Eye、StarVR One等。表1汇总了近年集成眼动追踪技术的VR头显设备。

表1 集成眼动追踪技术的VR头显设备

3 VR眼动技术应用场景

VR眼动交互是在人机交互的基础上发展起来的一门新技术,主要应用于教育、医疗、社交、家具设计、旅游、新闻传播、设计装配、电子商务、运动和游戏等领域。实际应用中,可以从视觉效果、沉浸感、舒适度三个方面评价VR眼动系统的应用效果。其中:视觉效果指用户在虚拟环境下,即使快速切换场景,也能看到良好的视觉景象;沉浸感指当用户带入头戴式设备进入到虚拟环境中时,感觉系统可以出现与真实环境一样的感觉并完成处理[71];舒适度指用户在长时间佩戴过程中,眼睛依旧舒适,并且场景切换时眩晕感低。未来会有更多行业使用VR眼动交互技术。

3.1 医疗领域

目前,VR在健康医疗领域主要应用在临床医学和医学教育。随着应用的多元化,VR与医学深度结合主要有以下优势:1)患者康复训练中,真实训练没有虚拟环境中的训练有效;2)让医生可以更加直观认识病人的病灶,有助于医生更快、更方便制定出治疗方案;3)视觉效果、沉浸感与舒适度良好。在头戴式VR设备的基础上,Park等[72]使用加入红外眼动仪的头戴式设备,帮助患者进行前庭康复治疗。Kadhum等[73]通过比较弱视患者与健康人群在VR视频游戏中的不同表现,总结出治疗弱视的障碍。Gestefeld等[74]使用VR眼动追踪技术帮助偏盲患者进行视力恢复训练。

3.2 社交领域

近年来,随着各种社交APP的出现,人与人之间的交流方式不断变化,线上交流也成为一种主流的交流方式,但随着人们对多样化设计的要求,VR社交也逐步进入大众视野,虽然VR社交可以释放硬件资源、降低负载和功能,能够让VR设备视觉效果、沉浸感和舒适度达到最佳,但在VR世界中人们交流受限,不能直观了解对方,基于此,许多企业和研究人员也进行了探索。Oculus、Magic Leap、Facebook等公司都已经研究出了利用眼动跟踪进行捕捉人的面部表情的技术;SMI Social Eye系统可通过瞳孔反应表达自己真实感受,有利于交流。

3.3 游戏领域

作为一种先进的技术,VR在游戏领域的深入使用使游戏产业得到了突破性的发展。眼动跟踪让玩家通过眼球注视点完成主动输入操作,控制VR视角,使视觉效果、沉浸感与舒适度达到最好。但由于玩家控制游戏中的角色进行移动时,玩家需要大幅度移动手柄和多次按键,使玩家感到疲劳,且情感体验感不强,因此,Bai等[75]通过在VR排球游戏中构建虚拟角色来增强用户的情感体验。

3.4 设计领域

目前,家具展示多以图片、视频为主,不能让用户全方位了解家具的功能与特点,难以保证用户的体验效果。而在家具领域使用VR技术,可以展示家具的详细特点,眼动跟踪也可以贴切反映用户的体验感,两者结合有利于开发出适合用户使用的家具,创造出视觉效果、沉浸感与舒适度良好的家居环境。Fen等[76]以室内色彩因素与感性语义之间的权重关系为指导,可以帮助设计师更快地在VR中设计出用户需要的色彩;贺田潇等[77]使用VR眼动技术从图书馆内设施的材质、布局、高度出发,进行家具的研究设计。

3.5 教育领域

在教育领域结合VR技术可以帮助学生更加直观地学习知识并帮助他们健康成长。而随着VR的不断发展,VR技术在教育领域的应用也会更加深入,应用场景也会更加多元化。但VR教育由于技术上不成熟,也尚未在大中小学校普及,老师传授知识依旧是依靠文字视频的方式。Hou等[78]利用VR技术开发一个虚拟生态环境来学习台北树蛙,以提高学生的学习兴趣;Khan等[79]通过VR设备研究虚拟空间中儿童道路安全教育与在游戏中进行学习的关系。

4 问题与展望

近年来,为进一步提高VR眼动追踪在相关领域的应用效果,许多高校及研究机构都进行一些探究性实验,如:墨尔本大学的Pai等[80]通过在用户前臂上使用注视跟踪和肌电图检查系统,使虚拟空间中的选择任务更加高效,但此方法仅基于16位群众进行研究,不具有普适性;图宾根大学的Sipatchin等[81]使用Raspberry Pi系统测试VR时间精度,证明HTC Vive Pro Eye可作为视力丧失的在线帮助工具,但自动校准系统不够流畅;同济大学的郭亚楠等[82]在Unity 3D中搭建虚拟场景来完成眼动仪的对接,这有助于设计团队优化建筑风貌,实现民居现状和设计方案的实施对比;厦门大学的Zhang等[83]将眼睛定义为圆锥形光源,并基于传统眼动追踪技术,完成虚拟环境中的3D裸眼追踪和空间定位,设计VR眼动追踪平台,完成在虚拟环境中对眼动数据和协议数据的集成与量化。从已有研究看,VR眼动追踪技术依旧存在一些问题,还需要不断探索实验。

在已有研究的基础上,本文总结并分析VR眼动的热点问题,并提出相应的解决方案,认为目前VR眼动的热点问题集中在微型化设备、屈光度矫正、优质内容匮乏、晕屏与眼球图像失真、定位精度和近眼显示系统六个方面。

4.1 微型化设备

对于VR眼动设备而言,轻量化、小型化是其成功的关键。目前,市面上的VR眼动设备,虽然其重量已低至500 g,但用户长时间佩戴依旧会产生疲惫感。微软的HoloLens2采用激光显示器和碳纤维减轻头盔重量,提升用户体验感;Tundra Labs开发的SteamVR Tracking套件可将VR眼动设备的控制、处理和通信组件压缩为尺寸仅为16 mm×10 mm的微模块,该模块包含SteamVR Tracking、定位追踪器和TS4112传感器,通过简化设备的控制器和外设,从而使VR设备尺寸更小、重量更轻。Magic Leap提出了一种基于单晶硅的MSMS扫描仪,能够将光从第一光纤和第二光纤传送到悬梁臂远端的第一波导和第二波导,在悬梁臂上使用光纤、磁换能器和单晶硅等组件。单晶硅的厚度约为100 μm,因而让使用单晶硅衬底光学扫描仪的厚度约为100 μm,从而进一步小型化了VR/AR设备。未来,可以进一步改进全息光学器件,例如对光学元件进行多次折叠或采用自适应光学处理器,使光学元件的厚度可以更薄,从而减轻设备的重量。

4.2 屈光度矫正

基于VR眼动交互技术的智能眼镜针对近视人群的并不多,智能眼镜大多都必须加入屈光度矫正装置和VR眼动装置,不仅难以穿戴,还会降低用户体验感。在VR眼动系统中加入近视自动矫正模块,让用户使用VR设备时,能自动矫正视力,势必会进一步增加VR设备在用户中的普及度,进而提高用户的使用率。另外,长时间佩戴VR眼镜将造成用户视觉疲劳,降低用户视力,因此,屈光度问题成为VR设备发展的一大难题。目前,研究人员针对该问题不断探索,例如:Mohammadpour等[84]根据屈光度不正引起的图像质量退化问题,提出基于可计算的光场显示器方法。王洋[85]使用全变差方法绘制图像来矫正视觉畸变。Yang等[86]将全息3D投影技术用于近眼显示器以提高近眼计算效率。Xia等[87]使用时间复用技术,以矫正聚光调节冲突问题。未来,在光学器件中加入自适应屈光度矫正方法,例如通过修改光学透镜参数进行矫正,使VR头显能够针对不同用户的视力情况实现自适应调整,这样就无须配戴眼镜,可以为用户带来更好的体验感。

4.3 优质内容匮乏

优质内容匮乏是VR行业面临的又一大问题。目前,VR设备还处于完善阶段。首先,硬件设备不成熟,3D摄像机、传感器仍处于开发阶段,国内外团队更多关注的是如何提高硬件设备质量;其次,VR内容制作周期长、难度大,所有细节不仅要考虑视差校正、景深等因素,还需考虑与用户的契合度,会耗费较大的人力与物力;最后,面向文化、制造、医疗、教育等领域的内容缺失,也制约了优质内容的制作。基于以上问题,国内外研究人员进行不断探索,如:Wang等[88]提出利用卷积神经网络设计VR全景图像和3D场景视频。刘宁宁[89]提出基于VR的半实物煤矿操作平台,为复杂设备操作培训提供了新思路。随硬件设备质量的提升,会有更多的公司与团队(如:Pinta公司是国内最重要的VR内容制作公司之一)加入VR行业,推出优质内容也只是时间问题。未来,在VR眼动设备中融入运行速率类似于“浏览器功能”的组件,该组件能够直接渲染浏览器内部场景并将其呈现,这样在VR设备中将会加载更多优质内容。

4.4 晕屏与眼球图像失真

头戴式VR设备中,“晕屏”和眼球图像失真导致用户体验感降低。当体验者的眼睛快速移动时,由于视觉和前庭刺激之间存在差异,镜片呈现的全息虚拟影像的帧速率并不能与眼睛移动速度相匹配,导致眼球图像失真和晕动症。此外,图像渲染速率低、姿态定位速度过慢和聚焦与视差冲突也会造成“晕屏”。图像失真算法分为两类:1)制作模板图像,使用多项式坐标变换完成模板图和失真图像的地址映射[90-91];2)借用摄像机成像原理研究几何失真的原因[92]。针对以上两类算法国内外出现了很多研究案例,例如:郭科等[93]提出EBL‒帧筛除算法,采用相邻图像匹配点的位置计算EBL参数,进而筛选出最不清晰的图像帧,去掉这些帧,根据剩下的帧计算相机位姿。程克非等[94]提出一种通过人眼注视区进行图形校准,此方法利用重心提取、去噪处理、坐标变化等方式进行图像矫正。有研究表明通过优化VR系统中的运动,如:通过调整3D环境和实验装置可降低眩晕感并提高图像分辨率。另外,人体的运动数据是通过运动神经纤维将运动内容通过内耳传感系统传递到大脑,可以在VR眼动设备中加入多通道传感器(如:振动传感器、声音传感器)来改变大脑对运动的感知,从而预防晕动症的发生。

4.5 定位精度

精度是评估眼动追踪数据质量的重要依据之一。即使很小的精度误差都会带来很大的影响,识别精度受环境亮度、眼睛最佳状态、设备漂移(如:耳机滑动)等因素的影响。基于以上问题,研究者提出了许多算法。如:周晓荣[95]提出基于瞳孔中心二次提取处理和基于RANSAC的边界拟合法,此算法先使用中值滤波、自适应阈值二值化处理,然后使用边缘检测和边界拟合法进行瞳孔中心点坐标提取,较大概率避免了将眉毛眼睑等错检为瞳孔,提高了精度。Tripathi等[96]提出用连续校准来补偿耳机相对于头部的细小移动,可使精确度与明确校准一致,但是多次校准需要额外的时间。Konrad等[97]使用眼视差渲染技术来改善VR中的深度感知精度和真实感。惯性测量装置(Inertial Measurement Unit, IMU)是当前VR眼镜测量角度的最常用设备,但复杂场景中,多个IMU测量会导致识别精度降低;红外激光定位技术能够提高识别精度、降低硬件成本,但不适用于复杂场景。未来,随着VR技术的发展,基于深度相机或双目相机的SLAM技术并融合多个传感器和计算机视觉算法使VR头显实现身体多部位与环境的追踪,不仅适用于复杂场景,还能提高定位精度和识别速度。一方面,根据不同用户的头部特征,通过逐一实验来优化头戴式显示器中显示屏的放置位置并根据不同情形下的影响因素来矫正镜片能够提高精度;另一方面,多数VR眼动设备是使用姿态传感器对用户姿态进行输入,我们或许可以考虑将视觉传感器、惯性传感器、GPS和卡尔曼滤波器等相结合来提高用户输入数据的精度。

4.6 近眼显示系统

由于近眼显示系统设备小型化、微型化的需求,需要调整显示屏发出的光线路径,并对图像数据进行压缩和渐进传输,以减小头戴式显示器的显示屏与眼睛之间的距离。近年来,许多研究人员都致力于研究该问题,例如:Zhang等[98]使用拟人视觉成像技术来测量近眼显示器的关键参数,包括视场、角分辨率、眼眶和虚拟图像深度。Xiao等[99]提出一种基于定向散射全息波导和弯曲护目镜的同轴近眼显示系统,用以实现大视场、高LU和轻量化场景。Park等[100]介绍了一种用于近眼显示器的紧凑型光学元件,它使用一对微透镜阵列,在距眼睛几厘米以内的平视显示器上进行调节眼睛视线。王小东等[101]提出在使用深度学习进行实现估计时,加入多任务训练和多阶段输出,能够在不增加训练数据的基础上,提升视线估计精度。目前,近眼显示系统是提高VR眼动跟踪性能的关键技术之一,未来依旧可以沿着显示装置、光学引擎等方面探索出性能更优的系统,例如:通过提高光学组件中的输入滤光器、输出滤光器、反射折射透镜和波导反射组件的性能(如:更换表面材料提升光学参数、调整组件数量或者改变显示面板的倾斜度来匹配3D屏幕深度等),让光传播后呈现在显示器上的画面能使眼睛的状态最舒适。

5 结语

本文主要围绕用于VR系统的眼动交互技术相关研究及进展进行了综述。在VR中融入眼动交互技术意味着注意力跟踪过程可以被测量,这为准确理解人类的行为提供了可能性,但也面临巨大的挑战。眼动交互技术目前已经在减轻VR带来的眩晕感、疲惫感,增强环境的视觉效果、沉浸感、舒适度等方面给用户带来了更优质的体验,在心理学、医学、教育培训、游戏等领域的应用也逐步落地,相关研究人员针对VR眼动交互系统的屈光度矫正、晕屏与眼球图像失真、定位精度和近眼显示系统等方面的研究进展显著,各大巨头公司对具有眼动跟踪交互的VR头盔产品的研发趋之若鹜。展望VR系统中眼动交互技术的研究发展趋势,融合眼动跟踪软硬件的多感知人机自然交互的VR智能眼镜(头盔)的超轻量化以及智能化解决方案、多用户VR环境中基于眼动交互技术的情感传递模型、多领域眼动跟踪典型应用场景的拓展等将是未来一段时间内研究的重点和热点。

[1] 贾宏博,师国伟,姚钦. 眼动跟踪技术及其在军事领域的应用[J]. 航天医学与医学工程, 2016, 29(5): 385-390.(JIA H B, SHI G W, YAO Q. Eye tracking technology and its application in the military[J]. Space Medicine and Medical Engineering, 2016, 29(5): 385-390.)

[2] ROBINSON R M, THOMAS M L, WETZEL P A. Eye tracker development on the fiber optic helmet mounted display[C]// Proceedings of the SPIE 1116, Helmet‑Mounted Displays. Bellingham, WA: SPIE, 1989: 102-109.

[3] MORIMOTO C, MIMICA M R M. Eye gaze tracking techniques for interactive applications[J]. Computer Vision and Image Understanding, 2005, 98(1): 4-24.

[4] 王丽萍,汪成,邱飞岳,等. 深度图像中的3D手势姿态估计方法综述[J]. 小型微型计算机系统, 2021, 42(6): 1227-1235.(WANG L P, WANG C, QIU F Y, et al. Survey of 3D hand pose estimation methods using depth map[J]. Journal of Chinese Computer Systems, 2021, 42(6): 1227-1235.)

[5] RAYNER K. Eye movements in reading and information processing: 20 years of research[J]. Psychological Bulletin, 1998, 124(3): 372-422.

[6] ROBERTS E O, PROUDLOCK F A, MARTIN K, et al. Reading in schizophrenic subjects and their nonsymptomatic first‑degree relatives[J]. Schizophrenia Bulletin, 2013, 39(4): 896-907.

[7] 王文冠,沈建冰,贾云得. 视觉注意力检测综述[J]. 软件学报, 2019, 30(2): 416-439.(WANG W G, SHEN J B, JIA Y D. Review of visual attention detection[J]. Journal of Software, 2019, 30(2): 416-439.)

[8] 易琳,贾瑞双,刘然,等. 虚拟现实环境中视觉诱导晕动症的评估指标[J]. 航天医学与医学工程, 2018, 31(4): 437-445.(YI L, JIA R S, LIU R, et al. Evaluation indicators for visually induced motion sickness in virtual reality environment[J]. Space Medicine and Medical Engineering, 2018, 31(4): 437-445.)

[9] 周小龙,汤帆扬,管秋,等. 基于3D人眼模型的视线跟踪技术综述[J]. 计算机辅助设计与图形学学报, 2017, 29(9): 1579-1589.(ZHOU X L, TANG F Y, GUAN Q, et al. A survey of 3D eye model based gaze tracking[J]. Journal of Computer‑Aided Design and Computer Graphics, 2017, 29(9): 1579-1589.)

[10] BADI H. A survey on recent vision‑based gesture recognition[J]. Intelligent Industrial Systems, 2016, 2(2): 179-191.

[11] 黄进,张浩,田丰. 面向动态交互场景的计算模型[J]. 图学学报, 2021, 42(3): 359-366.(HUANG J, ZHANG H, TIAN F. Computational model for dynamic interactive scenarios[J]. Journal of Graphics, 2021, 42(3): 359-366.)

[12] HANSEN D W, JI Q. In the eye of the beholder: a survey of models for eyes and gaze[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2010, 32(3): 478-500.

[13] 路雪,卫兵,吴小培. 基于连续眨眼的人‒机交互新模式[J].计算机工程与应用,2018,54(20):263-270. (LU X, WEI B, WU X P. Novel human‑computer interaction model based on continuous eye‑blinks[J]. Computer Engineering and Applications, 2018, 54(20): 263-270.)

[14] MA C F, BAEK S J, CHOI K A, et al. Improved remote gaze estimation using corneal reflection‑adaptive geometric transforms[J]. Optical Engineering, 2014, 53(5): No.053112.

[15] 吕文蕾,贺田潇,耿晓杰. 虚拟现实结合眼动追踪技术在家具设计中的应用前景[J]. 木材工业, 2019, 33(3): 36-40.(LYU W L, HE T X, GENG X J. Application prospect of virtual reality combining eye tracking technology in furniture design[J]. China Wood Industry, 2019, 33(3): 36-40.)

[16] ARIKAWA M, HAYASHI K. Adaptive equalization of transmitter and receiver IQ skew by multi‑layer linear and widely linear filters with deepunfolding[J]. Optics Express, 2020, 28(16): 23478-23494.

[17] 朱博. 视线追踪技术及其在驾驶员与乘客监测系统中的应用研究[D]. 沈阳:东北大学, 2013:22-26.(ZHU B. Gaze tracking and its application in driver and passenger monitoring systems[D]. Shenyang: Northeastern University, 2013:22-26.)

[18] 程时伟,孙志强. 用于移动设备人机交互的眼动跟踪方法[J]. 计算机辅助设计与图形学报, 2014, 26(8):1354-1361.(CHENG S W, SUN Z Q. An approach to eye tracking for mobile device based interaction[J]. Journal of Computer‑Aided Design and Computer Graphics, 2014, 26(8):1354-1361.)

[19] ZHU Y C, ZHAI G T, MIN X K. The prediction of head and eye movement for 360 degree images[J]. Signal Processing: Image Communication, 2018, 69: 15-25.

[20] ZHU Y, ZHAI G, MIN X, et al. The prediction of saliency map for head and eye movements in 360 degree images[J]. IEEE Transactions on Multimedia, 2020, 22(9): 2331-2344.

[21] LEE K F, CHEN Y L, YU C W, et al. Gaze tracking and point estimation using low‑cost head‑mounted devices[J]. Sensors, 2020, 20(7): No.1917.

[22] Apple Inc.Eye tracking using low resolution images: 20210081040[P]. 2021-03-18.

[23] CUI W, CHANG C L, GAO L. Development of an ultra‑compact optical combiner for augmented reality using geometric phase lenses[J]. Optics Letters, 2020, 45(10): 2808-2811.

[24] Magic Laep, Inc. Content interaction driven by eye metrics: 20210181514[P]. 2021-06-17.

[25] Facebook Technologies, LLC. Hybrid coupling diffractive optical element: 20210173210[P]. 2021-06-10.

[26] Apple Inc. Optical alignment for head‑mounted device: 20210149203[P]. 2021-05-20.

[27] YEH C H, LIN M H. Robust 3D reconstruction using HDR‑based SLAM[J]. IEEE Access, 2021, 9: 16568-16581.

[28] LI H X, YU H Y, KIM Y K, et al. Computational model‑based estimation of mouse eyeball structure from two‑dimensional flatmount microscopy images[J]. Translational Vision Science and Technology, 2021, 10(4): No.25.

[29] Microsoft Technology Licensing, LLC. Light field camera modules and light field camera module arrays: 20210021785[P]. 2021-01-21.

[30] Oculus VR, LLC. Eye tracking using a light field camera on a head‑mounted display: 20180173303[P]. 2018-06-21.

[31] 曹奕铖,蒋路茸,童基均. 基于瞳孔角膜反射法的视线估计系统设计与实现[J]. 浙江理工大学学报(自然科学版), 2019, 41(2): 201-207.(CAO Y C, JIANG L R, TONG J J. Design and implementation of line of sight estimation system based on pupil corneal reflection method[J]. Journal of Zhejiang Sci‑Tech University (Natural Sciences Edition), 2019, 41(2): 201-207.)

[32] NAQVI R A, ARSALAN M, BATCHULUUN G, et al. Deep learning‑based gaze detection system for automobile drivers using a NIR camera sensor[J]. Sensors, 2018, 18(2): No.456.

[33] LIU C G, PAZZUCCONI B, LIU J, et al. A holographic waveguide based eye tracker[C]// Proceedings of the SPIE 10474, Ophthalmic Technologies XXVIII. Bellingham, WA: SPIE, 2018: No.104741T.

[34] LEE D E, YOON H S, HONG H G, et al. Fuzzy‑system‑based detection of pupil center and corneal specular reflection for a driver‑gaze tracking system based on the symmetrical characteristics of face and facial feature points[J]. Symmetry, 2017, 9(11): No.267.

[35] MESTRE C, GAUTIER J, PUJOL J. Robust eye tracking based on multiple corneal reflections for clinical applications[J]. Journal of Biomedical Optics, 2018, 23(3): No.035001.

[36] EBISAWA Y, FUKUMOTO K. Head‑free, remote eye‑gaze detection system based on pupil‑corneal reflection method with easy calibration using two stereo‑calibrated video cameras[J]. IEEE Transactions on Biomedical Engineering, 2013, 60(10): 2952-2960.

[37] HENNESSEY C A, LAWRENCE P D. Improving the accuracy and reliability of remote system‑calibration‑free eye‑gaze tracking[J]. IEEE Transactions on Biomedical Engineering, 2009, 56(7): 1891-1900.

[38] OGAWA T, NAKAZAWA T, NISHIDA T. Point of gaze estimation using corneal surface reflection and omnidirectional camera image[J]. IEICE Transactions on Information and Systems, 2018, E101‑D(5): 1278-1287.

[39] Magic Leap, Inc. Virtual and augmented reality systems and methods: 20210141237[P]. 2021-05-13.

[40] BERTEL T, YUAN M Z, LINDROOS R, et al. OmniPhotos: casual 360° VR photography[J]. ACM Transactions on Graphics, 2020, 39(6): No.266.

[41] Google LLC. Multi‑perspective eye‑tracking for VR/AR systems: 20190129174[P]. 2019-05-02.

[42] Disney Enterprise, Inc. Adaptive VR/AR viewing based on a users eye condition profile: 20190056780[P]. 2019-02-21.

[43] Microsoft Technology Licensing, LLC. Display with eye tracking and adaptive optics: 20210239971[P]. 2021-08-05.

[44] Apple Inc. Selecting a text input field using eye gaze: 20210240331[P]. 2021-08-05.

[45] Valve Corporation. Eye tracking system for head‑mounted display devices: 20210232216[P]. 2021-07-29.

[46] Magic Leap, Inc. Method and system for eye tracking using speckle patterns: 20210232221[P]. 2021-07-29.

[47] Sony Interactive Entertainment Inc. Eye tracking system with holographic film decoder: 20190384386[P]. 2019-12-19.

[48] 吴凤山,葛贤亮,王丽. 眼动人机交互技术的类别与特点[J]. 人类工效学, 2017, 23(4): 80-86.(WU F S, GE X L, WANG L. Categories and characteristics of eye movement‑based human‑ computer interaction technology[J]. Chinese Journal of Ergonomics, 2017, 23(4): 80-86.)

[49] BROCKMOLE J R, LE‑HOA VÕ M. Semantic memory for contextual regularities within and across scene categories: evidence from eye movements[J]. Attention, Perception, and Psychophysics, 2010, 72(7): 1803-1813.

[50] KLEINKE C L. Gaze and eye contact: a research review[J]. Psychological Bulletin, 1986, 100(1): 78-100.

[51] NAKANO Y I, ISHII R. Estimating users engagement from eye‑ gaze behaviors in human‑agent conversations[C]// Proceedings of the 15th International Conference on Intelligent User Interfaces. New York: ACM, 2010: 139-148.

[52] ENGEL J, STURM J, CREMERS D. Scale‑aware navigation of a low‑cost quadrocopter with a monocular camera[J]. Robotics and Autonomous Systems, 2014, 62(11): 1646-1656.

[53] MASSICETI D, HICKS S L, VAN RHEEDE J J . Stereosonic vision: exploring visual‑to‑auditory sensory substitution mappings in an immersive virtual reality navigation paradigm[J]. PLoS ONE, 2018, 13(7): No.e0199389.

[54] GAO Y, ZHAO Y Y, XIE L, et al. A projector‑based augmented reality navigation system for computer‑assisted surgery[J]. Sensors, 2021, 21(9): No.2931.

[55] WADDINGHAM P E, BUTLER T K H, COBB S V, et al. Preliminary results from the use of the novel Interactive Binocular Treatment (I‑BiT™) system, in the treatment of strabismic and anisometropic amblyopia[J]. Eye, 2006, 20(3): 375-378.

[56] FORLIM C G, BITTNER L, MOSTAJERAN F. Stereoscopic renderinggoggles elicits higher functional connectivity during virtual reality gaming[J]. Frontiers in Human Neuroscience, 2019, 13: No.365.

[57] VANCLEEF K, SERRANO‑PEDRAZA I, SHARP C, et al. ASTEROID: a new clinical stereotest on an autostereo 3D tablet[J]. Translational Vision Science and Technology, 2019, 8(1): No.25.

[58] LEE C C, CHIANG H S, HSIAO M H. Effects of screen size and visual presentation on visual fatigue based on regional brain wave activity[J]. Journal of Supercomputing, 2021, 77(5): 4831-4851.

[59] LIN S K V, SEIBEL E J, FURNESS T A F, III. Testing visual search performance using retinal light scanning as a future wearable low vision aid[J]. International Journal of Human‑ Computer Interaction, 2003, 15(2): 245-263.

[60] LIM C J, KIM D. Development of gaze tracking interface for controlling 3D contents[J]. Sensors and Actuators A: Physical, 2012, 185: 151-159.

[61] CHI J N, WANG D, LU N, et al. Cornea radius calibration for remote 3D gaze tracking systems[J]. IEEE Access, 2020, 8:187634-187647.

[62] SKODRAS E, KANAS V G, FAKOTAKIS N. On visual gaze tracking based on a single low cost camera[J]. Signal Processing: Image Communication, 2015, 36: 29-42.

[63] PAN C T, SUN P Y, WANG S Y, et al. Integration of multi‑axis platform with synchronous motion‑sensing and virtual reality imagery for the depth of immersion[J]. The International Journal of Advanced Manufacturing Technology, 2020, 108: 91-103.

[64] 才华,孙俊,王爽,等.一种基于多模态融合方法的VR/AR模型构建方法:CN202010248294.5[P]. 2020-07-28.(CAI H, SUN J, WANG S, et al.A VR/AR model building method based on multimodal fusion method: CN202010248294.5 [P]. 2020-07-28.)

[65] 贺辉,黄君浩. 基于眼动跟踪的人机交互应用[J]. 山东大学学报(工学版), 2021, 51(2): 1-8.(HE H, HUANG J H. Eye tracking in human‑computer interaction control[J]. Journal of Shandong University (Engineering Science), 2021, 51(2): 1-8.)

[66] 冯成志,沈模卫. 视线跟踪技术及其在人机交互中的应用[J]. 浙江大学学报(理学版), 2002, 29(2): 225-232.(FENG C Z, SHEN M W. Application of gaze tracking in human computer interaction[J]. Journal of Zhejiang University (Science Edition), 2002, 29(2): 225-232.)

[67] 董士海. 人机交互的进展及面临的挑战[J]. 计算机辅助设计与图形学学报, 2004, 16(1):1-13.(DONG S H. Progress and challenges of human‑computer interaction[J]. Journal of Computer‑Aided Design and Graphics, 2004, 16(1):1-13.)

[68] MAHALIL I, RUSLI M E, YUSOF A M, et al. Study of immersion effectiveness in VR‑based stress therapy[C]// Proceedings of the 6th International Conference on Information Technology and Multimedia. Piscataway: IEEE, 2014: 380-385.

[69] HE Q, WU Y F, FENG Z P, et al. Triboelectric vibration sensor for a human‑machine interface built on ubiquitous surfaces[J]. Nano Energy, 2019, 59: 689-696.

[70] 苗岭. 虚拟现实眼动系统在环境交互设计中的研究[J]. 包装工程, 2018, 39(22): 274-281.(MIAO L. Eye‑tracking virtual reality system in environmental interaction design[J]. Packaging Engineering, 2018, 39(22): 274-281.)

[71] 黄东军,伯斯科,陈斌华. 沉浸感显示技术研究[J]. 计算机系统应用, 2007, 16(3): 43-46.(HUANG D J, BO S K, CHEN B H. Research on immersion display technology[J]. Computer Systems and Applications, 2007, 16(3): 43-46.)

[72] PARK J H, JEON H J, LIM E C, et al. Feasibility of eye tracking assisted vestibular rehabilitation strategy using immersive virtual reality[J]. Clinical and Experimental Otorhinolaryngology, 2019, 12(4):376-384.

[73] KADHUM A, TAN E T C, LEVI D M, et al. Barriers to successful dichoptic treatment for amblyopia in young children[J]. Graefes Archive for Clinical and Experimental Ophthalmology, 2021, 259(10):3149-3157.

[74] GESTEFELD B, KOOPMAN J, VRIJLING A, et al. Eye tracking and virtual reality in the rehabilitation of mobility of hemianopia patients: a user experience study[J]. International Journal of Orientation and Mobility, 2020, 11(1):7-19.

[75] BAI Z C, YAO N M, MISHRA N, et al. Enhancing emotional experience by building emotional virtual characters in VR volleyball games[J]. Computer Animation and Virtual Worlds, 2021, 32(3/4): No.e2008.

[76] FEN G, PAN Y. Research on home interior colour based on VR panoramic rendering experience[J]. Journal of the Ergonomics Society of Korea, 2020, 39(5): 423-435.

[77] 贺田潇,吕文蕾,耿晓杰,等.基于虚拟现实结合眼动技术的图书馆家具设计研究[J].家具与室内装饰,2018(12):12-13.(HE T X, LYU W L, GENG X J, et al. Research on library furniture design based on virtual reality combined with eye movement technique[J]. Furniture and Interior Design, 2018(12): 12-13.)

[78] HOU K L, LIU Y H, TARNG W. Development of a virtual ecological environment for learning the Taipei tree frog[J]. Sustainability, 2021, 13(11): No.5911.

[79] KHAN N, MUHAMMAD K, HUSSAIN T, et al. An adaptive game‑based learning strategy for children road safety education and practice in virtual space[J]. Sensors, 2021, 21(11): No.3661.

[80] PAI Y S, DINGLER T, KUNZE K. Assessing hands‑free interactions for VR using eye gaze and electromyography[J]. Virtual Reality, 2019, 23(2):119-131.

[81] SIPATCHIN A, WAHL S, RIFAI K. Eye‑tracking for clinical ophthalmology with Virtual Reality (VR): a case study of the HTC Vive Pro Eyes usability[J]. Healthcare, 2021, 9(2): No.180.

[82] 臧伟,郭亚楠,周鸣浩.基于VR眼动数据的空间环境信息采集分析方法和应用探究——以喀什高台民居保护与设计为例[C]// 数智营造:2020年全国建筑院系建筑数字技术教学与研究学术研讨会论文集. 北京:中国建筑工业出版社, 2020: 249-254.(ZANG W, GUO Y N, ZHOU M H. Research on methods and application of spatial environment information collection and analysis based on VR eye movement data ― taking protection and design of Gaotai ancient homes in Kashgar as an example[C]// Digital Design and Intelligent Construction: Proceedings of 2020 National Conference on Architectures Digital Technologies in Education and Research. Beijing: China Architecture and Building Press, 2020: 249-254.)

[83] ZHANG L M, ZHANG R X, JENG T S, et al. Cityscape protection using VR and eye tracking technology[J]. Journal of Visual Communication and Image Representation, 2019, 64: No.102639.

[84] MOHAMMADPOUR S, MEHRIDEHNAVI A, RABBANI H, et al. A pre‑compensation algorithm for different optical aberrations using an enhanced wiener filter and edge tapering[C]// Proceedings of the 11th International Conference on Information Science, Signal Processing and their Applications. Piscataway IEEE, 2012: 935-939.

[85] 王洋. 基于反卷积滤波的头盔显示图像人眼屈光度预校正算法研究[D]. 长春:长春理工大学, 2017: 1-51.(WANG Y. Research on pre‑correction algorithm of human eye diopter for helmet mounted image based on deconvolution filtering[D]. Changchun: Changchun University of Science and Technology, 2017: 1-51.)

[86] YANG X, ZHANG H B, WANG Q H. A fast computer‑generated holographic method for VR and AR near‑eye 3D display[J]. Applied Sciences, 2019, 9(19): No.4164.

[87] XIA X X, GUAN Y Q, STATE A, et al. Towards a switchable AR/VR near‑eye display with accommodation‑vergence and eyeglass prescription support[J]. IEEE Transactions on Visualization and Computer Graphics, 2019, 25(11): 3114-3124.

[88] WANG M, LYU X Q, LI Y J, et al. VR content creation and exploration with deep learning: a survey[J]. Computational Visual Media, 2020, 6(1):3-28.

[89] 刘宁宁. 基于VR虚拟现实的半实物综采实操平台[J]. 煤矿安全, 2019, 50(6): 114-117.(LIU N N. Semi‑physical fully- mechanized mining practical operating platform based on VR[J]. Safety in Coal Mines, 2019, 50(6): 114-117.)

[90] SMITH W E, VAKIL N, MAISLIN S A. Correction of distortion in endoscope images[J]. IEEE Transactions on Medical Imaging, 1992, 11(1): 117-122.

[91] HUGHES C, GLAVIN M, JONES E, et al. Wide‑angle camera technology for automotive applications: a review[J]. IET Intelligent Transport Systems, 2009, 3(1): 19-31.

[92] LIU A L, ZHANG J J, GUO B P. Geometric distortion correction for streak camera imaging[J]. Journal of Electronic Imaging, 2019, 28(3): No.033023.

[93] 郭科,方俊永,王潇,等. 一种视觉SLAM中运动模糊应对方法[J]. 哈尔滨工业大学学报, 2019, 51(11): 116-121.(GUO K, FANG J Y, WANG X, et al. A method to deal with motion blur in visual SLAM[J]. Journal of Harbin Institute of Technology, 2019, 51(11): 116-121.)

[94] 程克非,曹爽,台正. 一种眼动跟踪图像失真的校正方法[J]. 激光杂志, 2013, 34(2): 32-34.(CHNEG K F, CAO S, TAI Z. A method of image distortion correction based on eye tracking[J]. Laser Journal, 2013, 34(2): 32-34.)

[95] 周晓荣. 基于头戴式眼动仪的视线跟踪算法研究[D]. 哈尔滨:哈尔滨工业大学, 2019: 1-71.(ZHOU X R. Eye tracking algorithm based on head‑mounted eye tracker[D]. Harbin: Harbin Institute of Technology, 2019: 1-71.)

[96] TRIPATHI S, GUENTER B. A statistical approach to continuous self‑calibrating eye gaze tracking for head‑mounted virtual reality systems[C]// Proceedings of the 2017 IEEE Winter Conference on Applications of Computer Vision. Piscataway:IEEE, 2017: 862-870.

[97] KONRAD R, ANGELOPOULOS A, WETZSTEIN G. Gaze‑ contingent ocular parallax rendering for virtual reality[J]. ACM Transactions on Graphics, 2020, 39(2): No.10.

[98] ZHANG Q, SONG W, HU X, et al. Design of a near‑eye display measurement system using an anthropomorphic vision imaging method[J]. Optics Express, 2021, 29(9): 13204-13218.

[99] XIAO J S, LIU J, LV Z L, et al. On‑axis near‑eye display system based on directional scattering holographic waveguide and curved goggle[J]. Optics Express, 2019, 27(2): 1683-1692.

[100] PARK H S, HOSKINSON R, ABDOLLAHI H, et al. Compact near‑eye display system using a superlens‑based microlens array magnifier[J]. Optics Express, 2015, 23(24): 30618-30633.

[101] 王小东,谢良,闫慧炯,等. 基于多任务辅助推理的近眼视线估计方法[J]. 北京航空航天大学学报, 2022, 48(6):1030-1037.(WANG X D, XIE L, YAN H J, et al. Near‑eye gaze estimation method based on multi‑task auxiliary reasoning[J]. Journal of Beijing University of Aeronautics and Astronautics, 2022, 48(6):1030-1037.)

Review of eye movement‑based interaction techniques for virtual reality systems

HOU Shouming1, JIA Chaolan1*, ZHANG Mingmin2

(1,,454003,;2,,310027,)

Eye movement‑based human‑computer interaction can enhance the immersion and improve comfort of users by using eye‑movement characteristics, and the incorporating of eye movement‑based interaction techniques in Virtual Reality (VR) system plays a vital role in the popularity of VR systems, which has become a research hotspot in recent years. Firstly, the principles and categories of VR eye movement‑based interaction techniques were described, the advantages of combining VR systems with eye movement‑based interaction techniques were analyzed, and the current mainstream VR head‑mounted display devices and typical application scenarios were summarized. Then, based on the analysis of experiments related to VR eye tracking, the research hotspots of VR eye movement were summarized, including miniaturized equipment, diopter correction, lack of high‑quality content, blurring and distortion of eyeball images, positioning accuracy and near‑eye display system, and the corresponding solutions were prospected for those related hot issues.

computer vision; Virtual Reality (VR) system; eye tracking; human‑computer interaction

This work is partially supported by National Key Research and Development Program of China (2018YFB1004900), National Key Technologies of Henan(172102210273, 182102210310), Training Program for Young Backbone Teachers in Higher Education Institutions in Henan Province (2018GGJS298).

HOU Shouming, born in 1972, Ph. D., professor. His research interests include engineering digitalization and simulation, virtual reality, augmented reality.

JIA Chaolan, born in 1995, M. S. Her research interests include computer vision, virtual reality, augmented reality.

ZHANG Mingmin, born in 1968, Ph. D., senior engineer. Her research interests include virtual reality, human‑computer interaction.

1001-9081(2022)11-3534-10

10.11772/j.issn.1001-9081.2021122134

2021⁃12⁃21;

2022⁃02⁃27;

2022⁃03⁃07。

国家重点研发计划项目(2018YFB1004900);河南省科技攻关项目(172102210273, 182102210310);河南省高校青年骨干教师培养计划项目(2018GGJS298)。

TP391.9

A

侯守明(1972—),男,河南焦作人,教授,博士,CCF会员.主要研究方向:工程数字化与仿真、虚拟现实、增强现实;贾超兰(1995—),女,河南商丘人,硕士,主要研究方向:计算机视觉、虚拟现实、增强现实;张明敏(1968—),女,浙江宁波人,高级工程师,博士,主要研究方向:虚拟现实、人机交互。