基于改进RetinaNet的果园复杂环境下苹果检测

孙 俊,钱 磊,朱伟栋,周 鑫,戴春霞,武小红

基于改进RetinaNet的果园复杂环境下苹果检测

孙 俊,钱 磊,朱伟栋,周 鑫,戴春霞,武小红

(江苏大学电气信息工程学院,镇江 212013)

为了快速准确地检测重叠、遮挡等果园复杂环境下的苹果果实目标,该研究提出一种基于改进RetinaNet的苹果检测网络。首先,该网络在传统RetinaNet的骨干网络ResNet50中嵌入Res2Net模块,提高网络对苹果基础特征的提取能力;其次,采用加权双向特征金字塔网络(Bi-directional Feature Pyramid Network,BiFPN)对不同尺度的特征进行加权融合,提升对小目标和遮挡目标的召回率;最后,采用基于焦损失(Focal Loss)和高效交并比损失(Efficient Intersection over Union Loss,EIoU Loss)的联合损失函数对网络进行优化,提高网络的检测准确率。试验结果表明,改进的网络在测试集上对叶片遮挡、枝干/电线遮挡、果实遮挡和无遮挡的苹果检测精度分别为94.02%、86.74%、89.42%和94.84%,平均精度均值(mean Average Precision,mAP)达到91.26%,较传统RetinaNet提升了5.02个百分点,检测一张苹果图像耗时42.72 ms。与Faster-RCNN和YOLOv4等主流目标检测网络相比,改进网络具有优异的检测精度,同时可以满足实时性的要求,为采摘机器人的采摘策略提供了参考。

图像识别;采摘机器人;苹果检测;RetinaNet;BiFPN;EIoU;遮挡

0 引 言

中国是苹果生产和消费大国,2019年,中国苹果产量达到4 242.54万t,占全球的50%以上[1]。由于果园环境复杂,目前仍主要依靠人工采摘,存在生产效率低、成本高和劳动力不足等问题[2]。采摘机器人可以实现采摘工作的自动化,以苹果采摘机器人代替人工采摘具有重要的现实意义和广阔的应用前景[3]。快速准确的苹果检测系统是苹果采摘机器人的关键,由于树枝、叶片以及果实之间存在重叠和遮挡等诸多因素,增加了果园环境下苹果果实的识别难度。因此,如何在果园环境下实现稳健高效的苹果检测,对推进苹果采摘自动化起着决定性作用。

目前国内外对于水果检测方面的研究已经取得了一定的进展。廖崴等[4]利用基于R-B颜色特征的Otsu阈值分割方法,得到苹果果实和叶片图像,建立基于随机森林的绿色苹果识别模型,对苹果果实的识别率达到88%,但是识别效果易受光照影响。Ji等[5]利用支持向量机(Support Vector Machine,SVM)对苹果进行分类识别,对套袋苹果的识别率达到89%,但是识别速度较低,无法满足实时性要求。传统的苹果识别方法依赖图像预处理和人工设计特征,仅针对特定场景进行研究,受环境的影响较大,鲁棒性和泛化性不强,无法满足采摘机器人在各种复杂情景下的实际工作需求[6-9]。近年来,随着人工智能的快速发展,相比于传统方法,基于深度卷积神经网络的目标检测算法显现出巨大的优越性,深度卷积神经网络可以直接从大量样本中学习到特定目标的高维抽象特征,比人工提取的特征具有更强的鲁棒性。目前,基于深度学习的目标检测算法主要分为两大类,一类是基于区域建议的二阶段检测(two-stage detection)算法,代表性的算法有RCNN[10]、Fast RCNN[11]和Faster RCNN[12],该类算法优点是检测精度较高,缺点是检测速度较慢。李林升等[13]提出了基于Faster RCNN的苹果目标检测模型,以自然光源下的苹果图像为研究对象,设置9个不同尺度的候选框,并增加1个滑动窗口,提高了模型定位精度,对苹果的检测准确率达到97.6%。Sun等[14]提出了基于Faster RCNN的番茄关键器官的检测模型,使用Resnet50代替vgg16特征提取网络,并采用K-means聚类方法替代人工设置锚框尺寸,提高了检测精度。Jia等[15]在Mask RCNN网络的基础上,将残差网络(ResNet)与密集卷积网络(DenseNet)相结合,实现了对苹果的精准检测。Chu等[16]通过在Mask RCNN上添加抑制分支,过滤掉骨干网络学习到的非苹果特征,提高了对苹果的检测精度,F1值达到0.905,并实现了较快的检测速度。另一类是无区域建议网络的单阶段检测(one-stage detection)算法,代表性算法有SSD[17]、YOLO[18-19]等,该类算法利用单一卷积神经网络直接通过整幅图像预测目标的位置及类别,因此检测速度较快。赵德安等[20]通过改进YOLOv3算法,调整预设锚框尺寸,提高复杂环境下苹果的检测精度,并保持较高的检测速度。武星等[21]提出一种轻量型YOLOv3的苹果检测算法,设计同构残差块串联的特征提取网络,不仅减少了模型的内存占用,还提高了苹果检测精度。Tian等[22]用DenseNet方法处理YOLOv3 网络中分辨率较低的特征层,YOLOv3-dense模型能有效地检测重叠和遮挡条件下的苹果目标。彭红星等[23]提出了一种改进的SSD水果检测算法,利用迁移学习和随机梯度下降算法优化模型,实现对自然环境下4种水果的精准检测。Ma等[24]提出了一种改进的RetinaNet,采用MobileNetV3作为特征提取网络,对特征金字塔网络进行了改进,并利用K-means聚类算法优化了锚框的大小,提高了网络对苹果的检测精度和速度。王昱潭等[25]通过改进SSD模型,采用DenseNet作为骨干网络,用Inception模块替换SSD模型的前3层,在不加载预训练模型的情况下,对灵武长枣的检测精度达到了96.60%,并减少了模型的参数量。

上述研究仅仅把单一的水果作为识别对象,识别过程中未根据不同的遮挡情况对水果进行细致区分,不利于采摘机器人制定采摘策略,若被树枝或电线遮挡的水果被视作可采摘对象,可能会造成采摘机器人的末端抓手在采摘过程中,被树枝或电线损坏。因此,本文以果园环境下苹果为研究对象,根据苹果的不同遮挡类型。对苹果分类标注,在传统RetinaNet基础上进行网络结构改进,并在苹果数据集上训练,在测试集上验证改进网络的有效性,改进网络对不同遮挡类型苹果的检测结果,可以为采摘机器人在现代果园内机械化采摘提供理论依据。

1 材料与方法

1.1 试验数据来源

本文的苹果图像数据集包含A和B两部分,数据集A用于模型训练和寻优,该数据集从GitHub仓库(https://github.com/fu3lab/Scifresh-apple-RGB-images-with-multi-class-label)下载获取,苹果图像数据的采集背景为现代商业果园,共800张分辨率为1 920×1 080像素的苹果图像;数据集B用于验证模型在不同果园场景下的泛化性能,该数据集采集时间为2022年7月8日,采集地点位于英国伦敦的Queens果园,采集设备为iPhone12,共120张苹果图像,分辨率为4 032×3 024像素。

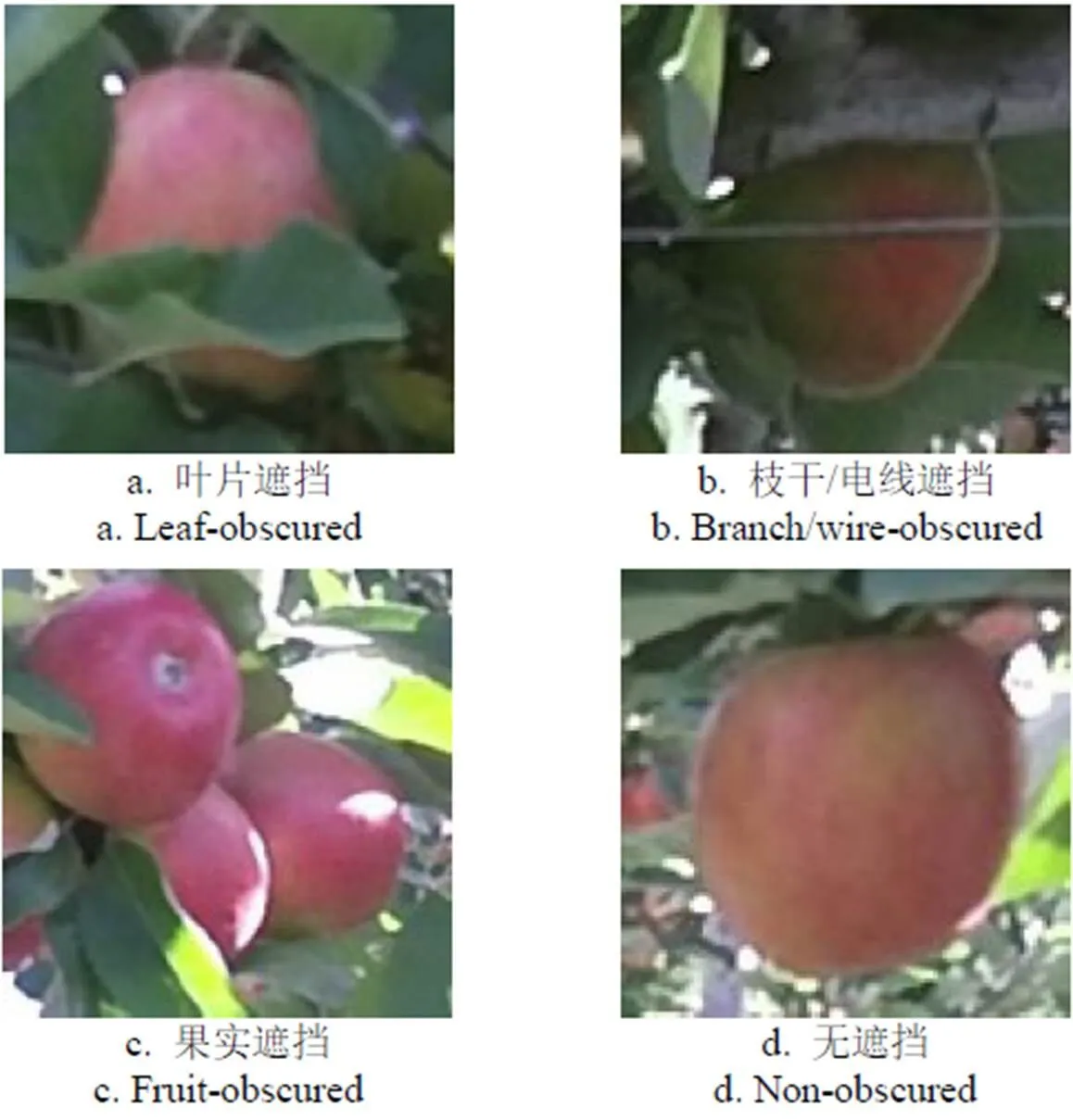

苹果图像标注采用的工具是labelImg软件,将图像中苹果标注框的坐标和标签信息保存至xml格式文件。由于果树上的苹果比较密集,存在多样的遮挡情况,若采摘机器人对被果实遮挡的苹果或被枝干/电线遮挡的苹果进行采摘,可能会破坏苹果果实或导致采摘机器人的末端抓手损坏,造成经济损失。因此本文根据不同的遮挡情况,将苹果目标分成了4类进行标注,如图1所示。第1类为叶片遮挡,表示苹果只存在叶片遮挡;第2类为枝干/电线遮挡,表示苹果被枝干/电线遮挡,无论是否同时被叶片或果实遮挡;第3类为果实遮挡,表示苹果被果实遮挡,无论是否同时被叶片遮挡,但不被枝干/电线遮挡;第4类为无遮挡,表示无任何遮挡的苹果目标。检测出不同遮挡类型的苹果,可以为采摘机器人的采摘策略制定提供理论依据,比如对无遮挡和叶片遮挡的苹果进行优先采摘,而被果实遮挡的苹果可以在采摘完前端苹果后再进行采摘,被枝干/电线遮挡的苹果则在当前位置不考虑采摘。

图1 四种遮挡类型的苹果

1.2 图像数据增强

深度学习的网络训练通常需要大量的数据,较少的数据量容易引起网络训练出现过拟合。本文利用数据增强来扩大苹果数据集样本,以增强训练完模型的泛化能力和鲁棒性。采取了水平翻转、镜像变换、图像亮度调整和添加高斯噪声等手段对数据集A实现了数据扩充,同时对转换后的图像标注文件进行了相应的变换,最后共获得4 800张苹果图像,在总样本中随机选取90%(4 320张)图像作为训练集,再在训练集中随机选取10%(432张)作为验证集。总样本中剩下的10%(480张)作为测试集,用于评估最终模型的泛化能力。

1.3 果园复杂背景苹果检测模型的改进

RetinaNet是Lin等[26]在2017年提出的单阶段目标检测网络。传统RetinaNet网络结构主要由三个部分组成,残差网络(ResNet)[27]为其骨干特征提取网络,特征金字塔网络(Feature Pyramid Network,FPN)[28]为其颈部特征融合网络,最后由2个全卷积子网络(Fully Convolutional Network,FCN)[29]分别实现分类和回归任务。RetinaNet使用Focal loss作为损失函数,减少易分类样本的权重,增加难分类样本的权重,解决目标检测任务中正负样本不平衡导致的网络朝着非理想方向优化的问题。

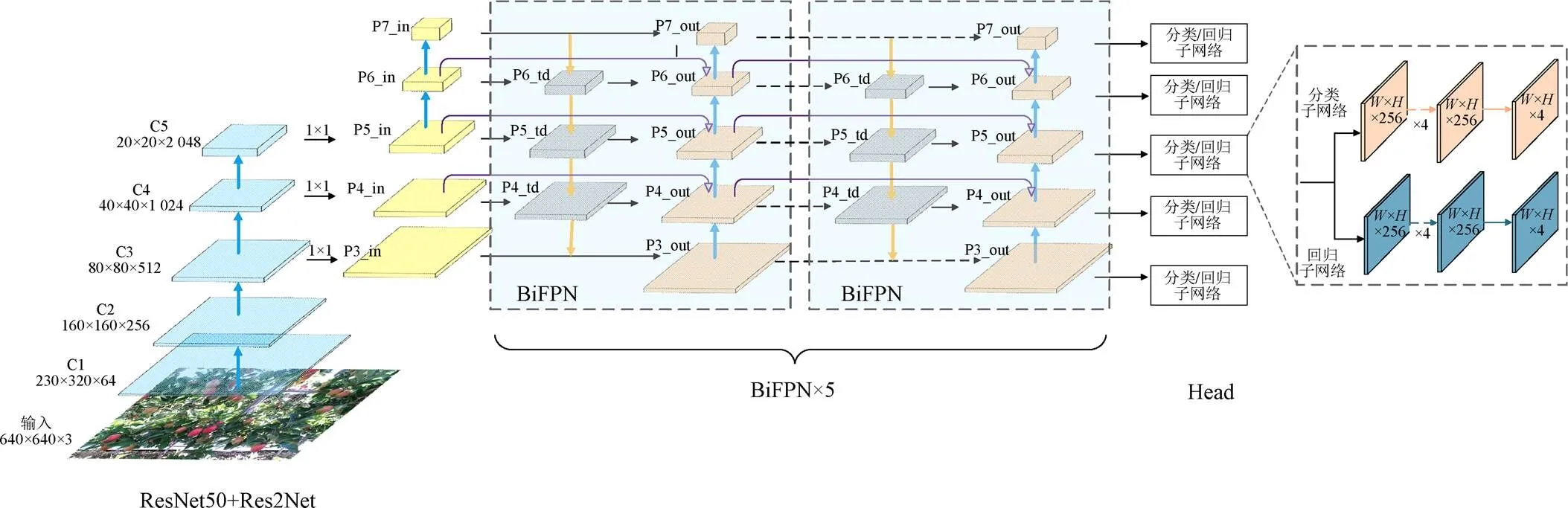

由于果园环境下背景复杂,果实之间存在较多重叠和遮挡情况,暴露出的果实面积大小不同,传统RetinaNet对小目标果实、重叠遮挡果实的漏检率较高。因此,本文在骨干特征提取网络ResNet50中嵌入Res2Net[30]多尺度特征提取模块,加强网络的多尺度性能,并采用BiFPN[31]作为颈部特征融合网络,对提取到的不同层级的特征图进行加权双向跨尺度融合,提高网络对不同大小和遮挡苹果的检测精度。改进后的网络结构如图2所示。

注:H,W为特征图的高和宽;P3_in,P4_in,P5_in,P6_in,P7_in表示5个输入层特征图,大小分别为80×80×256,40×40×256,20×20×256,10×10×256,5×5×256;P4_td,P5_td,P6_td表示3个中间层特征图,大小分别为40×40×256,20×20×256,10×10×256;P3_out,P4_out,P5_out,P6_out,P7_out表示5个输出层特征图,大小分别为80×80×256,40×40×256,20×20×256,10×10×256,5×5×256。

1.3.1 骨干特征提取网络

基础特征提取是目标检测任务的一个重要环节,Res2Net[30]模块能够提取不同感受野、多种尺度的特征,并且可以与多种结构融合形成更强的骨干网络,因此,本文在ResNet50中嵌入Res2Net模块,以提高骨干网络对多尺度特征的提取能力。Res2Net在瓶颈层(bottleneck)内部构建多通道残差连接,用3个3×3卷积核替代单个3×3的卷积核。输入特征经过1×1卷积调整通道后在通道维度分为四组,分别记作1、2、3和4,每组特征的通道数分别为输入特征通道数的1/4。1不进行任何操作直接输出为1;2经过一个3×3卷积核后分为两条支线,一条支线直接输出为2,另一条与3融合作为第三组的输入特征;以此类推得到第三、四组的输出3、4。最后,4个输出特征相加融合,并送入1×1卷积核进行通道调整得到总输出。Res2Net结构如图3所示。

输入特征每经过一个3×3卷积核,对应输出的感受野都会得到增加,最终Res2Net模块的总输出包含不同感受野大小的特征组合,不仅增加了网络层的等效感受野,还可以在更细粒度级别表示多尺度特征,进一步增强对重叠及遮挡情况下苹果特征的提取能力。

1.3.2 加权双向特征金字塔网络(BiFPN)

RetinaNet在颈部采用了传统的特征金字塔网络,对低层高分辨率特征图和高层强语义特征图进行跨尺度特征融合,然而融合过程仅采用自顶向下的单向路径,且对不同层级的特征图直接简单相加,忽略了不同分辨率的特征图对输出贡献度的不一致。

注:X表示输入特征;x1、x2、x3、x4表示4个输入的分组特征;y1、y2、y3、y4表示4个输出的分组特征;Y表示输出特征。

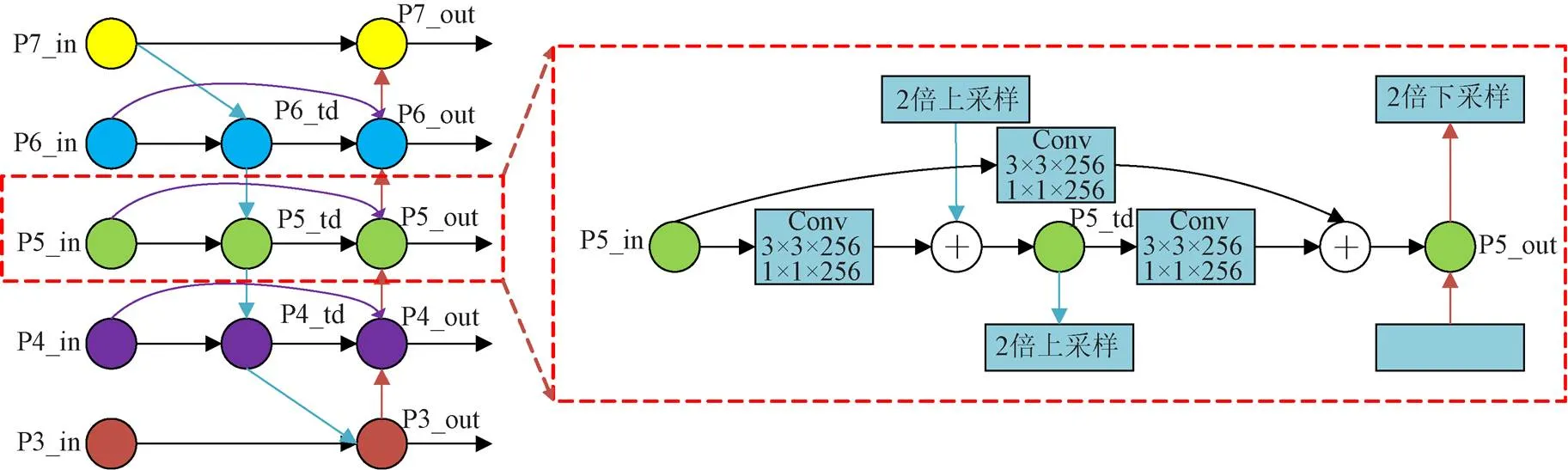

本文引入BiFPN[31]作为颈部网络,它是一种加权的双向特征金字塔网络,BiFPN结构如图4所示。结构上,去除了只有单个输入的节点,因为只有一个输入的节点,对网络融合不同特征的贡献小。在同一层级的输入与输出节点之间增加一条额外的支线,以类似残差的方式使输出获得更丰富的特征信息。首先,自顶向下对P7_in进行两倍上采样与P6_in加权融合,得到中间节点P6_td,以此类推依次得到P5_td和P4_td,P4_td两倍上采样与P3_in加权融合得到输出P3_out;其次,自底向上P3_out通过两倍下采样与P4_in、P4_td加权融合得到P4_out,以此类推依次得到P5_out、P6_out;最后,P6_out两倍下采样与P7_in加权融合得到P7_out。

注:Conv为深度可分离卷积;3×3×256代表256个3×3的卷积核;1×1×256代表256个1×1的卷积核。

由于不同输入特征具有不同的分辨率,对输出的贡献通常是不相等的,因此在特征融合过程中引入可学习的权值,并采用快速归一化融合让网络快速学习不同输入特征的重要性。

式中I为第个输入特征,为输出特征,w为对应输入的权重,每个w后面接Relu激活函数确保w≥0,=0.000 1以避免输出数值不稳定。为了进一步提高效率,压缩模型大小,特征融合过程中均采用深度可分离卷积,并在每次卷积后添加批归一化和激活。

BiFPN将每个双向(自顶向下&自底向上)路径视为一个特征网络层,本文通过试验探究,在改进网络中对BiFPN进行5次堆叠,实现了更深层高效的多尺度特征融合,P3_out~P7_out分别传输至头部的分类网络和回归网络。当输入图像分辨率为640×640像素时,网络在5×5、10×10、20×20、40×40和80×80这5个尺度的特征图上分别进行输出预测,实现对果园内不同大小和遮挡苹果的准确检测。

1.3.3 损失函数改进

本文的损失函数由两部分组成,为分类损失L和回归损失L,总体损失如式(2)所示,

L

=

Lcls

+

Lreg

(2)

在果园环境下苹果图像中,大部分区域是复杂的果园背景,苹果目标所占面积较小,因此为解决正负样本区域严重失衡问题,本文仍然采用原网络的Focal loss作为分类损失函数L,如式(3)所示。

Lcls

=-

αt

(1-

pt

)

γ

ln(

pt

) (3)

式中p表示预测苹果类别的概率,α表示平衡因子,表示焦距参数。本研究中取α=0.25,=2。

回归损失反映预测框与真实框的偏离程度,传统RetinaNet采用Smooth L1回归损失函数,独立计算预测框4个偏移量(宽、高和中心点坐标)的损失值,忽略了在相同的损失值时,预测框与真实框之间的重叠面积与相对位置并不唯一。因此,本文选择EIoU Loss作为回归损失函数L,该损失函数包含3个部分,分别为重叠损失IoU、中心距离损失L和边长损失L,其定义如式(4)所示。

式中IoU为交并比,反映预测框与真实框的重叠情况;、b分别为预测框和真实框中心点坐标;(·)为计算欧式距离;为预测框和真实框的最小包闭框的对角线长度;和w分别为预测框和真实框的宽;和h分别为预测框和真实框的高;D和D分别为预测框和真实框的最小包闭框的宽和高。

通过式(4)可以看出,EIoU Loss不仅关注预测框与真实框的重叠面积,还增加了中心距离损失作为惩罚项,并直接计算预测框与真实框之间的宽高损失。预测框与真实框在重叠、不相交或包含时,均能通过反向传播使网络训练快速准确地收敛。

2 模型的训练与试验

2.1 试验环境与参数设置

本文试验的操作平台为台式计算机,在Ubuntu18.04 LTS 64位系统环境下运行,采用能够支持GPU加速和动态神经网络的Pytorch1.8版本的深度学习开源框架,配合CUDA10.1进行模型搭建、训练与测试。计算机搭载的处理器为Intel Core i7-10700K @ 3.80GHz 十六核,内存为32 GB,显卡为RTX 3080,显存为10 GB。

2.2 评价指标

为了评价本文提出的果园环境下苹果检测模型的有效性,使用平均精度(Average Precision, AP)和平均精度均值(mean Average Precision, mAP)作为评价指标。

式中表示准确率,即预测框中检测正确的比例;表示召回率,即正确检测出的正样本在所有正样本中的比例;TP表示预测为正样本且实际为正样本;FP表示预测为正样本而实际为负样本;FN表示预测为负样本而实际为正样本。AP是评价某一类检测的平均精度值,通过和可以绘制PR曲线,计算PR曲线下的面积得到某一类的AP。mAP是衡量所有类别AP的平均值,如式(7)所示。

式中表示某一类别,为所有类别的集合。

2.3 模型训练

为减小显存压力,模型训练时将输入图像分辨率统一设置为640×640像素,采用4个样本作为一批,每迭代一批更新一次损失。为提高训练速度,本试验模型训练使用迁移学习,将训练分为两个阶段,分别是冻结阶段和解冻阶段。训练前50期为冻结阶段,特征提取网络参数不发生改变,仅对网络进行微调,初始学习率设置为0.000 1,采用Adam优化器,动量参数为0.9,若两次迭代损失不减小,则将学习率更新为0.5倍。训练50期之后为解冻阶段,网络所有参数都会随训练过程更新,初始学习率设置为0.000 01,学习率更新策略和前述保持一致。

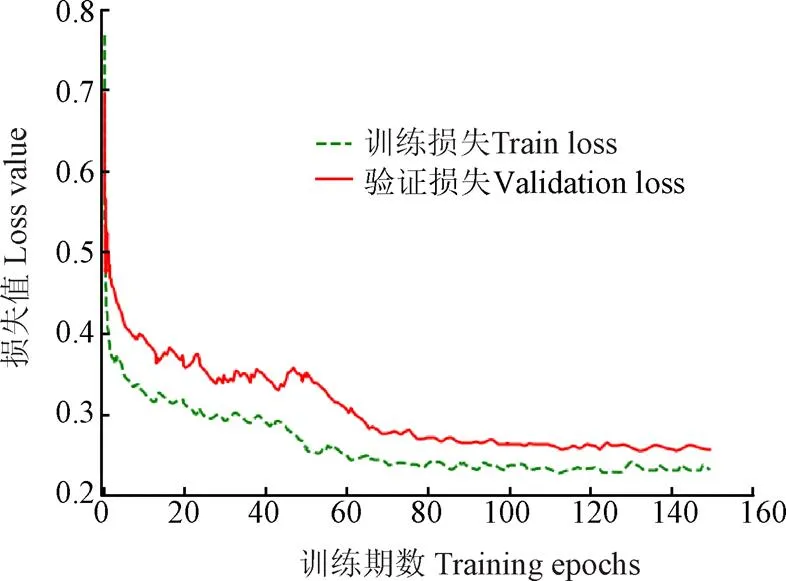

模型共训练150期,已经达到收敛,从训练日志得到损失值数据,绘制损失值曲线,如图5所示。可看出模型在前40期迭代中迅速拟合,训练集损失值和验证集损失值均快速变小,在80期迭代之后逐渐稳定,只有稍许的振荡,模型训练达到收敛。

图5 损失值变化曲线

3 结果与分析

3.1 模型的性能试验

在本文的试验中,模型一共训练了150期,每期迭代输出一个模型,由图5可知,训练在80期后基本达到平稳收敛,将稳定后的模型选出。为了验证模型的有效性,利用苹果数据集对最终获得的模型进行测试,结果如表1所示。

表1 模型的检测精度

由表1所知,模型在测试集上的平均精度均值达到91.26%,略低于在训练集和验证集的检测精度,结合图5的损失变化曲线,模型并未欠拟合或过拟合,验证了模型的有效性。但是,模型对测试集中枝干/电线遮挡苹果的检测精度较低,与训练集和验证集的该类别的检测精度相比,分别低了5.83和4.59个百分点,分析其原因是本试验的苹果数据集中枝干/电线遮挡苹果的数量比其他类别的数量少很多,导致模型对测试集上该类别遮挡苹果的泛化能力相对不足。

3.2 消融试验

为验证本文提出的各项改进措施对果园环境下苹果检测效果的提升,本文将不同改进程度的RetinaNet在测试集上进行了对比试验,对比试验的结果如表2所示。

表2 不同改进RetinaNet的检测精度对比

由表2可知,相比于传统RetinaNet,本文引入的不同改进对果园环境下不同遮挡情况下的苹果的检测精度均起到了提升效果。当仅在网络的骨干部分引入Res2Net模块时,增强了网络的多尺度特征提取能力,对不同遮挡类型的苹果检测精度均得到提高。仅将网络的颈部升级为BiFPN时,增进了网络不同层级间的特征高效融合,缓解了因网络层级过多引起的小目标特征信息丢失,对遮挡苹果的检测精度提升明显。仅将网络损失函数的回归分支替换为EIoU Loss时,提高了预测框对苹果目标的回归效率,网络的检测精度也得到一定提升。最终提出的改进网络对苹果的检测平均精度均值达到91.26%,相较于传统RetinaNet提升了5.02个百分点。

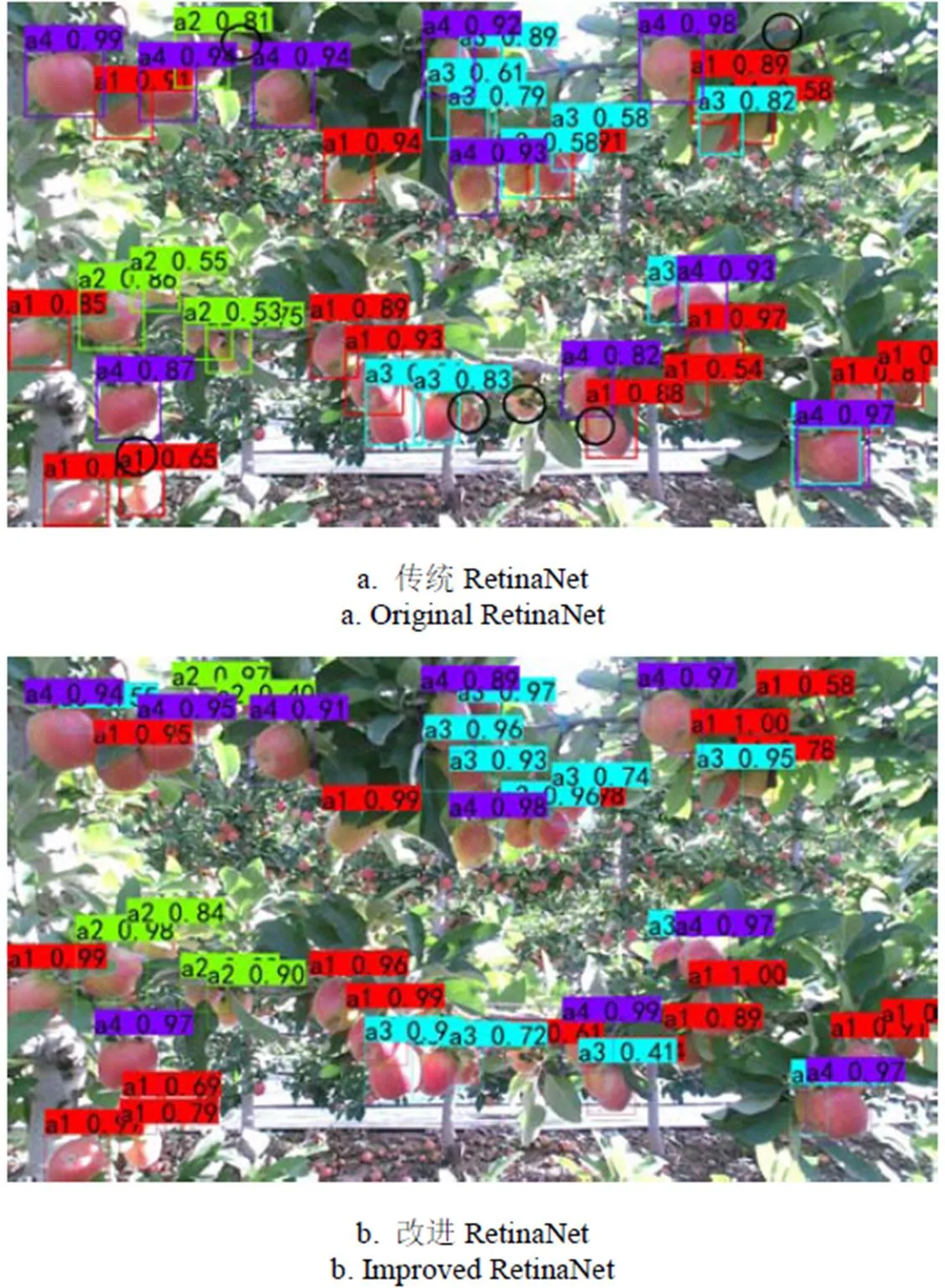

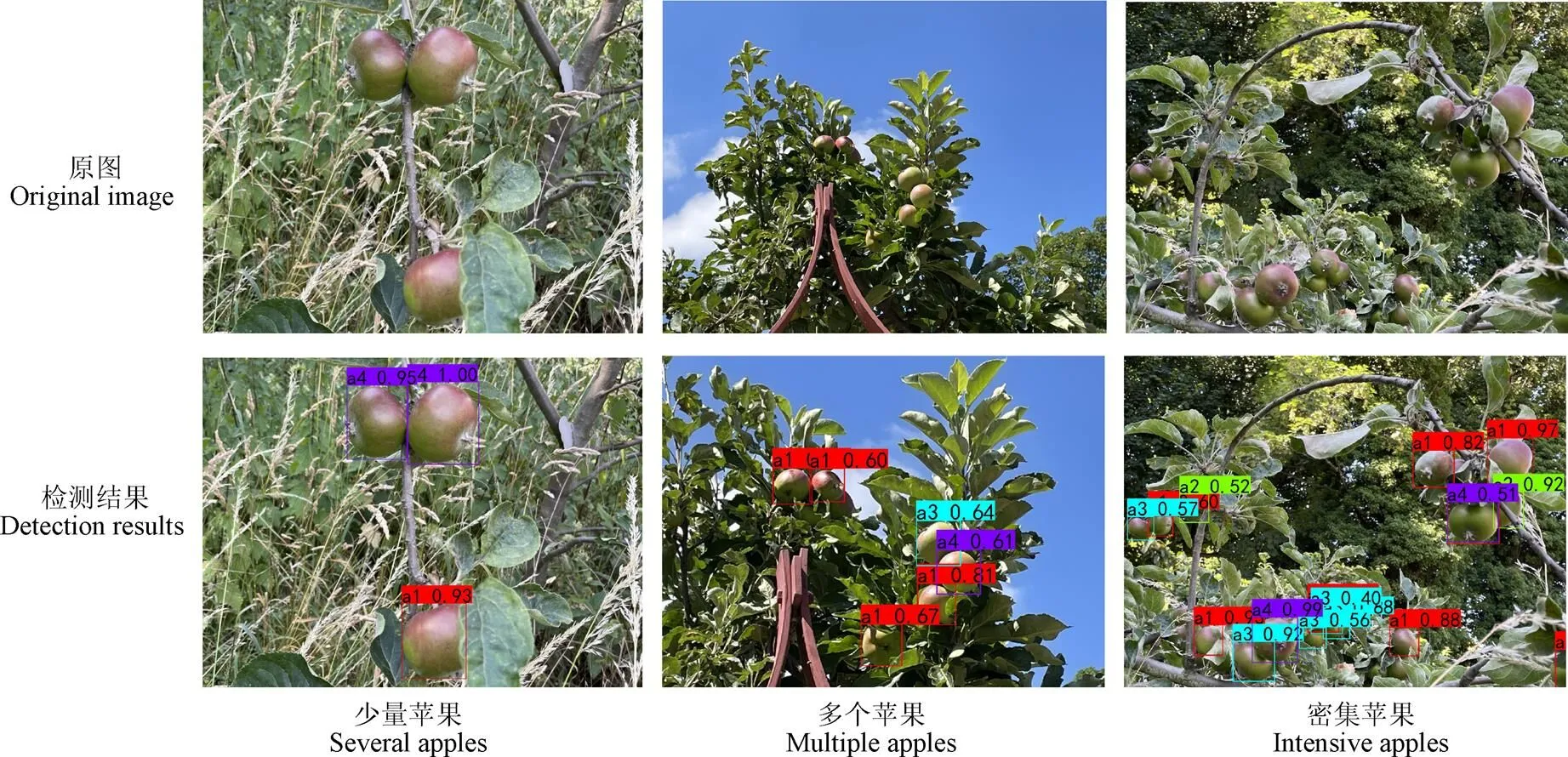

比较改进前后2种方法在测试集上对苹果的检测效果,部分测试结果如图6所示。当苹果果实较大且无遮挡时,包含更多有效的苹果信息,比较容易被网络精准检测,传统RetinaNet与改进RetinaNet均能取得较好的检测效果;而当苹果果实较小,或被树叶、果实或枝干遮挡时,由于果实暴露面积小,包含的有效苹果信息较少,检测难度增大,传统RetinaNet出现了漏检的情况,图中黑色圆圈标记的为未检测出的苹果果实,而改进网络则不受影响,正确检测出了所有果实目标。

注:a1表示叶片遮挡;a2表示枝干/电线遮挡;a3表示果实遮挡;a4表示无遮挡;检测框上方的数值表示检测为苹果的置信度;圆圈标记为未检测到的苹果。

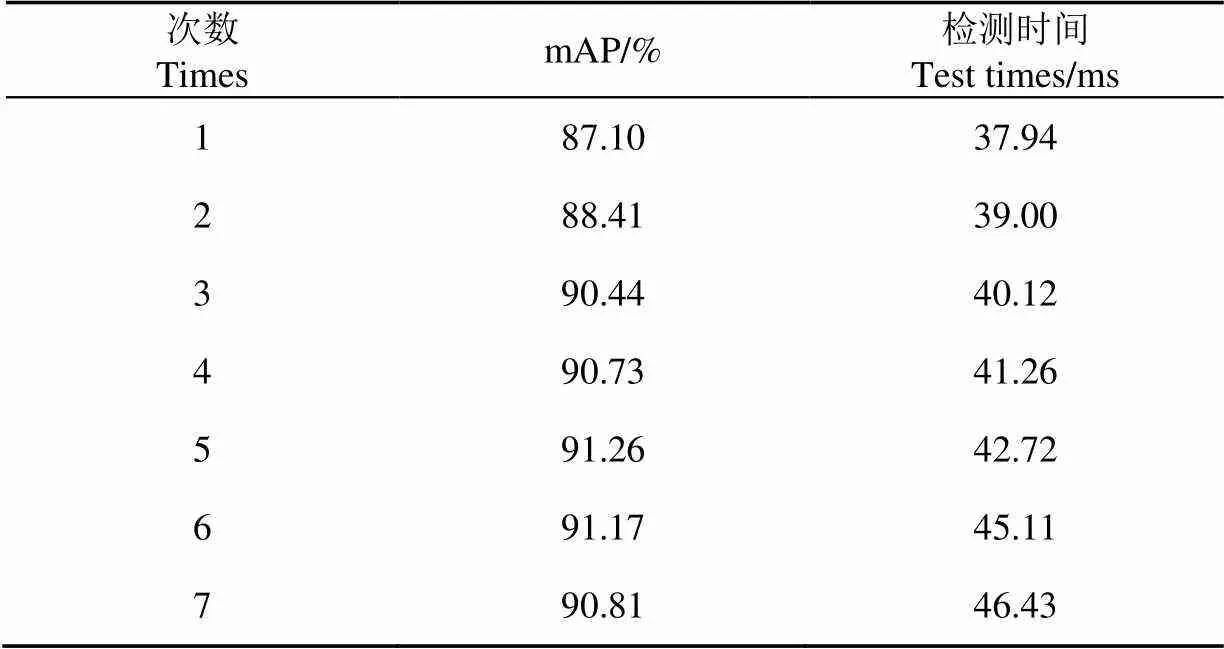

3.3 BiFPN不同堆叠次数的对比试验

BiFPN允许多次堆叠,以增强对多尺度特征的融合能力,提高检测精度。然而,随着BiFPN堆叠次数的增加,网络结构也会变得更加复杂,导致检测效率降低。为探究BiFPN堆叠次数对检测精度和速度的影响,本文对改进网络中BiFPN分别进行1~7次堆叠,并在苹果数据集上训练和测试,比较检测结果,如表3所示。最终,考虑检测精度和检测速度之间的平衡,选择在改进网络中将BiFPN进行5次堆叠,使网络综合性能达到最佳。

表3 BiFPN不同堆叠次数的测试

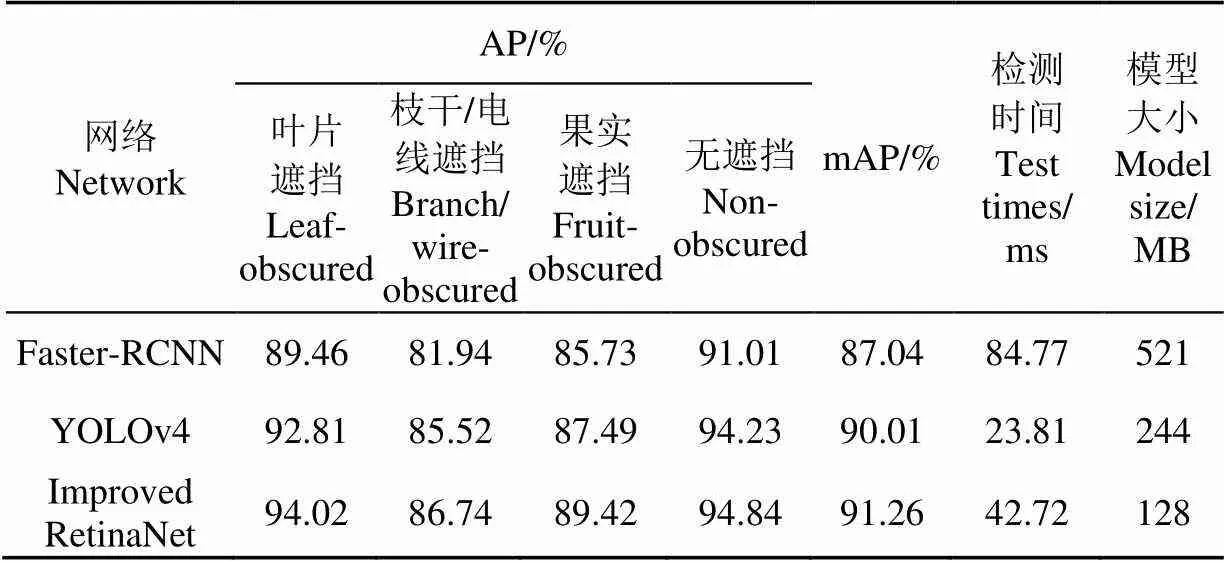

3.4 不同检测网络对比试验

为了进一步验证改进网络的性能,本文将改进RetinaNet与当前的主流目标检测网络Faster-RCNN 和YOLOv4在苹果数据集上进行对比试验,得到的检测结果如表4所示。

表4 不同网络检测结果对比

改进RetinaNet的平均精度均值与Faster-RCNN和YOLOv4相比,分别提高了4.22和1.25个百分点。平均每张图像的检测速度比Faster-RCNN快了42.05 ms,比目前检测速度较快的YOLOv4只慢了18.91 ms,当前采摘机器人采摘水果平均耗时2 780 ms[32],改进网络的检测速度满足实际需求。改进RetinaNet的模型大小与Faster-RCNN和YOLOv4相比,分别减少了75.4%和47.5%。

3.5 在不同果园背景的泛化性测试

为了验证本文提出的改进RetinaNet在实际应用中的检测性能,将训练好的改进模型在苹果数据集B上进行精度测试,模型对不同遮挡类型苹果的检测平均精度均值为90.41%,部分检测结果如图7所示。通过图7可以看出,面对不同密集程度的苹果,模型均能取得较好的检测结果。结果表明本文提出的改进网络在不同的果园场景下具有较好的泛化性。

图7 不同密集程度果实的检测结果

4 结 论

本研究针对传统方法在果园复杂环境下对果实检测精度较低的问题,提出了一种基于改进RetianNet的检测网络。本研究使用4 800张果园环境下包含多种遮挡类型的苹果图像作为试验数据集,对改进RetinaNet进行训练和测试。试验结果表明,本研究提出的改进RetinaNet对果园环境下的苹果能够实现准确检测,对叶片遮挡、枝干/电线遮挡、果实遮挡和无遮挡苹果的检测平均精度值分别为94.02%、86.74%、89.42%和94.84%,平均精度均值达到91.26%,优于传统RetinaNet、Faster-RCNN和YOLOv4;检测每张苹果图像平均耗时42.72 ms,优于Faster-RCNN,稍慢于YOLOv4网络,相较于采摘机器人每个水果2 780 ms的采摘周期,该速度满足农业应用中采摘机器人的实时性要求。对不同遮挡类型苹果的检测结果也可以进一步用于制定苹果采摘顺序,为采摘机器人的采摘策略提供理论依据。

[1] 郭雨,闫小欢. 中国鲜食苹果国际竞争力及影响因素[J]. 北方园艺,2021(24):155-162.

[2] 吴璞,薛彪,吴卓雅,等. 苹果辅助采摘装置的设计和制作[J]. 机械工程与自动化,2020(3):107-108.

[3] 张鹏,张丽娜,刘铎,等. 农业机器人技术研究现状[J]. 农业工程,2019,9(10):1-12.

[4] 廖崴,郑立华,李民赞,等. 基于随机森林算法的自然光照条件下绿色苹果识别[J]. 农业机械学报,2017,48(S1):86-91.

Liao Wei, Zheng Lihua, Li Minzan, et al. Green apple identification under natural lighting conditions based on random forest algorithm[J]. Transactions of the Chinese Society for Agricultural Machinery, 2017, 48(S1): 86-91. (in Chinese with English abstract)

[5] Ji W, Zhao D, Cheng F, et al. Automatic recognition vision system guided for apple harvesting robot[J]. Computers & Electrical Engineering, 2012, 38(5): 1186-1195.

[6] Zhao C, Lee W S, He D. Immature green citrus detection based on colour feature and sum of absolute transformed difference (SATD) using colour images in the citrus grove[J]. Computers and Electronics in Agriculture, 2016, 124: 243-253.

[7] 马翠花,张学平,李育涛,等. 基于显著性检测与改进Hough变换方法识别未成熟番茄[J]. 农业工程学报,2016,32(14):219-226.

Ma Cuihua, Zhang Xueping, Li Yutao, et al. Identification of immature tomatoes based on saliency detection and improved Hough transform method [J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2016, 32(14): 219-226. (in Chinese with English abstract)

[8] 卢军,桑农. 变化光照下树上柑橘目标检测与遮挡轮廓恢复技术[J]. 农业机械学报,2014,45(4):76-81.

Lu Jun, Sang Nong. Detection of citrus targets and restoration of concealed contours in trees under changing light[J]. Transactions of the Chinese Society for Agricultural Machinery, 2014, 45(4): 76-81. (in Chinese with English abstract)

[9] Song P, Qi L, Qian X, et al. Detection of ships in inland river using high-resolution optical satellite imagery based on mixture of deformable part models[J]. Journal of Parallel and Distributed Computing, 2019, 132: 1-7.

[10] Girshick R, Donahua J, Darrell T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]//IEEE Conference on Computer Vision & Pattern Recognition, Columbus, Ohio, USA, 2014: 570-578.

[11] Ross G. Fast R-CNN[J]. Computer Science, 2015, 9(1): 10-19.

[12] Ren S, He K, Girshick R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[13] 李林升,曾平平. 改进深度学习框架Faster-RCNN 的苹果目标检测[J]. 机械设计与研究,2019,35(5):24-27.

Li Linsheng, Zeng Pingping. Apple target detection based on improved Faster-RCNN framework of deep learning[J]. Machine Design & Research, 2019, 35(5): 24-27. (in Chinese with English abstract)

[14] Sun J, He X F, Ge X, et al. Detection of key organs in tomato based on deep migration learning in a complex background[J]. Agriculture-Basel, 2018, 8(12): 8196.

[15] Jia W, Tian Y, Luo R, et al. Detection and segmentation of overlapped fruits based on optimized mask R-CNN application in apple harvesting robot[J]. Computers and Electronics in Agriculture, 2020, 172: 1-7.

[16] Chu P Y, Li Z J, Lammers K, et al. Deep learning-based apple detection using a suppression mask R-CNN[J]. Pattern Recognition Letters, 2021, 147: 206-211.

[17] Liu W, Anguelov D, Erhan D, et al. SSD: Single Shot MultiBox Detector[C]//Proceedings of the 14th European Conference on Computervision. Berlin, Germany: Springer, 2016: 21-37.

[18] Redmon J, Divvala S, Girshick R, et al. You only look once: Unified, real-time object detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, Las Vegas, USA, 2016: 779-788.

[19] Redmon J, Farhadi A. YOLO9000: Better, faster, stronger[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, USA, 2017: 7263-7271.

[20] 赵德安,吴任迪,刘晓洋,等. 基于YOLO深度卷积神经网络的复杂背景下机器人采摘苹果定位[J]. 农业工程学报,2019,35(3):164-173.

Zhao Dean, Wu Rendi, Liu Xiaoyang, et al. Apple positioning based on YOLO deep convolutional neural network for picking robot in complex background[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(3): 164-173. (in Chinese with English abstract)

[21] 武星,齐泽宇,王龙军,等. 基于轻量化YOLOv3 卷积神经网络的苹果检测方法[J]. 农业机械学报,2020,51(8): 17-25.

Wu Xing, Qi Zeyu, Wang Longjun, et al. Apple detection method based on light-YOLO V3 convolutional neural network[J]. Transactions of the Chinese Society for Agricultural Machinery, 2020, 51(8): 17-25. (in Chinese with English abstract)

[22] Tian Z, Shen C, Chen H, et al. FCOS: Fully convolutional one-stage object detection[C]//IEEE International Conference on Computer Vision (ICCV), South Korea, 2019: 9626-9635.

[23] 彭红星,黄博,邵园园,等. 自然环境下多类水果采摘目标识别的通用改进SSD 模型[J]. 农业工程学报,2018,34(16):155-162.

Peng Hongxing, Huang Bo, Shao Yuanyuan, et al. General improved SSD model for picking object recognition of multiple fruits in natural environment[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2018, 34(16): 155-162. (in Chinese with English abstract)

[24] Ma Z, Li N Q. Improving Apple Detection Using RetinaNet[J]. Lecture Notes in Electrical Engineering, 2022, 813: 131-141.

[25] 王昱潭,薛君蕊. 改进SSD的灵武长枣图像轻量化目标检测方法[J]. 农业工程学报,2021,37(19):173-182.

Wang Yutan, Xue Junrui. Lingwu long jujube image lightweight object detection method based on improved SSD[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(19): 173-182. (in Chinese with English abstract)

[26] Lin T Y, Goyal P, Girshick R, et al. Focal loss for dense object detection[C]//Proceedings of the IEEE International Conference on Computer Vision, Venice, Italy, 2017: 2980-2988.

[27] He K M, Zhang X Y, Ren S Q, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, Las Vegas, USA, 2016: 770-778.

[28] Lin T Y, Dollár P, Girshick R, et al. Feature pyramid networks for object detection[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu, HI, USA: IEEE, 2017: 936-944.

[29] Long J, Shelhamer E, Darrell T. Fully convolutional networks for semantic segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(7): 640-651.

[30] Gao S H, Cheng M M, Zhao K, et al. Res2Net: A new multi-scale backbone architecture[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2021, 43(2): 652-662.

[31] Tan M, Pang R, Le Q V. EfficientDet: Scalable and efficient object detection[C]//IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2020: 10778-10787.

[32] Rui S, Gao F F, Zhou Z X, et al. Improved multi-classes kiwifruit detection in orchard to avoid collisions during robotic picking[J]. Computers and Electronics in Agriculture, 2021, 182: 106052.

Apple detection in complex orchard environment based on improved RetinaNet

Sun Jun, Qian Lei, Zhu Weidong, Zhou Xin, Dai Chunxia, Wu Xiaohong

(212013)

A fast and accurate detection is one of the most important prerequisites for the apple harvest robots. However, there are many factors that can make apple detection difficult in a real orchard scene, such as complex backgrounds, fruit overlap, and leaf/branch occlusion. In this study, a fast and stable network was proposed for apple detection using an improved RetinaNet. A picking strategy was also developed for the harvest robot. Specifically, once the apples occluded by branches/wires were regarded as the picking targets, the robot arm would be injured at the same time. Therefore, the apples were labeled with multiple classes, according to different types of occlusions. The Res2Net module was also embedded in the ResNet50, in order to improve the ability of the backbone network to extract the multi-scale features. Furthermore, the BiFPN instead of FPN was used as a feature fusion network in the neck of the network. A weight fusion of feature maps was also made at different scales for the apples with different sizes, thus improving the detection accuracy of the network. After that, a loss function was combined with the Focal loss and Efficient Intersection over Union (EIoU) loss. Among them, Focal loss was used for the classification loss function, further reducing the errors from the imbalance of positive and negative sample ratios. By contrast, the EIoU loss was used for the regression loss function of the bounding box, in order to maintain a fast and accurate regression. Particularly, there were some different relative positions in the prediction and the ground truth box, such as overlap, disjoint and inclusion. Finally, the classification and regression were carried out on the feature map of five scales to realize a better detection of apple. In addition, the original dataset consisted of 800 apple images with complex backgrounds of dense orchards. A data enhancement was conducted to promote the generalization ability of the model. The dataset was then expanded to 4 800 images after operations, such as rotating, adjusting brightness, and adding noise. There was also a balance between the detection accuracy and speed. A series of experimental statistics were obtained on the number of BiFPN stacks in the network. Specifically, the BiFPN was stacked five times in the improved RetinaNet. The ablation experiments showed that each improvement of the model enhanced the accuracy of the network for the apple detection, compared with the original. The average precision of the improved RetinaNet reached 94.02%, 86.74%, 89.42%, and 94.84% for the leaf occlusion, branch/wire occlusion, fruit occlusion, and no occlusion apples, respectively. The mean Average Precision (mAP) reached 91.26%, which was 5.02 percentage points higher than that of the traditional RetinaNet. The improved RetinaNet took only 42.72 ms to process an apple image on average. Correspondingly, each fruit picking cycle was 2 780 ms, indicating that the detection speed fully met the harsh requirement of the picking robot. Only when the apples were large or rarely occluded, both improved and traditional RetinaNet were used to accurately detect them. By contrast, the improved RetinaNet performed the best to detect all apple fruits, when the apples were under a complex environment in an orchard, such as the leaf-, fruit-, or branch/wire-occluded background. The reason was that the traditional RetinaNet often appeared to miss the detection in this case. Consequently, the best comprehensive performance was achieved to verify the effectiveness of the improvements, compared with the state-of-the-art detection network, such as the Faster RCNN and YOLOv4. Overall, all the apples in the different classes can be effectively detected for the apple harvest. The finding can greatly contribute to the picking strategy of the robot, further avoiding the potential damage by the branches and wires during harvesting.

image recognition; picking robot; apple detection; RetinaNet; BiFPN; EIoU; occlusion

10.11975/j.issn.1002-6819.2022.15.034

S126

A

1002-6819(2022)-15-0314-09

孙俊,钱磊,朱伟栋,等. 基于改进RetinaNet的果园复杂环境下苹果检测[J]. 农业工程学报,2022,38(15):314-322.doi:10.11975/j.issn.1002-6819.2022.15.034 http://www.tcsae.org

Sun Jun, Qian Lei, Zhu Weidong, et al. Apple detection in complex orchard environment based on improved RetinaNet[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(15): 314-322. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2022.15.034 http://www.tcsae.org

2022-03-09

2022-07-20

江苏大学农业装备学部项目(NZXB20210210);江苏高校优势学科建设工程(三期)资助项目(PAPD-2018-87)

孙俊,博士,教授,博士生导师,研究方向为计算机技术在农业工程中的应用。Email:sun2000jun@ujs.edu.cn

中国农业工程学会会员:孙俊(E041200652S)