基于知识蒸馏的心肺音分离模型

林家荣 郑凯文 甘兆明 谢仕宇 郑君锐

学术研究

基于知识蒸馏的心肺音分离模型

林家荣郑凯文甘兆明谢仕宇郑君锐

(广东工业大学,广东 广州 510006)

针对基于双向门控循环单元(BiGRU)的心肺音分离模型存在的参数量大、算法繁杂、训练成本高、硬件算力要求高等问题,提出基于知识蒸馏的心肺音分离模型。该模型基于BiGRU,教师网络、学生网络分别采用3层、1层BiGRU网络。实验结果表明,采用“教师—学生”知识蒸馏方法可提高学生网络性能,且蒸馏后的“学生+KD”心肺音分离网络相比教师网络,模型更小、算法更简单、训练成本更低,为部署到边缘设备以及资源受限的设备提供了理论依据。

心肺音分离;双向门控循环单元;知识蒸馏;教师网络;学生网络

0 引言

心音和肺音可用于心血管、呼吸系统和睡眠呼吸暂停综合征等疾病的诊断[1-3]。然而现实采集的心音和肺音是混合信号,需进行分离,以准确识别相关疾病。

心音信号的频率范围一般为10 ~ 320 Hz,肺音信号的频率范围一般为60 ~ 600 Hz,其频率范围相互混叠。传统的带通滤波器仅适用于分离频带相互分离的信号,无法有效分离心音和肺音;自适应滤波法、小波变换法依赖模板和参数,难以在实际应用中推广。

近几年,国内外学者虽然提出了很多心音信号和肺音信号的分离方法[1-4],但这些方法都有一定的缺陷,如自适应滤波法收敛速度较慢;小波变换法难以选取小波基,不同的小波基分析结果也不相同等。随着深度学习的发展,采用深度学习网络模型分离心肺音的研究也越来越多,如长短时记忆网络(long short- term memory, LSTM)、门控循环单元(gated recurrent unit,GRU)、双向门控循环单元(bidirectional gated recurrent unit, BiGRU)等循环神经网络(recurrent neural network, RNN)的变形,因可以较好地处理序列问题[4]而应用于心肺音分离。

RNN随着训练次数、层数增加,其参数呈指数增长,计算时间也相应增加,这对边缘设备的硬件要求较高。

为此,本文提出基于知识蒸馏的心肺音分离模型。该模型的基本框架为BiGRU,将知识蒸馏应用于该模型,使模型更小、算法更简单、训练成本更低。

1 心肺音混合数学模型

本文研究的心肺音分离模型仅限于单通道心肺音信号,其混合数学模型为[5]

式中:

为简单起见,假设只考虑安静无噪声环境下的心肺音混合信号,即仅含心音信号和肺音信号,公式(1)可简化为

2 BiGRU

基于知识蒸馏的心肺音分离模型采用了BiGRU网络结构。BiGRU主要由输入层、前向传递层、后向传递层和输出层组成[6],结构如图1所示。

图1 BiGRU结构

式中:

在心肺音混合信号中,某个时刻的信息与历史信息、未来信息均有关联。单向的GRU网络只能感知按时间顺序传递的信息,无法反向获取未来信息与当前信息的关联。BiGRU通过训练2个方向相反的单向GRU网络,既考虑数据时间正序、逆序的关联,又可充分提取心肺音混合信号的深层特征信息。BiGRU在结构上简化为2个门:更新门和重置门,较少的参数使模型训练更快收敛。

3 基于知识蒸馏的心肺音分离方法

3.1 心肺音分离模型的知识蒸馏框架

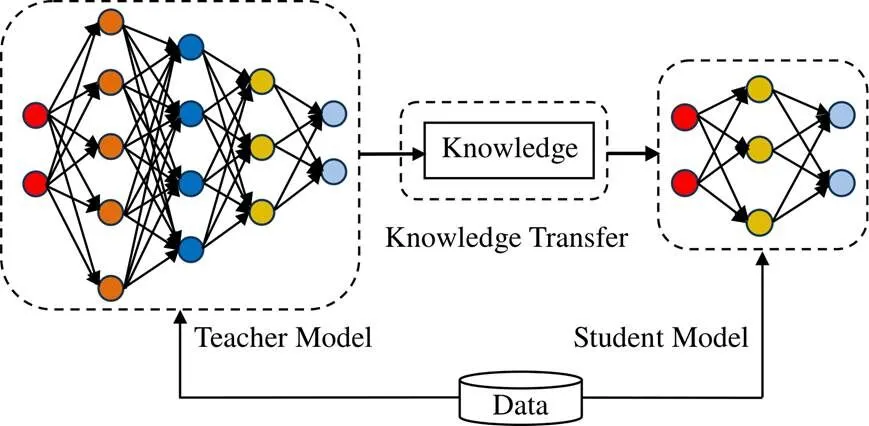

知识蒸馏是一种网络轻量化方法,由多伦多大学的HINTON提出[7],其核心思想是通过知识迁移,教师网络采用训练好的大网络,学生网络采用运行速度更快、参数更小的网络;将复杂的教师网络输出的软标签作为知识传递给学生网络,提升学生网络性能。本文心肺音分离网络的知识蒸馏框架如图2所示,其中Teacher Model表示教师网络,Student Model表示学生网络。

图2 知识蒸馏框架

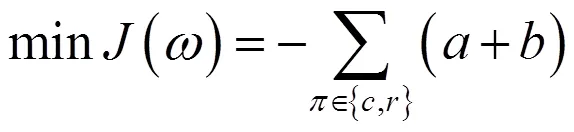

知识蒸馏网络的损失函数为蒸馏损失函数和学生网络在真实标签监督下的损失函数的加权和,计算公式为

(6)

式中:

知识蒸馏训练框架和学生网络的测试框架如图3所示。利用教师网络和学生网络同时训练,训练出分离效果最好、总损失最小的学生网络,并使用测试数据集进行测试。

图3 知识蒸馏训练框架和学生网络的测试框架

3.2 教师网络与学生网络

目前,主流的基于深度学习的心肺音分离模型训练步骤为:首先,利用短时傅里叶变换(short-time Fourier transform, STFT)将心肺音混合信号转换成时频谱;然后,经过分离网络得到心音和肺音的时频掩码;最后,利用逆短时傅里叶变换乘以时频掩码,得到分离后的心音信号和肺音信号[5]。

本文教师网络框架如图4所示,以BiGRU为主体架构,基本训练步骤与主流的基于深度学习的心肺音分离模型一致。

学生网络性能依赖于教师网络。因此,在利用知识蒸馏训练学生网络时,先将教师网络训练到最好效果。为尽可能地压缩学生网络规模,本文设计的学生网络在教师网络的基础上减少2层BiGRU,从而减少网络的规模和参数数量,其余部分与图4相同。

图4 教师网络框架图

3.3 代价函数

心肺音分离的效果可通过分离后的心音信号和肺音信号的信噪比来衡量,信噪比越高说明分离效果越好[8]。本文取心音信号和肺音信号的信噪比之和,并取负数作为损失函数,则心肺音分离网络的代价函数为

式中:

其中,公式(7)为学生网络在真实标签监督下的心肺音信噪比;公式(8)为学生网络在教师网络伪标签监督下的心肺音信噪比。

3.4 训练流程

基于知识蒸馏的心肺音分离模型的训练流程为:

1)搭建教师网络和学生网络,教师网络复杂、参数量较大;学生网络简单、参数量少;

2)在公开数据集上训练教师网络,得到一个效果最好的网络;

3)将教师网络分离后的心音信号和肺音信号作为伪标签,让学生网络在真实标签和伪标签的监督下训练,得到效果最好的学生网络。

4 实验和结果分析

4.1 实验设置

实验采用的心音信号和肺音信号分别来自公开数据集PhysioNet和Welch Allyn[9-10]。其中,心音信号102条,肺音信号95条,信号时长为2~70 s,信号采样率为4 kHz或44.1 kHz。为方便计算,统一对信号进行降采样,将信号频率降至2 kHz,并按照固定的能力比0 dB和10 dB进行混合;以信噪比(signal- to-noise ratio, SNR)作为心肺音分离实验的评价指标。

式中:

4.2 实验结果及分析

为验证知识蒸馏方法对心肺音分离网络的有效性,对比基于NMF模型的心肺音分离网络、基于全连接LSTM的心肺音分离网络、教师网络、学生网络、学生+KD网络(学生+KD网络为采用知识蒸馏结构训练的学生网络)的分离效果,其信噪比如表1所示。

表1 不同分离网络分离出心音的信噪比

由表1可以看出,基于LSTM的分离方法的分离效果比基于NMF的分离方法好;本文采用的BiGRU网络(即教师网络)的分离效果比基于LSTM的分离方法高约0.4 dB,说明采用BiGRU网络不仅减少了网络参数,还提高了分离效果。

学生网络的网络参数比教师网络少,SNR与教师网络相比下降约2 dB,分离效果仍然优于基于NMF的分离方法。

经过知识蒸馏后,教师网络将知识迁移到学生网络,虽然学生+KD网络分离效果比教师网络差,却比普通的学生网络提高了约0.35 dB,说明知识蒸馏方法可以提高学生网络的心肺音分离精度。

5 结语

本文针对现有的心肺音分离模型参数量较大、算法繁杂、训练成本高等问题,将知识蒸馏方法应用于心肺音分离,提出基于知识蒸馏的心肺音分离模型。通过实验表明,使用深度学习的分离方法比传统的NMF分离方法效果好,且使用“教师—学生”知识蒸馏方法可提高学生网络性能。蒸馏后的“学生+KD”心肺音分离网络相比教师网络虽然SNR减小,但整个模型更小,算法更简单、训练成本更低,为部署到边缘设备、资源受限设备提供了可能。

[1] BOHADANA A B, PESLIN R, UFFHOLTZ H, et al. Potential for lung sound monitoring during bronchial provocation testing[J]. Thorax, 1995,50(9):955-961.

[2] HARDIN J C, PATTERSON J L. Monitoring the state of the human airways by analysis of respiratory sound[J]. Acta Astronautica, 1979,6(9):1137-1151.

[3] AHLSTROM C, HULT P, RASK P, et al. Feature extraction for systolic heart murmur classification[J]. Annals of Biomedical Engineering, 2006,34(11):1666-1677.

[4] NERSISSON R, NOEL M M. Heart sound and lung sound separation algorithms: a review[J]. Journal of Medical Engineering & Technology, 2017,41(1):13-21.

[5] SHAH G, KOCH P, PAPADIAS C B. On the blind recovery of cardiac and respiratory sounds[J]. IEEE Journal of Biomedical and Health Informatics, 2015,19(1):151-157.

[6] ZHANG Z, DONG Z, LIN H, et al. An improved bidirectional gated recurrent unit method for accurate state-of-charge estimation[J]. IEEE Access, 2021,9:11252-11263.

[7] HINTON G, VINYALS O, DEAN J. Distilling the knowledge in a neural network[J]. arXiv preprint arXiv:1503.02531, 2015, 2(7).

[8] 陈骏霖,张财宝.几种循环神经网络和时频掩码在心肺音分离中的应用[J].自动化与信息工程,2020,41(1):39-44.

[9] PhysioNet. Classification of normal/abnormal heart sound recordings: the physionet computing in cardiology challenge 2016[DB/OL].(2018-08-13)[2019-01-26]. https://physionet.org/ content/challenge-2016/1.0.0/

[10] Welch Allyn. Student clinical learning [DB/OL]. (2019-01-26) [2019-01-26]. https://diagnosis101.welchallyn.com/auscultation/ educational-topics/sounds-pathologies/

Cardiorespiratory Sound Separation Method Based on Knowledge Distillation

LIN JiarongZHENG KaiwenGAN ZhaomingXIE ShiyuZHENG Junrui

(Guangdong University of Technology, Guangzhou 510006, China)

In order to address the problems of the existing cardiorespiratory sound separation model based on bidirectional gated recurrent unit, such as huge parameters, complex algorithms, high training costs and high requirements for hardware computing power, this paper applies the knowledge distillation method to the cardiorespiratory sound separation, and proposes a cardiorespiratory sound separation model based on knowledge distillation. The model is based on BiGRU. The teacher network uses three-layer BiGRU network, and the student network uses one-layer BiGRU network. The experimental results show that the performance of student network can be improved by using the "teacher student" knowledge distillation method. The distilled "student +KD" cardiopulmonary sound separation network is smaller than the whole teacher model, with simpler algorithm and lower training cost, which provides a theoretical basis for deploying to edge devices and resource constrained devices.

cardiorespiratory sound separation; bidirectional gated recurrent unit; knowledge distillation; teacher network; student network

R318; TN912.3; TP183

A

1674-2605(2022)05-0003-05

10.3969/j.issn.1674-2605.2022.05.003

林家荣,郑凯文,甘兆明,等.基于知识蒸馏的心肺音分离模型[J].自动化与信息工程,2022,43(5):13-16,29.

LIN Jiarong, ZHENG Kaiwen, GAN Zhaoming, et al. Cardiorespiratory sound separation method based on knowledge distillation[J]. Automation & Information Engineering, 2022,43(5):13-16,29.

林家荣,男,1997年生,硕士研究生,主要研究方向:模式识别、机器学习、生物信号处理。E-mail:1440645304@qq.com

郑凯文,男,1994年生,硕士研究生,主要研究方向:模式识别、机器学习、生物信号处理。E-mail: kwenzheng@126.com

甘兆明,男,1995年生,硕士研究生,主要研究方向:模式识别、机器学习、生物信号处理。E-mail: 1803158832@qq.com

谢仕宇,男,1997年生,硕士研究生,主要研究方向:模式识别、机器学习、生物信号处理。E-mail: 398462377@qq.com

郑君锐,男,1997年生,硕士研究生,主要研究方向:模式识别、机器学习、生物信号处理。E-mail: 1016202705@qq.com