基于改进Q-learning算法的输电线路拟声驱鸟策略研究

柯杰龙 张羽 朱朋辉 黄炽坤 吴可廷

0 引言

随着生态环境的改善与人们对野生动物保护意识的增强,鸟类数量在逐年增加,活动范围也在不断扩大.鸟类活动引起的架空输电线路故障频次也呈现明显上升趋势,给输电线路的安全运行带来了极大威胁[1-5].

为了降低鸟类活动对输电线路造成的危害,许多学者对驱鸟策略进行了研究.比如:李凯等[6]设计利用绝缘子电容电压放电的驱鸟板,当鸟类在驱鸟板上停歇时,驱鸟板自动通电使鸟类遭受电击飞离;何义良[7]设计基于红外检测技术的组合(固定频率闪光、固定频率超声波和多种音频)驱鸟装置,当检测到鸟类靠近时,装置选择一种驱赶方式进行驱鸟;袁佳炜等[8]设计声光组合驱鸟装置,其激光模块通过添加托管结构增大了照射面积,且能以一定频率闪烁进行驱鸟,而语音模块存储了6种不同的驱鸟语音,并能随机选择一种语音和随机选择语音播放时长驱鸟;周自强等[9]设计基于光电检测的激光驱鸟装置,能够通过定扫模式和巡航模式进行驱鸟.上述文献研究的驱鸟策略具有一定的驱鸟效果,但是所设计的驱鸟装置没有自学习功能,在实际应用中,无法应对鸟类的适应性问题.

为了提高驱鸟装置的驱鸟效率,需要对不同驱鸟方式的驱鸟效果进行定量和更有针对性的研究.陈晓东等[10]设计声、光、电等驱鸟实验,通过观察鸟类是否飞离确定有效的驱鸟参数;谢将剑等[11]通过观察喜鹊是否飞离,研究了音频种类(喜鹊惨叫声、喜鹊惊叫声和枪声)、声强和距离对驱鸟效果的影响;文献[10-11]所设计的驱鸟实验以鸟类是否飞离作为驱鸟效果的判断标准,缺乏鸟类在不同驱鸟方式下的更细化的行为描述;金麟雨等[12]通过将鸟类行为描述为惊飞、飞离和警戒,研究煤气炮和定向声波的驱鸟效果与有效驱鸟距离.文献[12]虽然对鸟类行为进行了更细化的描述,但是并未基于实验观察所得数据对驱鸟效果进行定量研究.

本文提出基于改进Q-learning算法的拟声驱鸟策略.首先,设计单一音频驱鸟实验得到不同音频的初始权重值,为了客观描述实验过程中的鸟类反应,结合模糊综合评价法,将鸟类的突发应激反应[13-14](即鸟类听到音频后的行为表现)定义为不同的反应类型.其次,优化CRITIC方法的权重计算公式使所得各音频权重值更符合实际实验情况.最后,借鉴强化学习的思想[15-23],并在使用Q-learning算法时考虑实验所得的各音频权重值,使装置在驱鸟过程中能够自动切换并选择更有效的驱鸟音频进行播放,提高驱鸟效率,降低鸟类的适应性.实验结果表明,装置的拟声驱鸟模块在使用本文提出的改进Q-learning算法后,装置具有自学习功能,且在拟声驱鸟模块第一次启动时就能选择到驱鸟效率较高的音频进行播放.

1 研究方法

为了提高输电线路拟声驱鸟策略的有效性,本文对Q-learning算法进行了改进.首先,设计单一音频驱鸟实验,根据实验情况,利用模糊综合评价法定义鸟类反应类型;然后,收集统计鸟类反应数据,分析不同音频下的驱鸟效果,并计算各音频初始权重;最后,设计与其他拟声驱鸟策略的对比实验,验证本文提出的拟声驱鸟策略的有效性.

1.1 驱鸟实验设计

实验地点选择校园中的湖边小树林,树林中白腰文鸟(Lonchurastriata)较多,鸟类活动频繁.实验情况通过视频监控设备实时发送到远端手机或电脑上.实验相关变量定义如下:

t1:选定实验音频的播放时长(单位:s);

t2:选定实验音频两次播放的间隔时间(单位:s);

f:选定实验音频的播放次数.

实验设计如下:

1)单一音频驱鸟实验

当鸟类进入装置的保护范围,装置音频驱赶模块开始工作,相关变量取值:t1=25 ,t2=30 ,f=6.为了避免实验点鸟类适应性对实验结果产生影响,当f>6时便更换实验地点.

2)与其他拟声驱鸟策略的对比实验

在装置中设置4种拟声驱鸟模式,分别是随机模式、Sarsa算法模式、Q-learning算法模式和改进Q-learning算法模式.在音频驱赶模块触发后,依次采用4种模式更换驱鸟音频,相关变量取值:t1=25 ,t2=30 ,f=2.同样地,考虑到鸟类的适应性,当累计播放24次音频后便更换实验地点.

1.2 实验方法

1.2.1 基于模糊理论的鸟类反应类型定义

对于实验中鸟类听到音频后行为表现的集合,采用模糊集合进行定义,具体如下:

1)因素集:U={u1,u2,u3},u1为鸟类远离装置距离(单位:m);u2为鸟类摇头次数;u3为鸟类在原地停留时间(单位:s).

2)权重集:A={a1,a2,a3},a1为鸟类远离装置距离权重;a2为鸟类摇头次数权重;a3为鸟类在原地停留时间权重.

3)评语集:V={v1,v2,v3},v1为良好;v2为一般;v3为较差.

4)根据实验情况设定各因素的边界值,然后根据边界值,各因素选择对应的梯型隶属度函数计算得到每只鸟的行为矩阵R.

5)由权重矩阵T和R得到鸟类的最终行为表现B.

B=T·R.

(1)

1.2.2 音频权重值计算

对于实验收集到的数据,本文采用CRITIC方法得到不同音频的权重值.

(2)

当鸟类对音频的行为表现差异较大时(即该音频驱赶效果较差),由CRITIC方法得到的权重值较大,这与音频驱赶效果差对应权重值小的需求并不相符,因此本文对CRITIC方法的权重计算公式进行了修改:

(3)

(4)

(5)

对权重计算公式进行修改后,音频权重值的大小能够准确反映音频的驱鸟效果优劣.

1.3 基于Q-learning算法的拟声驱鸟策略研究

目前市面上绝大部分拟声驱鸟装置不能自动更换驱鸟音频,导致装置在使用一段时间后驱鸟效果变差,无法驱离鸟类.本文结合强化学习的思想,在装置播放驱鸟音频后,通过检测鸟类是否离开装置保护区域并给予奖惩,使装置能够根据驱鸟效果自动更换驱鸟音频,从而能够降低鸟类适应性、提高装置的驱鸟效率.

1.3.1 Q-learning算法

强化学习的核心思想可通过智能体(Agent)的学习过程来体现.一个智能体在采取行动(Action)后,通过与环境(Environment)发生交互并获得奖励(Reward)改变行动从而改变下一状态(State).

Q-learning算法中的主要参数有:状态s,动作a,即时奖励r,衰减因子γ,探索率和Q值(即在某一状态s下,采取动作a能够获得的最大奖励r的期望).由于环境会根据智能体的动作a反馈相应的奖罚r,所以算法的核心就是构建Q表,然后根据Q值确定能够获得最大奖励r的动作a.

1.3.2 基于Q-learning算法和音频权重值的拟声驱鸟策略研究

Q-learning算法的使用使装置能够根据驱鸟效果自动更换驱鸟音频.为了进一步提高装置的驱鸟效率,在更新Q表时考虑单一音频驱鸟实验得到的音频权重值,从而加快算法的收敛速度.

拟声驱鸟装置作为Q-learning算法中的智能体,它使用多普勒雷达检测鸟类,当鸟类进入装置的保护区域,装置驱赶模块触发启动,播放选择的音频x驱鸟,此时装置的状态s为音频x播放中.多普勒雷达检测鸟类是否离开装置保护区域并给予音频x与奖惩r,结合音频权重库里单一音频驱鸟实验得到的各音频权重值更新状态s下动作a的Q值.如果鸟类没有离开装置保护区域,重复执行上述过程;否则更新Q值后结束本次驱赶.基于Q-learning算法和音频权重值的拟声驱鸟流程如图1所示.

图1 基于Q-learning算法和音频权重值的拟声驱鸟流程Fig.1 Bird-repelling strategy based on Q-learning and audio weight

实验中,装置中存储了10种音频供驱赶模块选用,这样,装置作为一个智能体,有10个状态(音频x播放中)和10个动作(下次驱赶选择音频y播放),Q表为一个10×10的矩阵.

Q表的更新过程具体如下:

1)当多普勒雷达检测到有鸟类进入装置的保护区域,装置驱赶模块触发启动,初始化Q表并随机选择音频x播放,此时装置的状态s为音频x播放中.

3)根据多普勒雷达的检测结果给予当前播放音频奖惩,即如果检测到鸟类离开装置保护区域,则给予当前播放音频奖励,更新Q表,否则给予当前播放音频惩罚,更新Q表,并选择音频进行下一次驱赶.

4)更新Q表:Q-learning算法采用时序差分方法估计装置播放音频的价值,设当前状态的价值函数为V(st),价值函数的更新公式如下:

V(st)←V(st)+β[rt+γV(st+1)-V(st)],

(6)

式中:β为学习速率,控制保留之前效果的比例,β越大,对之前训练效果的保留就越少;rt为当前状态下执行选定动作的奖惩值,驱鸟成功rt=1,驱鸟失败rt=-1;r为折扣因子,控制下一状态价值函数的比例;V(st+1)为下一状态的价值函数.

在Q-learning算法中,Q表中的Q值即为音频价值函数的取值,更新公式如下:

Q(st,at)←Q(st,at)+

(7)

简化式(7)得:

(8)

为了提高Q-learning算法的收敛速度,使装置快速找到有效的驱鸟音频,更新Q值时考虑在单一音频驱鸟实验中由CRITIC方法得到的音频权重值,将式(7)改写为

Q(st,at)←Q(st,at)+

(9)

式中:wt为当前音频权重值.

5)更新音频权重库:当多普勒雷达检测到鸟类离开装置保护区域,则更新音频权重库中对应的音频权重值,具体公式如下:

(10)

6)当多普勒雷达检测到鸟类离开装置保护区域则结束本次驱赶,否则重复步骤3)—6).

1.3.3 Sarsa算法

与Q-learning算法一样,Sarsa算法也属于强化学习算法,两者的区别在于Q值的更新方式不同,Sarsa算法的Q值更新公式如下:

Q(st,at)←Q(st,at)+

β[rt+γQ(st+1,at+1)-Q(st,at)],

(11)

式中Q(st+1,at+1)为下一状态下一动作的Q值.

2 结果与分析

2.1 鸟类反应类型定义

根据湖边小树林中的驱鸟实验情况确定各因素边界值,具体如表1所示.

表1 鸟类各反应类型评价标准

统计每次实验每只鸟{u1,u2,u3}的具体数值,计算各因素数值选用的隶属度函数如表2所示.

表2 隶属度函数选择

因为u1和u2数值越大说明驱鸟效果越好,而u3数值越小说明驱鸟效果越好,所以对于良好情况,u1和u2选用偏大型梯型隶属度函数,u3选用偏小型梯型隶属度函数.

通过梯型隶属度函数计算得到行为矩阵R,设权重矩阵T=[0.6,0.3,0.1],通过式(1)计算得到鸟类的最终行为表现B.

2.2 单一音频鸟类驱离实验

在单一音频驱鸟实验中,对每个音频进行两组实验,统计对该音频有反应的鸟类数量,以此作为该音频驱鸟效果的主要参考依据,实验所得数据如表3所示.

表3 对各音频有反应的鸟类数量统计

采用SPSS25软件中单因素方差分析法分析不同音频的驱鸟效果是否有明显区别.显著性水平α=0.05,单因素方差分析法结果如表4所示.

表4 单因素方差分析法结果(不同音频的驱鸟效果)

单因素方差分析结果表明,各音频驱鸟均存在显著影响(P<0.05).

统计各音频驱鸟实验中不同反应的鸟类数量,所得结果如表5所示.

表5 各音频下不同反应的鸟类数量

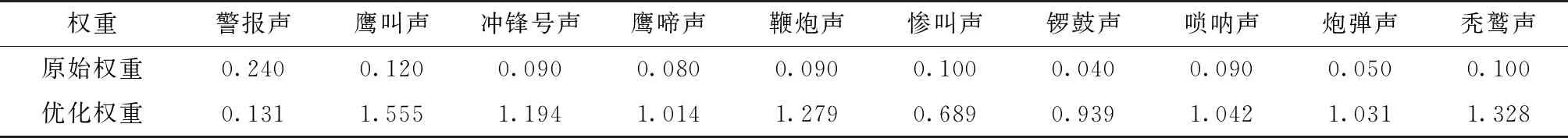

由表5的数据,使用CRITIC方法,并根据式(2)—(5)(其中g=2),计算得到各音频的权重值如表6所示.

表6 各音频权重值

由表6的数据可知:鹰叫声、秃鹫声、鞭炮声和冲锋号声权重值较大,这4个音频的共同特点是声音响亮且尖锐,说明音调高的声音更容易使鸟类受到惊吓,驱鸟效果更好;而鹰啼声由于音调较低,权重值相对较小.鹰叫声、鹰啼声与秃鹫声都是鹰科大型猛禽发出的叫声,但三者最后的权重值存在差异,推测是有些鸟类没有听过这类大型猛禽发出的叫声,因而这类声音对它们来说并不等于危险信号.类似地,惨叫声和炮弹声也不一定会使鸟类感到害怕.综上所述,音调高的声音驱鸟效果更好.

2.3 驱鸟策略对比实验

驱鸟策略对比实验一共做了8组,对于统计得到的实验数据,使用单因素方差分析法分析4种拟声驱鸟策略的驱鸟效果是否有明显区别,并使用SPSS25软件中LSD法对4种模式进行两两对比.将随机模式设置为空白对照组,如果其他3个模式与随机模式的驱鸟效果存在明显差异,则说明使用强化学习算法选择驱鸟音频能够提高装置的驱鸟效率,从而降低鸟类的适应性.此外,为了说明本文改进Q-learning算法能够进一步提高装置的驱鸟效率,统计了Sarsa算法模式、Q-learning算法模式和改进Q-learning算法模式下对驱鸟音频有反应的鸟类数量.

图3 4种模式对驱鸟音频有反应的鸟类数量Fig.3 Mean and variance of bird repelling number in different modes

2.3.1 实验数据分析

使用单因素方差分析法分析4种驱鸟音频选择模式的驱鸟效果是否有明显区别,显著性水平α=0.05,所得结果如表7所示.

表7 单因素方差分析法结果(不同音频选择模式的驱鸟效果)

单因素方差分析结果表明,各音频驱鸟均存在显著影响(P<0.05).统计不同驱鸟音频选择模式下对驱鸟音频有反应的鸟类数量,使用SPSS25软件中LSD法对4种模式进行两两对比,所得结果如表8所示.

表8 4种模式的驱鸟效果对比

表8中模式1代表随机模式、模式2代表Sasra算法模式、模式3代表Q-learning算法模式、模式4代表改进Q-learning算法模式.当2个模式的比较指标——显著性P值<0.05时,则认为这2个模式有明显区别.从表8的显著性P值可得:其他3个模式的驱鸟效果都与随机模式有明显区别,这也表明这3个模式的驱鸟效果都比随机模式好;而Sarsa算法模式与Q-learning算法模式的驱鸟效果没有明显区别;Sarsa算法模式与改进Q-learning算法模式、Q-learning算法模式与改进Q-learning算法模式的驱鸟效果存在明显区别,且改进Q-learning算法模式的驱鸟效果优于Q-learning算法模式.

2.3.2 策略对比

驱鸟实验中4种模式下对驱鸟音频有反应的鸟类数量与鸟类总量的比值如图2所示.

图2 4种模式的驱鸟效果Fig.2 Bird-repelling performances of 4 methods

由图2可知,改进Q-learning算法模式下有反应的鸟类数量占比达到76%,高于其他3个模式.

每次驱鸟实验中4种模式下对驱鸟音频有反应的鸟类数量统计结果如图3所示.

由图3可知,随机模式下有反应的鸟类数量波动性较大,驱鸟效果存在不确定性.对于Sarsa算法模式和Q-learning算法模式,由于前几次音频的选择是随机的,因此前几次音频播放后有反应的鸟类数量存在一定波动性;此外,由于2种算法Q值的更新方法不一样(Sarsa算法模式更偏向于保守地选择有效音频播放,而Q-learning算法模式则是大胆地选择有效音频播放),因此在后续驱鸟实验中,Sarsa算法模式下有反应的鸟类数量波动比Q-learning算法模式小,但随着学习的积累,2种模式下有反应的鸟类数量都会逐渐增加,最后均收敛于7~8只.对于改进Q-learning算法模式,由于开始驱赶时就考虑了单一音频驱鸟实验所得音频权重,因此前几次选择的音频就能有效驱赶鸟类,且最后收敛于8~9只,高于其他3种模式,驱鸟效果最好.

3 结论

本文主要研究了基于改进Q-learning算法的拟声驱鸟策略,实验数据显示驱鸟效率达到了76%,能够有效驱鸟.首先,为了评价各音频的驱鸟效果,结合模糊理论,提出鸟类反应类型的模糊定义方法,将鸟类听到音频后的动作行为量化为相应鸟类反应类型.其次,设计并进行了单一音频驱鸟实验,实验结果显示音调高的音频驱鸟效果更好,为装置驱鸟音频的选择提供了实验依据.为了使计算得到的各音频权重值更符合实际,优化了CRITIC方法的权重计算公式.最后,设计并进行了与其他拟声驱鸟策略的对比实验,实验结果显示基于改进Q-learning算法的拟声驱鸟策略驱鸟效果优于其他3种驱鸟策略,驱鸟效果稳定且收敛速度快,能够降低鸟类的适应性.