基于细节信息提取的全色与多光谱图像融合方法

王 欧,罗小波

基于细节信息提取的全色与多光谱图像融合方法

王 欧,罗小波

(重庆邮电大学 空间大数据智能技术重庆市工程研究中心,重庆 400065)

全色(Panchromatic, Pan)图像与多光谱(Multi-spectral, MS)图像融合的目的是生成具有高空间分辨率的多光谱图像。为了进一步提升融合图像的质量,提出一种基于细节信息提取的融合方法。首先,使用滚动引导滤波器与差值运算分别获取Pan与MS的高频分量。其次,采用自适应强度-色度-饱和度(Adaptive Intensity-Hue-Saturation,AIHS)变换处理MS的高频分量与经像素显著性检测后Pan的高频分量,生成对应的强度分量(Intensity,I),再将Pan与I作差值运算获取细节图像。接着,采用引导滤波器计算Pan与MS的高频分量的差值,得到残差图像。最后,利用最速下降法将细节图像与残差图像注入到原始的MS图像中获得最终融合结果。实验结果表明,本文所提算法得到的融合图像能够取得较好的主观视觉效果,且客观定量评价指标较优。

AIHS变换;引导滤波;滚动引导滤波;遥感图像融合

0 引言

随着卫星传感器技术的不断发展,遥感数据获取能力进一步提升。受限于成像机理,卫星很难获得同时具有高空间分辨率和高光谱分辨率的遥感图像[1]。当下,大多数卫星都能同时提供单波段的全色图像和多波段的多光谱图像。全色图像具有较高的空间分辨率和较低的光谱分辨率,而多光谱图像具有较低的空间分辨率和较高的光谱分辨率。为了更好地集成两类图像的互补信息,可以通过全色锐化(Pansharpening)的技术对其进行融合,以获取具有高空间分辨率的多光谱图像。融合后的图像在精准农业、资源调查、环境监测、军事国防等领域可以发挥重要作用[2]。

全色锐化主要有3种方式[3]:基于成分替换的方法(Component Substitution,CS)、基于多分辨率分析的方法(Multiresolution Analysis,MRA)以及基于变分优化的方法(Variational Optimization,VO)。其中,CS方法的基本思想是通过从PAN图像中提取高频细节信息并将其注入到MS图像中[4],其代表性算法有:主成分分析法、施密特正交化方法等。通常,此类方法具有较低的时间复杂度但却容易引起光谱畸变,其原因在于该类融合算法未充分考虑光谱信息的保留问题。基于MRA的方法首先使用金字塔或小波变换将原图像分解到多个尺度,然后采用恰当的融合规则对各个尺度的子带图像进行融合,最后利用逆变换得到融合图像[5],其代表性算法有:à trous小波变换、非下采样轮廓波变换等。从整体上来看,由于此类方法考虑了图像中地物的各向异性,因此该类方法通常能够保持较好的光谱信息,然而其融合结果的质量严重依赖于融合规则、分解层数与方向数。基于VO的模型是一种重要的全色锐化方法[6],它通常包含能量泛函的设计与求解两部分,其代表性算法有:P+XS、交替变分小波融合算法等。该类方法虽有较好的保真度,但其计算过程复杂且时间成本较高。

为了提取精细的空间结构信息,本文在考虑了多光谱图像在不同波段间存在差异性的基础上提出一种基于细节信息提取的融合方法。该方法首先通过滚动引导滤波器提取低频图像,并利用差值运算获取高频细节图像;接着采用自适应强度-亮度-饱和度(Adaptive Intensity-Hue-Saturation,AIHS)算法与差值运算获取初始细节图,再借鉴引导滤波器所具有的特征转移特性提取细节残差图;最后通过最速下降法将所有的细节图都注入到原多光谱中生成高保真的融合图像。

1 相关理论

1.1 AIHS变换

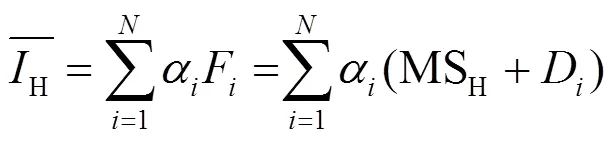

IHS变换法可以对多光谱图像的空间信息和光谱信息进行有效分离。其基本原理为:将多光谱图像从RGB空间投影到IHS空间,其中代表原RGB图像的亮度分量,也就是空间结构信息分量,而和两个分量共同表示MS图像的光谱信息。其亮度分量可以通过下式进行估算[7]:

式中:代表多光谱图像的波段数;的取值通常为1/[8];MS代表多光谱图像的第个通道。然而,尽管该方法能够很好地提取空间细节信息但却忽略了光谱信息丢失问题。因此,为了进一步解决光谱失真问题,有学者使用了AIHS[9]的方法,通过结合全色图像,其可以由如下方程获得:

式中:代表全色图像。当求解出自适应因子后,最终融合结果可以表示为:

F=MS+(3)

式中:F代表第个波段的融合结果图像;为与的差值。

1.2 引导滤波

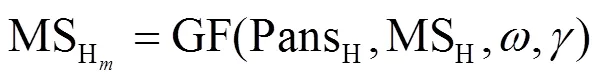

引导滤波(Guided Filter,GF)是一种基于局部线性模型的滤波方法。与其他种类的滤波处理方式不同,它着重于将导向图像的特征注入到输入图像中[10]。因此,GF不仅可以保留原输入图像的总体特征,还可以起到增强边缘细节的作用。目前,它已经广泛应用于许多图像处理场景,例如图像融合与细节增强等[11]。在数学表达上,给定输入图像和引导图像,则输出图像可以表示为:

式中:GF(×)代表引导滤波操作;为滤波窗口大小。

1.3 滚动引导滤波

滚动引导滤波(Rolling Guidance Filter, RGF)是Zhang[12]等提出的一种具有尺度感知能力的高效滤波器。相对于引导滤波器和双边滤波器而言,它不仅具有边缘保持的特性还兼具尺度感知功能。其整体工作流程可以分为两个步骤:小尺度结构平滑和大尺度结构边缘恢复[13]。

1)小尺度空间结构信息平滑过程:使用高斯滤波器过滤图像的小结构信息,如轮廓、纹理等。对输入图像与输出图像,则其实现过程可以写成如下形式:

式中:为归一化因子;代表以像素为中心点的相邻像素集合;是邻域块中的像素点;s为空间标准差,其取值控制着滤波尺度大小。

2)大尺度结构边缘迭代恢复过程:使用双边滤波器经次迭代逐步恢复空间细节信息,其迭代过程如下所示:

式中:f+1为次迭代边缘恢复后得到的输出图像;f为经式(8)得到的滤波结果;r为高斯函数在灰度域的权重参数。结合公式(8)~公式(11),可以将滚动引导滤波的迭代滤波过程归纳为如下形式:

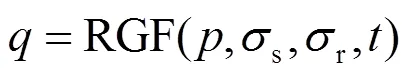

式中:RGF(×)代表滚动引导滤波操作。

2 融合步骤与框架

本文所提算法的流程图如图1所示,其具体步骤为:

1)考虑到MS图像的不同波段间存在一定差异性,假设MS图像的波段数为,为了方便后续处理,首先将Pan图像构造成维图像,其中任意维图像均与原Pan图像相同。

2)将1)中的维Pan图像与MS图像进行逐波段直方图匹配可以得到经直方图匹配后的维Pan图像,记作Pans。

3)将Pans与原多光谱图像利用式(12)进行迭代滤波获得低通图像PanL与MSL,接着通过差分运算获取各自的高频细节分量,其计算方式如下:

PansL=RGF(Pans,s,r,) (13)

MSL=RGF(MS,s,r,) (14)

PansH=Pans-PansL(15)

MSH=MS-MSL(16)

式中:PansH代表Pans的高频细节分量;MSH代表MS的高频细节分量。

4)将PansH经像素显著性判断法获取精细的单波段细节图像PanH,受启发于多分辨率分析模型中系数绝对值取大的融合规则,本文将显著性判断法定义为:

式中:x, y为图像PanH的横纵坐标;max(abs(×))代表绝对值取大运算。而后将PanH与经式(16)运算获得的MSH通过式(1)与式(2)估算出高频亮度分量IH。

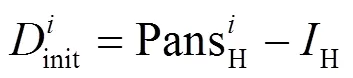

5)提取PanH相对于H额外拥有的细节信息init,其实现过程可以通过下式表示:

式中:代表第个波段,其取值范围为1~。

6)由于引导滤波器具有优秀的细节转移特性,本文利用引导滤波器与差值运算提取多级细节残差Res,再结合Res与经式(18)获取的初始细节信息图init得到最终的细节图final,其数学表达如下:

式中:F为第个波段的融合结果;D是经细节增强后的细节图。由于通过步骤3)消除了低频信息影响后,融合结果图像与原多光谱图像具有相同的光谱特征,因此在步骤4)中通过AIHS算法估算高频亮度分量H时求得的自适应因子不必更新[14]。其中,D可以通过式(23)中的最速下降法[15]联合式(24)中的最小化差异函数进行估算:

式中:为步长;初始时D(0)取值为final。

8)获得细节增强后的细节图D后。根据式(3),其融合结果可以改写为下式:

F=MS+D(25)

式中:F代表具有高空间分辨率的多光谱图像;MS与D分别代表原多光谱图像与最终细节图的第个波段。

3 实验结果与分析

为了验证所提算法的有效性,分别从GeoEye1、WV2、WV3上选择4组数据进行融合实验。并通过直观视觉与客观评价两个方面对各个融合算法进行有效评估。由于缺乏真实参考图像进行定量评价,因此本实验遵循Wald协议[16],将经下采样再上采样的MS图像与下采样的Pan图像作为输入,再将原MS图像作为参考图像。其中,本实验中全色图像大小为256×256像素,多光谱图像大小为64×64像素,重采样方法为双三次插值法,其权重参数分别设置为:s=2.2,r=1.2,=4,=16,=0.01。

本文选择8种经典、主流的融合算法与所提算法进行对比,分别为:亮度-色度-饱和度调制法、调制传递函数与广义拉普拉斯金字塔相结合的方法(Modulation Transfer Function_Generalized Laplacian Pyramid,MTF-GLP)、局部参数估计的带相关空间细节融合法(Band Dependent Spatial Detail with Local Parameter Estimation,BDSD)、比值变换(Brovey Transform,BT)、非下采样轮廓波变换与稀疏表示相结合的方法(Non-subsampled Contourlet Transform and Sparse Representation,NSCT-SR)、亮度平滑滤波调制(Smoothing Filter-based Intensity Modulation,SFIM)、双树复小波变换融合法(Dual-tree Complex Wavelet Transform,DTCWT)以及基于上下文决策的多尺度分析方法(Context-Based Decision,CBD)。为了更好地体现本文所提方法的效果,8种对比算法的实验参数均设置为最佳。所有实验均在Windows10操作系统下Matlab 2016软件中完成,并在具有32GB RAM且CPU为Intel(R)3.70GHz的电脑中运行。

3.1 主观评价

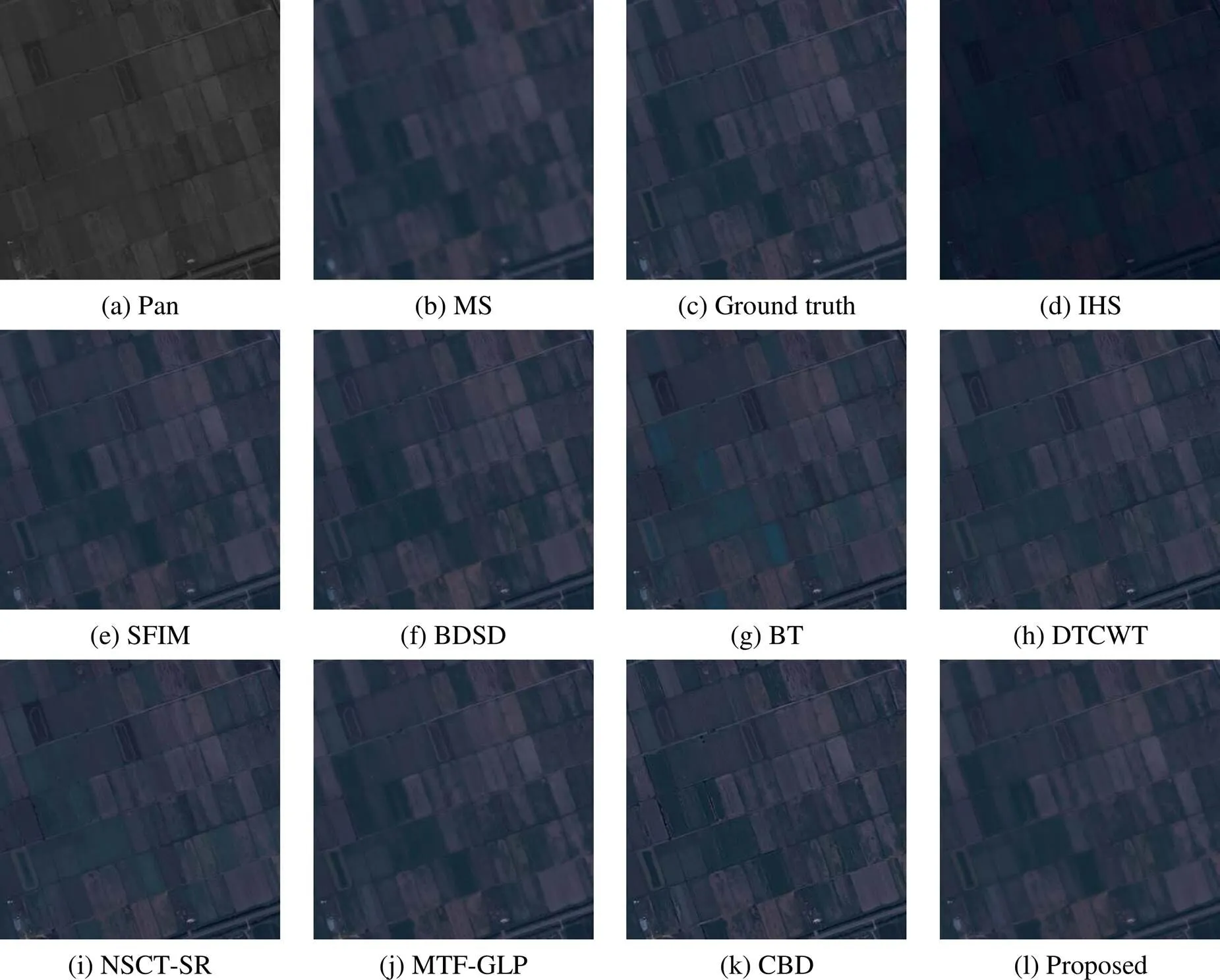

图2、图3为WV3数据融合结果图像,分别记为WV3-Ⅰ、WV3-Ⅱ,图4为GeoEye1图像的融合结果,WV2数据的融合结果如图5所示。从图2~图5(d)中可以看到,由IHS变换融合方法获得的结果图像能够保持较好的空间结构,但其色调偏暗,说明该算法丢失了较多原多光谱图像的光谱特征从而导致了全局性的光谱扭曲。由SFIM算法获得的融合图像在图3(e)、图4(e)中均能取得不错的视觉效果,对比度鲜明且层次感较好,然而通过对比图2(c)中的参考图像可以看出,图2(e)中的水体边缘处存在明显的伪影,而图5(e)与原MS图像相比则存在明显的光谱失真现象。BDSD算法获得的融合结果虽然能够较好地保留空间细节信息,但从图2(f)处的绿色植被处可以看到此处存在轻微的光谱信息丢失问题,而图5(f)中的道路两侧则存在过度锐化问题,其原因在于该算法从Pan图像中提取了较多的空间细节信息。对于BT算法而言,通过图2~图5(g)可以看出在4组实验结果中都出现了局部性的光谱失真,如图4(g)中偏深蓝色的规整田地块及图5(g)中呈紫色的道路侧。

DTCWT算法从总体上看表现一般,从图2(h)中可以明显看到其绿色植被的颜色整体偏淡,图5(h)的融合质量略优于IHS算法,但光谱失真依然严重。由NSCT-SR算法融合得到的结果轮廓模糊、清晰度较低且出现了全局性光谱畸变,通过目视解译看来,其融合结果质量相比于DTCWT算法更差。由MTF-GLP和CBD算法得到的融合结果都在一定程度上提高了原多光谱图像的空间分辨率,且并未出现明显的光谱失真现象,其融合图像的信息相对丰富且不存在明显结构性误差,通过图5(j)和图5(k)中的建筑物顶部和道路两侧的色调可以看出,CBD算法能够更多地保留光谱信息,因此CBD算法相对稳定。本文算法如图2~图5(l)所示,由图2(l)中可以看出地物边界信息饱满,整体色调保持较好,无明显振铃效应。图3(l)空间信息保持良好,但在操场与房顶处丢失了部分光谱信息,视觉效果相对较优。图4(l)在光谱保真方面较优,相比于CBD算法而言,本文算法没有细节信息注入过度的风险。图5(l)的空间细节清晰度较高,相比其他算法而言,图5(l)保持了多光谱图像的绝大部分光谱特征,且在空间细节的提升方面仍具有竞争力。总体来说,本文提出的方法在细节信息改善与光谱信息保真方面表现良好。

图2 WV3-Ⅰ 融合结果

图3 WV3-Ⅱ 融合结果

图4 GeoEye1融合结果

图5 WV2融合结果

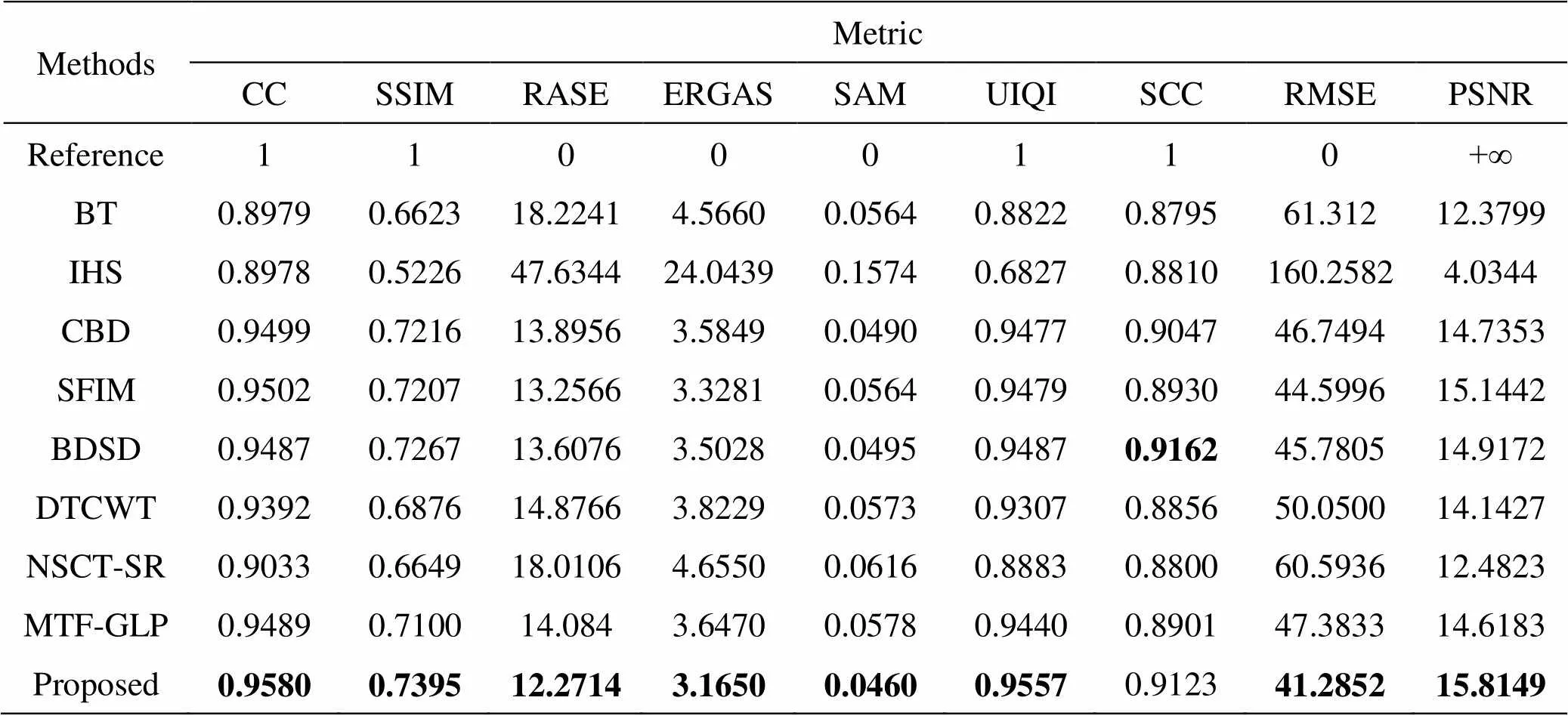

3.2 客观评价

为了客观地评价各个融合结果的准确性,本文采用空间相关系数(Spatial Correlation Coefficient,SCC)、结构相似性(Structure Similarity Index,SSIM)、相对平均光谱误差(Relative Average Spectral Error,RASE)、相对无量纲的全局误差(Erreur Relative Globale Adimensionnelle de Synthese,ERGAS)、光谱角映射(Spectral Angle Mapper,SAM)、通用图像质量指数(Universal Image Quality Index,UIQI)、相关系数(Correlation Coefficient,CC)、均方根误差(Root Mean Squared Error,RMSE)、峰值信噪比(Peak Signal to Noise Ratio,PSNR)9个指标在空间、光谱和整体一致性上对各融合算法进行定量评价。表1~表4分别对应图2~图5的客观评价结果。为了方便观察,将表中每一列的最优评价结果以加粗形式展示。

表1 WV3-Ⅰ的定量评价结果

表2 WV3-Ⅱ的定量评价结果

其中,表1和表2是WV3卫星的定量评价结果。从表中可以看出,BT算法在SAM指标上总能取得最优值,但在RASE等指标上却没有明显优势,说明该算法在光谱保持方面还有待提高。IHS变换法在绝大部分指标上均未取得较好的效果,说明其保真性整体偏差。CBD、SFIM以及MTF-GLP融合算法整体表现较好,通过SCC与ERGAS可以看出这些算法空间结构维持较好且光谱扭曲度较低,但它们仍有进一步提升的空间。通过SCC与SSIM指标可以看出BDSD算法能够保持较好的细节信息,但ERGAS较大,说明光谱特征保持力较差。对于NSCT-SR算法而言,其在SAM上表现一般,而在其余指标的表现与BT算法整体相当。本文算法虽在SAM指标上表现一般,但在ERGAS、RASE等衡量光谱信息的指标上表现良好,因此从总体上看来,本文算法可以提高多光谱的空间分辨率,同时由于本算法消除了低频分量的影响,所以能在一定程度上克服光谱扭曲问题。

表3、表4分别为GeoEye1与WV2两组遥感图像关于上述几种融合方法的定量评价。从这两个表中可以看出,本文所提方法除了在WV2数据的SCC指标上取得次优值外,在其余指标上均取得最优值,这也与主观视觉评价相符。从整体来看,MTF-GLP算法能在GeoEye1数据上取得次优值,而BDSD算法能在WV2上取得次优值,以此说明这两种算法并不具有较强的鲁棒性。通过以上各个评价指标也可以看出,BT、IHS以及NSCT-SR算法总体结果偏差,说明它们都在不同程度上丢失了光谱或细节信息。从RASE等指标来看,CBD算法可以在一定程度降低光谱扭曲度,但是该算法在CC、SSIM等可以对图像的空间、光谱信息进行综合衡量的指标上并不具有明显优势。从UIQI、PSNR等指标可以看到,由SFIM算法得到的融合图像富含丰富的信息,但其在空间结构保持方面仍有待提高。NSCT-SR融合算法在CC、SSIM两个指标上表现偏差,说明与参考图像相比,其整体相关度偏低,同时,通过RASE及SCC可以分析出,该方法容易出现光谱失真、细节信息不丰富的问题。综上所述,相比其它融合算法而言,本文所提方法更具优势。

表3 GeoEye1的定量评价结果

表4 VW2的定量评价结果

4 结论

本文提出一种基于细节信息提取的遥感图像融合方法。考虑到多光谱图像波段之间的差异性,本文首先以多光谱图像的波段数为基准将全色图像构造成多波段图像,再将多波段的全色图像与多光谱图像进行逐波段直方图匹配以降低光谱失真。随后,通过RGF与AIHS算法提取多级细节图,接着利用GF逐波段提取残差。最后通过最速下降法获取增强细节图并注入到原多光谱图像中得到最终融合结果。本文将所提算法与8种经典、主流算法在GeoEye1、WV2及WV3三个数据集上进行了对比实验,其实验结果表明,本文算法在主观评价与客观指标上均有一定优势,能够在提高空间分辨率的同时较好地维持光谱特征。

[1] 王芬, 郭擎, 葛小青. 深度递归残差网络的遥感图像空谱融合[J]. 遥感学报, 2021, 25(6): 1244-1256. WANG F, GUO Q, GE X Q. Pan-sharpening by deep recursive residual network[J]., 2021, 25(6): 1244-1256.

[2] 李树涛, 李聪妤, 康旭东. 多源遥感图像融合发展现状与未来展望[J]. 遥感学报, 2021, 25(1): 148-166.

LI S T, LI C Y, KANG X D. Development status and future prospects of multi-source remote sensing image fusion[J]., 2021, 25(1): 148-166.

[3] MENG X, SHEN H, LI H, et al. Review of the pansharpening methods for remote sensing images based on the idea of meta-analysis: practical discussion and challenges[J]., 2019, 46: 102-113.

[4] 陈毛毛, 郭擎, 刘明亮, 等. 密集卷积残差网络的遥感图像融合[J]. 遥感学报, 2021, 25(6): 1270-1283.

CHEN M M, GUO Q, LIU M L, et al. Pan-sharpening by residual network with dense convolution for remote sensing images[J]., 2021, 25(6): 1270-1283.

[5] YANG Y, LU H, HUANG S, et al. Pansharpening based on joint-guided detail extraction[J]., 2021, 14: 389-401.

[6] YANG Y, WAN C, HUANG S, et al. Pansharpening based on low-rank fuzzy fusion and detail supplement[J]., 2020, 13: 5466-5479.

[7] TU T M, HUANG P S, HUNG C L, et al. A fast intensity–hue–saturation fusion technique with spectral adjustment for IKONOS imagery[J]., 2004, 1(4): 309-312.

[8] 陈应霞, 陈艳, 刘丛. 遥感影像融合AIHS转换与粒子群优化算法[J]. 测绘学报, 2019, 48(10): 1296-1304.

CHEN Y X, CHEN Y, LIU C. Joint AIHS and particles swarm optimization for pan-sharpening[J]., 2019, 48(10): 1296-1304.

[9] Rahmani S, Strait M, Merkurjev D, et al. An adaptive IHS pan-sharpening method[J]., 2010, 7(4): 746-750.

[10] 王威, 张佳娥. 基于引导滤波和shearlet稀疏的遥感图像融合算法[J].计算机工程与科学, 2018, 40(7): 1250-1255.

WANG W, ZHANG J E. A remote sensing image fusion algorithm based on guided filtering and shearlet sparse base[J]., 2018, 40(7): 1250-1255.

[11] JIAN L, YANG X, WEI W, et al. Pansharpening using a guided image filter based on dual-scale detail extraction[J/OL]., 2018: 1-15,https://doi.org/ 10.1007/s12652-018-0866-4.

[12] ZHANG Q, SHEN X, XU L, et al. Rolling guidance filter[C]//, 2014: 815-830.

[13] 陈峰, 李敏, 马乐, 等. 基于滚动引导滤波的红外与可见光图像融合算法[J]. 红外技术, 2020, 42(1): 54-61.

CHEN F, LI M, MA L, et al. Infrared and visible image fusion algorithm based on the rolling guidance filter[J]., 2020, 42(1): 54-61.

[14] LI Q, YANG X, WU W, et al. Pansharpening multispectral remote‐sensing images with guided filter for monitoring impact of human behavior on environment[J]., 2018, 33(4): e5074.

[15] Kalpoma K A, Kawano K, Kudoh J I. IKONOS image fusion process using steepest descent method with bi-linear interpolation[J]., 2013, 34(1-2): 505-518.

[16] Wald L, Ranchin T, Mangolini M. Fusion of satellite images of different spatial resolutions: assessing the quality of resulting images[J]., 1997, 63(6): 691-699.

Panchromatic and Multispectral Images Fusion Method Based on Detail Information Extraction

WANG Ou,LUO Xiaobo

(Chongqing Engineering Research Center of Space Big Data Intelligent Technology, Chongqing University of Posts and Telecommunications, Chongqing 400065, China)

The fusion of panchromatic images (Pan) and multi-spectral images (MS) is designed to generate multi-spectral images with high spatial resolution. A fusion method based on detailed information extraction is proposed to improve the quality of the fused images. First, the high-frequency components of Pan and MS are obtained by a rolling guidance filter and margin calculation, respectively. Second, the adaptive intensity-hue-saturation (AIHS) transform is used to process the high-frequency components of MS and Pan, determined by the pixel significance, to generate the corresponding intensity component (I, intensity). Then, the difference between Pan and I is calculated to obtain the detailed image. Then, the residual image is obtained by calculating the difference between the high-frequency components of Pan and MS with a guided filter. Finally, the detailed and residual images are integrated with the original MS image using the steepest descent method to obtain the final fusion result. The experimental results demonstrate that the fused images obtained by the proposed algorithm can achieve better subjective visual effect. Simultaneously, the objective evaluation indicators are better.

AIHS transform, guided filter, rolling guidance filter, remote sensing image fusion

TP751

A

1001-8891(2022)09-0920-09

2022-01-04;

2022-02-09 .

王欧(1994-),男,硕士,主要从事遥感图像融合相关方面研究。E-mail:1004553012@qq.com。

罗小波(1975-),男,博士,教授,主要从事遥感图像处理、城市热红外遥感和生态环境监测等研究。E-mail: luoxb@cqupt.edu.cn。

国家自然科学基金资助项目(41871226);重庆市高技术产业重大产业技术研发项目(D2018-82)。