低空小型无人机空域冲突视觉感知技术研究进展

张洲宇,曹云峰, *,范彦铭

1. 南京航空航天大学 航天学院,南京 210016 2. 中航工业沈阳飞机设计研究所,沈阳 110035

国家空域系统是指由飞行器和空中交通管制相互作用而形成的复杂系统,传统意义上国家空域系统中的飞行器只包含有人机。近年来随着无人机的快速发展,各种类型的无人机已经开始进入到社会生活的方方面面,在世界各国都受到了广泛的重视。

与此同时,无人机的全空域、无限制使用给整个国家空域系统带来了巨大威胁,如何将无人机安全地集成到国家空域系统,是世界各国的空域管理都需要共同面对的问题。无人机空域冲突感知技术是国家空域集成中最具挑战性的关键技术,在现有的空域冲突感知技术中,适用于低空小型无人机的空域冲突视觉感知技术因具备非合作目标感知能力、安全的工作模式、低尺寸/重量/能耗等优势,受到了世界各国尤为广泛的关注。

本文针对小型无人机在低空空域应用愈加广泛、迫切需要融入低空空域的背景,综述了低空小型无人机空域冲突视觉感知技术的研究进展。第1节论述了空域冲突感知技术的研究现状与发展趋势;第2节介绍了低空小型无人机的应用现状,归纳了低空空域环境与小型无人机的典型特征;第3节根据感知对象的类型,将空域冲突感知设备分为协同式与非协同式2类,由此总结出适用于低空小型无人机的空域冲突感知设备应该具备的特点;第4节介绍了视觉信息预处理、入侵目标视觉检测、入侵目标相对距离估计这3项空域冲突视觉感知关键技术的最新研究进展;第5节总结了该领域有待进一步解决的难点,并对未来的发展方向进行展望。

1 空域冲突感知技术的发展现状

图1展示了北美无人机产业市场规模的迅猛发展,预计到2025年北美无人机的市场规模将达到6 000亿美元以上。美国联邦航空局的统计数据显示,2016年美国民用无人机保有量是190万台,到2021年将达到430万台。

图1 2014—2025年北美商用无人机市场 规模(单位:亿美元)Fig.1 Market size of commercial UAV in North America from 2014 to 2025 (unit: one hundred million dollar)

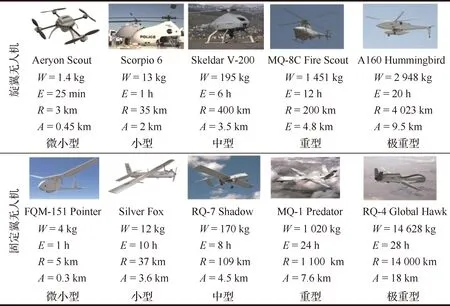

现有无人机的重量从几百克到几十吨不等,飞行高度覆盖范围从近地面的几十米到几万米高空,典型无人机的分类如图2所示,与无人机类型对应的航时、航程、飞行高度等指标如表1所示,、、、分别表示重量、续航时间、飞行半径、最大升限。总体而言,无人机的全空域、无限制使用给整个国家空域系统带来了巨大的威胁。因此,如何将无人机安全的集成到国家空域系统,与有人机共享空域是世界各国的空域管理都需要面对的一个共同问题。

图2 典型无人机分类Fig.2 Classification of UAV

表1 与无人机类型对应的航时、航程、飞行高度

美国在《2009—2040年无人机路线图》中分析指出:现有无人机飞行过程中的灾难性事故率比有人军用飞机高出1~2个数量级,提高无人机飞行的安全性与适航性刻不容缓。为此,如图3所示,美国联邦航空管理局针对现有空域的特点制定了适用于无人机的国家空域系统集成方案,其中最外层的空域冲突感知依赖现有的空中交通控制系统,而最内层的空域冲突感知主要依赖于无人机自身的机载设备。

图3 美国联邦航空管理局制定的国家空域系统集成方案Fig.3 National aerospace system integration scheme made by federal aviation administration

显然,无人机的国家空域系统集成是一个庞大的工程,不仅涉及空中交通管理相关法律法规的制定,也包含无人机空域冲突感知技术的研究与应用。在技术层面上,无人机空域冲突感知技术是国家空域集成中最具挑战性的关键技术,美国联邦航空管理局在《2009—2040年无人机路线图》对无人机空域冲突感知技术作出了如下的明确定义。

无人机空域冲突感知技术为无人机提供在飞行过程中探测潜在威胁的功能,需要达到类似于有人机飞行员用人眼发现入侵目标并目测相对距离的能力。

近10年来,无人机空域冲突感知技术受到了尤为广泛的关注,美国、加拿大、意大利、匈牙利等国家的研究机构先后针对无人机空域冲突感知技术开展了大量的深入研究。为此,众多学者开展了无人机空域冲突感知技术的综述工作,其中最具代表性的综述文献及其内容如表2所示。在现有的综述中,绝大部分综述文献都将适用于所有无人机类型的空域冲突感知技术包含在内统一进行对比分析,缺乏对适用于某一特定空域、特定类型无人机的空域冲突感知技术的深入探讨。例如,文献[7]对空域冲突感知技术中的感知、决策、避障3个功能模块进行全面梳理,文献[9]从硬件实现的角度综述了空域冲突感知技术的几种典型方案,文献[10]综述了无人机感知与规避的概念、核心技术和系统设计,文献[8]梳理了空域冲突视觉感知技术的硬件实现方案;部分综述文献侧重于阐述现有空中交通管理的法律法规对无人机空域冲突感知技术的兼容性,例如,文献[6]从政策、法规、标准3个角度系统地阐述了空域冲突感知的需求与挑战;部分综述文献只讨论了空域冲突感知技术中的一个较小的组成部分,例如,文献[11]综述了入侵目标检测识别算法的研究进展。

然而随着时间的推移,无人机空域冲突感知技术的发展可谓日新月异,每年在《Progress in Aerospace Sciences》《IEEE Transactions on Aerospace & Electronic Systems》《Aerospace Science and Technology》等航空航天领域的顶级期刊和IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS)、IEEE Intern-ational Conference on Robotics & Automation (ICRA)、American Institute of Aeronautics and Astronautics (AIAA)、International Conference on Unmanned Aircraft Systems (ICUAS)等无人机与机器人领域的顶级会议上公开的研究成果层出不穷,图4给出了过去10年无人机与机器人领域的顶级会议与Web of Science收录的期刊上发表的有关空域冲突视觉感知的论文数量统计。截至2021年,适用于低空小型无人机的空域冲突视觉感知技术已经可以作为一个独立的专题进行深入研讨,及时地总结梳理将有效推动无人机空域冲突感知技术的进一步发展。为此,本文针对小型无人机在低空空域应用愈加广泛、迫切需要融入低空空域的背景,综述了低空小型无人机空域冲突视觉感知技术的研究进展。

表2 无人机空域冲突感知技术的代表性综述文献Table 2 Representative survey papers of UAV aerospace conflict sensing technologies

图4 过去10年无人机与机器人领域的顶级会议与Web of Science收录的期刊上发表的有关空域冲突视觉感知的论文数量统计Fig.4 Papers related to vision based aerospace conflict sensing published in top conferences on UAV and robotics and indexed in Web of Science during past decade

2 低空小型无人机的应用现状

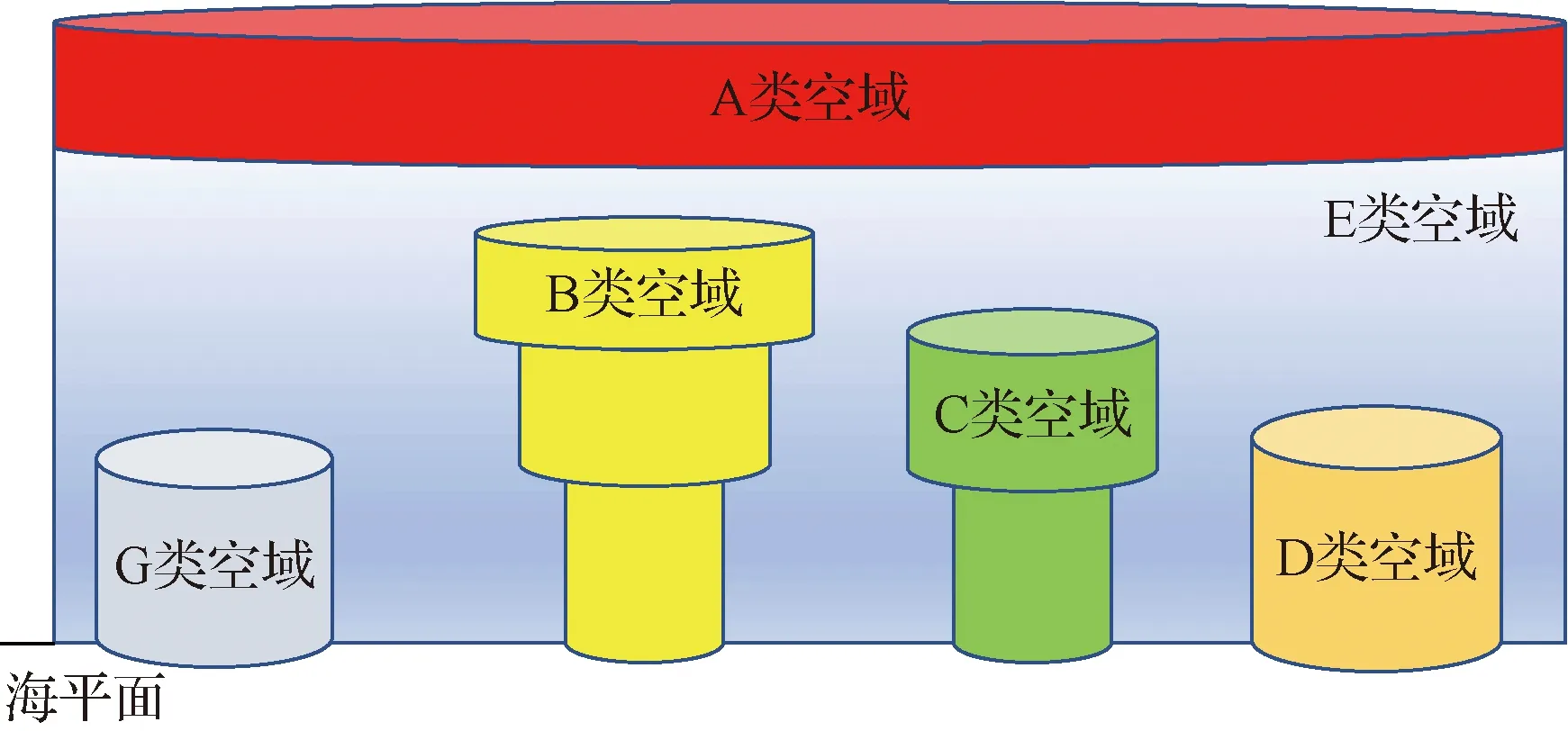

如图5所示,在现有空中交通管理系统中,根据飞行与管制规则的不同,整个空域被划分为6类:

A6 000~20 000 m高度空域,现有民航运输类飞机主要飞行区域,严格按照现有空管规则进行飞行。

B主要机场周边高度低于3 000 m空域。

C次于B类机场的繁忙机场周边高度低于1 200 m的空域。

D有塔台的机场周边高度低于800 m的空域。

E从地面开始,A~D类外的空域。

G非管制空域。

一般而言,空中交通管理系统中的低空空域主要是指除A类空域以外的B、C、D、E、G类空域。

结合图2与表1给出的无人机分类可知:在上述6类空域中,能够在A类空域飞行的无人机占现有无人机总数的比例极小,且多数为大型军用无人机,其成本较高、各种探测与感知设备完备,自身一般都具备有人机驾驶员所具有的“感知与规避(Sense and Avoid, SAA)”能力,加之这一空域范围巨大,在此空域飞行的各类飞行器数量有限,由无人机所引起的安全事故极少。

但是,对于B、C、D类等低空空域而言,飞行在这一区域无人机主要是图2中示出的小型/微小型无人机(本文统一称之为小型无人机),其共同特点可归纳为:

1) 数量巨大,低空小型无人机因为成本低廉、操作简单、起降便捷等优势受到了尤为广泛的青睐,目前已有相当数量的这一类型的无人机投入实际应用,为实际监管带来了巨大的挑战。

2) 操作简便,不需要对地面操纵人员进行系统培训就可以直接操纵无人机,这也导致操纵人员素质参差不齐,相关由操纵人员引起的安全事故屡有发生。

图5 空中交通管理系统中的空域划分Fig.5 Aerospace classification in aerospace traffic control system

3) 负载较低,绝大多数的低空无人机的自重在200 kg以下,其中中型无人机小于200 kg,小型无人机小于50 kg,微小型无人机小于5 kg,其有效载荷小于其自重,故其有效搭载能力有限。但是,几乎所有此类无人机都装备了机器视觉传感器,即光学相机,并将其作为主要任务载荷。

总体而言,在B、C、D类等低空空域飞行的无人机数量巨大,且绝大多数为低成本、低负载的小型无人机,其自身完全不具备SAA能力。因此,低空小型无人机在B、C、D类低空空域对民航飞机起飞、进近与着陆安全带来了巨大安全隐患,在国内外引发的航空安全事故层出不穷:如图6所示,2017年1月7日,莫桑比克航空(LAM Mozambique Airlines, LAM)的波音737-700客机在马普托飞往太特的航行途中与一架无人飞行器发生碰撞,碰撞导致波音737-700的鼻锥严重受损。2017年2月2日晚近22点,一架疑似无人机的飞行器进入四川绵阳机场净空保护区,导致3架飞机备降。2017年2月6日下午,一架军机在降落台北松山机场过程中发现在飞机下滑通道上有无人机,且高度与飞机相当,导致松山机场暂停了所有航班的起降。

图6 莫桑比克航空的波音737-700客机受损情况[15]Fig.6 Damage of Boeing 737-700 of LAM[15]

综上所述,由低空小型无人机所引起的安全事故或事故征候给包括空中交通管理系统在内的整个航空运输安全体系带来了巨大的挑战和威胁。为此,2013年美国FAA和欧洲无人机系统指导小组分别制定了无人机集成国家空域系统的路线图,2018年美国FAA又进一步完善了无人机集成国家空域系统路线图。美国和欧洲空管部门制定的路线图都明确指出发展新的空域冲突感知技术是民用无人机系统集成进入现有空域管理体系的关键。

3 空域冲突视觉感知的优势

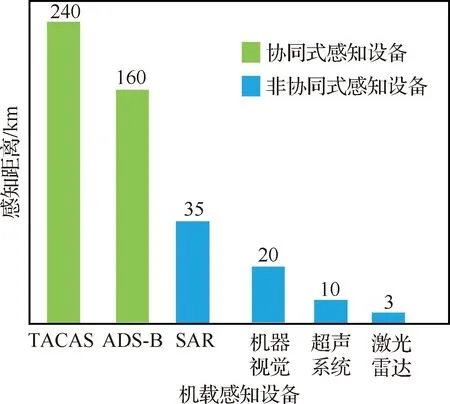

根据感知对象是否可以进行信息交互,现有机载空域冲突感知设备可以分为2类:① 针对合作目标的协同式感知设备,如空中交通预警与防撞系统(Traffic Alert and Collision Avoidance System, TACAS),广播式自动相关监视(Automatic Dependent Surveillance Broadcast, ADS-B)等,该类感知设备通常是指包含探测设备与应答设备在内的一组设备,需要通过探测设备与应答设备的相互配合实现对空域入侵目标的感知;② 针对非合作目标的非协同式感知设备,如合成孔径雷达(Synthetic Aperture Radar, SAR)、超声系统、激光雷达、机器视觉等,该类感知设备只包含探测设备,无需应答设备的配合即可实现空域入侵目标的感知。

协同式感知设备与非协同式感知设备在感知距离、可提供的信息、目视气象条件(Visual Meteorological Conditions, VMC)下能否工作、仪表气象条件下(Instrument Meteorological Conditions, IMC)下能否工作、SWAP(Size, Weight and Power)特征等方面的比较如表3和图7所示。

表3 机载感知设备的各类特性对比Table 3 Comparison of features of airborne sensing equipment

图7 机载感知设备的感知距离Fig.7 Sensing ranges of airborne sensing equipment

总体而言,协同式感知设备的优势是可以实时鲁棒地获取空域入侵目标的类型、高度、速度、位置信息,但是要求感知对象必须是安装有应答装置,因此其共同不足可归纳为:① SWAP特征不佳,因此对载荷的要求较高,低空小型无人机往往不具备搭载协同式感知设备的能力;② 缺乏非合作目标的感知能力,不适用于低空空域。因此,低空小型无人机一般不考虑采用协同式感知设备。

非协同式感知设备的优势是无需应答装置,具有较强的适用性,但是基于非协同式感知设备的空域冲突感知效果极大地依赖于算法的设计。

在上述6种空域冲突感知设备中,采用机器视觉作为低空小型无人机空域冲突感知的感知设备具有如下3点与众不同的优势:

1) 非合作目标感知能力

如第2节所述,低空空域存在着大量的非合作目标,机器视觉以光学图像为输入信息,在视觉目标检测算法的基础上无需探测设备与应答装置的相互配合即可实现对影响飞行安全的入侵目标的感知。

2) 安全的工作模式

机器视觉传感器的被动工作模式不需要向外发射信号,也不需要接收信号,因此装备视觉传感器的无人机不会不占用无线电频段,从而与国家空域系统内的其他飞机相互干扰,在敌对环境下也不易被敌方探测。

3) 良好SWAP特征

如图2所示,小型无人机的自重决定了对于空域冲突感知设备的挂载要求极高。在上述6种空域冲突感知设备中,TACAS与ADS-B这2类协同式感知设备一般是作为民航客机的空域冲突感知使用的,明显不符合低空小型无人机的挂载要求;而SAR、超声系统、激光雷达这3类非协同式感知设备的共同不足包括:机载设备自重大、独立天线、设备昂贵、能耗高,均无法满足低空小型无人机的载荷要求。相比之下,机器视觉成像设备重量轻、尺寸小、能耗低、信号稳定可靠,符合低空小型无人机的挂载要求。

4 无人机空域冲突视觉感知的关键技术

根据现有的研究工作,无人机空域冲突视觉感知技术的工作原理可归纳为如图8所示的框架,进一步又可以分为3项逐次递进的关键技术:视觉信息预处理、入侵目标视觉检测、基于视觉的避障路径规划,图9给出了过去10年顶级会议与期刊上发表的论文针对上述3项关键技术的研究方向统计。无人机空域冲突视觉感知技术的具体工作原理是:首先通过机载视觉传感器获取视觉信息,通过视觉信息预处理模块对原始视觉信息进行预处理,从而满足空域冲突感知的基本要求;其次,通过入侵目标视觉检测模块完成图像中入侵目标的定位,作为避障路径规划的基础;接着,基于视觉的避障路径规划模块将根据目标检测的结果估计相对距离,并计算一条安全的避障路径;最后,无人机飞行控制系统和无人机动力学模型将共同配合,跟踪期望的避障路径。本节将依次介绍上述3项关键技术的研究进展。

图8 无人机空域冲突视觉感知技术的工作原理Fig.8 Operation procedure of vision based UAV aerospace conflict sensing technology

图9 过去10年顶级会议与Web of Science收录期刊上发表的论文研究方向统计Fig.9 Census about research fields of papers published in top conferences and indexed in Web of Science during past decade

4.1 视觉信息预处理

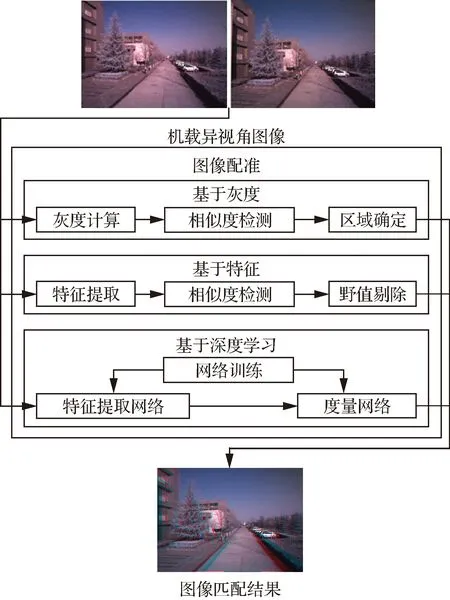

视觉信息预处理的作用是:对机载视觉传感器获取的初始图像/视频等信息进行初步处理,以满足空域冲突感知的基本需求。现有的研究中,空域冲突视觉感知的视觉信息预处理方法主要包括:天地分割、图像配准、图像融合,图10~图12分别示出了上述3种方法研究现状的体系结构,表4进一步归纳了视觉信息预处理的典型方法分类与对比。

图10 天地分割方法的体系结构Fig.10 Structure for sky and ground segmentation

图11 图像匹配方法的体系结构Fig.11 Structure for image matching

图12 图像融合方法的体系结构Fig.12 Structure for image fusion

4.1.1 天地分割

天地分割是通过检测机载图像中的地平线将初始图像分割为天空区域与地面区域2个部分,其目的是减少初始图像的面积,从而降低后续算法的计算复杂度。因此,天地分割方法的核心为机载图像中的地平线检测,如图10所示,现有的天地分割方法可分为:基于Hough变换、基于边缘组合、基于相似梯度3类。

Hough变换是地平线检测最为常见的方法之一,于1962年由Hough本人首次提出,其初衷是在笛卡尔坐标系中将离散的点转化到参数空间,从而确定直线方程。然而,最初的Hough变换方法存在的缺陷在于无法表征直线斜率的极值,因此后续文献提出了标准Hough变换方法(Standard Hough Transform, SHT),将Hough变换的思想转化到极坐标系下,从而克服了斜率无法取极值的不足。SHT算法首先对初始图像进行边缘检测,在此基础上通过Hough变换确定图像中的直线方程,最后根据预设期望直线段的阈值(长度、角度等)提取所需要的直线段。文献[36]采用SHT对初始机载图像进行天地分割,在此基础上采用简单的纹理滤波器即可实现入侵目标检测。基于Hough变换的天地分割算法的优点在于通过集成全局的图像信息生成方向稳定的直线段,其缺点在于仅通过直线方程难以精确地确定地平线的起止点,因此在地平线检测过程中常需要结合图像的纹理、梯度等信息综合判断。

相比之下,基于边缘组合与基于相似梯度的天地分割算法都是先提取图像中的局部信息,通过局部信息的一致性、相似性等约束条件来确定地平线。边缘组合算法首先通过Canny等边缘检测算子提取初始图像中的边缘信息,通过将方向一致的局部边缘首位相连组合为直线段。边缘组合算法的优点在于运行速度快、抗噪性能好,但是其缺点在于非常依赖机载图像的边缘丰富程度,当机载图像中的边缘信息不够丰富时,边缘组合算法的天地分割效果会受到较大的影响。为了弥补这一不足,考虑到图像中的梯度信息比边缘信息更稳定可靠,文献[49]提出了基于相似梯度的直线段检测(Line Segment Detector, LSD)算法,首先计算初始图像中每个像素点的梯度方向与幅值,在此基础上选择梯度最大的像素点作为起始点进行区域生长,将矩形区域近似等价为直线段。对于机载图像而言,基于相似梯度的地平线检测算法优点在于只需要图像的梯度信息,因此对红外、可见光等多种源图像都可以获得不错的效果,但是缺点在于易产生过分割。

4.1.2 图像配准

图像配准预处理的用途包括2个方面:① 匹配2个机载视觉传感器获取的异视角图像,从而便于后续的入侵目标检测、深度图获取等处理;② 匹配同一个机载视觉传感器前一时刻与后一时刻获取的序列图像,从而便于后续提取序列图像中的时域信息。如图11所示,现有的图像匹配方法可分为:基于灰度、基于特征、基于深度学习3类。

基于灰度的图像匹配方法的核心思想是将灰度信息作为机载图像的相似性度量指标,其基本步骤包括:灰度信息的计算、灰度相似度检测、匹配区域确定。因此,相似度检测算法的性能是制约该方法效果的关键,目前机载图像常用的相似度检测算法包括平均绝对差、主成分分析(Principal Component Analysis, PCA)等。总体而言,基于灰度的图像匹配方法原理简单、易于实现,然而该方法对于几何形变的鲁棒性明显不足,且计算复杂度完全取决于图像的尺寸。

基于特征的图像匹配方法是最经典、应用最为广泛的图像匹配方法,其核心思想是将图像中的点、线、区域等特征作为机载图像的相似度度量指标,因此,其性能直接取决于所选用的特征。常用的点特征包括SIFT (Scale-Invariant Feature Transform)及其衍生出的特征检测算子,线特征包括直线、轮廓曲线等,区域特征包括Hu不变矩等。总体而言,基于特征的图像匹配方法对几何形变及遮挡具有较好的鲁棒性,但是其缺点在于匹配性能受图像中提取到的特征丰富度的极大制约,如何根据图像的类型选取恰当的特征是该方法的关键。

随着卷积神经网络(Convolutional Neural Networks, CNN)相关理论的发展,基于深度学习的图像匹配方法近年来开始逐步出现,相比于CNN在目标检测、图像分割等领域的应用,CNN应用于图像匹配需要增加一个额外的功能组件:度量网络。MatchNet是卷积神经网络在图像匹配中成功应用的代表算法,通过卷积神经网络对2幅初始图像分别提取特征,然后通过度量网络衡量特征的相似度,利用带标签的数据联合训练特征提取网络与度量网络。DeepCompare在MatchNet的基础上进一步增加了空间金字塔池化模块(Spatial Pyramid Pooling, SPP),从而可以处理任意尺寸的输入图像。总体而言,基于深度学习的图像匹配方法是提升图像匹配精度的有效方案,且卷积神经网络的工作机制更符合人类视觉皮层的认知过程,但是其缺点在于依赖大量带有标注的训练样本,训练时间较长。

4.1.3 图像融合

图像融合预处理的作用是为了提升低照度条件下视觉感知的可用性,低照度条件下的可见光图像几乎无法捕获入侵目标,但是可以获取灯光等细节信息;与此互补的是,红外图像可以准确地捕获入侵目标,但是对于地面纹理、灯光等信息的获取能力明显不足;而融合图像可以较好地保留两者的优点,提升低照度条件下的视觉质量。如图12所示,图像融合方法根据其发展的历史可分为:基于多尺度变换、基于压缩感知、基于深度学习3类。

基于多尺度变换的图像融合方法的核心思想是利用一组手工设计的基函数对初始图像进行图像变换,在变换域对图像的表示系数进行融合,最后利用基函数对融合后的系数进行重建,获取融合结果。显然,基函数的设计是多尺度变换方法的核心,直接决定了最终图像融合的效果,常用的多尺度变换方法包括小波基、金字塔基等。总体而言,基于多尺度变换的图像融合方法原理简单,且克服了最初空间域融合方法的不足,但是其最大的缺点在于基函数的图像表示能力有限,无法挖掘图像内在的语义信息。

压缩感知理论的出现在一定程度上克服了多尺度变换理论的不足,其最大的改进在于采用从自然图像中训练得到的过完备字典对初始图像进行稀疏表示。相比于人工设计的基函数,过完备字典的图像表示能力大幅提升。因此,基于压缩感知理论的图像融合方法在融合效果上有较大的改善,因此一度成为图像融合领域的SOTA(State Of The Art)算法。但是,由于过完备字典维度的限制,压缩感知理论只能处理尺寸有限的图像,因此往往需要先对源图像进行网格化的分割处理,然后对分割后的图像块逐一进行图像变换,这种局部建模的方式打破了图像的语义结构,并对匹配精度提出了严苛的要求。

深度学习的出现进一步推动了图像融合方法的发展,相比于压缩感知理论,深度学习应用于图像融合的优势在于:通过全局变换的方式最大程度地保留了初始图像的语义结构。基于深度学习的图像融合方法可以分为:基于卷积神经网络与基于卷积稀疏表示2类。基于卷积神经网络的图像融合方法目前采用的网络类型包括回归式卷积神经网络与分类式卷积神经网络,回归式卷积神经网络采用全卷积网络(Fully Convolutional Networks, FCN)结构从初始的异源图像直接获取端到端的融合结果,其优势在于无需人工设计融合规则,但是目前最大的难点在于无法直接获取用于网络训练的监督数据;分类式卷积神经网络采用图像分类任务的预训练网络对初始的异源图像提取卷积图,将卷积图作为图像融合的判据,其优势在于可以直接借鉴VGGNet等分类式预训练网络,但是缺点在于依然需要手工设计融合规则。基于卷积稀疏表示的图像融合方法可以视为压缩感知理论的进一步延伸与拓展,相比于压缩感知理论所采用的过完备字典,卷积稀疏表示采用的卷积字典滤波器可以直接对初始源图像进行全局变换,由此克服了压缩感知理论应用于图像融合的不足,但是其缺点在于需要手工设计融合规则。

表4 视觉信息预处理的典型方法分类与对比Table 4 Classification and comparison of typical visual pre-processing methods

4.2 基于视觉的入侵目标检测

基于视觉的入侵目标检测的作用是:在视觉信息预处理的基础上,从视觉信息中提取对无人机可能存在威胁的入侵目标,为后续的避障路径规划提供参考信息。

区别于一般的视觉目标检测任务,入侵目标视觉检测存在如下3点特殊性。

1) 三维运动环境带来的轨迹不可预测性

三维运动环境带来的第1个问题是目标的运动轨迹完全无法预测。如图13(a)所示,基于视觉的车辆与行人运动预测方法目前已经得到了广泛的研究,目标运动的预测可以极大地降低视觉检测的难度,因此在车辆与行人视觉检测等任务中,部分研究采用了运动预测模块来提升检测算法的精度。然而,由于空域入侵目标的三维运动环境,很难通过引入运动预测来提升算法精度。

2) 入侵目标外观差异带来的类内差异性

与车辆视觉检测、行人视觉检测等传统任务不同,入侵目标的外观具有较大类内差异性。如图13(b)所示,尽管四旋翼无人机、无人直升机、固定翼无人机的外观差异明显,但三者都有可能成为入侵目标;另一方面,同一入侵目标的外观也有可能因为姿态的调整而发生较大的改变。在过去10年中,手工设计的特征都在某一类特定的视觉检测任务场景中得到了广泛的应用,例如梯度直方图(Histogram of Oriented Gradients, HOG)适用于检测行人、车辆等具有中心对称性的物体,SIFT适用于处理尺度变化等。尽管现有的研究也尝试过采用这些手工设计的特征来检测入侵目标,但是都存在验证场景过于理想的不足,未能解决入侵目标外观差异带来的挑战。因此,仅依赖手工设计的特征难以应对入侵目标的外观差异,有必要采用特征学习的手段来获取更具判别力的特征表达。

3) 避障任务带来的小目标检测难题

一般的目标视觉检测都是致力于检测图像中出现的所有目标,而空域冲突视觉感知所需解决的入侵目标检测是由避障任务驱动的。因此,当无人机与入侵目标之间的接近速度很大时,需要在尽可能远的距离检测入侵目标。如图13(c)所示,在距离很远的情况下,入侵目标一般呈现为极小的像素图案,因而引出了小目标(Dim Target)检测的问题。因此,在这种情况下入侵目标的时间域信息对于小目标的视觉检测具有重要的意义。

图13 入侵目标视觉检测问题的3点特殊性Fig.13 Three specificities of vision based intruder detection

现有的研究中,基于视觉的入侵目标检测方法主要包括:采用空间域特征的目标检测、采用时间域特征的目标检测,表5归纳了基于视觉的入侵目标检测典型方法分类与对比。

表5 入侵目标视觉检测的典型方法分类与对比Table 5 Classification and comparison of typical methods for vision based intruder detection

4.2.1 采用空间域特征的目标检测方法

采用空间域特征提取的目标检测方法主要是针对单幅图像,利用从单幅图像中提取的空间域特征完成目标检测。如图14所示,现有采用空间域特征的目标检测方法可分为:传统方法、基于深度学习的方法2类。

图14 采用空间域特征的目标检测方法体系结构Fig.14 Structure for spatial feature based object detection

传统基于空间域特征的目标检测方法包含2个独立的环节:离线训练与在线检测。离线训练环节的目的是为了获取分类器的参数,在线检测环节包含3个步骤:候选区域提取、特征提取、候选区域分类。候选区域提取是利用纹理、边缘等信息从初始图像中提取出潜在的、可能包含待检目标的区域,其目的是避免对初始图像进行遍历搜索,提升算法的速度,常见的候选区域提取算法包括EdgeBoxes、SelectiveSearch;特征提取在选定候选区域的基础上进一步提取特征向量,其目的是将候选区域从图像空间映射到特征空间,以便进一步分类,常见的空间域特征包括SIFT、局部二值模式(Local Binary Patterns, LBP)等底层特征以及采用稀疏表示进一步学习得到的空间金字塔特征;分类器设计根据所提取的特征,利用分类算法完成对特征类别的判断,最终确定候选区域是否为待检目标,常见的分类器包括支持向量机(Support Vector Machine, SVM)等。总体而言,传统基于空间域特征的目标检测方法设计思路清晰,易于解释与理解,但是其缺点在于在线检测3个步骤相互依赖,需要对每个步骤分别调试才能获得最佳的检测效果。

基于深度学习的空间域特征目标检测方法又可以进一步分为无候选区域的方法(又称单步法)和采用候选区域的方法(又称双步法)。单步法的核心思想是采用卷积神经网络同时完成候选区域的分类与回归,由于简化了候选区域提取这个步骤,因此单步法在目标检测速度上得到了很快的提升。YOLO系列算法是单步法最为经典的代表,首先对初始图像进行网格化分割,每个网格都要预测一定数量的边框,边框不仅包含了位置信息也包含了置信度信息,从而将候选区域的提取与预测合二为一,YOLO系列算法通过这种机制减少对同一个目标的重复检测,因此速度大幅提升。单步法的优势在于目标检测的速度较快,但是早期的单步法均存在检测精度不足、对小目标的检测效果不够理想等不足。双步法则继承了传统基于空间域特征的目标检测方法的框架,最初的双步法如RCNN等算法,其框架与传统目标检测算法完全一致,将CNN作为一个单独的特征提取器来使用,结合SelectiveSearch与SVM来完成目标检测。后续算法对RCNN进行了相应的改进,如Fast RCNN实现了只需对全图提取一次特征从而实现加速的改进,Faster RCNN进一步增加了区域建议提取网络(Region Proposal Network, RPN)模块,进一步提升了算法的速度。双步法的优势在于目标检测的精度更高,但是由于需要首先提取候选区域,因此速度普遍较单步法更慢。

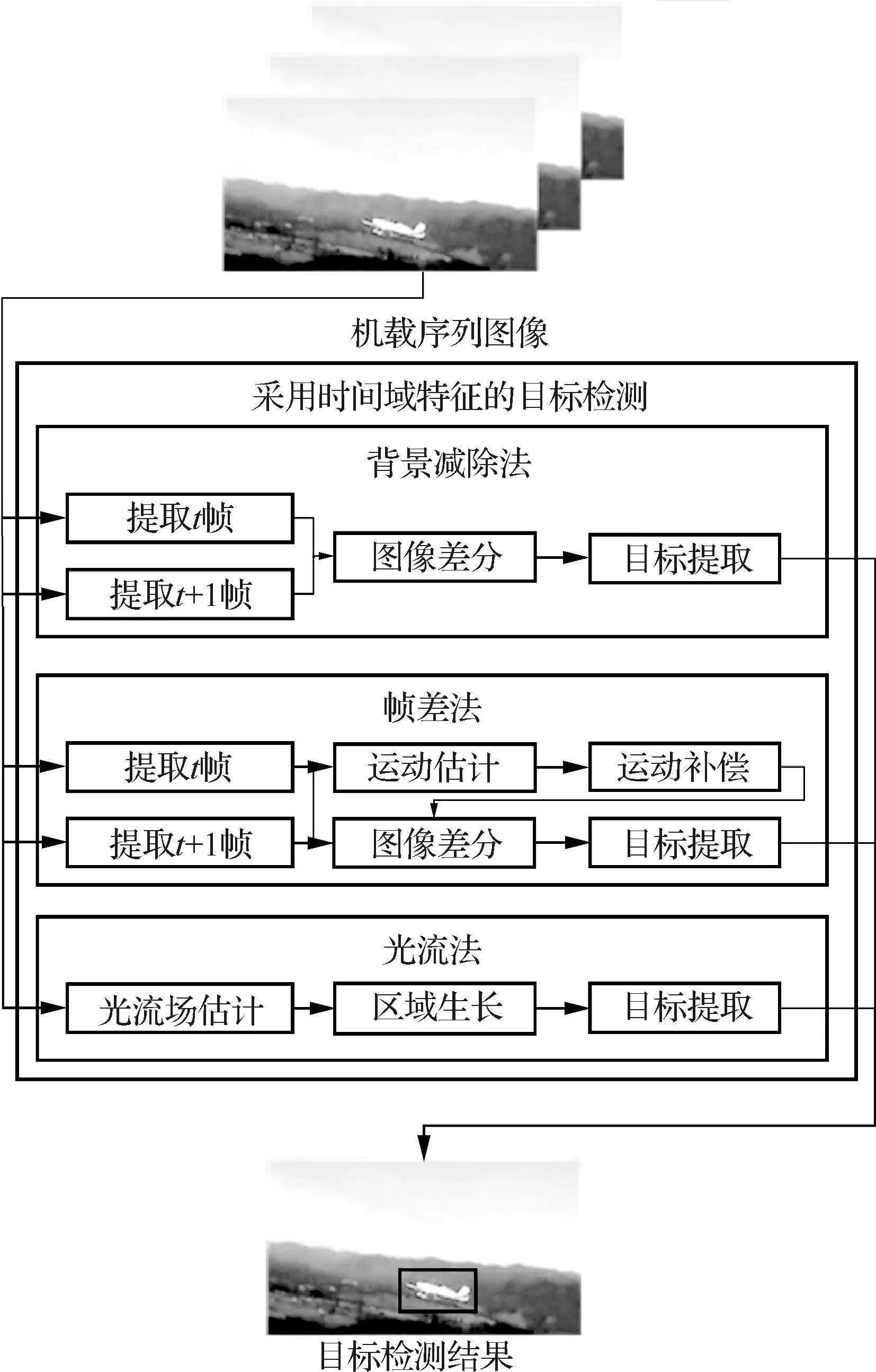

4.2.2 采用时间域特征提取的目标检测方法

采用时间域特征的目标检测方法主要是针对序列图像,利用从连续图像的帧与帧之间提取到的时间域特征完成目标检测。如图15所示,现有的采用时间域特征的目标检测方法可分为:背景减除法、帧差法、光流法3类。

图15 采用时间域特征的目标检测方法体系结构Fig.15 Structure for temporal feature based object detection

背景减除法最适用于视觉传感器完全静止不动的情况,由于背景始终固定,因此只需要对先后帧图像做简单的差分即可提取目标。由于机载视觉传感器始终处于运动状态,因此背景减除法并不适用于空域冲突感知的应用背景。

背景减除法的应用场景过于局限,帧差法的基本思路是将背景减除法扩展到视觉传感器运动的情况,通过对前后帧图像进行运动估计从而补偿前后帧之间的相对运动,在此基础上进一步做差分提取目标。帧差法的经典算法包括鲁棒主成分分析(Robust Principal ComponentsAnalysis, RPCA)、前后向运动历史图(Forward and Back Motion History Image, FBMHI)等,其主要缺点在于无法有效地检测出慢速运动目标。

光流法尤其适用于目标与背景之间存在相对运动的情况,通过提取图像中每个像素点在不同时刻的光流矢量确定图像中可能存在目标的区域,其经典算法包括Lucas-Kanada等。光流法的优势在于不仅可以检测目标,还可以获取目标的运动速度大小、运动方向等信息,但同样存在计算耗时、对亮度变化敏感等不足。

4.3 基于视觉的避障路径规划

基于视觉的避障路径规划的作用是:在入侵目标视觉检测的基础上,通过视觉测量手段获取入侵目标与无人机之间的相对位置关系(包括距离、角度等),由此完成入侵目标的威胁度评估,并根据威胁度评估的结果规划安全的避障路径。

区别于一般意义上的路径规划,基于视觉的避障路径规划的主要难点在于,路径规划算法需要充分考虑视觉感知的特点。

图16展示了基于视觉的避障路径规划与基于ADS-B的路径规划的主要区别,图中为机体坐标系,原点位于单目相机的光心;()()()()(=1,2,…,)为固连在入侵目标上的相对世界坐标系,其中为每个时刻检测到的入侵目标总数;′′′′为固定在地面的绝对世界坐标系。

如图16(a)所示,当采用相对世界坐标系进行避障路径规划时,绝对世界坐标系′′′′主要用于无人机的导航定位,借助GPS等手段,可以确定机体坐标系相对于绝对世界坐标系′′′′的转换关系。而相对世界坐标系则用于获取无人机与侵入目标之间的相对位置关系,从而完成避障路径规划的目的。在数学意义上,由于无法获取空域内所有侵入目标的位置信息,相对世界坐标系下的避障路径只能达到局部最优。

如图16(b)所示,当采用绝对世界坐标系进行避障路径规划时,首先,借助于GPS提供的定位数据,空域内所有的飞行器(包含无人机与其他侵入目标)都可以获取其自身在绝对世界坐标系′′′′下的坐标;其次,借助于地面站和机载雷达及接收机,无人机可以获取空域内所有侵入目标在绝对世界坐标系下的坐标;最后,利用绝对世界坐标系下的全局信息,规划出一条避障路径。在数学意义上,绝对世界坐标系下的避障路径可以实现全局最优。

图16 基于视觉的避障路径规划问题与基于ADS-B的避障路径规划问题对比Fig.16 Comparison of vision based and ADS-B based collision avoidance trajectory planning

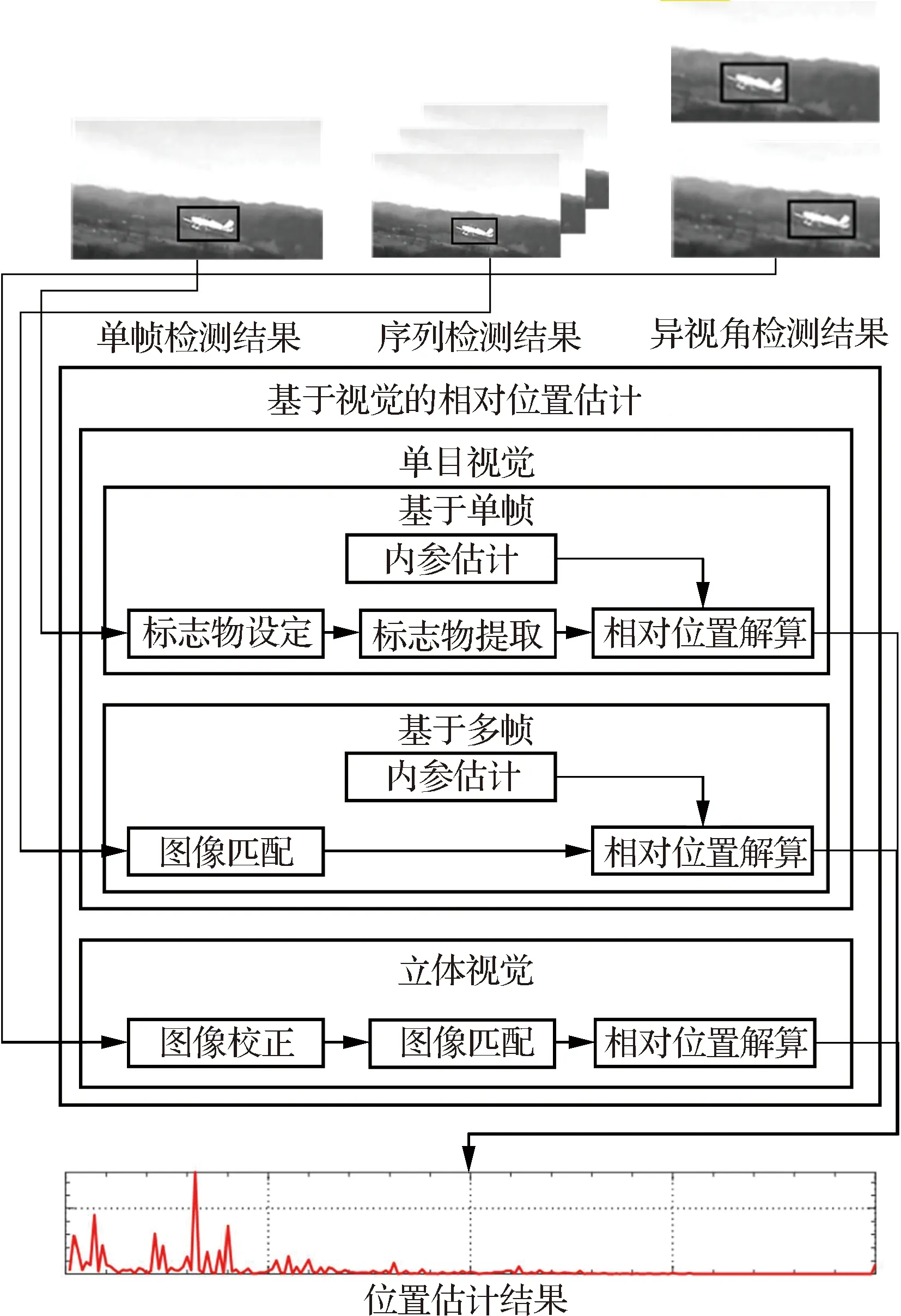

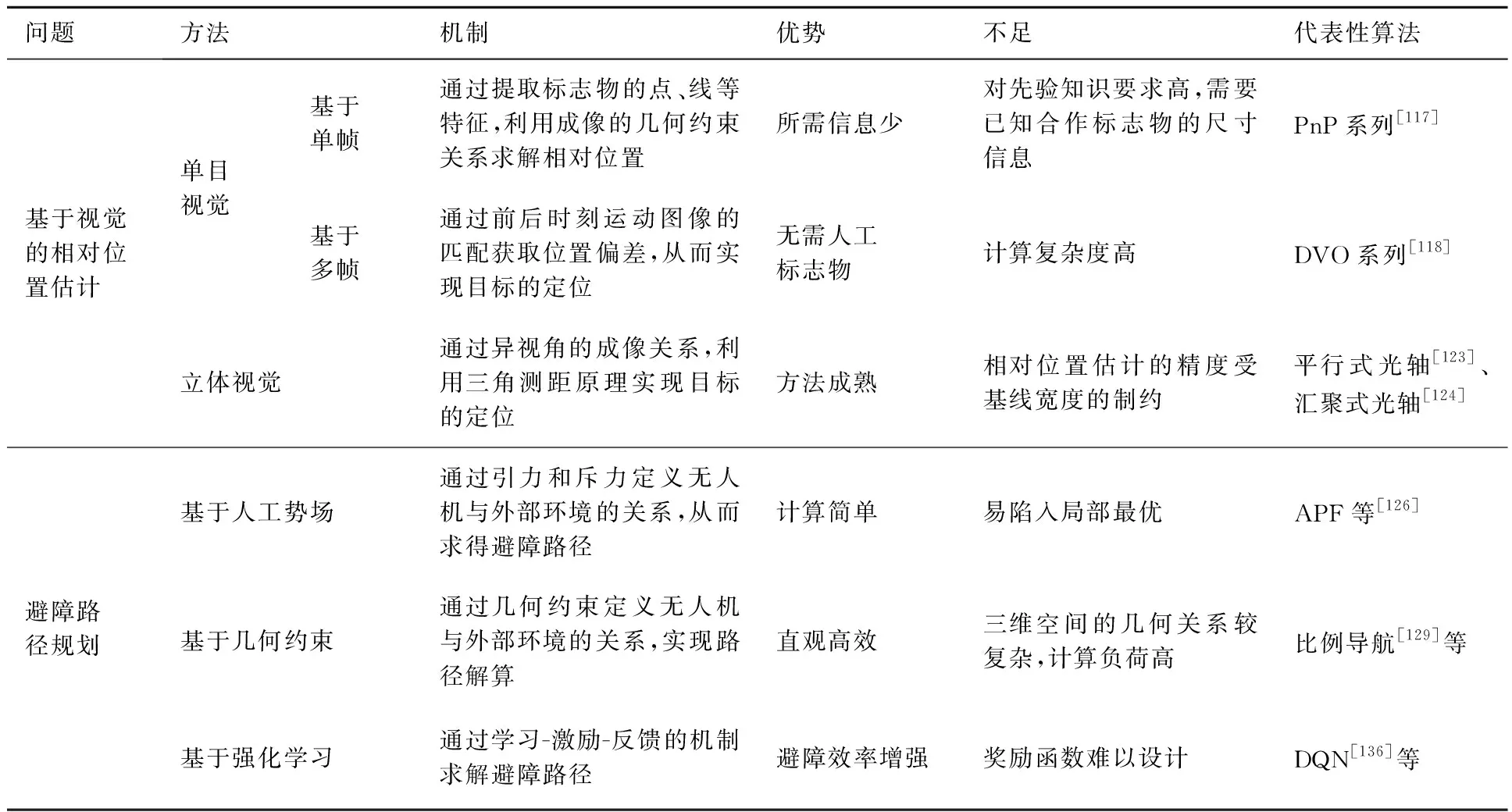

综上所述,基于视觉的避障路径规划不仅需要充分考虑通过视觉获取相对距离的特点,还要在此基础上结合视觉感知的特点设计避障路径规划算法。因此,现有研究中,基于视觉的避障路径规划方法包括:基于视觉的相对位置估计、避障路径规划,图17和图18分别示出了上述2个方法研究现状的体系结构,表6进一步归纳了基于视觉的避障路径规划方法的分类与对比。

图17 基于视觉的相对位置估计方法体系结构Fig.17 Structure for vision based relative position estimation

图18 避障路径规划方法体系结构Fig.18 Structure for vision based collision avoidance path planning

表6 基于视觉的避障路径规划问题的典型方法分类与对比Table 6 Classification and comparison of typical methods for vision based collision avoidance trajectory planning

4.3.1 基于视觉的相对位置估计

基于视觉的相对位置估计是指利用机载视觉传感器获取的图像信息,采用三维重建的手段获取入侵目标与无人机之间的相对位置关系。如图17所示,现有基于视觉的相对位置估计方法可分为:基于单目视觉的相对位置估计、基于立体视觉的相对位置估计2类。

基于单目视觉的相对位置估计是指仅利用一个视觉传感器采集的单帧图像或图像序列完成距离估计,因此又可以进一步分为基于单帧和基于多帧的相对位置估计方法。基于单帧的相对位置估计方法就是只采用一幅图像完成目标的定位,通过提取在场景中预先设置的特征标志物,利用几何约束关系结合相机的内参数完成相对位置的解算。因此,特征标志物的设定与提取是该方法的关键,现有研究中的特征标志物包括点、直线段、曲线段等。总体而言,基于单帧的相对位置估计方法具有所需图像信息少的优势,但是其不足之处在于对先验知识的要求较高,当场景中不包含特征标志物时无法采用该方法进行定位。基于多帧的相对位置估计方法是通过视觉传感器采集同一个场景不同时刻的图像,利用帧与帧之间每个像素点的位置偏差实现目标的定位。运动视觉里程计(Dynamic Visual Odometry, DVO)是该方法的代表性算法,在DVO的基础上又进一步衍生出了多运动视觉里程计(Multi-motion Visual Odometry, MVO),通过帧间动态目标的特征点匹配,实现了多目标的距离估计。总体而言,基于多帧的方法克服了单帧方法对于先验知识的依赖,但是存在计算复杂度高、实时性差的不足。

基于立体视觉的相对位置估计在原理上最初受到了仿生视觉的启发,通过模仿生物的双目感知系统从不同的方位获取异视角图像,最终利用三角测距原理完成目标的定位,Marrd和Poggio提出的视觉理论为立体视觉奠定了坚实的理论基础。基于立体视觉的相对位置估计首先需要对异视角图像进行校正,确保异视角图像的共轭极线位于同一水平线上,在此基础上完成异视角图像的匹配,最后利用三角测距原理完成每个像素点的位置估计。根据视觉传感器的安置方式,基于立体视觉的相对位置估计包括平行式光轴与汇聚式光轴2种模式。平行式光轴的相机拍摄角度完全相同,光轴平行,这种模式极大地降低了图像匹配的难度,但是存在重叠视场有限的不足;汇聚式光轴相当于是将平行式光轴的左右相机分别向内或向外旋转一定的角度,汇聚式光轴可以扩大重叠视场的范围,但是极大地增加了图像匹配的难度。总体而言,基于立体视觉的相对位置估计可以稳定地获取位置信息,但是针对空域冲突视觉感知的应用背景,其不足之处在于位置估计的精度受基线宽度的制约,无法实现对远距离小目标的精确位置估计。

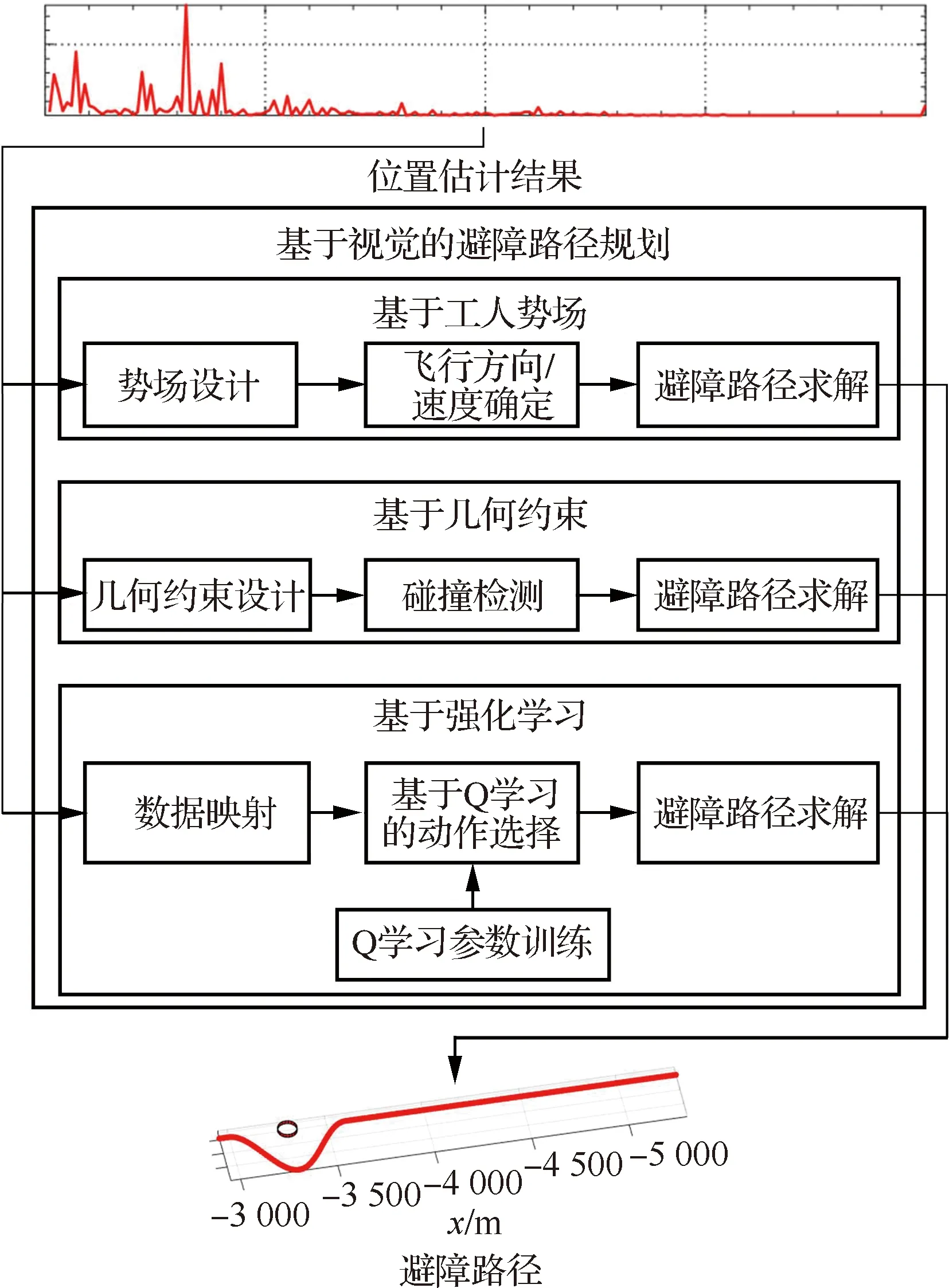

4.3.2 避障路径规划

避障路径规划是根据相对位置估计的结果计算安全的避障路径,本节开头已经指出基于视觉的避障路径规划需充分考虑视觉感知的特点,采用全局信息的避障路径规划算法无法适用于空域冲突感知的应用背景。因此,如图18所示,现有避障路径规划方法均只采用了视觉感知获取的局部信息,可分为:基于人工势场、基于几何约束、基于强化学习3类。

基于人工势场的路径规划(Artificial Potential Field, APF)核心思想是借鉴物理学中的原子间的互吸、互斥关系完成对避障路径规划的数学建模,具体而言,采用引力场描述无人机与目的地之间的关系,采用斥力场描述无人机与障碍物之间的关系,由此确定无人机的实时运动方向与速度,求解避障路径。显然,引/斥力函数的设计是基于APF的避障路径规划方法关键,文献[128]结合空域冲突感知的应用背景,设计了一种快速响应的APF函数,并考虑了无人机的转弯半径等运动特点。总体而言,基于APF的避障路径规划方法原理简单、易于实施与计算,然而其不足之处在于容易陷入局部最优。

基于几何约束的避障路径规划是在无人机避障中应用最为广泛的方法,通过无人机与外部环境之间的几何关系来检测碰撞,最终实现避障路径的求解。该方法的经典算法包括比例导引(Proportional Guidance)、最小接近距离(Closest Point of Approach, CPA)、冲突核(Collision Core)等,其共同特点都是通过定义空域冲突的几何约束关系设计避障规则,而基于视觉的相对位置估计是设计避障规则的基础。针对单目视觉难以获取距离信息的不足,文献[109] 进一步模拟人类感知系统设计了基于相对视线角变化率的避障规则。总体而言,基于几何约束的避障路径规划是一种直观高效的方法,但是三维空间中的避障几何约束设计复杂,导致该方法的计算负荷偏高。

强化学习(Reinforcement Learning, RL)是一种直接与环境进行互动,通过不断地试错来选择最优动作的人工智能算法。当应用于空域冲突感知时,首先需要将测量的感知数据映射到控制系统的状态空间,然后通过Q学习选择最优的避障动作,最后通过组合一系列的动作完成避障路径的求解。最初的强化学习算法受限于动作和样本空间的维度,无法处理复杂的实际问题,因此后续算法将深度学习与强化学习结合,提出了深度Q网络(Deep Q Network, DQN),深度强化学习最大的优势在于可以直接从图像信息中解算得到避障路径。文献[135]采用深度强化学习模仿基于几何约束的避障路径规划,在群智能感知的框架下取得了理想的效果,文献[136]在此基础上改进了奖励函数,进一步增强了避障性能。总体而言,基于强化学习的避障路径规划通过与环境之间的不断互动,相比于其他2类方法在避障效率方面得到了增强,但是其不足之处在于需要调试奖励函数和学习策略才能获得理想的效果。

5 总结与展望

低空小型无人机空域冲突视觉感知至今仍然是世界各国亟待突破的技术瓶颈,具体而言,包含3项逐次递进的关键技术有待进一步解决:视觉信息预处理、入侵目标视觉检测、基于视觉的避障路径规划。视觉信息预处理是对机载视觉传感器获取的初始图像/视频等信息进行初步处理,以满足空域冲突感知的基本需求;基于视觉的入侵目标检测是在视觉信息预处理的基础上,从视觉信息中提取对无人机可能存在威胁的入侵目标,为后续的避障路径规划提供参考信息;基于视觉的避障路径规划是在入侵目标视觉检测的基础上,通过视觉测量手段获取入侵目标与无人机之间的相对位置,由此规划安全的避障路径。

基于本文所聚焦的关键技术,结合当前的技术发展趋势,未来还有以下问题值得进一步探讨:

第一,在视觉信息预处理方面,现有的研究工作主要包括图像分割、图像配准、图像融合,其核心目的都是为了提升图像质量,为后续的进一步图像处理提供高质量的视觉信息。然而在实际应用中还存在大量亟待解决的视觉信息预处理难题,如:去除图像中的运动模糊、图像去雨/雾/尘、过曝光/欠曝光图像的后处理等等。后续研究应该着眼于建立一个适用于多种条件下视觉信息增强的统一范式,并给出视觉感知的图像质量评价体系。

第二,在入侵目标视觉检测方面,现有的研究工作主要包括基于空间域特征提取的目标检测、基于时间域特征提取的目标检测,由于入侵目标视觉检测的3点特殊性,现阶段单一的空间域特征与时间域特征都无法完全满足入侵目标视觉检测的需求。后续研究可以通过机器学习的手段,自动获取空时域上下文概率图的融合权重,从而增强不同条件下入侵目标检测的鲁棒性。

第三,在基于视觉的避障路径规划方面,现有的研究主要包括基于视觉的相对位置估计、路径规划算法,其中路径规划算法的设计需要充分考虑通过视觉获取相对距离的特点。近年来单目视觉图像中的场景深度信息提取得到了愈发广泛的关注,场景深度信息同样可以作为入侵目标位置的观测信息。后续研究可以针对场景深度信息在避障路径规划中的应用展开研究,设计与之对应的避障规则。