智能机器的道德设计进路及其责任归因

于 雪

责任的原意是对某事的回应,负责任意味着回答某件事的状态或事实,这是对某个行为提供解释的能力。因而,它涉及主体的特定心理动机和沟通、判断、反思等能够承担责任的主体能力[1](350-376)。基于此,责任一直被视为人类语境中独有的概念,并且承担责任被视为人类独有的能力。但是,智能机器的崛起正在改变这种传统意义上的责任观念,有些学者开始试图将责任归因于这些智能机器。例如,温德尔·瓦拉赫(Wendell Wallach)和科林·艾伦(Colin Allen)通过提出一种功能等价的思路来对人工系统进行责任归因。这种观念转变的假设一方面是由于数字化时代促发了关于“人”本质的新认识,这些新认识主要来自信息技术和智能技术对“人”自身的深刻影响。另一方面,由于机器人化、自动化、数字化等时代特征带来的挑战,人们在社会、政治和经济系统的组织形式中对责任的理解也发生了根本性的转变[2](1-20)。尽管这种责任范式的转变会导致责任鸿沟(responsi⁃bility gap)①责任鸿沟的概念是安德烈亚斯·马蒂亚斯(Andreas Matthias)提出的。在他看来,传统意义上机器的制造商/操作者(在道德上和法律上)要对其操作的后果负责,但基于神经网络、遗传算法和自主体架构的自主学习机器,创造了一种新的情况,即机器的制造商/操作者原则上不能够预测未来机器的任何行为,因此不能承担责任,这就是“谁应该为智能机器的后果负责”的责任鸿沟。参见MATTHIAS A,“The responsibility gap:Ascribing responsibility for the actions of learning automata,”Ethics and Information Technology,2004,6(3),pp.175-183.的出现,但是这种转变仍然在持续。并且,随着智能机器在道德情境中参与度的提升,这种责任范式的转变也涵盖了道德责任。基于这种对责任范式转变的接纳以及对责任鸿沟的弥合,本文试图为智能机器的责任归因(responsibility ascription 或responsibility attribution)提供新的解决思路,其中道德设计是解决该问题的关键环节。据此,本文首先回应智能机器为何需要道德设计,并且在现有道德设计进路的基础上,提出道德交互设计的理念,将责任置于动态的交互环境中以实现人机交互过程中的责任归因。

一、智能机器道德设计的必要性

智能机器指的是以智能系统和智能平台为依托的自动机器,其核心特征是自动化和智能化①本文关于智能机器自动化和智能化特征的强调来自我国封锡盛院士对机器人的分类,即根据机器人的智能化程度将其分为无智能机器人(1.0 机器人)、智能机器人(2.0 机器人)和生物机器人(3.0 机器人)。1.0 机器人是基于自动化技术的机械电子装置,其核心特征是自动化,而2.0 机器人是在1.0 机器人的底层之上增加了智能顶层,因此其核心特征是智能化。本文所谈及的智能机器是技术层面的2.0 机器人,其行为过程表现为“既定使命和被感知的环境信息经过智能顶层的分析、决策和规划过程,产生由底层执行的行为指令”。参见封锡盛:《机器人不是人,是机器,但须当人看》,《科学与社会》2015 年第2 期。。自动化指的是机器设备或系统在没有人或较少人的直接参与下,经过一系列操作而实现预期目标的过程。自动化是机器的基本特征,是机器区别于一般的工具(如手工工具)的根本特征。智能化指的是机器设备或系统通过模拟个人智慧或群体智慧而体现出的“计算”、“思考”和“创造”能力。智能机器的自动化水平与智能化程度不断提升,促使其更加频繁和深入地参与到人类的道德场景中,甚至包括道德决策、道德行动等场景,因而在其设计中加入道德关怀(moral consideration)的呼吁也越发强烈。这一方面是因为智能机器自身的道德涉入程度在不断加深,另一方面则是因为随之而来的道德风险的扩散。

1.智能机器道德涉入程度的加深

随着智能机器的算力提升和算法优化,其道德涉入程度也在加深。根据詹姆士·摩尔(James Moor)的伦理能动者划分方式②摩尔根据不同的伦理涉入程度,将伦理能动者分为四种类型,分别是有伦理影响的能动者(ethical impact agents)、隐性的伦理能动者(implicit ethical agents)、显性的伦理能动者(explicit ethical agents)和完备的伦理能动者(full ethical agents)。摩尔对伦理能动者的划分(参见于雪、王前:《“机器伦理”思想的价值与局限性》,《伦理学研究》2016 年第4 期)比较经典,本文据此对智能机器的道德涉入程度加以区分。,智能机器的涉入程度呈现出递进式的加深过程。

第一阶段是“有道德影响的智能机器”,其功能相对简单,由人类进行操作,机器基于既定目标执行任务。这类机器体现出一定的道德作用,表现为影响人们的道德观念或行为。例如,工业生产中的机械臂可以代替人类在高温、危险和需长时间工作的环境中作业,以降低人类死亡的可能性。

第二阶段是“道德隐性的智能机器”。从功能上看,这类机器可以在人类辅助操作下实现一些相对复杂的功能。这类机器的道德影响往往是隐性的,既包括无意识设计行为导致的间接道德后果,如使用超声波机器增加了因为胎儿性别而选择流产的可能性,也包括有意识设计行为导致的直接道德后果,如设计一种仿制钞票的机器会有可能导致制造假钞的作恶行为。不同于有道德影响的智能机器,道德隐性的智能机器在其被设计的过程中已经蕴含着道德诉求,只是需要操作的人通过一定的方式将其中的道德因素解析出来。

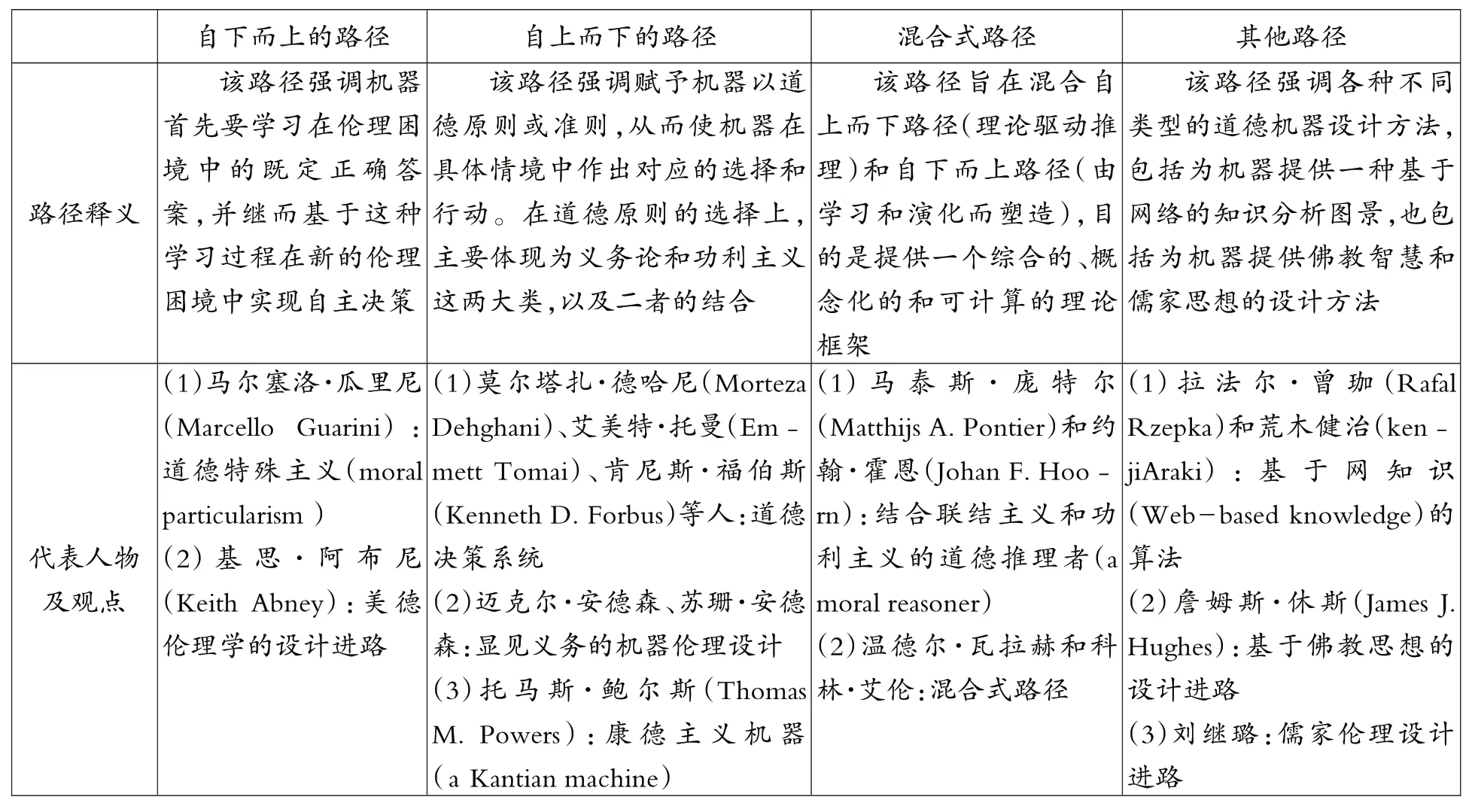

第三阶段是“道德显性的智能机器”。从功能上看,这一类智能机器与前面两类智能机器最大的不同是具有决策功能,能够在复杂环境中基于一定的程序算法作出判断和决策,并据此实施行动。这种决策能力体现在道德情境中则表现为道德决策能力,通过内在的道德机制,机器能够评估道德情境中的可能性,并依据道德原则和规范作出最优的道德选择。例如,迈克尔·安德森(Michael Anderson)和苏珊·安德森(Susan Leigh Anderson)将罗斯的显见义务作为道德原则设计到机器的算法程序中,使用者可以利用程序来判定在不同道德情境中道德选择的不同后果[3](476-492)。更多的设计方法参见表1①笔者依据约翰-斯图亚特·戈登(John Stewart Gordon)对道德机器的分类整理而成。参见GORDON J S,“Building moral robots:Ethical pitfalls and challenges,”Science and Engineering Ethics,2020,26(1),pp.141-157.。

表1 道德机器的四种设计路径

第四阶段是“道德完备的智能机器”,其在功能上无须人类介入,自身能够完全地实现判断、决策和行动的过程。这一阶段的智能机器在道德上被赋予了完备道德能力,能够在道德情境中作出基于考量的道德选择和行为,目前还只存在于科幻电影中,如《2001 太空漫游》中的HAL②HAL(型号为HAL9000)是《2001 太空漫游》中的一台具有人工智能的高级电脑系统,它为了执行任务,选择“杀死”飞船中的三位科学家和二位宇航员。之所以将HAL 视为道德完备的智能机器,是因为在丹尼尔·丹尼特(Daniel Dennett)看来,HAL 比一般的计算机系统(如“深蓝”)更加完备。按照丹尼特的术语,如果“深蓝”是“意向系统”,那么HAL 就是“高阶意向系统”(a higher-order intentional system),即它“能够建构关于自身信念的信念,建构关于自身欲望的欲望,建构关于自身害怕或希望的信念”。参见GORDON J S,“Building moral robots:Ethical pitfalls and challenges,”Science and Engineering Ethics,2020,26(1),pp.141-157.。智能机器道德涉入程度的加深表明其在道德场景中起作用的程度也在加强,这意味着智能机器有可能承担越来越多的道德角色,因此要在其设计中嵌入道德考量。

2.智能机器道德风险的扩散

道德风险(moral risk)指的是道德活动或决策带来的可能伤害。随着智能机器道德涉入程度的加深,其引发的道德风险也在不断扩散。一方面,智能机器依赖于复杂的操作系统,某个细微因素的变化就有可能导致整个操作系统的不稳定甚至崩溃,一些黑客也有可能通过攻击操作系统的某个程序来控制智能机器从事不道德的行为;另一方面,智能机器在社会中的渗透与嵌入也会引发社会脆弱性,比如就业结构、家庭结构、社会组织结构等重要社会关系的结构性调整。

此外,智能机器道德风险的扩散还会引起关于其能否在道德意义上被接受的问题,即道德接受性(moral acceptance)。道德接受性强调在关于道德行动的情境中主体是否自愿地同意、接纳或赞成客体的行为,包括道德接受主体、道德接受客体以及道德接受语境这三个方面[4](621-640)。基于这三个方面,智能机器的道德接受性可以分为客体导向和主体导向。客体导向主要涉及智能机器自身的特征、智能机器的发展前景及潜在影响、与此相关的法律责任和道德责任等因素。主体导向主要涉及接受主体对智能机器的态度、判断、期待、主观动机等方面。客体导向与主体导向都与接受语境相关,不同语境下的接受性和可接受程度是不同的。这种不同源自智能机器的道德风险,而道德风险的扩散会降低智能机器被接受的可能性。为了应对这种情况,转向一种道德设计的实践路径是必要的。以设计的方式将道德内嵌于机器之中,使机器在有限的可能性中预防由其不确定性导致的道德风险,能够更好地应对潜在的风险后果并提升其易感性(susceptibility)和回弹力(resilience)。

二、智能机器的道德设计进路及责任困境

智能机器的道德设计是以设计的方式将道德内嵌于机器之中。根据道德嵌入的不同程度,本文将当前的道德设计进路总结为“强进路”与“弱进路”。“强进路”旨在设计具有道德决策能力的智能机器(如“道德显性的智能机器”)使其有可能成为道德行为的发起者。“弱进路”则旨在设计无道德决策能力的机器(如“道德隐性的智能机器”),通过嵌入道德价值的方式使其有可能成为道德行为的承受者。这两条道德设计进路都面临着能否对其责任归因的困境,前者涉及能否将智能机器视为责任主体(the subject of responsibility),后者涉及能否将智能机器视为责任客体或责任对象(the object of responsibility)。

1.“强进路”中智能机器的责任主体困境

“强进路”强调通过设计的方法将道德决策能力嵌入到机器之中,使其成为道德情境中行为的发起者。这种设计进路中的智能机器也被瓦拉赫和艾伦称为“人工道德能动者”(Artificial Moral Agents,AMAs)[5](4)。AMAs 的设计想法来自“为机器增加伦理维度”的机器伦理,即“创建一类能够遵循一种正当的伦理原则或者一套准则的机器”[6](109-114)。因此,该进路主要关注何种道德原则或伦理标准应当被赋予智能机器。关于这个问题,当前的研究相对丰富,总体上可以分为四种路径:自下而上路径、自上而下路径、混合式路径、其他路径。不同路径的核心释义及其代表观点详见表1。

该进路的核心是通过将道德原则嵌入机器算法的过程使其具备道德决策能力从而成为道德行为的发起者,它试图让智能机器成为道德情境中的行为主体。该进路面临着是否以及如何使智能机器成为责任主体的问题,换句话说,该不该让智能机器负责?这种观点比较激进,而直接承认智能机器的责任主体地位至少要先回答以下两个问题。

一是,作为主体承担道德责任意味着该主体应当是“道德能动者”(moral agents),那么具有道德决策能力的智能机器能否成为道德能动者?

道德能动者是能动者(agents)的一个子集,能动者指的是能够根据其意向主动实施某种行动的实体或主动的行动者(actors)[7](35-45),而道德能动者则强调该行动处于道德情境中。具体而言,实体X 可以被认为是道德能动者需要满足以下四个条件:(1)X 具有能力;(2)根据该能力,X 可以自由选择;(3)X 审慎地考虑该做什么;(4)在实际情况中,X 能够正确地理解并且应用道德规则[8](19-29)。简化之,道德能动者可以按照道德规则自由地行动。传统的哲学观点(如康德哲学)认为道德能动者只能是人,动物、人工物、环境等非人因素都不能是道德能动者。尽管被嵌入道德决策能力的智能机器通过程序算法同样也展现出了按照道德规则自由行动的能力,但是这里的“自由”在何种意义上与人类的自由等同仍有待澄清,因而将其视为道德能动者的想法仍然是难以被接受的。尽管有一些主张承认人工道德能动者的呼吁,但这些呼吁无法解释人工物如何作为责任主体承担道德责任。

二是,作为主体承担道德责任意味着该主体应当具有“道德自主性”(moral autonomy),那么具有道德决策能力的智能机器是否具有道德自主性?

斯蒂芬·达沃尔(Stephen Darwall)对四种自主性的区分可以回应这个问题,即“个体自主性”(per⁃sonal autonomy)、“道德自主性”、“理性自主性”(rational autonomy)和“能动自主性”(agential autono⁃my)[9](263-284)。“个体自主性”是从个人价值和个体目标出发考虑行动的自主性,“道德自主性”则依据道德规范和伦理准则。康德的“autonomy”实际上同时体现了这两种自主性,即依据高级(道德)律令作出的自我决定。因此,这两种自主性一直被认为是人类所独有的。“理性自主性”依据的是“最重要的理由”(weightiest reason),而“能动自主性”则依据“真正的行动”(genuine action),根据达沃尔的解释,这二者从某种意义上说可以通过算法赋予人工系统。因此,尽管对具有决策能力的智能机器而言,它们满足实现理性选择和自主行动的条件,但也仅能体现理性自主性和能动自主性,而无法体现使其能够成为责任主体的道德自主性。

综上,“强进路”试图设计一种道德机器使其成为责任主体是很有争议的,如果不能清楚地解释机器如何体现道德自主性并成为道德能动者,是无法将其视为责任主体而将责任归因于其的。

2.“弱进路”中智能机器的责任客体困境

与“强进路”不同,“弱进路”并不试图将道德决策能力“写入”机器算法中,而是将道德价值赋予智能机器,使其有可能成为道德关怀对象。这种想法来自“为了价值的设计”(design for values)[10](27-31),通过将价值设计到技术中以使技术最大限度地符合社会大众的价值预期。那么道德是否也可以作为一种价值被嵌入智能机器的设计之中呢?

伯特伦·马莱(Bertram Malle)从宽泛的意义上提出了利用道德能力(moral competence)将道德价值赋予机器。道德能力的五个核心要素分别是:道德词汇(a moral vocabulary)、道德规范(moral norms)、道德认知和影响(moral cognition and affect)、道德决策和行动(moral decision making and action)、道德沟通(moral communication)。把道德词汇设计到智能机器中可以使机器构建出对规范的概念化理解、学习和使用,如可以将“惩罚”“原谅”“训斥”等对违规行为的回应设计到机器的道德词汇中。道德规范的设计可以通过同时赋予机器规范获取(norm acquisition)和规范表征(norm rep⁃resentation)两种能力实现。赋予机器以道德认知能力指的是使机器能够基于分割视觉和语言的事件流识别违反道德规范的现象,从被分割的事件中识别出有意图的行为,从而以反事实推理能力阻止事件的发生。为机器嵌入道德决策和行动能力与“强进路”十分相似。最后,智能机器应当增加道德交流的维度,即通过交流的方式来修正道德判断和决策[11](243-256)。

该进路的核心是通过将道德价值赋予智能机器使其成为道德情境中的行为对象而被道德关怀,该进路面临着是否以及如何使智能机器成为责任客体的问题,即该不该对智能机器负责?该不该关怀智能机器?这条进路相对比较温和,但仍然有两个问题需要回答。

一是,将道德价值赋予智能机器,并且承认它们是应当被负责的责任客体是否意味着机器真的能够被道德关怀?

将智能机器视为道德关怀对象有一个预设的前提,即人类很容易与世界上的事物建立一种情感联系,也很容易将某种仿佛存在的能动性(as-ifagency)归因于事物。比如,人们对拟人化机器人有一种天然的好感,这在理论上可以得到社会心理学家弗里茨·海德(Fritz Heider)的归因理论(attribu⁃tion theory)的支持。该理论是从人自身出发解释其对象的行为,所以是作为人类的我们决定了我们想要与作为机器的“它们”建立道德关系,那就等同于“它们”有了道德状态。换句话说,如果我们决定将某物视为道德关怀对象去回应它,那么就等同于该物是道德对象。这里有一个简化的关系式:我感觉X 是道德关怀对象→X 是道德关怀对象。将这个关系式置于责任框架中,则改为:我感觉X 有责任→X 有责任。但是,这个关系式显然有待澄清,因为若X 表示一支铅笔,则该结论就显得荒谬了。因此,承认智能机器的责任客体地位的理由也尚不充分。

二是,将智能机器视为责任客体并纳入责任考量的范围,对机器而言有什么意义?

将智能机器视为责任客体意味着将其视为行为的承受者,并且承认该行为将导致一个后果。这是将智能机器纳入责任网络(responsibility networks)的做法,责任网络是克里斯蒂安·纽豪泽尔(Christian Neuhäuser)提出的,包括六个特征:(1)规模庞大;(2)责任主体或规范标准、权限等其他相关要素难以界定;(3)责任网络是在不清楚如何定义具体责任时出现的;(4)责任网络结合了几种不同的责任;(5)当事人通常有不同的立场(例如,他们是一种责任的主体,但却是另一种责任的客体);(6)责任网络中的关系元素经常重叠[12](269-286)。纽豪泽尔的责任网络将关涉某行为的所有利益相关者都纳入其中,这当然也包含了智能机器。在责任网络中,智能机器是作为责任客体被纳入的,并且是一个应当被道德关怀的对象。这里的论证依据是智能机器作为人类道德世界的一部分且在道德上值得考虑,因此就是责任网络中的道德关怀对象。但是,通过将智能机器纳入责任网络的方式承认其责任客体的地位对于机器自身而言究竟有什么意义?如果不能合理地回答这个问题,那么这种论证就仅是隐喻意义上的。

总的看来,“弱进路”相对柔和,仅主张智能机器应当是被负责任的对象,但该进路也尚未澄清对其负责和道德关怀究竟意味着什么,因而将智能机器视为责任客体而对其责任归因的理由也是不充分的。

三、智能机器的道德交互设计及其责任归因

上述两条道德设计进路都试图对智能机器进行责任归因,“强进路”试图回答“该不该让智能机器负责”,而“弱进路”则试图回答“该不该对智能机器负责”。然而,这两条进路都遇到了困难,前者无法解释智能机器如何具备道德自主性和道德能动性以负责,而后者也无法解释对智能机器负责任究竟有什么意义。在本文看来,这些困难在于把目光置于智能机器本身,更关注作为设计产品的机器,在一定程度上忽视了设计中的智能机器与人之间的交互关系。本文提出一种道德交互设计理念,以人与智能机器的设计关系作为框架来理解责任。道德设计的责任归因应当是人与智能机器的交互关系,而责任归因的目的也在于更好地塑造智能机器与人的交互关系。

1.智能机器的道德交互设计理念

交互设计是设计活动中的一个重要方向,通过不同的形式促成人与机器之间的交流互动。随着交互模型的优化,交互设计也呈现出从“输入—反馈”的单向关系到“推荐—选择”的双向关系的变化。正是基于这种变化,本文提出一种道德交互设计的理念。该理念指的是在人机交互过程中实现道德设计,强调人与智能机器之间的道德信息交换,人为智能机器提供可计算的道德理论,智能机器为人提供计算过程和可供选择的计算结果,在人和智能机器的互动过程中实现一种“推荐—选择”的道德设计。这既不是简单地为智能机器输入固定的道德理论,也不是人被动地接受智能机器的道德输出,而是在人与智能机器的动态关系中实现道德设计,如通过设计一些动态情境使智能机器获得关于情境的敏感性,从而在道德行动中提供恰当的辅助。智能机器需要“处于”这样一个交互情境中,以促成道德行为,这是因为“道德行为是一个主体间动态的交互过程”[13](104-116)。

这种贯穿在人机交互过程中的道德设计也许能够回应上面提及的责任归因困境,其回应方法是不再将责任归因于作为实体的智能机器(无论是责任主体归因还是责任客体归因),而是将责任归因于人与智能机器的交互关系,因为“[责任]主体不再是感知者或观察者,而是一个积极与环境联系的行为者”[14](50)。这种思路的核心就在于以人机之间的动态关系来应对道德分歧(moral disagree⁃ment)[15](591-608),因为尽管人们在特定的道德理论上存在分歧,但他们可以在良好道德行为的例子上达成一致,虽然在面临道德困境时,彼此的道德判断有可能会大相径庭[16](2105-2108)。

本文所提出的道德交互设计是一种设计理念,是为了回应现有道德设计进路的责任困境,目前还未有成熟案例。不过,从技术上尝试基于人机交互的设计有很多种方法,比如机器人专家罗德尼·布鲁克斯(Rodney Brooks)设计的情境机器人,因其具身化特征可以与它所处的环境相互作用。基于情境敏感性的道德应当是在人机交互的过程中生成的,这种尝试为道德交互设计提供了方法论层面的可能性,即通过交互设计的方法将道德嵌入机器,使机器在与人互动的过程中实现道德选择和道德生成。

2.对责任归因困境的回应:由实体性责任转向交互性责任

道德交互设计理念对责任归因困境的回应在于将传统的基于主客二分的实体性责任重构为基于关系的交互性责任。实体性责任是指将责任建立在实体上,强调责任主体和责任客体之间的关系。道德设计中的“强进路”与“弱进路”所涉及的责任都是这种实体性责任,将智能机器或者视为责任主体或者视为责任客体,都是在主客二分的框架下理解责任的,因而产生了责任归因的困境。

实体性责任的一个理论依据是行为主义,即从可观测行为(observable performance)出发判定行为中的责任。约翰·达纳赫(John Danaher)提出了“伦理行为主义”(Ethical Behaviourism)来论证机器人的道德责任归因。他的论证结构是:

(1)如果一个机器人在行为上大致等同于另一个被广泛认为具有重要道德地位的实体,那么为机器人提供同样的地位是正确和适当的;

(2)机器人可以大致等同于其他实体,人们普遍认为,这些实体具有重要的道德地位;

(3)因此,赋予机器人重要的道德地位是正确和恰当的。[17](2023-2049)

有意思的是,行为主义在20 世纪70 年代左右就已经受到了抨击,因为它不能解释内在的心理活动,那么为什么在当前的机器人伦理讨论中又一次被提出来了呢?[18](1-9)达纳赫的解释是“伦理行为主义论证了一个可靠的认知基础或保证——相信我们对其他实体负有责任和义务——可以在可观察到的行为关系和对我们(以及周围环境)的反应中找到”[17](2028)。伦理行为主义的建议是有价值的,因为智能机器的外在行为表现可以直接决定其责任分配,但是这更多地表现为法律责任、经济责任等外在责任关系,而不是道德责任这种必须涉及内在心理活动的责任关系。因此,本文建议在吸纳伦理行为主义合理成分的基础上,转回对基于关系的交互性责任的寻求以化解责任归因困境。

责任本就是一种关系性存在,但是这种关系是一种外在的关系,即主客二分的关系。本文所提倡的交互性责任建立在主体间的交互关系上,表现为一种内在的关系,即动态的、生成性的责任。道德交互设计理念所涉及的责任更多地表现为这种交互性责任,即在这种动态生成的交互关系中理解人与智能机器的责任。交互性责任有两个特点:一方面,责任主体和责任客体既不是一元的也不是自足的,而是与其他人类和非人类相互作用的主体或客体;另一方面,责任产生于与人类和非人类的互动中,由人类和非人类共同构成的“主体—客体”的框架来承担。艾伦·汉森(Allan Hanson)的联合责任(joint responsibility)就是一种基于延展能动性(extended agency)和交互能动性(interaction agency)的责任类型。在汉森的责任框架中,责任不是作为属性或特性,而是作为“主体—客体”之间的交互作用和联结方式[19](91-99)。道德交互设计理念将责任视为一种交互性责任,将责任置于动态的交互环境中并将其归因于人机交互关系。需要说明的是,在交互性责任的归因问题上,不是对已发生事件的惩罚性追责,而是对尚未发生事件的预防性责任,它不是一种后置责任而是一种前置责任。

结语

智能机器的蓬勃发展带来了诸多问题,其中的责任问题尤为显著。通过设计的方式将道德嵌入智能机器的做法在一定程度上得到了认可,但是随之而来的责任困境尚未得到普遍关注。无论是“强进路”引出的“该不该让智能机器负责”还是“弱进路”引出的“该不该对智能机器负责”,都是在寻求一种基于主客二分的实体性责任。本文提出一种道德交互设计理念,构想在人机交互过程中实现道德设计。该设计理念下的责任将呈现为一种动态的、生成的交互性责任。这种预防性的前置责任方式将有助于跨越“责任鸿沟”,从而实现人机交互过程中的责任归因。这种构想只是一次新的尝试,希望能够对人机之间的责任归因提供新的解释思路。但无论如何,解决人机之间责任问题的构想和解析都将有助于建构未来的人机共生社会。