固定翼无人机着陆姿态角测量算法研究

齐 乐,袁宝玺,郭凤娟,郭建新,徐 悦,米 辰

固定翼无人机着陆姿态角测量算法研究

齐 乐1,袁宝玺1,郭凤娟2,郭建新1,徐 悦1,米 辰1

(1. 西京学院 信息工程学院, 西安 710123;2. 陕西省组合与智能导航重点实验室,西安 710071)

针对固定翼无人机自主着陆过程中姿态角测量不精确的问题,提出了一种新的基于单目视觉的姿态角测量方法。并且针对现实环境中拍摄的合作目标图像存在的光照不均、反光和模糊等情况,提出了纹理增强和检测效率优化算法,消除了图像退化对检测结果的影响,从而实现了对光照退化具有鲁棒性的检测方案。实验结果表明,姿态角测量误差为0.39°,每秒检测帧数达到了83.33帧,能够同时满足无人机着陆误差与实时性的要求。

固定翼无人机;视觉导航;合作目标检测;姿态角测量

0 引言

近年来,关于无人机自主着陆系统的研究取得了很多成果。其中大多数使用视觉导航[1-4]、全球卫星导航系统(global navigation satellite system, GNSS)或惯性导航系统(inertial navigation system, INS)来估计无人机的状态。惯导系统使用陀螺仪和加速器等惯性元件来获取无人机的位置和速度,但惯导系统在长期飞行中往往由于累积误差而漂移。GNSS被广泛应用于无人机的定位,但是GNSS依赖于他国卫星,且在复杂的城市或室内环境中很容易受到干扰。视觉导航通过对视觉传感器获取的图像进行处理,估计无人机的飞行状态和相对位置。它具有设备简单、信息量大、自主性强、抗干扰能力强等特点。因此,基于视觉的自主着陆方法在无GNSS环境下的优势尤为突出。

现有的基于视觉的自主着陆方法,采用的传感器包括可见光和红外摄像机,研究大多集中于基于合作目标的自主着陆方法。例如,文献[5]提出了一种红外摄像机阵列制导系统,提供固定翼无人机的实时位置和速度,并在无GNSS环境下成功降落在跑道上。但是,由于地面上摄像机阵列系统设置复杂,这种方法不适合在狭窄的着陆区域使用。文献[6]设计了一种地基驱动红外立体视觉系统,但是当背景中有高温目标时,该方法无法精确捕捉目标的中心。文献[7]构建了一个旋翼机自主着陆系统,该系统采用了一个混合相机阵列,包括一个鱼眼镜头相机和一个立体相机。然后将宽视场和深度成像相结合,实现了对着陆合作目标的精确定位。对于可以悬停的旋翼无人机来说,在得到合作目标的位置信息之后,通过水平面的平移和升降运动即可实现着陆。对于通过滑跑方式降落的固定翼无人机来说,必须通过实时控制姿态角(俯仰、滚转和偏航角)来实现自主着陆,因而难度更大。

针对以上问题,本文提出了基于约洛v5s(you only look once v5s, YOLOv5s)结合n点透视(e-perspective-n-point, EPnP)算法的姿态角测量方法,通过YOLOv5s检测合作目标,利用EPnP解算姿态角引导无人机进行自主着陆。本文算法兼顾精度的同时保证了检测的实时性,且本文提出的基于YOLOv5s和轻量级U型网络的纹理增强和检测效率优化算法,消除了图像退化对检测结果的影响,进一步提高了导航精度。

1 基于单目视觉的姿态角测量算法

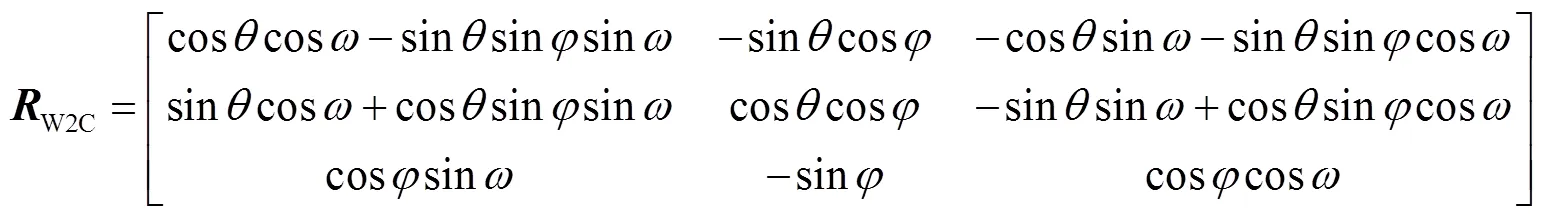

1.1 位姿估计理论

图1 相机成像模型

即

图2 无人机坐标系

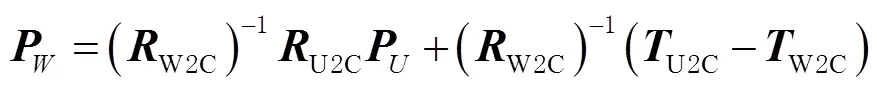

世界坐标系与无人机坐标系的关系为

1.2 EPnP算法

n点透视(perspective-n-point,PnP)算法是由勒珀蒂(Lepetie)和莫雷诺(Moreno)在2009年提出的一种非迭代算法,文献[9-10]从噪声、实时性、特征点个数等角度将EPnP与比例正交投影迭代变换算法(pose from orthography and scaling with iterations,POSI)、直接线性转换(direct linear transformation,DLT)等算法进行对比,实验结果表明,EPnP算法精确度更高、鲁棒性更强。该算法的核心思想是:因为三维坐标系中的任意一点都可以用4个控制点来加权表示,所以算法求解的问题就转换成了4个控制点的求解与优化问题。而控制点的坐标可以通过检测算法获得,然后根据转换关系求得旋转矩阵与平移向量,从而解算出无人机的姿态角。算法流程如图3所示。

图3 算法流程

2 合作目标检测

2.1 合作目标设计

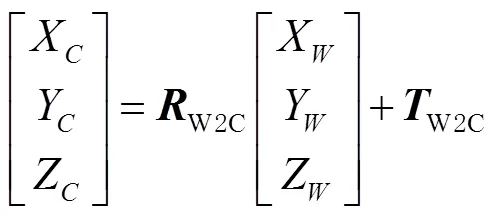

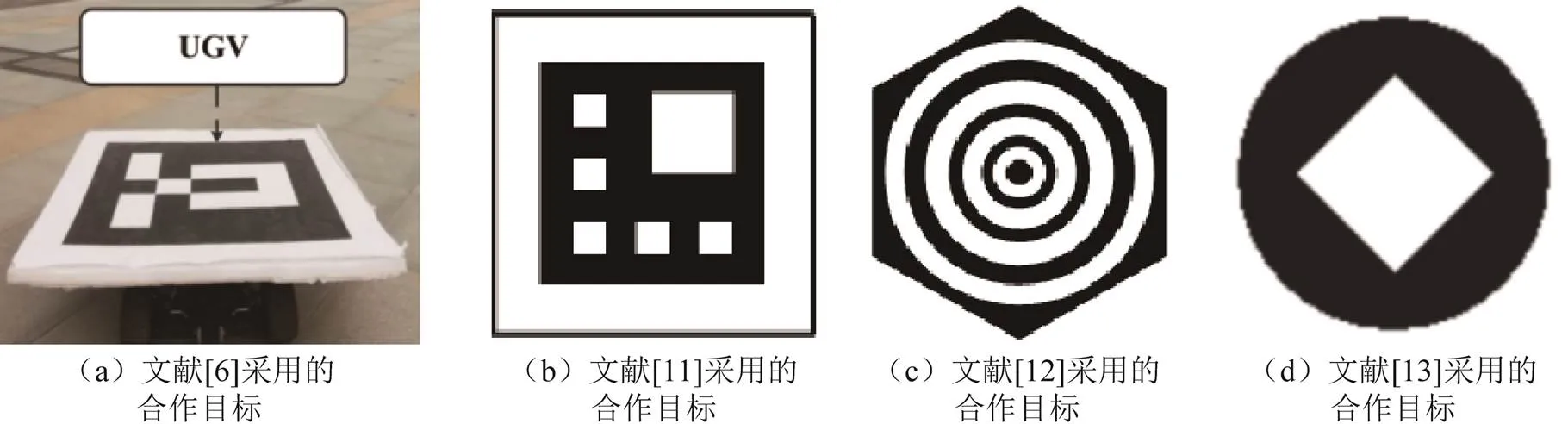

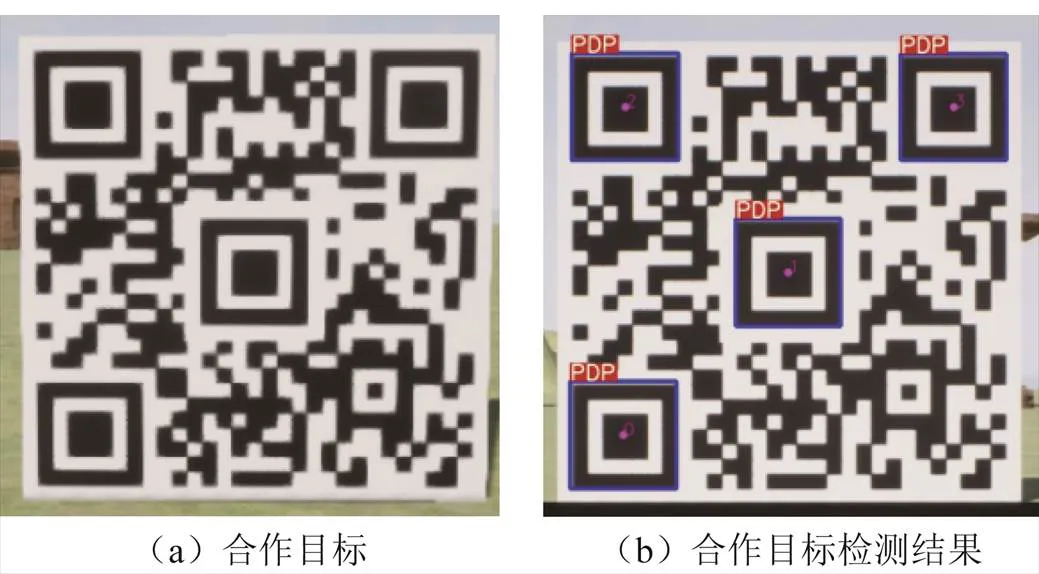

文献[6]与文献[11-13]中采用的合作目标如图4所示,这些合作目标一般由黑白两色组成,具有一定的编码规则,具有较强的视觉特征。从广义上讲,图4所示的合作目标也是某种二维码,但其模式比二维码更简单,包含的编码信息更少。因此,在无人机接近着陆点时,本文设计了如图5(a)所示的快速响应码(quick response code,QR码)图像作为合作目标。图中像“回”字形的图案部分被称为“位置探测图形(position detection patterns,PDP)”,根据EPNP算法需要4个控制点输入的要求,本文设计的QR码中间部分也是一个位置探测图形,合作目标检测结果如图5(b)所示。相对于图4中的合作目标,二维码的一个显著优势是容量大,纠错能力强,安全性高。QR编码算法本身具有较强的自纠错能力,可以提高在存在污染和部分缺失情况下正确解码的概率,从而提高复杂环境下合作目标检测的鲁棒性。

图4 无人机自主着陆合作目标

图5 合作目标及其检测结果

2.2 合作目标检测算法

根据无人机姿态角的求解过程可知,影响无人机姿态角测量精度的关键因素在于是否精确定位到了合作目标的位置。只有十分准确地检测到无人机获取的图像中的合作目标,得到其精确的位置坐标,然后进行坐标系的转换得到旋转矩阵,才能准确求得无人机的姿态角,后续才能引导无人机进行精准地着陆。而由于无人机在飞行过程中速度极快,所以在对检测算法进行选择时,还要考虑算法的检测速度,只有速度够快才能达到实时解算姿态角控制无人机飞行状态的要求。

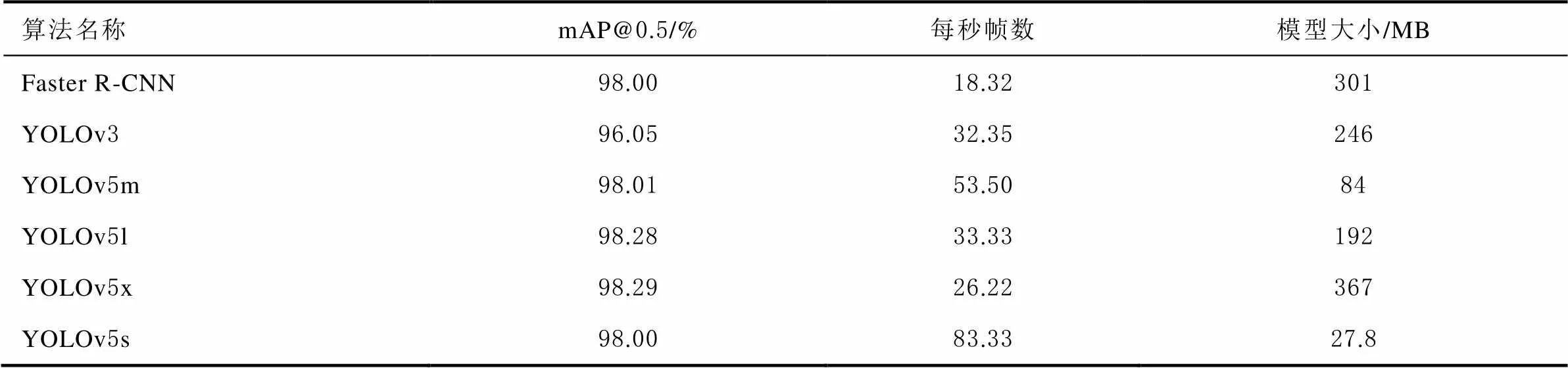

YOLOv5s模型尺寸非常小,部署十分快速,默认为批处理推理,单张图像的推理速度能够达到140帧每秒(frames per second, FPS),可以极大地满足实时检测的要求。将YOLOv5s与其他代表性的一阶段和二阶段目标检测算法进行比较,其中二阶段算法选取快速区域卷积神经网络(faster region convolutional neural network, Faster R-CNN[14]),一阶段算法选用约洛3(you only look once v3,YOLOv3[15])、YOLOv5m、YOLOv5l、YOLOv5x,将6种算法在统一的自制数据集上进行模型的训练与推理,不同算法的性能对比结果如表1所示。表1中:mAP(mean average precision)为类平均精度,mAP@0.5为阈值为0.5时的类平均精度。

表1 不同算法性能对比

由表1可以看出: mAP最高的为YOLOv5x的98.29%,每秒检测帧数最高的为YOLOv5s,达到了83.33。YOLOv5s相比于YOLOv5x速度提高了3.18倍,mAP仅比YOLOv5x低了0.29%。考虑到无人机的高速性,需要准确度高、模型小、同时检测速度满足实时性要求的检测算法,所以YOLOv5s算法为最优选择。

3 基于YOLOv5s和轻量级U型网络的纹理增强和检测效率优化算法

3.1 轻量级U型网络

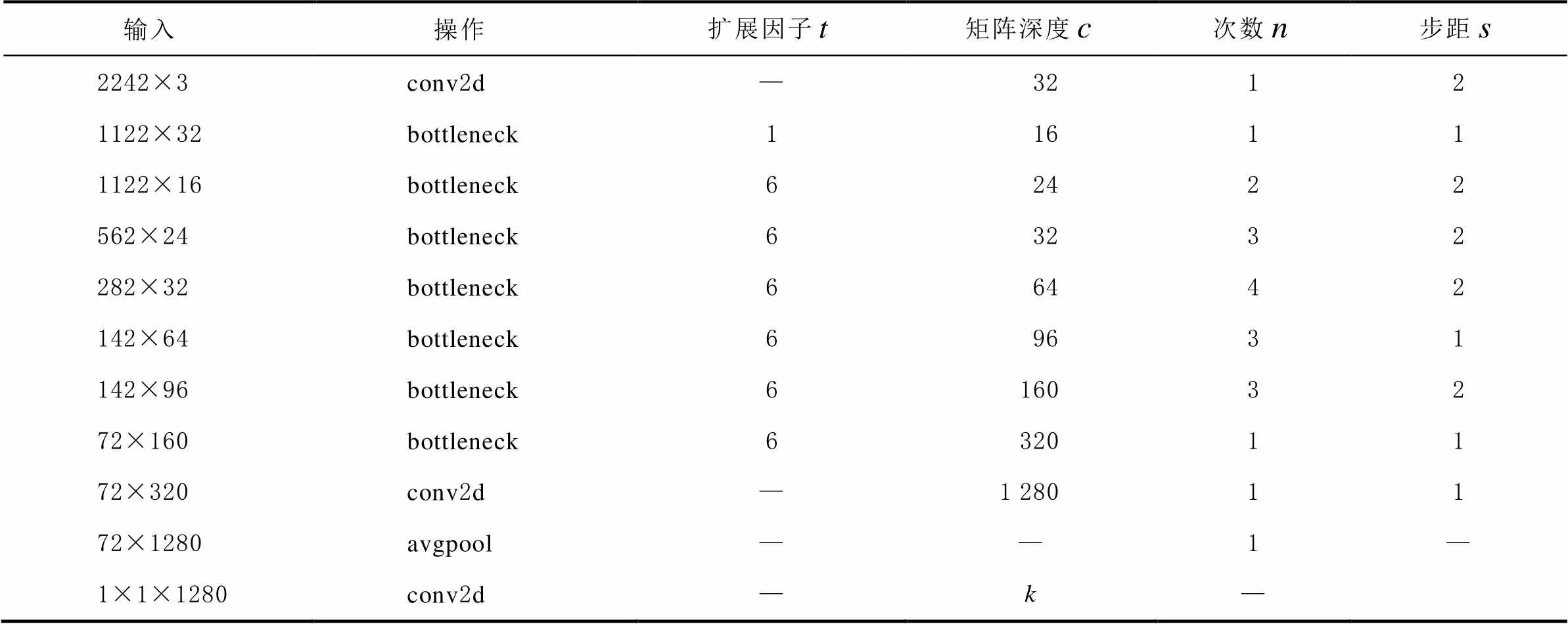

传统U型网络(u-network,UNet[16])的主干网络部分使用的是视觉几何群网络(visual geometry group network,VGG16)模型,VGG16模型参数量大、要求的算力较高,模型权重大小约为490 MB,并不适用于移动端或者嵌入式设备,所以传统的Unet模型并不能满足本文对合作目标进行实时检测的需求。而移动网络(mobile network v2,MobileNetv2[17])使用深度可分离卷积结构,在提升了模型准确率的同时,大大减少了模型参数与计算量,极大提高了模型推理速度,可用于移动端以及嵌入式设备进行实时的特征提取。因此本文提出了基于YOLOv5s和改进的U型网络的光照退化鲁棒检测方案,将改进的U型网络命名为轻量级U型网络(mobile network v2-u-network, MUnet)。

表2 MobileNetv2网络结构参数

3.2 基于YOLOv5s和MUnet的光照退化鲁棒检测方案

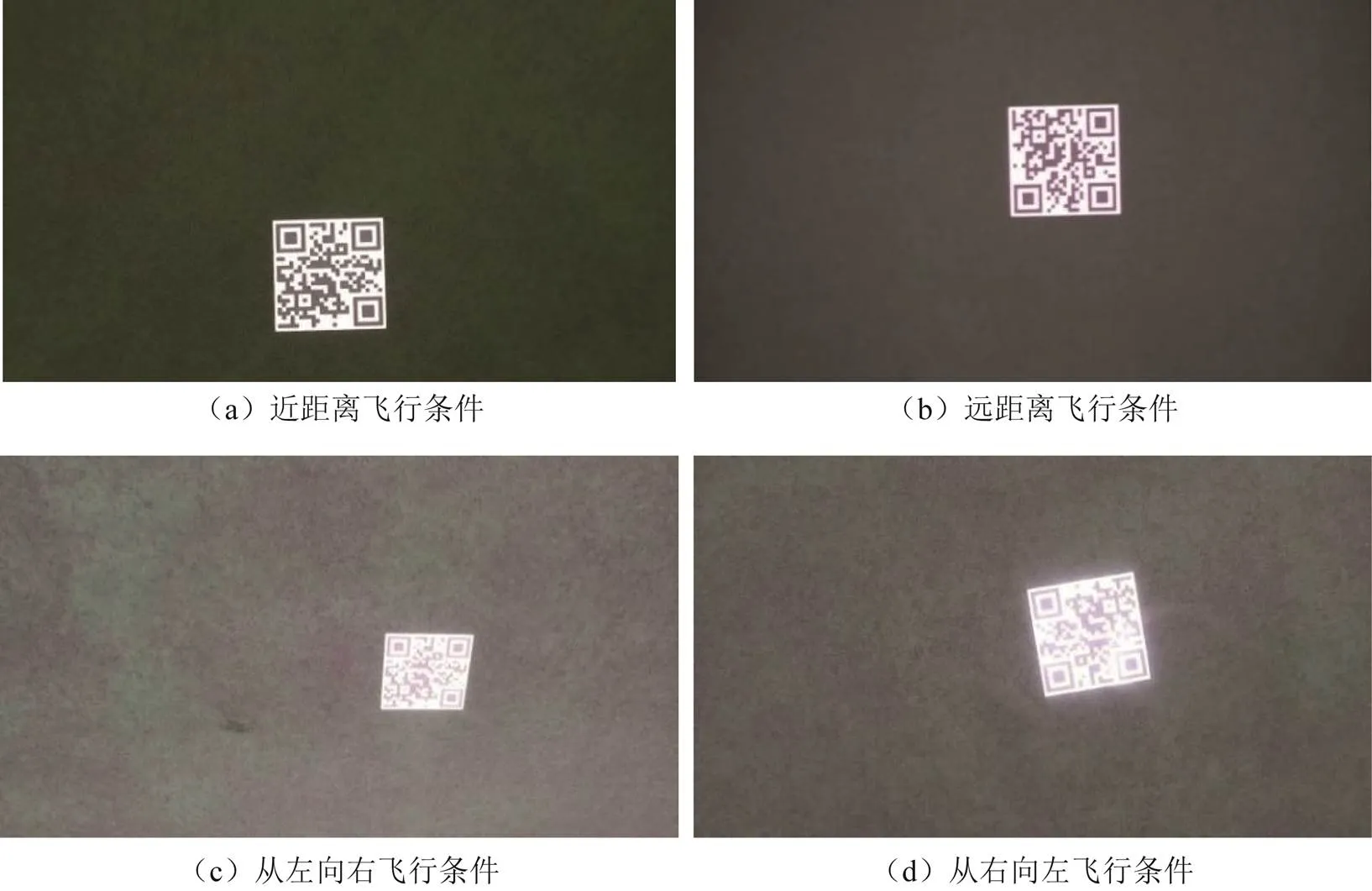

本文使用大疆云台相机禅思Zenmuse Z30在操场进行了实机实验。实验中无人机以不同角度,不同高度由远及近拍摄视频,然后将视频转换为图像序列。图6所示为获得的不同飞行条件下的QR码图像。

图6 不同飞行条件下的QR码图像

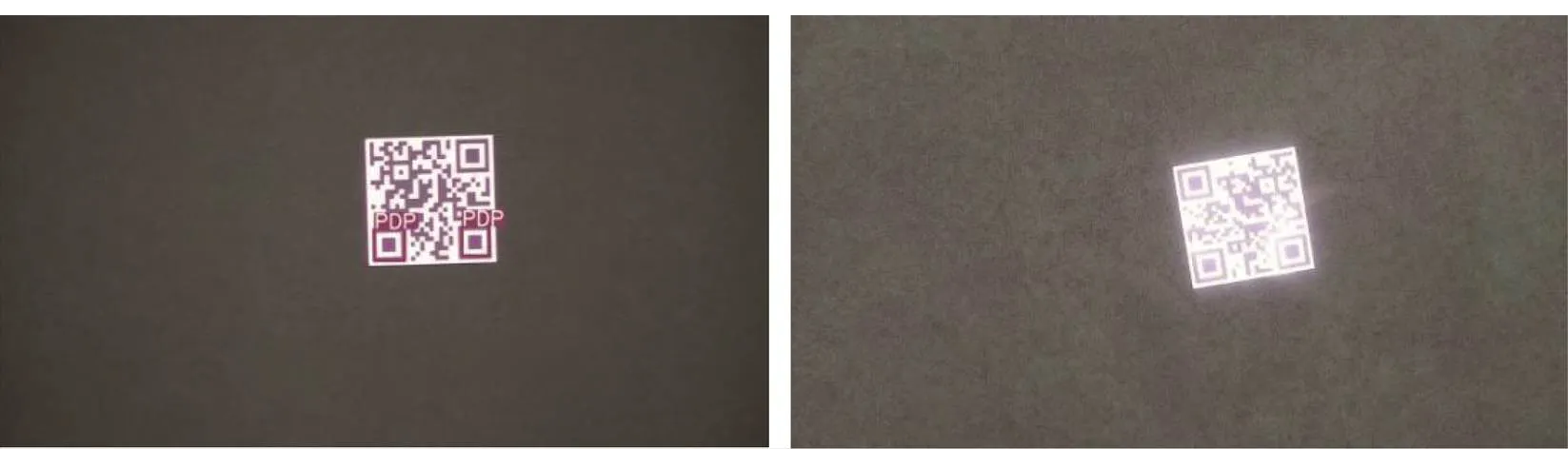

从图6可以看出,合作目标在现实环境中受光照影响很大,经相机拍摄会出现光照不均、反光和模糊等情况,导致目标检测精确度大大降低,从而影响真实无人机姿态角测量的精度。实验表明,直接使用YOLOv5s检测场景中的合作目标的PDP时存在漏检情况,如图7左图中的3个PDP图案中只检测到了2个,右图中的3个PDP图案全部没有检测到。

但是,如果将整个QR码图像作为被检测目标,存在光照不均、反光和模糊等情况的QR码图像的检测率会大大提升,实验结果显示,检测整个QR图像的准确率能够提高到95%,检测结果如图8所示。

然而将整个QR码图像作为被检测目标,只能得到1个控制点,无法满足EPnP算法的使用条件,所以仍然需要得到QR码图像中的位置探测图案的坐标信息,因此必须要解决经相机拍摄的QR码图像存在的光照不均、反光和模糊等退化问题。由于QR图像存在大量的纹理,经实验发现基于深度学习的UNet网络能够有效解决纹理图像中的光照不均、反光和模糊等退化问题。图9(a)为退化图像,图9(b)为采用MUNet网络进行纹理增强之后的图像。

图7 真实场景漏检情况

图8 整个QR图像检测结果

图9 纹理增强前后图像对比

因此,本文设计了基于YOLOv5s和MUnet的光照退化鲁棒检测方案:

1)使用YOLOv5s检测整个QR图像,并按照检测得到的外接框作为感兴趣区域(图8所示)把QR图像分割出来,分割结果如图9(a)所示。这样做的目的是,将纹理增强限定在QR图像范围内以减少计算面积;

2)将QR图像进行纹理增强,增强效果如图9(b)所示,从实验结果可以看到,图9(a)中存在的光照不均、反光和模糊等退化问题都能得到有效增强。考虑到无人机实时性检测这一特点,为了更进一步提高整个算法的效率,本文将传统的UNet网络进行了改进,使用更加轻量级的MobileNetv2代替传统UNet网络中的VGG16作为主干网络,使得纹理增强时间更进一步减少10倍左右;

3)在增强之后的图像中,再次使用YOLOv5s检测PDP定位图案,其检测也是在感兴趣区域内进行,实验结果表明,将第三步的检测范围限制在感兴趣区域内可以同时提高检测精度和检测速度。

3.3 实验结果分析对比

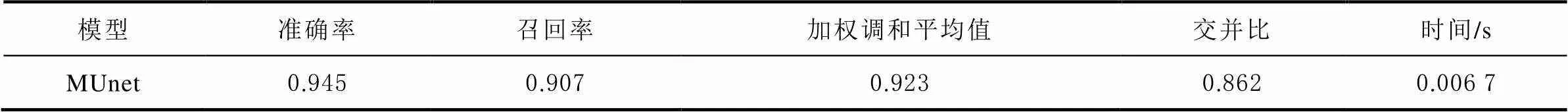

模型训练采用批处理的方式、将提取的8000张图像中的每8张为一个批次输入搭建好的MUnet模型进行训练,最大训练轮数设为1000、损失函数使用交叉熵损失,表3记录了基于MUnet的QR码纹理增强算法的推理结果,由表3可以看出,加权调和平均值为0.923,准确率较高,且推理每张图像的平均时间为0.0067s,说明MUnet算法的推理速度很快。

表3 模型推理结果

图6中不同飞行条件下的QR码图像经MUnet网络进行纹理增强后的效果如图10所示。

使用YOLOv5s分别对图6(a)、图6(b)、图6(c)、图6(d)和图10中的图10(a′)、图10(b′)、图10(c′)、图10(d′)进行检测,检测结果对比如图11所示。

从图11所示的结果中可以看出,纹理增强后的PDP定位图案的检测效果有了明显的提升,特别是图6(c)、图6(d)两图,原图经YOLOv5s检测后并没有检测到任何信息,所以图11并未加入图6(c)、图6(d)两幅原图进行对比,而图10(c′)、图10(d′)中的PDP定位图案都能检测到。实验统计结果显示,检测指标mAP由原来的33.27%提高到了96.35%。

图10 QR码纹理增强效果

图11 纹理增强前后检测结果

4 姿态角测量实验结果及分析

4.1 实验设计

姿态角测量实验过程设计为三步:1)给定飞行高度和初始姿态角作为姿态基准值,无人机按照设计的路线着陆,获取第一组着陆图像;2)保持飞行高度不变,改变初始姿态角度值再次进行着陆,获取第二组着陆图像;3)重复第二步获取足够多姿态角度的无人机着陆图像数据。本文设定共获取7组不同姿态下的着陆图像。最后,根据拍摄所获得的不同姿态下的着陆图像求解无人机的姿态角,并与基准值进行对比,验证本文所提出的算法的有效性。其中本文设计的7组实验中姿态角基准值如表3所示。

表3 各组实验姿态角度

4.2 实验结果及分析

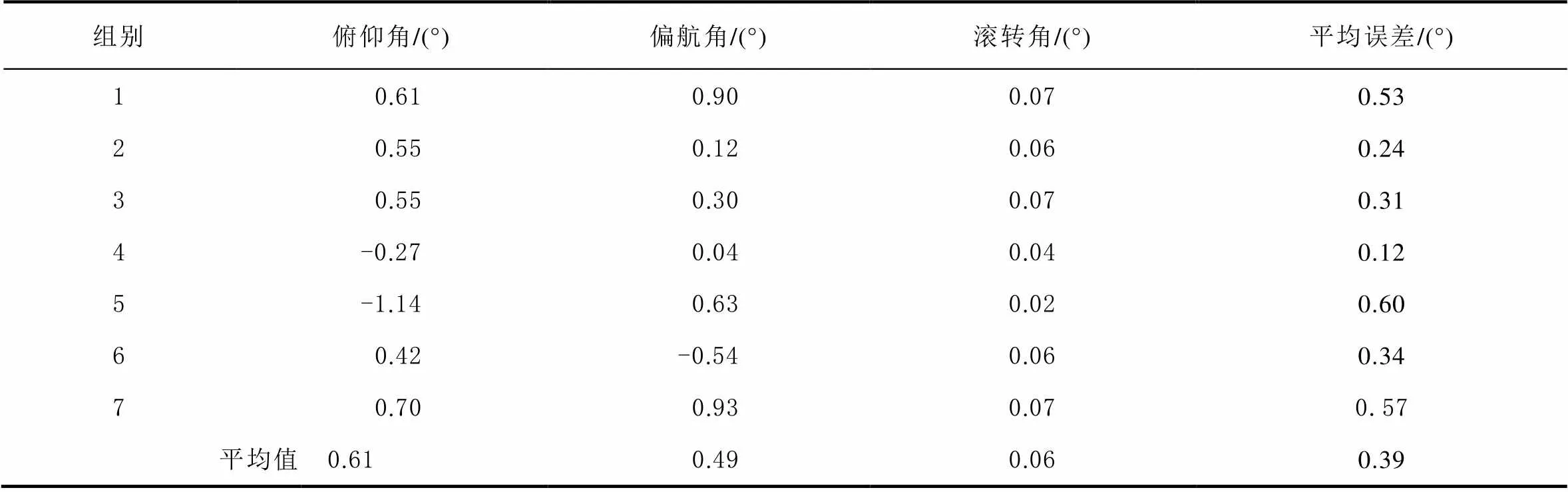

各组无人机姿态角测量误差如表4所示。由表4可知,通过本文提出的“YOLOv5s+EPnP”算法解算的3个姿态角的误差均值为0.39°。与文献[18]基于双目视觉测距原理使用“Faster R-CNN+PnP”算法求解旋翼无人机姿态角的方法相比,本文方法在检测一张图像的时间上提高了96%,检测准确率提高了0.41%,测量误差降低了38%。实验结果表明了本文算法能够获得快速、准确并且稳定的测量结果。

表4 无人机姿态角测量误差

5 结束语

本文采用的基于YOLOv5s和MUnet的纹理增强和检测效率优化算法,消除了现实场景图像退化对检测结果的影响,采用的“YOLOv5s+EPnP”的姿态角测量方法,检测速度快、测量误差小能够同时满足测量精度和速度的要求,具有很大的工程实用价值。在后续的研究中,可以根据仿真实验中验证成熟的算法,逐步移植到实际固定翼无人机硬件中,并增加实际硬件相关参数的设定,最终实现自主着陆的工程应用。

[1] 徐贵力, 倪立学, 程月华. 基于合作目标和视觉的无人飞行器全天候自动着陆导引关键技术[J]. 航空学报, 2008, 29(2): 437-442.

[2] FORSTER C, PIZZOLI M, SCARAMUZZA D. SVO: Fast semi-direct monocular visual odometry[C]// The Institute of Electrical and Electronic Engineers (IEEE). Proceedings of International Conference on Robotics and Automation. Hong Kong: IEEE, 2014: 15-22[2020-08-28].

[3] 张小正, 周鑫, 陈丽娟, 等. 无人机视觉着陆位姿参数估计方法[J].电光与控制, 2017(5): 26-29.

[4] 戴江鹏. 基于单目视觉的无人机位姿估计算法研究[D].北京:北京理工大学,2018.

[5] YANG T, LI G, LI J, et al. A ground-based near infrared camera array system for UAV auto-landing in GPS-denied environment[J]. Sensors, 2016, 16(9): 1393-1393.

[6] KONG W, ZHANG D, WANG X, et al. Autonomous landing of an UAV with a ground-based actuated infrared stereo vision system[C]//The Institute of Electrical and Electronic Engineers (IEEE). Proceedings of International Conference on Intelligent Robots & Systems. Tokyo: IEEE, 2013: 2963-2970[2020-08-28].

[7] YANG T, REN Q, ZHANG F B, et al. Hybrid camera array-based UAV auto-landing on moving UGV in GPS-denied environment[J]. Remote Sensing, 2018, 10(11): 1-31.

[8] LEPETIT V, MORENO-NOGUER F, FUA P. EPnP: an accurate O(n) solution to the PnP problem[J]. International Journal of Computer Vision, 2009, 81(2): 155-166.

[9] 武君, 白刚, 张彩霞. EPNP和POSIT算法在头部姿态估计上的实验比较与分析[J].北方工业大学学报, 2017, 29(2): 19-27.

[10] 邓非, 吴幼丝. 球形全景影像位姿估计的改进EPnP算法[J]. 测绘学报, 2016, 45(6): 677-684.

[11] LI J, MA X, CHEN H, et al. Real-time detection and tracking method of landmark based on UAV visual navigation[J]. Journal of Northwestern Polytechnical University, 2018, 36(2): 294-301.

[12] SHARP C S, SHAKERNIA O, SASTRYS S. A vision system for landing an unmanned aerial vehicle[C]//The Institute of Electrical and Electronic Engineers (IEEE). Proceedings of International Conference on Robotics and Automation. Seoul: IEEE, 2001(02): 1720-1727[2020-08-28].

[13] LANGE S, SUNDERHAUF N, PROTZEL P. A vision based onboard approach for landing and position control of an autonomous multirotor UAV in GPS-denied environments[C]//The Institute of Electrical and Electronic Engineers (IEEE). Proceedings of International Conference on Advanced Robotics. Munich: IEEE, 2009: 1-6[2020-08-28].

[14] REN S, HE K, GIRSHICK R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2017, 39(6): 1137-1149.

[15] REDMON J, DDIVVALA S, GIRSHICK R, et al. You only look once: unified, real-time object detection[C]//The Institute of Electrical and Electronic Engineers (IEEE). Proceedings of Computer Vision & Pattern Recognition. Las Vegas: IEEE, 2016: 779-788[2020-08-28].

[16] RONNEBERGER O, FISCHER P, BROX T. U-Net: convolutional networks for biomedical image segmentation[EB/OL].(2015-11-18)[2020-08-18].https://link.springer.com/content/pdf/10.1007/978-3-319-24574-4_28.pdf.

[17] SANDLER M, HOWARD A, ZHU M, et al. MobileNetV2: inverted residuals and linear bottlenecks[C]//The Institute of Electrical and Electronic Engineers (IEEE). Proceedings of Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 4510-4520[2020-08-28].

[18] 张嘉旭. 基于深度学习的无人机位姿视觉测量与计算方法[D]. 西安: 西安理工大学, 2019.

Study on landing attitude angle measurement algorithm of fixed wing unmanned aerial vehicle

QI Le1, YUAN Baoxi1, GUO Fengjuan2, GUO Jianxin1, XU Yue1, MI Chen1

(1. School of Information Engineering, Xijing University, Xi’an 710123, China;2. Shaanxi Key Laboratory of Integrated and Intelligent Navigation, Xi’an 710071, China)

According to the fact that there is no enough algorithm of attitude angle measurement during autonomous landing of fixed wing Unmanned Aerial Vehicle (UAV), a new attitude angle measurement method based on monocular vision is proposed. In view of the illumination imbalance, reflection and blur of cooperative target images taken in the real environment, texture enhancement and detection efficiency optimization algorithm are proposed to eliminate the influence of image degradation on detection results, so as to realize the detection scheme with robustness to illumination degradation. Experimental results show that the mean of attitude angle error is 0.39, and the number of detection frames per second reached 83.33, which can meet the requirements of UAV landing error and real time simultaneously.

fixed wing unmanned aerial vehicle; visual navigation; cooperative target detection; attitude angle measurement

P228

A

2095-4999(2022)04-0056-09

齐乐,袁宝玺,郭凤娟,等. 固定翼无人机着陆姿态角测量算法研究[J]. 导航定位学报, 2022, 10(4): 56-64.(QI Le, YUAN Baoxi, GUO Fengjuan,et al. Study on landing attitude angle measurement algorithm of fixed wing unmanned aerial vehicle[J]. Journal of Navigation and Positioning, 2022, 10(4): 56-64.)DOI:10.16547/j.cnki.10-1096.20220408.

2020-10-10

陕西省重点研发计划工业领域一般项目(2021GY-341)。

齐乐(1997—),女,河北沧州人,硕士研究生,研究方向为视觉导航、图像处理。

袁宝玺(1974—),男,甘肃定西人,博士,副教授,研究方向为视觉导航、图像处理等。