基于超分辨率与在线检测DSST的红外小目标跟踪

李 斌,李秀红,艾斯卡尔·艾木都拉

〈图像处理与仿真〉

基于超分辨率与在线检测DSST的红外小目标跟踪

李 斌,李秀红,艾斯卡尔·艾木都拉

(新疆大学 信息科学与工程学院,新疆 乌鲁木齐 830046)

红外小目标的相关研究在军事领域的制导、预警和边防间谍无人机检测中极其重要。针对红外小目标的跟踪研究,本文提出了一种基于超分辨率增强与在线检测DSST(Discriminative Scale Space Tracker)的小目标跟踪算法。首先,基于融入红外图像特征的超分辨率重建算法对原始图像进行更新,增强了弱小目标,然后,增强的图像被用作基于在线检测DSST算法的输入,得到响应映射,估计目标位置。实验结果表明,与几种最新算法相比,该算法在准确性方面表现出色。

小目标跟踪;超分辨率;DSST;在线检测

0 引言

红外复杂场景下的小目标跟踪研究的意义极其重要。首先,在军事领域的导弹防空预警、导弹精准制导和海上漂浮地雷侦查中发挥了非常重要的作用[1]。其次,现如今由于轻量化的小型无人机的普遍使用,导致存在边防间谍无人机的威胁与在敏感设施中未经授权的无人机侦查偷拍的威胁,所以远距离跟踪非法无人机至关重要。

传统的红外小目标跟踪方法主要可以分为3类:①基于模板匹配。此类算法通过框架之间的设计模板来测量相似度,以找到最相似的目标。文献[2]提出了联合概率数据关联法,通过使用联合关联概率估计目标的状态而获得的显著跟踪改进。文献[3]提出了基于贝叶斯滤波的跟踪算法,不受高斯或者线性相关的背景噪声的限制,可以用于多种状态的转换与模型测量。②基于均值漂移。此类算法利用核加权灰度直方图来表示目标并通过均值平移法找到其位置。文献[4]开发了一种在混乱环境中跟踪多个目标的算法,能够启动跟踪,解决虚假或丢失的报告以及处理相关报告集。文献[5]同时收集包含目标特征和背景噪声的帧,以一种动态编程算法最佳地检测穿过传感器视场的昏暗移动目标。③基于粒子滤波器。此类算法通过基于一组粒子计算后验概率密度来估计目标状态。文献[6]提出了一种权重选择方法,结合灰度特征和梯度特征建立了基于红外图像特征的观测模型。文献[7]提出的粒子滤波跟踪算法使用了均值漂移方法使粒子向目标区域移动,但是在稍微复杂一点的场景中就不稳定。

本文提出了一种基于超分辨率增强与在线检测DSST的小目标跟踪算法。首先,基于融入红外图像特征的超分辨率重建算法对原始图像进行更新,增强了弱小目标,随后,增强的图像被用作基于在线检测DSST算法的输入,得到响应映射,估计目标位置。

1 所提跟踪方案

本文所提出的红外小目标跟踪方案流程如图1所示。

图1 本文所提的小目标跟踪框架

1.1 基于SIFT特征的图像超分辨率处理

常用的红外图像超分辨率处理可分为单帧与多帧。单帧处理的过程不需要多帧图像,使用的场景比较多[8]。线性插值法常用于单帧处理中,可在短时间内完成超分辨率处理,但是也会遗失图像高频信号[9]。不同于单一处理图像若干特征的稀疏光流,稠密光流可以对图像的像素点进行逐一匹配,图像的稠密计算可以使得图像中的像素点的偏移量得以计算而累积为稠密光流场[10-11]。

局部特征描述子(Scale Invariant Feature Transform,SIFT)是一种稳定的局部特征[12],其对于尺度的缩放、图像的旋转以及图像亮度的转变等可以维持特征不变。可以通过计算稠密度,对全局的像素点进行SIFT特征的提取,计算其稠密度。计算全局像素点的SIFT特征而得到目标轨迹流场=(,)。

设连续的前后两帧的像素坐标为,则连续的前后两帧的特征可以表示为1()与2(),则位于坐标点的流可以表示为()=((),())。其中()表示为水平流场,()表示为垂直流场。

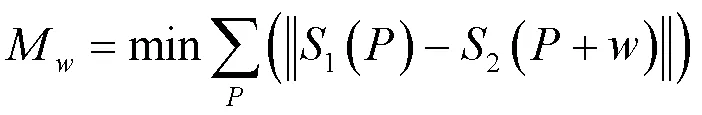

在特征匹配过程中,邻域像素计算相似度匹配,需按局部特征向量1()与2()进行,即需满足:

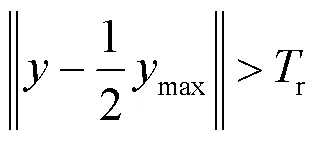

而在实际情况中,流速2()+2()为相邻帧像素速率,值不应太大,即需要满足:

此外,像素点的邻近区域内的像素具有类似的流向量,即满足:

式中:、、为参数。综上所述,特征流场的计算可以总结为:

()=()+()+() (6)

根据以上公式计算,得到对应图像之间的水平和垂直流场分别定义为H,V。

对红外图像进行稠密计算,其水平流场与垂直流场可以表示相邻图像的局部特征的变化,对比邻接的图像帧,进行高质量、高精确度的匹配。融合图像帧后可增强红外图像的分辨率。图像融合步骤如下:

1)将连续3帧序列通过双立方插值放大倍后输出:BIR1、BIR2、BIR3;

2)计算BIR1、BIR2、BIR3的特征流场,输出对应序列间的水平和垂直流场:H21、V21、H23、V23

3)将BIR1、BIR3的像素坐标映射在BIR2上对应位置,输出:BIRs1、BIRs3。

4)设(,)为BIR上的像素坐标;(,)为H21,V2上的矩阵数值的坐标;

计算:(,)=(+,+)

输出BIR1的像素映射到BIR2时对应的新坐标(,)。

5)用双线性插值法,将BIR1像素灰度值映射到新坐标(,)上,输出BIRs3,同理输出BIRs3。

6)融合BIR2与其相似图像BIRs1和BIRs3,输出BIRs2。

7)利用中值法融合BIRs2、BIRs3和BIRs2:对比BIRs2、BIRs3和BIRs2的每个像素灰度数值,取中值输出为融合结果图像。

8)循环操作:计算流场、映射与融合,直至图像收敛:

式中:BIR2(,)表示BIR2的新的像素灰度数值;BIR2(,)表示上一次迭代生成的BIR2的像素灰度数值;(>0)表示最大误差值。

图2(a1)与图2(b1)为红外原始数据图像,图2(a2)与图2(b2)为本文的超分辨率方案处理后的效果图,可以很直观地看出效果比较好。

(a1) 原始图像(a2) 处理后图像 (a1) Original image(a2) Processed image (b1) 原始图像(b2)处理后图像 (b1) Original image(b2) Processed image

1.2 DSST与PN学习

DSST是在MOSSE(Minimum Output Sum of Squared Error filter)[13]的基础上衍生而来的,基于学习获得位置的相关滤波,然后用此滤波器估计在下一帧图像中目标的坐标。DSST可以分为两个滤波器,第一个是位置滤波器,第二个是尺度滤波器。DSST利用判别相关滤波来估计坐标。

由于相似性和相关性之间的正相关关系,相关滤波是用于测量两个信号的相似性的模式。将相关滤波应用于跟踪问题是基于这样的思想,即当将手工特征过滤到高维空间中时,两个连续帧之间的两个相似对象可以高度相关。在第一帧中给出感兴趣区域作为输入,并对其进行训练以获得相应的相关滤波。余弦窗函数和快速傅里叶变换(Fast Fourier transform,FFT)通过输入信号执行,然后乘以相关滤波以定位最大响应点。最大响应点的获取过程表示如下:

式中:i是响应输出值;i是输入图像;Ä表示卷积操作;是过滤器模板。

公式(7)是一个费时的卷积过程。因此,采用FFT将卷积操作更改为点乘法运算,可以将其描述为:

()=(Ä)=()×()*(8)

式中:是傅里叶变换,“×”表示点乘法。公式可简单表述为:

=×*(9)

然后转移视觉跟踪任务以寻找最佳过滤器*:

*=/(10)

对于原始DSST,从给定的感兴趣区域(Region of interest,ROI)中提取要跟踪的特征,并对其进行训练以获得第一个输入帧的相关滤波。然后,将FFT变换的输出乘以相关滤波,以找到最大响应点。DSST的最大瓶颈在于,应不断正确更新滤波器模板,以获取每帧的最大输出响应。在没有遮挡的情况下,最大化地将位置指向正确的目标,但是当发生遮挡时,跟踪结果通常不理想,因为响应图被困在局部极值中。

文献[14]提出了PN(P-expert & N-expert)学习,通过一对“专家”来估计错误:①P专家估计错过的检测,②N专家估计错误警报。PN学习分为4个模块:P-N experts、训练样本、学习前分类器与监督学习。PN学习在红外图像的每一帧中都会对检测器进行评估。估计的误差增加了检测器的训练集,并且对检测器进行重新训练以避免将来出现这些误差。PN专家也自己犯错,但如果专家错误的可能性在一定范围内,则错误会相互补偿,从而达到学习稳定。PN学习利用有监督训练进行初始化,对每一帧红外图像都进行以下操作:①对当前帧评估检测器;②使用PN专家估计检测器错误;③通过专家输出的带标签示例更新检测器。在学习结束时获得的检测器称为最终检测器。

图3(a)所示为红外视频序列的3个帧,其被扫描网格覆盖。网格中的每个边界框都定义了一个图像块,其标签在图3(b)和图3(c)中用实心圆点表示。每个基于扫描窗口的检测器都将补丁视为独立补丁。因此,有2单个框架中可能的标签组合,其中是网格中边界框的数量。图3(b)所示为这样的标记。标签表明对象出现在单个帧中的多个位置,并且运动中没有时间上的连续性。这样的标签不太可能是正确的。另一方面,如果检测器输出图3(c)所示的结果,则标记是合理的,因为对象出现在每一帧的一个位置,并且检测到的位置会及时建立轨迹。换句话说,补丁的标签是相关的,这种属性称为结构。本文采用思想为利用数据中的结构来识别检测器错误。

PN学习中的P专家使用红外图像序列中的时间信息结构,并且假定目标沿着轨迹进行运动,且会记录目标在上一帧中的坐标,使用图像帧之间的跟踪器预测当前图像帧中小目标的位置。如果检测结果否定了当前坐标,即产生错误的否定错误,则P专家会生成肯定的示例。

PN学习中的N专家使用红外图像序列中的空间信息结构,并且估计目标大概率能出现的单个坐标位置。N专家通过计算将当前帧中检测器产生的响应与跟踪器产生的响应进行对比分析,得出最佳的响应。然后与最大置信度色标不重叠的色标被标记为负色。最可能的像素补丁区域会重新初始化为跟踪器的位置。

(a)序列(b) 标签(c) 轨迹 (a) Sequence(b) Labeling(c) Track

尽管快速DSST可以成功解决视觉跟踪问题,但在红外小目标图像中在空间上跟踪隐蔽目标的性能仍然不令人满意,当发生遮挡时,快速DSST将无法连续跟踪。这是用于估计二维图像空间中的三维位置的病态问题。物体外观的遮挡和变形通常在动态背景下发生,在动态背景下,运动目标和相机之间存在相对运动,DSST的跟踪效果在没有遮挡的情况下令人满意,而在发生遮挡时完全失去了跟踪目标。

鲁棒的跟踪方案需要在跟踪过程中发生丢失目标的现象时进行重新检测,不同于一些公开成型的跟踪器,在每一帧上进行重新检测,本文使用一个阈值r激活检测器,如果max(s)<r则激活。为了提高计算效率,本文采用PN学习作为检测器。

采用短期反遮挡策略来确定目标是否通过高斯响应图被遮挡。最大值对应的位置最大限度响应图的目标是目标的新位置。当被遮挡的目标出现时,响应图会剧烈振荡。当前帧的响应输出与响应图的最大值之间的差异可以用作标准。

1.3 在线检测DSST

本文提出的红外小目标跟踪算法改进的地方为:在DSST跟踪算法的框架加上在线检测机制,SVM(Support Vector Machine)分类器计算出置信度(响应值)最高的图,SVM可看为阈值组件。然后导入在线PN学习进行在线训练与学习,进行重检测。图4所示即为融合在线学习的DSST的框架。

相关跟踪:平移跟踪(HOG(Histogram of Oriented Gradient)特征)→尺度跟踪(21个尺度HOG特征),对于尺度跟踪的响应,如果最大响应值小于重检测阈值,跟踪失败,调用detector全图重检测。

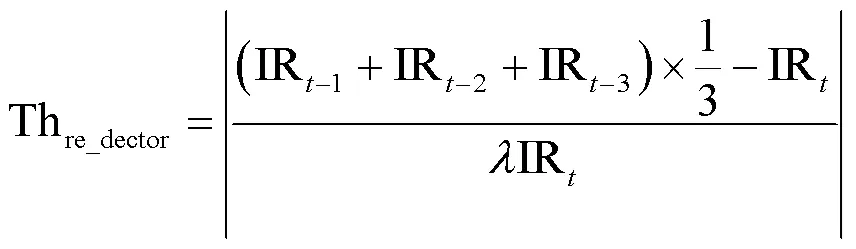

重检测阈值THre_dector从前3帧的目标响应值中计算,如式(12)所示:

式中:IR表示第帧所有候选样本中的最大响应值,IR表示相邻的前3帧最大的目标响应值的标准差。

在线检测:将历次检测到的结果resize到15×15,特征:gray特征成功跟踪到的样本为正样本,跟踪失败为负样本。全局检测,当最大响应值大于重跟踪阈值,检测成功,重新跟踪。

2 实验分析

2.1 数据集与评估指标

本文所有实验均通过Python3.5在配备Intel(R) Core(TM) i7-8700 CPU @ 3.20GHz CPU,NVIDIA GeForce GT 730和16 GB内存的计算机上执行。

本文实验采用数据集为收集于网络的视频进行标注而获得,如表1所示。在Seq.1中,云的边缘非常强,以至于昏暗目标的SNR(Signal-Noise Ratio)低于1.5。此外,目标会在背景边缘移动数十幅图像,序列长度为429帧。在Seq.2中,目标运动相对来说是不稳定的,是由固定相机拍摄的。它的大小从5×5像素到6×6像素变化。在Seq.4中,手动添加了一个小的目标,其大小设置为2×2像素。此外,目标经历杂乱的背景,并以较大的瞬时速度(即每帧8个像素)以曲线形式移动。序列包含300帧。在Seq.5中,空间背景下的暗淡目标出现在开始时的右上角,并遵循向下的对角线路径。此外,图像序列中还会出现一些假物体。该序列总长349帧。在Seq.6中,昏暗目标的性质与在Seq.5中相同。唯一的区别是Seq.4包含移动的云,其移动速度比Seq.3中的移动速度快。

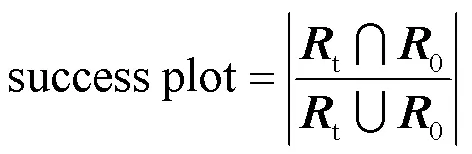

为了评估本文所提出的跟踪算法的性能,使用单次通过评估(One-Pass Evaluation,OPE)作为评估协议。OPE有两个部分,分别称为精确率图和成功率图。成功率图(success plot)是标注的跟踪框和跟踪的跟踪框之间的重叠程度,如式(13),其中t和0分别为标注的目标框和跟踪的目标框的矩阵框。

2.2 对比实验

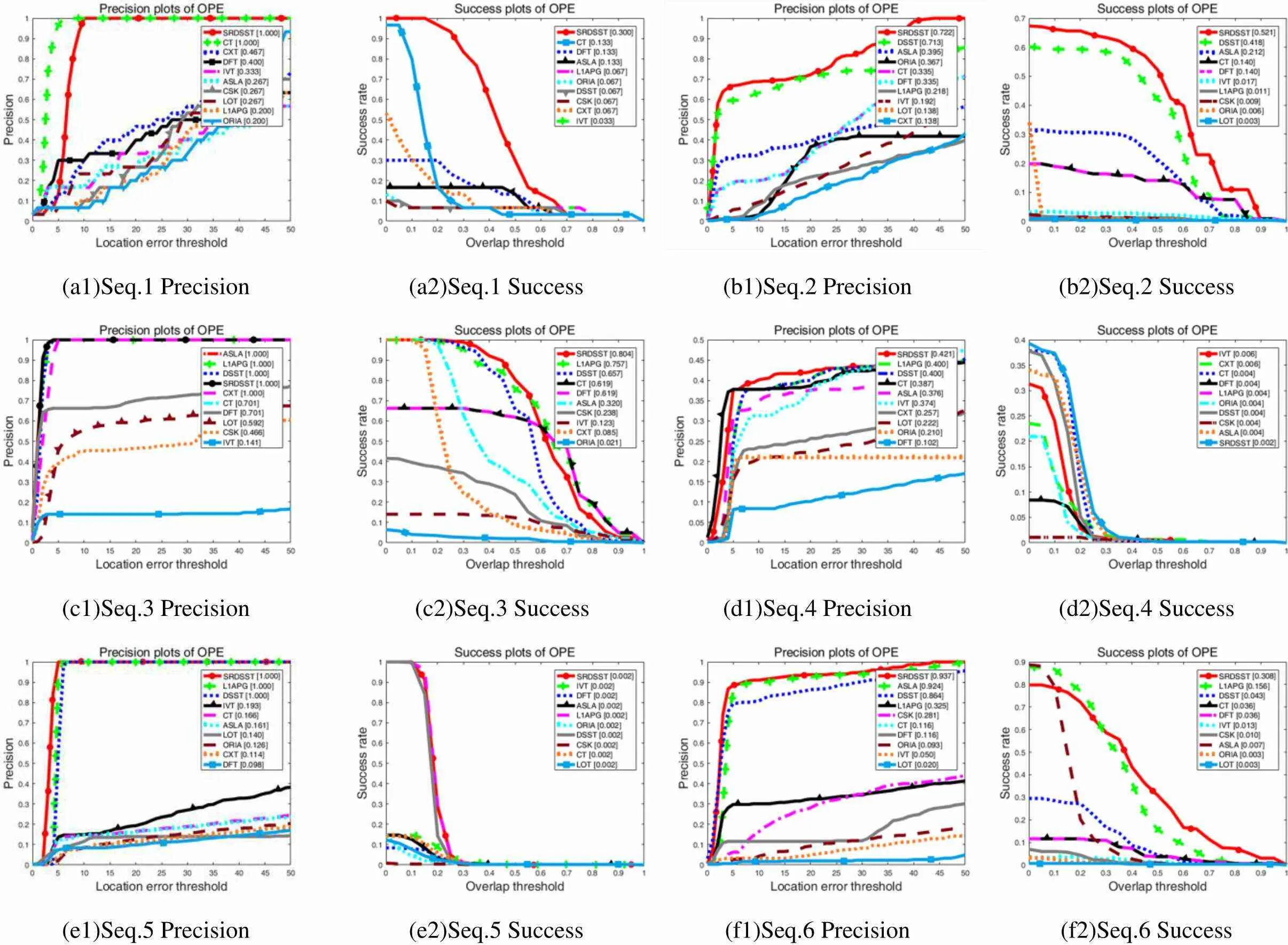

本文对比实验是在公开评测框架Visual Tracker Benchmark下完成的,本文算法与几种比较常见的算法进行比较:CT(Compressive Tracking)、IVT(Incremental Visual Tracking)、DFT(Distribution Fields for Tracking)、ASLA(AdaptiveStructuralLocalsparseAppearancemodeltracking)、L1APG(L1 tracker using Accelerated Proximal Gradient approach)、ORIA(Online Robust Image Alignment)、DSST(Discriminative Scale Space Tracking)、CSK(Circulant Structure Kernel)、LOT(Locally Orderless Tracking)。本文算法在对比实验中标注为SRDSST(Super-Resolution DSST)。

图4 融合在线学习的DSST

表1 实验数据集

图5分别显示了不同算法在红外小目标数据集上检测的实时结果,其中正红色框(箭头所指示)为本文算法的跟踪效果。图6显示了本文整理的红外小目标运动数据集中所有图像序列的精确率图和成功率图。

可以直观地从图5中看出本文所提出的基于超分辨率与在线检测DSST的红外小目标跟踪方案对于红外图像下小目标的有效跟踪,一些常见的算法都表现出目标跟踪丢失的现象。图5(a)系列与图5(c)系列直观看出CSK算法在Seq.1与Seq.6数据集中,一开始就表现出尺度估计错误且目标丢失的情况。

图5 跟踪结果

图6 精确率和成功率