任务为中心的6G网络AI架构

吴建军,邓 娟,彭程晖,王 君,杨 立,刘光毅,王 飞,何宇锋,孙万飞,艾 明,李文璟,戴翠琴,袁雁南,石 聪,许 阳,杨 旸0,张宏纲,李荣鹏

(1.华为技术有限公司 无线技术实验室,上海 201206;2.中国移动通信有限公司研究院 未来研究院,北京 100053;3.中兴通讯股份有限公司,江苏 南京 210012;4.中国电信股份有限公司研究院,广东 广州 510630;5.中信科移动通信技术股份有限公司,北京 100083;6.北京邮电大学 计算机学院,北京 100876;7.重庆邮电大学 通信学院,重庆 400065;8.维沃移动通信有限公司,北京 100083;9.北京欧珀通信有限公司,北京 100026;10.特斯联科技集团有限公司,北京 100027;11.浙江大学 电子与信息工程学院,浙江 杭州 310027)

0 引言

随着互联网兴起产生的海量数据及摩尔定律带来的计算力的突飞猛进,从4G移动互联到5G万物互联,移动通信网络的传输速率、传输时延、连接规模等关键性能指标不断提升,应用场景不断丰富。

随着5G系统全面商用,面对5G运营中出现的基站建设成本升高、网络复杂性增加等问题导致的增量难增收的窘况,电信运营商迫切需要探索合理高效的网络架构和部署方式来保证网络建设的经济性。面对5G网络复杂化、业务差异化、用户需求多样化等一系列挑战,利用人工智能(Artificial Intelligence,AI)技术进行网元智能化、网络智能化和业务智能化,是业界普遍认同的技术路径。比如在网络运维方面,利用AI的数据感知、智能分析能力,可在海量运维数据中抽取隐含的关联特征和规则,追溯根因、定位故障,进行主动式的网络运维,实现全面的网络端到端部署自动化。目前,AI的数据驱动特性、自动控制能力、各种学习方法已经被成功地用于解决通信网络中的一些问题。业界普遍认为:引入AI技术后的5G网络,将具备更广阔的覆盖范围、更大的通信容量、更小的传输时延和更多的用户连接能力,实现更加泛在、智能、安全、可信的公共移动信息基础服务能力。

5G开启的万物互联的场景连接,将千行百业接入到了移动通信网络,带来了新的场景和无处不在的数据。针对未来,6GANA等组织提出了6G网络的作用之一是基于无处不在的大数据,将AI的能力赋予各个领域的应用和场景,通过广域覆盖和场景的智能适应,创造一个“智能泛在”的世界[1-6],因此,6G网络需要构建内生的、泛在的和分布化的AI能力。值得注意的是:当前5G网络中应用AI的模式大多是基于场景驱动的“外挂式”和“叠加式”,无法较好发挥AI技术的效能。6G需在网络架构设计上支持网络内生AI,一方面根据6G网络传输与控制需求以及所需完成的任务特征进行6G网元和网络的智能化,另一方面在网络内通过统一的架构设计来提供完整的AI环境和AI服务(AI as a Service,AIaaS),提供业务所需智能[7-10]。

1 6G网络AI的背景介绍

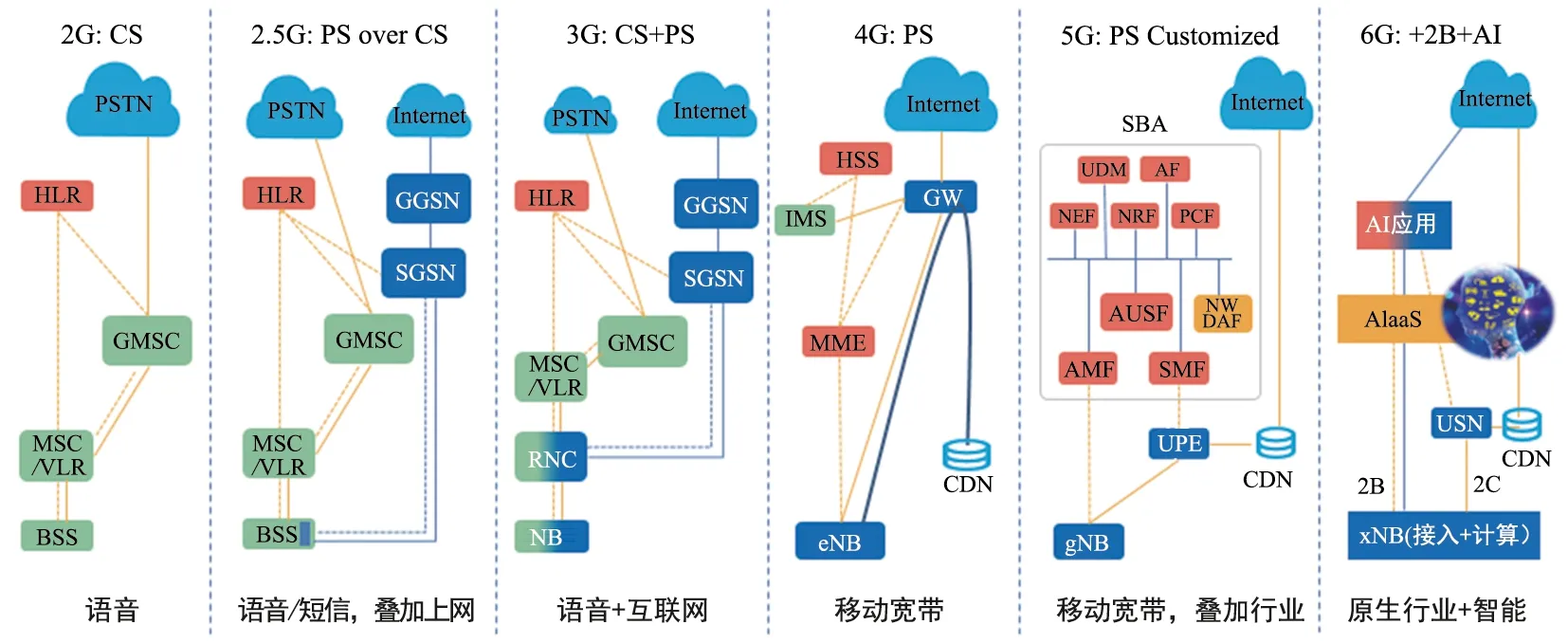

1.1 网络智能化实践启示

如图1所示,从无线网络演进历史来看,2G到5G分别提供了不同类型普惠性质的基础服务,其背后都离不开原生架构能力的支持,即通过原生设计来支持内生功能。例如2G的普惠性质基础服务是语音服务,与此匹配的2G端到端网络架构就是为语音原生设计的;到了3G和4G,普惠性质的基础服务是数据服务,但3G架构还不能完全算是原生的数据架构,更多是将数据服务叠加在传统网络基础上;4G架构则是完全基于数据服务来原生设计的,语音等传统业务都要基于基础数据服务来提供(VoLTE);5G提供的基础服务是万物互联,从URLLC、mMTC、eMBB到切片等[11-12],5G设计了很多原生的架构能力来支持,但在智能化领域,5G更多是采取如NWDAF进行功能叠加或是单独提供AI算法等外挂的方式。文献[13-14]详细阐述了5G网络中基于场景驱动的“外挂式”和“叠加式”的网络智能化实践面临诸多挑战,包括数据获取困难、数据质量难以保证、AI模型的应用效果缺乏有效的验证和保障手段等,这些因素导致了人工智能的性能和效率低于预期。面对上述挑战,6G网络需要原生智能的网络架构。

图1 无线网络架构演进历史

1.2 6G网络AI的场景需求

6G网络原生智能架构,就是要在网络内通过统一的架构设计来提供完整的AI环境和AI服务,由此引入了网络AI的理念,以明确区分现有的云AI。网络AI主要面对高实时性能、高安全隐私或低综合能耗等需求,在网络内进行AI训练、验证或推理[15],提供适应不同应用场景的智能能力;网络AI可以是云AI的有益补充[16]。

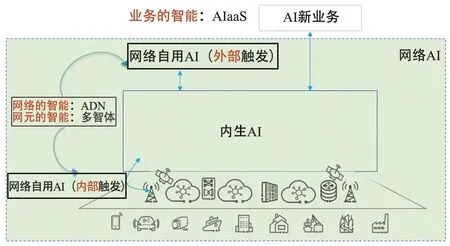

网络AI的主要场景可以分为三个类别:网元智能、网络智能和业务智能,如图2所示。其中网元智能是指网元设备的原生智能化;网络智能是指多个智体网元协同产生网络级的群体智能;业务智能是指整个无线通信系统为业务提供的智能服务,一般由外部业务触发,无线网络负责执行,其中的业务逻辑可以对无线通信系统透明。

图2 6G网络AI的场景需求

网元智能场景包括传统的无线资源管理(Radio Resource Management,RRM)、无线传输技术(Radio Transmission Technology,RTT)的智能化,以及网元本身的原生智能化,如网元智能体。网元智能可以发生在网元、终端的功能和协议栈,影响从空口物理层到高层,如RTT智能化算法主要在PHY层,RRM智能化算法主要是MAC层(如调度、MIMO配对、功率控制、MCS选择等算法)和RRC层(如切换、负载均衡等算法)。

网络智能场景主要是网络系统层面的优化场景,最为典型的场景是自动驾驶网络(Autonomous Driving Network,ADN),即通过数据与知识驱动的智能极简网络,实现网络自动、自愈、自优、自治,使能新业务并实现极致客户体验、全自动运维、高效资源和能源利用[17]。网元智能和网络智能从网络和AI关系的角度,可以认为是AI4NET(AI for Network),即使用AI来辅助通信效率、用户业务体验等的提升。

业务智能场景主要是第三方通过网络为AI提供多种支撑能力,使得AI训练/推理可以实现得更有效率、更实时,或者提升数据安全隐私保护等。例如用户可以利用6G网络的基础模型、数据集、算力、连接等服务,辅助和优化其业务的AI训练或推理,从而更高效、安全地获得期望的AI模型,例如6G网络可以为完全自动驾驶汽车提供QoS预测和保障的辅助服务,从而进一步降低交通事故的发生风险。特别注意的是,业务智能不是说6G网络要做业务本身,而是网络为业务的智能化提供更好的资源、功能或服务方面的支持。业务智能从网络和AI关系的角度,可以认为是NET4AI(Network For AI),即基于6G网络的原生AI能力辅助业务提升效率和体验。

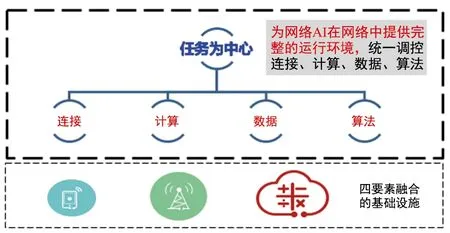

2 网络架构:从会话为中心到任务为中心

传统通信系统是以通信连接为中心的设计,其典型的应用场景是为特定终端之间、或为终端与应用服务器之间提供连接,网络在架构上为会话提供了完整的生命周期管理机制(例如端到端通信隧道的创建、修改、删除、锚点迁移等流程)和QoS保障。其主要目的是为数据传输提供连接、支持用户移动性、保证其业务体验。在资源类型上,非云化部署的设备通常采用专用算力资源,对计算和存储资源的需求量均不高。与传统通信业务不同,AI属于数据和计算密集型业务,为使6G网络具备原生的AI能力,6G网络需引入新的资源维度,包括异构的算力资源和存储资源、新的计算任务(AI相关计算)以及新的数据类型(AI计算输入输出数据)等,需要设计相应的管控机制。另一方面,6G网络将具备更全面的感知能力,包括目标检测、定位(距离和角度)、测速和3D成像,并将引入基于雷达回波的方案[18]。上述AI能力、感知能力等网络新能力将涉及到多节点场景下算力、连接、算法、数据资源的协同和调配,以共同完成某个特定的目标。本文将在6G网络层面通过多维度资源协同来完成某个特定目标的过程定义为“任务”。面向6G网络中将出现的不同类型、数量众多的任务,6G网络层面需要提供任务相关的四要素(连接、计算、数据、算法)协同完整的任务生命周期管理机制和任务QoS保障。从网络架构角度,6G将从会话为中心转为任务为中心,如图3所示。

图3 以任务为中心的架构

2.1 从会话管控到任务管控

6G网络需要原生支持网络AI和感知等新能力,无线网络架构应发生根本性改变,体现为:

变化1无线网络系统中的管控对象从“会话”转变为“任务”。

变化2调度资源从连接资源转变为连接、计算、数据和算法的四要素资源。

变化3基于任务粒度的管控,实现四要素的深度协同,提供高效的任务运行环境。

为了方便理解,对任务、任务管控进行进一步说明。

2.1.1 任务

现有的通信网络包括核心网(Core Network,CN)、承载网和无线接入网(Radio Access Network,RAN),包含的典型网元有核心网网元、接入网网元和用户设备(User Equipment,UE)等。

如上所述,任务是指网络新能力涉及到多节点场景下连接、计算、数据和算法资源的协同和调配,以共同完成某个特定的目标。本文将在6G网络层面通过多维度资源协同来完成某个特定目标的过程定义为“任务”。根据不同目的,任务分为AI推理、AI训练、计算、感知等多种类型。

根据参与任务的节点数量,又可以分为协作类和非协作类:① 单个节点执行的为非协作类任务,例如可以在UE单独执行,也可以在RAN或CN网元上单独执行。② 涉及到两个或多个节点的协作任务。例如协作节点可以是UE和RAN、UE和CN、RAN网元间、CN网元间,以及RAN和CN等。

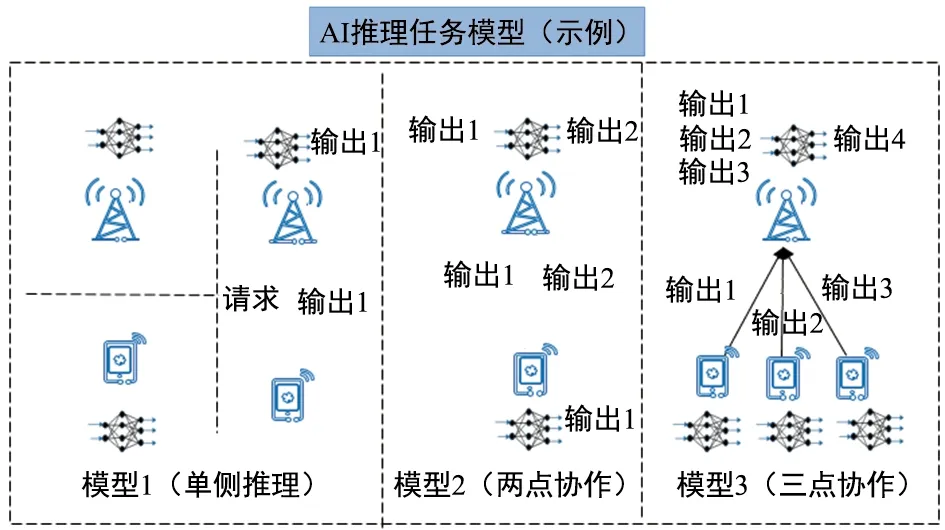

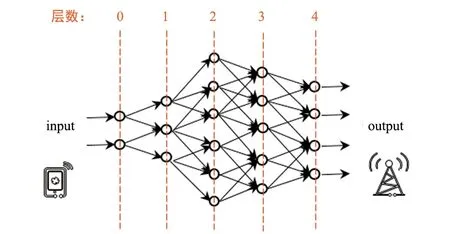

图4是以AI推理任务为例,说明单点、两点、多点任务的工作机理;AI训练任务、计算任务、感知任务等类似,不再赘述。

图4 AI推理模型示意图

图4中,模型1是指在基站或UE侧进行单点推理,或者UE请求基站侧推理;模型2对应两节点联合推理,UE先经过推理获得输出1,上传到基站侧并作为基站推理的输入,基站获得输出2并使用,或发送给UE使用;模型3对应多节点联合推理,3个UE先各自推理并分别将输出1、输出2、输出3发送给基站,基站整合后作为自身推理的输入,推理得出输出4并使用(即基站使用推理结果)。

通常来说,针对一个具体任务的执行,需要以下两个维度的协同。

四要素协同一个任务的执行可能同时需要连接、计算、数据、算法的部分或全部四要素资源。例如,在任务部署阶段提供四要素资源的配置,以及在任务执行期间进行实时的四要素资源调度。

多节点协同首先,在传统通信网络中连接相关的计算处理大多是在单个网元内实现的,网元间一般无需算力共享和算力协同。随着越来越多的AI场景伴随着大规模的AI训练、大模型的AI推理和海量的感知图像处理,这些对算力的需求量远超传统网络,通过简单的扩容逐个网元的计算能力,会导致整网部署成本过高。而分布式计算可通过算力共享的方式来协同完成任务,因此协同任务(即涉及多节点协同的任务)需要节点间算力层面的协同。其次,随着社会的进步和数据所有权意识的提升,数据隐私保护的要求也越来越高,协同任务需要多节点间进行数据层面的协同。例如UE的原始数据由于隐私原因无法上传到网络进行训练,而联邦学习通过协同学习和梯度传递的方式在一定程度上解决了该问题。最后,为了支持内生AI,模型的训练需要消耗较大的计算和存储资源,一个好的模型也需要在网络内共享以提升整网效率,协同任务需要多节点间进行AI模型层面的协同。

2.1.2 任务管控

任务管控是指伴随在整个任务运行过程中的管理和控制行为,包括任务部署阶段多节点协同的调配(例如参与节点的选择)、任务的生命周期管理和控制(例如任务的创建、修改、暂停、删除等)和四要素参数配置(例如参与节点使用的输入数据、模型参数等),以及在任务执行期间为了满足QoS要求进行的QoS监控和资源调度。其中,资源调度包括多节点协同的调配(例如协同节点的增加、删除、变更等操作)和四要素资源协同的调度(例如参与节点的四要素变更或参与节点自身的资源分配)等。

需要澄清的一个问题是:在引入任务为中心架构后,会话为中心的架构是否依然存在?一种方式是任务为中心完全融合会话为中心,即基于纯连接的会话管理流程作为任务为中心的其中一个分支运行(四要素中仅有连接需求);另一种方式是任务为中心和会话为中心的两种架构和流程同时存在,例如当发起会话管理流程时启用会话为中心架构,当发起计算、AI、感知、数据处理等6G新业务时启用任务为中心架构。两种方式对于方案的统一性、与5G纯连接系统的兼容性、标准复杂度、部署灵活性等存在不同的影响;由于篇幅有限,本文不展开讨论。

2.2 从通信QoS到任务QoS

面向各行各业对6G网络AI千差万别的需求,将用户的需求转化为网络可以理解的对网络AI服务能力的要求是亟需解决的问题。6G网络将不再只是服务于传统通信业务的管道,不同的智能应用场景对AI服务的质量将有着不同的需求,需要一套指标体系通过量化或分级的方式传达用户的需求以及网络编排控制AI各要素(包括连接、计算、数据和算法等)的综合效果。对此,本文提出AI服务质量 (Quality of AI Service,QoAIS)的概念,QoAIS是对AI服务质量进行评估和保障的一套指标体系和流程机制。

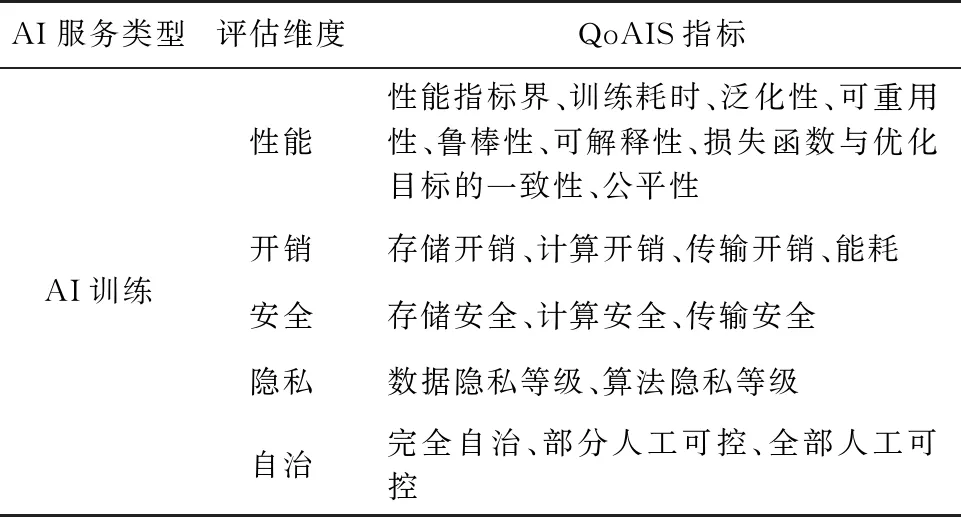

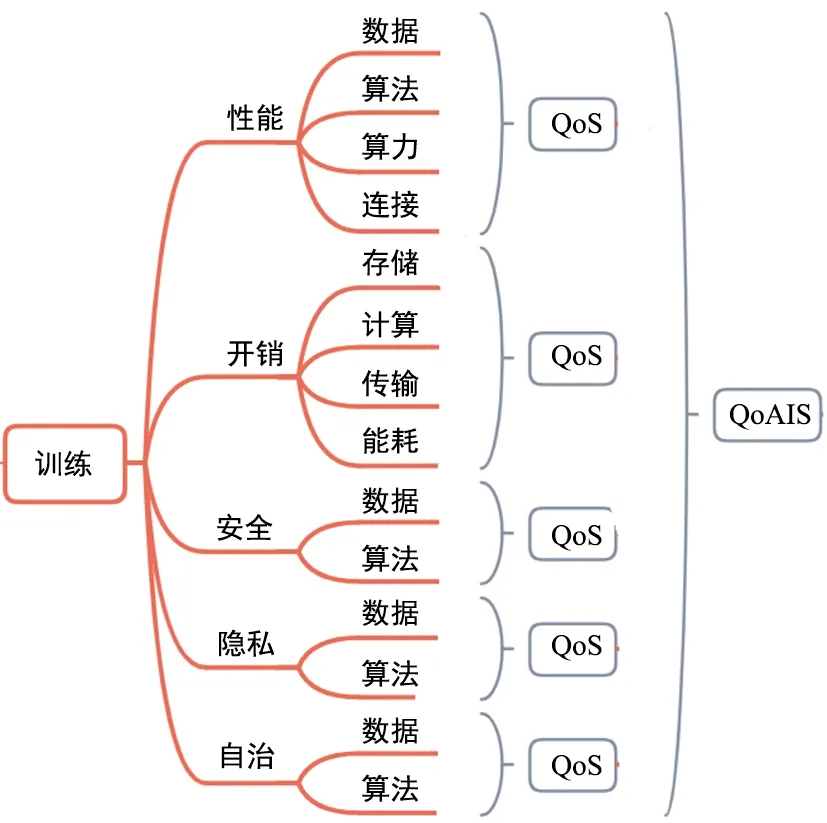

6G网络的AI服务可以分为AI数据类、AI训练类、AI推理类和AI验证类,每一类AI服务均需要一套QoAIS[19]。在具体指标体系设计上,传统通信网络的QoS主要考虑通信业务的时延和吞吐率(MBR、GBR)等与连接相关的性能指标[20-21],6G网络除了传统通信资源外,还将引入分布式异构算力资源、存储资源、数据资源、AI算法等AI服务编排的多种资源元素,因而需要从连接、算力、算法、数据等多个维度来综合评估网络内生AI的服务质量。同时,随着“碳中和”和“碳达峰”政策的实施、全球智能应用行业对数据安全性和隐私性关注程度的普遍加强,以及用户对网络自治能力需求的提升,未来性能相关指标将不再是用户关注的唯一指标,开销、安全、隐私和自治方面的需求将逐渐深化,从而成为评估服务质量的新维度。而不同行业和场景在这些新维度上的具体需求也将千差万别,需要进行量化或分级评估。因此,QoAIS指标体系从初始设计时,即需要考虑涵盖性能、开销、安全、隐私和自治等多个方面,需从内容上进行扩展[22]。

表1提供了一种针对AI训练服务的QoAIS指标设计方式。

表1 AI训练服务的QoAIS指标体系

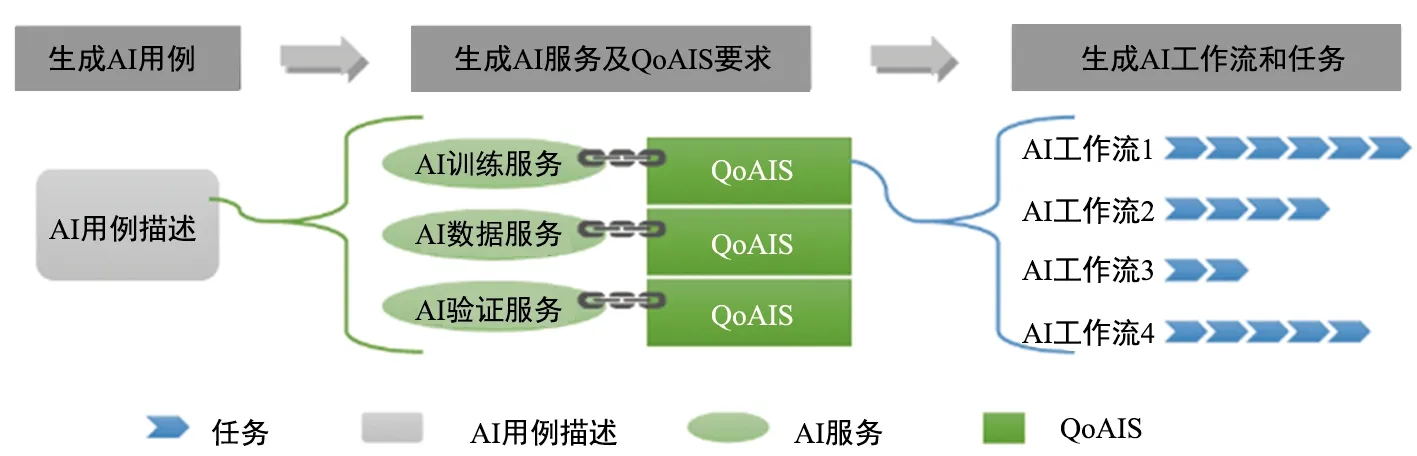

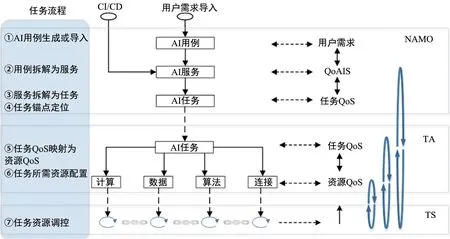

QoAIS 是网络内生AI 编排管理系统和控制功能的重要输入,管理编排系统对顶层的QoAIS进行分解和映射,生成AI任务的QoS需求,再将任务QoS映射到对连接、计算、数据和算法等多维度资源的QoS 要求上,通过管理面、控制面和用户面相关机制的设计获得持续保障。图5为AI用例、AI服务和AI任务的逻辑关系,需要注意的是,AI 用例是用户在智能应用场景下向网络提出的一次AI 服务请求,一个AI 用例可能涉及到一类或多类网络内生AI 服务(如AI 训练、验证和推理服务)的调用。

图5 AI服务(QoAIS)和AI任务(任务QoS)间的逻辑关系示例

2.3 从通信数据到任务数据

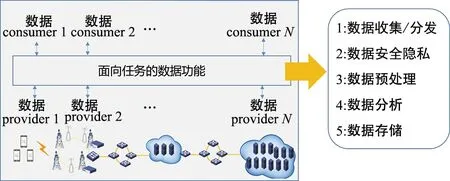

面向通信连接的管理和控制,5G网络内的通信数据主要包括通信测量数据、用户签约数据和网络管理数据等。随着6G服务从通信连接扩展至感知、计算和AI等服务,6G网络内的数据将增加感知测量数据、计算测量数据、AI数据等。面向任务采用统一方案收集、传输和提供数据是6G网络高效运转的重要基础之一。面向任务的数据功能是数据提供者和数据消费者之间的抽象功能,解耦数据消费者和物理数据提供者。特别是存在多个数据提供者或多个数据消费者时,数据功能有助于维持数据的完整性,通过重用性提高数据服务效率。6G数据功能旨在高效支持端到端的数据采集、传输、存储和共享,解决如何将数据方便、高效、安全地提供给网络内部功能或网络外部功能,在遵从隐私安全法律法规的前提下降低数据获取难度、提升数据流动效率和数据消费体验。如图6所示,根据潜在的6G数据功能范围,可将数据功能分为5个类别。

图6 面向任务的数据功能

① 数据收集/分发。为数据生产者和消费者提供基础数据收集的发布和订阅机制,提升数据收集/分发效率。

② 数据安全隐私。借助安全和隐私保护技术为用户和网络按需提供高质量的可信数据服务,既保证用户和网络的隐私保护,又保证数据的安全不可篡改及可溯源性。

③ 数据分析。叠加利用模型、算法、知识和算力等提供统计信息、预测信息、网络异常分析和优化建议等信息,提升网络内部功能和网络外部功能的数据消费体验。

④ 数据预处理。对所收集的数据进行格式转换、去噪和特征提取等通用工具类预处理满足智能应用需求。

⑤ 数据存储。存储和检索上述所收集的数据,以及为数据安全隐私、数据分析或数据预处理等相关数据处理功能提供存储支持。

2.4 需解决的技术问题

单个任务的生命周期可以分为两个阶段:任务部署和任务执行。针对这两个阶段,存在如下问题:

问题1任务部署阶段,面对无线系统中算力的固有特征(分布式、异构、海量、动态等),以及任务部署的灵活、实时等诉求,基于现有的CN、RAN、UE多级架构,如何设计出高效的任务部署系统?

问题2任务执行阶段,如何达成AI任务在无线系统中执行期间的QoS保障和效率最优?

3 任务架构和关键技术

下面将重点阐述针对上述架构变化及技术问题的架构方案,包括逻辑架构、部署架构、接口、协议和流程、任务QoS保障、AI用例自生成和任务应用实例及其对应的四要素协同等。

3.1 逻辑架构

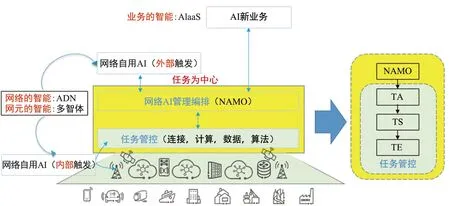

以任务为中心的架构包括两大部分:网络AI管理编排和任务管控,如图7所示。基于任务管控各阶段对实时性不同要求、任务管控范围等因素的考虑,本文新引入网络AI管理编排(Network AI Management & Orchestration,NAMO),来完成从AI业务到任务的分解、映射和AI业务流编排,NAMO通常是非实时的,一般部署在管理域;任务管控则是在控制层引入任务锚点功能(Task Anchor,TA)、任务调度功能(Task Scheduler,TS)、任务执行功能(Task Executer,TE),对任务进行分层的控制,以在任务范围和任务实时调度之间寻求平衡。

图7 以任务为中心的逻辑架构

仅通过管理域的NAMO对任务进行管控,存在如下问题:

① NAMO无法直接管理UE,涉及UE的任务需通过应用层来部署,网络无法感知,因此也无法实现四要素协同来管控和保障任务QoS。

② NAMO信令时延较大(一般是分钟级别),导致任务管控不及时,难以满足严格的任务QoS保障要求。

③ NAMO管理的节点多,如果进行高度集中的任务管控,信令消耗大,容易成为瓶颈。

因此,本文引入一个任务锚点TA来负责任务的生命周期管控;该节点部署在控制面,能够保证信令的实时快速传输(毫秒级别),使得任务控制更为实时和高效。在任务范围较大的场景,TA部署位置可能较高(例如部署在核心网)。TS的部署位置取决于四要素资源控制的实时性需求,比如控制连接资源的TS部分需要部署在靠近TE的位置,以便更实时地感知连接资源状态,以及进行实时QoS质量监控和资源调整。

基于上述的TA、TS、TE三级架构,下面分别阐述每个逻辑功能的特性。

任务锚点功能(TA)TA负责任务的生命周期管理,基于任务QoS需求完成任务部署、启动、删除、修改、监控等,包括调控四要素资源来进行任务的QoS保障。

任务调度功能(TS)TS负责任务的控制,在任务实例的部署过程中,TS会建立并维护任务相关的上下文信息,从而对任务进行控制。针对任务控制功能,TS主要有三大核心特性:其一,TS需要接受TA的管理控制。TS不能作为网络架构外的功能独立存在,需要由TA来管理控制。其二,TS负责任务执行的实时控制,实现通算深度融合。TS实时感知网络环境的变化,如终端切换、链路状态变化等,通过自身或者通知TA来实时调整任务配置,保障任务的顺利执行和QoS要求。其三,TS负责任务相关TE间资源的调度。比如,任务执行是一个过程,期间对于算力的需求是不断变化的,需要TS进行实时的算力调度。

任务执行功能(TE)TE负责任务的具体执行,并进行业务逻辑上的数据交互。同一个服务的工作流可能被实例化为多个任务,部署在多个TE间执行,因此TE间存在数据的交互。

3.2 部署架构

TA对TE的管理需要具备实时、灵活等要求,在RAN域内部署RAN TA实现对RAN TE的管理更为合理,同理CN TA对CN TE类似。这是因为TE的状态是实时变化的(例如 CPU负载、内存、电量、UE的信道状况等),TA/TS的就近部署能够带来更少的管理时延;此外,根据3GPP的设计逻辑,CN和RAN需要尽量解耦。例如 RAN RRM和RTT优化不应对CN感知;反之若由CN TA来管理RAN TE并执行RAN任务,会导致业务逻辑强耦合。因此本文建议分别在CN域和RAN域都独立部署TA/TS,达到实时管理和业务解耦的目的。

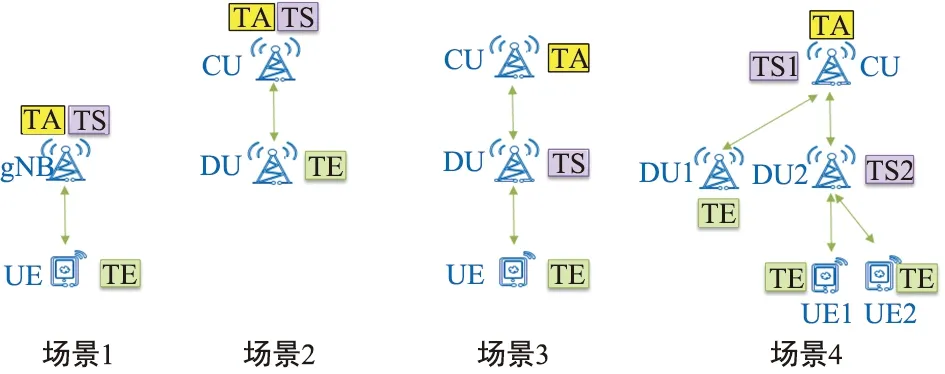

以基站和终端进行联邦学习为例,下面详细说明TA、TS和TE如何部署。由于6G架构未定,本文以5G RAN架构为例进行说明,如图8所示。

图8 以任务为中心的部署架构-站内任务协同

场景1:gNB+UE场景其中gNB同时是TA和TS,UE是TE;此时UE是算力提供方和任务执行方,接受gNB的任务管理和任务四要素调度(例如 UE侧与基站的连接建立、空口资源的实时调度,以及AI模型的分配和实时调整等)。

场景2:CU+DU场景其中CU同时是TA和TS,DU是TE;此时DU是算力提供方和任务执行方。

场景3:CU+DU+UE场景其中CU是TA、DU是TS、UE是TE,此时UE是算力提供方和任务执行方,CU是任务管理者,DU感知CU给UE分配的任务,并进行四要素资源调度和任务实时QoS保障。在该场景中,TA和TS是分开部署的,TS部署比TA位置更低,因此能够更实时感知TE的连接、算力、模型等状态,从而更为实时监控任务QoS和快速调整四要素资源。

场景4:复杂任务场景上述三个场景都是对应一个简单任务,仅包括一个TA、TS和TE;对于计算量更大的任务,仅有一个TE是不够的,因此需要多个TE共同参与同一个任务。针对本场景,CU是TA,在接受一个大任务后,将部分任务分给DU1进行处理(此时DU1是TE,CU还是该TE的TS),并将剩余任务交给DU2下的UE1和UE2处理(DU2是该子任务的TS,UE1和UE2是对应TE)。

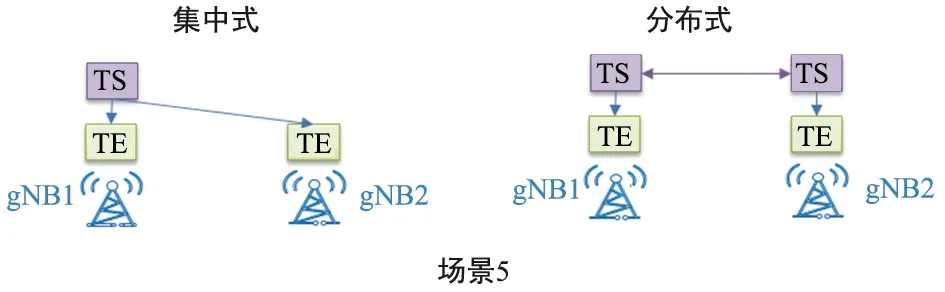

场景5:跨站协同场景图8所示场景是针对在一个基站内进行任务执行的,场景5则重点关注基站间联合进行联邦学习。为简单起见、本文以两个基站为例进行说明。如图9所示,由于在无线通信系统中,基站与基站之间的拓扑是对等的,因此可以采用集中式或分布式方案来实施任务协同。其中分布式方案是指每个基站既是TE、又是TS,两个TS之间通过协商的方式来协同算力分配或模型更改,此时两个基站是对等的,没有决策者和决策执行者的区分;而集中式是指在两个基站间选择一个节点作为逻辑的TS,并对两个站的TE资源进行调度(连接优化、算力调度、模型变更、数据配置等),此时两个基站是不对等的,其中一个是资源调度的决策者,另一个是决策执行者,执行者本身针对该任务没有资源调度的决策功能,但当其内部存在多个任务时,需要考虑任务间资源调度的需求。

图9 以任务为中心的部署架构-站间任务协同

从上面例子可以看出,TA、TS和TE仅是逻辑功能,这些功能根据不同场景可以部署于同一逻辑节点或不同逻辑节点;从逻辑节点来看,单个节点可以同时具备多个逻辑功能(如TA、TS、TE的任意组合)。

3.3 接口、协议和流程

本节分为接口和协议栈、任务流程两个部分。

3.3.1 接口和协议栈

无线系统中的现有网元都具备一定计算能力,在考虑TA和TS的部署位置时,需要考虑网络的拓扑结构,以及CN网元、RAN网元、UE侧算力分布的特点,以便充分并高效地利用分布式算力。TA或TS是较为集中的控制TE的功能实体,适合部署在CU或AMF等类似网元上;而其他RAN网元(如DU、CU-UP等)、CN网元(如UPF、SMF等)和UE作为TE进行部署。

基于上述部署假设,TA/TS对TE的管控涉及到的接口有:① 对RAN TE的管理,重用现有CU和DU间的F1接口、CU-CP和CU-UP间的E1接口;② 对UE TE的管理,包括Uu口和NAS接口,可以重用RRC或NAS信令;③ 对CN TE的管理,重用现有CN网元间的SBA接口并新增信令。此外,若要支持TA/TS间任务协同,则需影响:① RAN TA/TS间的站间接口,如Xn接口;② RAN TA和CN TA间接口,如Ng接口;③ CN TA间接口。

3.3.2 任务流程

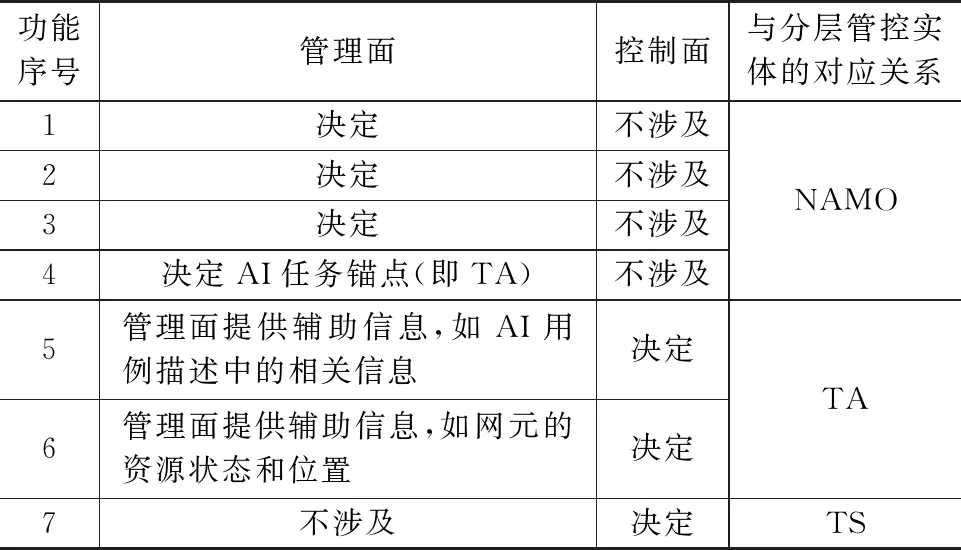

从整个端到端流程来看,NAMO接收外部服务请求后,将对应AI业务提交给TA来完成执行,AI服务实施的整个端到端流程包括如下功能:

① 生成或导入AI用例;

② 将用例分解为一个或多个AI服务;

③ 将AI服务分解为一个或多个AI任务(AI Task,AIT),同时将AI服务对应的QoAIS分解为AI任务的QoS;

④ 决定AIT的锚点位置;

⑤ 将任务QoS分解为资源QoS需求,明确AIT所需四要素资源的需求,包括连接、计算、数据和算法/模型;

⑥ 决定并配置任务所需四要素资源,包括节点选择(选择参与计算的节点、提供数据的节点、提供算法/模型的节点)、建立节点间的连接,或更新上述配置;

⑦ 在选择参与的节点范围内,实时决定并调整计算的分配、优化通信连接质量、决定并采集处理所需数据,以及决定并更换或优化算法模型,以保证任务QoS的达成,从而保证QoAIS的达成。

如上所述,考虑管理面实时性较差,获取网络信息范围广,但粒度粗;控制面实时性强,可获取较精准的信息,但数据范围比较局限;另外,管理面无法获得空口链路和终端侧资源状态的实时信息。因此,部分功能适合在管理面或控制面上实施,另一部分功能可通过管理面和控制面的协同达到更好的效果,具体功能与管理面和控制面的映射关系如表2所示。

表2 任务管理和任务控制的功能划分

另一种场景是由控制面生成的网络AI能力需求,如用户通过控制信令向网络提交的AI服务请求。针对这种场景的端到端流程需要进一步分析,比如一种可能的方式是TA首先判断该需求是一个AI服务需求,还是AI任务需求。若为前者,则交由NAMO执行;若为后者,则TA处理。

3.4 任务QoS保障

如前文所述,6G网络AI需要设计一套评估和保障AI服务质量的指标体系和流程机制—QoAIS。传统的通信QoS包括时延、可靠性、速率、优先级等指标,由CN网元根据IP五元组映射获得每个数据包对应的QoS flow及QoS指标,进而传递给RAN,并由RAN进行相应的数据无线承载映射和空口资源调度来同时保证不同业务和数据包的通信QoS。这种QoS机制仍存在业务区分颗粒度较粗、优化调整周期较长无法较好满足边缘业务的实时性要求,以及空口资源配置无法灵活适配网络与业务的实时动态变化、指标体系无法适用于AI业务等弊端,因此需要重新设计新的指标体系以及生成和保障机制。

如前文所述,QoAIS是6G网络AI编排管理系统和控制功能的重要输入,网络AI管理编排系统需要对顶层的QoAIS进行分解,再映射到对连接、计算、数据和算法等各方面的QoS要求上,此过程与三层管控功能实体的逻辑关系如图10所示。

图10 以任务为中心的QoS保障

为保障QoAIS的达成,上述分层管控逻辑架构通过“三层闭环”进行实施。TS层通过实时监测和优化四要素资源,在TA的资源配置范围内,保证任务QoS的达成;当TS层无法提供任务QoS保证时,TA层对总体资源配置进行更改,如调整参与任务的网络节点、更换模型仓库或数据仓库;当TA层无法提供任务QoS保证时,交由NAMO进行优化,NAMO可通过更改AI任务的锚点位置,也可以对AI服务与AI任务的映射进行重新分解。

为保障QoAIS的达成,上述分层管控逻辑架构通过“三层闭环”进行实施。TS层通过实时监测和优化四要素资源,在TA的资源配置范围内,保证任务QoS的达成;当TS层无法提供任务QoS保证时,TA层对总体资源配置进行更改,如调整参与任务的网络节点、更换模型仓库或数据仓库;当TA层无法提供任务QoS保证时,交由NAMO进行优化,NAMO可通过更改AI任务的锚点位置,也可以对AI服务与AI任务的映射进行重新分解。

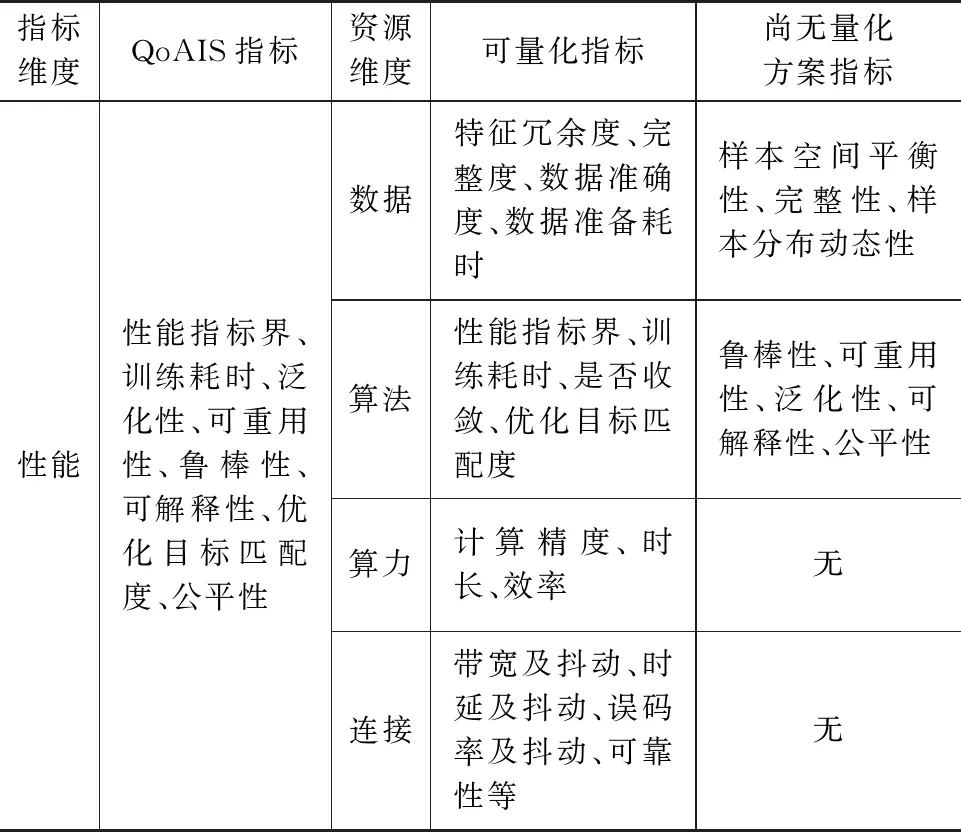

图11展示了QoAIS各指标维度和各资源维度上QoS之间的映射关系。AI服务的QoAIS指标拆解到任务及各指标维度上的QoAIS指标,再进一步映射到各资源维度上的QoS指标,由管理面、各资源维度的控制面和用户面机制进行保障。

图11 QoAIS指标分解到各资源维度上的QoS指标

图11中各资源维度上QoS指标可分为适合量化评估的指标(如各类资源开销)和适合分级评估的指标(如安全等级、隐私等级和自治等级)。在前一类指标中,有部分指标的量化方案已成熟或较容易制定(如训练耗时、算法性能界、计算精度、各类资源开销等),部分指标目前尚无定量评估方法(如模型的鲁棒性、可重用性、泛化性和可解释性等),如表3所示。因此,如何在起始阶段设计出足够开放包容的网络架构,以便后续逐步引入上述指标的成熟量化技术,是需要思考和研究的问题。

表3 AI训练服务性能QoAIS到各资源维度的映射

3.5 AI用例自生成

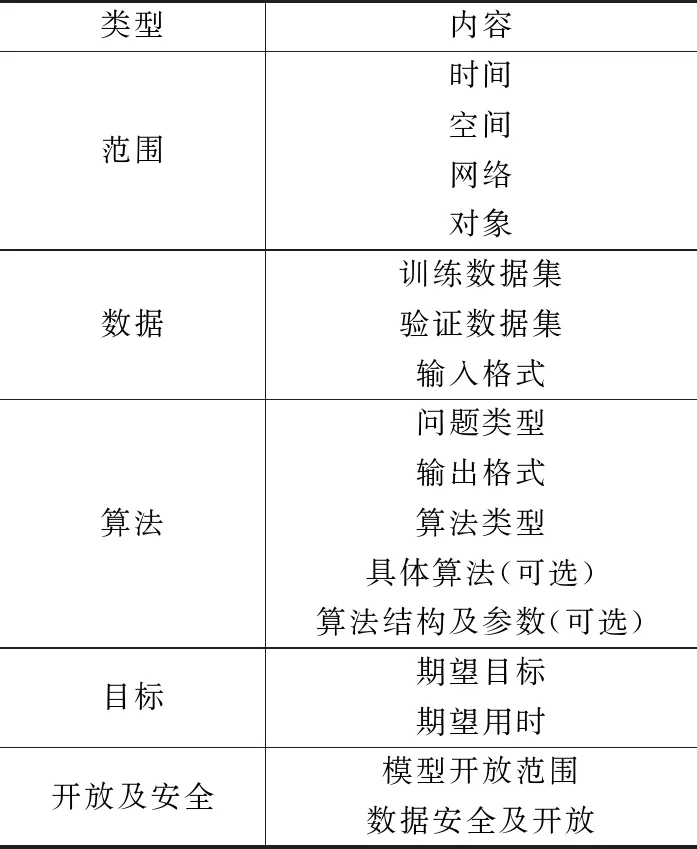

如上文所述,任务及QoAIS均与AI用例表示的用户需求有着密切联系。为了全方位地表征各场景细致的差异,精准适应场景对网络能力和服务的需求,本文提出AI用例自生成的方式,从范围、数据、目标、开放等多维度表征用户AI用例需求。需要解释的是,AI用例是用户在智能应用场景下向网络提出的一次AI服务请求,一个AI用例可能涉及到一类或多类网络内生AI服务(如AI训练、验证和推理服务)的调用。

AI用例自生成的方式可以是网络自身根据数据分析推演或外部导入,生成关于AI用例描述(AI Use case Description,AIUD)。通过AI 用例的管理将AI 用例部署到网络中,网络根据AI 用例的描述按需调配网络元素(包括连接、计算、数据、算法等)以满足该用例的性能需求。除此之外,与通信感知技术的结合,网络可以做到感知-数据分析-用例生成-QoAIS保障-任务管控执行的闭环处理,具备自主化的智能能力。

AI用例自生成的关键是AI用例描述,AI用例描述承载了用户提出AI服务请求的相关信息。由于场景与需求的差异,AI用例描述的部分内容可能是通用性的内容,部分内容可能是差异化的可选内容。根据目前的研究,经过对需求的分类,提出一种AI用例描述的方式,如表4所示。

表4 AIUD的组成

表4中,范围指的是使用数据的范围,包括使用数据的起始时间范围、地理空间范围、网络空间范围(如网元、网络域等)以及使用数据的对象(如用户组、功能等)。数据类型考虑了训练数据集和验证数据集,可以表示用例两类数据集数据量、数据来源以及各自的占比。算法中对问题类型进行了归类,如规则类、预测类、决策类等;算法类型则表示监督/非监督、强化学习等的机器学习算法类型。在此处列举了两个可选的内容,包括具体算法,如KNN、LSTM等,以及算法结构及参数,如深度神经网络层数、每层节点数等。此两项可选内容对于网络专家来说可能是更有益处的,可以更好地表达需求,但是对于普通用户,并不具备表达此类需求的能力,因此作为可选内容。目标则是期望用例达到的目标及训练的时长。开放和安全方面,对模型使用开放的范围(如用户组)、数据的安全等级及开放范围进行了规范。

目前AIUD的组成内容研究还比较初步,不够完备。随着研究的深入,还有较大的优化空间,尤其是对各类用例需求研究后的可选内容,可以预见将十分丰富。此项工作后续也将是本文未来研究的一项重要内容。

3.6 任务应用实例

一般而言,高性能同时伴随着高消耗,因此这里的四要素协同是指网络侧如何在更高性能和更少资源消耗之间进行折中?下面用两个具体的例子来说明针对网络中的任务,如何协同四要素资源,以及协同带来的有益效果。

第一个例子是基站和UE进行AI联合推理任务,一个大AI模型被拆分为两部分,前半段推理任务在UE执行,执行完成后输出中间output并通过空口上报给基站侧,基站将UE上报的中间output作为输入,再执行后半段推理任务。网络侧通过调整AI模型的切割点,从而控制UE和基站分别执行的神经网络规模,进而控制UE和基站的计算量。图12为AI联合推理任务的分割点调整示意图。

图12 联合推理任务的分割点调整

例如,当UE电池电量不足时,网络可将切割点往前调整,从而减少UE计算量及电池消耗。此外,网络侧也可以根据UE网络信号的好坏来调整AI模型的切割点,例如当UE处于网络边缘时,由于数传速率低,此时可将切割点调整为中间output数量少的位置,从而减少UE侧上报量。

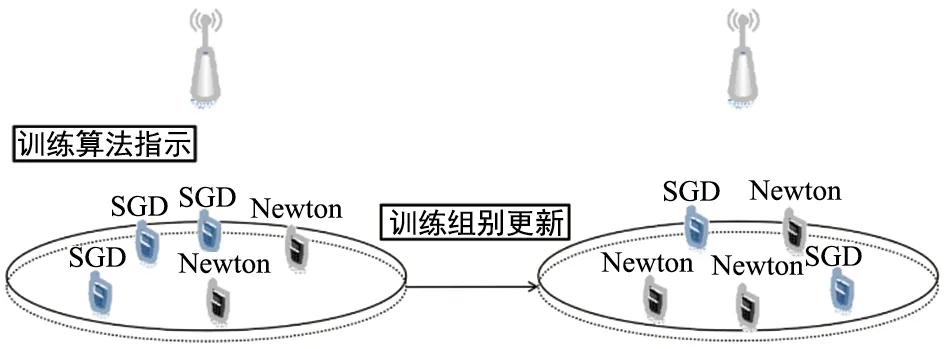

第二个例子是终端与基站协作进行分布式AI模型训练,当前,业界已提出较多分布式AI模型训练的技术框架,比如(分层)联邦学习[23]、群学习[23]、多智能体学习[25]、基于模型分割的学习[26-27]等。在空口应用这些训练框架,训练过程会产生大量中间计算结果,需频繁占用空口无线资源进行传输,训练节点数量、各训练节点的计算时延、传输的时延和误码率情况会对训练结果产生影响。为了在保证模型收敛的同时,提高空口无线资源的利用率,引入效率更高的高阶模型学习算法是一种值得考虑的思路[28-30]。由于不同阶数(零阶、一阶随机梯度下降、二阶牛顿方法等)的模型学习算法在训练速度和资源开销上各有优劣势,可以考虑根据无线信道状态动态调整学习算法,即多种学习算法间的动态转换机制,图13展示了为引入这种动态转换机制设计的功能交互。

图13 多种学习算法动态转换原理示意图

上述新技术需要在空口引入针对AI连接的控制机制和数据传输协议,相应的逻辑功能分别用Dtrain_C和Dtrain_U来表示。其中,Dtrain_C是负责控制终端与基站协作进行AI模型训练的控制功能,该实体根据网络变化,动态调整参与分布式训练终端采用的模型学习算法。Dtrain_U是负责终端与基站协作进行AI模型训练的业务面功能实体,其包含有在基站与终端间传输模型参数、梯度或梯度范数等信息所需的专用协议栈。

上述示例仅描述了算法和连接的协同,例如通过调整AI模型的切割点来控制UE上报量,以及通过调整AI模型的训练算法来提高空口无线资源的利用率。更多的连接、计算、数据和算法之间的协同,有待于后续进一步的研究。

4 结束语

本文针对6G智能普惠等新业务需求,提出一种任务为中心的网络内生AI架构,通过在无线通信系统中原生集成和融合四要素协同能力,并在网络层面以任务的形式提供新业务服务;通过给移动网络带来新的量纲(从连接服务的单量纲,到以任务的形式封装和提供连接、计算、数据、算法的多量纲),保证计算类如感知、AI业务的SLA等,进一步拓展6G网络的应用场景、充实无线网络价值。6G应在5G基础上全面支持整个世界的数字化,并通过内生AI的网络架构设计,实现智慧的泛在可得,全面赋能万事万物。为了实现“智能泛在”的愿景,本文认为6G需要提供智能普惠的基础服务,关键是在网络架构层面设计相应的原生能力,即6G架构层面的原生智能能力。需要特别说明的是,本文中的多数技术方案和观点是经过6GANA组织的充分讨论,最终达成的业界共识。

虽然业界已就6G原生网络AI达成初步共识,但如何高效地支持和可标准化方面还有待于进一步研究和讨论,例如本文提出的QoAIS保障、AI用例自生成以及四要素如何高效协同将是未来深入研究的方向之一。