AI手语主播的技术可供性:代偿性机制下认知重构的发展版图

喻国明 傅海鑫

【内容摘要】本文以听觉障碍在AI技术的框架内的解决方案为例,探讨了未来传媒发展的“聚合”逻辑。首先,探讨了AI手语主播的技术可供性,阐释了人的多感官认知系统与认知障碍的弥补代偿机制下认知重构的发展版图;其次,考察了AI手语主播的技术迭代的演进逻辑,并论证了AI手语直播在听觉认知弥合的未来发展中的升级版图。指出,传统媒介对个体的赋权总是以分割感官为前提的,个体很难在媒介世界中获得如同真实个体般的全感官体验,无法实现人的“感觉总体”回归 。但是在全要素整合的AI互联网系统中,人类将在媒介中得到全感官复制的体验,感受到 “镜像”般的数字孪生世界。

【关键词】媒介;无障碍信息传播;技术可供性;AI手语主播

传播场域如今面临巨大变局,唯有洞见传播的核心概念“媒介”之内核,厘清媒介技术演化的中心逻辑,才能准确定位传播的其他问题。

在麦克卢汉的“延伸观”及莱文森的“补偿观”中,均显示了媒介观中最核心的观点,即认可媒介的人本主义,强调媒介演进的逻辑起点是人类本身。如彼得斯所言,媒介技术的发明与应用之动力来源都是人类对自我与他人、私人与公共、内心思想与外在语词之间的“交流”的渴望。①以人类视角反观媒介演进史,可以发现它实际是一段人类实践半径不断扩大的历史。②把握人类自由度的拓展之势,即是把握了媒介技术演进的内在规律。这其中当然也包括媒介技术的进化史,实际上也是一部对于人的感官通路障碍不断打通的历史。

2022年2月4日,由“百度智能云曦灵”数字人平台联合央视新闻打造的首个AI手语主播在冬奥会正式上岗,在冬奥会新闻播报、赛事直播和现场采访中,为听障人士送上实时手语翻译服务,AI手语主播以其流畅的手语以及凝练的动作为广大听障人士提供了跨越听觉的认知体验,让听障人士可以快捷获取赛事资讯,感受赛事精彩。③作为AI虚拟主播的一种,AI手语主播通过视觉方式模拟真实的手语者,帮助广大听障人士了解国家政策、获取知识信息、进行情感娱乐等。这体现了技术对于无障碍传播的推动,也彰显了技术对于人文的关怀和对社会和谐的促进。

作为2022年北京冬奥会信息无障碍传播的一部分,AI手语主播的出现补足了听障人士对体育赛事和新闻信息的“听觉”感官,通过实时演绎的手语动作、表情和唇语,从而在视觉上弥补了听障人士在听觉方面的认知缺陷。从信息无障碍传播的角度来看,其强调用技术的方式弥合残障人士与健全人之间的認知鸿沟,用技术对感官的替代达到认知要素的补足。④而AI手语主播所展现的AI对听觉感官的弥补与多感官信息的弥合,让听障人士信息无障碍传播有了进一步发展。

按照人文主义的观点,听障人士与健全人一样是具有信息消费的天然权利的,而其权利必须通过媒介技术之于接收能力的改善才能够真正实现。由于听觉的缺失,听障人士认识能力和反应能力相比于健全人之间具有较强认知差异。而能够为人类所使用和不断迭代的技术就成为了弥合残障人士与健全人之间的认知鸿沟的重要帮手。因此,想要了解AI是如何对认知鸿沟的弥合作用则首先应从人的认知过程和感官系统出发,了解正常人如何通过包括听觉在内的感官系统的各个要素完成认知过程以及听觉缺失下人对感官的注意力转移和代偿。

一、人的多感官认知系统与认知障碍的弥补代偿机制

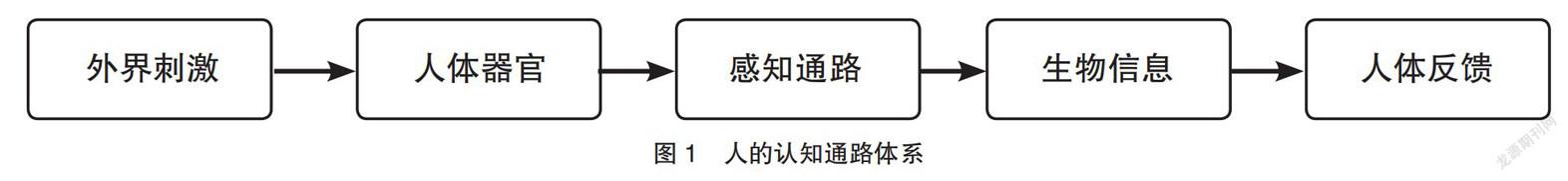

在人的认知过程中,人的器官接收由外界的复杂信息经由人体感官通路转译并形成生物信息,再根据生物信息产生的刺激进行对信息的反馈。⑤以处在认知过程中的儿童为例,儿童通常会先采取“察看”的方式接收视觉信息,了解事物的外表包括颜色、状态等,而后采取触摸、嗅闻、听、尝的方式来对事物施加刺激并认识事物的信息反馈并最终形成对事物的认知,⑥最终,儿童会根据他们多次对话、多种感官所得到的信息来综合认知所接触到的事物。人的器官是人接收信息的重要媒介,通过人体的器官将所接收到的感觉转化为人体可识别的生物信息。而在这整个的认知到反馈的过程中,人所接收的信息是综合的且多元的系统整合的产物(见图1)。

在多感官的信息接收系统中,听觉是其中一个重要的感知分支,人利用耳朵为主要的感知器官接受听觉信息。国内针对听觉的研究提出,人在“听”的过程中,“听觉信息的感觉识别和登记主要是在听觉网络(以颞叶为核心)完成,反应选择则需要认知控制网络(以背外侧前额叶为核心)参与,而反应准备和执行则是运动网络(以中央后回和辅助运动区为核心)完成”,⑦换言之,听觉可以感知声音的音律、音色、响度、节奏的变化,并将这些复杂的音频信息经由大脑处理后形成人的完整听觉感知。在听觉的支持下,人可以能够完成接收音频内容、感知空间方位、感受语言情感与节奏。⑧听障人士由于听力信息的缺失导致了对于音频信息所包含的认知要素感知能力一并缺失,这也就形成了听障人士与健全人之间的认知鸿沟。

而在人的认知过程中,除了对信息的接收过程,还有对情绪的感知过程。情绪的存在是人与人之间形成沟通、共情并建立良好沟通渠道的重要前提,听觉是让人感知情绪的主要通路,是除了图画(视觉)、动作(触觉)以外的重要情感感知来源。根据研究,人的视觉与听觉具有相同的多感觉皮层,这代表着视觉和听觉在情感认知上具有部分的相通性,但单独使用视觉或听觉时或会导致情感感知上的残缺。⑨听觉为语言文字以音频的方式提供了可以明确感知的情绪要素,不同的音律、节奏下能够提供不同的情绪认知。因此,听障人士对听觉的缺失势必会造成他们在情绪感知上的缺失,至少是不充分。

健全人在认知的过程中会将人的注意力进行均衡分配,以达到在不同的场景下根据人的需要感知场景中的敏感信息。当人失去听觉时,会把原本用于听觉的注意力分配至其他的感官上,从而迫使个体加强其他类型的感知以达到感知弥补的作用,⑩其在外在表征上则体现为听障人士对视觉、触觉等感觉的敏感。对听障人士来说,他们需要一个可以提供多感官认知的中介来替代失去听力情况下的信息接收和语言表达能力。综合对比视觉、触觉、味觉等感官信息接收能力,作为接收信息最充裕的视觉便成为了替代听觉的最优感知路径。

因此,应用于听障人士的手语便从人可视的肢体动作上,以视觉感知为补偿性通路为听障人士构建补偿听觉缺失的沟通符号。基于这个路径思维,服务于听障人士的软件辅助功能或是硬件辅助设备也大多从视觉刺激的角度出发进行开发,将文字、语言转化为听障人士可识别的视觉信息。AI手语主播亦是从视觉的角度出发,通过完善的人物建模和流畅的手语动作达到辅助无障碍信息传播的目的,从而通过AI手语主播在听障人士与媒体信息之间建立沟通的桥梁。

但是,对于AI手语主播而言,AI技术实际上可以从技术的诸多可供性上为人的听觉沟通的重建建立更多基于AI的感官通路的合成,以便超越原有人工手语的单向度连接的局限。概言之,AI参与下的手语虚拟主播从技术可供性上是能够在视觉感知通路的基础上为听障人士提供更多认知信息连接的可能性的。

二、AI手语主播技术迭代的演进逻辑

AI手语主播依托于AI技术构建手语传播通路,其发源于早期“手语虚拟主播”的概念。在2002年,有学者针对手语虚拟主播进行了阐述,提出了手语虚拟主播的概念,在该研究所提及的手语虚拟主播是基于时下虚拟主播的既有技术,将预设动作和文本结合形成完整的手语虚拟主播。但在此概念下的手语虚拟主播是基于简单文本反馈所得到的,由人工对所播报的字句进行手语简化和转译,再进而将转译后的信息传达给虚拟主播。由于手语虚拟主播对人力要求大、翻译过程复杂、手语动作算法简单以及早期計算机硬件算力不足等因素,手语虚拟主播在当时技术环境中难以实现。

随着时间推移至2018年,经过长时间AI技术的发展,虚拟主播已经能够借助算法对动作进行实时模拟。在当年12月,爱奇艺推出了全球首款AI手语主播“奈奈”,其原理是通过自动语音识别技术(ASR),准确识别视频中的语音并将其转换为文字,而后以NLP(Natural Language Processing)技术将文字转换为手语内容,之后通过2D虚拟偶像进行输出。其中,AI作为语言文字和手语语言的符号连接核心的雏形开始出现。2019年,爱奇艺与华夏出版社、中国聋人协会和凤凰云祥等机构合作推出3D的AI手语主播,而词汇量相比于上一代有了更大扩充,从几十个词到上千个词。2021年10月,华为在开发者大会上展示了其所开发的华为手语服务(SignPal Kit),AI成为手语主播的实际核心,利用算法服务于实时语言转译。2021年11月,由中央广播电视总台央视新闻联合百度智能云倾心打造的首个AI手语主播亦正式亮相于公众,其AI对语言文字的翻译已趋于成熟。

AI手语主播从最初的手语虚拟主播逐渐向目前的AI手语主播发展,究其根本,是在AI的作用下改变了其背后的传播路径。在“手语虚拟主播”的概念中,以文字和虚拟主播作为直接路径,将语言文字经过电脑和算法直接生成动作。该种“文字—手语”传播路径下,语言符号量级较小的手语无法有效对所阐述的语言文字进行直接翻译,而不得不采取人工校对的方式,避免产生手语语义错误并需要检查内容表述完整,人工对手语语言的转译和对手语动作的锚定也直接导致了“文字—手语”翻译过程的效率低下。另外,早期计算机图像渲染能力不足也直接导致了手语虚拟主播动作无法实时生成,冗长的动作渲染时间进一步限制了手语虚拟主播的应用与发展。

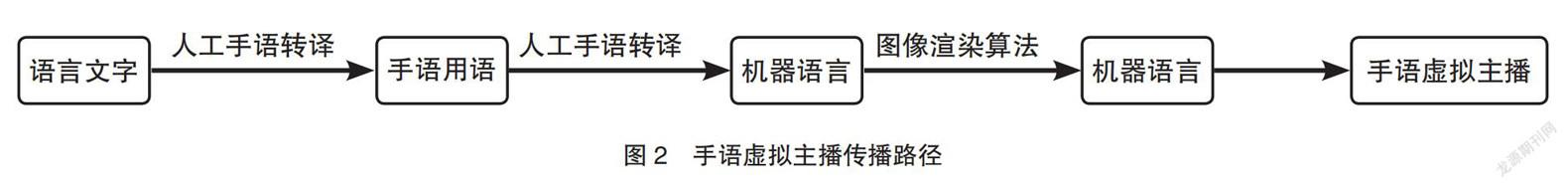

在传播路径上(见图2),手语虚拟主播需要从文字、口语开始,通过人工对语言的转译形成适用于手语语言的文字,再将文字输入至计算机算法中并最终视觉性转化形成手语虚拟主播,因此,“文字—手语”的翻译过程是对文字的转译和转化过程。同期与之相比的是人工手语主播,其大多出现在新闻直播间的一角,由专业的手语工作者辅助听障群体接收新闻信息而存在。相比于人工手语主播,复杂的转译中介和多种语言的转换使得流程上远长于直接使用人工手语主播。因此,在早期无AI参与的“手语虚拟主播”中,由于语言文字翻译效率低下和动作渲染能力不足以及转译流程长,其效率和使用价值上远不如同期的人工手语主播。

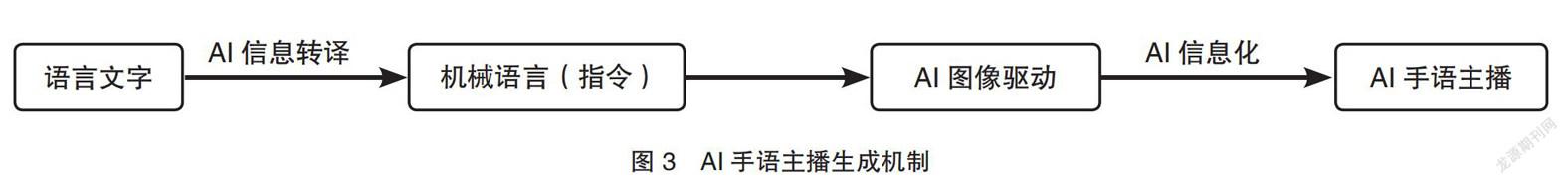

而随着AI对流程的深入参与,既有的AI手语主播技术路径与传播路径(见图3)也发生了变化。以2022年北京冬奥会AI手语主播为例,其依托于智能云,基于《国家通用手语词典》规范建立的规模庞大的手语动作库,导出可用于机器语言的翻译结果,再将机器语言输入至服务于图像的AI中并最终输出AI手语主播的模拟画面。在该流程中,AI作为信息转译、动作生成的核心,将语言文字与最终的手语主播相串联,取代了上述人工所需要参与的语言文本转译、校对的过程。

其传播路径上,AI手语主播已经能够完成人工对语言文字的转译过程。基于语言库的匹配和手语图像规范的AI算法,让AI手语主播能够“理解”文本语言并在此基础上形成合理的“解释”。在AI的参与下,“文字—手语”的转译路径也由多个转译中介变为由AI进行直接转译并输出机器语言。转译介质上的统一让其在传播路径上相比手语虚拟主播大大缩短,能够有效避免语言多次转译带来的语义错误或语义缺失并极大提高信息转译的效率。AI加持下的图像驱动为AI手语主播提供更高效率的图像渲染能力,凭借对动作的实时锚定,将文字符号转化为视觉符号,实现AI手语主播实时转译手语的视觉性符号转化。

但手语并不是听障人士使用的唯一语言,瑞典研究者在《双语论、手语以及瑞典语》中认为,听障人士中双语的使用能够有效地提高对文本语义的理解能力。因此,在现有的特殊人群手语教学中,通常采用双语教学的方式以增强对文本语言的理解力,这同时也要求手语主播能够在演示手语的同时提供唇型等辅助动作。早期AI手语主播主要在于对单一手语的信息要素传递,随着对AI手语主播使用要求的不断提高和AI手语主播的职能要素的不断增加,面部动作成为AI手语主播虚拟形象所必须的元素之一。因此,在AI的参与下,要求AI手语主播在生成手语动作的机械语言(指令)过程的同时,能够根据文字需要实时生成手语相对应的唇形动作,从而进一步完善手语传播过程中对手语、唇语的需求,进而实现对听障人士的双语服务要求。

此外,在手语虚拟主播与人工手语主播传播路径的对比过程中,人工手语主播能够在表达手语的同时将语言情感以面部表情的方式进行传递,手语虚拟主播局限于语言翻译能力和图像渲染能力,不能将情感元素传递至虚拟主播而仅能进行手语语言的表达。而AI手语主播的AI能够有效识别语言文字内容中的情感信息并将该信息传递至AI加持下的图像驱动,从而使虚拟主播的表情能够随着语言文字的情感变化而变化,进而在应用上达到与人工手语主播近似或相同的情感传递效果。

在上述内容中,笔者综合阐述了人的认知过程以及AI手语主播如何进行对语言文字内容的转译和转化并最终形成手语的过程。在AI的参与下,手语虚拟主播从单一的手语语言传达到手语、口型、表情的多方面糅合,AI助力手语虚拟主播完成向多维的视觉感官演进。AI手语主播作为听障人士的中介,为听障群体和媒体之间提供信息连接。弥补听力缺失带来的认知不足,而这种由AI建立起的连接将成为弥合听障人士和健全人之间认知鸿沟的重要工具。

三、AI的技术可供性:AI手语直播在听觉认知弥合的未来发展中的升级版图

施拉姆在其大众传播理论中提出,信息是经由编码者、译码者和释码者自大众传媒传递给受众。在AI手语主播中,来自信源的文本作为信息传递的开端,听障人士作为信息的受众,AI在其中将信息进行转译、转化形成手语信息,充当了大众信息传播途径中的编码者、译码者;而依托于AI的图像驱动则成为了该途径中的释码者,AI及依托于AI的多媒体技术彼此之间形成了良好的依附,共同构建起连接信源与听障人士之间的信息桥梁。

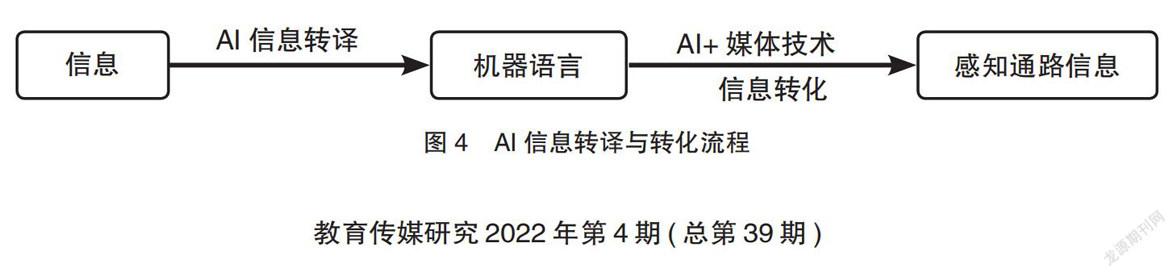

另一方面,受众在接收信息的过程中所接收的信息并不是单一的一种,而是基于上述多感官认知过程中的多种感知信息。AI在完成构建二者信息沟通桥梁的过程中需要完成对多感官信息的传递,即在AI手语主播中传递手语肢体信息的同时,还要传递表情、唇形等信息要素,AI技术的可供性成为了实质上的连通信息和多感官认知的核心——在既有的AI手语主播中,AI就像电脑的主机一样掌控了AI手语主播的转译和转化流程(见图4),实现了AI对信息的翻译,使AI成为听障人士的信息接收端口。基于此,我们可以认为对AI信息表达的拓展即是对听障人士的认知感官的拓宽。因此,若借助AI手语主播为听障人士提供视觉外的多感官信息拓展,则应从AI的角度出发,以“信息转化模块”的方式為AI添加“三头六臂”式的多感知通路。

AI与媒体技术之间以机器语言作为二者间的沟通中介,AI对媒体技术输出指令让媒体完成既定信息的展示。但在其中,“构建什么样的信息模块”“如何将信息进行符号化再表达”成为AI拓展“信息转化模块”的两大课题。

(一)人的认知系统的互补与代偿机制:AI手语主播重构听觉补偿机制的基本参照系

在关于“构建什么样的信息模块”中,AI所使用的媒体技术发展的基本参照系是听障人士的认知系统各个通路之间的互补与代偿机制。比如,声音中的节奏可以通过触觉的节奏来传达;声音中的情绪与情感可以通过视觉中的色彩变幻来体现;甚至旋律与风格也可以通过视觉与触觉的统合来加以表现。如果我们考虑到未来技术可能将味觉与嗅觉统合到数字场景中,听觉重构的手段、路径和模式势必将更加丰富和有效。概言之,AI技术的可供性为我们依循人的认知重构的系统框架可以越来越好地实现超越听觉障碍的认知模式与传播机制。

(二)专用AI感知技术装备:听觉认知重构的全新“入口”

在关于“如何将信息进行符号化再表达”中,AI所转译形成的机器语言在经过媒体技术形成听障人士可以接收的信息过程,需要对信息进行符号化再表达,这些再表达需要专用的AI感知技术装备来成为听觉认知重构的全新“入口”。恰如手语对文本语言的符号化再限定,让听障人士能够看懂语言文字并能够将话“说”出来,媒体技术需要将所要传达的信息进行符号化再表达,以完成AI对信息的转化,并满足听障人士的信息接收行为。而这一过程是媒体技术对语言文字的再定义,将人需要理解的语言文字转化为可以直接感触的知觉信息(如感受触觉与振动的“AI触觉手套”,再如通过画面和色彩变幻的节律表达来代偿情绪感知与调性的视觉屏幕或AI眼镜等)。在当下对于AI手语主播的应用过程当中,仍然存在着感知通路单一、信息语料库不足等问题,因此AI手语主播的媒体技术要完成对信息的符号化再定义,就需要不断地挖掘人的感知通路,尤其是听障人士的感知通路,并形成专用装备,通过对不同感知通路的发掘和“落地”,达到对听觉感官通路的系统代偿与弥补。

在目前AI手语主播的应用上,已经可以完成对手语表达的同时提供AI形象的表情、口型实时变化,这代表着AI能够将一种语言文字同时输出为多种感官的符号化再表达。那么在对听障人士的信息供给过程中,这种多感官的符号化在表达能力上可以结合视觉与触觉、视觉与味觉、视觉与嗅觉等方式将媒体技术模块进行累加,拓展单一视觉路径上的AI手语主播,将视觉上AI的手语主播作为场景元素中的“景”,利用多感官的方式为听障人士提供可以充分感知语音代偿的手语传播场景。

现有的AI手语主播在传播途径上仍然是以单向传播为主,若要建立完整的认知桥梁还需要补足沟通桥梁上最后一个要素,即人对AI手语主播的即时的多通路反馈。众所周知,人的认知过程是根据不断与事物进行对话而完善的,单次信息传递所能提供的信息量以及理解要素是有限的,如果可以将深度学习的AI技术嵌入到听觉代偿机制的反馈链条中,无疑将极大提升其代偿性机制的契合性,这将造成AI手语主播以自适应的方式完成与听障人士之间的对话、交互,进而提高对信息理解的系统性表达的完善。

四、一点延伸的结论

在上文中,我们以听觉障碍在AI技术的框架内的解决方案为例,探讨了未来传媒发展的“聚合”逻辑。研究表明,未来媒介会在既有互联网媒介技术的存量基础上,全面、整合地拓展人类自由度。

首先,未来媒介已初步具备互联网提供的基础建设、用户生态、产业集群等存量条件。Web1.0时代,互联网发展主要着眼于基础设施建设与软件服务完善,集中在产业端蕴蓄;Web2.0是To C的,新技术在向用户端转移和普及的过程中爆发;Web3.0为包含5G在内的新媒介技术做产业准备,初步呈现出全要素聚合的样态。一旦Web3.0的产业准备搭建完成,Web4.0聚焦无限渠道、无时无刻、无限内容的互联网生态级系统也将来临,未来媒介也将实现落地。

以此为基础,未来媒介的着力点在于以更整合、全面的方式拓展人類自由度。传统的、相对散落的媒介总是通过对个体某一方面的延伸以拓展人类活动半径,因而传统媒介对个体的赋权总是以分割感官为前提的,个体很难在媒介世界中获得如同真实个体般的全感官体验,无法实现人的“感觉总体”回归。但是在全要素整合的AI互联网系统中,人类将在媒介中得到全感官复制的体验,感受到“镜像”般的数字孪生世界。换言之,未来媒介致力于让个体超越“分割式”的赋权,得到“感觉总体”的全部赋权,在数字世界中以完全的个体形态探索更多的实践空间。

注释:

①〔美〕约翰·杜翰姆·彼得斯:《对空言说:传播的观念史》,邓建国译,上海译文出版社2017年版,第3页。

②喻国明:《互联网是一种高维媒介》,《教育传媒研究》2016年第1期。

③《AI手语主播上岗 助听障人士观冰雪赛事》,人民网, http://health.people.com.cn/n1/2022/0208/c14739-32347640.html,2022年2月8日。

④李东晓、熊梦琪:《“可及”之后:新媒体的无障碍传播研究与反思》,《浙江学刊》2017年第6期。

⑤程玉洁、周曙、王优:《青年人被动型和主动型听觉事件相关电位时空模式比较》,《中国心理卫生杂志》2014年第7期。

⑥Tamis-LeMonda, Catherine S , Kuchirko, et al. Why Is Infant Language Learning Facilitated by Parental Responsiveness?[J]. Current Directions in Psychological Science (Sage Publications Inc, 2014).

⑦滑蓉蓉、刘春艳、邢岩:《听觉与认知研究进展》,《中国神经免疫学和神经病学杂志》2020年第3期。

⑧Maslen, Sarah. Researching the Senses as Knowledge: A Case Study of Learning to Hear Medically[J]. Senses & Society, 2015, 10(1):52-70(19).

⑨张瑶、张帆、毕泰勇、邱江:《视觉和听觉通道情绪知觉加工的神经机制及其异同》,《科学通报》2019年第7期。

⑩张兴利、施建农:《听力障碍对视觉注意的影响(综述)》,《中国心理卫生杂志》2006年第8期。

王兆其、杨长水:《虚拟主持人的设计与实现》,《电视字幕(特技与动画)》2002年第9期。

《爱奇艺推出全球首个AI手语主播,让听障人士平等享受视频带来的乐趣》,爱奇艺,https://www.iqiyi.com/common/20181203/b47c90918d000779.html,2018年11月28日。

《爱奇艺再次推AI手语主播,相比上代有表情、可识别更多词汇》,AI云资讯, https://www.icloudnews.net/a/20190519/20114.html,2019年5月19日。

《总台首个AI手语主播亮相 央视新闻联合百度智能云打造》,《经济参考报》2021年11月24日。

Ahlgren.Sign Languageas the First Language [G]// Inger Ahlgren, Kenneth Hyltenstam. Bilingualismin Deaf Education. Hamburg: Signum, 1994.

〔美〕伯纳多·胡伯曼:《万维网的定律:透视网络信息生态中的模式与机制》,李晓明译,北京大学出版社2009年版,第34页。

〔美〕约书亚·梅罗维茨:《消失的地域:电子媒介对社会行为的影响》,肖志军译,清华大学出版社2002年版,第154页。