人工智能中agent的中译正名及其法律意义

寿步

摘 要:AI中agent的中文译名尚未形成共识,限制了研究的深入。回顾AI中agent出现的时代背景,汇总中文语境下AI中agent的译名情况,详细考察若干AI经典英文论著中agent的论述,思考agent中译正名的理由,可以确定agent应译为“行为体”(doer或actor),agent应是AI与哲学社会科学各学科交叉研究时涉及的AI在各该领域的“行为”的“主体”。因此,AI与法律交叉研究时涉及的AI相关“行为”主体即“法律主体”就是agent。此项正名为在AI与法律交叉领域研究中agent的“行为”埋下循名责实的线索,预留名正言顺的空间,既有助于在AI领域本身加深对agent的认识,也有助于深入推进AI与法律的交叉研究,还有助于在更高层次上对agent进行旁通统贯的研究。

关键词:agent;行为体;施事者;施动者;智能体

中图分类号:D 912 文献标志码:A 文章编号:2096?9783(2022)03?0001?13

在与人工智能(Artificial Intelligence,简称AI)相关的哲学社会科学各学科的交叉领域研究中,通常会涉及AI在各该领域的“主体”问题,这是各该领域研究的基础问题。如在AI与法律(AI and law)领域,会研究AI相关的“法律主体”(legal entity或legal subject)或“拟法律角色”问题。

以AI与法律领域为例,国内学者的相关论著通常只是笼统地将“人工智能”这四个字作为可能的“法律主体”或“拟法律角色”,却没有进一步说明所称的“人工智能”究竟是指什么。是指AI科学,还是指AI技术?是泛指所有AI产品,还是特指某个AI产品?是泛指所有AI服务,还是特指某种AI服务?是泛指AI的所有应用场景,还是特指AI的某种应用场景?这样就无法从AI的内在机制出发阐释在AI与法律研究中涉及的AI相关“主体”究竟是什么。

agent是AI业界尝试统合AI理论的载体,是AI的一个重要基础概念。在AI与哲学社会科学各学科的交叉领域研究时所涉及的“主体”应该共同指向AI中的agent。为此,需要准确理解AI中agent 的本意,在正本清源的基础上进行agent中译的正名,进而确定agent在AI与哲学社会科学各学科的交叉领域(包括AI与法律领域)中的“主体”地位。本文将介绍在AI研究中引入agent的时代背景,说明中文语境下AI中agent的译名情况,详细考察AI领域六部(篇)经典英文论著中关于agent的论述,确定对agent中译正名的理由和结果,阐述其法律意义。

一、agent是 AI理论统合尝试的载体

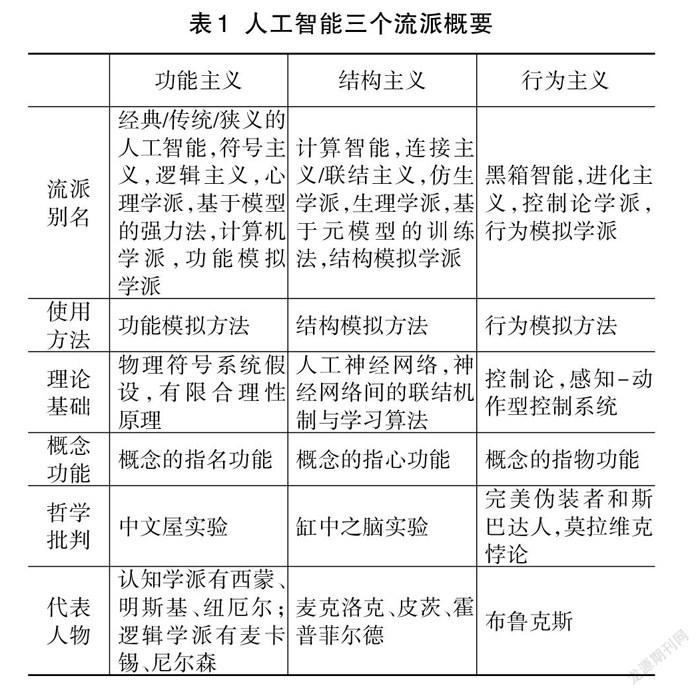

众所周知,AI作为一门学科始创于20世纪50年代。此后AI研究主要有三个流派:功能主义、结构主义、行为主义。三个流派采用不同的方法来模拟智能,其要点如表1所示:

AI三大流派各有长短,AI的发展过程也是曲折不平的。现在的AI研究已经不再拘泥于遵循AI某个单一流派的路径,在许多应用场景会综合各个流派的技术。一方面,各个流派继续在发展;另一方面,各个流派也在不断融合之中。

20世纪80年代末到90年代初,AI业界出现了关于AI基础的反思辩论。要融合AI的不同流派,就需要寻求新理论、新方法来统合既有的AI理论。这样的趋势在20世纪末到21世纪初非常明显。其中最具代表性的是20世纪90年代的两部著作:(1)拉塞尔和诺维格的Artificial Intelligence:A Modern Approach;(2)尼尔森的Artificial Intelligence: A New Synthesis。这两部著作都试图以agent为载体,以agent的能力水平的扩展为轴线,把AI的三大流派串联起来,以期形成统一的AI理论。

因此,agent成为AI研究的重要概念,在中文语境下准确翻译AI中的agent概念对于AI相关各学科研究就具有显著的意义。

与agent相关的建立Multi Agent System(缩写MAS)从20世纪80年代起成为一个独特的研究领域,该领域在20世纪90年代中期就已经得到广泛的认同。

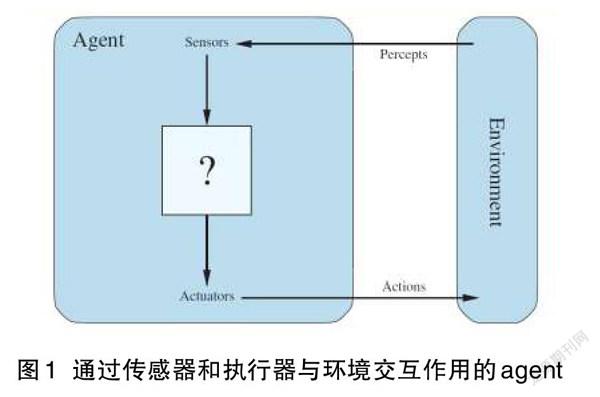

拉塞尔和诺维格给出了关于agent的示意图1,如图1所示:

图1显示,在agent与环境(environment)之间,通过传感器(sensors)和执行器(actuators)互相联系。传感器可以感知环境的状态;执行器可以给环境施加作用。在agent内部还有一个用“?”表示的方框,它代表agent内部从传感器接收输入信息到执行器发出输出信息的中间环节,即agent内部的决策机制(能力模块)。决策机制至少包括三种情况:(1)如果决策机制提供的是一系列“条件—动作规则”,这时agent就成为感知—动作系统,对应于行为模拟方法;(2)如果决策机制提供的是人工神经网络的学习能力,这时agent就具有学习能力,对应于结构模拟方法;(3)如果决策机制提供的是以物理符号系统假设为基础的符号模式的处理过程,就对应于功能模拟方法。这样就以agent为载体,通过“?”方框即决策机制内部的变化,把行为模拟方法、结构模拟方法、功能模拟方法作为agent的三种特例,将AI三大流派统一在agent的基础上。

二、AI相关agent的中译现状

(一)英文原著中文译著中的agent译名

1.在明斯基著的《思維的社会》中,译著将agent译为“智能体”,并将agency译为“智能组”2。

2.在拉塞尔和诺维格合著的《人工智能:一种现代方法》中有两个中译本,译著1 是此书第2版的译本,将agent译为“智能体”,因而将intelligent agents译为“智能化智能体”。这个译法同义重复,问题出在agent的译法。译著2是此书第3版的译本,译著不译agent,保留原文3。E993D0D0-9E61-492A-BE5A-216212B78122

3.在尼尔森著的《人工智能:新综合》中,译著不译agent,保留原文[1]。

4.在伍德里奇著的《多Agent系统引论》中,译著不译agent,保留原文[2]。

5.在普尔和麦克沃思合著的《人工智能:计算agent基础》中有两个中译本,其中针对第1版的译著1除了在前言采用“agent(智能体)”的译法之外,书中其他所有agent都是保留原文。同时将agent示意图(即本文图5)中负责与环境进行交互的部分body译为“主体”[3-4]。

6.在司马贺著的《人工科学:复杂性面面观》中,译著将仅有的一处agent译为“活动者”[5]。

(二)中文论著中的agent译名

1.在蔡自兴等著的《人工智能及其应用》中,以该书第5版为例4,该版本主要用“真体”(作为“艾真体”的简称)翻译agent,有时也用“主体”“智能体”的译名;并用“多真体系统”“多智能体系统”表述MAS。该版专设一小节“9.2.1 agent的定义和译法”,该书作者认为AI的agent译为主体、代理等都不合适,宜取相近发音译为“艾真体”,简称“真体”。“真体”所处的环境可以是实时环境,也可以是虚拟世界。本文认为,这一观点有一定道理,但该译名还不是最佳选择。

2.在朱福喜编著的《人工智能》(第3版),该书前言中出现“多智体(multi-agent)”,在第一章概述中出现“智能主体(agent)”的表述,在第九章“基于agent的搜索”中则全部不用中文译名,直接使用agent5。

3.在钟义信的两部著作涉及agent之处,有时直接使用agent,有时使用“智能体”或“智能代理”[6-7]。

4.史忠植先后分别使用“智能主体”“主体”“智能体”作为其三部著作中agent的译名6。

5.肖晴等的论文[8]中,agent的英语解释是person or thing performs results,故用译名“作用体”。该文所称“多作用体系统”就是MAS。

6.廖强等的论文[9]也将agent译为“作用体”。该文所称“多作用体”就是Multi-agent。

7.徐英瑾有两部人工智能哲学著作[10-11],在《心智、语言和机器》中有多处以中英文对照形式给出agent的中文译名,如“行动者”“能动者”“特殊主体”“智能体”;还有以中英文对照形式给出对agency的中文译名“能动性”。在《人工智能哲学十五讲》中涉及agent的译法至少有两种,“能动者”“智能体”,另有“多主体系统”应是对应于MAS,也就是将agent译为“主体”。换言之,哲学学者除了援引IT业界既有译法(智能体、主体等)外,还将agent译为“能动者”“行动者”,将agency译为“能动性”。

8.白惠仁将agent译为“能动者”,将agency译为“能动性”。这是哲学学者的又一例7。

9.陈家成在《复杂科学与佛法》一文8中多处使用“作用元”或“作用体”来指代agent。“作用元”的译法比较别致。

(三)中文语境下agent译名小结

在AI译著方面多不翻译,保留原文agent;若翻译,则多译为“智能体”,但此时有的将intelligent agents译为“智能化智能体”或“智能智能体”,出现同义重复的违和问题,也有译为“活动者”。另有将agency译为“智能组”。

在中文论著方面,可分三种情况:

(1)IT技术专家,多直接使用英文agent;使用中译的,则以“智能体”最多,其他中译还有“智能主体”“主体”“智能代理”“作用体”等;另有独创的音译“艾真体”(简称“真体”)。

(2)哲学学者,除使用与IT技术专家相同或近似的译名“智能体”“特殊主体”“主体”之外,还有用译名“行动者”“能动者”。另有将agency译为“能动性”。

(3)其他学者,有将agent译为“作用元”。

三、从《思维的社会》看agent

(一)行为体(agent)和行为体的社会(society of agents)

明斯基是AI三大流派之一功能模拟学派中的認知学派的代表人物,也许是最早将agent概念引入AI领域的学者之一,这体现在他1985年出版的著作《思维的社会》(The Society of Mind)中。该书将社会与“行为体社会”概念引入计算系统。该书第一章引言写道:

“本书尝试说明思维如何运作。智能如何从非智能中涌现(emerge)出来呢?为回答这个问题,我们将显示,你可以从许多自身无法思维的小部件来构建思维。

“我把这样的机制称作‘思维的社会,其中每片思维都是由较小的进程组成的。我们把这些小进程称为行为体(agent)。每个心理的行为体本身只能做一些简单的事情,这些事情完全不需要思维或思想。然而当我们以某些非常特殊的方式将这些行为体加入思维的社会时,就将导致真正的智能。”

该书第1.1节思维行为体(The agent of the mind)中写道:

“为了解释思维,我们就必须展示思维(minds)是如何由无思维(mindless)的东西构成的,这些组件比可以认为是智能(smart)的任何东西都小得多又简单得多。

“一旦我们将思维(mind)看作是行为体的社会(society of agents),那么每一个答案也就解释了其他的问题。”

在IT业界,对AI的agent最常见的译名是“智能体”。本文则认为应将agent译为“行为体”。何为标准?应以作者原意为准。

明斯基在此对agent有下列描述:(1)智能是从非智能中涌现出来的。注意,这里蕴涵着复杂性科学的涌现性(emergence,也译为突现性、层创性)思想。(2)“你可以从许多自身无法思维的小部件来构建思维。”从许多小部件可以构建出思维,而这样的每个小部件本身是无法思维的。这里的小部件就是作者后面所称的agent。(3)agents是指“思维的社会”这个机制中“每片思维都是由较小的进程组成的”中的那些较小的进程(smaller processes)。agent不同于思维(mind),而只是它的构成成分。(4)“每个心理的行为体本身只能做一些简单的事情,这些事情完全不需要思维或思想。”心理的行为体自身只能做一些简单的完全不需要思维或思想的事情。(5)“然而当我们以某些非常特殊的方式将这些行为体加入思维的社会时,就将导致真正的智能。”如果我们没有以某些非常特殊的方式将这些行为体加入思维的社会中,那就不存在真正的智能。换言之,agent本不具有真正的智能。(6)“为了解释思维,我们就必须展示思维是如何由无思维的东西构成的”“将思维看作是行为体的社会”,这里体现了复杂性科学的涌现性思想。E993D0D0-9E61-492A-BE5A-216212B78122

(二)agent的涌现性解释

可以用复杂性科学中的涌现生成理论,结合本文图1来对AI中的agent进行阐释。涌现是一种从低层次到高层次的过渡,涌现性并不存在于低层次的单个要素之中,而是系统在低层次构成高层次时才表现出来,所以形象地称为“涌现”。系统功能之所以往往表现为“整体大于部分之和”,就是因为系统涌现了新质的缘故,其中“大于部分”就是涌现的新质。系统的这种涌现性是系统的适应性行为体(adaptive agent)之间非线性相互作用的结果。

具有涌现现象的系统往往可以根据agent之间的相互作用来建模。agent提供了对具有涌现现象的系统建模的最快办法。神经网络中的神经元、蚁群中的蚂蚁、物理学中的基本粒子都可以由一些规则和规律来描述,这些规则和规律决定了这些agent在一个大环境中的行为。每种情况下我们都能将这些agent的行为描述成处理的物质、能量或信息,它们可以产生某一行为,这个行为通常就是物质、能量或信息的传送。agent的功能是处理输入状态并且产生输出状态。这里的输入状态是由agent当前的实时环境决定的,而生成的输出状态则决定了agent将对当前的实时环境所造成的影响。在环境中其他agent与给定agent之间的相互作用,也作为该给定agent的输入状态的一部分[12]。

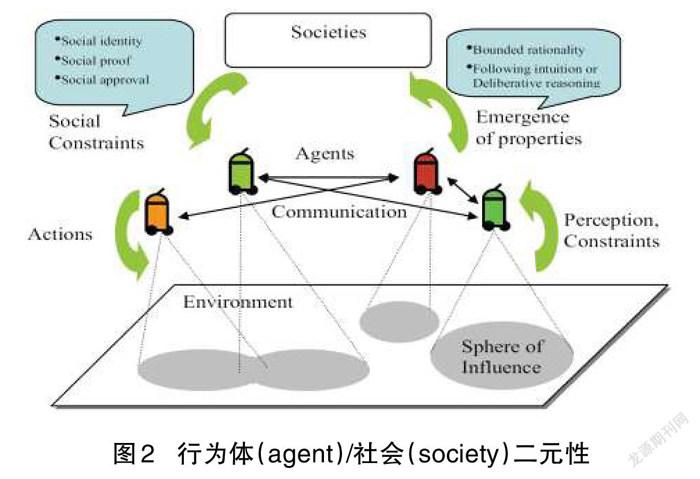

关于AI中的agent,明斯基说,当人们以某些非常特殊的方式将这些agent加入思维的社会后,由于涌现性,思维的社会才出现真正的智能。显然,agent(即系统低层次的要素或组成成分)本身并非“智能体”(顾名思义即“有智能的主体”),而出现了涌现性的“思维的社会”或“行为体的社会”(即系统的高层次形式)才可能是“智能体”,上述思想可用图2表示9。

因此,如果将agent译为智能体,就在译名上指明它自身“已经”具有智能。这样的译名显然不符合明斯基的原意,也不符合复杂性科学中的涌现性原理。如果将agent译为行为体,则译名本身并不涉及agent是否有智能,不会引出agent已经“有智能”的误解。

(三)行为体(agent)和能动性(agency)的关系

再看该书第1.6节行为体与能动性(agents and agencies)的相关表述:“我们想要将智能(intelligence)解释为更简单事物的组合。这就意味着我们必须在每一步都确认,没有一个行为体本身是有智能的(none of our agents is, itself, intelligent)……相应地,任何时候只要发现一个行为体(agent)在做任何复杂的(complicated)事情,就用一个行为体的子社会(a subsociety of agents)取而代之。”

明斯基在此再次强调没有一个agent本身是有智能的。这再次说明将agent译为“智能体”是不妥的。

该节就关于如何用“寻找”(Find)和“拿起”(Get)这样的小部件组合成“建设者”(BUILDER)以此构建建塔技能作出说明,并给出图3。

图3中的两段文字是:就其自身来看,作为一个行为体,“建设者”只是一个打开或者关闭其他行为体的简单流程。从外部看,作为一种能动性(agency), “建设者”可以做任何由其子行为体(subagents)通过互相帮助所能完成的事。

图3之外的相关文字写道,“如果你从外部观察‘建设者的工作,在对它的内部如何工作一无所知的情况下,你就会有这样的印象——它是知道如何建塔的。但是如果你能够从它的内部去看,你就一定会发现那里不存在任何知识。除了已经安排好的按照各种方式互相之间进行开和关的一系列开关之外,你就看不到任何东西。‘建设者‘真的知道如何建塔吗?答案取决于你如何去看。让我们用两个不同的术语——行为体(agent)和能动性(agency)——来说明为什么‘建设者看起来具有双重身份。作为能动性,它似乎是知道它的工作(As agency ,it seems to know its job);作为行为体,它却不知道任何东西(As agent, it cannot know anything at all)。”

本文将agency译为“能动性”,认为agency在图3中对应于“行为体的社会”,它在本质上体现了能动性。一方面,没有一个行为体本身是有智能的;另一方面,行为体的社会则是有能动性的。因此,一个“什么也不知道”的agent不应译为“智能体”;agency则宜译为“能动性”。

四、从《人工智能:一种现代的方法》看agent

(一)行为体(agent)和智能行为体(intelligent agent)

下面针对拉塞尔和诺维格合著的《人工智能:一种现代的方法》(2009年第3版)进行述评。该书试图将现在已知的内容综合到一个共同的框架中,就是要将已知的AI技术纳入以agent为线索的框架。该书前言的“本书概览”指出,“本书的主题概念是智能行为体(intelligent agent)。我们将AI定义为对从环境中接收感知信息并执行行动(actions)的行为体(agents)的研究。每个这样的行为体实现把感知序列映射到行动(actions)的功能,我们讨论了表达这些功能的不同方法,如反应式行为体(reactive agents)、实时规划器和决策理论系统等。”

注意原文中有intelligent agent,如果将agent译为“智能体”,则intelligent agent势必译为“智能智能体”或“智能化智能”体。由此可以倒推看出将agent译为“智能体”的不妥。

该书第一章绪论给出了其他作者在8种著作中从四种不同途径给出的AI定义模式:“(1)像人行动:图灵测试的途径;(2)像人思考:认知建模的途径;(3)理性思考:‘思维法则的途径;(4)理性行动:理性行为体的途径(Acting rationally: The rational agent approach)。人們在这四个方向都做了许多工作,既相互争论,又彼此帮助。”E993D0D0-9E61-492A-BE5A-216212B78122

该书在介绍第四种定义时说,“行为体就是能够行动的某种东西(agent来源于拉丁文agere,意思是‘去做)10。当然,所有的计算机程序(computer programs)都做某些事情,但是计算机行为体(computer agents)则可以指望做得更多:自主操作,感知环境,长期持续,适应变化,创建并追求目标。理性行为体(rational agent)是这样的行为体,即为实现最佳效果或者当存在不确定性时为实现最佳预期效果而行动(acts)。”

可见,理解并解释agent的关键词是act或to do。此外,“计算机行为体”比一般的计算机程序“做得更多”。

(二)行为体(agent)在多学科中的使用

该书1.2.3小节提到经济学中的决策论和博弈论对AI发展的贡献。其中说,“每个行为体(agent)无需注意其他行为体作为个人而言的行动”的情况;也讲到“对于某些博弈,理性行为体(rational agent)将随机(或者至少是看上去是随机)采取对策”。

该书1.2.5小节提到认知心理学对AI发展的贡献,“克雷克说明了基于知识的行为体(knowledge-based agent)的三个关键步骤:(1)刺激必须翻译为内部表达;(2)认知过程处理这个表达以获取新的内部表达;(3)这些表达反过来再翻译回来变成行动。”

显然,在英语语境下,AI中的agent与经济学中的agent和认知心理学中的agent都是同一个东西。中译时,应为这三个领域中的agent寻找一个在不同领域都适用并且不违和的译名11。

如果在AI领域将agent译为“智能体”(且不论agent本身是否有“智能”),在经济学和心理学领域中也能译为“智能体”吗?显然不合适。而“行为体”的译法则是既反映了agent的本意(act或to do),又是在经济学和心理学等不同领域都可采用的译名。

五、从《人工智能:新综合》看agent

(一)行为体(agent)和反应式行为体(reactive agent)

尼尔森所著《人工智能:新綜合》一书于1998年出版。其第一章绪论第1.4节本书规划中指出:

“AI研究者已经开发出与机械化智能相关的许多创意和技术。本书将在一系列更有能力的和更复杂的‘行为体(agent)的语境里描述这些创意和技术。可以关注本书对行为体与环境的相互关系的论述。

“本书首先介绍反应式行为体(reactive agents),它有各种工具在其世界中感知和行动(acting)。更复杂的行为体也有记忆特性和存储世界内在模型的能力。在所有情况下,反应式行为体所采取的行动(actions)都是其所感知和记忆的世界当前状态和过去状态的函数。

“本书进一步介绍可以做规划(make plans)的行为体,它有能力预见其行动的影响,并采取行动以期实现其目标。一些研究者认为,做规划的能力就是智能的判定标准,AI由此开始。本书还将介绍具有推理(reason)能力的行为体。

“本书最后将介绍行为体出现在已有其他行为体处于其中的世界的情况,这时就其自身而言行为体之间的通信(communication)就成为重要的行动(action)。”

该书第23章多行为体中第23.1节交互行为体中指出:

“本书先前部分除了第12章之外,所讨论的都是单个行为体,这种行为体在一种与其能力和目标多多少少相适应的环境中进行反应、规划、推理、学习。已经假设任何其他行为体或进程(processes)的有关影响是可以要么被适当的行为体反应(agent reactions)所减缓的、要么被忽略的。从第23章开始,本书关注每个行为体在自己的规划中如何能预测到其它行为体的行动(actions)。一个行为体在维护其自身目标过程中是如何影响其他行为体的行动(actions)的。一个行为体可以对另一个行为体建模(model)、与之通信(communicate),以便预测并影响后者将要做什么(will do)。

“本书采用‘以行为体为中心(agent-centric)的观点。根据这一观点,用结构和目标来识别单个行为体,称之为我们的行为体(our agent),该行为体在一个包含其他行为体和/或进程的环境中行动(acting)。与本书先前的大多数假设不同,在这里,其他行为体和进程的行动(actions)对我们的行为体的影响是巨大的。对于我们的行为体的目标来说,其他行为体和进程可能是有益的、可能是中立的、也可能是有害的。本书的论述将专门研究这种情况——若干行为体协调他们的行动(activities)以实现共同的目标,即所谓的分布式人工智能(DAI)。”

(二)行为体(agent)和机器人(robots)

该书第25章行为体体系结构(agent architectures)的引言指出,“虽然我们经常假设所讨论的行为体是机器人(robots),但是AI的许多创意也可以用于非实体的行为体(nonphysical agents)。可能并不存在一个单一的、理想的、智能的行为体体系结构。”注意到,行为体(agent)既可以是实体的(如有形的机器人),也可以是非实体的。

六、从《智能agent:理论与实践》看agent

(一)行为体(agent)的理论、体系结构、语言

《智能agent:理论与实践》是伍德里奇和詹宁斯在1995年发表的与AI领域agent相关的一篇著名论文12。该文摘要说:“行为体(agent)的概念在AI和主流计算机科学中都变得日益重要。本文的目的是说明,与智能行为体(intelligent agent)的设计和构建相关的最重要的理论和实际议题是什么。为方便起见,本文将这些议题分为三个领域。首先是行为体的理论,这涉及行为体是什么的问题和关于行为体性质的表示和推理的数学形式体系的使用问题。其次是行为体的体系结构,这可以视为行为体的软件工程模型;该领域的研究者主要关注设计软件或硬件系统以满足行为体理论家指定的特性。最后是行为体的语言,这是带有行为体的编程和实验的软件系统;这些语言可能体现了理论家提出的原则。本文并不打算作涉及的所有议题的教学导论,但希望对最重要议题给出其工作的详细描述,以替代简单的说明。本文包含对行为体技术的当前和潜在应用的简要说明。”E993D0D0-9E61-492A-BE5A-216212B78122

(二)行为体(agent)的弱概念、强概念和能动性(agency)的其他特征

此外,该文还指出:

“AI的一种定义是,它是计算机科学的子领域、旨在构建可以展示各方面智能行为的行为体。因此,行为体的概念是AI的核心。本文区分了‘行为体一词的两种通常用法:第一种是弱概念,相对没有争议;第二种是强概念,可能争议较多。

“行为体(agent)的弱概念。使用行为体术语的最常见方式也许是表示硬件、或者(更常见的)是表示基于软件的计算机系统,它们享有下列特性:(1)自治性(autonomy):行为体操作时没有人类或其他东西的直接干预,并对其行动(actions)和内部状态有某种控制;(2)社会性(social ability):行为体通过某种形式的行为体通信语言(agent-communication language)与其他行为体(可能是人类)进行互动;(3)反应性(reactivity):行为体感知其环境并以适时的方式对其中发生的变化做出反应,这个环境可能是物理世界、用户通过图形用户界面、一批其他行为体、因特网、或者可以是所有这些的组合;(4)预动性(pro-activeness):行为体并不是简单地对其环境做出行动(act),他们能够通过自发地工作表现出以目标为导向的行为。

“行为体(agent)的强概念。对某些研究者尤其是AI领域研究者来说,行为体术语有着比如上所述的更强、更明确的含义。这些研究者通常指行为体是一个计算机系统,除了如上所述特性之外,要么是概念化的、要么是使用更常用于人类的概念来实现的。例如,在AI中常用心理现象的(mentalistic)概念来描述行为体,如知识、信念、意图和义务。一些AI研究者走得更远,考虑了情感的行为体(emotional agents)。(为了避免读者认为这只是毫无意义的拟人化,应该注意,在类似人类的精神状态方面,有很好的理由支持设计和构建行为体)另一种赋予行为体类似人类特性的方式是在视觉上展示它们,也许是通过使用类似卡通的图形图标或有生命的面孔——显然,这样的行为体就那些对人机界面感兴趣的人而言特别重要。

“能动性(agency)的其他特征。在能動性的语境中,行为体的各种其他特征也会涉及。例如:(1)移动性(mobility)是指行为体在电子网络中移动的能力;(2)诚实性(veracity)是假设行为体不会有意传播虚假信息;(3)善意性(benevolence)是假设行为体没有相互冲突的目标,因此每个行为体都会尝试去做要求它做的事情;(4)合理性(rationality)是(粗糙地)假设行为体将采取行动(act)以实现其目标,而不会采取行动(act)以阻止实现其目标——至少在其信仰允许的限度内。”

此处给出了行为体(agent)的弱概念和强概念,也给出了能动性(agency)的其他特征。这些观点在后来的AI发展中被广泛引用。

注意到,行为体一语既可以表示硬件,也可以表示基于软件的计算机系统。从能动性特征中的移动性所指的行为体在电子网络中移动的能力看,行为体可以是非实体的,因为只有非实体的行为体才可能在电子网络中移动。

七、从《人工智能:计算agent基础》看agent

(一)行为体(agent)和智能可计算行为体(intelligent computational agent)

普尔和麦克沃思合著的《人工智能:计算agent基础》第1版于2010年出版(以下讨论针对第1版)。该书前言开宗明义指出:“本书将AI视为关于智能可计算行为体(intelligent computational agents)的设计的科学。关于智能行为体(intelligent agent)在环境中的行动(acting)是研究的中心点。希望将行为体(agent)想象为分层设计的,它在随机环境中智能地行动(acts intelligently)。”

该书第1.1节什么是AI中指出:

“AI的研究领域是关于可以智能地行动的可计算行为体(computational agents)的综合与分析。行为体是在环境中行动(acts)的事物(something),它做(does)一些事。行为体可以是蠕虫、狗、恒温器、飞机、机器人、人、公司和国家。我们感兴趣的是一个行为体做什么?怎么做?我们根据其行动来判断一个行为体。在下列情况,就认为行为体是在智能地行动:(1)其行为能够与其环境和目标相适应;(2)能够灵活地适应改变的环境和改变的目标;(3)能够从经验中学习;(4)给定感知和计算限制时能够作出恰当的选择。行为体通常不能直接观察世界的状态,它只有有限的记忆,只有有限的时间去行动。

“可计算行为体是这样的行为体,它关于行动的决策可以用计算(computation)来解释,即决策可以分解为能够在有形设备上实现的一系列原始操作。计算有多种形式:在人类是通过湿件(wetware,指与计算机系统相对的人脑)完成的;在计算机则是通过硬件完成的。虽然有一些行为体按理是不可计算的,例如侵蚀景观的风和雨,但是,所有的智能行为体是否都是可计算的仍然是一个开放性的问题。”

注意,出现某些特定的情况就可以认为行为体是在智能地行动。这些情况实际上就是判断行为体是否有智能的标准。因此,只有当行为体在智能地行动时,它才是中文意义上名副其实的“智能体”;而在一般情况下,agent并不是“智能体”。这一点,对确定agent的中文译名非常重要。

(二)人工行为体(artificial agent)和人工系统(artificial system)

该书第1.1节接着指出:

“AI的核心科学目标是理解使自然系统或人工系统(natural or artificial systems)具有智能特性的原理,主要通过:(1)分析自然行为体和人工行为体(natural and artificial agents);(2)构思和测试关于构建智能行为体的假说;(3)用可计算系统(computational systems)来进行设计、构造和实验,这种系统可以完成通常看来需要智能的任务。作为科学的一部分,研究者已经建立了一些实验系统来验证某些假设,或者探索可能的空间。这与适用于某个实际领域的那些应用系统有很大不同。注意:上述定义并不是关于智能思想(intelligent thought)的。我们仅仅对如何智能地思考(thinking intelligently)感兴趣,只要它能带来更好的性能。思想(thought)的作用是影响行动(action)。E993D0D0-9E61-492A-BE5A-216212B78122

“AI的核心工程目标是设计和合成有用的且智能的(intelligent)人工制品(artifacts)。我们实际上希望构建可以智能地行动的行为体。这样的行为体可用于许多应用之中。”

该书第1.3节处于环境中的行为体指出:

“AI研究实用的推理,为了做某件事进行推理。感知、推理、行动相结合构成行为体。行为体在环境中行动(acts)。一个行为体的环境可以包含其他的行为体。一个行为体与其环境合起来称为一个世界(world)。图4说明一个行为体的输入输出情况即它与环境的交互情况。

“行为体可以是机器人,可以是专家系统,也可以是计算机程序。总体而言,智能行为体的复杂程度,从简单的恒温器到一队移动机器人,到由人类提供感知和行动的诊疗咨询系统,到社会本身,千变万化各不相同。”

(三)行为体(agent)和行为体系统(agent system)

该书第2章行为体体系结构和分层控制指出:

“行為体通过主体(body)与环境进行交互。物化的行为体(embodied agent)有着有形的主体(physical body)。机器人是一种人工的、有目的的物化的行为体。有时候也将只在信息空间中行动(act)的行为体(agents)称为机器人。图5描绘了行为体与其环境之间的一般交互情况。这样的整个系统在一起合称为行为体系统(agent system)。

“行为体系统由行为体与其环境组成。该行为体从环境接收刺激并在环境中实施行动(actions)。行为体(agent)由主体(body)和控制器组成。控制器从主体接收感知信息并向主体发出指令。主体(body)包括传感器和执行器。传感器将外部刺激转为感知信息,执行器将指令转为行动(actions)。刺激包括光、声、键盘输入的单词、鼠标的移动和有形的碰撞。刺激也可以包含从网页或数据库获得的信息。”

应该注意到,在图5中行为体(agent)由主体(body)和控制器组成,主体(body)包括传感器和执行器。因此,至少在AI领域(乃至在范围更广的IT领域),不宜将agent译为“主体”,以免与body的中文译名“主体”相混淆。我们不能用中文说“主体由主体和控制器组成”(前后两个“主体”的英文分别是agent和body)。中文里就相当于说“A=A+B(B≠0)”,显然不合逻辑。

该书第2章行为体体系结构和分层控制(Agent Architectures and Hierarchical Control)第2.6节小结(Review)指出:“行为体系统由行为体及其环境组成。行为体通过传感器和执行器与其环境进行交互。行为体(agent)由主体(body)和交互控制器组成。行为体及时且必须根据其与环境的交互历史做出做什么的决定。行为体并不直接访问其历史,但访问所记忆的(信念状态)和所观察的。在每个时间点,行为体决定做什么并决定根据其信念状态与当前观察记住什么。复杂行为体根据交互的分层结构进行模块化构建。智能行为体拥有的知识可以在设计时获得、离线获得、在线获得。”

(四)智能人工行为体(intelligent artificial agent)和自治行为体(autonomous agent)

该书第10章多行为体系统第10.7节小结指出:“多行为体系统(multiagent system)由多个行为体(multiple agents)组成,这些行为体可以自治行动(act autonomously)、对于结果有其自己的效用。该结果取决于所有行为体(agents)的行动(actions)。这些行为体可以竞争、合作、协调、通信、协商。”

该书第15章回顾与展望(Retrospect and Prospect)指出:

“尽管我们仍然没有能力去构建具有人类水平表现的智能人工行为体(intelligent artificial agent),但是我们看起来已经有了开发一个智能人工行为体的积木块。主要的挑战是对真实世界复杂性的处理。然而,至今为止看起来并不存在构建具有人类水平表现的可计算的物化的行为体(computational embodied agents)的内在障碍。

“自治行为体(autonomous agents)靠自己感知、决策、行动。在我们的技术和技术想象方面,这是根本的性质上的变化。这一发展带来了自治行为体采取超出我们的控制范围的意料之外行动(actions)的可能性。如同任何颠覆性的技术那样,这必定带来实质性的正面和负面后果——许多后果我们将无法判断,许多后果我们简直就是无法预见或者不能预见。

“许多老的社会伦理规则将被打破,无法适用于新世界。作为AI新的科学技术的创建者,对此给予认真的关注是我们共同的责任。”

注意,我们仍然没有能力去构建具有人类水平表现的智能人工行为体,看起来只是有了开发一个智能人工行为体的积木块。因此,没有理由将agent译为“智能体”,agent只是一个“行为体”。

八、从《多Agent系统引论》看agent

(一)多行为体系统(MAS)和人工社会系统(artificial social system)

伍德里奇是前述论文《智能agent:理论与实践》的两作者之一。他的《多Agent系统引论》是一部教科书,2002年出版第1版,2009年出版第2版。该书第2版前言指出:

“多行为体系统(Multiagent systems)是由多个称为行为体的相互作用(interacting)的计算单元组成的系统。行为体作为计算机系统具有两项重要能力:第一,它们至少具有某种程度的自治行动(autonomous action)能力——它们自主(for themselves)决定需要做什么(to do)以满足其设计目标。第二,它们有能力与其他行为体相互作用——不只是简单地交换数据,而是从事在生活中每天都有的合作、协调、磋商之类的社交活动。E993D0D0-9E61-492A-BE5A-216212B78122

“多行为体系统从1980年代起成为一个独特的研究领域,该领域在1990年代中期得到广泛的认同。从那时以来,国际上对该领域的兴趣大为增加。其原因至少有一部分是基于这样的信念,行为体是一种适当的软件范式(software paradigm),可用它来开发像因特网(Internet)这种巨大的开放的分布式系统所体现的各种可能性。尽管在开发因特网的潜在能力方面,多行为体系统在一定程度上具有关键作用,但是多行为体系统可以做得更多。对于理解和构建(我们或可自然称呼的)广泛的人工社会系统(artificial social systems)而言,多行为体系统看上去是一个自然的比喻。多行为体系统的思想并不局限于单一的应用领域,而是看起来适用于很多不同的应用领域,这与在其之前的对象(objects)类似。”

(二)行为体(agent)及其所处环境的特性

该书第2版在第2章智能行为体的引言写道:“此处给出伍德里奇和詹宁斯1995年给出的定义:行为体(agent)是一个计算机系统(computer system),它处在某个环境中,能在这个环境中自治行动(autonomous action)以实现其设计目标。”这是指前述伍德里奇和詹宁斯的论文《智能agent:理论与实践》中给出的行为体的弱概念中的第一个特性即自治性(autonomy)。

该书第2版图2.1引自拉塞尔和诺维格的《人工智能:一种现代的方法》(1995年第1版),如图6所示。

图6中的文字说明是:“处在环境中的行为体。行为体从环境中获得感知的输入,产生行动(actions)作为输出以影响环境。这种交互作用通常是持续存在、并不终止的。”

该章的引言部分引用了拉塞尔和诺维格的《人工智能:一种现代的方法》1995年第1版的文字,以说明关于行为体处于其中的环境特性的四种分类,具体包括:“(1)可观察的与不可观察的;(2)确定性的与非确定性的;(3)静态的与动态的;(4)离散的与连续的。”

值得注意的是,上述关于行为体处于其中的环境特性的四种分类,在被引的《人工智能:一种现代的方法》2020年第4版中已经拓展为七种分类:“(1)完全可观察的与部分可观察的;(2)单行为体的与多行为体的;(3)确定的与随机的;(4)阵发的与顺序的;(5)静态的与动态的;(6)离散的与连续的;(7)已知的与未知的。”

(三)多行为体系统(MAS)的组成

图7是该书第1版的图6.1,说明多行为体系统的组成情况。图中的文字说明是:“多行为体系统是由一些相互之间交互作用的行为体组成的。为了成功地交互作用,这些行为体需要具备互相合作、协调、磋商的能力,很像我们通常那样。”

九、agent的中译正名及其意义

下面参考必应(Bing)词典(网址是https://cn.bing.com/dict/)的agent释义进行AI相关agent中文译名的选取和正名。必应词典显示,名词agent的“权威英汉双解”释义有下列五种:

①(企业、政治等的)代理人,经纪人:a person whose job is to act for, or manage the affairs of, other people in business, politics, etc;

②(演員、音乐家、运动员、作家等的)代理人,经纪人:a person whose job is to arrange work for an actor, musician, sports player, etc. or to find sb who will publish a writer's work;

③原动力,动因(指对事态起重要作用的人、事物):a person or thing that has an important effect on a situation;

④(化学)剂:a chemical or a substance that produces an effect or a change or is used for a particular purpose;

⑤施事者;施动者;行为主体:the person or thing that does an action (expressed as the subject of an active verb, or in a ‘by phrase with a passive verb).

前文我们已经通过对AI领域的六部(篇)代表性论著的述评,了解在AI领域中agent的背景、含义、特性,知晓agent和MAS的概念、环境、应用。因此,就agent的五种释义与AI领域中agent含义的吻合度分为三种情况:

(1)第⑤种释义“最”吻合,此时agent是指“施事者”“施动者”“行为主体”,就是采取一个行为的人或事物,此时agent表述为一个主动动词的主语,或者表述在有被动动词出现时的“by”短语中。

这里“施事者”的反义词是“受事者”;“施动者”的反义词是“受动者”。“施事者”一词比较不常用;“施动者”一词更不常用。而比“行为主体”更常见的用法是“行为体”;也考虑避免将agent 译为“行为主体”而与“主体”(body)在中文语境下混淆。因此与AI相关agent的译名宜采用“行为体”。

(2)第③种释义与AI领域中的agent“在某种程度上有时”吻合。

(3)第①、②、④这三种释义与AI领域中的agent“不”吻合。因此AI相关agent的译名不可采用与第①、②、④这三种释义相关的译名。

当然也不可采用含义并不准确、可能误导读者的“智能体”。

众所周知,在哲学社会科学各学科的研究中会涉及各该领域的“行为”,如伦理行为、经济行为、心理行为、法律行为等。以AI与法律研究为例,当我们将agent译为“行为体”后,就为AI中agent作为“行为体”在法学研究可能涉及的“法律行为”(act in the law或 juristic act)埋下了循名责实的线索,预留了名正言顺的空间。AI与法律领域中 AI相关的“法律主体”或“拟法律角色”应该是agent。E993D0D0-9E61-492A-BE5A-216212B78122

進行agent中译的正名,既有助于在AI领域本身加深对agent的认识和理解,也有助于在AI与哲学社会科学各学科的交叉研究(包括AI与法律研究)中深入推进,还有助于在更高层次上对agent进行旁通统贯的研究。这就是对AI相关agent的中译进行正名的意义之所在。

参考文献:

[1] 尼尔斯·尼尔森. 人工智能:新综合[M].郑扣根,庄越挺,译,北京:机械工业出版社,2000.

[2] 迈克尔·伍德里奇. 多Agent 系统引论: 第1 版[M].石纯一,等译.北京:电子工业出版社,2003.

[3] 普尔,麦克沃思. 人工智能:计算agent 基础[M]. 译著1,董红斌,等译. 北京:机械工业出版,2015.

[4] 普尔,麦克沃思. 人工智能:计算agent 基础》:第2版[M]. 译著2, 黄智濒,等译. 北京:机械工业出版社,2021.

[5] 司马贺. 人工科学:复杂性面面观[M]. 武夷山,译. 上海:上海科技教育出版社,2004 .

[6] 钟义信. 高等人工智能原理:观念·方法·模型· 理论[M]. 北京:科学出版社,2014.

[7] 钟义信. 机制主义人工智能理论[M]. 北京:北京邮电大学出版社,2021.

[8] 肖晴. 多作用体系统的研究现状[J]. 控制与决策,1997,12(S1):391-402.

[9] 廖强. 基于多作用体的FMS 调度仿真系统[J].计算机仿真,1998,15(4):35-38.

[10] 徐英瑾. 心智、语言和机器——维特根斯坦哲学和人工智能科学的对话[M]. 北京:人民出版社,2013.

[11] 徐英瑾. 人工智能哲学十五讲[M]. 北京:北京大学出版社,2021.

[12] 黄欣荣. 复杂性科学方法及其应用[M]. 重庆:重庆大学出版社,2012:50.

The Rectification of Chinese Translation of AGENT in AI

and Its Legal Significance

Shou Bu

(Shanghai Jiaotong University Law School, Shanghai 200030, China)

Abstract: There is no consensus on the Chinese translation of the AGENT in Artificial Intelligence, which limits the depth of research. Reviewing the era background of the emergence of AGENT in AI, summarizing the translation of AGENT in AI in the Chinese context, examining in detail the descriptions of AGENT in several classic AI works in English, and thinking about the reasons for the rectification of Chinese translation of AGENT. It can be determined that the AGENT should be translated as "xingweiti"(doer or actor). The AGENT should be the "subject" of AI's "action" in each field involved in the crossover study between AI and various disciplines of philosophy and social sciences. Therefore, the AI-related "action" subject, that is, the "legal subject" involved in the crossover study of AI and law, is the AGENT. This rectification is to crossover study the "action" of AGENT in AI and law, to bury the clues of the name, so as not to be unjustifiable. It not only helps to deepen the understanding of AGENT in the field of AI itself, but also helps to further promote the cross research of AI and law, and also helps to achieve mastery through a comprehensive study on AGENT at a higher level.

Keywords: agent; xingweiti; shishizhe; shidongzhe; zhinengtiE993D0D0-9E61-492A-BE5A-216212B78122

- 科技与法律的其它文章

- On the Application of the Principle of Exhaustion of Distribution Rights in the Network Environment: A Review of European and American Adjudication Positions and China's Approach

- The Uninterpretability of Artificial Intelligence Algorithms: Risks, Causes, and Mitigation

- Determination of Generic Name of Commodities with Geographical Features: Confusion and Ways Out

- 论智能投顾的科技监管进路:困境与破壁

- 网络转载摘编法定许可的理论证成及实现进路

- 人工智能生成成果的法律定性