融合2D和3D卷积神经网络的无参考 立体图像质量评价

贠丽霞 李朝锋

摘要:为将图像处理技术更好地应用在智能交通中,发挥立体图像质量评价方法的作用,提出一种融合2D和3D卷积神经网络(convolutional neural network, CNN)的立体图像质量评价方法。该模型结合2DCNN与3DCNN两个通道;将独眼图输入2DCNN通道,提取双目竞争相关特征;将左视图、右视图、和图像和差图像输入3DCNN通道,通过3D卷积提取双目之间联系的相关特征;应用全连接层,将两个通道提取的特征融合并进行回归分析构建关系模型。在公开的LIVE 3D Phase Ⅰ和LIVE 3D Phase Ⅱ上的实验结果表明,所提方法与人类的主观感知保持高度一致。

关键词: 无参考立体图像; 质量评价; 卷积神经网络(CNN); 和图像; 差图像; 独眼图

中图分类号: U495; TP31941文献标志码: A

Noreference stereoscopic image quality assessment based on

2D and 3D convolutional neural network

Abstract: In order to better apply the image processing technology to intelligent transportation and play the role of the stereoscopic image quality assessment method, a stereoscopic image quality assessment method integrating 2D and 3D convolutional neural network (CNN) is proposed. In the model, the two channels of 2DCNN and 3DCNN are combined; the cyclopean images are input into the 2DCNN channel to extract the related binocular competition features; the left view, right view, summation and difference images are input into the 3DCNN channel to extract the related binocular connection features through 3D convolution; the full connection layer is applied to fuse the features extracted from the two channels and conduct regression analysis to construct the relationship model. Experimental results on the open LIVE 3D Phase I and LIVE 3D Phase II show that the proposed method is highly consistent with human subjective perception.

Key words: noreference stereoscopic image; quality assessment; convolutional neural network (CNN); summation image; difference image; cyclopean image

引言

越来越多的学者提出通过智能交通来缓解城市交通压力,而图像处理技术在智能交通系统中发挥着重要作用。利用图像处理技术再现性强、处理精度高、适用面广、灵活性高等优点,实时采集路况信息、识别车牌、跟踪车辆动态、抓拍违章现象等,能够实现对交通的科学化、现代化、高效化管理。当前基于双目视觉的图像技术(也就是立体图像)已经开始用到交通领域,如车辆间距的测量、车辆尺寸的测量、智能导航定位、障碍物识别与定位、交通标识测距等,而智能交通系统需要更为先进的立体图像处理技术。对于这些技术而言,立體图像质量评价(stereoscopic image quality assessment, SIQA)方法的运用是不可或缺的,但是SIQA方法还存在较多的问题。立体图像在采集、传输、处理和显示过程中,会发生各种失真,这就迫切需要对3D图像和视频内容的质量进行监控[1]。立体视觉体验是衡量人类对立体图像内容感知的重要指标之一,可以分为主观评价和客观评价。主观评价虽然准确有效,但耗时费力,难以应用于实时场景[2],因此,研究对立体图像质量的客观评价非常有必要。

全参考立体图像质量评价(full reference stereoscopic image quality assessment, FRSIQA)使用参考图像得全部信息,通过比较两组图像之间的相似性等,可以更准确获得失真立体图像对的质量。[37]相比较而言,无参考立体图像质量评价(no reference stereoscopic image quality assessment, NRSIQA)不使用原始图像,更符合实际需要,更具有实际应用前景,也更具有挑战性。[811]AKHTER等[12]提出一种将人工设计的局部特征和视差信息相结合的NRSIQA方法。CHEN等[13]利用独眼图的2D特征和深度图的3D特征建立模型,用于预测立体图像对的感知质量。ZHOU等[14]设计了一个基于双目融合和极限学习机的NRSIQA方法。YANG等[15]使用深度感知图量化立体图像的深度特征,并考虑双目特征,使用深度信念网络对图像质量进行评价。LI等[16]提出一种基于视觉感知和注意力机制的NRSIQA方法。该模型将图像显著性与临界可见偏差(just noticeable distortion,JND)相结合,对从左视图和右视图中提取的全局和局部特征进行加权,然后基于支持向量回归(support vector regression,SVR)模型来学习立体图像的质量。LIU等[17]提取与图像质量相关的特征,包括和差信号熵的双目特征和颜色统计等单目特征,利用SVR模型构建特征与质量得分之间的映射模型。

近年来,卷积神经网络(convolutional neural network, CNN)在计算机视觉和图像处理的许多应用中表现出了优异的性能。与传统的图像处理方法相比,CNN可以通过优化网络参数自动学习与目标密切相关的深层视觉特征,而不是使用手工制作的特征。CNN的主要优点是可以直接输入图像,然后在训练过程中将特征学习与质量回归相结合。田维军等[18]对左、右视图提取单目特征,对独眼图提取双目特征,然后用深度信念网络训练所得特征,预测立体图像的质量分数。KANG等[19]提出2D图像的CNN模型,学习图像块的质量特征,获得其视觉质量,然后将所有图像块的质量分数加权平均,计算出图像的客观得分。LI等[20]利用ImageNet模型预先训练的结构和权重,对网络进行微调,修改最后几层结构,回归得到图像客观的质量分数。LV等[21]建立了基于深度神经网络和双目自相似指数的立体图像质量预测模型,将这两部分特征融合,预测得到立体图像的质量。SUN等[22]使用CNN了解更深入的图像质量感知结构,并删除不显著局部图像的相关特征,然后将保留的显著特征融合,最终回归获得质量分数。

立体图像的失真可以分为对称失真和非对称失真。非对称失真可能是不同程度和不同类型的失真,这对立体图像的质量有很大的影响。另外,与平面图像质量评价方法不同,SIQA需要扩展深度感知维度,研究左、右视图之间的双目视觉机制,这也是目前研究的难点。本文尝试用2DCNN与3DCNN相结合的模型来解决这一难题。其中,3DCNN模型在许多研究中都被证明可以有效获得多张图像之间的相关性,例如:ZHANG等[23]提出一种用于心理负荷评估的3DCNN结构,从空间、光谱、时间三个维度学习脑电特征;考虑到视频在时间上的连续性,YANG等[24]采用3DCNN模型提取局部时空特征,对立体视频质量进行评价;YANG等[25]利用HIS空域和频域之间的相关性,设计了一种基于多尺度小波和3DCNN的高光谱图像超分辨率重建方法。这些不同方向的研究说明,3DCNN可以找到多种特征之间的联系,是一种非常有效的解决此类问题的方法。

1基于CNN的NRSIQA方法

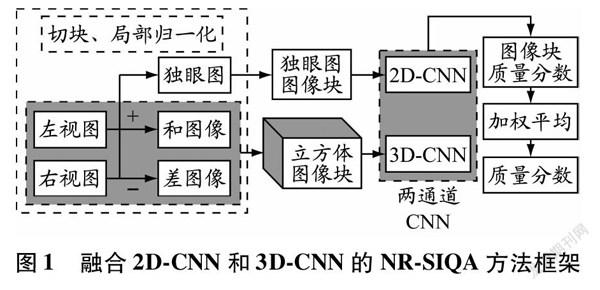

本文提出一种融合2DCNN和3DCNN的NRSIQA方法,框架见图1。对于立体图像的左、右视图,首先计算和图像、差图像和独眼图,然后用CNN进行切块和局部归一化运算。利用两通道CNN模型预测图像块的质量分数,其中独眼图作为2DCNN通道的输入,而由左视图、右视图、和图像和差图像组成的立方体作为3DCNN通道的输入。最后,对全部图像块的质量分数加权平均得到失真立体图像的客观质量分数。采用3DCNN模型除提取左、右视图之间的联系外,本文还考虑“双目和差理论”[26],即将双眼获得的信息转换为不相关的和差信号,再向前传输,使3DCNN能够获得更多维度的信息。

1.1独眼图

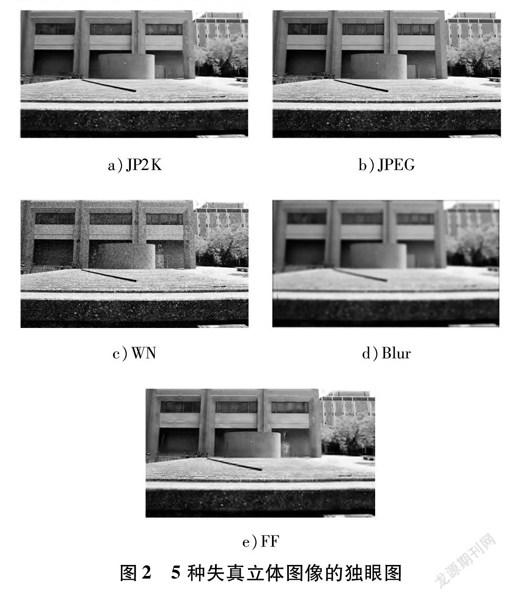

人眼观看外部世界时,人眼视觉系统会通过复杂的融合过程将左、右眼捕捉到的画面合成融合图,从而形成立体视觉,这个融合图被称为独眼图。而融合过程中,双眼获得的视觉信息会出现“双目竞争”现象。本文使用文献[4]基于SSIM的立体视差估计算法计算独眼图:

(1)

式中:C表示独眼图;IL和IR分别为左视图和右视图;d为视差;WL和WR是根据Gabor滤波器计算得到的权重。如图2所示,根据式(1)计算得到5种失真立体图像的独眼图,失真类型分别是JP2K(JPEG 2000)、JPEG、WN(White Noise)、Blur(Gaussian Blur)、FF(FastFading)。

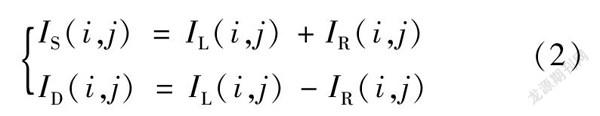

1.2和差图像

文献[27]提出视觉系统有一个独立的自适应双目和差通道,以实现双目信息的有效传输。在生理学层面,解释了和通道和差通道的信号是多路复用的,每个V1神经元接收这两个通道中信号的加权和。人类视觉系统能够感知视差,并将其转换为深度信息,因为大脑中反映的图像是3D图像,而差异图像主要显示物体的深度和轮廓信息,所以3DCNN从立体图像的和图像、差图像中提取質量特征来预测图像质量。和图像和差图像计算式为(2)式中:IS和ID分别表示和图像和差图像。图3给出了一立体图像对的和图像和差图像示例。由图3可知,和图像和差图像更多体现的是立体图像的深度信息和物体的轮廓信息。

1.33DCNN模型

一般来说,CNN模型结构首先交替使用卷积层和池化层来处理输入信息,然后使用全连接层来获得特征与目标之间的映射关系。在2DCNN中,卷积层和池化层只能提取二维图像的特征,而不能自动获取立体图像之间的关联信息。3D卷积和3D池化可以提取不同图像的特征,这正是立体图像所需要的。因此,本文在2DCNN通道的基础上增加3DCNN通道,以更好地完成立体图像质量评价任务。

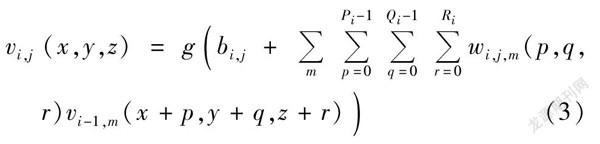

CNN中的卷积运算是输入数据与多个核函数之间的一种特殊的线性运算,用于生成特征图。对于立体图像,3D卷积在2D卷积的基础上增加了左视图与右视图之间关联的深度等信息特征,第i层第j个特征图在(x,y,z)位置处的值计算式为

(3)

式中:g(·)表示非线性激活函数;bi,j为当前特征图的偏置;wi,j,m(p,q,r)为第m个特征图的卷积核在(p,q,r)位置处的值。

1.4网络参数

图4是本文提出的由2DCNN通道和3DCNN通道组成的两通道CNN模型。2DCNN通道的输入是独眼图的图像块,3DCNN通道的输入是由左视图、右视图、和图像和差图像等4种图像的图像块组成的立方体。将图像切块主要是为了解决立体图像质量评价数据库中数据量不足和输入图像大小不一致这两个问题。本文将图像切成32×32大小的图像块,并进行归一化处理,每个图像块的标签都与原图的标签相同。2DCNN通道与3DCNN通道结构类似,都包含5个卷积层、3个池化层和2个全连接层;采用向量拼接的方式融合两个通道最后的全连接层,然后连接1个全连接层,最终得到图像块的质量分数。

本文所提出的模型参数设置见表1。另外,卷积过程中采用了填充处理,使卷积层的输入与输出大小一致。所有卷积层和全连接层的激活函数均采用ReLU。

2实验及分析

21数据库及性能指标

本文使用两个公开的数据库来验证算法的有效性,即LIVE 3D Phase Ⅰ[28]和LIVE 3D Phase Ⅱ[4]。LIVE 3D Phase Ⅰ包含20对原始图像和365对原始图像的失真图像(都是对称失真),其中:JP2K、

JPEG、WN和FF类失真图像各80对,Blur类失真图像45对。LIVE 3D Phase II包含8对原始图像和360对失真图像,失真类型与LIVE 3D Phase Ⅰ的相同,其中120对失真图像是对称失真,240对失真图像是非对称失真。

在实验中,采用了常用的3个性能指标:斯皮尔曼等级相关系数(Spearman rank order correlation coefficient, SROCC)、皮尔逊线性相关系数(Pearson linear correlation coefficient, PLCC)、均方根误差(root mean square error, RMSE)。当SROCC和PLCC越接近1,RMSE越接近0时,客观评价效果越好。在本文实验中,采用文献常用的方法,随机选取80%的失真图像作为训练集,其余20%的失真图像作为测试集。取100次随机实验结果的中位数作为最终结果。

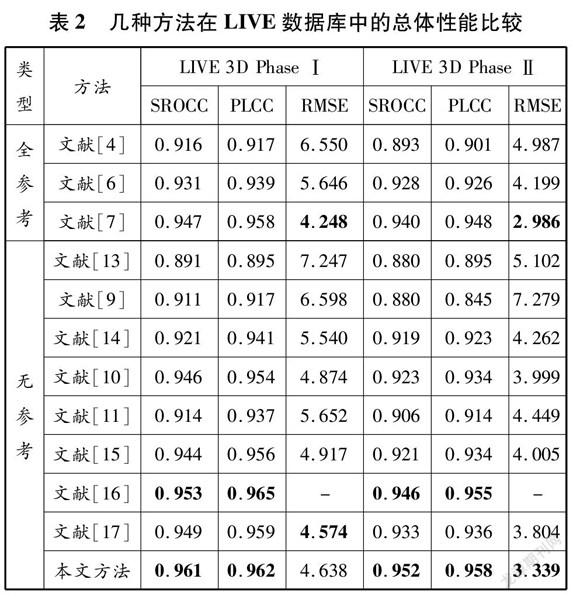

2.2总体性能分析

表2展示了本文提出的方法与其他12种方法的性能比较,其中包括3种FRSIQA方法(文献[4,67])和8种NRSIQA方法(文献[911,1317])。SROCC、PLCC和RMSE在LIVE 3D Phase Ⅰ和LIVE 3D Phase Ⅱ数据库中最好的两个结果以粗体显示。从表2可以看出,本文提出的模型在两个数据库中都取得了很好结果,SROCC和PLCC都在095以上。虽然文献[16]的方法也表现出了很好的效果,在LIVE 3D Phase Ⅰ中的PLCC比本文方法的高,但是在两个数据库中的SROCC都比本文方法的低。采用FRSIQA方法时,文献[7]的RMSE结果最优,但是SROCC和PLCC相对于本文方法较低。基于以上分析,本文提出的方法在两个数据库中都具有竞争优势,证明该模型能够有效地预测立体图像的质量。

2.3不同失真类型的结果分析

为更准确地评价模型的性能,列出不同类型失真图像在LIVE 3D Phase Ⅰ和LIVE 3D Phase Ⅱ数据库中的SROCC和PLCC,并加粗标注每类失真图像SROCC最优的2个结果,见表3和4。由表3和4可以看出,本文方法在SROCC指标上有6次排在前两位,在PLCC指标上有7次排在前两位,说明本文方法总体上优于其他11种方法。数据分析表明,本文方法在对称失真和非对称失真立体图像质量评价上均与人类主观感知具有较高一致性,可以很好地模拟人类视觉系统评测对称和非对称失真的立体图像。图5是本文提出的方法在LIVE 3D Phase Ⅰ和LIVE 3D Phase Ⅱ數据库中的预测结果和主观结果的散点图,横轴表示差异平均意见得分(differential mean opinion score, DMOS),纵轴表示预测的DMOS,曲线为拟合曲线,散点与曲线之间的距离越小,说明性能越好。从图5可以看出,本文提出的方法与人类主观评价具有高度的一致性。

2.4对比实验的性能比较

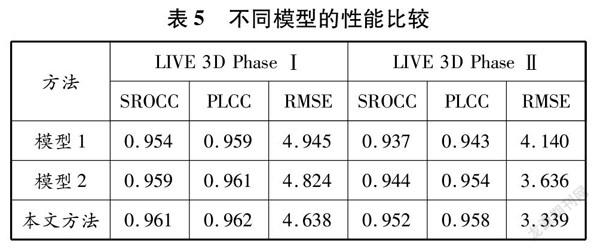

为进一步分析2DCNN和3DCNN在模型中起到的作用,将只有2DCNN与只有3DCNN的网络性能进行对比实验,结果见表5。在表5中:模型1表示2DCNN单通道网络模型,即2DCNN通道的第10层全连接层直接输出结果;模型2表示3DCNN单通道网络模型,即3DCNN通道的第10层全连接层直接输出结果。从实验结果可以看出:与模型1和模型2相比,本文方法的性能最好,说明2DCNN和3DCNN提取的特征具有互补性;与模型1相比,模型2性能更优,说明3DCNN确实能更好地表达立体图像的质量特征。

3结论

本文提出一种结合2DCNN和3DCNN的无参考立体图像质量评价(NRSIQA)模型,该模型能够避免传统方法依靠人类经验提取特征的复杂过程。本文设计的2DCNN通道输入独眼图能很好地模拟双目竞争,而3DCNN通道主要表征立体图像对之间相互作用产生的深度等感知效果,其中引入和差图像也是为了更加有效地体现深度感觉。结果表明,本文提出的模型在LIVE立体图像数据库中都取得了令人满意的结果,与人眼主观评价具有较高的一致性。

参考文献:

[1]XING L Y, YOU J Y, EBRAHIMI T, et al. Assessment of stereoscopic crosstalk perception[J]. IEEE Transactions on Multimedia, 2012, 14(2): 326337. DOI: 101109/TMM.20112172402.

[2]KIM T, KANG J, LEE S, et al. Multimodal interactive continuous scoring of subjective 3D video quality of experience[J]. IEEE Transactions on Multimedia, 2014, 16(2): 387402. DOI: 101109/TMM.20132292592.

[3]BENOIT A, LE CALLET P, CAMPISI P, et al. Quality assessment of stereoscopic images[J]. EURASIP Journal on Image and Video Processing, 2008: 659024. DOI: 101155/2008/659024.

[4]CHEN M J, SU C C, KWON D K, et al. Fullreference quality assessment of stereopairs accounting for rivalry[J]. Signal Processing: Image Communication, 2013, 28: 11431155. DOI: 101016/j.image.201305006.

[5]LIN Y H, WU J L. Quality assessment of stereoscopic 3D image compression by binocular integration behaviors[J]. IEEE Transactions on Image Processing, 2014, 23(4): 15271542. DOI: 101109/TIP.20142302686.

[6]SHAO F, CHEN W T, JIANG G Y, et al. Modeling the perceptual quality of stereoscopic images in the primary visual cortex[J]. IEEE Access, 2017, 5: 1570615716. DOI: 101109/ACCESS.20172733161.

[7]LI S M, HAN X, CHANG Y L. Adaptive cyclopean imagebased stereoscopic imagequality assessment using ensemble learning[J]. IEEE Transactions on Multimedia, 2019, 21(10): 26162624. DOI: 101109/TMM.20192907470.

[8]李苗苗, 桑慶兵. 一种基于图像融合的无参考立体图像质量评价方法[J]. 光学技术, 2017, 43(1): 2532. DOI: 1013741/j.cnki.111879/o4201701006.

[9]APPINA B, KHAN S, CHANNAPAYYA S S. Noreference stereoscopic image quality assessment using natural scene statistics[J]. Signal Processing: Image Communication, 2016, 43: 114. DOI: 101016/j.image.201602001.

[10]YANG J C, SIM K, JIANG B, et al. Noreference stereoscopic image quality assessment based on hue summationdifference mapping image and binocular joint mutual filtering[J]. Applied Optics, 2018, 57(14): 39153926. DOI: 101364/AO.57003915.

[11]YUE G H, HOU C P, JIANG Q P, et al. Blind stereoscopic 3D image quality assessment via analysis of naturalness, structure, and binocular asymmetry[J]. Signal Processing, 2018, 150: 204214. DOI: 101016/j.sigpro.201804019.

[12]AKHTER R, PARVEZ SAZZAD Z M, HORITA Y, et al. Noreference stereoscopic image quality assessment[C]∥The Society of PhotoOptical Instrumentation Engineers. SPIE, 2010, 7524: 112. DOI: 101117/12838775.

[13]CHEN M J, CORMACK L K, BOVIK A C. Noreference quality assessment of natural stereopairs[J]. IEEE Transactions on Image Processing, 2013, 22(9): 33793391. DOI: 101109/TIP.20132267393.

[14]ZHOU W J, YU L, ZHOU Y, et al. Blind quality estimator for 3D images based on binocular combination and extreme learning machine[J]. Pattern Recognition, 2017, 71: 207217. DOI: 101016/j.patcog.201706008.

[15]YANG J C, ZHAO Y, ZHU Y H, et al. Blind assessment for stereo images considering binocular characteristics and deep perception map based on deep belief network[J]. Information Sciences, 2019, 474: 117. DOI: 101016/j.ins.201808066.

[16]LI Y F, YANG F, WAN W B, et al. Noreference stereoscopic image quality assessment based on visual attention and perception[J]. IEEE Access, 2019, 7: 4670646716. DOI: 101109/ACCESS.20192909073.

[17]LIU Y, YAN W Q, ZHENG Z, et al. Blind stereoscopic image quality assessment accounting for human monocular visual properties and binocular interactions[J]. IEEE Access, 2020, 8: 3366633678. DOI: 101109/ACCESS.20202974006.

[18]田维军, 邵枫, 蒋刚毅, 等. 基于深度学习的无参考立体图像质量评价[J]. 计算机辅助设计与图形学学报, 2016, 28(6): 968975.

[19]KANG L, YE P, LI Y, et al. Convolutional neural networks for noreference image quality assessment[C]∥IEEE Conference on Computer Vision and Pattern Recognition. IEEE, 2014: 17331740. DOI: 101109/CVPR.2014224.

[20]LI Y M, PO L M, FENG L T, et al. Noreference image quality assessment with deep convolutional neural networks[C]∥IEEE International Conference on Digital Signal Processing. IEEE, 2016: 685689. DOI: 101109/ICDSP.20167868646.

[21]LV Y Q, YU M, JIANG G Y, et al. Noreference stereoscopic image quality assessment using binocular selfsimilarity and deep neural network[J]. Signal Processing: Image Communication, 2016, 47: 346357. DOI: 101016/j.image.201607003.

[22]SUN G M, SHI B F, CHEN X D, et al. Learning local qualityaware structures of salient regions for stereoscopic images via deep neural networks[J]. IEEE Transactions on Multimedia, 2020, 22(11): 29382949. DOI: 101109/TMM.20202965461.

[23]ZHANG P B, WANG X, ZHANG W H, et al. Learning spatialspectraltemporal EEG features with recurrent 3D convolutional neural networks for crosstask mental workload assessment[J]. IEEE Transactions on Neural Systems and Rehabilitation Engineering, 2019, 27(1): 3142. DOI: 101109/TNSRE.20182884641.

[24]YANG J C, ZHU Y H, MA C F, et al. Stereoscopic video quality assessment based on 3D convolutional neural networks[J]. Neurocomputing, 2018, 309: 8393. DOI: 101016/j.neucom.201804072.

[25]YANG J X, ZHAO Y Q, CHAN J, et al. A multiscale wavelet 3DCNN for hyperspectral image superresolution[J]. Remote Sensing, 2019, 11: 122. DOI: 103390/rs11131557.

[26]MAY K A, LI Z P, HIBBARD P B. Perceived direction of motion determined by adaptation to static binocular images[J]. Current Biology, 2012, 22(1): 2832. DOI: 101016/j.cub.201111025.

[27]MAY K A, LI Z P. Efficient coding theory predicts a tilt aftereffect from viewing untilted patterns[J]. Current Biology, 2016, 26(12): 15711576. DOI: 101016/j.cub.201604037.

[28]MOORTHY A K, SU C C, MITTAL A, et al. Subjective evaluation of stereoscopic image quality[J]. Signal Processing: Image Communication, 2013, 28(8): 870883. DOI: 101016/j.image.201208004.

(編辑贾裙平)

收稿日期: 20210117修回日期: 20210423

基金项目: 国家自然科学基金(61771223)

作者简介: 贠丽霞(1994—),女,河北张家口人,硕士研究生,研究方向为图像质量评价,(Email)1055064810@qq.com;

李朝锋(1971—),男,安徽庐江人,教授,博导,博士,研究方向为人工智能、机器学习和图像处理,(Email)cfli@shmtu.edu.cn