面向印花图案检索的特征融合方法研究

殷业瑜,高家全,李 莹

(南京师范大学计算机与电子信息学院/人工智能学院,江苏 南京 210023)

自20世纪末,关于图像检索的研究就陆续展开. 一般来看,图像检索根据检索形式可分为两类:基于文本的图像检索[1](Text Based Image Retrieval,TBIR)和基于内容的图像检索[2](Content Based Image Retrieval,CBIR). TBIR是通过文字信息检索与此关联的图片资源,CBIR则是直接通过用户上传的图片检索关联图片. TBIR的优点是查询方便快捷,缺点是其对图片的描述比较粗略,检索结果往往不够精确,用户需要浏览大量的图片才能最终筛选出自己想要的图片. 因此,检索性能更优的CBIR逐渐成为主流检索方法.

CBIR检索技术主要包含特征提取、相似性度量、重排序3个核心步骤. 特征提取是提取图像的代表性特征以降低图像的维度,通常以1个特征向量的形式表示1张图片;度量学习是利用度量函数计算图像特征之间的距离,得到特征之间的相似度. 在训练网络时,将其作为损失函数,使得相似图像之间的距离更近,不相似的图像距离更远;而重排序则是利用额外的度量方式,进一步修正检索结果,从而提升检索效果.

图像特征提取的好坏会直接影响图像检索精度. 在CBIR发展早期,常用的底层特征包括颜色特征、纹理特征、形状特征以及空间关系特征等,这些底层特征通常局限性较强,往往只关注图像的某一方面特征. 为了弥补底层特征的不足,人们提出了直接通过手工设计的图像特征,主要有SIFT[3]、GIST[4]以及HOG[5]等,这些特征在一定程度上弥补了早期底层特征的缺陷,但是随着图像数量的增多以及图像内容的多样化,手工特征也难以满足人类对于图像表示的需求,这些低层特征难以表示图像的高层语义.

随着深度学习的大放异彩,研究者在各类图像数据集中训练网络,利用卷积神经网络(Convolutional Neural Network,CNN)学习并提取图像特征. CNN上的参数通常通过训练海量的数据来学习,训练完成后各神经网络层得到最优的参数,从而提取到优异的图像特征. 利用深度CNN提取的特征在理解图像语义方面远胜于手工特征,并且可以利用神经网络中的卷积层、池化层以及全连接层等各层参数的设置来调整模型的拟合能力,使提取到的图像特征更科学,更能代表图片的高层语义. 从2012年Krizhevsky等[6]提出AlexNet模型后,研究者为了得到更优异的、更深层次的特征,设计的网络越来越深,如GoogLeNet[7]、VGG[8]等. 但是随着网络层次的加深,训练难以收敛,检索的精度反而开始下降,故而He等对CNN进行改进,提出了ResNet[9-13]等模型解决网络的退化问题.

此外,随着图像检索在各个领域上的应用愈发广泛,对于检索的要求也随之提高. 单一特征仅仅从图像的一方面特点衡量图像,无法准确地描述出不同图像之间的区别. 因此,通过单一特征的图像检索无法满足精确检索的要求,针对印花图案的检索则更为复杂. 为了解决印花图案检索问题,本文提出一种通过融合多个特征以此表征图像进行检索的方案,即从多个特征中选取具有互补性的特征,利用合理的方法进行融合. 实验证明,通过融合形成的新特征可以从多个角度衡量图像,具有更好的表述力.

1 基于特征融合的印花图案检索模型PGLN

本节将详细描述基于特征融合的印花图案检索模型PGLN的网络层次结构和训练流程.

图1展示了本文提出的基于特征融合的印花图案检索模型PGLN. 模型利用卷积神经网络学习深度全局和局部特征,结合GeM池化和注意力机制检索相似图像. 第一阶段使用全局特征进行检索,以有效地选择最相似的图像. 第二阶段使用局部特征对检索结果进行重排序,从而进一步提高系统的检索精度.

图1 PGLN模型结构Fig.1 The structure of PGLN model

1.1 全局特征提取

ResNet网络结构能够有效缓解梯度消失的问题,其中ResNet-50模型更是兼顾准确性和运算量. 鉴于此,本文的PGLN网络结构使用ResNet-50作为主干网络.

给定一幅图像,本文利用ResNet-50进行特征提取,得到两个特征图:S∈RHS×WS×CS和D∈RHD×WD×CD,分别表示较浅的和较深的激活图,其中H、W、C分别表示通道的高度、宽度和数量.对于常见的卷积网络,HD≤HS,WD≤WS和CD≥CS,越深层次的特征图越小,通道数量更多,sh,w∈RCS和dh,w∈RCD表示h,w位置的特征图.对于一般的网络设计,这些特征值都是非负的,因为它们是在ReLU非线性之后得到的.

为了将深度激活图聚合为一个全局特征,本文采用了广义平均池(GeM),它有效地加权了每个特征的贡献.全局特征学习的另一个关键组成部分是对聚合表示进行白化;本文通过一个全连接层F∈RCF×CD将它集成到本文的模型中,其学习到的偏置为bF∈RCF.这两个部分整合成一个总结了整个图像的判别内容的全局特征g∈RCF:

(1)

1.2 局部特征提取

对于局部特征,只选择相关的区域进行匹配是很重要的.这可以通过增加注意模块M来实现,该模块的目标是预测具有判别性的局部区域.设为A=M(S),其中M是一个小的卷积网络,A∈RHS×WS表示与S特征相关联的注意力得分图.

此外,CNN网络提取出的图像局部特征数以万计,容易导致维度过高,所以必须对它们进行紧凑的表示. 为此,本文增加一个小的卷积自编码器(AE)模块,它负责学习合适的低维表示.局部描述符为L=T(S),其中L∈RHS×WS×CT,T是自编码器的编码部分,对应为一个带有CT滤波器的的1×1卷积层.与S相反,局部描述符L不被限制为非负的.

1.3 损失函数

对于全局特征的学习,本文采用一个结合全局损失和局部损失的新损失函数,融合了softmax loss和cross-entropy loss. 此外还添加了ArcFace margin,它通过诱导较小的类内方差,在全局特征学习方面表现出了良好的效果.

经Arcface调整后的余弦相似度可以表示为:

(2)

式中,u为余弦相似度,m为ArcFace margin,c表示对应标签是否为ground-truth类,值为1表示是同一类,值为0则非同一类.在这种情况下,用softmax归一化计算的cross-entropy loss可以表示为:

(3)

为了训练局部特征,本文使用了两个损失函数.首先,第一个是MSE loss损失,使得自编码器良好地重建S.以S′=T′(L)作为S的重构版本,两者维数相同,其中T′为一个带有CT滤波器的的1×1卷积层,然后是ReLU.损失如式4所示:

(4)

第二个是cross-entropy loss,促使注意力模块选择更具判别性的局部特征,通过注意力权重ah,w对重构特征S′进行池化,如式(5)所示:

(5)

然后使用一个标准的softmax-cross-entropy loss:

(6)

式中,vi和bi分别指第i类的分类器的权重和偏差,k为各真实类别.该损失函数的目的是为了使判别性特征的注意权重变大.综上,PGLN网络结构的损失为Lg+λLr+βLa.

考虑到CNN网络提取出的图像局部特征数以万计,容易导致维度过高,所以必须对图像特征进行紧凑的表示. 为此,本文增加一个小的AE卷积自编码器模块,它负责学习合适的低维表示.

L=T(S),L∈RHS×WS×CT,

(7)

式中,T是自编码器的编码部分,对应为一个带有CT滤波器的的1×1卷积层.与S相反,局部描述符L不被限制为非负的.

2 实验结果与分析

为了衡量PGLN模型在印花图案检索任务上的检索效果,验证特征融合方式的有效性,本文采用 Pattern 数据集中的Design设计图子集进行实验,将PGLN模型与局部特征提取算法、全局特征提取算法以及特征融合算法分别进行了比较.

2.1 特征提取算法

图像检索主要包含特征提取、相似性度量、重排序这3个核心模块. 在特征提取阶段,提取出的特征优劣将直接影响图像检索的精度. 为了提高图像检索性能,需要两种类型的图像表示:全局特征和局部特征. 一方面,全局特征通常被称为“全局描述符”,它通常以一种紧凑的表示总结图像的内容. 另一方面,局部特征包含特定图像区域的描述符和几何信息. 总地来说,全局特征的查全率更高,而局部特征的查准率更高. 全局特征可以学习非常不同姿态的相似性,而局部特征无法找到相应关系;与此同时,基于局部特征的几何验证所提供的分数通常能很好地反映图像相似性,比全局特征距离更可靠. 然而,这两种特征在特征表示方面具有显著差异,因此,本文采用特征融合方法,克服传统特征提取方法较为片面、底层特征拘泥于图像细节、深层特征只考虑图像整体等局限性.

2.2 实验数据集和实验方法

在实验中,本文采用的数据集为Pattern数据集中的Design设计图子集,图2展示了实验数据集的部分图片.

图2 Pattern数据集中的Design设计图子集Fig.2 A subset of the Pattern data set named Design data set

设计图(Design):包含组成元素、图案风格、排列方式等3种类别标签,共计29种标签,例如花卉、田园风、单独图样等. 数据规模为20 000张图片,主要是由专业设计人员利用CAD软件设计得到的高清设计图. 图片通常较大,大小一般在1M~10M之间,清晰度高.

在实验中,各项基本参数的设置如下:PGLN模型使用的主干网络为ResNet-50,模型由预先训练的ImageNet权重初始化,根据检索任务进行了微调. 其中,从conv4输出中得到较浅的特征映射S作为局部特征,从conv5输出中得到较深的特征映射D作为全局特征.D的通道数是CD=2048;GeM池化使用参数p=3. 之后使用白化全连通层,产生一个维度为2 048的全局特征CF=2048.S的通道数是CS=1024;自动编码器模块学习这个特征映射的降维CT=128.注意力网络M有2个卷积层,卷积核大小为1×1;第一层使用ReLU作为激活函数,第二层使用Softplus作为激活函数. 检索的评价指标,选择平均检索精度mAP,该项指标能够较为全面地反映检索的准确率.

2.3 对比实验分析

实验1:为了验证PGLN算法在印花检索任务上的有效性,我们将PGLN与SIFT、DELF(DEep Local Feature)等局部特征提取算法进行了对比.

目前较为常用的局部特征包括基于手工的传统特征与基于深度学习的局部特征. 其中,传统局部特征提取算法包括SIFT算法、LBP算法等,基于深度学习的局部特征提取包括DELF算法等. 在实验中,本文以Design数据集为例,将这3种局部特征提取算法与PGLN算法进行了对比.

表1 不同局部特征提取算法在Design数据集上的检索结果Table 1 Retrieval results of different local featureextraction algorithms on the Design data set

从表1可以看出,针对Design数据集,SIFT算法、LBP算法的检索精度非常低,分别为48.63%和49.32%. DELF算法的检索精度略高于二者,达到了56.79%. 在该数据集上,PGLN模型的检索精度最高,达到了66.73%. 由此可以看出,一方面,无论是哪种局部特征提取算法,提取出的局部特征往往只能表征图像的局部细节,并没有深入挖掘特征的全局语义信息. 因此,仅使用局部特征提取算法来提取印花图案的特征是远远不够的,本文的PGLN模型则结合了全局特征提取算法,有效提升了检索的精度. 另一方面,Design数据集为Pattern数据集中的设计图子集,图片的内容最为丰富多样且标签数众多,检索的难度较高. 4种算法在该数据集上的检索精度尚未达到工业应用的检索要求.

本文从Design数据集上选取了一张印花图片作为查询图片,对比了几种局部特征提取算法的检索效果,检索结果如图3所示.

图3 不同局部特征提取算法的检索结果Fig.3 Retrieval results of different local feature extraction algorithms

本文选择了一张具有“人”“头像”“三角”“抽象”等4个标签的印花图片作为查询图像,红框内为检索正确的图片. 从图3来看,SIFT算法与LBP算法的检索效果较差,检索出的前5张图片中仅有2张与查询图像相似. 作为深度局部特征提取算法,DELF算法的检索效果要优于SIFT和LBP这两种传统局部特征提取算法,检索出的前5张图片中有3张与查询图像相似. PGLN模型则展现出更为精确的检索效果,检索出的前5张图片中仅有1张与查询图像不相似.

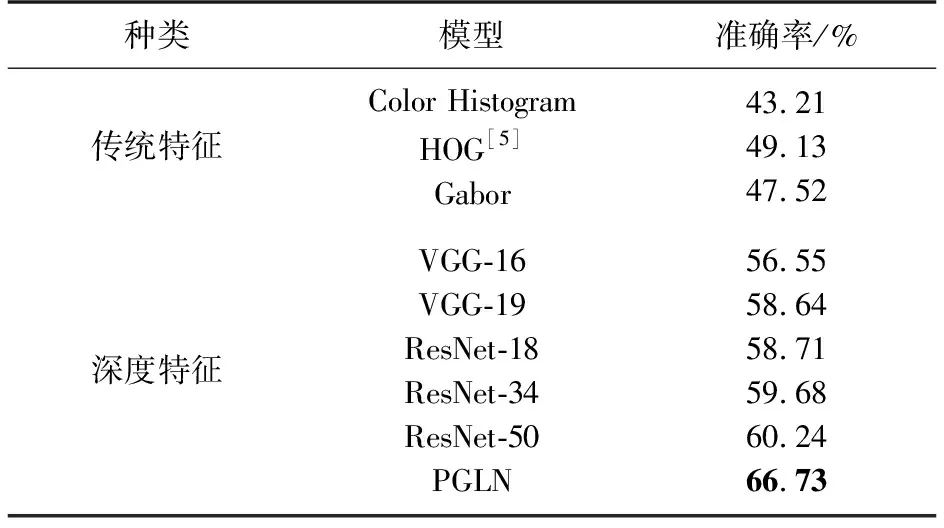

实验2:为了验证PGLN算法相较于全局特征提取算法的优势,我们将PGLN与HOG、VGG、ResNet等全局特征提取算法进行了对比.

常用的全局特征包括传统全局特征和深度全局特征. 传统全局特征包括Color Histogram特征、HOG特征和Gabor特征等. Color Histogram特征体现图像的颜色分布,HOG特征更关注图像中目标的形状轮廓,Gabor特征则常常用来描述图像的全局纹理信息. 深度全局特征包括VGG、ResNet等深度网络模型提取出的图像特征.

表2 不同全局特征提取算法在Design数据集上的检索结果Table 2 Retrieval results of different global featureextraction algorithms on the Design data set

表2为不同全局特征提取算法在Design数据集上的检索结果. 从特征提取方式来看,3种传统全局特征提取算法在Design数据集上的检索精度均未达到50%,VGG、ResNet和PGLN这3种深度全局特征提取算法的检索精度则均在55%以上,其中PGLN模型取得了高达66.73%的检索精度. 因此,深度全局特征提取算法在该数据集上的检索优势极为明显. 同时,深度网络的层数越深,其提取到的全局图像特征可能更具代表性,检索精度也越高.

为了直观地展示不同全局特征提取算法的检索效果,本文选取了一张标签为“文字”“抽象”的印花图片作为查询图像,红框内为检索正确的图片. 图4中,Color Histogram特征的检索效果较差,只检索出了1张与查询图像相似的图片,其余4张图片与查询图片只在颜色分布上较为相似. Gabor特征和VGG-19模型均检索出了2张相似图片,ResNet-50则检索出了3张相似图片. PGLN的检索效果最佳,检索出了 4张相似图片.

实验3:为了证明PGLN算法先用全局特征检索、再用局部特征排序的特征融合策略的有效性,我们将PGLN与目前主流的特征融合方法如FashionNet等进行了对比.

目前主流的特征融合网络包括U-net、FashionNet、HyperNet、ExFuse等,本文在Design数据集上验证了各个网络的性能.

图4 不同全局特征提取算法的检索结果Fig.4 Retrieval results of different global feature extraction algorithms

表3 不同特征融合算法在Design数据集上的检索结果Table 3 Retrieval results of different feature fusionalgorithms on the Design data set

从表3可以看出,PGLN模型在所有的特征融合方法中取得了最高的检索精度. 这表明,先使用全局特征进行常规检索,再使用局部特征对检索结果重排序的特征融合方式针对印花图案检索效果较好.

此外,本文选取了一张印花图片作为查询图像进行了测试,对比了几种特征融合算法的效果.

图5展示了5种特征融合算法的检索结果,红框内为检索正确的图片. 查询图像的标签为“花卉”“田园风”. 从图中可以看出,FPN、FashionNet、HyperNet、ExFuse等算法在印花图案检索任务上取得了一定的效果,检索出的前5张图片中均包含了2~3张正确相似图片;PGLN模型则取得了最优的检索效果,检索出的前5张图片包含了4张正确相似图片. 这表明本文的PGLN特征融合方法在印花图案检索上具有显著的优势,先通过全局特征进行检索,后通过局部特征重排序的方法能够充分利用图像特征,提升检索准确率.

图5 不同特征融合算法的检索结果Fig.5 Retrieval results of different feature fusion algorithms

3 结论

本文针对单一特征对图像的表征能力不足的问题,提出一种融合全局特征和局部特征的网络模型PGLN,即先通过全局特征进行图像检索,再利用局部特征对检索结果进行排序. 介绍了PGLN的网络框架的各部分细节,包括网络的各部分组成、全局特征提取、局部特征提取、损失函数及降维模块. 最后与单一局部特征、单一全局特征以及特征融合等其他特征提取方法进行对比. 结果表明,本文提出的PGLN模型,无论与单一局部特征或全局特征相比,针对印花图案的检索效果都是最佳的. 同时,相比于其他的特征融合方式,本文的融合方式也取得了最优表现,证明了先用全局特征检索、再用局部特征排序的特征融合方法的有效性.