基于异构并行神经网络的语音情感识别

张会云,黄鹤鸣

(1.青海师范大学 计算机学院,西宁 810008;2.藏语智能信息处理及应用国家重点实验室,西宁 810008)

0 概述

语音情感识别(Speech Emotion Recognition,SER)是自动语音识别(Automatic Speech Recognition,ASR)领域的重要研究方向,在人机交互中具有重要作用。随着ASR 技术的快速发展,以计算机、手机、平板等为载体的人工智能(Artificial Intelligence,AI)研究层出不穷。人机交互不再局限于识别特定说话人语音中的单一音素或语句,语音中的情感识别已成为ASR 领域的新兴研究方向。例如:在远程教学中,实时检测学生情绪,能够提高教学质量[1];在移动通信中,增加情感分析功能,能够及时检测客户的情绪变化,并根据这种变化为客户提供更好的服务[2];在医学实践中,实时检测病人情绪能够提供更好的临床治疗[3];在侦察破案中,通过检测情感状态能识破嫌疑人是否撒谎,保证案件顺利进行[4];在电商领域中,通过识别用户情感可以调控流量[5]。总而言之,准确高效地识别语音情感有助于提高人们工作、学习和生活的效率与质量。

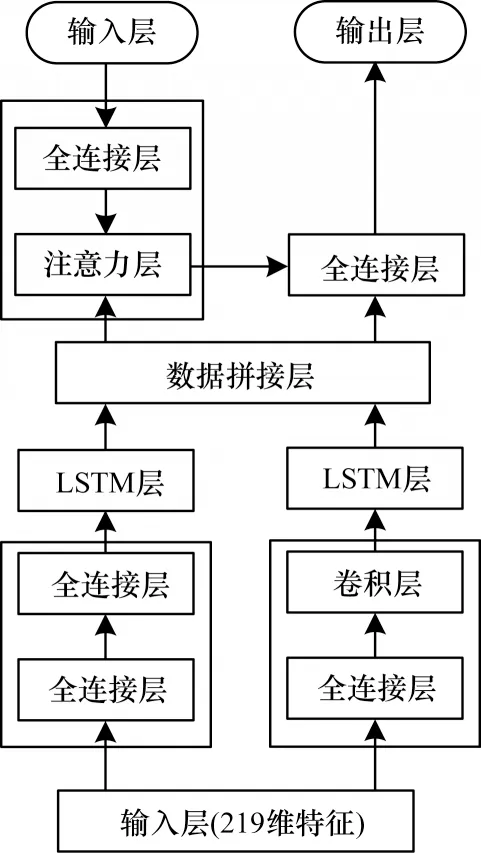

本文建立基于注意力机制的异构并行卷积循环神经网络(Recurrent Neural Network,RNN)模型AHPCL。该模型由2 个异构并行分支和1 个注意力机制构成:左分支由2个全连接层和1个长短时记忆(Long Short-Term Memory,LSTM)层构成,右分支由1 个全连接层、1 个卷积层和1 个LSTM 层构成,注意力机制由1 个全连接层和1 个注意力层构成。通过在EMODB、CASIA、SAVEE 等3 个语音情感数据库上提取音高(Pitch)、过零率(Zero Crossing Rate,ZCR)、梅尔频率倒谱系数(Mel Frequency Cepstrum Coefficient,MFCC)等低级描述符特征,同时计算这些特征的高级统计函数,得到共219维的特征作为输入来评估模型性能。

1 相关工作

SER 是指利用计算机对语音信息进行预处理,提取情感特征,建立特征值与情感的映射关系,从而对情感进行分类[6]。SER 主要包括语料库构建、情感信号预处理、情感声学特征提取以及声学建模4 个环节。在预处理方面,语音情感信号的预处理与语音识别的预处理一样,均需要进行预加重、分帧、加窗、端点检测等操作[7]。情感声学特征提取是SER 中一项极具挑战性的任务,对语音情感的识别严重依赖于语音情感特征的有效性。提取关联度更高的声学特征更有助于确定说话人的情感状态。通常以帧为单位提取语音信息的声学特征,并将全局统计结果作为模型的输入进行情感识别。一般而言,单一特征不能完全包含语音情感的所有有用信息,为了使SER 系统性能达到最优,研究人员通常融合不同特征来提高系统性能。高帆等[8]利用深度受限玻尔兹曼机将韵律特征、谱特征进行融合,并在EMODB 数据库上验证DBM-LSTM 模型的性能。实验结果表明,与传统识别模型相比,DBM-LSTM模型更适用于多特征语音情感识别任务,最优识别准确率提升了11.00%。宋春晓[9]研究了语速、过零率、基频、能量、共振峰、MFCC 等特征在EMODB 数据库上的性能,采用SVM 识别4 类情感时获得了82.47%的准确率。GUO 等[10]提取对数梅尔频谱特征,计算一阶差分和二阶差分,并融合这些统计值作为并行卷积循环神经网络模型的输入,在SAVEE 数据库上取得了59.40%的未加权召回率。

声学模型是SER 系统的核心。在识别过程中,情感特征输入到声学模型,计算机通过相应算法获取识别结果。MIRSAMADI 等[11]利用LSTM 网络提取深度学习特征,在IEMOCAP 数据库上采用SVM识别情感,获得了63.50%的识别准确率。ZHANG等[12]提取了深度学习特征,在SEED 和CK+数据库上采用循环神经网络识别情感,分别获得了89.50%和95.40%的识别准确率。传统LSTM 网络假设当前时间步长的模型状态取决于前一个时间步长的模型状态,该假设限制了网络的时间依赖性建模能力,而TAO 等[13]提出的Advanced-LSTM 网络较好地克服了该限制,能更好地进行时间上下文建模,获得了55.30%的召回率,优于传统LSTM 网络。

2 基于注意力机制的异构并行卷积循环神经网络模型

随着深度学习技术的不断发展,神经网络结构越来越复杂。与已有简单的前馈神经网络相比,RNN 的隐含层之间既有前馈连接又有内部反馈连接[14]。RNN 能较好地处理序列数据,但存在梯度问题,而LSTM 中的门控循环单元能够较好地解决梯度问题,同时门控循环单元也能够对先前的信息进行选择性记忆[15],从而使得网络的预测结果更加准确。因此,本文选择LSTM 提取语音情感的时间序列特征。但由于仅提取时间序列信息并不能很好地表征语音情感,因此同时采用卷积操作提取语音空间信息[16]。通过时间信息和空间信息共同表征语音情感,能使预测结果更理想。此外,注意力机制可以对来自不同时刻的帧特征给予不同关注[17]。

基于此,本文构建基于注意力机制的异构并行卷积循环神经网络模型AHPCL,如图1 所示。该网络模型由2 个异构并行分支和1 个注意力机制构成,其中,左分支包含2 个全连接层和1 个LSTM 层,右分支包含1 个全连接层、1 个卷积层和1 个LSTM 层,注意力机制包含1 个全连接层和1 个注意力层。拼接来自左右2 个分支结构的数据,并在注意力层将拼接后的数据与原始输入数据中的对应元素相乘,将相乘后的结果输入到4 个完全相同的全连接层,最终输入到Softmax 层进行分类。

图1 基于注意力机制的异构并行卷积循环神经网络Fig.1 Heterogeneous parallel convolutional recurrent neural network based on attention mechanism

AHPCL 模型在卷积层的计算如下:

其中,*表示卷积运算;h1表示第一个全连接层的输出;F=[k1,k2,…,k512]表示卷积核;N表示滤波器个数;S表示步长。

AHPCL 模型在注意层的计算如下:

其中:u表示经过注意力机制后第一个全连接层的输出;Fc表示数据拼接层的输出;Multiply(·)表示对应元素的乘积。

3 数据库描述与特征提取

为评估AHPCL 模型的性能,在EMODB、CASIA 及SAVEE 情感数据库上提取低级描述符特征,并计算相关的高级统计函数作为模型的输入。

3.1 数据库

CASIA[18]是由中科院自动化研究所在干净环境下录制的汉语语音情感数据库,包含4 位专业发音人在高兴(Happiness,H)、恐惧(Fear,F)、悲 伤(Sadness,Sa)、愤怒(Anger,A)、惊讶(Surprise,Su)、中性(Neural,N)等6 类情感下演绎的9 600 条情感语音,采样率为16 kHz。目前公开的CASIA 库中包含1 200 条情感语音,每类情感各200 条情感语音。

EMODB[19]是由柏林工业大学在专业录音室录制的德语语音情感数据库,采样率为48 kHz。从40 位说话人中选取10 位(5 男5 女)对10 句德语语句进行情感演绎并录音,包含中性、愤怒、恐惧、高兴、悲伤、厌恶(Disgust,D)、无聊(Boredom,B)等7 类情感,共800 条情感语音,考虑到每条语句的语音自然度,最终选取535 个样本,对上述7 类情感而言,每类情感包含的样 本数量分别为79、127、69、71、62、46、81。

SAVEE[20]是 由4 名演员演绎愤怒、厌恶、恐 惧、高兴、中性、悲伤、惊讶等7 类情感得到的表演型数据库,共480 条情感语音,语音情感数量分布相对平衡,除中性情感以外,其余6 类均有60 条情感语音。

由于上述3 个数据库均未提供单独的训练数据和测试数据,因此本文采用说话人相关(Speaker-Dependent,SD)策略:每类情感的所有样本随机等分为5 份,其中,4 份作为训练数据,1 份作为测试数据。实验重复10 次取均值作为模型的整体性能评估数据。

3.2 特征提取

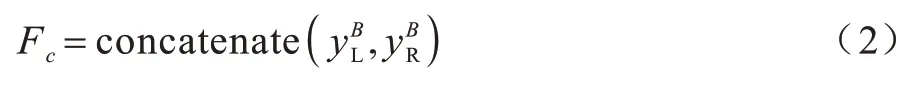

在提取音高、过零率、梅尔频率倒谱系数、幅度(Amplitude)、谱重心(Centroid)、频谱平坦度(Flatness)、色谱图(Chroma)、梅尔谱图(Mel)、谱对比度(Contrast)等低级描述符特征的基础上,计算这些特征的高级统计函数,得到共219 维特征作为AHPCL 模型的输入,所提取与计算的全部特征见表1。

表1 低级描述符与高级统计函数特征Table 1 Low-level descriptors and high-level statistical function features

4 实验与结果分析

在CASIA、EMODB 以及SAVEE 数据库上验证AHPCL 模型性能。首先计算AHPCL 模型在10 次验证中的均值,用于评价模型的整体性能。其次选取AHPCL 模型在10 次验证中所获得的最佳混淆矩阵。最后将AHPCL 模型与已有研究成果进行对比。

4.1 实验设置

实验运行在一台高性能服务器上,CPU 为40 核80 线程,内存为64 GB。使用2 块RTX 2080 Ti GPU进行加速训练。利用深度学习框架Keras和TensorFlow进行模型搭建。采用的优化器(Optimizer)为Adam,激活函数为Leaky ReLU,批处理(Batch_size)大小为32,丢弃率(Dropout)为0.5,迭代周期(Epoch)为100。基于混淆矩阵、准确率、精确率、未加权平均召回率(Unweighted Average Recall,UAR)、F1 得分等指标对模型性能进行评价。

4.2 结果分析

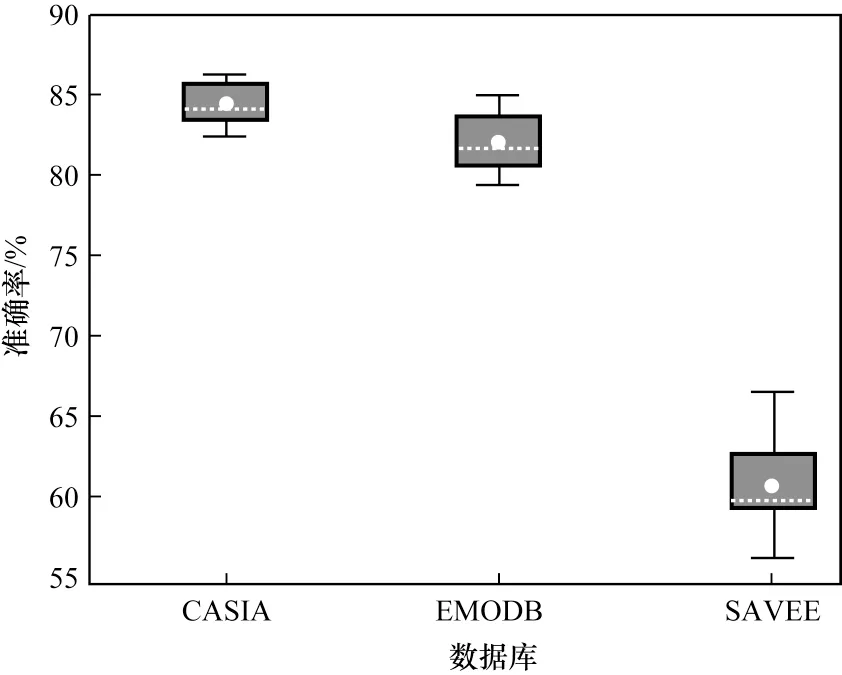

在CASIA、EMODB、SAVEE 数据库上对AHPCL模型进行10 次验证,模型在每个数据库上的均值和波动程度如图2 所示,其中:箱体中间的一条虚线表示数据的中位数;箱体的上下限分别是数据的上四分位数和下四分位数,这意味着箱体包含了50%的数据;箱体的高度在一定程度上反映了数据的波动程度;在箱体的上方和下方各有一条线,分别表示最高准确率和最低准确率。

图2 AHPCL 模型在CASIA、EMODB、SAVEE 数据库上的箱线图Fig.2 Box-plot of AHPCL model on CASIA,EMODB,and SAVEE databases

由图2 可以看出:在10 次验证中,AHPCL 模型在CASIA、EMODB、SAVEE 这3 个数据库上的最高准确率依次为86.25%、85.05%、66.67%,最低准确率依次为82.50%、79.44%、56.25%,平均准确率依次为84.50%、82.06%、60.84%。由此可见:1)AHPCL 模型在CASIA 数据库上最高准确率和最低准确率相差最小,EMODB 数据库次之,SAVEE 数据库相差最大,即AHPCL 模型在CASIA 数据库上的波动程度最小,稳定性最好;2)AHPCL 模型在CASIA 数据库上的均值最高,表明取得了最佳性能。AHPCL 模型在CASIA 数据库上性能最佳的主要原因为:CASIA数据库仅包含6 类情感,少于其他2 个数据库中的7 类情感,类别数少有利于识别;CASIA 数据库中样本数据量是EMODB、SAVEE 数据库的2 倍多,模型得到了更好训练。

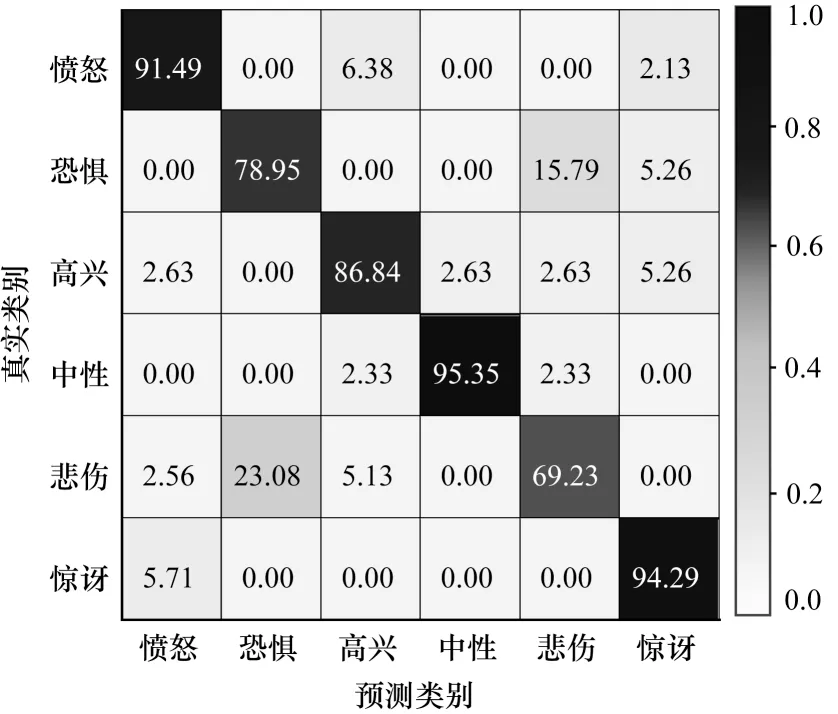

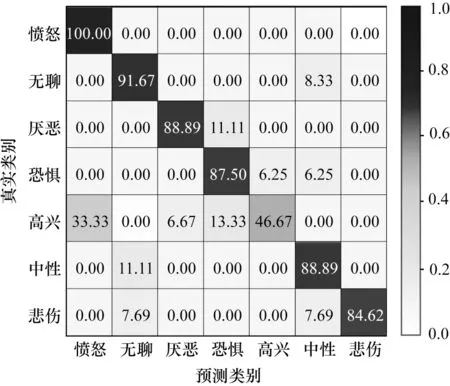

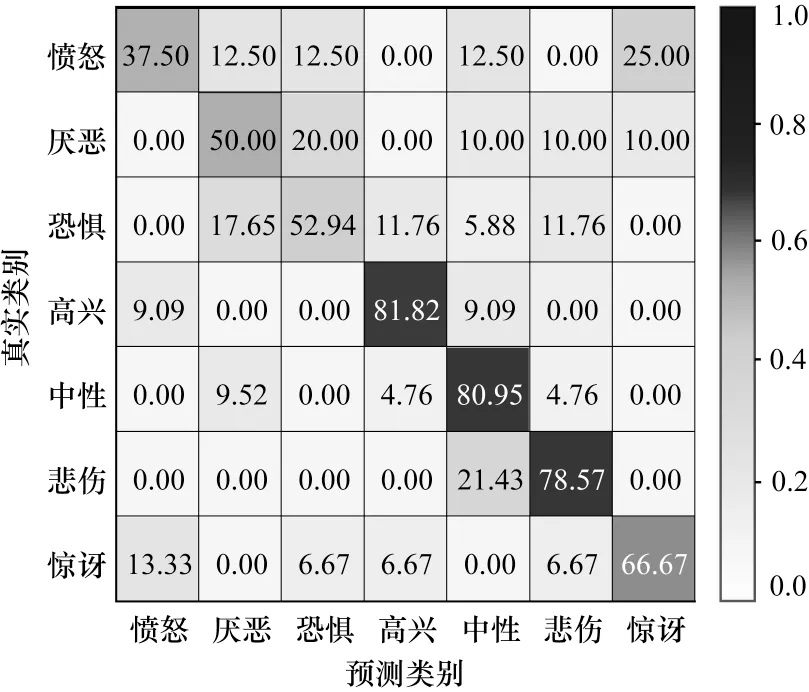

图3~图5选取了AHPCL 模型在CASIA、EMODB、SAVEE 数据库上的最佳混淆矩阵。如图3 所示,AHPCL 模型在CASIA 数据库上6 类情感的准确率、精确率、未加权平均召回率以及F1 得分依次为86.25%、85.77%、86.02%、85.90%。从图3 可以看出:愤怒、惊讶、中性这3 类情感的召回率均达到了90.00%以上;恐惧和悲伤这2 类情感的识别率较低且这2 类情感容易混淆,即在恐惧类情感中,有15.79%的样本被预测为悲伤,同样地,在悲伤类情感的识别过程中,有23.08%的样本被预测为恐惧。如图4 所示,AHPCL 模型在EMODB 数据库上7 类情感的准确率、精确率、未加权平均召回率以及F1 得分依次为85.05%、86.33%、84.03%、85.16%。从图4可以看出:高兴类情感的识别准确率较低,33.33%的样本被误判为愤怒类情感,13.33%的样本被误判为恐惧类情感,仅有46.67%的样本识别正确;其余情感均取得了较好的识别性能,愤怒情感的召回率达到了100.00%。如图5 所示,AHPCL 模型在SAVEE数据库上7 类情感的准确率、精确率、未加权平均召回率以及F1 得分依次为66.67%、64.35%、64.06%、64.20%。从图5 可以看出,7 类情感的平均召回率为64.06%,愤怒、厌恶、恐惧这3 类情感的召回率均较低,高兴情感的召回率最高,达到81.82%。

图3 AHPCL 模型在CASIA 数据库上的混淆矩阵Fig.3 Confusion matrix of AHPCL model on CASIA database

图4 AHPCL 模型在EMODB 数据库上的混淆矩阵Fig.4 Confusion matrix of AHPCL model on EMODB database

图5 AHPCL 模型在SAVEE 数据库上的混淆矩阵Fig.5 Confusion matrix of AHPCL model on SAVEE database

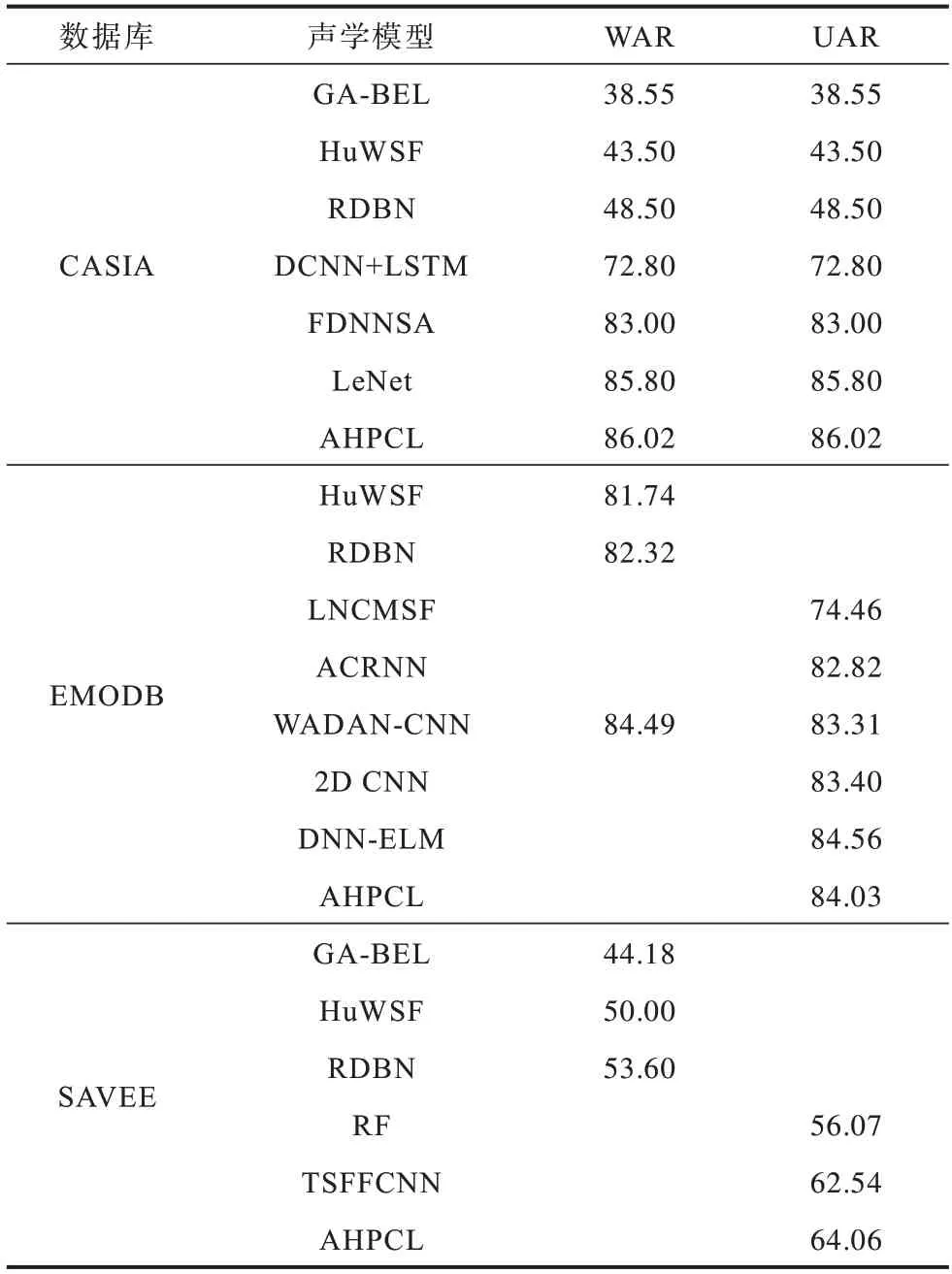

AHPCL 模型与DNN-ELM[16]、LeNet[18]、WADANCNN[19]、TSFFCNN[20]、GA-BEL[21]、HuWSF[22]、LNCMSF[23]、DCNN+LSTM[24]、FDNNSA[25]、RDBN[26]、ACRNN[27]、2D CNN[28]、RF[29]等同类模型的性能对比见表2,其中,WAR 是指加权平均召回率(Weighted Average Recall,WAR),CASIA 中的WAR 与UAR 相同的原因为CASIA 中各类情感样本数量完全相等,均为200,即各类样本在总样本中所占的比重(权重)是一样的,因此这2 个指标相等。

表2 在CASIA、EMODB、SAVEE 数据库上AHPCL模型与现有模型的性能对比Table 2 Performance comparison of AHPCL model with other models on CASIA,EMODB,and SAVEE databases %

由表2 可以看出:在CASIA 数据库上,AHPCL 模型的性能均优于6 类基线模型,WAR 和UAR 比最好的基线模型LeNet[18]高出0.22 个百分点;在EMODB 数据库上,AHPCL 模型的UAR 仅比DNN-ELM 模型[16]低0.53 个百分点,除此之外,AHPCL 模型的性能均优于其余6 类基线模型;在SAVEE 数据库上,AHPCL 模型的性能均优于5 类基线模型的性能,而且UAR 比最优的TSFFCNN 基线模型[20]高出1.52 个百分点。

综上:AHPCL 模型在CASIA、SAVEE 这2 个数据库上的性能均优于现有研究成果,在EMODB 数据库上也与现有研究成果相当,证明了AHPCL 模型的鲁棒性和泛化性均较好。

5 结束语

为提高语音情感识别性能,本文提出一种基于注意力机制的异构并行卷积循环神经网络模型AHPCL。在卷积层提取语音情感的空间谱特征,在LSTM 层提取语音情感的时间序列特征,同时基于注意力机制,根据不同的时间序列特征对语音情感的贡献程度分配权重。实验结果表明,该模型能同时提取语音情感的空间谱特征和时间序列特征,具有较强的鲁棒性和泛化性。后续将使用向量胶囊网络替代AHPCL 模型卷积层中的一维卷积,并将模型应用于混合语言的语音情感识别中,进一步提升鲁棒性和泛化性。