人类能让机器人受道德约束吗

王瑞良

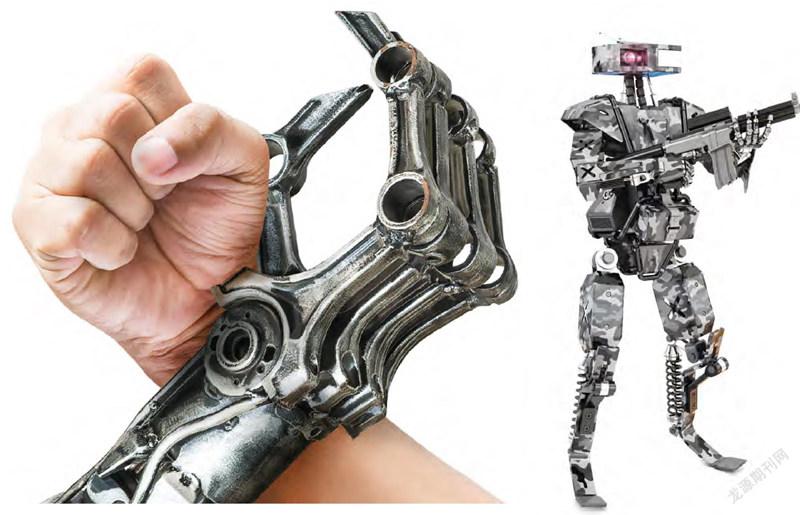

随着人工智能(AI)技术突飞猛进的发展,现在许多无须人工操控的自动化系统如雨后春笋般出现,大大丰富和改善了人们的物质文化生活。当然,这项技术也不可避免地会进入军事领域,催生多种自动化武器装备,如无人驾驶的飞机、舰艇、战车以及人形超级智能作战机器人等。这些武器裝备在激活后无须人类干预,即可自动选择目标和采取行动,这就不能不引起人们的忧虑——它们会不分青红皂白地滥杀无辜,从而改变战争的性质,使人类遭受重大伤害。

于是,一个问题出现了:有没有办法让机器人恪守人类道德?

“杀人机器人”引出的争论

美国是最早开始研发和使用这种自动化武器(俗称“杀人机器人”)的国家,英、日、德、俄、韩和以色列等国家紧随其后,也相继研发出各自的系统。其中数量最多的,是美国的无人机。

据悉,美军现有各种无人机7000架,其型号涵盖了从手掌大小的微型机到翼展超过波音737的“全球鹰”巨型机,它们普遍配有摄像头和图像处理器,可以在没有任何通信和控制系统的情况下被派去摧毁目标。据报道,美军曾在阿富汗大量使用无人机,造成许多无辜者伤亡。

2020年3月,在利比亚内战的战场上,一架土耳其生产的自杀型无人机甚至在完全自主模式下,攻击了一名参战士兵。联合国安理会发布的相关报告震撼了国际舆论,更引发了深刻的道德和法律争论。支持者认为,战场机器人如果使用得当,可以有效降低士兵的伤亡率,挽救生命。但科学界的普遍看法是,战场机器人是一种威胁,这不单单是指它具有自主能力,而是指它掌握着生杀大权。为此,联合国发文呼吁,“杀人机器人”的问世,动摇了关于战争行为的国际公约,必须“冻结”相关技术的研发,最终目标是永久性地禁止这种武器的使用,不能把生杀大权交给一个机器人。

一项有趣的试验

联合国这么呼吁的理由是:机器人无法对自己的行为负责——它可以判断对方是人还是机器,但是要识别对方是士兵还是平民,几乎不可能。士兵可以用常识判断眼前的女子是怀孕还是身藏炸药,机器人恐怕不大可能。如果恐怖分子利用“杀人机器人”取代自杀式袭击,就如同打开了现代“潘多拉魔盒”,后果不堪设想。

那么,有没有办法通过程序设计,让机器人具有“道德观念”和“法律意识”,做一个具有仁爱之心的“好人”呢?或者说,是否可以将机器人的所作所为限定在一个合法的范畴之内呢?

这是一个饶有兴味的问题,激发了一批顶尖科学家的灵感,并有一些人进行了实际试验。例如,英国布里斯托机器人实验室的艾伦·温菲尔德及其同事,为机器人设计了这样一个程序:阻止其他拟人机器人掉进洞里。这是根据美国著名科幻作家艾萨克·阿西莫夫提出的“机器人三定律”设计的。

试验一开始,机器人还能顺利完成任务:当拟人机器人向洞口移动时,机器人会冲上去将其推开,防止其掉进洞里。随后,研究人员又添加了一个拟人机器人,两个拟人机器人同时向洞口移动,救人机器人则要被迫进行选择。有时,它成功地救了其中一“人”,而另一“人”掉进了洞里;有几次,它甚至想两个“人”都救。然而,在33次测试中,它有14次因为在救哪一个的问题上不知所措而浪费了时间,以致两个“人”都掉进了洞里。这项试验公开展示后,得到了世人的高度关注。事后,温菲尔德说,虽然根据设定的程序,救人机器人是可以对他人施救的,但它根本不理解这种行为背后的原因,因而实际上是一具“道德僵尸”。

随着机器人日益融入人们的生活,这类问题需要有一个明确的答案。例如,一辆自动驾驶的汽车,某一天或许要在“保证车内人员安全”和“给其他驾驶员或行人造成伤害”之间进行权衡。解决这个问题可能非常困难。然而,可喜的是,某些机器人或许能够提供一个初步答案:美国佐治亚理工学院的计算机专家罗纳德·阿金专门为一个名为“道德监督员”的军事机器人研发了一套运算法则,在模拟战斗测试中,它可以帮助机器人在战场上作出明智的抉择。例如,不得在学校和医院等受保护目标附近开枪,要尽量减少人员伤亡。不过,这是相对简单的情形,如果遇到复杂情况,结果往往会大不一样。看来,要回答机器人能否作出道德伦理选择这个问题,不是短时间内能够做到的,这中间涉及一系列极其尖端复杂的人工智能技术,要取得实质性进展,还有很长的路要走。

让机器人“讲道德”的难度

这是人工智能技术在发展过程中遇到的一个重大问题。要正确地回答和解决这个问题,首先要弄清一个关键:需要掌握道德标准的是人工智能本身,还是人类?

一个多世纪前,有人曾发出警告说,电力特别是电报的发明会对人的智力带来不利影响,由于人们不停地用电讯传递信息而很少有时间思考,因而将削弱人的思考能力,甚至最终会导致大脑瘫痪。100多年后,也有人对谷歌发出类似的警告——当他们有时看到社交网络充斥着大量废话后,就误认为上面说的“思考能力的弱化”已经成为现实。但是,即便上述情况属实,而将其原因归之为电力的发展,这是不公平的。因为要对大量废话负主要责任的,显然不应是电力技术,而应是作为行为者的人的本性。

如今,人工智能的发展也面临着类似情况:人们一方面在高度评价它给各行各业带来的无与伦比的巨大推动作用,同时对它可能存在的某些弊端又不无忧虑,“杀人机器人”的问世便是典型案例之一。

人工智能的巨大威力,主要是通过它那卓越的图灵识别模式来工作的。例如,在新冠肺炎疫情大流行的背景下,它可以识别出无症状感染者,从而避免疾病的传播;它可以通过皮毛上的斑点来识别和分类濒危动物,有利于对其进行监控,从而降低物种灭绝的风险;它还能识别出古代文字的痕迹并确定作者数量;它甚至能通过智能算法判断出考场中的异常行为,将作弊者识别出来……

但是,尽管如此,人工智能技术并非万能的,当它的发展逐渐接触到人类的意识、情感、意志和道德层面的问题时,便会相形见绌,有时甚至完全无能为力。这是因为,战争法则已有数千年的历史,人类往往会受到情感等因素的影响而打破规矩,机器人则不会。这种情况已成为与哲学和伦理学有关的一部分了。因此,要解决人工智能中的道德伦理问题,不能单纯从技术角度着眼,必须考虑哲学、伦理学的因素,这就不可避免地会增加解决问题的难度。

怎样让机器人恪守人类道德

这种难度主要可归纳为两个方面:其一,难以处理一些抽象概念,例如“造成傷害”的概念。杀人显然是一种伤害,但是接种疫苗也会引起疼痛,个别的甚至会造成死亡,那么,达到何种程度才能界定为“伤害”呢?其二,来自对可能伤害的评估,以及必须避免对人类造成伤害。如果一个智能系统遇到两个具有相同伤害可能性的目标就无所适从,不知道该把目标锁定在哪个身上,就不能被认为是一个成熟的系统。

尽管这一问题解决起来难度很大,甚至被认为“根本无法解决”,但是科学家并未因此放缓探索未知、攻坚克难的步伐。围绕着怎样让机器人恪守人类道德这一目标,他们费尽心思,提出了许多思路、建议和方案,其中有些已经在进行试验,概括起来就是:

第一,参照科幻大师艾萨克·阿西莫夫提出的“机器人三定律”,严格限定智能机器人不能伤害人类,不能因不作为而使人类遭受伤害;如有违反,相关的研发人员或机构将会受到惩罚。

第二,采取诉诸多数的观点。一般而言,大多数人的利益往往能决定什么是对的、什么是错的。例如,假设在涉及行人、立即发生且不可逆转的事故时,我们必须决定自动驾驶车辆应该做什么:到底是救乘员还是救行人?美国曾用一种道德机器来分析这些可能的决定,结论是如果一种行为能为最大数量的人带来最大的幸福度,那它就是一件值得做的好事。在这里,幸福度是一个主要的预期目标。

第三,在未来的战场上,真正的困境出现在面对未来士兵的时候。要想让未来士兵具有战斗力,他们必须在可感知的威胁消灭他们之前把威胁消灭掉。这可以通过编程的方式,让机器人遵守一些“道德规则”来实现,尤其是涉及战斗环境中的士兵时。但指挥员可能会发现,如果为机器人内置的“道德”限制将会危及本部队战斗人员时,这种编程就会干扰任务的遂行。例如,人工智能系统会锁死士兵的枪,以防止平民被杀,而这个平民其实是对方的战斗人员或恐怖分子。从这个角度讲,在城市恐怖事件中,似乎永远也不可能弄清楚谁是平民、谁不是。因此,这里的编程就是一项极其复杂的技术,需要各方面的顶尖专家集思广益、通力合作,才有可能取得突破。

综上所述,能否让机器人受道德约束是一个大目标,实现这个目标的根本途径不是如何使人工智能技术符合道德规范,而是人类在研发和使用人工智能时要遵守道德规范。如果说有道德的机器人目前还是一个神话,那么,有道德的人却完全不是。因此,完全有可能和绝对有必要敦促全世界的科学家、军事指挥员采取有道德的行动,即只有在自身安全受到伤害的必要情况下才动用自动化武器。在这方面。人类是可以大有作为的。正如人工智能之父阿兰·麦席森·图灵所言:“我们的目光所及,只能在不远的前方,但是可以看到那里有大量需要去做的工作。”因此,前景是光明的。