基于ALBERT-BIGRU的情感分析模型

韩健 郝刚

摘要:针对预训练模型BRET所面临的模型复杂、参数规模大带来的训练难度提升问题,提出一种基于 ALBERT(A Little BERT)的情感分析模型ALBERT-BiGRU-attention-CRF。在online_shopping_10_cats 网络购物评论数据集上取得了93.58%的 F1 值,同传统BiGRU-CRF 等情感分析模型相比均有所提升,同BERT 模型相比在P值上提升0.61%,且缩短将近一半运行速度时间。实验结果最终表明该模型在缩减模型参数需求,增加运行效率的同时能有效保留类似 BERT 模型的模型表现。

关键词:中文情感分析;ALBERT预训练模型;双向门控制循环单元网络BIGRU;注意力机制Attention

中图分类号:TP391 文献标识码:A

文章编号:1009-3044(2022)01-0012-03

文本中的情感分析作为一项自然语言处理(Natural Language Processing, NLP)中的基本任务,目标是从具有强主观性的文本中抽取出文章作者的情感。Bengio等人最早在语言模型中加入了神经网络[1]。

Bahdanau等人提出了注意力机制理论,Mnih等人在RNN模型上使用了注意力机制来进行图像分类的成功,使注意力机制广受关注[2]。王伟等人提出BiGRU-Attention模型进行情感分类[3]。杨东等人提出了Attention-C-GRU模型,有效提高了F值[4]。郑雄风等人提出将双向GRU和Attention机制与产品文本分类融合一起,提升了模型的训练速度和准确率[5] 。赵勤鲁等人提出了LSTM-Attention模型,有效地提取了文本语义结构相关的信息[6]。朱星嘉等人提出了改进的Attention-Based LSTM特征选择模型,强化提取了文本的重点特征信息[7]。白静等人提出将BiLSTM、CNN、Attention机制融合的混合神经网络进行两种特征融合的分类[8]。司念文等人提出的Attention和LSTM混合模型可以高效地对中文词性进行标注[9]。以上机制的成功均说明了恰当引用注意力机制可以有效提高情感分析的准确率。

为了将人类语言转换化成计算机理解的语言,需要文本向量化技术。One-hot向量可以解决此问题,但One-hot向量在处理具有顺序特征的信息文本时暴露出很大的局限性,它未将词序也作为参考条件,因此提取的特征散乱无章。基于上述问题,2018年谷歌提出了能解决一词多义基于字符的文本向量化模型BERT模型[10]。

本文构建了一个ALBERT-BiGRU-Attention-CRF综合模型,相较于传统的基于BiGRU模型,可以充分利用上下文信息解决一词多义问题。经测试在准确率和F1值方面取得了较好的分类效果。

1 相关工作

1.1 BERT预训练语言模型

在训练阶段中主要将模型划分为MASK LM(MLM)与“预知未来”任务。为训练双向表征,该模型随机将输入的部分Token进行遮蔽处理,对遮蔽的Token进行预测。提取15%的训练集中的词训练,将有80%的概率把其中被标记的词替换为MASK标签,而剩下的词中的一半将替换成随机词,另一半保留原始Token,让模型判断打上MASK单词的意义。为获得能够理解句子关系的模型,在“预知未来”任务中选择句子甲和乙为预训练样本:乙有可能是甲的下一句,或是存放在语料库中的语句,判断语句是否呈接续关系。

Input Embedding模块将输入词进行处理,获取词向量的同时对其位置信息进行编码化。MultiHead-attention模块由多层自注意力层组成,可从语句中提取不同词语的关联。它的输出会经过ADD& Norm层。该层输出将传递至前馈神经网络处,再次经过ADD&Norm 层后进行输出。

1.2 双向门控制循环单元网络

GRU网络模型使每一个循环单元都具备捕获不同尺度时间依赖性的能力且具备自适应性。单向的GRU结构的状态是单向传播的,忽略了后文单词对整体逻辑状态的影响。而BiGRU的输出受双向影响,解决了单向GRU的问题,结果更加稳定、准确。

1.3 注意力机制

早在2014年,注意力机制就在机器翻译领域上因其出色的效果而备受关注。对于一个句子每个词的重要程度不同,需提取重要的单词的语义信息。注意力机制可以概括为由Encoder和Decoder两部分组成。Encoder处理输入数据,Encoder得到输出。

1.4 条件随机场

条件随机场(CRF)是一种综合了隐马尔可夫模型和最大熵模型的优势的概率无向图模型。它通过观察序列来推测对应状态序列,将邻近的前后标签关系加工处理获取最优当前标记。

2 基于ALBERT-BiGRU的情感分析模型

本文提出了基于ALBERT-BiGRU-Attention-CRF情感分析模型。該模型主要由ALBERT向量表示层、BiGRU层、Attention层以及CRF层共同组成。通过ALBERT模型对输入文本进行编码操作,从而获取其对应的词向量,然后经过BiGRU层双向捕捉语义,再经过Attention层对BiGRU层的隐含变量进行加权运算处理,获取上下文信息,最后将处理后的信息送入CRF层进行处理得到情感分析结果。如图1所示为本文提出的模型的结构图。

2.1 ALBERT向量表示层

由于BERT模型参数量过于庞大,时间需求过高等缺点,本文采用了优化后的ALBERT模型。ALBERT模型基于BERT模型做了如下改进:

1)嵌入向量参数化的因式分解:基于模型结构的限制,BERT模型中WordPiece embedding的大小E恒等于隐层大小H。词嵌入仅对单词进行学习,而隐层需要针对与上下文关系进行学习,后者需要更多的参数,可以适当增大H的大小,或者满足H>>E。但现实情况下词汇表V非常大,若维持E=H,增大隐层H会使得embedding matrix(V×E)的维度变得庞大。

为了打破E、H之间的绑定,将embedding matrix分解为两个大小为V×E和E×H矩阵对嵌入向量参数化因式分解,提升模型表现,使embedding matrix的维度从O(V×H)缩小至O(V×E+E×H)。当H>>E时,优化将非常明显。

2)共享跨层参数机制:在ALBERT中默认共享全部参数。实验表明,当加入上述机制后,基于L2距离以及余弦相似度的角度观察该机制能使模型参数更趋于稳定。

3)句间连贯性损失:BERT模型中,预训练任务Next-Sentence Prediction(NSP)的正例是文章中连续的句子,而负例则各从两个文章中选择一个构成。它在对两个句子的关系给出合理化推断时综合考虑了句子的连贯性与不同句子的主题,降低了判断的难度。而ALBERT提出了Sentence-Order Prediction (SOP)任务,SOP任务采用别无二致的正例,但负例是来源于相同的文章,改进后两个句子将具有同样的主题,训练的主要任务倾向于句子的连贯性。

4)删除drop out机制:在BERT模型中并未出现任何过拟合现象,删除drop out机制可以进一步提升模型表现。

2.2 BiGRU层

为了进一步降低时间需求,不同于其他基于BiLSTM的情感分析模型,我们采用了BiGRU模型。同LSTM模型的繁杂冗余相比,GRU模型显得更为简洁,其仅由更新门z和重置门r构成,比LSTM少了一个门,所以在训练的时候参数更少,收敛时间更快。

2.3 Attention层

在本模型中,Attention层的主要目的是衡量隐藏层向量特征的权重,通过对不同时刻的输出根据权重计算,在此之上再进行降噪处理。在传统模型中,隐藏层特征的权重相同,先输入的内容会被稀释掉,语义向量不能完整覆盖。

2.4 CRF层

在实验中,BiGRU 模型的输出是完全独立的,虽然BiGRU学习到了输入中前后信息的特征,但是不具备利用输出标签的能力。因此本文在 BiGRU 后新增加了一层CRF层,从而增加效果的真实性。

3 实验与分析

3.1 数据集

实验采用了online_shopping_10_cats 网络购物评论数据集。该数据集种类繁杂且其评论覆盖范围极广。本次实验从中均匀选取数据:总数为22000条,测试集17600条,验证集2000条,测试集2400条。

3.2 实验环境

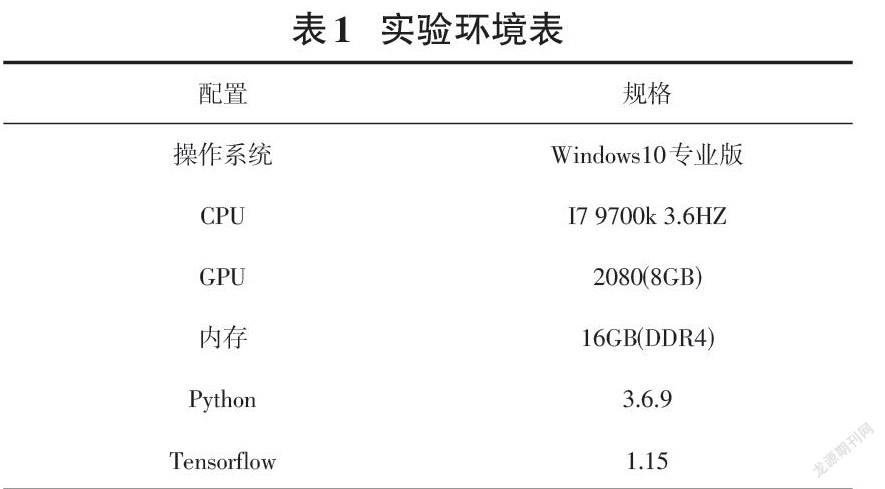

实验环境如表1所示。

3.3 评价指标

本文采用的评价指标为精确率(Precision,P)、召回率(Recall,R)和F1值。

其公式依次如公式(1)~(3)所示。

3.4 參数设置

在参数方面,本次实验设置文本最大长度为128,batchsize设置为32,dropout 设置为 0.1,使用Adam优化器,学习率初始值设为 2e-5。

3.5 对比实验设置与结果分析

实验设置多组对比实验,除本文采用的网络模型外,其他模型默认输入引用word2vec训练的词向量,实验在测试集上测试的Precision、Recall、F1结果如表2所示。

从表3的六组模型的对比结果可以看出,SVM模型虽然取得了较好效果,但基于深度学习的其他五组模型均优于SVM,BERT+BIGRU+CRF模型的三项结果表现均高于ALBERT+BIGRU+CRF模型,大约1%~2%,这是由于在使用ALBERT模型时,大规模降低参数使用量的结果,使识别能力有小幅度下降。本文使用的ALBERT-BIGRU-Attention-CRF模型同其他模型相比,精确度的F1值高达94.06%,与其他五组模型相比均有小幅提升。说明在BIGRU后加入Attention层,实体种类增加时,注意力机制可以划分实体边界,提升效果,且以10个epoch为指标,基于ALBERT的模型用时约为5小时,BERT模型超过10小时,可见仅以运行速度为考量,基于ALBERT的模型也有可观的提升。说明ALBERT 模型的优化主要在于提升运行速度、降低训练难度,在大幅减少训练时间、降低资源占用的情况下能最大限度地保留 BERT 的性能。

为进一步展现模型的优劣,本文在样本总数为2400的测试集上进行了测试。实验对TP值、TN值、FP值、FN值、TURE和FALSE六种数据进行评判。为了便于统计,我们将输出结果大于0.5的值视为1,小于0.5的值视为0。测试结果如表3所示。

表3中ALBERT-BIGRU-Attention-CRF模型预测正确的次数最多,错误的次数最少,可见ALBERT-BiGRU-Attention-CRF模型时效果最优。

4 结束语

本文提出了一种基于ALBERT-BIGRU-Attention-CRF模型的中文文本情感分析方法。经过在online_shopping_10_cats 网络购物评论数据集上进行训练和测试,实验结果表明本文模型可以在时间需求很低的前提下有效地提高文本情感分类准确率。但是对于表达相对暧昧的文本,识别置信度还需要进一步提高。为进一步提高模型性能,后续可以考虑从细化实体分类规则、扩大预料集规模、替换其他预训练模型等方面着手进行。

参考文献;

[1] Bengio Y.Learning deep architectures for AI[J].Foundations and Trends in Machine Learning,2009,2(1):1-127.

[2] Bahdanau D, Cho K, Bengio Y. Neural machine translation by jointly learning to align and translate[C]//Proceedings of the 3rd International Conference on Learning Representations.San Diego:ICLR,2015.

[3] 王伟,孙玉霞,齐庆杰,等.基于BiGRU-attention神经网络的文本情感分类模型[J].计算机应用研究,2019,36(12):3558-3564.

[4] 杨东,王移芝.基于Attention-based C-GRU神经网络的文本分类[J].计算机与现代化,2018(2):96-100.

[5] 郑雄风,丁立新,万润泽.基于用户和产品Attention机制的层次BGRU模型[J].计算机工程与应用,2018,54(11):145-152.

[6] 赵勤鲁,蔡晓东,李波,等.基于LSTM-Attention神经网络的文本特征提取方法[J].现代电子技术,2018,41(8):167-170.

[7] 朱星嘉,李红莲,吕学强,等.一种改进的Attention-Based LSTM特征选择模型[J].北京信息科技大学学报(自然科学版),2018,33(2):54-59.

[8] 白静,李霏,姬东鸿.基于注意力的BiLSTM-CNN中文微博立場检测模型[J].计算机应用与软件,2018,35(3):266-274.

[9] 司念文,王衡军,李伟,等.基于注意力长短时记忆网络的中文词性标注模型[J].计算机科学,2018,45(4):66-70,82.

[10] Devlin J, Chang M W,Lee K , et al. Bert: Pre-training of deep bidirectional transformers for language understanding [C]//Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics:Human Language Technologies,2019,1:4171-4186.

【通联编辑:代影】

收稿日期:2021-05-26

作者简介:韩健(1993—),男,硕士研究生,CCF会员,主要研究方向为自然语言处理;郝刚(1968—),男,通信作者,教授,CCF会员,主要研究方向为网络信息安全、自然语言处理。

3778500589279