联合战役兵棋AI设计难点问题研究∗

任 航 贺筱媛 陶九阳

(1.国防大学 北京 100091)(2.中国人民解放军31113部队 南京 210008)

1 引言

兵棋是重要的作战模拟手段形式,它使用棋盘和棋子代表真实的理信息和军事力量,利用从军事实践活动中获得的经验、原则和数据提炼形成规则,结合统计概率体现战场的偶然性和不确定性。兵棋发展紧随时代脚步,与军事指挥发展同步,兵棋所覆盖的领域由传统的陆、海、空三维延伸至网络、电磁以及太空等领域。

近年来以深度强化学习技术为代表的AI技术在游戏领域获得巨大成功,相继攻克了围棋、纸牌和复杂的即时策略游戏[1~7]。兵棋决策遂成为智能技术亟待突破的下一个领域前沿。联合战役兵棋由于力量构成以及层级关系自然成为当前兵棋智能化研究的领域高地。伴随联合演训活动深入开展,联合战役兵棋智能化应用需求也愈发急切。由于专业兵棋特别是联合战役兵棋严肃的军事背景与游戏有着诸多差异,以致为相应AI技术设置了应用障碍。本文在梳理兵棋及兵棋研究历史现状基础上,立足联合战役兵棋功能定位并结合联合战役兵棋智能化军事需求,将联合战役兵棋与典型强化学习环境进行比较,分析相关技术落地中存在的实现难点。

2 兵棋及兵棋智能化研究的历史现状

自普鲁士宫廷顾问冯·莱斯维茨肇始现代兵棋理论在国外发展已两百余年。世界兵棋研究的中心从其诞生地的德国转向现今的美国。20世纪80年代起美军先后开发了联合战区级模拟系统(Joint Theater Level Simulation,JTLS)、联合冲突战术模拟系统(Joint Conflict and Tactical Simulation,JCATS)等典型兵棋系统,用以对作战方案进行辅助分析与评估。美军在智能兵棋推演的初步尝试可以追溯至2007年美国防部高级研究计划局(De⁃fense Advanced Research Projects Agency,DARPA)资助下启动的“深绿”计划[8]。美军寄希望通过实现兵棋系统的自主决策控制从而摆脱人在回路推演方式的诸多运用限制。系统核心包括“指挥员助手”、“水晶球”以及“闪电战”三大子功能模块[9]。其中,“指挥员助手”模块是人机接口工程,试图实现从指挥作业草图到作战方案自动生成的转变;“闪电战”模块实现系统推演仿真,快速生成可能态势用以辅助作战计划检验;“水晶球”模块主要实现战场态势认知的作用,辅助指挥员构建未来可能的态势图景。由于庞大搜索空间加之算力缺乏,“深绿”计划最终搁浅。随着机器学习为代表的新兴智能方法出现,兵棋智能化研究在短暂沉寂后又重新趋于活络。2020年DARPA启动“游戏破坏者”项目计划,希图在专业兵棋CMANO上实现人工智能技术的嵌入融合。同年兰德公司发布题为《思维机器时代的威慑》专题报告,重点针对在未来战争中智能化武器系统对国家力量威慑与升级的影响进行兵棋推演[10]。

较之国外对兵棋智能推演的研究,国内研究起步相对较晚。2017年起中国指控学会连续多年举办“全国兵棋推演大赛”。几届比赛中机器智能组的冠军相继为中科院自动化研究所、国防科技大学所摘得。上述团队研发的“CASIA-先知V1.0”、“战颅”系统,在人机对抗赛中以明显优势击败人类组冠军。2021年以临机应变为主题,开创图灵测试比赛模式的首届“庙算杯”人机对抗测试赛成功举行。在人机混合对战中,中科院自动化所研发的智能体AlphaWar顺利通过了通过图灵测试,并以一分劣势位居排名第一的人类选手之后。

国内围绕兵棋智能化的部分理论探索工作有:张可等以模糊遗传系统为基础建立兵棋决策的控制框架[11];刘满等通过挖掘历史数据,利用兵棋的基本规则以及多属性综合评价软优选算法进行棋子控制[12];李琛等将强化学习方法与规则相结合,基于Actor-Critic框架和产生式战术规则研究多智能体决策方法[13];Hanchao Wang等提出基于多智能体强化学习方法对棋子单元进行分层控制[14];程恺等面向战术兵棋提出兵棋AI的设计框架[15]。

总体来看,相关理论研究及产品主要集中于战术层级,所包含的实体单位规模数量较为有限,实体间的指挥控制关系相对简单。研究使用的平台偏重于游戏娱乐,缺少军事规则约束,与真实作战场景还有不小距离。在这样平台中进行军事决策问题研究,往往会由于微操等原因导致决策问题退化为单纯的速度比拼,将军事决策问题这个根本忽视。

3 联合战役兵棋智能化军事需求分析

兵棋服务的对象核心是各层级指挥员,是指挥员学习战争规律锤炼战争思维的依托平台,而非单纯的军事技能训练工具。兵棋主要用于战争分析与军事训练,突出作战过程的谋略和对抗特性。不同兵棋所关注问题的层级粒度不尽相同。指挥员决策的导向作用在战略战役层级更为凸显,战斗层级以上兵棋刻画重点由交战细节转向决策本身,兵棋模型构模精细程度逐渐减弱,决策辐射作用范围逐渐扩展。战役兵棋一方面凸显决策这个中心功能,另一方面聚焦决策在战术层级上的末端执行,可谓起点于战役,落点在战术。

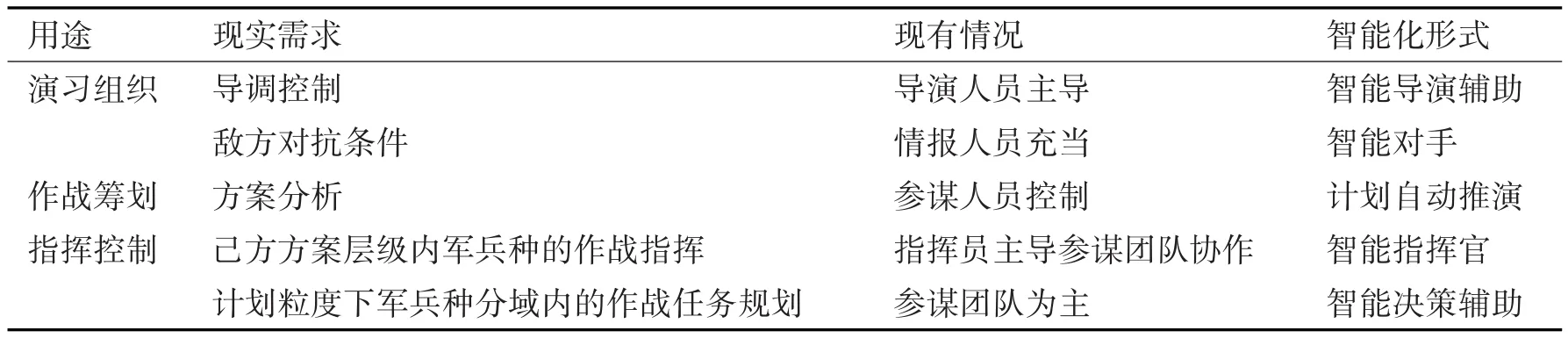

聚焦决策特别是关乎全局的宏观决策是联合战役兵棋关注重点。联合战役兵棋直接应用于作战筹划以及指挥对抗训练。作战筹划可以作为一个环节融入指挥对抗训练中,也可以作为一个独立部分单独运用。美军在其联合出版物JP5-0中明确规定兵棋推演在联合作战计划制定流程中的地位作用。表1简要梳理了联合战役兵棋推演对智能化的典型需求。其中,智能指挥官、智能辅助决策以及智能对手重点关注决策智能。智能指挥官辅助指挥员以快速推演的形式对作战方案进行检验评估,以期及时发现方案中的漏洞不足进而对方案进行迭代升级。智能辅助决策重点就指挥员决策进行细化,将战役级任务向下分解为能够落地的战术行动。智能指挥官、智能辅助决策共同构成智能红军,与智能对手即智能蓝军相对应。

表1 联合战役兵棋智能化需求分析简表

智能蓝军主要构成训练或方案检验过程中的条件对手,与智能红军类似但又非完全一致。与智能红军相比智能蓝军的构设要求及实现难度更高。在进行基本的全维对抗外,还要尽可能地挖掘出所模拟对象的风格特质并以有效的方法手段最大化地加以呈现。智能红军直接对接指挥员及参谋团队更强调与之共同的知识理解与表达,因而决策的可解释性成为智能红军决策建模的重点;智能蓝军作为指挥员陪练,决策建模偏重于决策模型与对手决策模式约束的结合方式上。

智能红军抑或是智能蓝军是兵棋智能的外在应用展现形式,除去见招拆招般的应对以外,联合战役兵棋AI应实现科学计划与灵活作战控制间的统一。联合战役兵棋决策智能需要凸显复杂战役态势下智能的稳局控局能力,面向终态目标的长程规划与阶段目标下的有效执行能力,依托方案计划的协调统筹与机变处置能力。由OODA理论联合作战指挥过程是一个以观察、判断、决策、行动为核心的滚动向前迭代过程。对抗各方通过一方面加速己方OODA循环另一方面力图打破对方OODA循环链路方式握紧战争主动权,从而将对手置于己方作战节奏下。联合作战复杂特性决定了方案计划对作战组织的重要作用。方案计划为各作战行动的协调提供了统一的参照基准,作战行动通过方案计划实现逻辑串联,在时域、空域、频域等方面完成功能组织的同步。

4 联合战役兵棋与典型强化学习AI平台环境比较

4.1 典型强化学习AI研究平台环境简介

街机学习环境(Arcade Learning Environment,ALE)是通过游戏表现评价智能体通用能力的平台[17],其交互的对象是模拟Atari 2600的游戏环境[18],内容涵盖搏击、射击、竞技、冒险等多种类型。围绕AI测试相关研究者挑选出57种固定游戏形成 Atari-57[17,19]评价基线,并将人类玩家平均得分(Human Normalized Score,HNS)作为衡量AI效果度量的依据标准。

OpenAI Gym是OpenAI推出的强化学习开源测试平台。Gym涵盖经典控制游戏、机器人操作、文字游戏以及Atari视频游戏等不同类型的仿真环境。机器人操作使用MuJoCo物理引擎,用于研究机器人的精细仿真控制。Atari游戏部分直接对封装了ALE内容。Gym提供标准化的学习辅助环境,智能体与环境的交互、仿真环境的步进都遵循严格的协议规范,仿真结果连续稳定向外输出。

星际争霸是一款即时战略游戏,涉及微观动作操控、宏观策略规划、多任务学习以及多智能体协作等复杂决策问题。其与军事决策高度的相似性使其具有极强的军事借鉴价值。DeepMind与暴雪公司合作发布的学习环境SC2LE[20]同样是智能研究重要的平台。SC2LE包含应用程序接口API、Py⁃thon开源工具PySC2以及数量巨大的对战数据集。

棋牌类游戏作为受众广泛的博弈游戏同样受到关注。得克萨斯农工大学设计并开源了面向棋牌类游戏的强化学习平台RLCard。RLCard支持斗地主、麻将、21点等八种牌类游戏,在其上有多种强化学习算法实现并能够实现并行训练[21]。RL⁃Card通过预训练模型或规则代替对手,使整个游戏变为基于玩家视角的单智能体接口,并按照Ope⁃nAI Gym形式封装环境。

表2 典型强化学习环境比较

4.2 联合战役兵棋环境特点及AI落地难点总结

深度强化学习综合了深度学习与强化学习两者优点,深度学习实现信息知识的提取,强化学习重点在深度学习基础上实现高水平决策。深度强化学习作为AI开发的关键技术,学习训练效果与环境高度相关。联合战役兵棋环境与典型强化学习AI环境相比更为复杂,无形中增加了兵棋AI的落地难度,主要困难挑战集中在下述方面。

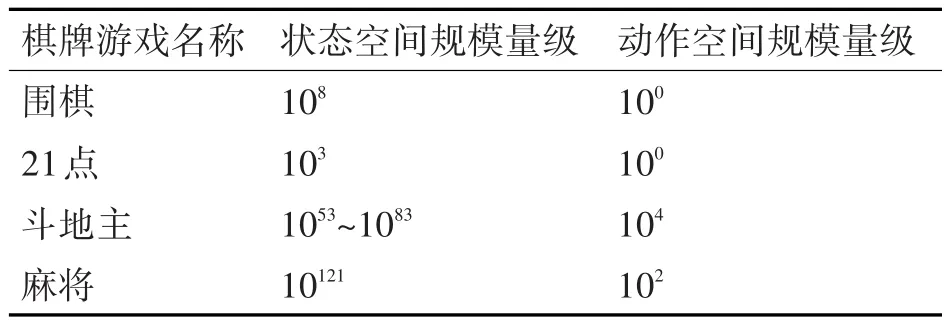

1)问题结构规模复杂。联合战役兵棋决策规模与想定高度关联,基于真实想定背景的联合战役兵棋棋子有数百个之多,所涉及的行动指令数量分布从数百到上千条不等,与指令相关的参数类型、取值范围千差万别。以各拥有100个作战实体单位的中等想定规模推演为例,其复杂度可能达到1014400量级。棋牌类游戏有着严格的规则制约,其问题规模难以与兵棋相比较。表3总结了常见的棋牌类游戏规模。星际争霸、Dota这类RTS游戏虽然存在类似情况,但由于相对固定的场景设置因而问题量级规模远逊于兵棋。

表3 常见棋牌类游戏问题规模

2)实体间存在复杂的交互关联关系。兵棋实体之间构成复杂的交互关系网。伴随作战目的改变以及作战进程演进,交互关系也在不断调整。作战体系中关键要素节点微小的变化都可能导致胜负天平发生不可逆的倾斜。作战行动间关联密切,聚焦于战役关节点各作战力量单元在整个时间域、空间域、信息域中形成复杂的缠绕交错态势。棋牌类游戏除牌面信息外不附加额外信息,RTS游戏中属性信息相对有限属性信息交互更多集中在伤害输出方面,而兵棋实体中还包含有支援、保障、信息压制等相关属性信息。这些属性信息及其之上衍生的关联关系信息共同构成AI决策所依赖的信息源。

3)不完全信息对作战决策影响显著。联合战役兵棋态势以及对手信息的不确定程度更高。兵棋推演是不完全信息博弈对抗过程。由于存在“战争迷雾”,加之对手的隐真示假行动,及时准确掌握态势信息愈发困难。不完全信息博弈在增加对抗性给人以更强体验感的同时也增大了决策难度。从现有博弈场景分析来看,围棋对抗中双方信息完全公开透明,斗地主、德州扑克中不完全信息体现在对手手牌的估计,兵棋及RTS游戏中不完全信息集中于敌方状态信息以及可能行动意图的预判上。相较于敌方兵力信息,对敌方作战意图、行动策略估计更加困难,训练AI从宏观视角综合把握局面的难度更大。

4)统计随机因素增加了对模型的学习难度。兵棋在描述战争一般规律的同时,融合有大量统计模型以刻画偶然因素的影响。随机性的影响充斥于交战毁伤、对目标侦察发现结果等裁决中。相较于棋牌类游戏兵棋执行结果展现出高度不确定性。兵棋状态转移结果表现为状态转移概率分布,这也是minimax搜索难以移植于兵棋的重要原因。诸多随机因素进一步增加了兵棋复杂程度,同样增大了AI对兵棋模型结构机理的捕捉以及学习难度。相较于游戏,基于model-based强化学习方法在联合战役兵棋中难以适用。学习出一个抽象的兵棋前向模型需要付出极高资源成本,因而无法像Atari游戏那样利用习得模型进行前向规划。

5)可借鉴的兵棋样本数据相对缺乏。Alpha⁃Go、AlphaStar等的成功离不开高质量对战数据的支持。通过模仿高水平人类玩家,AI能够迅速形成初始决策判断能力,为后续训练奠定良好基础。战争不同于游戏只有少数真实案例及演习数据可供借鉴。一方面联合作战对专业性的要求为组织运用联合战役兵棋推演设置了较高准入门槛,联合战役兵棋的应用领域决定其仅仅面向少数军事人员;另一方面保密的要求更降低了受众基础,导致无法像棋牌游戏、RTS游戏那样有着海量参考数据可供利用。特别对于模拟蓝军这样有着更高质量要求的数据则更是缺乏。

6)初始力量设置并非绝对均衡。基于真实想定情况的对阵双方并非如游戏一样力量对比大体相当,以致推演初始就带有明显的局面优劣差别,甚至可能出现一方实力对另一方全面碾压的极端情形。兵棋推演中的不对称特性主要表现在两个方面:一是力量的不对称性,集中体现在作战力量多寡、武器性能强弱、信息手段优劣等的差异上;二是作战目标的不对称性,兵棋中作战目标与推演角色定位密切相关。两方对战的博弈游戏中消灭对手往往是其唯一目标,而兵棋中作战目标受到自身红蓝角色背景制约。兵棋不对称性间接造成一战一棋这一比之棋类游戏的独特运用形式,导致诸如自博弈的强化学习训练方法无法直接运用。

7)最终结果无法仅用简单绝对的胜负二元值描述。战争目的带具有多目标属性特点,围绕相关属性目标指挥员通过环环相扣的精心设计实现其战役目的。根据指挥员的特点偏好,兵棋AI需要在不同目标间平衡取舍以尽可能地实现指挥员的作战意图。此外,战争目标并非一成不变,指挥员会根据战场需要动态进行目标调整,兵棋AI需要具有一定的策略适应性,能够根据奖励函数的变化进行策略的及时调整。

5 结语

伴随以深度强化学习为代表的AI技术在竞技游戏中不断攻城略地,数据驱动的智能博弈对抗建模技术愈发受到行业领域关注。联合战役兵棋作为一种不完全信息下的复杂博弈环境,既有游戏激烈对抗的影子又兼具军事问题的严肃主题。联合战役兵棋与战术兵棋、RTS游戏、棋类游戏等相比有着明显的特点区分。这些特点导致单纯以强化学习为核心构建的AI难以取得令人满意的结果。一种现实而可行的解决方式是将人的知识与强化学习相结合,重点围绕决策框架结构、训练设计以及模型构建等方面寻找解决问题的创新可能,具体知识与强化学习的结合方式尚有待后续更为深入的研究工作。