复杂场景下特征增强的显著性目标检测方法

李波 饶浩波

(华南理工大学 电子与信息学院,广东 广州 510640)

显著性目标检测任务主要是将图像中最具有视觉差异性的区域分割出来,相关方法被广泛应用于其他计算机视觉任务的预处理中,如图像编辑[1]、图像描述[2- 3]、问题回答[4]等。

早期的显著性目标检测算法依赖于研究者定义的特征,主要分为色彩分布和先验假设。如一些工作[5- 7]依据像素与区域之间的色彩对比分析来判定该像素的显著值。另外,Liu等[8]假设显著性目标处在图像的中心区域,然后利用多尺度对比、颜色空间分布以及图像中心区域直方图来检测图像中的显著目标;Sun等[9]则假设边缘像素为背景,于是将图像的左侧和顶侧假设为背景,然后通过马尔科夫吸收概率得到显著图,并利用扩散机制、超像素抑制函数和引导过滤器进一步优化完成检测。这些典型的传统检测算法取得了比较优异的性能,但是由于人工定义特征的语义表达能力有限,在具有复杂背景的场景中,算法检测性能严重受到制约。

近些年,得益于全卷积神经网络(FCN)高效的特征提取能力,显著性检测的有关研究者们做了大量工作,极大地提升了显著性目标检测模型的性能,如:崔冬等[10]利用FCN提取图像的多级深度特征并融合深层和浅层的卷积特征,然后采用传统的随机游走方法加强全局和局部特征之间的关系来得到最终的显著图;Hou等[11]在深层和浅层网络之间引入短连接,短连接结构沿通道拼接深层强的语义特征和浅层细节信息;Li等[12]分层地进行特征拼接来融合特征以得到浅层边界信息和高层语义信息,然后通过边界信息采用特征相加的方式引导深层特征得到显著图。然而每层的特征对于提升模型性能的作用不同,直接将不同层的特征融合不是最优的方案,因此Zhang等[13]引入注意力机制,在每层先采用注意力机制权重化深层特征,强化利于完成任务的特征且滤除冗余信息,然后将权重化的深层特征与浅层特征融合以得到增强的特征;Wei等[14]根据注意力机制思想,将深层特征和浅层特征相乘得到它们共同的特征,然后将其分别与输入的深层特征、浅层特征直接相加来增强对应的深层和浅层特征。这些出色的工作极大地提升了显著性检测模型的性能。

然而,目前的算法直接采用特征拼接、特征相加甚至注意力机制将FCN提取的特征进行简单的融合,没有根据任务的具体场景有针对性地增强特征,尤其是对于背景复杂、前景目标和背景元素杂糅的图像,依然存在目标误检和漏检问题。本文分析目标的误检和漏检的原因有以下3点:①目标误检多发生于显著性目标的背景复杂的场景中,此时背景的噪声对显著性目标的判定造成了极大的干扰,尤其是当背景的颜色和纹理与前景目标相似的情况下,极易将其误检为前景目标。②目标误检还会出现在前景目标和背景交织杂糅的场景,交织边界处的背景极易被误检为前景目标。③模型在网络最深层产生的分辨率较低且细节信息匮乏的显著图在不断解码为高分辨率显著图的过程中,由于细节信息修复不充分而发生目标漏检,尤其是在目标的边缘与内部区域,主要表现为预测的目标内部灰度一致性差。而现有算法仅依赖于强化浅层特征中的前景信息来得到更强的特征,这可能不是最优的策略,因为漏检的目标信息极有可能被淹没在背景特征中。

根据以上分析,文中提出了复杂场景下特征增强的显著性目标检测方法。不同于现有模型中采用特征拼接、相加以及注意力机制等特征增强策略,本文着眼于显著性目标漏检和误检易发生的背景复杂、前景目标和背景元素杂糅的场景,面向显著性目标更精细的分割需求提出了差异化的特征增强方法,以提高模型在复杂场景中对细节的检测与分割能力。具体工作包括:①背景复杂场景中目标和背景噪声的颜色、纹理相似,在局部感受野上无法准确识别前景目标,本文从全局感受野角度出发,提出了全局上下文信息提取和增强方法,在网络的最深层进一步扩展卷积核的感受野来提取全局特征,同时将全局特征直接传递到其它网络层,使得各层特征得到全局化增强,在复杂背景中对显著性目标鲁棒。②针对目标和背景交织场景中,模型对目标结构缺乏感知,极易将背景误检为显著性对象的问题,本文提出了结构化信息增强方法,将蕴含在浅层中丰富的目标空间结构信息融合到深层卷积层,使得增强后的深层特征能够对目标的结构敏感,以更准确地定位前景目标。③针对易漏检的分割区域,本文基于残差学习的思想设计了残差化特征增强模块,从背景特征中重新挖掘出丢失的前景信息,然后通过残差的方式修复深层的预测图。最后,在5个常用的数据集上对文中提出方法进行了验证。

1 整体框架

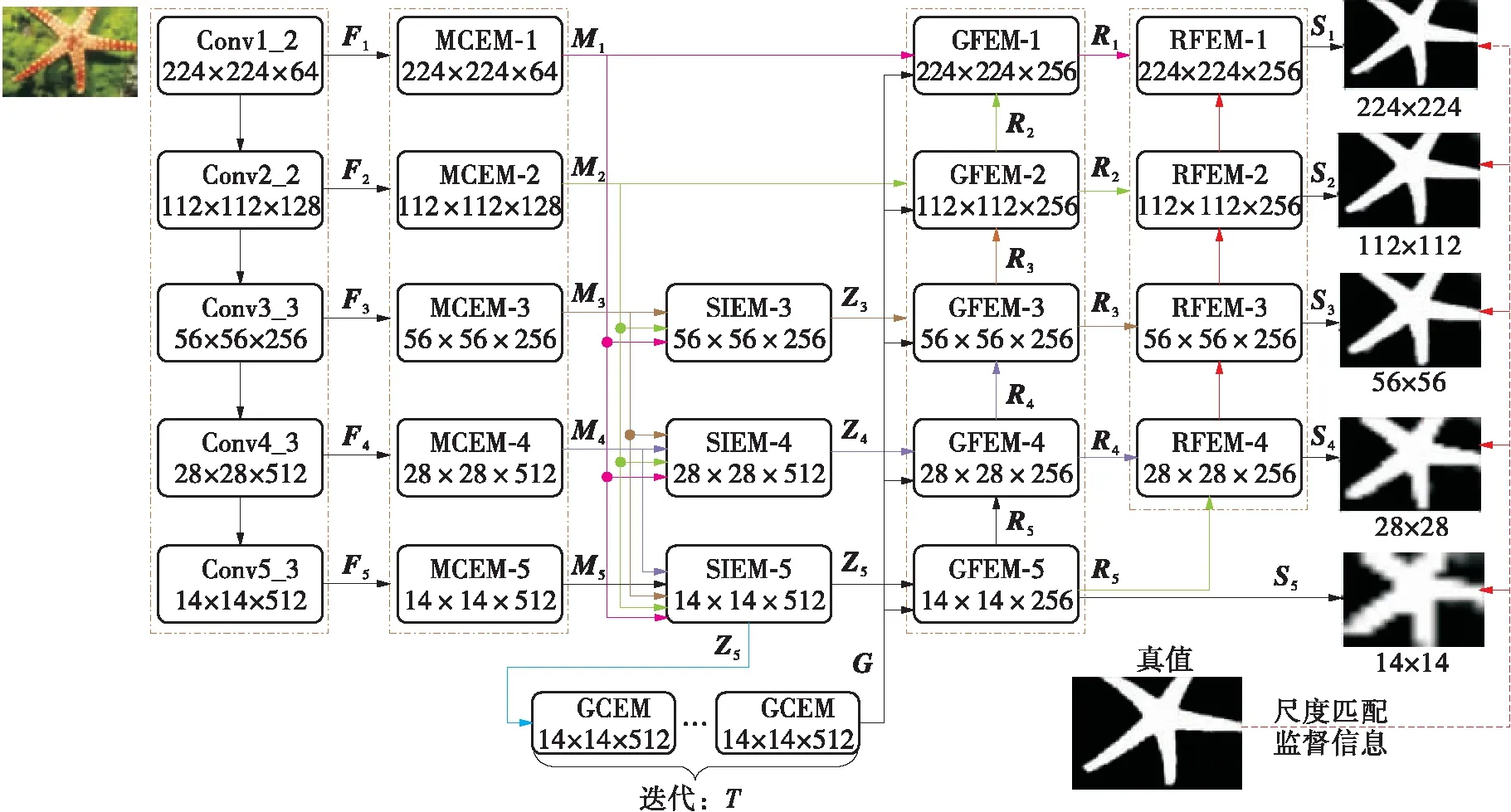

本文设计模型的整体框架如图1所示,整体框架采用“编码器-解码器”的结构。其中,编码器采用已预训练的VGG16[15]网络。显著性目标检测是像素级的视觉任务,因此本文将VGG16最后的池化层和全连接层全部丢弃。输入图片的尺寸表示为H×W,VGG16各层的输出表示为Fi,i=1,2,3,4,5。模型的工作过程为:

图1 显著性检测模型的整体框架

(1)在原始图片输入模型后,将网络各层的Fi输入多尺度特征增强模块(MCEM),在各层提取多尺度信息Mi,使得模型对尺度变化的目标鲁棒。

(2)结构化信息增强模块(SIEM)以Mi作为输入,利用浅层蕴含的目标丰富的空间结构信息增强深层特征后,得到Zi。Zi能准确定位前景和背景交织区域中的前景部分,避免发生目标误检。

(3)在Z5后接入全局上下信息提取模块(GCEM),进一步扩展卷积层的感受野,提取出全局特征G。

(4)将全局特征G直接输入给特征全局性增强方法(GFEM),GFEM融合全局特征G和各层的特征,使得各层特征得到全局性增强,从而使每层输出的深度特征Ri均可对背景复杂中的目标鲁棒。

(5)将MCEM、SIEM以及GFEM的输出传给残差化特征增强模块(RFEM),RFEM从背景中学习丢失目标的特征,渐进地以残差T修补显著图S。

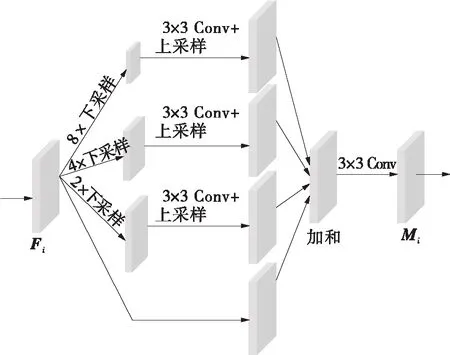

1.1 多尺度特征增强模块

输入模型的原始图片种类不一、分割对象不同且尺度变化大。VGG16在各层的感受野单一,缺乏多样的感受野,导致每层无法捕获到尺度变化的MCEM包含4个子分支,利用不同因子的池化操作对输入特征下采样以获取尺寸不同的感受野。然后下采样的特征经过3×3卷积层和上采样层恢复到与输入特征尺寸一致。MCEM采用残差连接,既保证了梯度流的更新,又保证了模块增强后的输出不会比原始输入特征弱。具体操作表示为:

目标。本文基于池化技术对原始特征增强,图2是MCEM的具体结构。

图2 MCEM结构图

Mi=φ(Sum(φ(D8(Fi),w1),φ(D4(Fi),

w2),φ(D2(Fi),w3),F),w)

(1)

其中,Sum代表像素相加操作;φ表示一个3×3的卷积层;D8、D4、D2分别表示因子为8、4、2的下采样层;w1、w2、w3、w代表卷积层的参数。采用池化技术的优点有:①池化能帮助特征去除噪声,捕捉语义信息;②不同核的池化能进一步获取不同的感受野,从而适应尺度变化的目标。

1.2 结构化信息增强模块

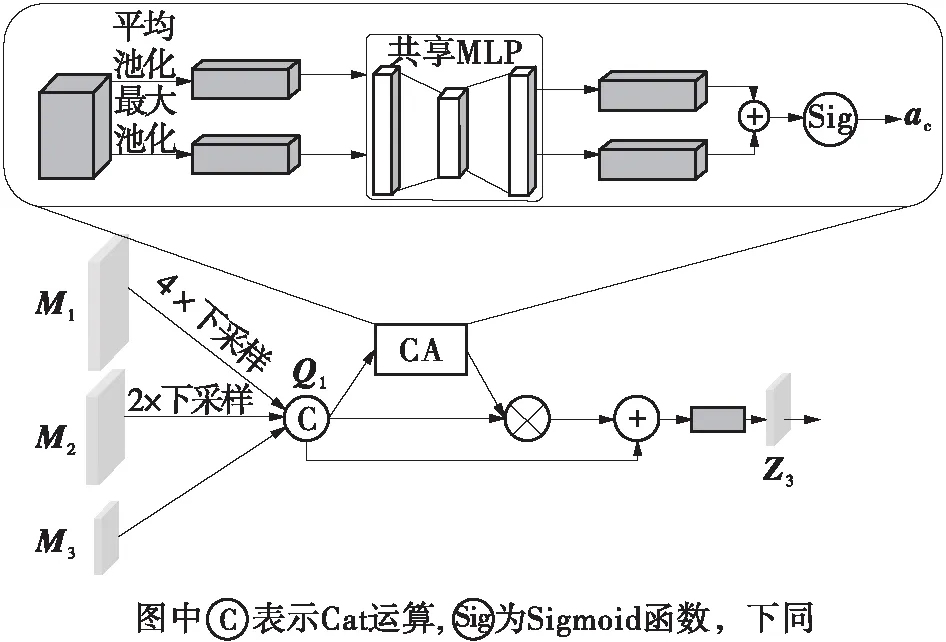

前景和背景交织在一起给模型定位显著性目标带来了极大的困难。交织区域中的前景和背景相互杂糅,模型极易将背景误检为前景。原因在于深层语义特征定位目标的过程中缺乏对目标的结构化细节信息的感知,导致模型无法对交织的前景和背景做出有效的区分。因此本文将浅层网络蕴含的目标结构化信息传递给深层网络,增强深层特征使其对目标的结构具有鲁棒性,从而达到区分交织前景和背景区域的效果。文献[16]提出目标的定位在最深的3层,因此本文在网络最深的3层进行特征结构化增强。

本文设计了SIEM实现特征的结构化增强,其部署在网络最深的3层,分别为SIEM- 3、SIEM- 4和SIEM- 5,它们的结构相同,具体位置如图1所示。为了更加充分地挖掘出浅层网络蕴涵的目标结构化信息,以有效地结构化增强深层特征,SIEM 的输入部分采用了密集连接的方式,即当前SIEM的输入为前面所有层的MCEM的输出(如图1所示),这也使得它们的输入数量不同。而在模块内,SIEM在不同的输入特征后接入不同因子的池化层,可以使得不同尺寸的输入特征匹配当前深层特征的尺寸。

为了方便起见,本文仅以SIEM- 3为例讨论结构化信息增强模块,其结构如图3所示。SIEM- 3的输入是较浅的3层网络经过多尺度增强之后的特征Mi(i=1,2,3),随后将Mi(i=1,2)分别经过因子为4和2的池化操作,使其尺寸与M3匹配。然后将Mi沿通道维度拼接得到Q1。由于不同层的特征对于目标的定位起不同的作用,因此在Q1后加入通道注意力模块(CA)。CA首先对输入特征在空间维度上进行平均池化和最大池化得到两种特征向量,这样可以更好地保留原始特征的纹理和前景信息;然后将这两种特征向量输入到一个参数共享的多层感知机(MLP),MLP为3层瓶颈式全连接层网络。最后将MLP输出的两种特征向量相加并经过Sigmoid激活函数得到通道注意向量ac。ac沿通道维度权重特征Q1,并和Q1残差相加;最后,通过一个1×1的卷积层降维得到Z3,并使其和M3的通道维度匹配。整个过程可表示为:

图3 SIEM- 3的结构图

ac=σ(MLP(AP(φ(Cat(M1,M2,M3),w1)))+

MLP(MP(φ(Cat(M1,M2,M3),w2))))

(2)

Z3=φ(Q1⊗ac+Q1,w3)

(3)

式中:MLP表示多层感知机;AP和MP分别表示平均和最大池化;Cat表示通道维度的特征拼接;⊗表示特征相乘。

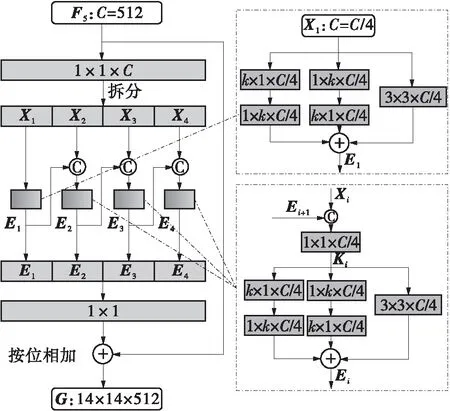

1.3 全局上下文提取模块

根据Zhou等[17]的工作,卷积神经网络理论上的感受野比实际感受野小,导致网络中的感受野是局部的,无法从全局角度准确判断每一个像素是否属于前景,因此本文提出GCEM,进一步扩展感受野以得到全局特征。

图4描述了GCEM的结构,其中C为通道数量。GCEM的输入为第5个卷积层特征F5。工作过程如下:

图4 GCEM的结构图

(1)GCEM沿着通道维度将F5分成4等份(X1、X2、X3、X4),以降低计算量和模型的参数量;

(2)每一等份上采用1×k+k×1、k×1+1×k和3×3组成的混合卷积层扩大感受野;

(3)受启于文献[15]中堆叠小卷积核以实现大卷积核效果的思想,GCEM级联每个混合卷积层的输出,即当前混合卷积层的输出作为下一个混合卷积层的输入。这样既能获得全局感受野,又可进一步降低参数量;

(4)将4等份的输出沿通道拼接,并采用一个1×1的卷积层和残差连接得到最终的全局特征G。为了保证感受野是全局的,本文在F5后级联2个GCEM模块。

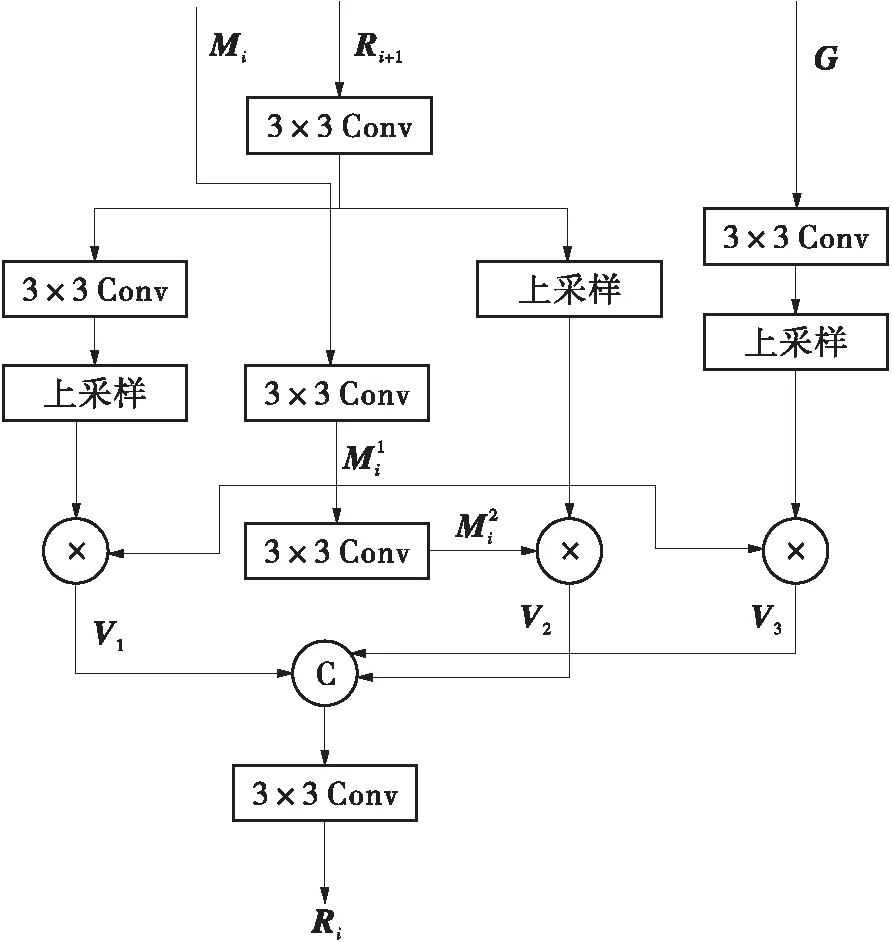

1.4 特征全局性增强模块

VGG16的各层特征尽管经过多尺度增强和结构化增强,但其感受野是局部的,导致模型无法准确地定位复杂场景中的目标,因此本文进一步利用GCEM输出的全局特征G对各层的特征进行全局性增强,一方面去除各层特征中的冗余和噪声,另一方面使得各层的特征对复杂场景的目标具有鲁棒性。

图5 GFEM的结构图

(4)

(5)

(6)

(7)

Ri=φ(Cat(V1,V2,V3),w5)

(8)

其中,up表示双线性上采样层。

1.5 残差化特征增强模块

将深层低分辨率显著图解码产生最终高分辨率显著图的过程中,已有的工作[11,13]重点关注于强化浅层特征中的前景信息,从而得到更强的特征,并且用其去修复低分辨率显著图。这忽略了浅层特征的背景信息对于目标的修复作用,因为漏检的目标区域可能被淹没在背景特征中,所以仅从前景信息无法将漏检的显著性区域召回,造成显著图得不到充分的修复。本文基于残差学习的思想设计了RFEM,其从背景中重新学习到缺失目标的信息,然后用其来补足深层的显著图,可以显著地缓解目标漏检的问题。

由于显著图已经丢失了丰富的信息,无法从中更充分有效地重新学习,因此RFEM-i没有直接采用显著图,而是采用对应的特征图。RFEM-i的输入为深层特征图Ti+1和相邻的浅层特征图Ri。具体工作过程为:

(1)Ti+1经过2倍上采样,以及经Sigmoid函数归一化得到模型检测的前景像素的概率值;

(2)用“1”减去该概率值得到对应的背景像素的概率值。利用背景像素的概率值加权浅层特征Ri得到权重化的浅层背景特征W_Ri;

(3)W_Ri经过一个3×3的卷积层从背景特征中重新学习,得到丢失的前景目标信息并与Ti+1残差相加来补足Ti+1丢失的前景区域。整个残差化特征增强过程如下:

W_Ri=Ri⊗(1-Sig(up(Ti+1)))

(9)

Ti=up(Ti+1)+φ(W_Ri,w)

(10)

其中,Sig表示Sigmoid函数。为了促进网络优化,本文在每层加入了辅助监督学习。RFEM每层的输出Ti经过一个1×1的卷积层和一个Sigmoid函数得到通道数为1、像素值在[0,1]的显著图Si。然后将真值图进行下采样,与Si尺寸一致。整个损失函数Ltotal包含两部分:最终输出的显著图的主损失函数和每层的辅助监督损失函数。

(11)

(12)

2 实验配置

2.1 训练参数

本文用VGG16参数初始化模型的前13个卷积层,其余结构采用Xavier[18]方式初始化。采用Adam[19]优化器,初始学习率为10-5,在训练15轮之后,学习率降为10-6。辅助损失函数的权值λi(i=2,3,4,5)分别设置为0.8、0.5、0.5、0.5。在训练阶段,采用水平翻转的数据增强方法,然后每张图像被调整为256×256,再随机裁剪成224×224。在测试阶段,直接将图像调整为224×224,并输入到模型中产生对应的显著图。模型每次输入图像的数量为4,即batch大小为4。本文基于DUTS-TR[20]数据集训练,在单个GTX Titan XP GPU上共训练了19轮。

2.2 数据集

本文模型和其他方法分别在5个数据集上对比:DUTS-TE[20]、ECSSD[21]、SOD[22]、HKU-IS[23]、PASCAL-S[24]。

2.3 性能评估指标

本文采用文献[25]中的评估方法评估算法的性能,具体包含P-R曲线(P为精确率,R为召回率)、Fβ分数以及平均绝对误差(EMAE)。P-R曲线常被用来评估预测的显著图,通过在0到255之间滑动取得阈值用来二值化显著图。然后根据二值化的显著图与真值图计算精确率和召回率,而Fβ是综合性的评估指标,计算公式为:

(13)

为了强调精确率比召回率更重要,β2设置为0.3。而EMAE用来计算预测的显著图和真值图之间的平均绝对误差,公式定义如下:

(14)

式中,TS(u,v)、TG(u,v)分别为显著图和真值图中坐标为(u,v)的像素的取值。

3 实验

3.1 消融实验

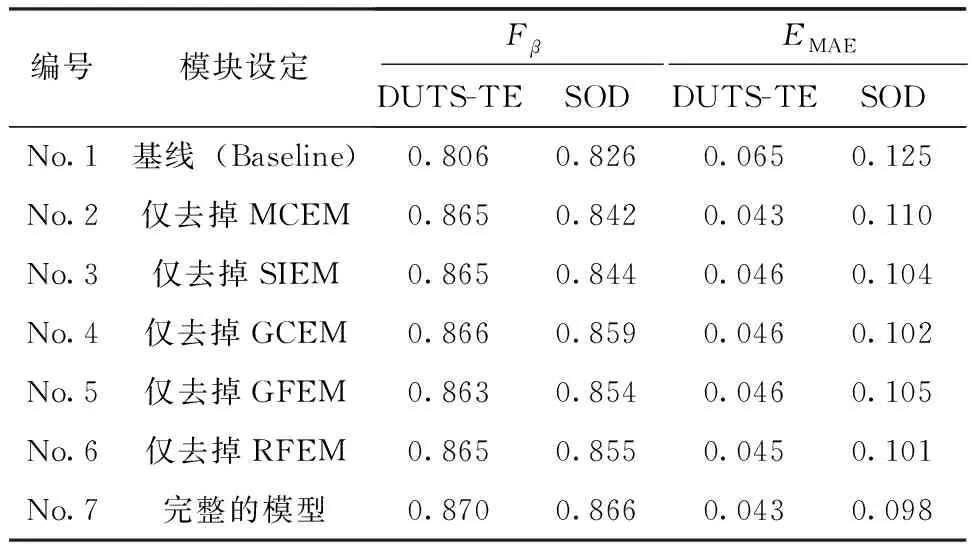

本文在DUTS-TE和SOD数据集上做了一系列消融实验来验证和分析本文所提模块的有效性。

如表1所示:

表1 消融实验结果

(1)本文在完整的模型上只去掉MCEM,从No.2可知,Fβ分数大幅度降低,EMAE上升,表明MCEM能有效提取多尺度信息,增强每层特征,使其能够捕获到尺度变化的目标;

(2)由No.3可知,模型仅去掉SIEM结构,其他模块保持不变,使得Fβ和EMAE分别降低和上升,表明SIEM能有效地结构化信息增强深层的语义特征,使得模型能准确地定位交织区域中的前景目标,避免发生目标误检情况;

(3)由No.4和No.5可知,分别去掉GCEM和GFEM时,Fβ和EMAE分别呈现降低和上升,证明了GCEM和GFEM从全局的角度确保模型在各层都能适应背景复杂的场景,极大缓解了此场景中的目标定位不准确导致的目标误检问题;

(4)从No.6可知,仅去掉RFEM时,Fβ和EMAE分别下降和上升,验证了RFEM从背景中学到了丢失的前景目标信息,并通过残差的方式来修复残缺的显著图,缓解了目标漏检的问题。

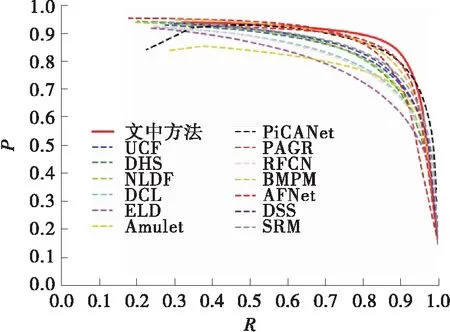

3.2 与其他先进方法的对比

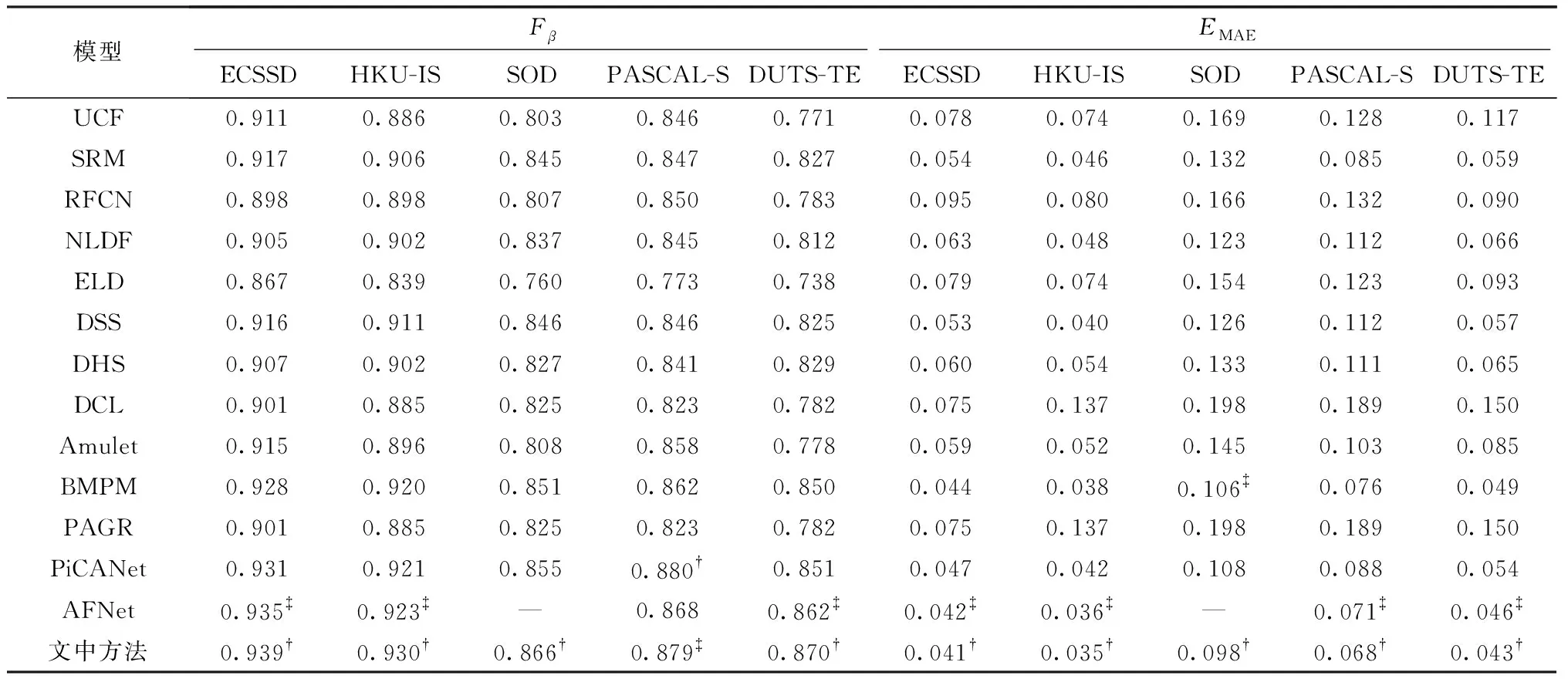

将文中提出的模型和其他13种先进方法(DSS[11]、UCF[26]、DCL[27]、AFNet[28]、PAGR[13]、Amulet[29]、DHS[30]、ELD[31]、NLDF[32]、RFCN[33]、SRM[34]、PiCANet[35]和BMPM[36])对比。这些方法均为近年提出且在5个数据集上表现优异。为了公平比较,这些先进方法的实验数据来自原文,或者根据原文作者提供的源代码测试产生。

从定量角度分析,表2列出了文中模型和其他13种先进方法在5个数据集上的性能评估指标结果。从表2中可知,文中模型在不同数据集以及不同的指标上均优于13种对比方法,从而证明了文中提出模型的有效性。根据文中模型与其他13种先进方法在4个数据集上的测试结果,画出了P-R曲线,如图6所示。可以看到文中模型的P-R曲线均优于其他模型的P-R曲线。

(a)DUTS-TE上

表2 在5个数据集上文中模型和其他13种先进方法的定量比较1)

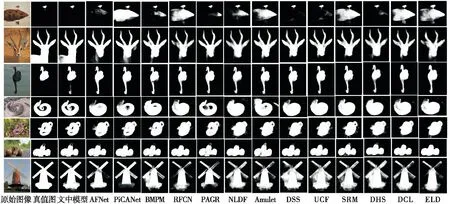

为了更直观地从视觉角度观察模型的性能,图7展现了文中模型和其他13种先进方法在测试集上输出的显著图。由图可知:第1列的第1和第2张图目标的尺度变化非常大,但文中模型仍能很准确地分割出目标,从而验证了MCEM能有效缓解目标尺度变化大的情况;第3张图前景和背景的颜色、纹理非常接近,严重干扰前景的检测,文中模型依然能准确定位目标,不会将背景误检为前景,说明GCEM和GFEM有效地缓解了背景复杂场景中的目标误检问题;第4和第5张图中蜷曲的

第1列原始图像来自测试数据集;第2列为真值图;第3列是文中模型产生的显著图;从第4列至最后1列为其他13种先进方法产生的显著图

蛇和背景交织在一起,蛇中间的背景极易被误判为前景,而文中模型能很好地将交织的背景剔除,准确定位出交织中的前景,证明文中提出的SIEM可有效地缓解交织场景中的目标误检问题;第6张图中的蜗牛触角能有效地被文中模型分割出来,以及第7张图中风车的风叶和底座能被完整地分割,分割的结果内部灰度一致,从而验证了RFEM结构能从背景中学到目标的边缘和内部丢失的部分,最终得到灰度一致的完整显著图。相对地,其他模型在这些复杂场景下无法分割完整的目标。

4 结论

根据已有工作中在复杂场景下存在的目标误检和漏检的问题,文中提出了针对性的特征增强方法。由于目标误检主要发生在目标和背景交织以及背景复杂的场景中,因此本文分别从结构化和全局性角度对原始特征增强,从而避免交织中的背景以及复杂的背景环境对前景目标定位带来干扰。此外,目标漏检多发在低分辨率显著图解码为高分辨率显著图的过程中,尤其是目标的边缘和内部,本文在解码的过程中,从背景中重新学习前景丢失区域的信息,然后利用残差的方式补足和修复前景目标丢失的区域,最终得到灰度一致的显著图。消融实验的结果表明,本文所提出的各特征增强方法有效地缓解和解决了显著性目标漏检和误检问题,对比实验也表明本文所提模型的性能优于其他先进的检测方法。由于本文模块较多、模型复杂,未来将更加深入探索各模块之间的联系,设计一种统一的解决方案,轻量化模型,在保持模型性能的同时提升算法的运行速度。