基于BiGRU和注意力交互模型的方面级情感分析

汪平凡

北京星网船电科技有限公司,北京 102308

0 前言

互联网技术的发展拓宽了信息交互的渠道,人们习惯在网络平台发表观点,表达个人情感。提取并分析带有个人情感色彩的文本信息可以帮助我们认识事物的多面性,具有一定的应用价值[1]。如何将非结构文本转化为计算机可以识别的结构化信息,以及如何有效识别文本中特定方面的情感倾向成为研究的热点。

传统的粗粒度级情感分析只关注文本整体情感倾向,无法深入挖掘句子中潜在的语义信息[2]。方面级情感分析旨在识别句子中某个特定实体或属性的情感倾向(如积极、消极、中性)。例如,给定一句话“餐厅的食物非常美味,但周围的环境很糟糕”,那么“食物”和“环境”这两个方面词的情感极性分别是积极和消极,因此,情感极性的判别不仅由句子的内容决定,而且与文本中特定方面词密切相关。如果我们忽略了方面词对整个句子的影响,就无法准确地分析出文本所表达的情感倾向[3]。

神经网络因其独特的优势而被研究者们应用在情感分析领域。TANG D等人[4]提出TD-LSTM模型,该模型使用两个LSTM网络分别对上下文和方面词建模,将得到的隐藏向量拼接起来输入到softmax层进行情感分类。GRAVES A等人[5]使用循环卷积神经网络进行文本分析,该方法从正反两个方向学习词语的时序关系。TAI KS等人[6]考虑了句子语义信息,在LSTM网络基础上引入外部依存树来提高情感分析的准确度。

由于句子中每个词对情感分类的贡献不同,注意力机制被应用到深度学习模型中为词语分配不同的权重分数。WANG X等人[7]结合LSTM网络和注意力机制分析文本中特定方面的情感倾向,模型在训练过程中关注特定方面信息,避免对文本做相同处理。余本功等人[8]使用双重注意力机制分析文本信息,利用综合权重强化特定方面词和上下文之间的相关特征。MA D等人[9]提出交互注意力模型(IAN),利用注意力机制交互学习方面词和上下文之间的关联信息,取得了较好的情感分类效果。曾铎等人[10]提出多头注意力循环神经网络模型,使得模型充分学习方面词和上下文之间的特征关系。

本文将GRU网络和注意力机制相结合,提出了基于BiGRU的注意力交互模型。该模型分别对句子和方面词建模,考虑方面词对句子整体情感极性的影响。首先,利用Bert预训练模型表示句子和方面词的特征向量,然后,GRU网络提取词向量信息,得到隐藏层向量表示,注意力机制交互学习句子和方面词之间的关联,区分句子中不同词语对情感分类结果的影响。

1 相关模型和技术

1.1 Bert模型

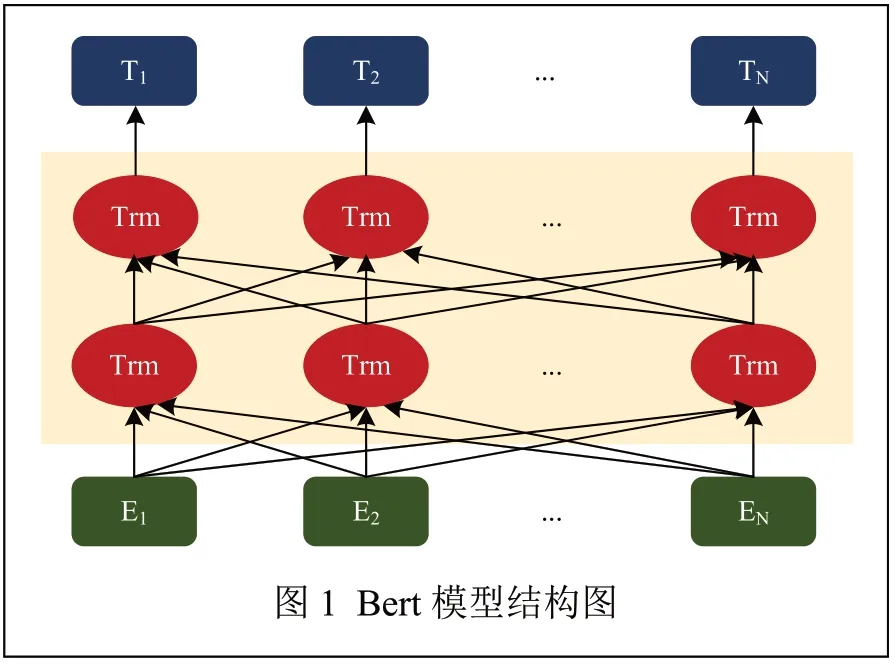

Bert模型是DEVLIN J等人[11]提出的一种预训练模型,该模型在Transformer的基础上进行改进。与word2Vec、Glove等语言表征模型不同,Bert模型旨在通过调节所有层中的信息来预先训练词向量,去除词语之间较长距离的限制,将目标词与上下文之间的内在关联显式地表现出来,可以解决模型无法并行处理和信息长期依赖的问题。Bert网络结构如图1 所示。

1.2 门控循环单元

门控循环单元(Gate Recurrent Unit,GRU)是循环神经网络(Recurrent Neural Network,RNN)中的一种门控机制,其旨在解决循环神经网络中出现的梯度衰减或爆炸问题,并同时捕捉时间序列中长距离间的依赖关系。GRU网络是在长短期记忆网络的基础上发展而来,仅存在更新门和重置门,GRU网络通过门结构来控制信息的流动。与LSTM网络相比,GRU网络结构相对简单,更容易进行训练,能够在很大程度上提高模型的训练速度。

1.3 注意力机制

BAHDANAU D等[12]首次将注意力机制引入到自然语言处理任务中,用以解决源序列与目标序列因距离过长而无法建立依赖关系的问题。注意力机制可以自动学习并计算输入数据对输出数据的贡献大小,从而为词语分配相应的权重分数,引入注意力机制可以更好地学习词之间的依赖关系,增强对重要词汇的关注。

2 基于BiGRU的注意力交互模型

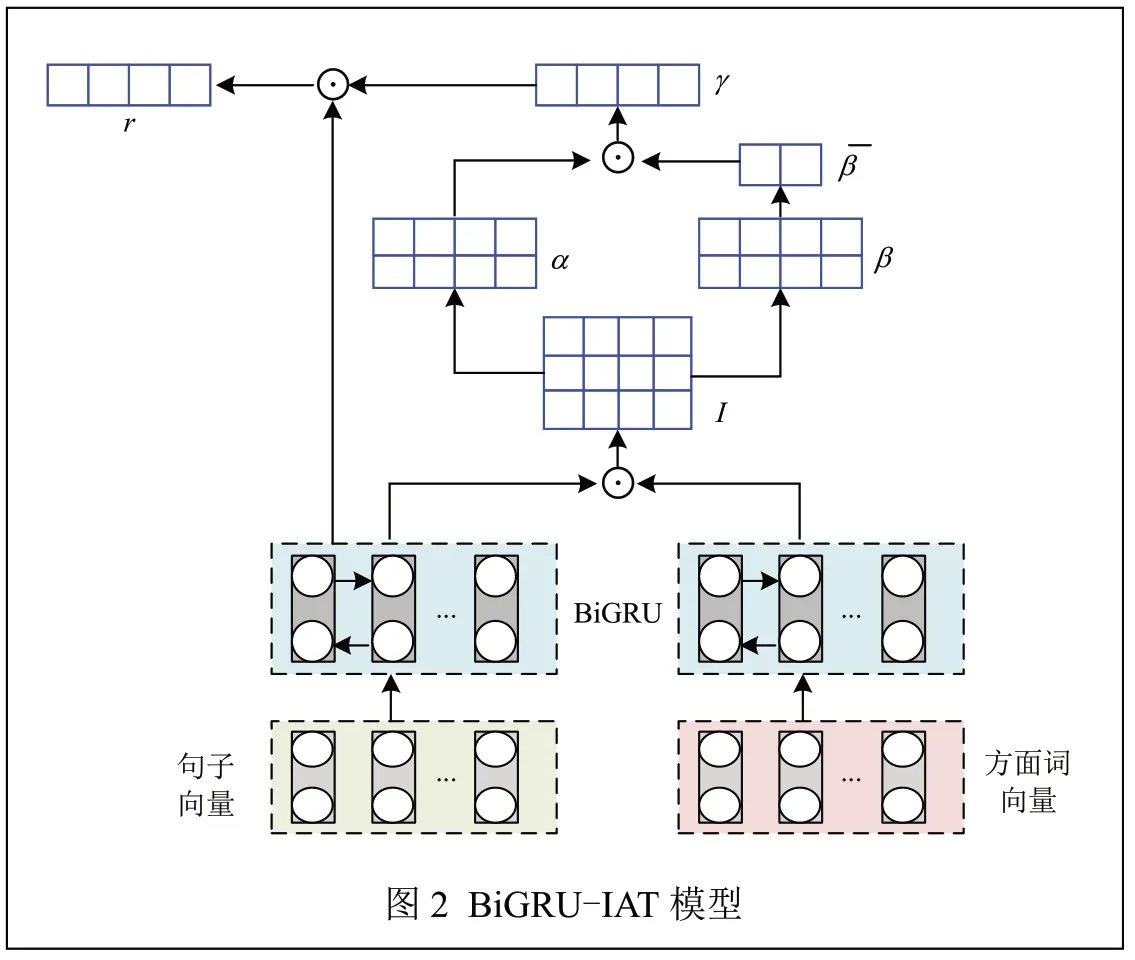

在方面级情感分析问题中,首先给定一个句子s=[w1,w2,…,wi,…,wj,…,wn]和 方 面 词t=[wi,wi+1,…,wi+m],方面词可以是单词或短语,目的是判断方面词在句子中的情感极性。本文提出的模型如图2所示,主要包括词嵌入层、双向GRU层、注意力交互层和输出层。

2.1 词嵌入层

词嵌入层包括方面词向量和句子向量嵌入,给定句子s=[w1,w2,…,wi,…,wj,…,wn],n表示句子的长度,方面词t=[wi,wi+1,…,wi+m],m表示方面词的长度。使用Bert预训练模型将每个单词映射为连续的词向量表示,Bert模型通过调节所有层的信息来预训练词向量,能够根据上下文信息调整词向量表示,从而有效解决词语的多义性问题。

本文使用规模较小的BERTBase训练词向量,其相关的参数设置如表1所示。

表1 BERTBase参数

2.2 双向GRU网络层

将文本词向量输入到双向GRU网络中,GRU网络提取方面词和上下文信息得到隐藏层向量表示。通过输入s=[v1;v2;…;vn]和前向GRU网络,可以得到隐藏状态序列,其中,dh是隐藏状态的维数。通过输入s=[v1;v2;…;vn]和后向GRU网络得到。双向GRU网络中,最终输出的隐藏向量表示为,其中,,n为句子长度。

2.3 注意力交互层

注意力机制获取隐藏层向量的关键信息,为词语分配不同的权重分数,交互式学习词向量之间的依赖关系。给定方面序列表示为,句子序列表示,首先计算交互注意力权重矩阵矩阵的值表示句子和方面词之间的词对相关性,分别对交互矩阵的行和列做归一化处理,得到行和列的权重值α和β,其中,α表示方面词对句子的权重分数,β表示句子对每个方面词的权重分数,对β逐列取平均值得到方面级注意力权重,用以表示方面词中的重要部分,最后得出方面词序列对每个词语的权重分数γ∈Rn,γ值代表着文本词对方面词的重要程度,具体计算公式如式(1)~式(4)所示:

其中,αij——方面词对全部文本的注意力权重值;

Iij——方面序列和句子序列的交互注意力权重矩阵。

其中,βij——文本对方面词的注意力权重值。

其中,——方面级注意力权重;

n——句子长度。

其中,α——方面词对文本的注意力权重值;

——方面级注意力权重的转置。

使用文本对方面词和方面词对文本的注意力权重值乘上句子隐藏向量表示,最终得到方面词和上下文的交互表示,用于文本的最终分类,具体计算如公式(5)所示:

其中,——句子向量的转置;

γ——注意力权重。

2.4 输出层

将最终的向量表示输送到softmax层得到文本的

情感极性,P表示真实的情感分类,表示预测的情感分类,损失目标函数如公式(6)所示:

其中,i——句子中的索引;

j——3种分类;

λ——L2正则化系数;

θ——模型中设置的参数。

3 实验

3.1 数据集及参数设置

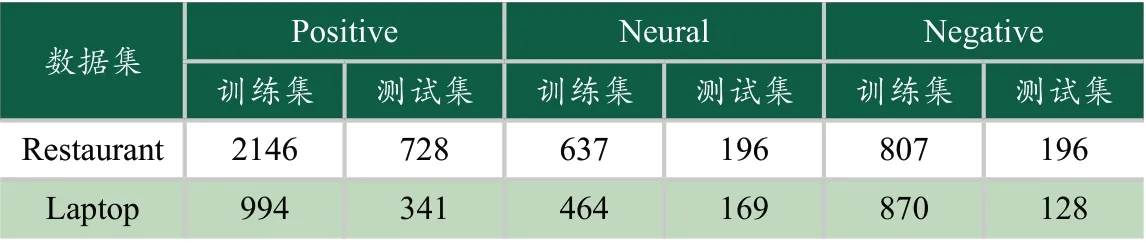

本文在SemEval2014数据集(包括Laptop和Restaurant数据集)进行实验,该数据集已标注句子中的方面词及其Positive、Neural和Negative 3种情感极性。数据集的统计信息如表2所示。

表2 数据集统计

将数据集分为训练集和测试集进行学习,所有权重矩阵随机初始化,所有偏置项设置为0,L2正则化系数设置为0.0001,dropout设置为0.5,使用Bert预训练模型表示句子和方面词的特征向量。GRU隐藏状态的维度设置为150,Adam优化器初始学习率为0.01,批处理大小为64。

3.2 对比模型及实验结果

将BiGRU-IAT模型与多个模型在SemEval数据集上进行实验,验证本文模型的有效性。

TD-LSTM模型[4]:使用两个LSTM网络学习文本信息,将得到的隐藏向量拼接起来,送入softmax层进行情感分类。

AT-LSTM模型[7]:使用LSTM网络分别对句子和方面词编码,注意力机制捕捉隐藏状态与方面词向量之间的内在联系。

ATAE-LSTM模型[7]:该模型在AT-LSTM模型的基础上改进,将方面词嵌入到每个单词向量中,充分考虑方面词对句子整体情感倾向的影响。

IAN模型[9]:利用LSTM网络学习句子和方面词信息,注意力机制交互式学习句子和方面词的注意权重。

实验中使用准确率和F1值作为评价指标,验证模型的有效性,实验结果如表3所示。

表3 不同模型实验结果对比

从表3中可以看出本文模型取得了较好的分类效果,分类准确率分别达到77.45%、83.61%,F1值达到73.5%、78.28%。TD-LSTM模型的性能较差,主要原因是根据方面词的位置信息分割语句,LSTM网络无法获取完整的语义信息,从而影响了模型的情感分类效果。AT-LSTM模型中引入注意力机制,模型可以充分捕捉句子中方面词的关键信息。ATAE-LSTM模型在AT-LSTM模型基础上进一步扩展,使用LSTM网络对方面词和上下文建模,充分考虑方面词对句子情感极性的影响,将方面词作为模型的一部分参与训练,得到文本在给定方面词上的权重表示。IAN模型使用交互注意网络学习方面词和上下文的内在联系,进一步强调文本中方面词的重要性。

本文提出的BiGRU-IAT模型结合了GRU网络和注意力机制的优势,使用Bert预训练模型分别对句子和方面词编码,充分考虑文本语义相关性,分析词语在不同上下文中的语义表达,从而有效地解决一词多义的问题。GRU网络从正反两个方向提取词向量信息得到隐藏层向量表示,注意力机制交互式学习方面词和句子之间的关联性,从而得到较好的情感分类效果。

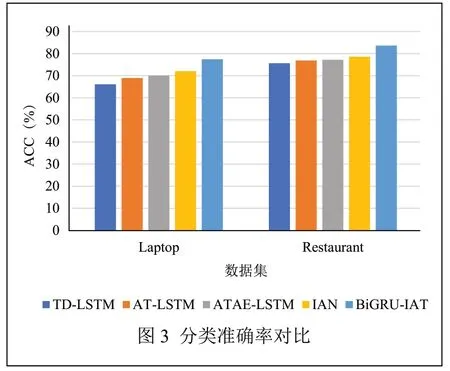

在不同模型中分类准确率的对比结果如图3所示,横轴表示Laptop和Restaurant数据集,纵轴为准确率(ACC)。

从图中可以直观地看出,BiGRU-IAT模型在SemEval2014数据集上准确率最高,实验结果充分说明了该模型的有效性。

4 结论

本文针对传统神经网络模型忽略方面词的问题,提出了基于BiGRU的注意力交互模型,充分考虑方面词对文本整体情感倾向的影响。模型使用Bert表示句子和方面词的特征向量,GRU网络从正反两个方向获取方面词和上下文的语义信息,利用注意力机制交互学习句子和方面词之间的内在联系。最后,在SemEval2014数据集上与多个模型进行对比,实验结果验证了BiGRU-IAT模型的有效性。