一种重叠视域多摄像头协同运动目标跟踪方法

李 旭,俞 娜,李景文,2,姜建武,2

(1.桂林理工大学测绘地理信息学院,广西桂林 541006;2.桂林理工大学广西空间信息与测绘重点实验室,广西桂林 541006)

1 引言

在运动目标检测和跟踪过程中单一摄像头难以实现大范围、多角度、长时间的跟踪监控[1],如何利用多摄像头协同工作实现目标检测和跟踪成为当前研究的热点。近年来众多学者对运动目标特征提取、跟踪和检测问题进行了研究,潘邈[2]通过计算目标图像的均布差值来划分运动前景和背景,融合EM算法得到目标图像特征的所属类别,进而完成精确的目标跟踪;卜言生[3]采用RGB 颜色特征与LBP 纹理特征对目标进行背景目标双加权,利用特征更新选择函数,从而实现目标行人的有效跟踪;杨辉[4]提出一种融合Harris角点和Surf算法对Meanshift改进的算法,提高了运动目标跟踪算法的性能;吴玮[5]等在Camshift算法框架下得到目标匹配中心位置,通过自适应加权融合的方法得到最优中心位置,进而实现存在颜色干扰以及目标重叠遮挡时运动目标的跟踪;W.Zhou[6]利用背景减法、HOG特征检测和系统聚类的偏差二乘法建立了基于HOG检测和系统聚类的多视角前景匹配模型,实现对同一位置不同角度前景运动目标的检测和提取;M.Z.Alom[7]等利用动态环境神经网络和背景差分法对行人进行检测,从而更好的获得前景区域的运动目标实时跟踪和检测。上述算法虽较好地实现了动态目标的实时跟踪,但是在多摄像头连续跟踪且存在重叠视野范围时,不能实现对同一运动目标的检测和跟踪。本文提出一种通过特征点对数匹配生成重叠视域范围内的视野分界线,实现同一运动目标判别和实时跟踪,完成在重叠视域范围的多视角协同的运动目标跟踪方法。

2 重叠视域运动目标交接跟踪实现过程

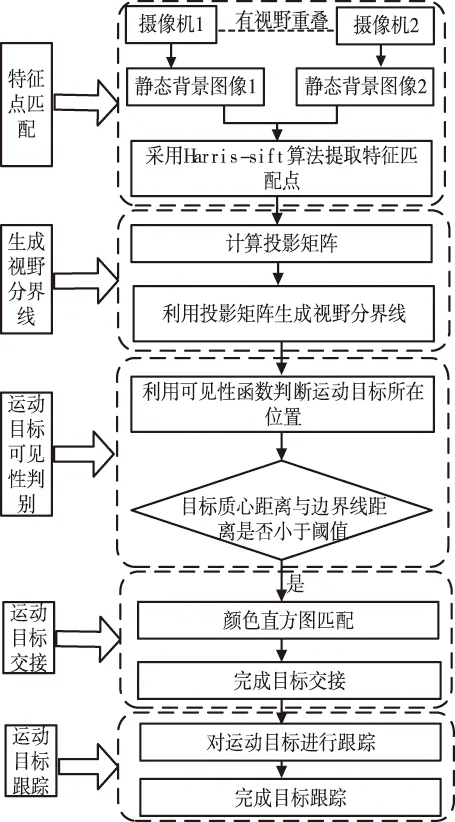

特征点的匹配、视野分界线的确定和目标的交接与跟踪是实现运动目标在重叠视域多视角协同下交接跟踪的核心环节,其具体过程是:首先通过Harris-Sift算法自动生成特征匹配点对,利用特征点对数计算求得投影矩阵,进而生成视野分界线,然后利用可见性函数判断运动目标的位置,检测识别同一运动目标,完成对重叠视域范围内的同一运动目标实时跟踪,该方法的具体技术流程如图1所示。

图1 运动目标交接跟踪技术流程

3 运动目标交接跟踪方法

在图1中,运动目标交接跟踪方法主要包括Harris-Sift特征点匹配、重叠视域视野分界线的生成、目标可见性判别、运动目标交接和运动目标跟踪五部分,特征点匹配结果和视野分界线为运动目标的可见性判别提供了基础,运动目标检测和交接是实现同一运动目标实时跟踪的关键环节。

3.1 Harris-Sift特征点匹配算法

本文将Harris算法和Sift算法相融合,利用Harris算法能够剔除视域范围边缘特征点对Sift算法[8,9]进行改进,通过Harris在角点邻域范围以角点为中心,设置半径限制检测图像特征点,从而删除不在Harris角点领域范围内的Sift特征点提高特征点匹配效率,实现光滑边缘特征点的提取,降低误匹配精度,提高特征点匹配效率。Harris-Sift特征点匹配方法的过程如下:

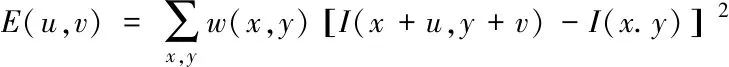

将图像窗口[u,v]进行灰度化E(u,v):

(1)

其中

I(x+u,y+v)=I(x,y)+Ixu+Iyv+o(u2,v2)

(2)

则

(3)

是用来滤波的高斯函数,对于局部微小移动量[u,v],表式为

(4)

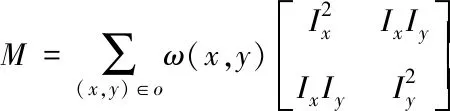

M为2×2矩阵,由图像的导数求得

(5)

对角点相应函数F进行阈值处理,F>threshold,即得到F的局部极大值

F(x,y)=det(M)-Ktrace2(M)

(6)

其中K为常数项,取值范围是0.03~0.05;det(M)=λ1λ2,trace(M)=λ1+λ2,和trace(M)分别为自相关矩阵的行列式和迹。

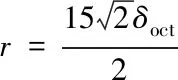

本文算法以Harris角点为中心,r为半径检测图像的特征点。其中半径r计算公式为

(7)

式中:δoct为Harris角点所在尺度。通过定义半径r,寻找得到半径r范围内的特征点,删除定义r半径外邻域范围的Sift特征点,使得这些特征点同时具备高稳定性和旋转不变性。利用最终在重叠视域范围得到的特征匹配点为视野分界线的生成提供基础。

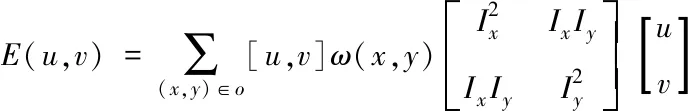

3.2 视野分界线生成方法

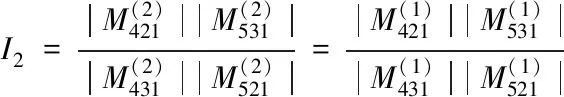

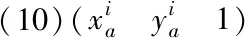

投影不变量算法[10]是一种投影变量不受场景、场景中目标的运动以及摄像机参数等信息变化而改变的方法,因此采用该方法能较好地生成视野分界线。如图2所示,图像A1和图像A2中任选三点,均不能构成一条直线,因此可以得到相互独立的两个投影不变量

(8)

(9)

(10)

利用Harris-Sift算法得到4对特征匹配点并获取相应坐标,选取摄像头A2右边界上的两点,将这两点的坐标和已获得的4点坐标带入式(8)中计算,求得A2右边界上的两点在A1中的对应点,连接两点,得到A2图像在A1图像中的视野分界线,再利用得到的重叠视域范围的视野分界线来判别运动目标。

3.3 运动目标可见性判别过程

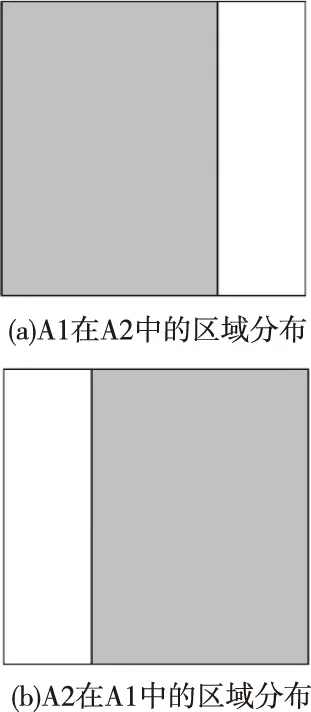

利用投影不变量算法得到的视野分界线后将一个摄像头的视野分为两个区域,如图3所示。其中灰色区域为视野中的可见区域,白色区域为不可见区域。

图3 相邻摄像头可见区域示意图

设所追踪的运动目标在A1图像中质心位置坐标为Q:(x1,y1),图像中的视野分界线为Q1Q2:Ax+By+C=0,则运动目标在图像A1视野中的目标可见性判别为

Q(x1,y2)=Ax1+By1+

(11)

因此,为确保运动目标能够顺利跟踪,只需通过运动目标判别性函数在视野范围以及视野分界线的情况即可。通过目标可见性判别,为后续实现对运动目标在重叠视域的交接和跟踪提供良好的基础。

3.4 运动目标交接

当运动目标从一个视野范围进入另一个视野范围时,判断运动目标的质心与视野分界线之间的水平距离即只需计算水平方向x的之间的值,将水平差值值最小的运动目标记为跟踪目标。运动目标的标记过程可以记为

(12)

通过直方图与视野分界线相匹配来解决在运动目标交接过程中出现误判而导致目标交接失败的问题,具体方法是:

1)根据目标质心与视野分界线在X方向的距离,通过对比阈值确定待跟踪目标,将待跟踪目标与跟踪目标的颜色直方图进行匹配度识别;

2)对匹配度最好的待跟踪目标赋予标识,进而完成运动目标交接。

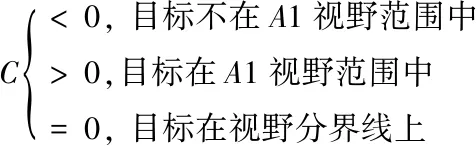

3.5 运动目标跟踪

运动目标跟踪首先利用Vibe算法对视频帧图像建立背景模型并对背景进行实时更新;然后是对图像进行三帧差分运算,并得到前景运动目标;最后利用meanshift算法融合实现对运动目标的提取,从而解决运动目标跟踪失败问题,具体流程如图4所示。

图4 运动目标跟踪过程

利用上述运动目标跟踪方法消除了Vibe算法在运动目标检测过程中产生的鬼影,解决了运动目标跟踪丢失的问题,实现了运动目标的实时跟踪。

4 实验验证

为了验证所提方法的有效性,本文所采用的开发环境为CPU:Inter(R)Core (TM)i7-7700K CPU @ 4.20GHz 4.20GHzi7+16G内存;程序代码采用Matlab2016a+OpenCv2.7.1为实验平台进行编写。在校园内设置实验场景,场景中相邻摄像机之间设置40-50%的重叠视野区域,为颜色直方图模板匹配法[11]和多特征信息融合法[12]及本文提出的改进算法的对比提供实验数据源。

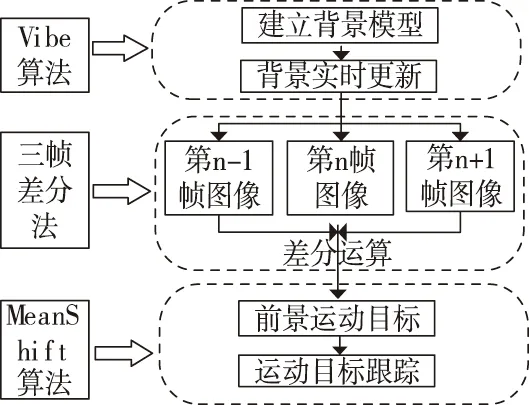

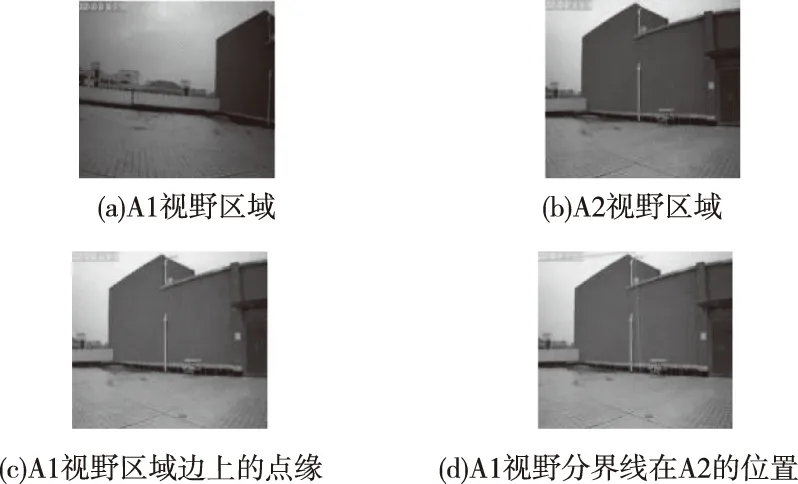

4.1 视野分界线实验

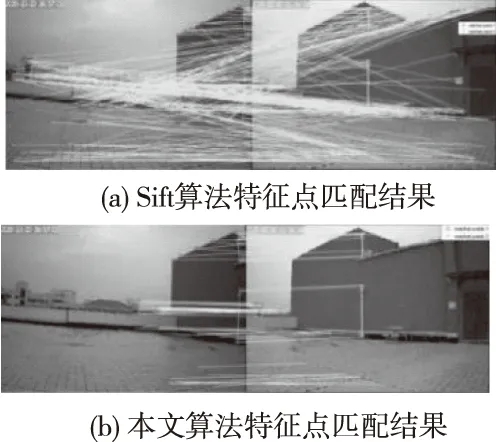

图5为A1视野区域在A2视野区域生成的视野分界线过程,图5(a)是A1视野区域,图5(b)是A2视野区域,图6(a)是利用Sift算法在A1和A2视野重叠视域内产生的特征点匹配结果,图6(b)是利用本文所提出的算法在A1和A2的重叠视域内产生的特征点匹配结果,从所有特征点对数中选取4对特征点,利用特征点求得投影变换矩阵,在图5(c)中选择A1视野右边界上两点,通过投影变换得到A2视野中的对应点,连接两点得到重叠视域的视野分界线,如图5(d)所示。

图5 生成视野分界线

图6 特征点匹配结果图

经过实验对比,Harris-Sift算法与Sift算法的特征点匹配结果相比较,降低了特征点误匹配效率,提高重叠视域范围的特征点的匹配精度,且该算法能够在重叠视域范围内能够找到特征匹配点对数,为视野分界线生成提供了基础。

4.2 目标跟踪实验及对比分析

为了验证重叠视域多摄像头协同的运动目标跟踪方法可行性和实时性,试验从运动目标跟踪效果和运动目标跟踪精度两个方面进行了对比试验。

4.2.1 运动目标跟踪效果对比

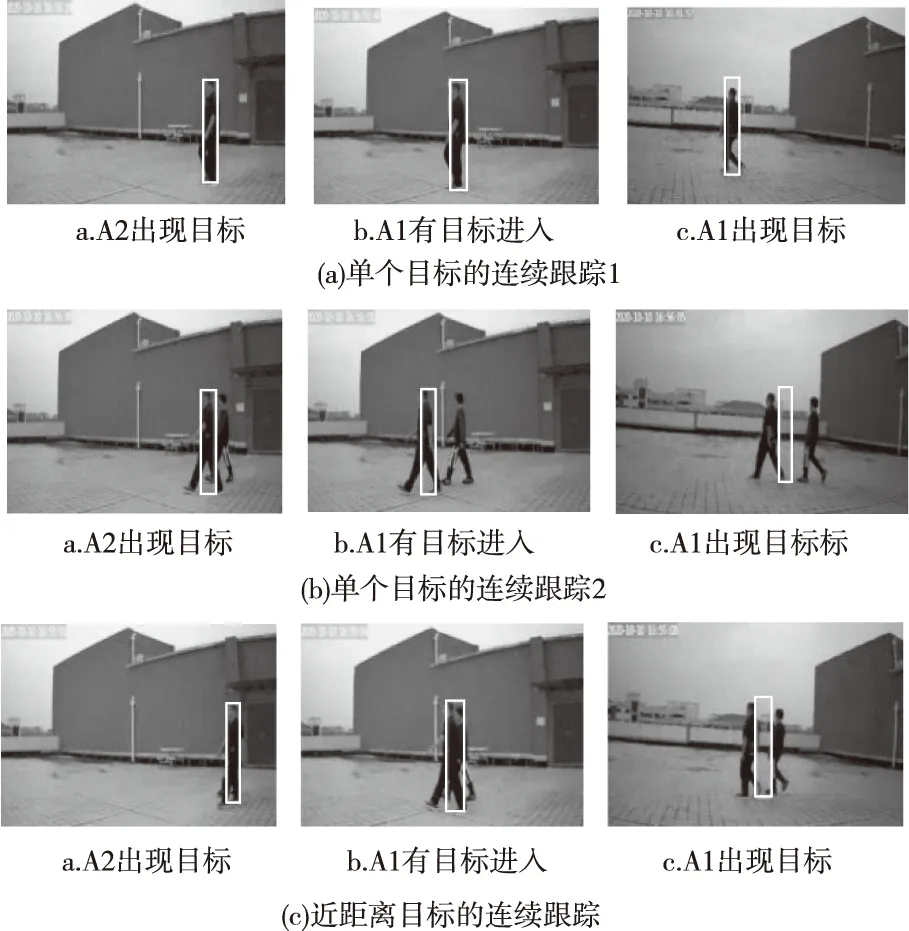

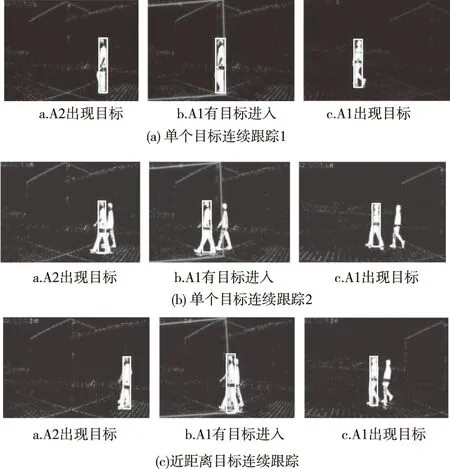

通过设置单目标的连续跟踪、有干扰目标时的连续跟踪和与干扰目标近距离跟踪三种常见实验场景,将颜色直方图模板匹配法、视野分界线与Sift算法融合和重叠视域目标跟踪算法进行实验对比分析,分别获取实验过程中的相关帧图像跟踪结果进行对比分析,实验结果如下图7、图8、图9所示。

图7 颜色直方图法目标跟踪结果图

图8 视野分界线与Sift算法融合的目标跟踪结果图

图9 重叠视域多视角跟踪算法对运动目标连续跟踪

图7中的a、b、c分别为单个目标的连续跟踪、有相近目标进行干扰时的连续跟踪和干扰目标靠近跟踪目标时的连续跟踪实验过程。从上述实验结果图中可以看出,当出现背景颜色进行干扰或匹配模板与运动目标出现偏差,跟踪效果较差,均会导致跟踪目标丢失。

图8中的a、b和c分别为单个目标连续跟踪、干扰目标与跟踪目标的连续跟踪和干扰与跟踪目标靠近的连续跟踪实验。跟踪结果可以看出,虽然视野分界线与Sift算法相融合的方法能够提高目标交接效率,当存在多个干扰目标时目标跟踪失败,因此导致运动目标跟踪丢失。

图9中的a、b和c为分别为单个目标连续跟踪、干扰目标与跟踪目标的连续跟踪和干扰与跟踪目标靠近的连续跟踪实验。从上述实验结果中可以得出,重叠视域多视角跟踪算法在三种不同的场景下对运动目标进行跟踪均能成功地实现目标交接,完成目标的连续跟踪。

4.2.2 运动目标跟踪精度对比

为了进一步验证本文算法的跟踪精度,与文献[13]算法进行对比,在原有的实验数据基础上进行了连续跟踪,跟踪过程中运动目标的起点和终点一致,跟踪视频帧数设为150帧,跟踪结果精度分析如表1所示。

表1 算法对比跟踪效果

本文与文献[13]算法相比在特征点匹配方面提高了特征点的匹配精度,降低了特征点误匹配效率;在运动目标检测与跟踪方面消除了Vibe算法在运动目标检测过程中产生的鬼影,解决了运动目标跟踪丢失的问题。通过数据对比(如表1所示),本文算法对运动目标跟踪准确率分别为76%、87%、88%,文献[13]算法对运动目标进行跟踪准确率为63.4%、74.7%、72%,实验结果分析表明,本文运动目标跟踪算法准确率高于文献[13]改进算法准确率。

5 结论

本文将Harris算法和Sift算法相融合提出了Harris-Sift特征点匹配算法,提高了重叠视域特征点匹配精度,通过构建重叠视域范围内视野分界线和目标可见性判别,提高了对运动目标交接。经过实验验证,本文构建的重叠视域多视角协同的运动目标交接跟踪方法既提高了运动目标跟踪精度,又提高了跟踪效率,解决了重叠视域范围运动目标交接与跟踪失败[14-16]的问题,为多视角重叠区域内的运动目标跟踪提供了一种实现方法。