基于分类分块的全色多光谱图像比值变换融合方法

魏晴 刘晋铭 徐其志

基于分类分块的全色多光谱图像比值变换融合方法

魏晴1刘晋铭*2徐其志1

(1 北京化工大学,北京 100029)(2 军事科学院国防工程研究院,北京 100036)

低分辨率全色图像合成是全色与多光谱图像融合的关键环节,决定了融合图像的光谱色彩和空间细节品质。由于光学卫星成像传感器的非线性光谱响应以及不同地物的光谱响应差异,导致直接利用多光谱图像各波段合成的低分辨率全色图像存在灰度失真,以致融合图像产生光谱色彩失真和空间细节失真。文章首先利用一种迭代求解的聚类分析算法k均值聚类算法(k-means算法)对全色和多光谱图像所有像素进行分类;然后根据各类像素的方差将其划分为不同大小的子块,利用带约束最小二乘法计算多光谱图像每个子块中各个像素的加权值;最后利用加权值合成低分辨率全色图像,并通过比值变换方法生成高保真融合图像。文章利用QuickBird和WorldView3卫星的全色与多光谱图像进行实验验证,与PNN、PanNet、FusionCNN等方法相比,该方法有效提高了融合图像的光谱色彩和融合细节的保真度。

图像融合 比值变换 像素分类 带约束最小二乘法 遥感图像

0 引言

现有光学遥感卫星往往采用全色与多光谱同时成像方式对地观测,然而实际遥感应用需要光谱信息丰富且空间分辨率高的图像,但由于影像信噪比与数据存储和传输的限制,卫星所获取的遥感影像的空间分辨率与光谱分辨率相互制约,无法直接获取高分辨多光谱图像[1]。而图像融合可提高图像的清晰度,且包含更多细节信息,与人和计算机的视觉相符合,有利于后续的图像处理(分类、检测、识别等),因此图像融合必不可少。在图像融合中,尤其是用比值变换方法时,融合图像与多光谱图像的比值等于全色图像与多光谱图像拟合的低分辨率全色图像的比值,故拟合的低分辨率全色图像的品质直接影响最终融合图像的品质,因此低分辨率全色图像的合成至关重要。但由于光学卫星成像传感器的非线性光谱响应[2]以及不同地物的光谱响应差异,通过多光谱图像各波段合成的低分辨率全色图像容易出现灰度失真,而多光谱图像与全色图像的空间分辨率相差较大,若采用现有的加性变换融合方法,容易导致融合图像产生光谱色彩失真或空间细节失真。针对全色和多光谱图像的融合,前人已经提出了许多有效的方法[3],如:分量替换法[4-5],比值变换法[6],多分辨率分析法[7],基于概率论、模糊理论的遥感图像融合方法和基于深度学习[8-11]的遥感图像融合方法等。其中比值变换法算法简单,易于实现,运算速度快,且有较好的融合效果,被广泛应用于遥感影像融合。利用比值变换的方法实现图像融合,融合图像等于全色图像与拟合的低分辨率全色图像的比值乘以多光谱图像,因此拟合的低分辨率全色图像可以直接影响最终的融合结果。而由于传感器非线性光谱响应与不同地 物间光谱响应的差异,拟合的低分辨率全色图像容易出现灰度失真现象,最终导致融合图像出现光谱与细节失真。

针对传感器非线性光谱响应导致融合图像光谱和细节失真的问题,文献[12]根据传感器的光谱响应特性在快速IHS方法的基础上,对强度分量进行重构并对空间细节注入的方式进行了改进,其中IHS方法是将原始多光谱图像从红、绿、蓝三波段空间(RGB)变换到亮度、色调、饱和度空间(IHS),然后用高分辨率图像或用不同投影方式得到的待融合图像替代亮度分量;文献[13]基于分量替换的融合方法,利用多光谱波段与全色波段的多元线性回归进行了改进,使得融合图像具有更高的光谱品质,但在融合图像的细节方面仍有些不足;文献[14-16]利用全色与多光谱图像构造线性回归方程,并利用回归系数构造低分辨率全色图像,有效改善了融合图像光谱与细节失真的问题,但由于未考虑不同地物光谱响应差异的问题,故融合图像品质仍有待提高;文献[17]针对不同地物光谱响应差异导致的融合图像光谱或细节失真的问题,提出先对多光谱图像像素进行聚类,再利用多元回归为每类像素计算出多光谱各波段与全色波段间的权值,更好地拟合出低分辨率全色图像,大幅减少了融合图像光谱与细节失真的问题。本文为了更精准地拟合低分辨率全色图像得到高保真的融合图像,提出了一种基于分类分块的全色多光谱图像比值变换融合方法。该方法首先利用k-means算法[18]对全色和多光谱图像所有像素进行分类;然后根据各类像素的方差将其划分为不同大小的子块,利用带约束最小二乘法计算多光谱图像每个子块 中各个像素的加权值;最后利用加权值合成低分辨率全色图像,并通过比值变换方法生成高保真融合图像。

本文利用QuickBird和WorldView3卫星全色与多光谱图像进行实验验证,并与GS[19]、Zhang的方法(利用全色与多光谱各波段多元线性回归拟合低分辨率全色图像并通过比值变换得到融合图像的方法)、PNN[20]、PaanNet[21]、FusionCnn[22]方法进行比较,实验表明,本文方法有效提高了融合图像的光谱色彩和融合细节的保真度。

1 融合方法

本文提出的融合方法主要是基于比值变换方法实现的,比值运算就是求2张或多张影像组合的对应像元灰度值的比值计算,是遥感影像处理过程中常用的方法。目前,比值变换的融合方法主要是Brovey算法[23],该算法简单,计算速度较快,易于实现。

1.1 比值变换方法

比值变换方法是通过计算全色图像与合成的低分辨率全色图像的比值得到待注入的细节,再将求得的比值与多光谱上采样图像相乘,即向多光谱上采样图像注入细节,最终得到既具有光谱信息又具有空间细节的融合图像,原理公式如式(1)。基于比值变换的Brovey算法,表达式见式(2)。

1.2 本文融合方法

图1 子块划分示意

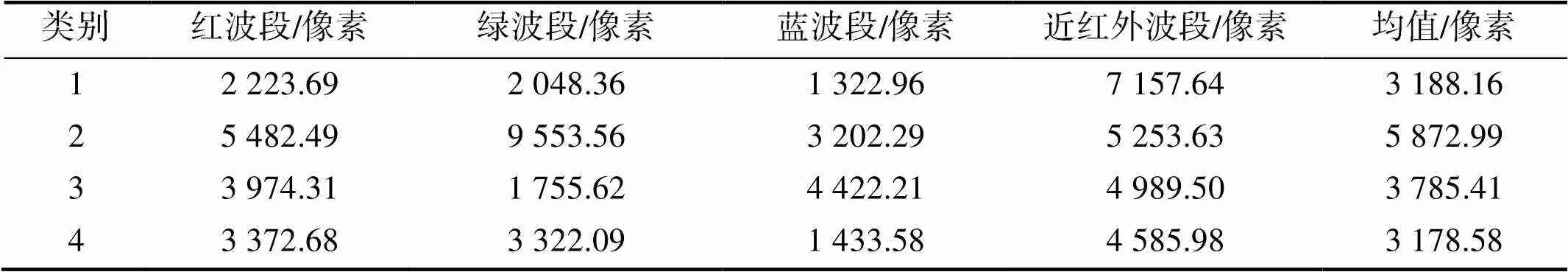

表1 不同波段下各类像素方差

Tab.1 The variance of various pixels in different bands

这种为不同类别的像素设定不同大小子块并进行局部拟合的方法,可以在像素所属不同类别的情况下,在适当的不同大小的子块中进行权值的计算,可解决由于不同地物光谱响应差异导致拟合的低分辨率全色图像灰度失真的问题,有效减少了融合图像色彩失真的问题。

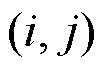

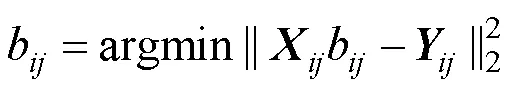

本文的融合方法如图2,首先将多光谱图像上采样至与全色图像相同空间分辨率,得到多光谱上采样图像;然后针对传感器的非线性响应以及不同地物光谱响应差异的问题,利用k-means算法对全色和多光谱图像所有像素进行分类,得到分类图像;接下来利用分块匹配计算各个像素加权值,即先根据各类像素的方差将其划分为不同大小的子块,再利用带约束的最小二乘法计算多光谱图像每个子块中各个像素的加权值。具体步骤如下:

argmin代表取最小值。最后利用加权值合成低分辨率全色图像,并通过比值变换方法生成高保真融合图像。

图2 本文方法方框图

直接使用最小二乘法计算所得的权值会出现负数,并不符合实际情况,对此文献[24]提出对最小二乘法增加非负的约束。为了让权值具有更明确的物理意义,本文对最小二乘法增加了约束条件。

2 实验数据与评价指标

2.1 实验数据

实验数据采用目前世界上最先提供亚米级分辨率的商业卫星QuickBird卫星的影像与DigitalGlobe商用高分辨率遥感卫星WorldView3卫星影像。实验影像包含丰富的地物,如:植被、建筑物、道路、裸地等,可作为检验融合方法效果的代表性样本。实验中所用的QuickBird影像全色图像分辨率为0.61m,多光谱图像分辨率为2.44m,全色图像大小为10 616像素×13 276像素,多光谱图像大小为2 654像素×3 319像素,拍摄地区为北京,拍摄时间为2008年4月25日。WorldView3实验影像全色图像分辨率为0.31m,多光谱图像分辨率为1.24m,全色图像大小为8 080像素×7 482像素,多光谱图像大小为2 020像素×1 870像素,拍摄地区为的黎波里,拍摄时间为2016年9月26日。

2.2 评价指标

为了客观地评价不同方法的融合效果,本文选取了4种常用的评价指标对融合图像的品质进行评估,分别是光谱角(SAM)、相对量纲为一的全局误差(ERGAS)、峰值信噪比(PSNR)和结构相似性(SSIM)[25]。SAM通过计算参考图像和融合图像间的角度来评估色彩的保真度,角度越小代表色彩保真度越好;ERGAS取值越小,融合图像品质越高;PSNR用于衡量图像有效信息与噪声之间的比率,评估图像是否失真,其取值越大,融合品质越高;相对于上述常用的图像品质评估指标,SSIM是可衡量两幅图像相似度的指标,更符合人眼对图像品质的判断。SSIM值越接近1则代表两张图像更为相近。

光谱角计算公式[26]为

ERGAS计算公式为

PSNR计算公式为

SSIM计算公式[25]为

3 实验结果与分析

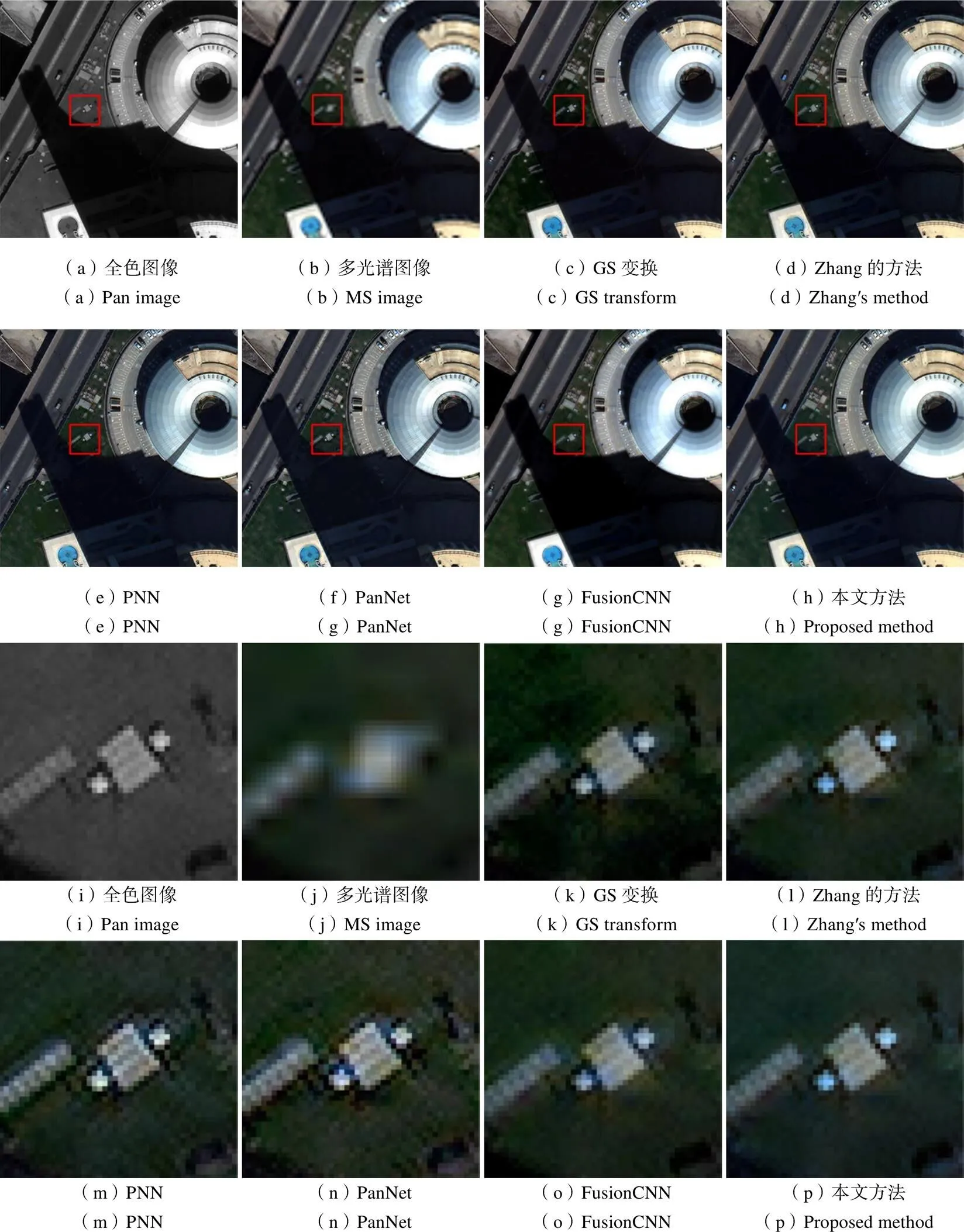

为验证提出的融合方法的有效性,本文选用了GS算法、Zhang的算法、PNN、PanNet以及FusionCNN进行对比实验。由于实验图像较大,本文仅展示包含植被、道路、房屋、水体等地物的局部区域融合效果。第一组实验图像为QuickBird影像,如图3(a)、(b)所示,分别为512像素×512像素的全色图像和128像素×128像素的多光谱图像;第二组实验图像为WorldView3影像,如图4(a)、(b)所示,分别为400像素×400像素的全色图像和100像素×100像素的多光谱图像。

如图3所示,对于QuickBird实验数据,利用GS、Zhang的方法、PNN、PanNet、FusionCNN和本文的融合方法得到的融合图像相对于原多光谱图像,分辨率均有一定程度的提高。图3(c)为GS方法得到的融合图像,空间细节较为清晰,但与原多光谱图像各波段值相差较大,光谱保真不够好,尤其是植被处失真较为严重;图3(d)为Zhang提出的方法得到的融合图像,存在局部光谱失真问题,这是由于该方法每个像素点共用同一组权值,导致拟合的全色图像出现灰度失真;使用PNN法得到的融合图像如图3(e)所示,色彩与原多光谱图像相差较大;通过PanNet和FusionCNN得到的融合图像分别如图3(f)和(g)所示,在建筑物、植被等处较为模糊,存在细节失真;图3(h)为使用本文方法得到的融合图像,整体光谱与细节保真度都较高。图3(i)~(p)为局部细节放大图,可观察到本文提出的方法在建筑物处色彩与原多光谱图像更为相近,且空间细节清晰,即本文方法在空间细节与光谱的保真方面均有一定优势。为验证本文方法在其他数据集上也能得到高保真的融合图像,同理,对WorldView3实验影像进行了同样的处理,其融合结果及局部细节如图4所示。可发现本文提出的方法光谱保真最优且更好地保留了全色图像的空间细节。

图3 QuickBird实验图像融合结果及局部细节

图4 WorldView3实验图像融合结果及局部细节

表2和表3分别为QuickBird和WorldView3实验影像融合图像的评价指标结果。通过对比各指标的评价结果发现本文提出的方法在四种融合品质评估指标下均获得了最佳值,即本融合方法在光谱保真与细节保真方面优于其他对比方法。

表2 QuickBird影像融合图像品质评估结果

Tab.2 The quality assessment results of QuickBird fused images

表3 WorldView-3影像融合图像品质评估结果

Tab.3 The quality assessment results of WorldView-3 fused images

4 结束语

在利用比值变换法进行全色和多光谱图像融合时,融合图像等于全色图像与拟合的低分辨率全色图像的比值乘上采样的多光谱图像,因此低分辨率全色图像的合成决定了融合图像的品质。当前融合方法多存在着融合图像光谱色彩失真或空间细节失真的问题,这是由于当前算法欠缺对传感器非线性响应带来的问题的处理,以及不同地物光谱响应差异导致拟合低分辨率全色图像存在灰度失真问题。针对上述问题,本文提出了一种基于分类分块的全色多光谱比值变换图像融合方法。该方法与先前方法的不同之处在于,利用了局部拟合的思想,用带约束最小二乘法为每一个像素点计算出一组权值,使得拟合的低分辨率全色图像更精准且更具物理意义,最终得到高保真的融合图像。通过QuickBird和WorldView3卫星全色与多光谱图像进行实验,与当前最新方法相比,本文提出的方法有效改善了融合图像色彩与细节失真的问题,可以得到高保真的融合图像。本方法中,大量的像素点的计算导致算法速度较慢,后续还需改进。

[1] 张良培, 沈焕锋. 遥感数据融合的进展与前瞻[J]. 遥感学报, 2016, 20(5): 1050-1061.

ZHANG Liangpei, SHEN Huanfeng. Progress and Future of Remote Sensing Data Fusion[J]. Journal of Remote Sensing, 2016, 20(5): 1050-1061. (in Chinese)

[2] THOMAS C, RANCHIN T, WALD L, et al. Synthesis of Multispectral Images to High Spatial Resolution: A Critical Review of Fusion Methods Based on Remote Sensing Physics[J]. IEEE Transactions on Geoscience and Remote Sensing, 2008, 46(5): 1301-1312.

[3] 张立福, 彭明媛, 孙雪剑, 等. 遥感数据融合研究进展与文献定量分析(1992-2018)[J]. 遥感学报, 2019, 23(4): 603-619.

ZHANG Lifu, PENG Mingyuan, SUN Xuejian, et al. Progress and Bibliometric Analysis of Remote Sensing Data Fusion Methods (1992-2018)[J]. Journal of Remote Sensing, 2019, 23(4): 603-619. (in Chinese)

[4] 王文卿, 刘涵, 谢国, 等. 改进空间细节提取策略的分量替换遥感图像融合方法[J]. 计算机应用, 2019, 39(12): 3650-3658.

WANG Wenqing, LIU Han, XIE Guo, et al. Component Substitution-based Fusion Method for Remote Sensing Images via Improving Spatial Detail Extraction Scheme[J]. Journal of Computer Applications, 2019, 39(12): 3650-3658. (in Chinese)

[5] 潘瑜, 徐丽燕, 王静, 等. 基于多重集典型相关分析的图像融合方法[J]. 航天返回与遥感, 2011, 32(3): 69-76.

PAN Yu, XU Liyan, WANG Jing, et al. An Image Fusion Method Based on Multi-set Canonical Correlation Analysis[J]. Spacecraft Recovery & Remote Sensing, 2011, 32(3): 69-76. (in Chinese)

[6] LI X, XU Q, GAO F, et al. Pansharpening Based on an Improved Ratio Enhancement[C]//2015 IEEE International Geoscience & Remote Sensing Symposium, July 26-30, 2015, Milan, Italy. IEEE, 2015.

[7] LI H, JING L. Improvement of MRA-based Pansharpening Methods through the Considerasion of Mixed Pixels[C]//IGARSS 20182018 IEEE International Geoscience and Remote Sensing Symposium, July 22-27, 2018 Valencia, Spain. IEEE, 2018.

[8] WEI Y, YUAN Q, SHEN H, et al. Boosting the Accuracy of Multispectral Image Pansharpening by Learning a Deep Residual Network[J]. IEEE Geoscience & Remote Sensing Letters, 2017, 14(10): 1795-1799.

[9] LIU X, WANG Y, LIU Q. PSGAN: A Generative Adversarial Network for Remote Sensing Image Pan-sharpening[J]. IEEE International Conference on Image Processing, 2020(99): 1-16.

[10] HE L, RAO Y, LI J, et al. Pansharpening via Detail Injection Based Convolutional Neural Networks[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2019(4): 1-17.

[11] YANG Y, TU W, HUANG S, et al. PCDRN: Progressive Cascade Deep Residual Network for Pansharpening[J]. Remote Sensing, 2020, 12(4): 676.

[12] 徐佳, 关泽群, 何秀凤, 等. 基于传感器光谱特性的全色与多光谱图像融合[J]. 遥感学报, 2009, 13(1): 97-102.

XU Jia, GUAN Zequn, HE Xiufeng, et al. Novel Method for Merging Panchromatic and Multi-spectral Images Based on Sensor Spectral Response[J]. Journal of Remote Sensing, 2009, 13(1): 97-102. (in Chinese)

[13] AIAZZI B, BARONTI S, SELVA M. Improving Component Substitution Pansharpening through Multivariate Regression of MS +Pan Data[J]. IEEE Transactions on Geoence & Remote Sensing, 2007, 45(10): 3230-3239.

[14] ZHANG Y. System and Method for Image Fusion: U.S. 7340099[P]. 2008.

[15] 王忠武, 赵忠明, 刘顺喜. IKONOS图像的线性回归波段拟合融合方法[J]. 遥感学报, 2010, 14(1): 43-54.

WANG Zhongwu, ZHAO Zhongming, LIU Shunxi. Band Simulation Based Pan-sharpening Algorithm by Linear Regression for IKONS Imagery[J]. Journal of Remote Sensing, 2010, 14(1): 43-54. (in Chinese)

[16] DAI, Q. Context Adaptive Panchromatic Band Simulation and Detail Injection for Image Pansharpening[J]. Journal of Applied Remote Sens, 2018, 12(1): 1.

[17] XU Q, ZHANG Y, LI B, et al. Pansharpening Using Regression of Classified MS and Pan Images to Reduce Color Distortion[J]. IEEE Geoscience & Remote Sensing Letters, 2015, 12(1): 28-32.

[18] WONG J. Algorithm AS 136: A K-means Clustering Algorithm[J]. Journal of the Royal Statistical Society, 1979, 28(1): 100-108.

[19] LABEN C A, BROWER B V. Process for Enhancing the Spatial Resolution of Multispectral Imagery Using Pan-sharpening: U.S. 6011875[P]. 2000.

[20] GIUSEPPE M, DAVIDE C, LUISA V, et al. Pansharpening by Convolutional Neural Networks[EB/OL].[2021-05-30]. https://www.researchgate.net/publication/305338139_Pansharpening_by_Convolutional_Neural_Networks.

[21] YANG J, FU X, HU Y, et al. PanNet: A Deep Network Architecture for Pan-sharpening[C]//2017 IEEE International Conference on Computer Vision (ICCV), October 22-29, 2017, Venice, Italy. IEEE, 2017.

[22] YE F, LI X, ZHANG X. FusionCNN: A Remote Sensing Image Fusion Algorithm Based on Deep Convolutional Neural Networks[J]. Multimedia Tools and Applications, 2018, 78(11): 14683-14703.

[23] TU T, LEE Y, CHANG C, et al. Adjustable Intensity-hue-saturation and Brovey Transform Fusion Technique for IKONOS/QuickBird Imagery[J]. Optical Engineering, 2005, 44(11): 116201-1-116201-10.

[24] 郝红勋, 何红艳, 张炳先. 基于非负最小二乘法的全色与高光谱图像融合[J]. 航天返回与遥感, 2019, 40(4): 105-111.

HAO Hongxun, HE Hongyan, ZHANG Bingxian. Panchromatic and Hyperspectral Images Fusion Based on Non-negative Least Squares Algorithm[J]. Spacecraft Recovery & Remote Sensing, 2019, 40(4): 105-111. (in Chinese)

[25] WANG Z. Image Quality Assessment: From Error Visibility to Structural Similarity[J]. IEEE Transactions on Image Processing, 2004, 13(4): 600-612.

[26] 刘万军, 杨秀红, 曲海成, 等. 基于光谱信息散度与光谱角匹配的高光谱解混算法[J]. 计算机应用, 2015, 35(3): 844-848.

LIU Wanjun, YANG Xiuhong, QU Haicheng. Hyperspectral Unmixing Algorithm Based on Spectral Information Divergence and Spectral Angle Mapping[J]. Journal of Computer Applications, 2015, 35(3): 844-848. (in Chinese)

Panchromatic and Multispectral Image Fusion by Ratio Enhancement Based on Classification and Block

WEI Qing1LIU Jinming*2XU Qizhi1

(1 Beijing University of Chemical Technology, Beijing 100029, China)(2 National Defense Engineering Research Institute of Academy of Military Science, Beijing 100036, China)

The synthesis of low-resolution panchromatic image is a key step in panchromatic and multispectral image fusion, it determines the spectral and spatial quality of the fused imagery. Due to the nonlinear spectral response of optical satellite sensor and the differences in spectral response of different ground objects, the low-resolution panchromatic image synthesized by each band of the multispectral image has gray-scale distortion which causes the spectral and spatial distortion of fused imagery. The proposed method firstly usedan iterative solution clustering analysis algorithm, namely k-means algorithm to classify all pixels of panchromatic and multispectral images; then divide them into sub-blocks with different sizes according to the variance of each class of pixels, after that, each pixel′s weights in each sub-block of the multispectral image are calculated by constrained least square method; finally, the weights are used to synthesize the low-resolution panchromatic image, and the high-Fidelity fused imagery is generated by ratio enhancement. This paper uses the panchromatic and multispectral images of QuickBird and WorldView3 satellite for experimental verification. Compared with PNN, PanNet and FusionCNN, the proposed method effectively improves the fidelity of the fused imagery's spectral color and fusion detail.

image fusion; ratio enhancement; pixel classification; constrained least square; remote sensing image

V445

A

1009-8518(2021)05-0108-10

10.3969/j.issn.1009-8518.2021.05.012

魏晴,女,1997年生,现为北京化工大学计算机科学与技术专业在读硕士研究生,主要研究方向为遥感图像融合处理。E-mail:weiqing@mail.buct.edu.cn。

刘晋铭,男,1991年生,2019年获中国人民解放军陆军勤务学院计算机应用技术专业博士学位。主要研究方向为国防工程的测量与规划技术。E-mail:xqzlab@buaa.edu.cn。

2020-12-28

国家基金面上项目(61972021,61672076)

魏晴, 刘晋铭, 徐其志. 基于分类分块的全色多光谱图像比值变换融合方法[J]. 航天返回与遥感, 2021, 42(5): 108-117.

WEI Qing, LIU Jinming, XU Qizhi. Panchromatic and Multispectral Image Fusion by Ratio Enhancement Based on Classification and Block[J]. Spacecraft Recovery & Remote Sensing, 2021, 42(5): 108-117. (in Chinese)

(编辑:庞冰)