基于距离交并比回归的孪生网络目标跟踪算法

黄智慧, 赵慧民, 詹 瑾*, 利华康, 郑鹏根, 2, 郑伟俊, 李伟键, 黄科乔

(1.广东技术师范大学计算机科学学院, 广州 510630; 2.中山大学电子与通信工程学院, 广州 510275)

目标跟踪是视频分析和理解视频语义的前提和基础, 是计算机视觉研究的一个重要分支,在人机交互、智能视频监控、自动驾驶、医学诊断等领域应用非常广泛.但视频场景存在遮挡、光线变化、快速运动和尺度变化等复杂的非线性变化,给视频目标跟踪研究带来巨大挑战.大数据时代的到来及深度学习方法的出现, 为目标跟踪的进一步研究提供了新的契机[1].为优化跟踪算法的准确度和稳定性,研究者不断完善基于深度网络的目标跟踪算法[2-3].Wang等[4]提出了一种DLT方法,首次采用离线预训练与在线微调相结合的思路,对大规模自然图像数据集进行训练,获得深度目标跟踪模型参数; Nam等[5]基于CNN网络提出了MDNet多领域学习框架,通过共享层和特定域多分支层组成网络模型,同时采用硬负样本挖掘法获得有效负样本,提高分类器的判别能力; Tao等[6]将孪生网络(Siamese network)引入到跟踪算法,通过训练通用匹配函数获得跟踪模型,取得良好的实验效果,由此引起了广泛关注; Bertinetto等[7]提出了SiamFC跟踪方法, 使用模板帧在搜索图像上作全卷积匹配,取得了较好的跟踪实时性和准确性,但对相似物体干扰的识别能力较差,容易产生目标定位误差.为了提高定位回归精度, Li等[8]提出了SiamRPN方法, 将Siamese网络与区域建议网络[9](region proposal network, RPN)结合,完成特征提取并快速生成候选目标,通过分类分支和定位回归分支确定最佳跟踪目标位置,取得了较好的跟踪目标位置的准确性.

在基于Siamese网络的深度跟踪算法中, 损失函数对于设计鲁棒且精确的跟踪器十分重要,可衡量训练模型的性能好坏.近年来,损失度量的优化得到越来越多的关注, 研究者相继提出一系列损失模型.Song等[10]针对正负样本分布不平衡问题提出VITAL算法, 采用高阶代价敏感损失函数降低了易负样本的影响, 提高了跟踪模型的鲁棒性; Yu等[11]引入交并比(intersection over union, IOU)损失函数, 考虑目标框和预测框的重叠面积, 将边框四个点作为整体进行回归,提高了回归收敛速度, 但无法应对边界框不相交时模型训练失败问题; Rezatofighi等[12]提出了广义交并比(generation intersection over union, GIOU)损失函数, 在IOU基础上增加了目标框和预测框的外接矩形, 具有尺度不变性, 提高了回归精度, 但当目标框完全包裹预测框时, GIOU退化为IOU; Zheng等[13]提出了距离交并比(distance intersection over union, DIOU)损失函数, 考虑了回归损失的重叠面积与中心点归一化距离, 训练过程模型收敛速度快且不易发散,更好地优化回归问题.

1 基于DIOU回归的孪生网络目标跟踪算法

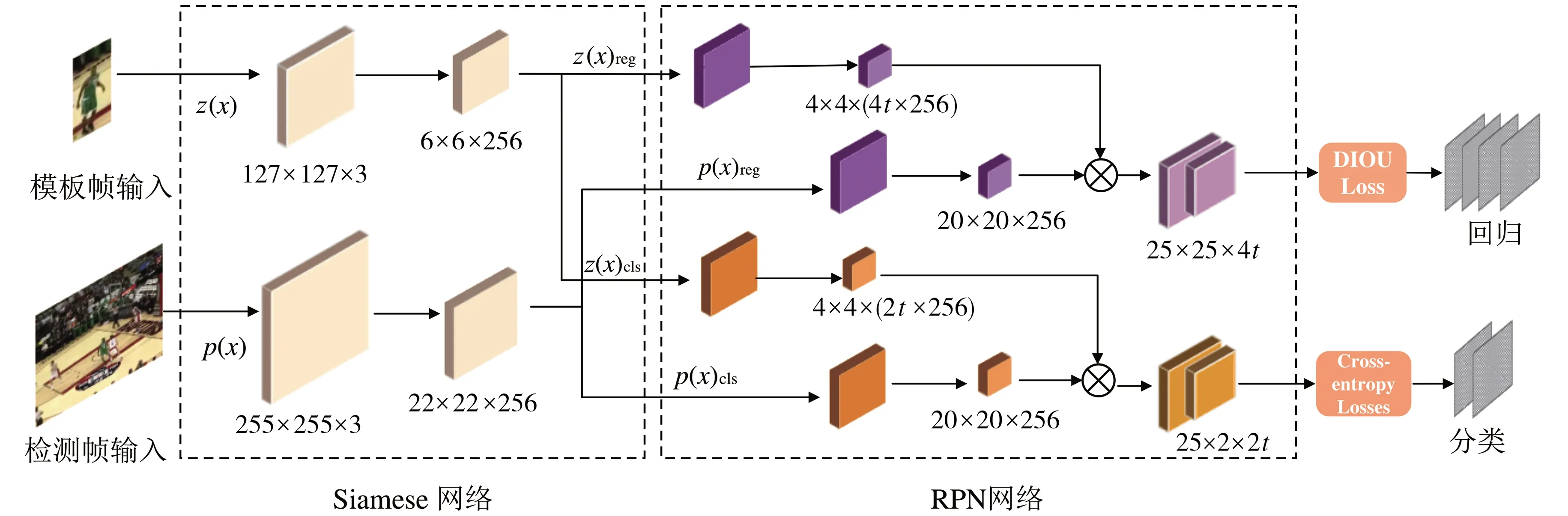

本文以SiamRPN网络框架为基础, 主要分为2个模块: 一个是Siamese网络, 完成输入模板帧与检测帧的特征提取,其骨干网络采用Resnet50网络,搭建训练框架; 另一个是区域建议网络, 根据特征向量获得预测目标候选区域,减少区域提取的时间开销.RPN网络包含分类分支与回归分支,其中分类分支用于识别正负样本,回归分支则负责预测候选目标坐标偏移量.具体网络框架如图1所示.

图1 网络框架图Fig.1 Method network framework

损失函数是模型优化最关键一步, 反映预测模型与实际数据之间的差异, 从而衡量训练模型性能.本文利用交叉熵损失函数完成分类任务,回归定位采用DIOU度量对预测框和真实框的中心点距离进行回归计算,输出精确位置信息.

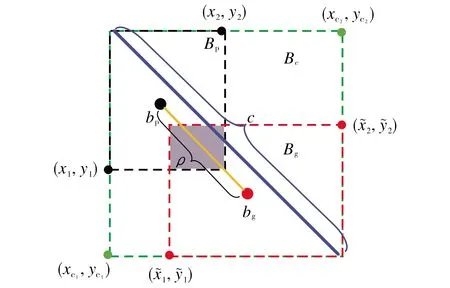

图2 真实框与预测框示意图Fig.2 Schematic diagram of target box and predicted box

基于DIOU[13]的距离度量损失函数具有尺度不变性, 既考虑了任意预测框和真实目标框的最小封闭框, 又优化了两者中心点归一化距离,使目标框包裹预测框时收敛速度更快.LDIOU的范围为0≤LDIOU<2, 当Bg和Bp完全重叠时,LDIOU=0, 此时预测框与真实框一致; 当两个边界框距离较远时,ρ2/c2趋向于1, 表明LDIOU逐渐收敛到最大值2.

2 实验结果与分析

2.1 实验参数

本文采用ILSVRC-VID数据集训练算法模型, 对OTB2015数据集进行测试.训练过程中, 学习率初设为5×10-3, anchor个数为5, 由于跟踪过程目标形变差异不明显, anchor尺度恒定不变, anchor ratios设置为(0.33, 0.5, 1, 2, 3), 共执行20次阶段训练.实验环境为单个GPU, 内存为8 GB, 显卡为Nvidia GTX 1080Ti, 整个训练过程大约40 h.

训练数据包含光照变化、尺度大小和低分辨率等不同场景的视频序列,以及跟踪目标的边框位置信息.对每个视频序列进行训练, 首先, 将第一帧作为模板与后序检测帧构成多组样本对; 其次, 分别输入模板分支和搜索分支进行相关处理,模板分支利用卷积操作调整输入图像块大小为127×127,搜索分支的图像块统一尺度为255×255; 最后, 根据DIOU loss损失度量计算结果分类,当检测样本DIOU大于0.6时判定为正样本, DIOU不超过0.3时为负样本.

2.2 结果分析

表1 采用4种损失函数进行跟踪的平均中心误差

图3 采用4种损失函数进行跟踪的平均精度和平均成功率曲线Fig.3 Average accuracy and success rate of tracking using four loss functions

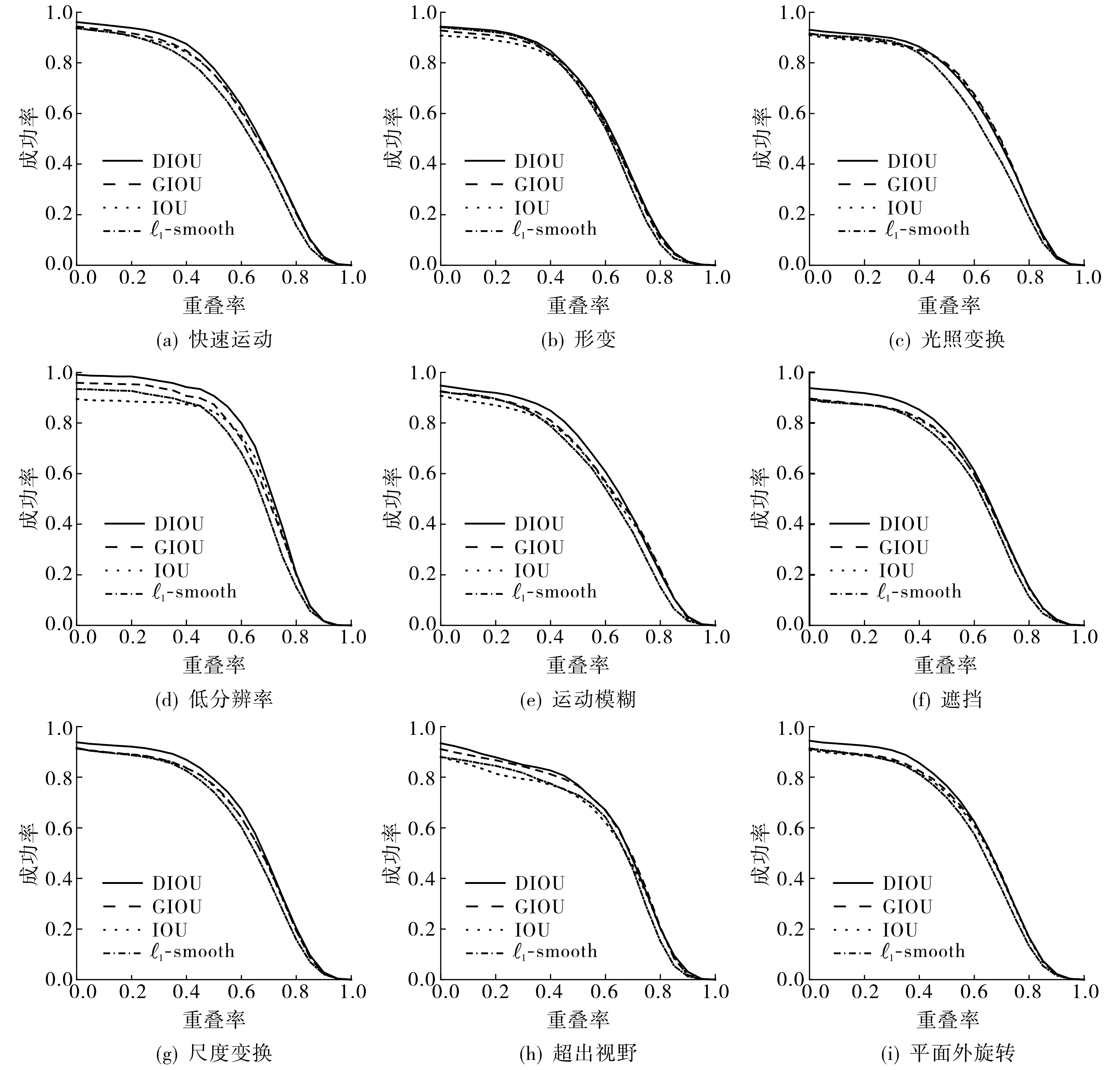

图4 不同视频场景下采用4种损失函数进行跟踪的成功率曲线图Fig.4 Success rate curve of tracking with four loss functions under different video scenes

边框颜色: 红色表示DIOU算法, 黄色表示1-smooth算法, 绿色表示GIOU算法, 蓝色表示IOU算法. 图5 采用4种损失函数进行跟踪的效果对比图Fig.5 The effect contrast diagram of tracking with four loss functions

3 结论

本文基于孪生网络和RPN网络框架,提出了一种基于距离交并比回归的孪生网络目标跟踪算法, 将距离交并比度量方法引入孪生网络的回归分支中,把目标框和预测框的重叠面积与中心点距离作为整体进行回归,为边界框提供更加直接的回归方向,加快了模型收敛速度,解决了目标检测框与真实框非重叠情况下不能优化的问题,提高了跟踪器在多种视频场景下的鲁棒性.实验结果表明,采用DIOU作为回归损失的SiamRPN跟踪方法在目标尺度变化、低分辨率、光照变化及快速运动等干扰下能够较好地完成目标跟踪任务,实现实时跟踪.