基于视觉机器人的自动抓取机械手控制研究

刘莹 祝学云 徐佳文

DOI:10.19850/j.cnki.2096-4706.2021.08.044

摘 要:为适应工程教育和课程教学改革的需要,依托视觉机器人平台对自动抓取机械手控制进行了研究。系统硬件主要包括实验平台、相机、光源和机械臂等组件。在图像处理与目标识别中,颜色的分类识别采用的是基于混合高斯模型(GMM)的分类器,形状的识别采用的是MPL多神经网络分类器。最后介绍了机械手的运动建模和抓取流程并进行了实验,实验效果良好。

关键词:视觉机器人;机械手;实验教学改革

中图分类号:TP241.2 文献标识码:A 文章编号:2096-4706(2021)08-0156-04

Research on Automatic Grabing Manipulator Control Based on Vision Robot

LIU Ying,ZHU Xueyun,XU Jiawen

(School of Instrument Science and Engineering,Southeast University,Nanjing 210096,China)

Abstract:In order to meet the needs of engineering education and curriculum teaching reform,the control of automatic grabing manipulator is studied based on the vision robot platform. The system hardware mainly includes the experimental platform,camera,light source,mechanical arm and other components. In image processing and target recognition,uses the classifier based on Gaussian mixture model(GMM)for color classification and recognition,uses MPL multi neural network classifier for shape recognition. Finally,the motion modeling and grabing process of the manipulator are introduced and experiment is carried out,and the experimental results are good.

Keywords:vision robot;manipulator;experimental teaching reform

0 引 言

机器人作为测控技术、机械自动化、计算机科学、控制理论、人工智能等多学科交叉的高新技术,在制造业、服务业、医疗保健、国防等各领域得到广泛应用。机器人传感与控制技术是仪器科学与工程学院重要的研究方向,涉及测控技术与仪器专业本科生的多门主干课程:传感器技术、检测技术、智能仪器设计、单片机技术、自动控制原理、机械原理等。

目前我院本科生的实验教学以各门课程的课程配套实验为主,缺乏大型的综合型设计型实验。在视觉机器人的基础上,设计测控一体化的研究型实验,能够让学生充分了解学科知识之间的关联性和融合性,锻炼和提高学生的工程实践能力和创新实践能力,对课程的建设、专业的发展、创新型人才的培养具有重要意义。

视觉机器人就是通过图像摄取装置将被摄取的目标转换成图像信号,传送给图像处理系统,图像处理系统对这些信号进行运算来抽取目标的特征,进而来控制设备动作,所以说视觉机器人是一项综合技术,包括传感器技术、图像处理、機械工程技术、自动控制等,十分适合作为我院高年级本科生的综合实验平台使用。结合本科生教学及学科发展的需要,依托视觉机器人平台设计自动抓取机械手控制实验[1-5]。为了让学生熟悉视觉机器人平台和为自动抓取机械手控制实验做知识储备,设置六个基础实验:视觉算法基础实验、颜色识别实验、形状识别实验、标定实验、二维测量实验、机械手控制实验,然后针对不同颜色不同形状的抓取目标学生自主设计完成自动抓取机械手控制实验。

1 系统硬件介绍

基于视觉机器人的自动抓取系统主要包括实验平台、面阵摄像机、镜头、可调节光源和机械臂等组件。其中实验平台由光源安装、相机安装、输出等模块组成,输出模块可以输出5 V、24 V直流电压,调节底部光源亮度以及开关上方光源。面阵摄像机采用的是紧凑型数字摄像机,通过GigE接口传输图像数据,具有高分辨率、高精度、低噪声等特点。镜头采用的是Computar工业镜头M1214-MP2百万像素12 mm定焦镜头。机械臂采用的是DobotMagician机械臂,该机械臂是一个高精度四轴桌面操作型机械臂,由底座、旋转主体、大臂、小臂、执行末端等部分组成,末端执行器有气动手爪套件、吸盘套件等,最大负载500 g,最大伸展距离320 mm。

在机器视觉系统中,通常分为手眼相机模式和固定相机模式两种,本实验系统采用固定相机模式,摄像机安装在实验平台的支架上。在固定相机模式下,相机不受机械臂抖动影响,视野固定,定位精度高。系统硬件结构如图1所示。

2 机器视觉

2.1 图像处理与目标识别

机器视觉通过采集相机和镜头信息获得目标图像,再利用图像处理系统进行处理分析。这里我们采用Halcon软件进行图像处理和目标识别[6,7]。Halcon是德国MVtec公司开发的图像处理软件,包含完善的综合标准软件库,并且架构灵活。

本实验中需要识别目标的颜色和形状。Halcon中常见的有四类分类器:MLP(多层神经网络neural Nets)、SVM(支持向量机)、K-NN(K-最邻近)、GMM(高斯混合类型)。MLP分类器识别率较高且分类速度较快,对于巨大量的训练集,训练速度慢于SVM分类器。SVM分类器在识别率和训练速度方面略优于MLP分类器,但是分类速度没有MLP分类器快,并且不能自动获取一个拒绝类。k-NN分类器参数很少且直观,可以用很少的训练样本工作,甚至每一类仅一个样本就可以工作,训练速度是所有分类器中最快的,缺点是分类速度相对较慢,且分类结果不如MLP和SVM分类器好,因此k-NN分类器适用于自动特征选择和快速评估。GMM是高斯混合模型分类器,按贝叶斯决策规则进行工作,仅对低维的特征向量有效,适用于对一般特征进行分类和图像分割。

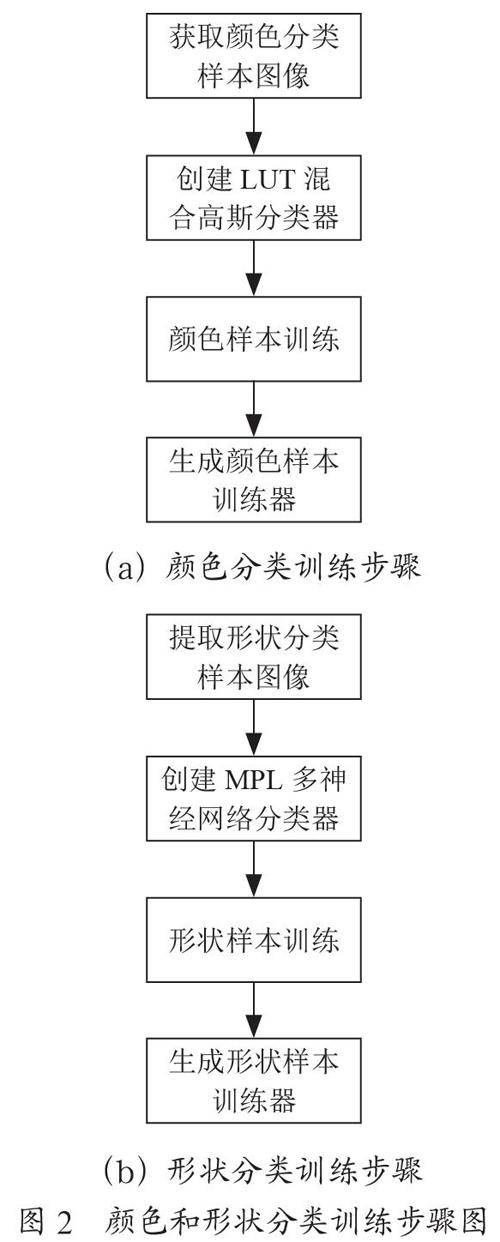

经过对比选择,颜色的分类识别采用的是基于混合高斯模型(GMM)的分类器,首先进行颜色分类训练,将采集到的颜色样本放入高斯分类器中进行样本训练,生成颜色分类的训练器;然后进行颜色分类,创建LUT混合高斯分类器,利用训练后的颜色分类器进行颜色分类识别。形状的识别采用的是MPL多神经网络分类器,首先进行形状分类训练,创建多层神经网络分类器,读取各种类型的形状样本图像,提取形状特征并加载到训练数据中,进行形状训练,保存训练结果;然后进行形状分类,读取需要分类的图像,分割提取形状,根据训练好的形状分类器进行形状分类识别。颜色分类和形状分类的流程图如图2所示。

2.2 目标物的定位

为了确定图像中的像素点与现实三维空间位置之间的对应关系,我们需要建立相机成像的几何模型,这个过程被称为相机标定[8]。相机标定包括相机内参标定和相机外参标定。内部参数主要用来表示像素坐标系与相机坐标系之间的关系,外部参数主要用来表示相机坐标系与世界坐标系之间的关系。利用相机内外参完成目标物成像坐标系到世界坐标系的转换,从而实现对目标物体三维空间的定位,即可以通过相机采集客观世界中物体的图像,通过获取物体在图像中的位置信息,然后通过坐标变换,可获得目标物体在客观世界中的位置坐标。

3 自动抓取机械手控制

3.1 机械手运动建模

机械臂可以抽象为一系列关节和连杆的顺序组合,关节处产生旋转或滑动使得机械臂末端到达指定位置,对机械臂进行运动学建模就是描述机械臂各个连杆之间的相对位置和方向关系,因此需要根据关节的结构在机械臂每个连杆上固定一个坐标系,用齐次变换矩阵来描述相邻两个连杆空间上的关系。

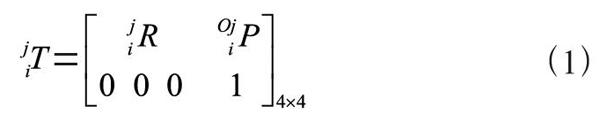

D-H建模是一种对机器人运动学进行建模的标准方法。在机械臂每个连杆上建立一个坐标系,通过确定每一关节与下一关节之间的所有齐次坐标变换,求得机械臂末端与底座的姿态关系。齐次坐标系用n+1维向量表示n维向量,将旋转变换和平移变换统一成了4×4矩阵运算。齐次变换矩阵表示如式(1)所示:

其中表示旋转,右边一列表示平移。

D-H建模过程中主要涉及四个参数:a为公垂线长度,α为相邻两z轴之间的扭角,d为z轴相邻公垂线之间的距离,θ为关节旋转角。机械臂的D-H参数表如表1所示。

D-H参数表的每一行对应每一步的齐次变换矩阵,将这些变换矩阵右乘可以建立基座与机械臂末端的坐标关系如使(2)所示,求解出关节变量,就可以实现对机械臂的控制。

在自动抓取系统中,我们事实上是在已知目标位置的情况下控制机械臂到达指定位置,即我们需要根据位置信息求解全部关节变量的值,这就是求解其逆运动学方程。

3.2 机械手抓取流程

下面具体介绍基于视觉机器人的自动抓取机械手控制实现流程,首先用Halcon圖像处理软件,处理所拍摄到的图片,完成目标物的颜色识别和形状识别并定位,并得到标定点。然后将识别的目标物的位置信息发送给机械臂的处理器,后面我们通过标定点的位置和目标点的位置坐标差,进行处理,来实现机械臂移动到目标点并抓取,使机械手完成目标物的抓取和分组放置。流程图如图3所示。

其具体步骤为:

(1)读取样本,完成颜色分类训练和形状分类训练。循环读取不同光照下的样本图片,进行颜色分类训练,颜色包括红、黄、绿、蓝四种。形状样本这里采用的不同的零件,读取各种类别的零件图像,从图像中分割提取形状特征并加载到训练数据中去,进行形状分类训练。

(2)获取目标物的图像,进行图像处理。读取图像,利用步骤(1)获得的颜色分类器进行颜色分类识别;提取分割形状,获取形状特征,利用步骤(1)获得的形状分类器进行形状分类识别。

(3)获取目标物坐标。根据相机的内外参数,将目标物的像素坐标转换到世界坐标

(4)控制机械臂抓取目标物,并按照颜色和形状进行分组码垛。机械臂逐个抓取目标物,按照目标物的颜色和形状将目标物码垛到指定位置。

3.3 实验验证

将不同颜色不同形状的物体放置于Z=0的平面,如图4所示。首先对目标物进行识别标定,记录其位置为理论位置。调整机械臂至初始状态,启动系统进行抓取测试。当机械臂运行至抓取位置,启动抓取操作时,记录下机械手当前的抓取位置为实际位置。

将理论位置和实际位置之间的距离记为误差,具体见表2。经计算14个实验样本的平均误差为1.96 mm。

实验结果表明,目标识别结果准确,抓取的定位误差较小,可以满足机械手的顺利抓取要求。

4 结 论

为适应工程教育改革,培养创新型实践型人才,在视觉机器人的基础上,设计了基于视觉机器人的自动抓取机械手控制测控一体化的研究型实验。利用基于混合高斯模型(GMM)和MPL多神经网络的分类器分别实现了颜色和形状的分类识别,利用D-H模型建立了机械臂的运动学模型,求解逆运动学方程,得到全部关节变量的值,从而实现对机械臂的控制。通过基于视觉机器人的自动抓取机械手控制,学生能够充分了解学科知识之间的关联性和融合性,锻炼和提高工程实践能力和创新实践能力,对课程的建设、专业的发展、人才的培养具有重要意义。同时实验具有很高的实用性和趣味性,能够充分调动学生的兴趣,发挥其主观能动性,实验教学资源也得到了充分的利用。

参考文献:

[1] 王勇,陈荟西.基于机器视觉与单片机结合的机械臂抓取系统 [J].自动化技术与应用,2021,40(1):78-84.

[2] 杨学文,王楠.视觉驱动机械臂自主作业技术综述 [J].南京信息工程大学学报(自然科学版),2021,13(3):281-290.

[3] 温剑锋.基于人工智能的视觉目标定位系统设计 [J].现代计算机,2020(35):65-69.

[4] 房国栋,高军伟,朱晨曦,等.基于机器视觉的机械臂智能分拣系统 [J].仪表技术与传感器,2020(12):72-76+81.

[5] 姚启才,汪地,廖茂生.基于机器视觉的机械臂智能抓取系统设计 [J].计量与测试技术,2020,47(10):28-33.

[6] 廖秉旺,林文煜.基于Halcon的工件视觉分拣系统 [J].现代信息科技,2021,5(1):156-158.

[7] 杨伟姣,杨先海,薛鹏,等.基于Halcon的固定视点手眼标定方法 [J].机床与液压,2021,49(8):35-37+71.

[8] 祁若龙,张珂,赵吉宾,等.基于高斯模型和视觉测量的机械臂在线自标定方法研究 [J].机械工程学报,2021,57(5):63-71.

作者简介:刘莹(1987—),女,汉族,江苏徐州人,工程师,硕士,主要研究方向:测控系统与智能仪器。

收稿日期:2021-04-28

基金项目:东南大学教学改革研究项目(2019- 119)