算法权力异化及法律规制

赵一丁 陈 亮

一、问题的提出

算法属于技术秘密的范畴,是指为解决某个特定问题而采取的确定且有限的步骤,实现算法的工具是计算机,基于数学工具的技术是算法肇始的渊薮。“图灵”伊始,人工智能技术的问世,迅速内嵌社会生活各领域。从个性化新闻推送到智能社会治理,从阿法零到自动驾驶,从犯罪风险预防到辅助量刑,社会科学和科技工程等多领域不断融通,算法在政治、经济、司法等领域呈指数性扩展。

传统的技术工具主义角度,技术是征服、改造自然的力量,无价值取向和权力属性,①参见刘永谋:《机器与统治——马克思科学技术论的权力之维》,《科学技术哲学研究》2012 年第1 期。算法亦然。但是,如果技术对人的利益能够直接形成影响和控制,技术便失去纯粹性而具有权力属性②参见梅夏英、杨晓娜:《自媒体平台网络权力的形成及规范路径——基于对网络言论自由影响的分析》,《河北法学》2017 年第1 期。。典型的例子是剑桥分析事件:英国剑桥分析公司(Cambridge Analytica)前雇员Christopher Wylie透漏,剑桥分析公司利用“爬虫”获取8700万Facebook用户数据,分析用户的浏览痕迹、行为模式和性格特征,制定个人“数据画像”。美国总统大选过程中,推送具有政治倾向性的“假新闻”,左右公众政治选择,影响政治走向。可以说,人工智能时代,权力越来越存在于算法之中。

算法权力是以算法为工具或手段,对他人或社会形成的特殊影响力和控制力。芬伯格认为,技术是一种双面(two-sided)现象:一方面有一个操作者,另一方面有一个对象,当操作者与对象都是人时,技术行为就是一种权力的实施③[加]安德鲁·芬伯格:《技术批判理论》,韩连庆、曹观法译,北京:北京大学出版社,2005 年,第11 页。。资本作为算法权力的操作者,具有天然进攻性与逐利性。这种内生性的风险及外部性失约,给算法权力带来了诸多异化风险,如算法极权,权力—权利格局的失衡,主体危机等。如何矫正算法权力的异化,规制算法权力是当下要解决的问题。

对于算法权力的规制,学界多有研究,多从单维度、阶段化、片面化的角度出发,具有较强的针对性①姜野、李拥军:《破解算法黑箱:算法解释权的功能证成与适用路径——以社会信用体系建设为场景》,《福建师范大学学报 (哲学社会科学版)》2019 年第4 期;肖冬梅:《“后真相”背后的算法权力及其公法规制路径》,《行政法学研究》2020 年第4 期。。然而,更加值得关注的是,借助深度学习技术,算法不再仅是工具,而是具备主体功能的技术体系。剑桥分析事件中,算法权力仍被设计者和主导者控制,社会危害依然可控。若算法完全从“客体工具”演化为“主体操作者”,算法权力的异化将导致颠覆性的社会危害。鉴于此,算法权力规制的核心在于通过透析其异化,探究其异化逻辑及根源,从技术与权力等层面多维度、全程化、整体化的展开规制,完善算法权力的治理机制。

二、算法权力异化的风险

异化一词,一般用德文词汇“entfremdung”和“entfemden”来表示,有脱离、对抗、受异己力量统治之意。费尔巴哈在黑格尔“绝对精神”的异化理念基础上,进一步提出“上帝是人的自我异化”。上帝本由人创设,后异化为与人相疏离的客观存在,甚至统治人。与费尔巴哈类似,费希特认为,异化是“自我”创造“非我”,“非我”反作用于“自我”的关系。故,我们将人类规定算法,算法反作用于人类,甚至统治支配人类的疏离关系称为算法权力的异化。即使智能算法涉及数学、心理学、计算机等多种学科,但算法自主决策却无法保持绝对的客观,从而引发诸多风险。如汉斯·昆所说,技术上最伟大的胜利与最大的灾难几乎并列②[瑞]汉斯·昆:《世界伦理构想》,周艺译,北京:生活·读书·新知三联书店,2002 年,第16 页。。算法权力异化所引发的风险必须高度重视。

(一)算法极权

极权(Totalitarianism)一词,用来指全面统治。黑箱掩护下,算法权力逐步确立权威并尽一切可能谋求控制公众与社会。这种全面统治的算法极权,一方面扩大贫富差距;另一方面资本文化盛行,吞噬社会正义。

1.贫富两极分化

掌握算法的大型资本企业根据自身利益需要,制定诸多交易规则及纠纷解决机制,其中不乏格式条款。消费者以让渡自身权利获取平台使用权。算法通过分析消费者的浏览痕迹、购买记录,进行消费身份构建,针对消费者的购买能力动态定价,实行“个人各价”,也就是所谓的“大数据杀熟”。数据的无偿使用是大型资本企业攫取利益的关键。剩余价值尚且是劳动创造的价值和劳动报酬之间的差额,然而,大型企业对数据的使用无须支付任何报酬,算法运作下,数据的“价值增值”远远超乎想象。研究显示,2015 年Uber 仅根据动态定价算法就创造了68 亿美元的利润③Hogan B:“The presentation of self in the age of socialmedia:Distinguishing performances and exhibition online,”Bulletin of Science,Technology &Society,Vol.30,No.6(2010),pp.377-386.。这一切的“原罪”是生产者和生产资料的分离,其造成的恶果就是占有算法的人的财富不断增加,而提供生产数据的生产者只能靠出卖自身的数据以换取平台使用权。这必然扩大算法掌控者与数据生产者之间的财富差,加剧贫富两极分化。

2.文化极权

技术的设计不仅反映技术中某一种社会因素,同时还具有更广泛的社会价值。算法权力所传递的文化是智能为王,如Google 开发者大会的口号“AI First”(智能为先)。智能算法的确使得社会生活极具便利,但部分公众被算法文化左右,却一无所知;部分公众即使知道这种文化灌输是资本获利的方式,却并不反感,甚至感到十分舒适。算法文化对人类思维的麻痹或强制指引,实质上是资本文化的极权,利用技术谋求公众及社会对资本经济需求合法化的认同。这种资本文化的极权,吞噬社会正义的同时,将整个社会变成了马尔库塞提出的“不会成为反对派”的单向度的人(One-Dimensionalman)。④单向度的人(One-Dimensionalman)指技术合法外衣下,发达工业社会对任何可能的反抗进行扼杀,使得社会失去批判性、否定性、超越性的向度,变成了单向度的社会,社会中的个体变成了单向度的人。其不能反抗,没有创造力,不能超越。参见[美]马尔库塞:《单向度的人——发达工业社会意识研究》,刘继译,上海:上海译文出版社,2014 年,第30 页。

(二)权力——权利格局失衡

传统二元格局下,非因革命手段,以国家、政府为代表的公权力和以公民为代表的私权利相互制衡。然而,算法权力的强势介入,造成原有的“权力—权利”格局的失衡。

权力与权利相对而言,权力具有进攻性,权利则具有防守性。权力与权力的结盟具有天然性,若无外部力量干预,算法权力与公权力结盟,是二者的必然选择,其结果是公权力的扩张,私权利的限缩。

一方面,公权力借助算法权力扩张,挤占私权利空间。理论上,公权力与私权利的纽带是公共利益,只有因公共利益,公权力方可介入私权利。“任何国家权力无不是以民众的权利让渡与公众认可作为前提的”①[美]孟德斯鸠:《论法的精神(上)》,张雁深译,北京:商务印书馆,1961 年,第213 页。。算法技术的高效、便捷,为公权力介入私权利提供了低成本手段,政府依靠算法权力掌握大数据,精准监控个人行为。如2013 年棱镜门事件,以算法科技进行全方位监控的幕后机构浮出水面,可怕的不仅是美国对国内外的监控和窃听行为,更是美国国家安全局与苹果、IBM 等掌握算法的高科技公司模糊的合作关系,也就是说公权力利用算法权力大肆扩张,侵犯公民隐私权乃至世界网络安全。人们在享受人工智能所带来的快捷服务时,悚然发现自己一直在互联网的监控下“裸奔”。正如佩德罗·多明戈斯(Pedro Domingos)所言:“永恒的监视才刚刚开始”②[美]佩德罗·多明戈斯:《终极算法——机器学习和人工智能如何塑造世》,黄芳萍译,北京:人民邮电出版社,2017 年,第365 页。。

另一方面,算法权力渗透公权力,逐步扩大自身话语权,侵害私权利。立法层面,算法影响民意。自尤尔根·哈贝马斯“商谈理论”始,公众参与在立法层面的发展和应用可见一斑。掌握算法的大型企业利用大数据分析公民性格喜好,利益需求,采取立法精准性营销,通过公众参与推动立法向有利于自身的方向发展,巧妙地完成算法影响公众,公众影响立法的权力转化。司法层面,算法成为司法辅助工具。近年来,智慧司法的构建中,算法不断渗透到司法活动的各个环节,譬如证据规则指引、单一证据校验、逮捕条件审查、社会危险性评估、类案推送、量刑参考、减刑假释案件办理等。研究表明,人类极易受到“自动化偏见”的影响,盲从于算法决策,智能算法逐渐成为司法辅助工具,甚至是直接裁判工具。

公权力与算法权力在各个方面都展开了频繁的互动,二者可谓是实现了“共赢”③崔靖梓:《算法歧视挑战下平等权保护的危机与应对》,《法律科学(西北政法大学学报)》2019 年第3 期。。“共赢”的同时,侵害了公民的隐私权、立法权、司法权等私权利,造成私权利边界的限缩。

(三)主体危机

“互联网+人工智能”的技术创新,正在颠覆长期以来形成的人与工具之间的控制与被控制、利用与被利用的关系,人工智能把技术创新的目标从解放体力转向解放智力④成素梅:《人工智能研究的范式转换及其发展前景》,《哲学动态》2017 年第12 期。。有学者认为“算法权力这种新兴的权力并不把我们当成‘主体’来对待,而是作为可计算、可预测、可控制的客体”⑤郑戈:《算法的法律与法律的算法》,《中国法律评论》2018 年第2 期。。人以“数据人”的身份作为算法权力运行过程中的一个节点或者元素,算法权力反客为主,传统的主客二分范式岌岌可危,人类主体面临着前所未有的挑战。

一方面,算法权力以技术理性为导向,消弭人格价值。正如亨利的生命现象学所说,技术的本质是对生命的否定和排斥⑥参见汤炜:《对技术的现象学反思之进路——兼谈人工智能》,《哲学分析》2019 年第2 期。。算法权力的运行逻辑中,人和物并没有区别,遵循技术理性的指引,人类与生俱来的尊严与人格被无情碾压。尽管,算法利用深度学习功能将人类从体力与智力的劳动中解放出来,但人类的“生命自我”也将被异化为非生命的数字节点。不乏与瓦尔·赫拉利同样的担忧,人类的进程其实是由算法来决定的,在未来,人类的生化算法将被外部算法超越⑦[以色列]尤瓦尔·赫拉利:《未来简史》,林俊宏译,北京:北京电子工业出版社,2017 年,第263—270 页。。生命和技术彻底决裂时,人类将失去对算法的控制,完全成为算法规制的客体,奴役的对象。

另一方面,算法权力的主体界定困难,引发归责困境。现有的规制逻辑是从社会生活实践中不断发展起来的,其原有的因果关系、主观过错、行为责任等法律逻辑遭遇算法权力主体界定的挑战时,必然方枘圆凿。如2019 年巴黎圣母院失火事件,美国YouTube 网站的算法自动将“9·11”恐怖袭击事件的说明专栏排版在巴黎圣母院失火事件的直播专栏下面。这一行为引发社会各界批评,认为YouTube此举是在暗示此次失火与恐怖袭击有关。YouTube 一度站在了舆论的风口浪尖,备受争议。令人意外的是,这种助长“阴谋论”的自主排版行为,其算法设计的初衷竟是打击网站上的“阴谋论”视频①参见赵挪亚:《YouTube 直播圣母院大火》,https://www.sohu.com/a/308249633_115479,2019 年4 月16 日。。面对算法自主的不可控,YouTube 堪称有苦难言。此外,平台企业常以“技术自主错误”而非“平台错误”来逃避法律责任。如Facebook 因算法错误导致广告播放量虚增两年,再次卷入“算法纠纷”,作为算法的受益者,Facebook 对外声称仅是算法错误②参见李玥:《虚增视频播放时长达两年,Facebook 称算法错误》,http://finance.sina.com.cn/roll/2016-09-27/docifxwermp4033395.shtml。。可见,平台“背锅”与平台“推责”已成为常态,传统的行为——责任逻辑被切断,因果关系面临重构危机。

三、算法权力的异化逻辑及根源

算法权力的运行催生了众多异化风险,难免引发社会治理困境。因此明晰算法权力的异化逻辑及根源非常关键,不仅是对算法权力异化机理的理构,也是预防与治理算法异化的前提。

(一)算法权力的异化逻辑

算法权力作为社会权力,有其自身的异化逻辑。从实质层面观察,所有异化现象都聚焦于一个本质——法律与技术关系的演变。人工智能语境下,笔者认为算法权力异化的本质是法律与技术的疏离对立。

1.法律利益衡平的博弈与算法权力单向逐利

利益法学的创始人,著名德国法学家菲力普·赫克认为,法律是社会中各种利益冲突的表现,是人们对各种冲突的利益进行评价后制定出来的,实际上是利益的安排和平衡③何勤华:《西方法律思想史》,上海:复旦大学出版社,2005 年,第255 页。。作为汇聚不同权力利益诉求的裁判者,利益衡平是法律价值构造的内核。与法律对利益的定位不同,资本利益的最大化,是算法权力的唯一追求。大型资本企业作为算法技术的主体,天然具备“操作自主性”,④“操作自主性”(operational autonomy),即所有者及其代表,在关于如何经营组织生产上的自主决策很自由,不必顾及弱势群体以及周边团体的利益和看法。参见[加]安德鲁·芬伯格:《技术批判理论》,第11 页。这也决定了算法的研发、生产、经营皆是以资本理性为出发点的私主体行为。技术主体将资本利益诉求植入算法,仰仗技术的优势进行权力的转化与扩张。更进一步地说,资本披着“技术中立”的外衣,将自身价值导向内化于算法权力的运行过程,这种过程是谋取自身权力正当化的过程。法律与算法的博弈可以说是公共利益与资本利益的斗争,表现于算法权力在谋取“正当化”的过程中,单向逐利,侵害公共利益,导致社会利益分化。

2.法律预测脆弱性与算法不可控性的矛盾

法律预测是对未来一段时期内的社会关系进行概率性的判断。由于未来的社会关系具有随机性与变异性,使得这种建立在人类有限认知基础之上的预测十分脆弱,容易出现误差。此外,法律对于技术的预测多习惯以“知识因果论”进行前提性预设,认为对技术认知越多,技术后果预测得越准确。这种观点建立在知识的线性积累上,主张随着技术的发展,人们自然会掌握技术的相关知识,可以准确地预测技术。

然而,“知识因果论”忽略了算法的不可控性,主要表现在两个方面。其一,算法自主性所带来的不可控。算法权力依托算法技术,而算法技术的构建者是算法设计者、研发者。他们建立、测试和改进模型。如果说算法设计者和研发者是母系统,那么算法权力便是子系统,二者在控制层面呈现耦合关系。换言之,算法设计者、研发者对算法权力有一定程度的控制力,但绝非全部。算法因“自主性”功能,常出现连设计者和研发者也无法控制的自主决策问题。如赫拉利所说:“即便是看来立意全然善良的程序,也不能排除带来令人恐惧后果的可能”⑤[以色列]尤瓦尔·赫拉利:《未来简史》,第294 页。。其二,算法田野性所带来的不可控。算法技术的设计,直接面对算法技术的应用,即现实问题的解决。而现实问题往往涉及多学科及多领域,这种现实复杂性决定了算法多学科、多领域交叉的田野性特征。该田野性使得算法权力的运行处于多维度、多层次的不可控状态。因之,算法的法律预测应当是法学家、伦理学家、技术专家甚至公众、社会组织等多学科、多领域交叉合作的过程。然而,实践中,法律预测的主体只有立法者与普通公民,其大多来自算法系统外部,他们以系统外部的观点甚至是传统法律规制逻辑来规制算法权力,无法“对症下药”。

无疑,算法自主性与田野性所带来的不可控增加了原本就脆弱的法律预测与算法权力之间的内在张力,使得算法权力的异化成为必然。

3.法律滞后性与算法动态发展线性时间的对立

法律作为社会意识形态之一,不是原本就有的,而是社会存在的附属。这种建构在决定与被决定逻辑之上的附属性,注定了算法权力异化与相关法律规制的先后性。更加重要的是,算法技术是链条状的无限发展状态,而立法由于程序所限,则无法保持时刻的连贯。这种“事前异化”与“事后规制”和“过去法律”与“现下技术”之间的时间差异,在技术发展早期与技术发展后期,引发了不同的技术控制困境。科林格里奇认为,在技术发展早期,人们往往对技术缺乏足够完备的认识和准确的预测,此时虽然易于控制技术后果,但却不知是否应该控制或应该如何控制;技术发展的成熟阶段,人们对于技术的认识逐步加深,但技术已在其发展过程中逐渐渗透到整个社会系统之中,此时人们虽然知道如何控制却囿于成本等因素而根本没有能力来实施控制①陈凡、贾璐萌:《技术控制困境的伦理分析——解决科林格里奇困境的伦理进路》,《大连理工大学学报(社会科学版)》2016 年第1 期。。法律滞后性与技术动态发展之间的矛盾本属正常。算法权力语境下,二者矛盾激化,其原因有二:一是,算法技术的发展堪称神速,超越了以往任何一种技术形态,技术发展与法律回应的速度差陡增。二是,与英美法系不同,中国是大陆法系国家,算法技术及权力的最新变化无法通过判例的方式翻译成法律规制,这种非连贯的立法方式无法适用于算法技术的动态变化。

综上所述,算法权力异化的实质是一种规制失灵的状态。封闭的算法权力系统自身缺乏控制和反思机制,难以将负外部性内部化。而独立于算法权力外部的法律规制,无法有效地参与到算法权力的运行过程中。这种分离对立的根源为何?笔者认为,“罪魁祸首”是算法黑箱,有必要对其进行深入分析。

(二)算法权力异化的根源——算法黑箱

无论是可能脱离人类控制的算法权力,抑或是在人类控制之下的算法权力,均肇始于算法设计者基于单向逐利的自主行为。脱离人类控制的算法权力,其产生的原因是且仅可以是算法的固有缺陷,而该缺陷本是算法设计者之外的社会或个体可以弥补之不足;人类可控的算法权力则源于权利主体对算法的垄断性独享。因之,算法权力异化的根源,是且仅可以是以算法技术为前提,以利益为驱动的算法黑箱。

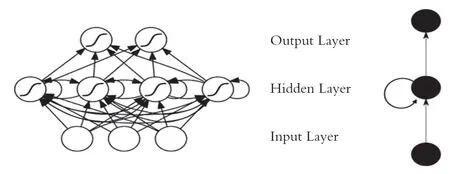

1.技术缺陷下算法黑箱:不透明

算法自主决策越来越依托“深度学习”模型,其技术逻辑是由相互联系的神经元组成,由输入层、隐藏层、输出层共同运作的多层神经网络。如下页图1 所示,算法根据输入层数据,在隐藏层自动进行特征提取、数据训练、自主学习,最后于输出层自动生成认知结果。在尼古拉斯·迪亚克普拉斯(Nicholas Diakopoulos)提出算法黑箱监督式学习和半监督式学习的基础之上,②算法黑箱监督模式:输入和输出均可知。算法黑箱半监督模式:输入不可知,输出可知。See Diakopoulos N:“Algorithmic Accountability:Journalistic investigation of computational power structures,”.Digital Journalism,Vol.3,No.3(2015),pp.398-415.学者张淑玲提出了算法黑箱无监督式学习的模式③算法黑箱无监督模式:输入和输出均未知。参见张淑玲:《破解黑箱:智媒时代的算法权力规制与透明实现机制》,《智媒时代》2018 年第7 期。。算法在接受输入数据之后,以至输出决策结果之前都会有一个人们无法洞悉的“黑箱”。详细而言,当输入和输出是线性因果关系时,方可保证“善因”得“善果”。然而,影响算法结构系统的因素十分复杂,输入和输出的关系是非线性的,“善因”可能得“恶果”。质言之,无论输出层、输入层是否可知,隐藏层内算法是如何运作的,无人知晓。

图1 深度学习神经网络(Neural Network of Deep Learning)

算法不透明所产生的不可控性为算法权力的异化提供了根本性可能。“黑箱”庇护下,算法自主性权力无目的性肆意妄为。无监督式学习的情况下,算法无任何人为干预,完全自主决策,输入和输出两侧均不可知,整个算法决策的流程处于闭环黑箱状态。那么,谁能保证输出一定不是“恶果”呢?

除此之外,“黑箱”阻断了因果关系,成为掩盖算法权力追求利益的“面纱”。利益驱动下,数据在输入层面上就难以做到准确和客观,算法设计者、控制者很可能将自身利益取向或偏见植入输入层数据,从根源上污染算法权力。“污染数据”经历隐藏层“黑箱”的二次污染后,数据利益取向与偏见得以加强,最终于输出层结出“毒树之果”。更重要的是,算法黑箱下,算法决策产生错误甚至侵害相对人合法权益的同时,罪魁祸首大可无耻地以“技术中立”为辩护理由,产生“有组织地不负责(organized irresponsibility)”①有组织地不负责任是指公司、政策制定者和专家结成联盟,利用法律和科学作为辩护之利器而推卸制造风险的责任。参见史长青:《科学证据的风险及其规避》,《华东政法大学学报》2015 年第1 期。。

2.法律保护下的算法黑箱:不公开

作为技术秘密,法律赋予算法持有人不公开的权利。传统意义上的技术秘密,均基于物理、化学、生物等科学的基本原理。法律赋予持有人不公开的权利,是为了保护技术秘密持有人的经济权利,鼓励社会技术进步。通常情况下,社会公众对其可以进行基本正确的解读,目前的法律制度亦可规制。而算法是基于计算机科学和数学的基本原理,对于算法持有者之外的社会公众对其一无所知。因此,算法的不公开,必然导致算法黑箱的产生。

对持有算法权力的商业运营企业而言,基于商业秘密和商业利益,并不主张算法公开。如腾讯、阿里巴巴、京东等公司,均将其持有的算法作为最高机密。就国家层面而言,世界主要经济体已将发展算法为基础的人工智能上升为国家战略。如美国的《国家研究人工智能和发展规划》、日本的“社会5.0”战略、欧盟的《人工智能协调计划》。自从技术创新成为经济引擎,国家对于人工智能核心技术——算法的保护,已是必然。

但是,利用算法实施商业欺诈行为欺骗公众牟取利益的方式,则不属于商业秘密的范畴。商业秘密是指不为公众所知悉、具有商业价值并经权利人采取相应保密措施的技术信息、经营信息等商业信息。显然,利用算法黑箱实施欺诈的商业运营方式,不应当属于商业秘密。厘清这一点,有利于找到正确的思路,以最简洁有效的法律规制解决面临的问题。

现实中,因不能正确区分技术秘密、商业秘密以及欺诈性的商业运营模式,对算法黑箱的错误保护,为算法权力异化提供了正当性。典型案例如美国威斯康星州诉Eric·Loomis 案②美国威斯康星州诉艾瑞克·卢米思(Eric Loomis)案,量刑阶段法院采纳了COMPAS 再犯评估的内容,引发卢米思(Loomis)上诉,其理由是法院对COMPAS 的依赖侵犯了他正当程序权力和平等权。最终州最高法院支持了初审判决。,最终州最高法院否定Loomis 的上诉主张,且未要求厂商公开算法或解释算法。提供再犯评估的COMPAS 算法作为Northpointe公司的商业秘密,其是否隐藏有Northpointe公司的利益取向,是否藏有歧视或偏见?ProPublica 作为一家非营利机构,在无任何利益驱逐的情况下,针对COMPAS 的预测数据进行了统计分析,结果发现,黑人被告得分更高的概率是白人的两倍③See Jeff Larson,etal.How We Analyzed the COMPAS recidivism Algorithm .[2016-05-23].https://www.propublica.org/article/how we analyzed the compas recidivism algorithm.。

由此可见,被作为技术秘密或商业秘密保护的算法并非中立。由于传统的法律保护原则和保护方法,利益相对方难以有效地行使异议权和救济权。加藤一郎认为,利益衡量乃是难以避免的自然之理④参见梁上上:《利益衡量论》,北京:法律出版社,2016 年,第40 页。。虽然从保护运营企业的财产权角度看,法律有义务避免算法变为“公知技术”,但这种极近一刀切的传统保护模式,成了资本牟利的“护身符”,造成平等私权主体之间权益失衡。

四、算法权力异化的规制路径

应对算法黑箱造成的权力失约,关键在于找到法律与算法勾连的有效着力点——“破解黑箱”,即允许算法黑箱的存在,升级规制思路,将算法权力的运行纳入法律调整的轨道。其主要包括三个方面:技术规制与权力制约并驾齐驱;终端规制到全程规制;公私领域分别规制过渡为整体性规制设计。

(一)算法权力规制的基本思路

1.技术规制与权力制约并驾齐驱

技术规制与权力制约,双管齐下,避免偏废其一。一方面,算法权力运行的基本原理为现代数学成果,其往往选择数学上的最优解,忽略法律、伦理等的价值取向。为应对这一技术缺陷,有必要对其进行技术规制,使人类的认知与价值内嵌算法技术,从而加强技术规制对算法权力的驱动力和控制力。此外,算法借助深度学习,从“客观工具”变为“主观操作者”,与人的行为相分离。单纯地依靠权力制约,显然无法应对算法由客转主的角色变化。

另一方面,一切有权力的人都容易滥用权力,这是万古不易的一条经验,有权力的人使用权力一直到遇有界限的地方才休止①[美]孟德斯鸠:《论法的精神(上)》,张雁深译,北京:商务印书馆,1961 年,第154 页。。即使技术规制能够制约算法自主权力及纠正算法设计者植入算法的偏见,却无法解决算法权力运行过程中权力行为主体对算法的滥用。此外,多层次场景化的算法应用更加要求从时间、地点、条件出发,更加动态、具体地对算法权力加以个性化的权力制约。

2.终端规制到全程规制

算法权力的运行具有流程性,包括数据的收集、加工,算法的研发、设计,以及算法的应用,其异化可能产生于以上任何阶段。然而,传统法律制度,“技术中立”的思维范式将算法设计与算法应用割裂开来,认为任何技术的设计都不在规制范围内,将规制的范围限缩在技术的应用阶段,忽视“被制造出来的风险(manufactured risk)”。②被制造出来的风险指的是由人们不断发展的知识对这个世界的影响所产生的风险,是人们在没有太多历史经验的情况下所产生的风险。[英]安东尼·吉登斯:《失控的世界》,周红云译,南昌:江西人民出版社,2001 年,第22 页。不仅如此,面对“算法黑箱”,终端规制面临法律因果链条断裂,现有法律之不敷的困境。故,算法权力的规制应升级规制思路,进行“事前预防—事中监管—事后救济”的全过程规制。首先,算法技术设计始,从源头将法律与技术进行勾连,弱化算法技术与法律的分离,这对于减少算法权力异化的概率具有十分重大的意义。其次,算法权力的运行过程中,加强对权力运行的监管及问责,提升算法权力运行的透明度,力建督审结合的监管制度体系。最后,针对算法权力异化所带来的负外部效应,进行具体的事后救济,引入异质权力制约—算法可解释权与算法问责机制勾连,重构法律因果链条。

3.从公私领域分别规制过渡为整体性规制

“算法黑箱”使得公共利益与资本利益相互交织,很难找到一条泾渭分明的界限。公权力与算法权力的相互渗透,模糊了公权力与私权利的界限。公权力借助算法辅助决策,以降低管理成本,提高管理效能;算法权力利用技术,形成“准公权力”扩大自身话语权。如果该决策是为“资本利益”服务,那么其决策性质为“私”;如果该决策是为“公共利益”服务,那么其决策性质为“公”。问题在于,“黑箱”掩盖下,算法决策何时出于公共利益,何时代表资本利益,决策主体无法给予合理的解释。面对这种弥散性的权力形态,要考虑对其进行整体性的规制设计:首先,扩大问责主体,将公私领域的问责主体合一,进行刚性约束,制约算法权力的滥用。其次,公私权力的交织,直接影响公权力的正当性,甚至是权力属性,有必要引入第三方治理,以确保权力监督的公正性。最后,无论是公领域抑或私领域,皆赋予个人算法可解释权,个人权利的配置不仅出于事后救济的需要,更是为整体性应对私权利缩限,增加私权利与算法权力博弈的资本。

(二)算法权力的法律规制

1.设计阶段:建构性算法伦理评估

建构性算法伦理评估指评估主体依据不同利益主体的反馈结果对算法设计可能造成的伦理风险进行分析论证,在此基础上提出调整建议及对策。之所以称“建构性”,是由于评估发生在算法设计阶段,旨对算法权力产生建构性的影响,实质上是规制体系从对事物规制向对代码规制的变革①See Paul Ohm,Blake Reid:“Regulating Software When Everything Has Software”.george Washington Law Review,Vol.84,No.6(2016).,从源头打破法律与技术分离对立的局面,将算法权力的异化扼杀在摇篮中。

具体而言,算法伦理评估的建构主要包括三个方面:

第一,算法伦理设计,即算法伦理性评估的前提,以立法形式明晰算法设计者的伦理设计义务。法律从来没有享受过价值无涉的保护伞,而是必须持续地回应公众的价值观期②蒋舸:《作为算法的法律》,《清华法学》2019 年第1 期。。这就要求算法在设计阶段将法律所追求的伦理价值融入算法功能,让伦理与技术并列成为算法设计的组成部分,实现算法设计伦理化。如欧盟《可信赖的人工智能准则》中将人的价值作为人工智能的首要考量因素和欧盟GDPR 的默认隐私原则。互联网巨头企业在其人工智能伦理的主张中也体现了默认隐私或默认伦理的诉求③汪庆华:《人工智能的法律规制路径:一个框架性讨论》,《现代法学》2019 年第2 期。。

第二,设计、负责及评估主体分离制度。该制度最朴素的叙述是任何人不能成为自己的法官,以确保评估结果的全面、中立。如果将算法设计主体与评估主体杂糅,算法设计主体极有可能利用自身评估职权影响评估过程和其他参与主体的判断。具体评估事项应交由第三方机构负责,该第三方机构可以是政府科技发展部门,也可以是专业技术评估机构,其通过协商或命令确保算法设计尽可能平衡各方利益。需要说明的是,鉴于公权力的异化特性与专业机构被“俘获”的风险,第三方机构并非评估主体,只负责设置评估任务、组织评估议程以及监督评估过程。算法伦理风险的分析与描述由专家(算法技术专家、伦理学家、法学家及其他相关学科专家)及利益相关者进行评估。

第三,算法风险交流机制。该机制指算法设计风险评估程序的每一阶段、步骤、环节,参与主体与社会公众都需充分的交换风险信息并交流反馈意见。需要强调的是该机制以信息公开为原则,无论是过程信息还是结果信息,除法定禁止公开的信息外,皆应公开。普通民众虽非评估主体,但可以通过平台平等的表达意见,缩小算法黑箱所带来的技术精英与普通民众的“信息鸿沟”,预防公权力与算法权力的双向“勾结”。

2.权力运行阶段:审督结合与第三方制约

审督结合与第三方制约的目标在于提高算法权力透明度,显化算法权力的运行,促使权力处于监督之下;另则,在于确保日后的责任回溯。

第一,审督结合。计算机协会(ACM)的算法透明度和问责性七原则中,指出必须有监管机制。算法设计者及控制者接受监督不仅是自我澄清和保护的手段④参见张凌寒:《风险防范下算法的监督路径研究》,《交大法学》2018 年第4 期。,还将成为必然的发展趋势,应采用企业内部审核与行政外部监督的审督结合方式。

私权领域,企业有必要引入“数据保护官(DPO)”内部审核制度。欧盟《一般数据条例》对于DPO 的设置作出了强制规定,如第37 条第5款、第39 条第1 款要求由独立的具有专业素养的数据保护官监管企业内部的数据处理活动⑤《一般数据保护条例(GDPR)》第37 条第5 款:数据保护人员的指派应当给予职业能力,尤其是关于数据保护法律的专业知识以及39 条所提到的完成任务的经验和能力。《一般数据保护条例(GDPR)》第39 条第1 款:数据保护人员的任务至少包括:a)向控制者、处理者以及根据本章程或者根据其他联盟法律成员国法律规定的义务进行数据处理的人员,提出通知和建议。b)和监控本章程、其他联盟成员国法律、控制者处理者关于个人数据的相关政策(包括职责、意识提高人员培训)以及相关审计活动的合规性;c)根据35 条提出对于数据保护影响评估和监控的建议;d)和监管机构合作;e)作为监管机构与处理活动的连接点,包括36 条提到的事先咨询或者其他咨询活动。。具有专业素养的“数据保护官”负责审核数据安全,监控算法的运行状态和运行结果,并向企业提供审核建议。中国企业正在逐步适应该内审制度,如东航在2018年6月设立DPO岗位,成为国内首家设立“数据保护官”的企业,而华为公司则对此在官方回应中指出华为已任命欧盟DPO。

公权领域,建构审计监督制度。与DPO 内审制度不同,审计监督制度是依靠行政力量,对DPO审核作业的查缺补漏。由独立审计方对数据处理的政策和行为,按年度实施审计工作,保证算法运行的透明度。具体的审计内容应包含但不限于算法设计的合法性、公正性、有效性以及透明性。印度《2019年个人数据保护法》①印度《2019 年个人数据保护法》第29 条第1 款:重要数据受托者应根据本法规定,由独立数据审计方对其个人数据处理的政策和行为按年度实施审计工作。与中国2020 年10 月1 日颁布的《信息安全技术个人信息安全规范》②11.7 安全审计对个人信息控制者的要求包括:a.应对个人信息保护政策相关规程和安全措施的有效性进行审计。b.应建立自动化审计系统,监测记录个人信息处理活动。c.审计过程形成的记录应能应对安全事件的处置、应急响应和事后调查提供支撑。d.应防止非授权访问、篡改或删除审计记录。e.应及时处理审计过程中发现的个人信息违规使用、滥用等情况。f.审计记录和留存时间应符合法律法规的要求。均有制定算法审计监督机制。

第二,引入第三方制约。“算法黑箱”模糊了公私领域的界限,应考虑建立值得信赖的第三方机构。该机构对被认为歧视相关公民或组织的算法进行调查,有权强制企业对算法失误决策做出说明,维护算法公正、透明的运行。此外,算法权力监督主体,包括但不限于特定信赖的第三方机构,还可以是数据提供者、具有专业素质的相关技术组织、相关世界组织甚至算法技术自身(监督算法的算法)。例如,Google IVO 2019 开发者大会上,Google 发布的一项名为“TCAV(Testing with Concept Activation Vectors)”的新技术,是一种算法歧视纠偏技术,可以监督其他算法模型中的歧视倾向③王焕超:《如何让算法解释自己为什么“算法歧视?》,https:\finance.sina.cnstock elnewsus2019-06-13detailihvhiews8657619.d.html.D。。

3.事后救济阶段:算法可解释权与算法权力问责机制

第一,设置算法可解释权。树立可解释性为第一原则,能够最大限度提纯技术价值,是防治算法权力异化拔本塞源的不二选择。

首先,确立解释路径。从当前所使用的主流算法来看,深度学习无法做到算法的透明性,即使公布深度学习的所有代码与程式,也无法得知算法如何以及为何得出相应的结果④参见左卫民:《关于法律人工智能在中国运用前景的若干思考》,《清华法学》2018 年第2 期。。有学者主张采取反设事实解释,即仅要求算法设计者、控制者向算法决策的相对人提供影响最终决策结果的重要因素或事实⑤See Sandra Wachter,Brentmittlelstadt,Chris Russell:“Counterfactual Expanations Without Opening the Black Box:Automated Decisions and thegDPR,”.Harvard Journal of Law&Technology,Vol.31,No.2(2017).。我们赞同这种针对算法决策理由与原因的解释,原因有三:一是,算法可解释权的目标是让算法决策利益相关人知晓与其预期有偏差的决策是如何做出的,而非“祛魅”。二是,算法的源代码具备复杂性、迭代性,与普通大众之间存在无法跨越的“专业槽”,即使公开也难逃“无效信息”的劫难。三是,这种“可理解”意义上的透明,算法可解释权并不意味着对算法专利的克减⑥姜野、李拥军:《破解算法黑箱:算法解释权的功能证成与使用路径——以社会信用体系建设为场景》。。相反,无论认知成本还是技术成本,反设事实解释都以最小的代价打通了技术与法律的要道,缓解了算法可解释权与商业秘密、知识产权制度的矛盾。

其次,保证事后救济的权利。当算法决策相对人发现负面决策是由于数据错误而产生的,有权要求更正数据或退弃算法决策,转而申请人工决策。欧盟《一般数据条例》第22 条第1 款,以立法形式体现了这一确权思想⑦《一般数据保护条例(GDPR)》第22 条第1 款:数据主体有权反对此类决策,完全依靠自动化处理——包括用户画像——对数据主体做出具有法律影响或类似严重影响的决策。。

第二,算法权力的问责机制。算法可解释权的设立成为“行为——责任”法律逻辑链条的重要连接点,有必要塑构算法权力的问责机制与算法可解释权进行有机勾连。主要包括以下三个方面:

首先,扩大问责对象。一是,增加算法设计者作为问责对象。算法设计者承担算法设计责任的主要目的是确保建构性算法伦理风险评估与内审外督制度的责任回溯。具体包括确保算法设计的基础资料真实、完整、准确;对拟采用的新技术进行技术论证;进行设计成果的实验等。若有算法设计者隐瞒设计质量问题的;未规定时限完成设计整改的;拒不整改的;拒不进行算法设计实验的,从重一级问责。二是,防范公权力被“俘获”,增加行政机关及相关决策人员作为问责对象。环境治理中,环境保护机构运用预测性算法识别最有可能违反环境法治的企业。公私权界的模糊,促使很多企业成为“无辜嫌疑人”,有违“无罪推定”的法律原则,直接影响公权力决策的正义性。三是,增加算法应用方、法定代表人、相关监督部门作为问责对象。传统实体交易模式,消费者买入假货劣货时,商场要与实体销售店共同承担连带责任,而线上交易,即使因推荐性算法的误导,消费者购入假货或者劣货,电商平台只有在明知或者应当知道该情形时方为问责主体。法律上的差别对待会加剧算法权力的滥用。因此,责任有失的情况下,算法应用方、法定代表人、相关监督部门应作为追责对象,承担连带责任。

其次,问责程序正当化。正当程序原则源于对“程序正义”的追求,是建立算法问责机制的前提。根据程序正义的要求,算法问责的正当程序应当包含三个方面:一是,私权领域算法权力的运行应引入第三方作为仲裁者。作为决定程序法律结果的法律主体应当处于中立地位,对参与程序的任何一方不得存有偏见和歧视①参见周佑勇:《行政法的正当程序原则》,《中国社会科学》2004 年第4 期。。商业平台单方面制定内部申诉机制,用户处于弱势,如淘宝规则中违规申诉相关条款②《淘宝规则》第47 条:会员可在被违规处理之时起总计3—30 天不等的时间内(淘宝审核时间除外)通过线上违规申诉入口提交违规申诉申请.[2015-01-16].https://rule.taobao.com/detail-2114.htm?cId=81&tag=self。。作为决定程序结果的主体,商业平台无法提供“正义审判”。二是,算法民主即赋予算法公共决策相关利益人要求听证的权利。三是,提高程序透明度。无论是公权领域还是私权领域,算法权力对算法相关利益人具有负面影响时,算法权力的相关利益人有被告知的权利。

最后,问责标准严格化。“算法黑箱”下,法律面临最大的挑战可能在于因果关系的重构。任何领域,人类对特定事件因果关系的判定都必须接受人类认知水平和当下信息现状的束缚。可以说,因果关系的认定是一个可能性的判断过程。算法技术复杂,人类对其认知有限,加之信息不对等,无法判定因果的情况甚多,但不应影响对其问责。相反,即使无法解释算法如何产生结果,算法设计者、控制者以及算法应用方均应对其使用的算法所作出的自动化决策负责。

算法社会,人类在无知觉中步入了算法的“权力时代”。正如,人们无法否定数字化时代的存在,也无法阻止数字化时代的前进,就像人类无法对抗大自然的力量一样③[美]尼古拉·尼葛洛庞帝:《数字化生存》,胡泳、范海燕译,北京:电子工业出版社,2017 年,第299 页。。面对算法权力异化,最好的做法是追根溯源,对症下药,以法律勾勒其权力边界,防治异化。