YOLOv4交通信号灯检测

南京理工大学电子工程与光电技术学院 刘 磊

交通信号灯的在线检测与识别是无人驾驶领域中的重要研究内容,文章给出了一种基于YOLOv4的信号灯检测与识别方法,该方法以YOLOv4目标检测算法为基础,结合MoblieNetV3的特征提取网络,对算法进行轻量化处理。采用自制的信号灯数据集对该网络进行训练和测试,结果表明,文章提出的算法识别效果较好,平均准确率为89.9%,高于原YOLOv4网络的平均准确率85.6%,检测速度达到37FPS,高于原YOLOv4网络的29FPS,满足实时检测的要求。实验表明,改进后的网络模型能在保证检测准确率的同时提高检测速度,有效降低模型参数量,具有一定的应用价值。

近年来,交通信号灯的检测技术被逐步应用于无人驾驶领域,国内外很多研究人员对信号灯的检测与识别方法进行了相关研究。目前,随着深度学习技术在各行各业的广泛应用,基于深度学习的目标检测算法渐渐代替了传统的目标检测方法,已成为目前的主要检测方法。He等人设计出了SPP-net,通过区域共享卷积计算解决了R-CNN中重复计算卷积特征引起的检测速度较慢的问题。Ren等人提出了RPN网络,利用CNN来生成多种类型的候选区域,减少了网络模型的计算量。Ross Girshick参考RPN的思想,进一步提出了Faster R-CNN网络模型。Dai等人提出了R-FCN网络。R-FCN模型改进了Faster R-CNN的特征提取网络,并将ROI Pooling的位置放在了卷积层的后边。

为了进一步提高算法的检测速度,Redmon等人提出YOLO。YOLO网络能够在一次预测中得到多个目标的位置和类型,使检测速度大大提升。为了提高YOLO的精度,YOLOv2被提出。YOLOv2对卷积层进行批处理归一化,并加入锚框、多尺度训练和细粒度特征等技术,使检测精度得到提升。然而YOLOv2对于一些小尺度目标,比如交通信号灯,其检测准确率依然有较大的提升空间。为克服这一问题,在YOLOv2的基础上,YOLOv3被提出。YOLOv3使用了一种快速连接结构来提升检测准确率,并且采用了多尺度预测方法以提高对于小目标的检测效率。YOLOv4是基于YOLOv3的改进算法,对检测的速度与准确度进行了很好的平衡。

文章利用YOLOv4网络框架速度快,精度高的优点,将轻量级神经网络MobileNetV3与YOLOv4算法结合,提出一种改进的MobileNetV3-YOLO-V4交通信号灯检测算法,通过实验与YOLOv4算法经过比较,结果说明文章提出的网络结构能够在保证检测速度的同时提高识别准确度。

1 交通信号灯检测算法

1.1 YOLOv4网络结构

YOLOv4网络主要由三个部分构成,分别是主干网络、颈部网络和头部网络。其中,主干网络采用CSP与Darknet53的结合网络CSPDarknet53,CSP是一种新型主干网络,具有轻量化、精度高的优点,可以减少所需的计算成本。Darknet53是YOLOv3的主干网络,YOLOv4将CSP网络与其结合形成CSPDarknet网络。并且改进了激活函数,使用Mish激活函数最终形成了CSPDarknet53网络。颈部网络为SPP和PANet网络。SPP网络主要是负责将CSPDarknet53卷积后的特征归到同一大小。PANet网络有助于提高小目标检测的准确度。头部网络则负责最终的结果预测。

在YOLOv4网络中,为了对数据进行增强,采用了mosaic方法,首先将4张训练图像进行缩小,然后将这些图像随机组合成一张新的图像,极大地丰富了训练的数据集,与此同时在缩放的过程中为图片新增了许多小目标,提高了模型的鲁棒性。此外,YOLOv4改进了YOLOv3的损失函数,使用CIOU Loss损失函数替换原来的IOU损失函数,提高了预测框的回归速度和准确度。

1.2 特征提取层的改进

原YOLOv4模型采用CSPDarknet53网络作为特征提取网络,会使得模型整体较大,检测速度较慢,对硬件的要求较高。本文基于轻量化网络思想,采用MobilenetV3作为特征提取网络,对YOLOv4算法模型进行改进,降低网络的参数数量,提高检测效率。

MobileNetV3是在MobileNetV1和MobileNetV2基础上的改进网络。MobileNetV3结合了深度可分离卷积思想以及具有线性瓶颈的逆残差结构。此外,MobileNetV3增加了部分深度可分离卷积和SENet网络。并且使用hswish作为激活函数,减少了计算量,提高了网络整体性能。

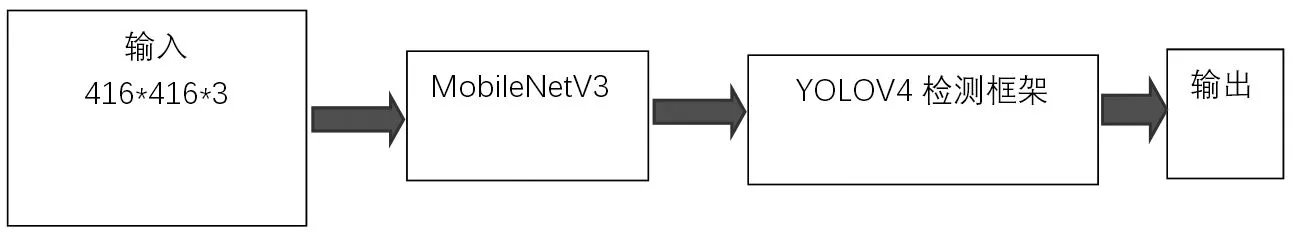

1.3 MobileNet-YOLOV4网络架构

为了将MobileNetV3网络与YOLOV4网络框架相结合,首先需要将MobileNetV3结构中最后的四层删掉,以满足尺寸衔接的要求,再与YOLOV4网络框架相结合并替换掉原来的特征提取网络,最终得到基于MobileNetV3-YOLOV4算法的目标检测模型,其结构如图1所示。

图1 MobileNetV3-YOLOV4结构

2 实验

2.1 实验环境

本实验用到GPU显卡型号为RTX2080Ti,显存为11GB,使用的编译语言和框架分别为python3.8和pytorch。操作系统为Ubuntu16.04。

2.2 数据集

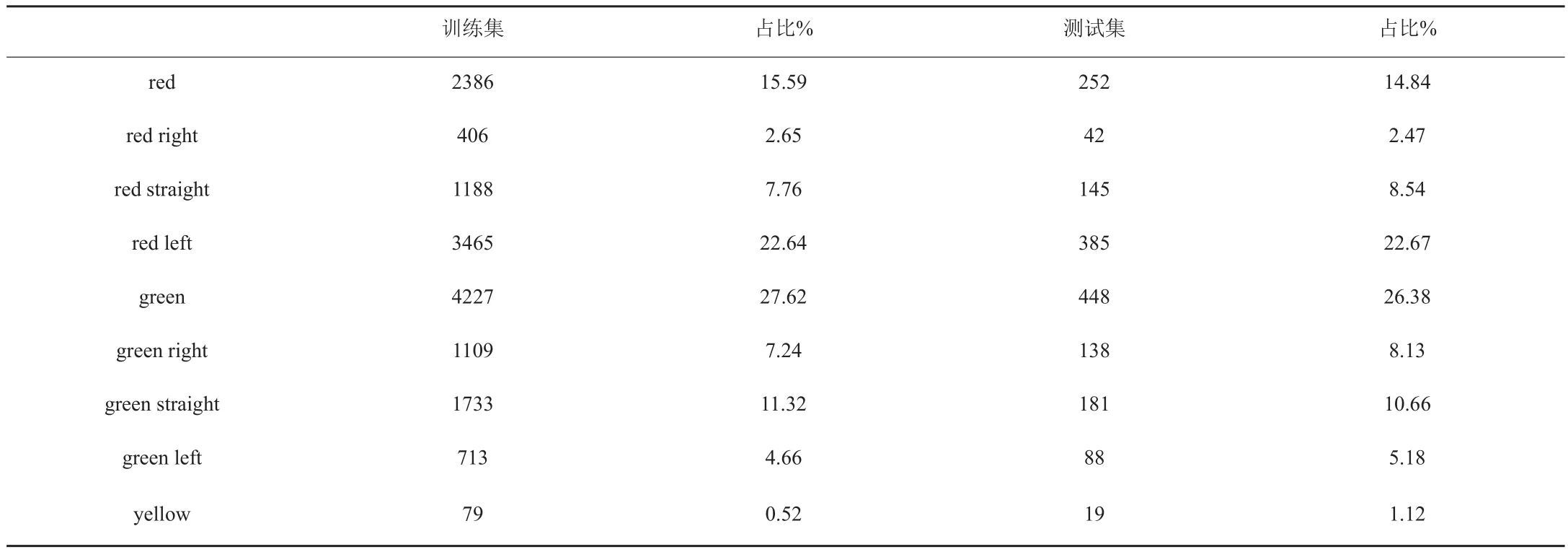

目前,国内外有关信号灯的数据集比较少,各个数据集的图片和标注差异较大。国内的信号灯数据集太少,不足以用于模型训练,国外的数据集由于地域差异,也不能直接使用。因此,本文决定采用自制的信号灯数据集。图片数据来源为通过标注采集的交通场景图像获取。数据集图片总计9800张,采集的地点城市包括:北京、上海、苏州、南京、深圳等地,包含不同场景,不同时间的交通场景数据。将采集得到的数据使用labelme软件进行标注,标注的类别为箭头和圆形交通信号灯其中圆形信号灯三类,左转箭头信号灯两类,直行箭头信号灯两类,右转箭头信号灯两类,共9类。标注完成后按照PASCALVOC数据集的格式进行存储,具体类别和数量如表1所示。

表1 自制交通信号灯数据集分布表

采用9:1的比例划分训练集和测试集,随机抽取8820张图像作为训练集,980张图像作为测试集。

2.3 评价指标

评估指标采用精度(Precision)、召回率(Recall)、平均准确率(mAP)和FPS(Frame Per Second)作为不同目标检测算法在信号灯检测任务上的评价指标。精度P=TP/(TP+FP),召回率R=TP/(TP+FN),其中TP表示真正例的样本数,FP表示假正例的样本数,FN表示假反例的样本数。准确率(AP)为PR曲线下的面积值,平均准确率(mAP)为所有目标的准确率取平均值。FPS即模型每秒内能够处理的图片数目。

2.4 实验结果与分析

实验过程中随机选取90%的数据集作为训练集进行训练,剩下的作为测试集。训练过程中设置初始学习率为0.0001,batch size设为16,总训练次数设置为100。

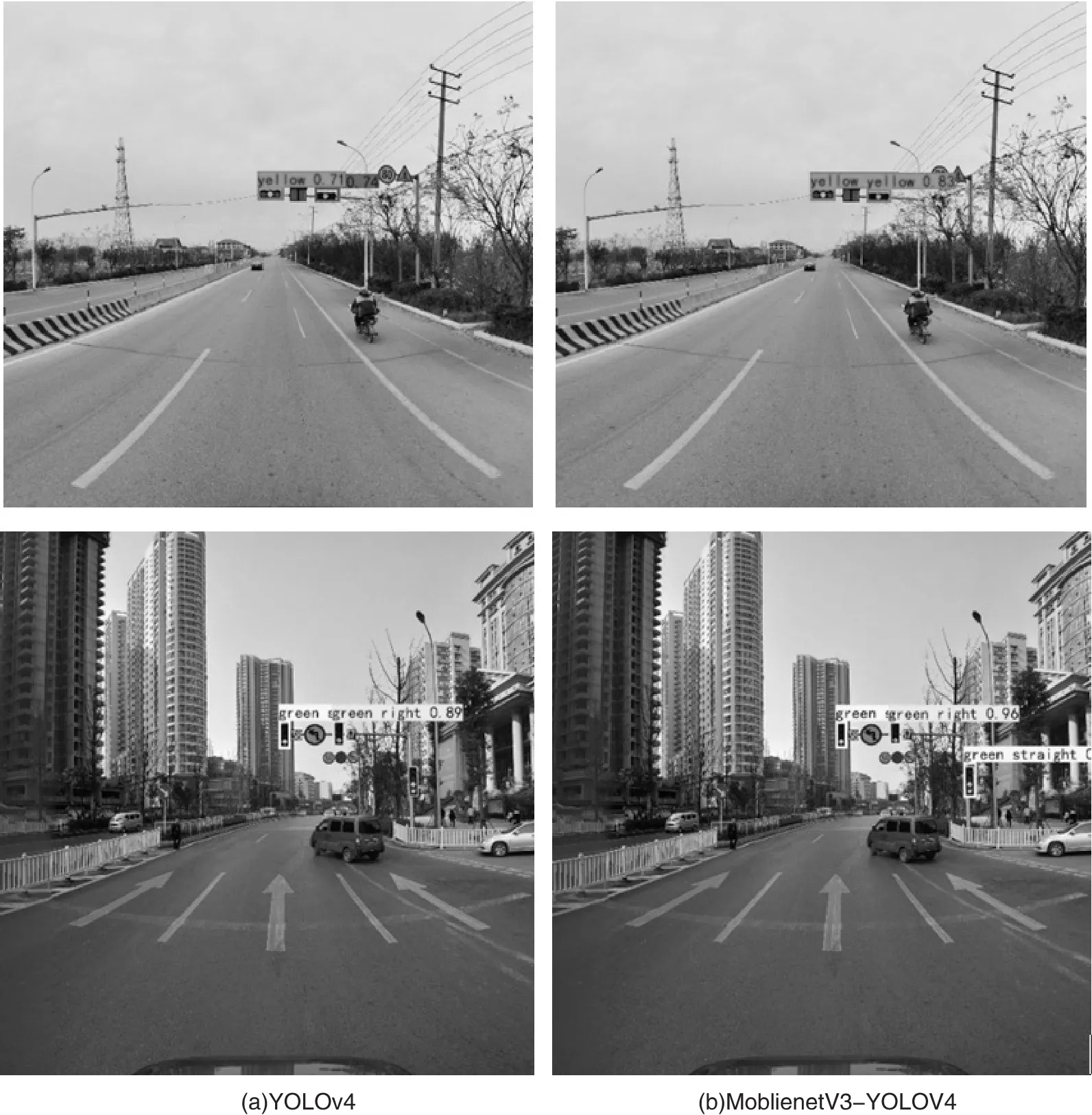

实验过程中选取了YOLOv4与MoblienetV3-YOLOV4网络进行效果对比。图2是在当前数据集下用相同方式训练相同周期的YOLOv4算法、和本文的MoblienetV3-YOLOV4算法的最终效果对比。

图2 算法效果对比图

通过比较两种算法的测试结果,原YOLOv4算法相比于MoblienetV3-YOLOV4算法对于交通信号灯的检测能力稍弱,对部分交通信号灯存在着检测错误或者检测遗漏问题,与此同时检测框对信号灯的定位相对来说不是很精确。而MoblienetV3-YOLOV4算法的检测精度则稍高一些。

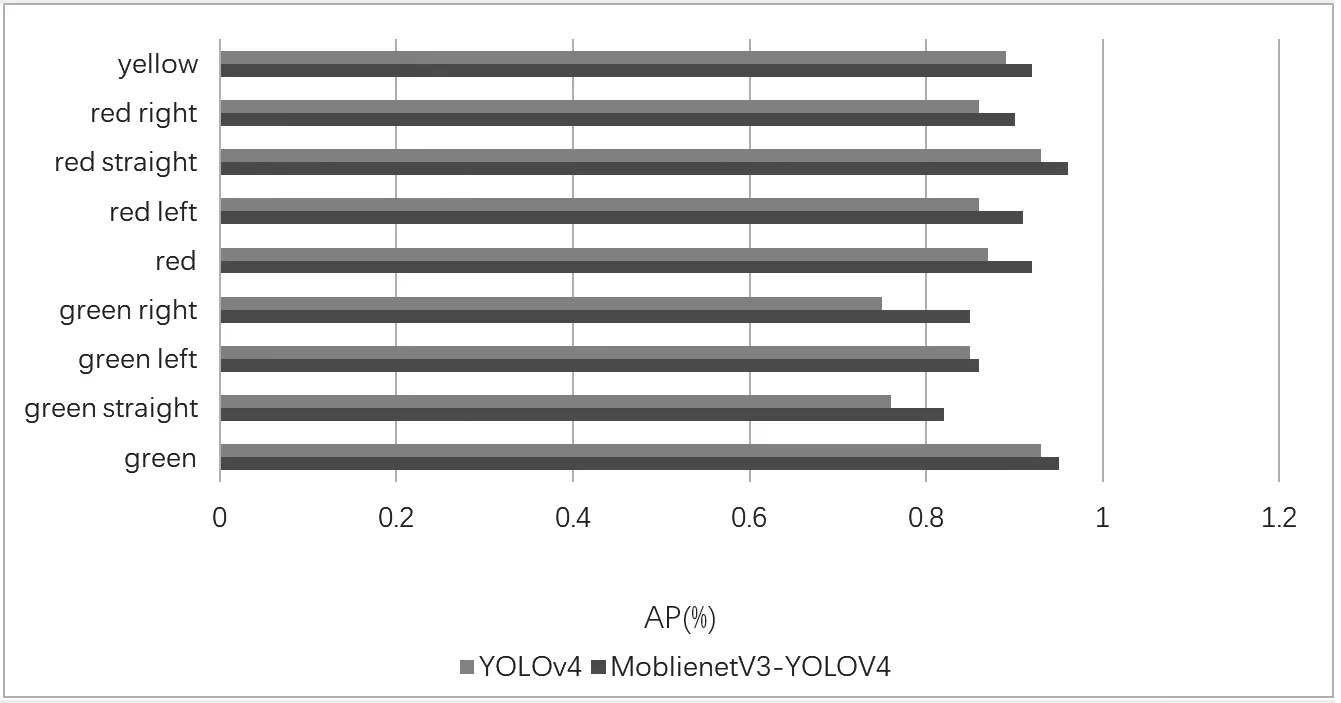

MoblienetV3-YOLOV4算法在自制的交通信号灯数据集上的Map达到89.9%,各个型号交通信号灯的mp值见图3。可以看出,MoblienetV3-YOLOV4算法对交通信号灯数据集的9种信号灯检测精度都高于YOLOv4模型。其中对红色直行箭头(red straight)类的检测准确度最高,达到96.1%,对绿色直行箭头(green straight)检测准确度稍低。

图3 具体准确率对比

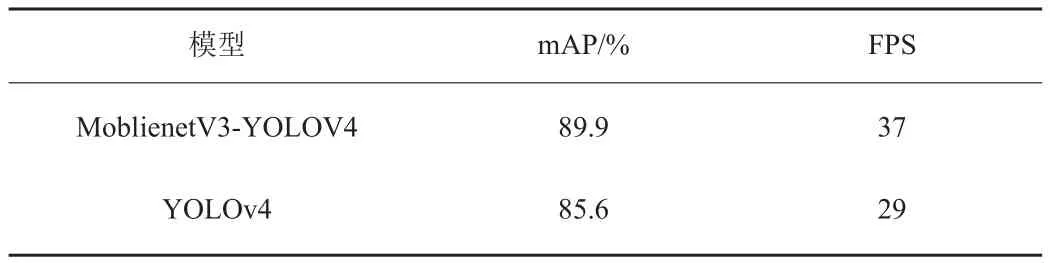

表2所示为YOLOv4算法与本文的MoblienetV3-YOLOV4算法在同一训练条件下对交通信号灯数据集进行训练的结果对比。两种算法均利用了ImageNet数据集下的预训练权重作为权重初始化方式。由表2可见,本文的MoblienetV3-YOLOV4检测算法在自制的交通信号灯数据集上的mAP达到89.90%,高于YOLOv4的85.60%。检测速度也快于YOLOv4。

表2 不同模型信号灯检测结果对比

结语:文章在YOLOv4算法基础上提出的MoblienetV3-YOLOV4交通信号灯检测算法,能够有效地对信号灯目标进行检测与识别,并通过相关实验验证了所设计网络模型的可行性及有效性,最终检测的平均准确率达到89.9%,在GPU下速度达到37fps。后续将考虑通过构建神经网络直接预测信号灯状态模块来进一步提升交通信号灯识别的准确率。