基于视频的人体状态快速识别方法研究

桑康西 祝凯 刘振宇 朱文印 王和龙

摘要:识别人体状态与理解人类情感是家电智能化的最终目的,人体许多日常行为并不携带明显的状态信息和情感倾向,而诸如跌倒、打哈欠、腰痛等出现频率较低却包含丰富的人体状态信息。以带有一定情感倾向或意图的人体状态为研究对象,从公开数据集中筛选出9种带有人体状态信息的典型行为,考虑到家居环境下实时产生的原始視频数据量庞大、存在特征冗余,提出用相邻视频帧做减法得到的RGB连续差分图像序列作为输入,鉴于样本少,使用常规大型网络容易过拟合,因此采用最新的轻量级网络模型MobileNetV2,极大减少训练参数量,进而实现快速有效的人体状态识别。研究结果表明,本方法能够达到较高的准确率,基本可以满足家居环境下的人体状态检测要求。

关键词:人体状态识别;RGB视频;卷积神经网络;MobileNetV2

中图分类号:TP391.4

文献标志码:A

文章编号:1006-1037(2021)01-0040-06

基金项目:

山东省新旧动能转换重大课题攻关项目(批准号:201905200432)资助。

通信作者:祝凯,男,博士,讲师,主要研究方向为机器视觉与人工智能。E-mail:zhu_kaicom@163.com

随着物联网的快速发展和智能家居的普及,准确高效地识别用户的行为、状态、情感、意图逐渐成为提高智慧家庭智能化水平的关键技术之一[1]。家居环境下的情绪识别归根结底是理解人的状态,推断人类意图,进而让机器做出准确回应[2]。研究表明,当人类表达情感意图时,语言信号所传达的情感信息仅占35%,而非语言信号传达的信息占比达65%[3]。非语言信号主要包括面部表情与人体行为,而实际场景中由于遮挡、偏移、光照、距离等原因导致面部特征无法准确获取和计算,因此空间尺度更大的人体动作或行为视频逐渐成为识别情感和预测意图的重要数据来源[4]。国内外学者对人体行为分类算法进行了较多研究。Bull[5]发现,部分情感与不同的身体姿势和动作有关,如兴趣或无聊,赞同或反对等。Pollick等[6]发现,一些特定的上肢手臂运动,可以辅助人类以显著高于基准水平的准确度辨别基本情感。Coulson[7]研究发现,静态身体姿势对于分类识别过程具有重要作用。Castellano等[8]提出了一种根据人体运动指标(如幅度、速度和流动性) 识别情绪的方法,通过图像序列和测试运动指标建立情绪模型。Saha等[9]使用Kinect传感器获得人体骨架数据,选取与上肢相关的11个关节,提取不同关节间的距离、角度、加速度共9个特征,并比较了集成决策树、k近邻、神经网络等分类器的分类效果。Shen等[10]用深度神经网络进行了一个探索性实验,从80个志愿者身上捕获了43 200个简单姿态的RGB视频,分别使用TSN[11]和ST-GCN[12]提取RGB特征和骨架特征,并取得一定的改进。目前在行为分类或通过人的行为推断情感上已有一定研究,主要表现在数据集的建立和分类算法上。实际上大量的人体日常行为并不能反映明显的人体状态或情感信息(比如站立、行走、喝水,只是日常行为,并不携带情感信息),而那些携带人体状态或情感信息的行为(如咳嗽、跌倒、打喷嚏等)研究的相关文献报道很少。这些行为中蕴含信息丰富,应是重点研究对象。本文以家居场景下实时监控视频数据为研究对象,从NTU RGB+D 120数据集[13]中筛选带有人体状态的样本构建成人体状态相关数据集,鉴于样本量少而特征维度过高,因此将RGB原始图像视频相邻帧做减法运算,得到RGB差分图像作为输入以减少冗余,鉴于样本少使用常规大型网络容易过拟合,因此采用MobileNetV2轻量级网络进行训练,实现人体状态的快速有效识别。

1 方法

1.1 整体框架

本文整体框架如图1。具体描述如下:

Step 1:对原始的RGB视频数据进行一系列预处理操作之后,通过前后帧相减获得RGB差分图像;

Step 2:以连续的RGB差分图像序列作为输入,采用MobileNetV2模型提取特征;

Step 3:对输入的行为状态进行分类。

1.2 RGB差分图像

对于原始RGB图像序列,通过前后帧对应像素值相减,得到RGB差分图像序列。目的是削弱图像的相似部分,突出显示图像的变化部分,极大减少特征冗余,为后续模型提供精简特征输入。

本文截取了几帧真实环境下的RGB视频原始图像及RGB差分图像,如图2。可知,在人体运动状态明显的区域,RGB差分图像都能够很好的以白色区域的形式表征出来。这是因为单帧的RGB图像只能显示出人体静态外观,缺少表征前后帧的上下文信息。而RGB差分图像,通过前后帧相减操作,可以减除无关的背景,有效保留两个连续帧之间的外观变化信息。

1.3 深度可分离卷积网络

从2016年开始,神经网络的轻量级模型取得较大进展。研究者们分别提出了SqueezeNet[14]、ShuffleNet[15]、NasNet[16]以及MobileNet系列等轻量级网络模型。这些模型使移动终端、嵌入式设备运行神经网络模型成为可能。而MobileNetV2[17]网络在轻量级神经网络中具有较高的应用。由于MobileNetV2独特的卷积方式以及内部结构优化,比经典的大型网络拥有更小的体积、更少的计算量以及较高的准确率,可在移动终端实现目标检测、目标分类、动作识别和人脸识别等应用。

MobileNetV2使用了深度可分离卷积(Depthwise Separable Convolution)。与标准卷积结构不同,深度可分离卷积是一种特别的卷积结构,将标准卷积分解为深度卷积(Depthwise Convolution)和逐点卷积(Pointwise Convolution)两个步骤,且每一层卷积之后都紧跟着批规范化和ReLU激活函数。

1.4 模型比较

相对于VGG-16、InceptionV3等大型经典网络,本模型需要训练的参数量大幅减少;与GoogleNet、MobileNetV1相比,其参数量处于同一数量级且依然少于两模型。鉴于模型在参数量的明显优势,当样本量较小时使用该模型可有效避免过拟合。

(1)深度卷积。深度卷积的卷积核尺寸为Dk×Dk×1,卷积核个数与输入数据的通道数M相对应。在常规卷积中,每个卷积核的维度与输入维度相同,每个通道单独做卷积运算再相加;深度卷积时,深度卷积核的维度为1,相当于将常规卷积核拆分成为M个具有单通道形式的卷积核,各个通道独立进行卷积运算无相加操作,可有效降低参数量的同时,也导致通道之间的信息不流畅。因此需要逐点卷积来完成卷积后的相加操作以整合不同通道的信息。

(2)逐点卷积。逐点卷积的卷积核尺寸为1×1×M,卷积核个数为输出通道数N。普通卷积将不同深度层的权重都看作为1,然后直接相加,逐点卷积则是将上一层的特征图在深度方向上进行加权组合,组合各个通道的特征图,以较少的计算量进行降维或升维操作。逐点卷积可以帮助各通道之间的信息流畅。常规卷积和深度可分离卷积结构对比如图3[18]。

(3)参数量对比。假设标准卷积的卷积核个数为N,卷积核尺寸为Dk×Dk×M,輸出特征图的尺寸为Dw×Dh,则标准卷积的计算量为Dk×Dk×M×N×Dw×Dh。深度卷积的计算量为Dk×Dk×M×Dw×Dh,逐点卷积的计算量为M×N×Dw×Dh。

因此,标准卷积与深度可分离卷积的计算量比值为

实际应用中,卷积核的个数N较大,通常所使用的是3×3的卷积核,即Dk=3时,计算量会下降到原来的1/9~1/8。同时,MobileNetV2网络还引入了线性瓶颈层和反向残差结构,能够进一步减少参数量,在空间和时间上同时优化网络。

2 实验

2.1 数据集及预处理

NTU RGB+D 120数据集[13]是在NTU RGB+D 数据集[19]的基础上扩展得到的,样本规模由原来的60个类和56 800个视频样本扩展为120个类和114 480个样本。这两个数据集都包含每个样本的 RGB 视频、深度图序列、3D骨骼数据和红外视频4种数据模态。NTU RGB+D 120数据集包括日常行为、医疗相关行为和交互行为三大类。数据集所包含的大量日常动作(如喝水、站立等)并不具有明显的情感倾向或意图,从中筛选了9个与医疗相关的部分行为状态作为研究对象,所选样本视频共432个,其中75%作为训练样本,25%作为测试样本。分别为:咳嗽、摇晃、跌倒、头痛、打哈欠、背痛、脖子痛、呕吐、扇扇子。从数据库中截取的几类视频示例如图4所示。

考虑到数据样本较少,为增加训练的数据量,防止过拟合,提高模型的泛化能力,可以使用数据增强方法来扩充数据量。选择旋转、平移、水平翻转、缩放4种增强方式,对于每帧图像随机选择2~4种增强方式。由于RGB图像的像素值在0~255之间,本文对图像进行归一化处理,使图像的像素值转化为 0~1 之间分布的数据。通过归一化的方法,可以有效防止仿射变换的影响,减小集合变换的影响,同时加快梯度下降求最优解的速度。

2.2 结果与分析

实验使用的CNN是MobileNetV2网络,其权值已在ImageNet预训练。输入MobileNetV2网络的数据维度为(8,224,224,3),即每个视频随机选取8帧,每帧图像的像素值为224×224,通道数为3。从MobileNetV2网络输出的数据经过平均池化,再输入LSTM,其后面又添加3个全连接层(dense层),每层节点个数分别是64、24、9,每层的dropout值为0.5。最后一层使用softmax函数分类并输出结果。

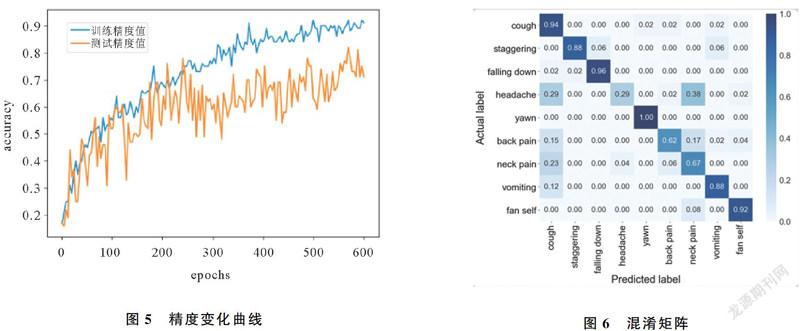

本模型在网络训练过程中,使用随机梯度下降算法和交叉熵损失函数,以精度作为衡量指标。实验采用TensorFlow框架,Python3.6版本,在配有Geforce RTX 2060的Windows10系统上运行。batch-size设置为4,epoch设为600。最终平均测试精度达到80.7%,精度变化曲线和混淆矩阵分别见图5、图6。

由图5可知,随着训练批次epoch的增加,训练精度和测试精度都逐渐上升。当训练批次达到350左右,训练精度和测试精度逐渐趋于稳定,精度值分别上升至85%、75%。在训练阶段后期,训练精度已接近90%,测试精度在80%左右。

图6是经网络模型预测出能反映人体状态类别的混淆矩阵,由图可见,打哈欠、跌倒、咳嗽、和扇扇子4类动作状态的识别精度最好,准确率均超过90%,背痛、脖子痛两类动作状态的识别效果稍差,精度在70%左右;头痛样本的识别精度不足30%,观察第四行可知,大量的头痛标签样本被错误识别为咳嗽或脖子痛。由混淆矩阵第一列数据可知,识别准确率最低的三类动作有一个共同点,即在相当程度上都被错误识别为咳嗽。分析认为,这几个动作基本都涉及到手部与头部的组合动作,特征具有较高的相似性,神经网络未能学习到动作间的细微差别,应是识别错误的主因;总样本量为432,样本量少也是导致模型未能充分挖掘特征的另一个重要原因。

根据图7所示的咳嗽和头痛两种动作的图像序列对比可以看出,这两类动作相似程度较高,即使人眼也容易造成误判。

3 结论

RGB差分图像相对于RGB图像,能更好获得帧序列间的动态变化信息,以RGB差分图像作为输入,使用CNN和LSTM的动作识别方法,具体以MobileNetV2和LSTM构建网络模型,分别提取空间信息和时间信息。并结合NTU数据集中9类有关人体状态的动作进行识别,大部分动作的识别精度在80%以上。由于识别准确率不高的动作比较集中,主要涉及到手部与头部等两个身体部位的动作组合,下一步可专门对这些动作进行细致研究,并制作专门的人体状态视频数据集,或对本文算法进行改进,提高识别准确率。

參考文献

[1]邬晶晶. 基于深度学习的情绪识别技术[M].北京:中国科学院大学(中国科学院深圳先进技术研究院),2020.

[2]KLEINSMITH A, BIANCHI-BERTHOUZE N. Affective body expression perception and recognition: a survey[J]. IEEE Trans on Affective Computing, 2013, 4(1) : 15-33.

[3]ELMAN J. Encyclopedia of language and Linguistics[M]. 2nd ed. Oxford: Elsevier, 2005

[4]GELDER D. Why bodies? Twelve reasons for including bodily expressions in affective neuroscience[J]. Philosophical Transactions of the Royal Society B: Biological Sciences, 2009, 364(1535): 3475-3484.

[5]BULL P. Posture & gesture[M]. Amsterdam: Elsevier, 2016

[6]POLLICK F, PATERSON H, BRUDERLIN A, et al. Perceiving affect from arm movement[J]. Cognition, 2001, 82(2): B51-B61

[7]COULSON M. Attributing emotion to static body postures: Recognition accuracy, confusions, and viewpoint dependence[J]. Journal of Nonverbal Behavior, 2004, 28(2): 117-139

[8]CASTELLANO G, VILLALBA S, CAMURRI A. Recognising human emotions from body movement and gesture dynamics[C]// Proc. of International Conference on Affective Computing and Intelligent Interaction.Berlin,2007: 71-82.

[9]SAHA S, DATTA S, KONAR A, et al. A study on emotion recognition from body gestures using Kinect sensor[C]// 2014 International Conference on Communication and Signal Processing. Melmaruvathur, 2014: 56-60.

[10]SHEN Z, CHEN J, HU X, et al. Emotion recognition based on multi-view body gestures[C]// 2019 IEEE International Conference on Image Processing (ICIP). Taipei, 2019: 3317-3321.

[11]WANG L, XIONG Y, WANG Z, et al. Temporal segment networks for action recognition in videos[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 41(11): 2740-2755.

[12]YAN S, XIONG Y, LIN D. Spatial temporal graph convolutional networks for skeleton-based action recognition[C]// AAAI Conference on Artificial Intelligence, New Orleans, 2018:7444-7452.

[13]LIU J, SHAHROUDY A, PEREZ M, et al. NTU RGB+D 120: A large-scale benchmark for 3D human activity understanding[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence (TPAMI), 2019,42(10): 2684-2701.

[14]FORREST N, SONG H, MATTHEW W, et al. Squeezenet: Alexnet-level accuracy with 50x fewer parameters and <0.5 MB model size[J/OL]. [2020-09-21]. http://arxiv.org/abs/1602.07360.

[15]ZHANG Z, ZHOU X, LIN M, et al. Shufflenet: An extremely efficient convolutional neural network for mobile devices[C]// IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Salt Lake City, 2018: 6848-6856.

[16]ZOPH B, VASUDEVAN V, SHLENS J, et al. Learning transferable architectures for scalable image recognition[C]// IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Salt Lake City, 2018: 8697-8710.

[17]SANDLER M, HOWARD A, ZHU M, et al. MobileNetV2: Inverted residuals and linear bottlenecks[C]// IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Salt Lake City, 2018: 4510-4520.

[18]HOWARD A, ZHU M, CHEN B, et al. MobileNets: Efficient convolutional neural networks for mobile vision applications. [J/OB] [2020-09-11].http://arxiv.org/abs/1704.04861.

[19]HOWARD A, ZHU M L, CHEN B, et al. NTU RGB+D: A large scale dataset for 3D human activity analysis[C]// IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas, 2016:1010-1019.