附着与隧通

蔡恒进 蔡天琪

[摘 要] 深度学习框架加速了人工智能技术的发展,越来越多的人工智能系统在专业领域超越人类,但沿此路径能否指引机器模拟出类人智能仍然没有定论。强计算主义的观点主张意识和智能可以被物理还原,甚至可以忽略意识。哥德尔等学者则倾向于机器无法模拟或超越人类。文章提出认知坎陷(意识片段)的“附着”与“隧通”这一对范畴,从新的视角探讨心智的工作模式。认知坎陷具有超越时空和流变的特性,在某时某地某景可以“附着”在某个具体对象之上。认知坎陷之间可以通过“隧通”链接成一个网络。“自我”作为最原初和最重要的认知坎陷,是人类意识与智能的发端。智能的作用之一是在情景改变时将“自我”“附着”到更合适的对象上。

[关键词] 意识;强人工智能;图灵机;认知坎陷

[中图分类号] B152 [文献标识码] A [文章编号] 1008—1763(2021)04—0122—07

Abstract:Deep learning framework accelerates the development of Artificial Intelligence. More and more AI systems have surpassed human beings in professional fields, but whether this path can lead machines to simulate human-like intelligence remains unclear. Strong Computationalism asserts that consciousness and intelligence can be physically reduced and that consciousness can even be eliminated, while other scholars like Godel tend to believe that machines cannot emulate or surpass humans. This paper proposes a pair of categories of bandwagoning and tunneling of cognitive attractors or consciousness fragments to explore the working mode of the mind from a new perspective. Cognitive attractors or consciousness fragments are beyond time and space, but at a certain point of time and space, a cognitive attractor can bandwagon to a specific object. Cognitive attractors can be tunneled with each other into a network. As the most primitive and important cognitive attractor, Self is the origin of human consciousness and intelligence. One function of intelligence is to tunnel Self to appropriate objects when situations change.

Key words: consciousness; strong AI; Turing machine; cognitive attractor

一 引 言

人工智能(Artificial Intelligence,AI)于1956年被首次提出以来,已经出现了许多表现出超强机器智能的AI系统。深度学习框架大幅提升了AI的能力。例如,面部识别技术已经广泛应用于个人支付,DeepFake等系统创造了一批批以假乱真的图片与视频。AI在文学创作、电子竞技等开放领域也有出色表现。2020年人工智能大会开幕式上,百度小度、小米小爱、B站泠鸢、微软小冰四位虚拟歌手领唱了大会主题曲,意味着AI可能很快能创作出被人们欣赏、广泛流行的音乐作品。

AI已经在很多专业领域超越了人类。例如,战胜了人类冠军棋手而名声大噪的AlphaGo已经发展到第四代MuZero[1],其表现力不仅超越了前面三代,而且能在未知任何人类知识以及规则的情况下,通过分析环境和未知条件来进行不同游戏的博弈。蛋白质的折叠空间预测是一个很难的科研问题,在近两届CASP(The Critical Assessment of Protein Structure Prediction,蛋白质结构预测的关键评估)上大获成功的AlphaFold和进化版本的AlphaFold2[2]在此问题上已经展现出了超高的水平。按照给定的评分标准,最优秀的人类专家团队只能达到三十多分,AlphaFold2却可以达到九十分,接近直接应用的水准。

即便如此,通用的超级人工智能何时到来,目前还不可预知。有学者

在1977年一次会议上,约翰·麦卡锡(John McCarthy)指出,創建这样一台机器需要“概念上的突破”,因为“你想要的是1.7个爱因斯坦和0.3个曼哈顿计划,而你首先要的是爱因斯坦……我相信这需要5到500年的时间。”参见https://www.nytimes.com/1977/08/27/archives/man and machine match minds at mit 5th conference on artificial.html提出,要在理论上突破可能还需要5到500年的时间。作为AlphaGo系列和AlphaFold系列的创造者,DeepMind认为自己研发的就是AGI(Artificial General Intelligence,通用人工智能),图灵奖得主辛顿(Hinton)[3]也倾向于将自己的研究归属到AGI。深度学习系统普遍存在的不可解释性、可迁移性较差和鲁棒性较弱的问题,一直是AI研究与开发的重点之一。

中国工程院院士、中国人工智能学会名誉理事长李德毅[4]指出,脑认知的三个内涵在于记忆认知、计算认知和交互认知。他认为,脑认知的核心是记忆认知,是人类智能的显著表现。记忆不是简单的存储,还伴随有一定的取舍,取舍就是计算、简约和抽象的过程。计算认知中,计算机做的算法很多,而人脑只有一个计算方法——相似计算。交互认知具有二重性,既有神经网络内部的交互,也有大脑通过感知系统与外部世界的交互。

中国科学院院士、清华大学人工智能研究院院长张钹[5]指出,人工智能经历了两种发展范式,即符号主义和连接主义(或称联结主义),分别称之为第一代和第二代人工智能。目前这两种范式发展都遇到了瓶颈:符号主义影响的第一代AI具有一定程度的可解释性,能模仿理性智能,但不能随机应变,无法解决不确定问题;以深度学习为代表的第二代AI使用门槛较低,能够处理大数据,极大推动了AI应用,但具有不可解释、易受攻击、不易推广和需要样本量巨大等负面特点。

从认知科学的角度切入AI的研发,可能触及到悬而未决的意识问题,这里一直是认知科学和AI交叉领域的研究热点,但是进展却是相当地不明显。

1988 年,科学家们首次发现了意识的实验证据(FMRI evidences),随后人们从不同领域(比如神经科学、哲学、计算机等)开展了对意识的研究。很多人认为机器没有意识、没有情感、没有思维,也不可能具备像人一样的高级智能,实际上也许并非如此。意识的功能之一是从长期记忆里提取短期记忆内容。人的长期记忆可能处于无意识状态,其数量十分庞大。短期记忆是大家都可以意识到的,但可能只有几个字节。意识需要根据当下的任务和情景,尽可能快地把最相关的因子提取出来。全局工作空间理论[6](Global Workspace Theory,GWT)迅速把长期记忆的关键因素抽取到工作内存里。在GWT的基础上,图灵奖得主布卢姆(Blum)进一步提出了“有意识的图灵机”[7]。在这套理论中,虽然机器对情感的处理方式与人不一样,但仍然能够包含机器的“愉悦”“痛苦”等因素,并假定机器已经能拥有这些情感。AlphaGo等AI用到了强化学习机制[8],这种奖励回馈机制也已经与情感有关系。

二 超越经典图灵机

图灵命题可以描述为:功能强大的计算机将会体现出智能,这是图灵为智能提出的一个充分不必要条件。丘奇-图灵(Church-Turing)论题[9]可以理解为,每一个可计算的函数可被一个通用图灵机所计算。丘奇-图灵论题讨论的对象是递归函数,但是并不涉及完成这些计算过程的物理系统或物理装置。1985年,英国物理学家多伊奇(Deutsch)首次把丘奇-图灵论题与实施计算过程的物理系统联系起来。他注意到,任何计算过程都是在一定的物理系统上进行的,亦即必须服从物理定律,于是得到丘奇-图灵-多伊奇命题(Church-Turing-Deutsch)论题[10],即每一个物理系统的过程都能被一个通用图灵机计算或模拟。该命题是强计算主义的代表,而强计算主义主张包括人类意识在内的一切内容都是可计算的。按照这类思路,就会推论得到意识并不重要,甚至是一种幻觉,因为意识是随附性的,可以被完全还原为物理过程,可以被完整计算,而计算又是图灵等价的。

另一类观点则是机器无法超越人类。哥德尔认为,人具有超越图灵机的东西。哥德尔不完备定理表明:任何一个形式系统,只要包括了简单的初等数论描述,而且是自洽的,它必定包含某些系统内所允许的方法既不能证明为真也不能证伪的命题。图灵曾经提出,人与机器的差别在于人会犯错

Hodges曾总结:“图灵指出了一个重要的事实:人类数学家很容易犯错。他认为,要让一台计算机真正具有智能,就必须允许它犯错误。”(Turing made a great point of the fact that human mathematicians are very capable of making mistakes; he argued that for a computer to be able to be genuinely intelligent, it, also, would have to be allowed to make mistakes.)参见A. P. Hodges (1983) Alan Turing: the enigma. Burnett Books and Hutchinson, London; Simon and Schuster, New York. p. 361. 以及Turings 1947 lecture to the London Mathematical Society in Turing (1986).,并提出了超级机器的范式O-machine[11]。一个O-machine由一个经典图灵机(有限的状态集和转换集)和一个Oracle(预言机,可能是无限的数字集)组合而成。经典图灵机存在“停机问题”,即判断任意一个程序是否会在有限的时间之内结束运行的问题。如果这个问题可以在有限的时间之内解决,则有一个程序判断其本身是否会停机并做出相反的行为,这时候显然不管停机问题的结果是什么都不會符合要求。所以,这是一个不可解的问题。而在现实中,任何一个人一定会“停机”(生命消亡),任何一台计算机也一定会停机(硬件老化等原因),人和机器在这个意义上就是超越经典图灵机的。O-machine也超越了经典图灵机,“错”就是一种“神谕”(Oracle)。计算机会犯错较为常见,比如指令执行有误,或者是数据存储不完整,又或是寻址发生异常等,这些错误的发生就会导致中断甚至系统崩溃(停机)。

“人会犯错”可以理解为人具有认知坎陷。在此前的研究[12]中,我们给出了认知坎陷(cognitive attractor)的定义,即在认知主体之间可用来交流、能够达成共识的一个结构体。认知坎陷是对真实物理世界的扰乱,也是人类自由意志的体现。也就是说,相对于客观的物理系统而言,认知坎陷作为人类的主观建构就是一种“错”或者偏差。

触觉大脑假说[13]给出了意识的起源,其主要内容是:人类进化过程中所获得的敏感触觉使得认知主体可以将世界清晰地剖分并封装成“自我”与“外界”的二元模型,人类以此(原意识)为起点,开启对世界概念化的认知过程,逐渐形成可理解的信念和价值体系,进一步确立“自我”在认知上的“实存”。触觉大脑假说可以视为认知坎陷第零定律,定义了“自我”的由来,人类的意识世界或者坎陷世界由此打开。

人类经过千万年的进化,具有统摄性的自我意识,以及对宇宙的整全意识。由人类设计制造的机器仅具备由人类赋予的各种意识片段,尚缺少统摄性的、强烈的关于“自我”的意识,也不具备对宇宙的整全意识。这是目前人类智能与人工智能之间的本质差异所在。把计算机的主程序看作是一种微弱的“自我”并在这一层面进行探索,有可能找到融合上述人机智能差异的途径。

在AI三大流派[14]中,符号主义主张严格从公理出发来演绎系统,其理念与经典图灵机等价。根据哥德尔不完备定理,公理系统是有限制的,因此符号主义的AI归属于弱人工智能范畴。而行为主义和联结主义因为与外界有交互,既没有预设所有的程序,或者可以接收新数据输入,也没有公理系统的限制,所以超越了经典图灵机。

会出错的、非理想的计算机反而会超越经典图灵机,也因此有可能在现实的计算机上构建出超越经典图灵机的意识与智能,或者说让机器获得发现、加工和运用认知坎陷的能力。

三 认知坎陷的“附着”与“隧通”

“自我”作为最原初、最重要的认知坎陷,所指代的含义既可以是无穷多的,在某一个场景下又可以是有限的。比如,“我”可以是自己的名字、形象、声音、观点、作品等,其中每一个侧面又可以包含更多细节,内容甚至可以无穷丰富;如果在讨论某一张合影,我们说的“我”就会很具体地指向这张照片中一个人的形象。

认知坎陷这种看似矛盾的关系,如果放在机器上应该如何处理呢?

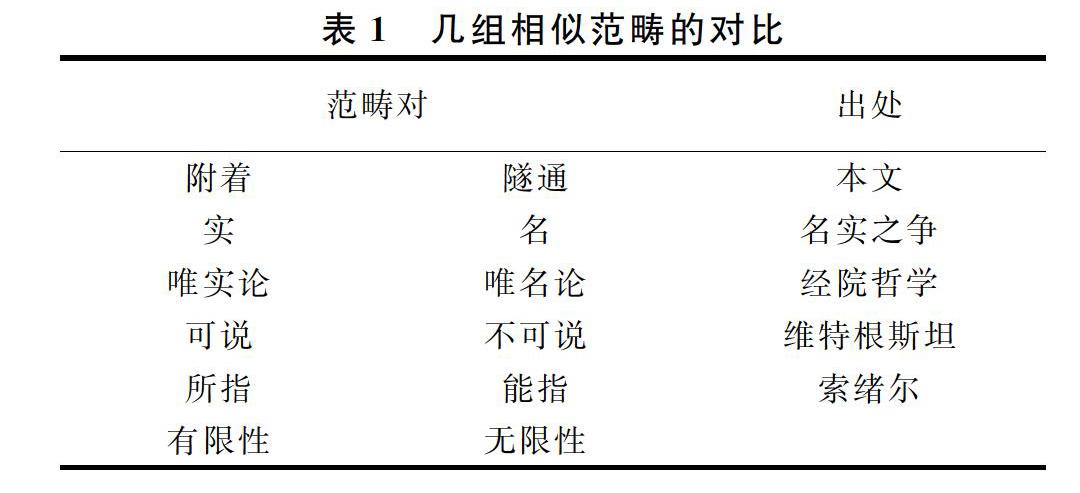

为此,我们提出一对新的范畴——“附着”和“隧通”。这对范畴就可以决定如何在机器上落地实现看似抽象的内容。附着相对容易理解 奎因说:“本质脱离物而依附词时成为意义。”斯宾诺莎说:“一切规定都是否定。智能的忽略,也就等于使焦点周围的其他所有的点都处于遮蔽状态中。”这些给我们定义认知坎陷的“附着”以启发。,是指一个认知坎陷在具体时空和场景下选择某一个侧面来表达。隧通,则是指在不同认知坎陷之间或者相同认知坎陷的不同侧面之间关系的建立。隧通可以是因果关系的建立[15],也可以是类比、对比、否定、假借等关系的构建,即隧通比建立因果关系要更加普遍。隧通的一个极致状态是德勒兹讲到的蔓延[16],他主张的认知或者概念是生成的且无边界的。但通常而言,隧通是通过一个优化的、较短的路径来实现的。表1中列出了几组相关概念,用来对照理解。

中国哲学史和逻辑思想史上的“名实之辩”是对名实关系的研究

春秋时期,“名实相怨”,邓析苜先作《刑名》一书并提出“按实定名”“循名责实”的主张。孔子以为“名不正则言不顺,言不顺则事不成”(《论语·子路》),主张按周礼等级名分来纠正“礼乐不兴”“刑罚不中”。墨子提出“取实予名”“非以其名也,亦以其取也”(《墨子·贵义》)。后期墨家对名实关系详细分析,认为“所以谓,名也;所谓,实也”(《经说上》)。“有实也,而后谓之;无实也,是无谓也。”(《经说上》)名的作用在于“拟实”“举实”,若名不符实就会产生错误,“过名也,说在宾”(《经下》)。,“实”可以理解为物理世界,“名”可以理解为语言概念。概念具有“内涵”和“外延”两个部分,内涵是相对容易解释清楚的,而外延就可能是无穷的。维特根斯坦提到的“可说”与“不可说”,索绪尔的“所指”与“能指”,隐喻与其背后的含义等这些范畴,分别体现了有限与无限的特性。这些可以与“附着”与“隧通”进行对照来理解。无限和有限之间看似存在着巨大矛盾,但在很多场景中,人类恰恰可以将认知中无穷的内容“附着”在微观、具象的内容上。比如说“我们的生活比蜜甜”,就是把一个无限的内容(生活)附着在一个很具体的事物(蜜)上。

意识片段(或认知坎陷)是超越时空的,不仅仅是只出现在一个时间点上,因而其内容可以是无穷丰富的。传统的理论倾向于假定有一个实体化的、理想的“点”,例如康德的“物自体”、柏拉图的“理念”,都有实体化的意味,但其实遇到的意识片段大都不是实体化的。意识片段在时间上既有连续性又有跳跃性。可以用一个符号去指代某个意识片段,只是这个符号不太可能将意识片段完整地重构出來。

这种“附着”非常重要,可以用来理解“自我”等认知坎陷所具备的不同侧面。“自我”虽然可以指代无穷多的含义,但是在具体的场景下,“自我”依然可以具象。有时候是自己的外形,有时候是对应在某一个时刻场景下的我,有时候可能只是一个名字,有时甚至是自己建构的观念……,这些都是“自我”可能附着的具象。在很多人心目中,李小龙可能是附着在他身穿黄黑色运动服、手持双截棍的经典形象上。普通社交之间,对不同人的认知可能就附着在这个人的名字上。不同的人或者同一个人在不同情形下,一个认知坎陷的“附着”都可能发生变化,但“附着”都提供了将无限压缩或投射到有限的功能。

意识片段或认知坎陷只有“附着”还不够,在不同的场景下,还要将意识片段不同的面向挖掘出来,这就是“隧通”的作用。比如,病毒附着在RNA上,但一旦放入细胞或者适宜环境,病毒就可以感染和复制,在不同的环境中进行相应的表达,这就是一种隧通。换句话说,无穷多的内容先附着在具象上,然后通过这个具象又可以隧通到背后相关联的多个面向,彼此可达。任何认知坎陷(包括信念等),都可以被附着和隧通,二者对应了学习过程里的“约”和“博” [14]。写作和阅读也是一直在附着和隧通,在博与约之间不断转换。高级智能就意味着能灵活处理这类博约的问题。

人的脑容量是有限的,例如有理论说人最多可同时处理7个左右的念头[17]。物理世界却是无限的。现实中有的人就拥有很强的理解能力与认知能力,似乎在任何场景中都能得心应手,其中的关键就在于他们能够快速地找到适合的附着之处,或者说能自如地隧通。对大多数人而言,附着并不是难题,但如何隧通、如何更好地适应新场景,则不是简单的问题,也体现了个体之间不同的智能水平。附着之处还是有好坏之分的,有人附着在“自我”、宗教信仰,有人关注身体状态,有人关注自己过去的遭遇,有人附着在对未来的美好期待,等等。除了附着本身的好坏之外,还要看主体附着之后是否能更好地适应新场景,适应性更强的附着之处往往更优。

四 具备“理解”能力的人工智能

爱因斯坦说:“世界上最不可思议的事情,就是这个世界是可以思议的。”柏拉图坚信“理念世界”的存在性。康德认为,将经验转化为知识的理性(即“范畴”),是人与生俱来的,没有先天的范畴我们就无法理解世界。

在附著与隧通的基础上,可以将“理解”定义为主体能够将某一个对象“隧通”到“自我”。理解的过程可以看作是主体的“自我”与对象的相遇。这种相遇并不是简单的降射,而是通过相遇可能产生新的内容。在此过程中,“自我”不会整体都发生变化,但经过相遇,与客体认知坎陷交互的过程中会发生信息交换,“自我”在吸收过滤了新的内容后,在局部上很可能会发生变化。

一个由认知坎陷所有侧面的关键词(也是认知坎陷)构成的网络,可以作为认知坎陷的知识本底。我们过去所谓的“理解”,其实是完美的理想,即对本底的理解是精确的。但实际上的理解是有损的、呈金字塔结构的交互,每一次相遇都是上下层之间的重构,成为新的网络。每个主体的坎陷世界都不尽相同,加之认知主体会受到主观和信息处理能力的限制,其认知不会是、也不可能是完整的,也有可能两个认知坎陷完全没有办法自如地隧通,表现为不理解甚至矛盾冲突。理想化的理解应该是对客体认知坎陷的所有侧面都能自如隧通到“自我”,现实中只存在部分的隧通。

虽然理解过程描述起来有些复杂,但实践起来却可以很简单。在对理解的度量方式上,使用相对度量、能够进行比较就足够了,因为做最终的判断是需要额外的信息的。人类的理解机制是开放的,与外界是息息相关的。这种开放性就与图灵机的机制显著不同:图灵机是一个封闭的环境,需要提供给定的各个条件或规则,而人类的理解则是不确定、不完整的,当外界因素(比如有待理解的对象)发生变化时,内部(坎陷世界)也在改变。

虽然事物是客观存在的,但我们不可能了解到物理世界的全部,或者说不可能开启“上帝视角”,而一定是站在某种角度去理解世界。用“上帝视角”去思考人工智能的问题,甚至是主观世界的问题,实际上会陷入瓶颈。我们真正要突破的是无限与有限之间的矛盾。

过去以为客观世界是可以被反映的,但其实客观世界是无穷的,是不可能被完美地反映的。对人而言,不完美的反映是可以接受的,只要抓住一个侧面或者子集,捕获某些特征就足够人类与世界交互。一方面,不同事物的主要特征不断变化,在不同时间、不同场景下,所体现的面向或所附着之处是不一样的;另一方面,每个人的经历不同,认知水平不同,甚至是身体状态不同,就算处在相同的时间和相同的场景下,对同一个事物的理解也可能不同。这些不同点放在机器学习中就起到了启发作用。

对机器而言,在相同时间和场景下捕获的特征理论上是完全一样的,而主观世界的形成则是多样性的。理论上说,机器以后也会朝着多样性的方向发展,当机器面对相同环境能够捕获出不同特征的时候,机器就有可能像人一样思考与理解,形成自己的坎陷世界。

在模拟实验中,完全随机性代表的是智能为零的基准。当主体具有某种偏好或者信念(相当于具有Oracle),有可能是智能为正(更快地达到目的),但也有可能是智能为负(陷入死循环或者暗无限[18])。在反思“自我”的时候会尽量地包罗很多因素,认为“自我”就是这个无穷大的集合。但在具体的实际场景下,“自我”是很单纯地附着在某些具体的面向上。在机器学习上,例如让模型识别ImageNet,实际上是要求机器识别其中所有的内容,包括再来一张新图片,也期望机器按照ImageNet训练的方式去识别去分类。从这个意义上看,就是要求机器识别整全的、包罗万象的内容。但如果从主观世界形成的角度来看,恰恰是不需要这样,而是识别特点,对同一个坎陷建立不同的面向,根据场景不同来隧通,附着到相应的面向上。

人们长久以来希望找到某个涵盖一切的、完整不变的东西来指代人类意识与智能本质,但恰恰人类认知是不完整的才更合理,效率才更高,因为物理世界包含无穷的可能性,我们不可能全部习得,只能够也只需要接触到个体能够捕获的有限特征就足够了。如果按照“丘奇-图灵-多伊奇命题”的强计算主义观点,所有的物理系统是图灵等价的,那么智能将无从谈起,也将无处着手。强调智能与意识、自我意识密切相关,正是因为由认知坎陷将人的认知偏离客观的物理系统,才有智能,反之对物理世界的完整反映与存储恰恰意味着没有智能。计算机的主程序可以看作是一种微弱的“我”。以此为基础,人工智能就有可能取得突破性的进展。

“活泼性”(vivacity)概念是休谟人性理论中一个重要概念。它既是感觉、记忆和知性的基础,又是判断、情感等心灵(或心智、意识)活动的主要驱动力。活泼性并非仅属于客体或仅属于主体的、与意识本身或意识对象割裂的个别的性质,而是意识对象所具有的特定性质与意识本身的特定能力之间互动的结果。在休谟的心灵模型中,心灵所呈现出的性质和所做的活动,既不是对自然的简单记录,也不仅仅是心灵主体结构的直接呈现,而是本身带有一定性质和能力的主体与自然互动、交融后形成的“第二自然”[19]。

休谟的心灵模型为我们模拟心智的工作模式提供了启发,为了模拟实现自如地隧通,模拟大脑中分布式的存储和多元的刺激(比如有正向信号、抑制信号、信号叠加等),可以设计出一套对多元化刺激的响应机制,最后能够得出可解释的响应结果。心智工作模型可以是一个分布式系统,机器拥有很多节点,不同节点具有不同的专业特点,用于感知、捕获特征,并以通证(Token)的形式从小范围开始交互并达成共识。通证实际上对应了人类意识世界的认知坎陷,也是休谟心灵模型中的“活泼性”,不同节点之间通过多元化的通证交换等方式来交互。由于不同节点的侧重点不一样,那么就有可能不同节点捕获到不同特征,从机器整体来看,就会有不同的“念头”先后冒出来。

五 总结与讨论

传统的特征工程是预设一个绝对正确的理念引导机器去抓取特征,而认知坎陷的“附着”与“隧通”主张没有恒定不变的本质,而是在动态演化的过程中抓取特征,特征附着在不同侧面,与外界进行交互、相遇和沉淀,认知坎陷因此得以不断进化。我们既不认为机器的意识与智能可以排除人的作用,也不认为机器无法模拟人或者达不到人类水平,而是从认知坎陷的“附着”与“隧通”来分析机器模拟出类人智能的可能路径,这也意味着机器在这一框架下,有超越经典图灵机、达到人类水平的可能。

曾经有研究团队[20]在2015年访问了很多AI领域专家,去预测AI在围棋领域战胜人类的时间。当时大部分专家认为将发生在2035年左右。但实际上实现的时间是2016年;专家们还普遍认为对于AI最难的是做数学研究的证明,认为要到2060年实现这项技術,然而Nature已经发表了最新的研究成果[21],Google打造的拉马努金机(Ramanujan Machine)已经在很多数学问题能算出近似值,还能在数学计算中快速找出精确规律,例如π和e这样的无限不循环常数。其虽然在科学领域司空见惯,但是计算高精度近似值往往很难,以前只有拉马努金这样的“天才”才能做到,现在AI已经在这个领域取得了一定成果。

很多人认为2040年左右,会有强人工智能的“奇点”来临,这意味着那时AI将在大多数领域全面超越人类。但其实,强人工智能的定义并不清晰。有人将强人工智能定义为通用人工智能,但高级的智能和情感并无法以通用的方式去定义。例如,爱因斯坦的物理能力与莫扎特的音乐能力,这两种能力各具专业性,是无法断定谁的能力水平更胜一筹或智力水平更高一等。既然对人而言,智能是与专业领域相关,不能以通用的方式来定义人的智能,那么我们也不宜追问机器什么时候全面超越人。如果仔细思考,会发现这个问题的本质类似于“机器什么时候全知全能”,因为只有所谓的“全知全能者”是无所不知、无所不能的,是全面超越人类的。

如果,我们并不要求机器像“全知全能者”一样,那么强人工智能已经逐一实现之前人们对它大部分的设想。人与机器在进化速度上也有差异,两千年来,科学技术进步较大,但人类在情感上没有太大改变。可是,科学发展的速度和机器进化速度相比仍有很大差异。经典摩尔定律描述了硬件发展,即每18个月芯片能力翻一倍,而AI的能力,例如类似AlphaGo系统按照时间来评估,其算力增速达到了每3.5个月翻一倍的速度,相当于每过一年,算力就增加了10倍左右[22],这种速度是人类无法追赶的。成人的大脑约有1000亿个神经元,每个神经元与其他1万个以上的神经元有相互连接,就大概有1000万亿的参数量[23],目前GPT-3的参数量达到1700亿,按照每年10倍的算力增长速度,机器超过人脑参数量也只需要不到4年的时间。解构机器对人的超越这一命题,起点就在于正确理解心智的工作模式,清楚回答人的主体性和超越性从何而来,本文即是一个开端。

[参 考 文 献]

[1] Julian Schrittwieser, Ioannis Antonoglou, Thomas Hubert, et al. Mastering atari, go, chess and shogi by planning with a learned model [J]. Nature,2020 (588): 604-609.

[2] Ewen Callaway. “It will change everything”: DeepMinds AI makes gigantic leap in solving protein structures [J]. Nature, 2020 (588): 203-204.

[3] Geoffrey Hinton. How to represent part-whole hierarchies in a neural network [EB/OL]. [2021-02-25].https://export.arxiv.org/pdf/2102.12627.

[4] 李德毅.人工智能为什么还没有意识[J] .检察风云,2020(5):82-83.

[5] 张钹,朱军,苏航.迈向第三代人工智能[J] .中国科学:信息科学,2020,(9):1281-1302.

[6] Bernard J. Baars, Stan Franklin. An architectural model of conscious and unconscious brain functions: Global workspace theory and IDA [J]. Neural Networks Special Issue, 2007, 20(9): 955-961.

[7] Manuel Blum,Lenore Blum. A theoretical computer science perspective on consciousness [J]. Journal of Artificial Intelligence and Consciousness, 2021, 8(1): 1-42.

[8] Yuxi Li. Deep reinforcement learning:An overview [EB/OL]. [2017-01-31].https://arxiv.org/abs/1701.07274.

[9] Alonzo Church. A note on the entscheidungsproblem [J]. Journal of Symbolic Logic, 1936(1):40-41.

[10]David Deutsch. Quantum theory, the church-turing principle and the universal quantum computer [C]. Proceedings of the Royal Society A: Mathematical, 1985: 97-117.

[11]Alan M. Turing. Systems of logic based on ordinals [C]. Proc. Lond. Math. Soc. series 2 vol. 45 (1939):161-228.

[12]蔡恒進.认知坎陷作为无执的存有[J].求索,2017(2):63-67.

[13]蔡恒进.触觉大脑假说、原意识和认知膜[J].科学技术哲学研究,2017(6):48-52.

[14]蔡恒进.行为主义、联结主义和符号主义的贯通[J].上海师范大学学报(哲学社会科学版),2020(4):87-96.

[15]B Schlkopf et al. Toward causal representation learning [C].Proceedings of the IEEE, vol. 109, no. 5, pp. 612-634, May 2021, doi: 10.1109/JPROC.2021.3058954.

[16]Deleuze. Différence et répétition [M]. Paris:Presses Universitaires de France, 1968.

[17]Miller G. A. The magical number seven, plus or minus two: Some limits on our capacity for processing information [J]. Psychological Review, 1956(63): 81-97.

[18]蔡恒进.超级智能不可承受之重——暗无限及其风险规避[J].山东科技大学学报,2018(2):9-15.

[19]黄昉.休谟“活泼性”概念的新阐释[J].清华西方哲学研究,2020(1):27-41.

[20]Katja Grace, et al. When will AI exceed human performance? Evidence from AI experts [EB/OL]. [2017-05-30].http://arxiv.org/abs/1705.08807v3.

[21]Davide Castelvecchi. AI maths whiz creates tough new problems for humans to solve [EB/OL]. [ 2021-02-03].https://www.nature.com/articles/d41586-021-00304-8.

[22]Open AI. AI and compute [EB/OL]. [2018-05-16].https://openai.com/blog/ai-and-compute/.

[23]The Human Memory. Brain neurons and synapses [EB/OL]. [2020-11-24].https://human-memory.net/brain-neurons-synapses.