融合自适应局部特征与改进模糊C均值的服饰分割算法

李立瑶,顾梅花,杨 娜

(西安工程大学 电子信息学院,陕西 西安 710600)

0 引 言

如何使用户准确、快速地在网上搜索到心仪服饰,线上常采用基于内容的图像检索方法解决这一问题[1-2]。其中,服饰图像分割作为图像检索的前期工作,目的是获取图像中的服装区域[3-4]。现实的服装图像呈海量性、多样性等,在分割服装区域时极易受着装人体与拍摄环境等影响,产生光照不均、阴影遮挡、内部纹理噪声等,降低了分割准确率。在聚类分割方面,文献[5]通过分析阴影在不同颜色空间的特性,提出在YCbCr空间中依据本影检测框架与半影边界去除阴影。文献[6]提出利用邻域灰度的异质性获取局部上下文信息,并将高斯径向基核函数引入FCM的目标函数改善分割效果。文献[7]结合形态学重建与邻域信息优化FCM算法的分割精度,增强算法的鲁棒性。文献[8]将改进的超像素方法用于提取图像的局部特征,融入FCM算法中实现对彩色图像的快速分割。在服装实例分割方面,文献[9]采用基于局部空间信息的核模糊聚类算法分割服饰区域,但未标记背景与目标区域,对于彩色图像中目标服饰区域的提取效果不佳。文献[10]提出结合轮廓检测算法与全自动化GrabCut算法,解决服装图像前景提取时无法去除人体肤色干扰与复杂背景图像存在欠分割的问题。

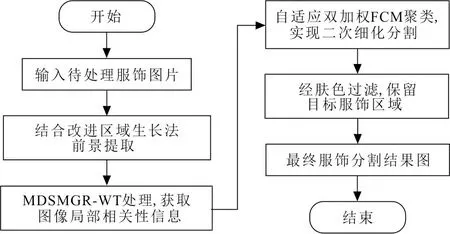

针对上述问题,本文提出了一种融合自适应局部特征与改进FCM的服饰分割算法。首先,通过改进区域生长法消除阴影并提取前景区域。其次采用MDSMGR-WT超像素处理,获取局部彩色特征信息,减少服饰内部的纹理皱褶,以及光照不均产生的影响。再次,将自适应区域局部信息融入经双加权改进的FCM目标方程中,通过二次聚类结合局部与全局特征。最后,过滤肤色区域实现快速获取轮廓更佳、分割效果更显著的彩色服饰图像。

1 算法设计

1.1 改进区域生长前景提取法

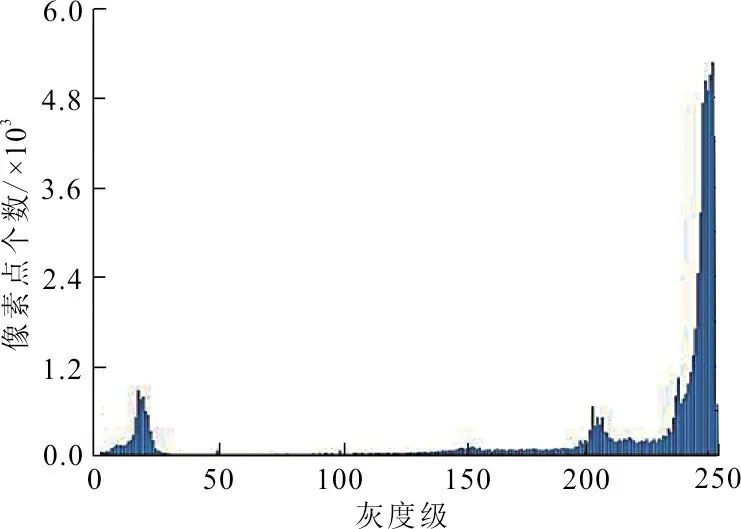

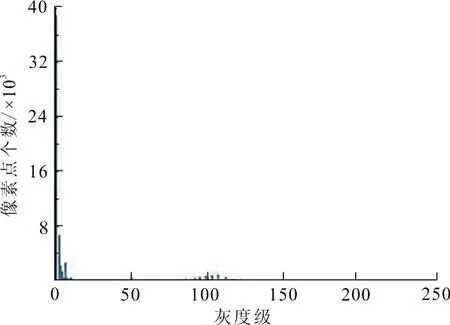

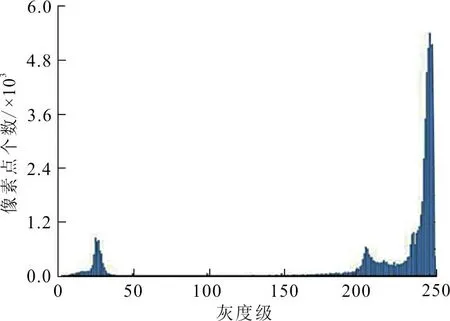

与原始背景相比,被阴影遮挡的像素点饱和度与亮度明显降低,而RGB颜色空间的色度与亮度信息被融入R、G、B等3个变量中[11],故在处理阴影遮挡图像时,应先转换为HSV颜色空间。分别提取饱和度矩阵S=[Sij]m×n与亮度矩阵V=[Vij]m×n及其对应的直方图,如图1所示,其中直方图中的第一峰值部分常代表图像的背景分布情况。

(a) 原始图像 (b) S对应图像 (c) V对应图像

(d) 原始图像对应直方图

(e) S对应直方图

(f) V对应直方图图 1 阴影图像及其对应直方图Fig.1 Shadow image and corresponding histogram distribution

图1(e)中,阴影部分对应于图中贴近第一峰值的小范围凸起,呈现近似双峰;图1(f)中,阴影区域对应于与第一峰值邻近的凸起区域,呈现三峰分布,据此对S、V矩阵设定不同约束规则。

以V矩阵中4个顶点均值拟为背景值Vm,各点Vij值与Vm之比为评判量μ,分析数据集中100幅阴影图像。设定μ为0.68<μ<0.96,满足则标记为阴影;对S矩阵通过OTSU法二值化,经形态学处理标记区域;最终结合S、V结果标记阴影区域。上述判定规则可表示为

(1)

式中:ζv、ζs分别为V、S矩阵下的判定规则,ζv判定阴影区域为1,否则为0,ζs判定服饰区域为1,否则为0;Vg、Sg为S、V矩阵的高斯滤波结果;T为二值化阈值。标记效果如图2所示。

(a) S矩阵 (b) V矩阵 (c) 阴影检测图 2 阴影规则分步处理效果Fig.2 Step by step processing effect of shadow rule

区域生长法是根据预先定义的生长准则[12],从一组种子点开始,逐步将像素或子区域集合成较大区域的处理方法,生长规则可表示为

(2)

式中:f(x0,y0)为种子点;f(xi,yi)为当前像素面;T′为生长判定阈值。

采用改进区域生长的前景提取法,以RGB图像中4个顶点的像素均值替换标定阴影区域像素值,过滤原图像,提取图像中的着装人体前景。

1.2 自适应局部特征的FCM服饰分割

1.2.1 基于MDSMGR的标记分水岭超像素 分水岭超像素是一种基于分水岭变换(watershed transform,WT)的形态学分割方法[13],聚合空间与梯度特征相近的像素点,但抗噪能力弱,易产生过分割现象。文献[14]采用形态学操作预处理图像消除区域极小值点,但抑制过分割现象不明显。文献[15]结合单层形态梯度重构,消除噪声与无用细节,保留目标轮廓。LEI等提出对原图像形态重构结合FCM算法解决这一问题[16]。

形态学开运算SO与闭运算SC均能剔除梯度图像中的区域极小值,可表示为

(3)

式中:Sδ为膨胀图像;Sε为腐蚀图像;SE是结构元,默认半径为r的圆形结构;δ为膨胀操作;ε为腐蚀操作。

形态学处理是以结构元对原始图像进行覆盖的运算[17],其覆盖范围对重构特征影响很大,过小易产生过分割现象,反之易出现欠分割。因此,需要一种自适应结构元方法对不同图像进行处理,减少MGR-WT处理结果中的小区域数目。在文献[15-16]的基础上,通过优化形态学重构提取梯度图像以消除MGR-WT的不良分割现象。以30°为步长,从0°~150°中选取6个不同方向提取特征构建梯度图像。以Gn表示融合6个方向的梯度特征,表示为

(4)

式中:k=0,1,2,…,5为任意方向数;f为待处理图像。

在给定初始结构体半径r1的前提下,逐渐增大r值,扩大覆盖面积,以上升渐变式结构元对梯度图像进行迭代形态学重构,提出MDSMGR(multi direction and scale morphological gradient reconstruction)处理,定义为

(5)

通过大量实验分析,设定1≤r1≤3。r2决定结构体最大尺寸,增大r2能够使超像素结果逐渐收敛,消除小区域影响,但对于不同图像,r2取值不一。为应对r2的自适应性,对式(5)设置上升规则,取MDSMGR处理前后结果的最大均方根误差为评估量,引入定值η取代r2,表示为

(6)

实验结果表明,随着η的增大r2值逐渐变大,当η值小于等于10-6时,r2的值不再变化,因此,设定η=10-6。

1.2.2 改进FCM服饰分割算法 将MDSMGR-WT获取的局部直方图信息融入FCM的目标方程[18]中,通过计算各超像素块与各聚类中心的相似程度分配权值,设样本权值公式为

(7)

式中:0<τ<0.077 2;c为聚类中心数;xj为第j个超像素块的像素值,j=1,2,…,n;vi为第i个聚类中心,i=1,2,…,c。

变异系数[19]是标准差与均值的比值,用于衡量聚类中心之间的差异程度,变异系数越大,表示以该组聚类中心为划分依据能实现分割精度更高,设第i个聚类中心所包含的超像素区域为χ={x1,x2,…,xw},对应变异系数ωi为

(8)

(9)

式中:βn为第n个聚类中心的权重;ωn为指第n个聚类中心的变异系数。

综上,融合自适应局部特征的改进FCM目标方程可表示为

(10)

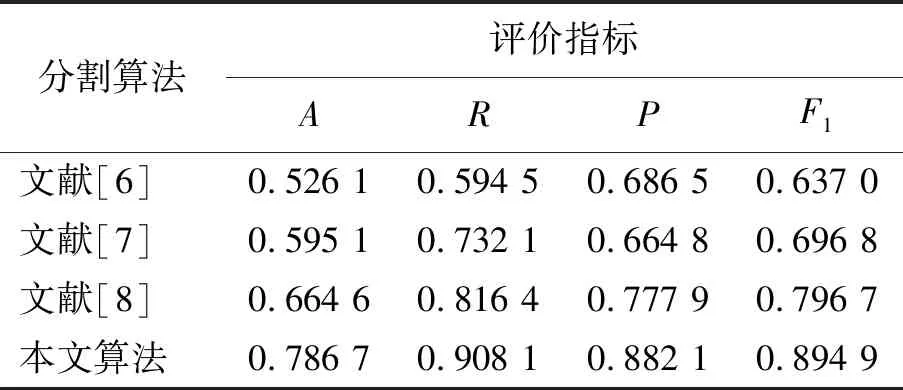

式中:c为聚类中心数;k为经MDSMGR-WT处理后的超像素区域数;vj(1≤j≤c)为聚类中心;Qi为第i块区域Si包括的像素数目;m(1 采用拉格朗日乘子[20]将上述问题转化为无约束优化问题,目标函数为 (11) 式中:λ为拉格朗日乘数。通过求取拉格朗日函数的极值点,给出μij与vj的解为 (12) 综上所述,提出的融合自适应局部特征的改进FCM算法步骤如下: 1) 读入前景提取后的服饰图像,设置聚类中心c,初始结构体半径r1,模糊化参数m,MDSMGR的最小误差阈值η,样本权值参量τ,以及FCM的最小误差阈值η′; 2) 采用Sobel算子提取多向特征,经多尺度MGR结合最小误差阈值η处理,获取保留重要轮廓细节、消除局部极小值的优良梯度图像; 3) 采用WT算法处理2)结果,获取MDSMGR-WT超像素图像; 4) 根据3)结果,随机初始化隶属度矩阵U0,置循环计数t=0; 5) 利用式(12)更新聚类中心vj与隶属度划分矩阵Ut; 6) 若max{Ut-Ut+1}≤η′,停止迭代,否则t=t+1,并跳转至5); 7) 结合肤色过滤,提取准确的目标服饰区域。 1.2.3 算法总体流程 首先,通过改进区域生长法提取着装人体区域,去除阴影遮挡与背景细节。其次,采用MDSDGR-WT超像素处理,消除服饰区域内部噪声以及光照不均的影响,将超像素的局部区域信息融入改进的双加权FCM目标方程实现二次精细化快速聚类分割。最后,经肤色过滤获取目标服饰区域。算法总体流程如图3所示。 图 3 融合自适应局部特征与改进FCM的服饰分割算法Fig.3 Clothing segmentation method with adaptive local features and improved FCM 采用Matlab编程仿真实现了一种融合自适应局部特征与改进FCM的服饰分割算法,并采用简单背景、阴影细节遮挡背景、以及不同人体姿态类型的服饰图像进行对比实验。 在背景光照不均与阴影遮挡情况下,采用改进区域生长法过滤原图像中的阴影部分并标记前景区域,与原始区域生长法对比结果如图4所示。 图 4 前景提取效果对比Fig.4 Comparison of foreground extraction effect 传统的区域生长合并法容易受背景噪声与阴影遮盖等影响,而采用改进的区域生长方法则能较好地处理这一问题,使前景提取效果得到很大的改善。 该算法采用MDSMGR-WT超像素算法对图像进行粗分割,获取局部特征信息,然后代入融合局部特征的双加权FCM算法实现二次精细化聚类分割。部分服装MDSMGR改进的梯度特征如图5所示,图5(a)为原始服装图像,图5(b)为图5(a)经MDSMGR提取的梯度特征效果。 (a) 原始图像 (b) MDSMGR梯度提取效果图 5 MDSMGR改进的梯度特征提取效果Fig.5 Improved gradient feature extraction based on MDSMGR 将前景提取后的服饰图像作为待处理图像,验证所提出的自适应局部特征双加权FCM分割算法应用于服饰区域的标记分割效果,并与文献[6]的改进FCM分割算法,文献[7]给出的基于形态学重建与邻域信息优化的FCM算法,及文献[8]所提出的SFFCM算法效果进行对比,处理结果如图6所示。 图 6 不同算法在标记服饰区域标记分割效果对比Fig.6 Comparison of different algorithms in theextraction of clothing area 结果表明,上述算法均能在着装人体服饰图像中获取目标区域,区别在于,因受服饰的内部花纹与光照不均等因素影响,结合形态学重构与邻域信息改进的FCM算法与基于形态学重构的FCM方法处理的服饰图像,标记的服饰区域存在较多孤立点。相比之下,文献[8]所提出的SFFCM算法与本文所提出的融合自适应局部特征双加权FCM分割算法在结合了超像素预处理的情况下,消除了服饰内部噪声与孤立点影响。但由于SFFCM算法引入的类别特征较少,使得后续FCM聚类结果在目标区域内出现空洞,存在如第4列所示的错误识别,丢失了重要的目标区域。自适应局部特征的加权FCM分割算法在消除内部噪声的同时,依据样本与类别特征信息,更好地保留了图像点与点、块与块之间相关特征,在目标服饰区域的标记处理中效果较好。 为进一步所提出的验证融合自适应局部特征的改进FCM分割算法在服装实例分割方面的有效性,将其与文献[10] 、文献[21]的算法性能进行对比,结果如图7所示。 图 7 服饰实例分割效果对比Fig.7 Comparison of extraction results of clothing segmentation practice 为了客观评价所提出算法的性能及效果,采取准确率A、召回率R、查准率P及F1值作为评价指标,对图6各个算法在服饰图像的区域标记效果定量分析,具体如式(13)所示: (13) 式中:Gti为图像Gi中目标服饰所占区域大小;ri为通过分割算法获取到的结果服饰区域大小;Pri为指图像Gi中通过正确人工标注的服饰区域大小。 表 1 服饰区域标记分割算法的性能评估Tab.1 Performance evaluation of clothing region label segmentation algorithm 从表1可知,融合自适应局部特征信息的FCM服饰分割方法在准确率、召回率、精确率以及F1值的评估方面均优于其他2种算法,综合各项指标而言,该算法更适合提取目标服饰区域。 采用像素精度Ap与均交并比MIOU为评价指标,对图7不同算法的服装实例分割结果定量评估,计算公式如下: 式中:pij为本属于i但被归为j类的像素数;pii为正确归类的像素数;k为区域类别数。 从表2可知,与其他分割算法相比,融合自适应局部特征信息的FCM服饰分割方法能够消除背景噪声、消除内部空洞,获得边缘更贴合、区域分割效果更显著的彩色服饰图像,具有较高的服装实例分割性能。 表 2 不同算法用于服饰实例分割的性能评估Tab.2 Performance evaluation of different algorithms for practice clothing segmentation 针对服饰图像的分割过程中,因拍摄场景与着装人体姿态等因素影响,普遍存在受服饰内部纹理褶皱、背景部分细小噪声,以及由光照引起的背景色不均及着装人体阴影遮挡等问题,提出了一种融合自适应局部特征与改进FCM的服饰分割算法。通过改进区域生长法提取前景区域,消除阴影遮挡与背景细节,经MDSMGR-WT超像素粗分割,减少服饰区域内部的纹理皱褶与光照不均的影响,然后将自适应局部空间与彩色信息融入双加权FCM目标方程中,实现二次精细化分割处理,最终经肤色过滤,快速而准确地提取目标服饰区域。

2 实验与分析

2.1 前景提取效果对比

2.2 服饰区域分割效果对比

3 结 语