新闻写作机器人性别偏见的个案研究

齐琳珲

人们正逐渐意识到人工智能并非是客观中立的,而是可能存在偏见的,这种偏见见于人种、职业、性别等多个方面,在人类社会存在已久,不同领域的学者一直在致力于研究与改变这些偏见。人工智能的出现,可能不但不会缓解性别偏见,相反会进一步加剧。一方面,因为机器算法不同于人类,无法抵制其所学到的偏见,对性别有偏见的社会价值观可以植根于数据库之中,并通过机器学习进入算法之中。另一方面,与之前所有技术一样,人工智能技术也将在某种程度上反映创造者的价值,由于人工智能的开发者绝大多数是男性,在这些技术的设计中,男性的过度代表性对于人工智能特性的影响,可能会悄然抵消几十年来在两性平等方面取得的进步。这种技术代表性上和语言上的原因而造成的性别偏见已有许多例子,比如之前谷歌翻译将“强壮”“医生”等词与男性相联系,而将“护士”“美丽”等词与女性自动关联。人工智能领域的研究者们应关注到可能存在的偏见问题,以避免性别偏见给女性带来的负面后果再度重演。

近些年来,人工智能技术逐渐应用于新闻传播领域,智媒时代已经到来。从新闻写作机器人Dreamwriter在腾讯财经频道的报道《8月CPI涨2%创12个月新高》开始,国内的新闻写作机器人正式登上新闻传播的舞台,新华社的“快笔小新”、第一财经的“DT稿王”、今日头条的“xiaomingbot”都陆续上岗。机器人写作多集中于体育、财经新闻报道,南方报业传媒集团的小南开始涉及民生新闻。这类写作机器人的特点是快速、高效、客观、中立,旨在高效地处理和分析数据,进行报道与推送。然而,质疑的声音也随之而来,人工智能是否可以真正地不存在偏见不带有情感偏向地审视新闻、写出稿件,还是偏见在其中以一种不易察觉的方式嵌于机器人所撰写的稿件之中,对于读者产生潜移默化的影响?文本试图以内容分析法探究新闻写作机器人“ZXM”(化名)在报道2018年温网赛事时是否体现出性别偏见,并试图讨论这种偏见背后可能的原因。

相关理论与文献梳理

1.新闻写作机器人与算法偏见

对于诸如xiaomingbot、Dreamwriter、快笔小新这类新闻写作机器人的称呼并不一致,通过检索知网、万方等数据库,发现有“机器人新闻写作”“机器人写作”“机器人记者”“人工智能新闻生产”等相关用词,但本质上是类似的,所指的都是基于人工智能和大数据技术进行新闻稿件生产的计算程序,这些程序通过算法对所收集的数据进行分析、处理和加工,从而形成一篇完整的报道。虽称其为机器人并以人名进行命名,但其并无实体身份,而是程序与算法。本文选取的研究对象ZXM属于二代写稿机器人,写稿速度更快,可以在2秒内完成稿件并发布;拟人化程度也更高,会根据选手的实际比赛成绩与赛前预测,以及比分的差距大小,自动调整撰写新闻稿件的语气;除此之外,它可以从图库中自动识别和筛选图片,将其插入新闻稿件之中,使报道更加完善。

关于新闻写作机器人的研究起步较晚,但发展迅猛。新闻写作机器人的应用提高了生产效率,转变了生产方式[1]。但同时也带来了新的伦理问题,基于大数据的机器学习存在侵犯隐私的可能性[2],数据的失实会造成新闻失实[3],即使数据真实可靠,但新闻写作机器人的算法的可能带有偏见,也会导致报道中的偏见[4]。算法的偏见可能存在于算法设计和运行的每一个阶段。首先,算法设计师有意的或者无意的认知偏见进入算法的设计之中会导致有偏见的算法[5]。其次,社会存在的数据进入机器学习程序之中,由于这些数据中本身就带有人类社会现存的偏见,机器学习会识别出这些偏见并将其纳入算法之中[6]。对于算法中的偏见的研究,可以破除对于算法“中立”“权威”的迷信,避免人为算法所控制。但是由于算法的“黑箱”特性和源数据的庞大、难以测量,很难通过科学的方法对算法中的偏见进行判定。新闻写作机器人的出现或许提供了探究算法是否存在偏见的一种新的路径——从结果逆推过程,即从新闻写作机器人生产的报道切入展开研究。

2.新闻报道中的性别偏见研究

尽管女性主义者一直都在致力于改变性别偏见问题,但在新闻报道中仍然存在性别刻板印象。性别刻板印象主要是从批判的视角出发,认为媒介中的女性被塑造为迎合男权文化的形象,巩固大众对于女性和男性的形象认知,从而维护男权文化与男权观念。也就是说,通过媒介的加工,男性和女性的社会性别差异被凸显。对于报道中的性别偏见的研究一直未曾停止。已有研究通过对记者所生产的新闻进行内容分析发现,性别偏见与新闻报道的主题和选择相关,在体育、政治和商业领域更为普遍[7]。比如,体育报道中存在的对于女性运动员的性别刻板印象——重点描述外在形象或者家庭身份等。报道中的性别偏见不仅体现于文本之中,还存在于报道中所选择图片的数量与类别。除时尚相关报道外,关于石油、政治、市场、运动、商业、技术等领域的报道,有关男性的图片数量远高于女性,其中体育领域,报道中的男性图片数量约是女性图片数量的三倍[8]。我国也有研究发现对男子运动员的体育报道的图片数量高于女子运动员,且报道中的图片内容因性别不同而有所差异[9]。新闻写作机器人“ZXM”拥有强大的自动选图功能,也就是可以实现图文自动关联发稿,这一功能的实现是通过学习图文语义匹配模型,再从庞大的图文数据库中寻找合适的配图[10]。新闻写作机器人智能选图方式是否对原本体育报道的图片呈现中可能存在的性别偏见问题有所改善,还是这种偏见依然存在?对此,本文提出以下问题:

Q1:新闻写作机器人在报道2018温网公开赛时,对男选手和女选手的图片报道数量是否存在差异?

Q2:新闻写作机器人在报道2018温网公开赛时,男女选手在报道图片中的呈现方式是否有所不同?

研究方法

本研究选择的样本是新闻写作机器人“ZXM”对2018年温网公开赛的报道中的图片,共从239篇报道中收集到图片605幅,男女选手是主要的研究关注对象。采用的方法为内容分析法。具体操作流程为:提出研究问题或假设;选择样本;定义编码类别;对编码内容进行编码,检查编码的可靠性;对编码过程中采集的数据进行分析和解释。

通过参照以往关于网球赛事的体育报道的性别偏见研究,将类目构建为图片对象、图片主题——图片对象为男选手和女选手,以回答问题一;图片主题分为运动类图片、情绪类图片和其他,以回答问题二[11]。运动类图片中根据图片强调的运动能力的不同,分为对抗类、速度类、技巧类、力量类。对抗类指的是强调对手之间的对抗,速度、技巧和力量则是看抓拍瞬间所强调的是哪一方面。情绪类分为赢球后的平静、胜利后的喜悦及丢分后的失落。其他类包括两类,一类为非选手本身的照片,而是与选手有关联的人的照片,包括评委、教练、观众、爱人等。另一类是选手的照片,但并非在比赛时的照片,如离场、接受采访、擦汗等。

在对样本数据编码完成一个月后,为了测试编码信度,笔者选取了10%的样本,根据编码类别,再次进行编码,结果与前一次编码所得显示一致。

研究结果

Q1:新闻写作机器人在报道2018温网公开赛时,对男选手和女选手的图片报道数量是否存在差异?

在2018年温网公开赛期间,新闻写作机器人“ZXM”对男选手的报道中配图总计有391幅,对女选手的报道中配图共有214幅。ZXM对男子运动员的报道中的配图数远高于关于女子运动员的报道中的图片数目。为了进一步看出其中的差异,对八分之一决赛、四分之一决赛的男女选手的报道所配图片数量进行比较,发现关于男选手的报道配图在4张以上(包含4张),而女选手报道的配图多为2或3张。

Q2:新闻写作机器人在报道2018温网公开赛时,男女选手在报道图片中的呈现方式是否有所不同?

依据所构建的类目,对报道图片进行编码所得结果如图1所示,发现男女选手在报道图片中的呈现方式并不相同。图1中可以直观看出大多数类别中男选手的图片数量都是远高于女选手的,只有两类例外。一是失落情绪类图片。温网赛事中,男子选手的报道图片中包含因失球或输掉比赛而显露出失落情绪的图片只有5张,而女子选手则有10张。二是报道中的非运动的关联类图片,关于女子比赛报道中此类照片明显多于男子比赛报道,且有多张是关于女选手与男教练对话的,女选手在照片中处于角落位置,而教练处于中间位置。以构图方式来凸显两人的关系和地位一直是电影和照片拍摄的一个重要手法,但在以比赛和运动选手为主角的报道中,将主角安排于图片角落位置,这种构图是否合适有待思考。除此之外,从图表中还可以看到男子与女子运动类照片有一个明显区别就是对抗类照片的有无。对抗类照片所突出的是对手之间的张力与对抗性。而女子运动照片都为突出单人选手的,并未有对抗类图片。

图1. 男女选手在报道图片中的呈现方式比较

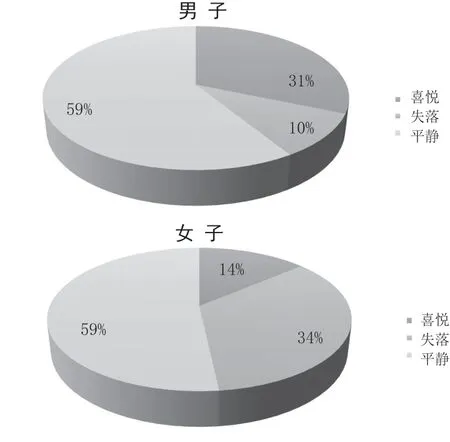

可以通过饼状图进一步比对男女选手报道的图片差异。关于男选手报道中的运动类图片占比(76%)要高于女选手(67%);关联类图片分别为11%与20%;情绪类(13%)持平。尽管男女选手的情绪类图片比例一致,但其中所呈现的具体情绪类型确有所不同(图2)。呈现因丢分或失败而引发的失落情绪的图片所占比重,女子运动员的(34%)显著高于男子运动员的(10%),而喜悦类情绪则相反,男子运动员(31%)高于女子运动员(14%)。

讨 论

1.社会中的性别偏见如何进入新闻写作机器人的稿件之中

通过分析“ZXM”对2018年温网公开赛的报道,结果发现男子赛事报道图片数量明显多于女子赛事的,且男女选手在图片内容的呈现方式上存在差异,男选手的运动类图片比例较女选手的多,且与运动无关的图片比例较女选手少;情绪类图片中更突出男选手胜利后的表情和女选手丢分后失落的表情。新闻写作机器人体现出这种偏见并非是预设了偏见程序,而是数据库中的图片本身在数量和内容上存在一定性别差异,新闻写作机器人通过学习图文语义匹配模型,自动从数据库中为新闻稿选择配图,而数据库的图片由人所拍摄并上传。在“女子1/32单打决赛Katie Boulter 0:2大坂直美”的报道中,所配图片是Boulter金色长发披肩,身穿一身时尚休闲衣服的形象,而非运动场上的形象。这种对于女子运动员生活照而非运动照的关注在传统的体育新闻报道中有所体现,社会中的性别偏见通过拍摄的图片和图文进入网络数据库中,并最终体现于新闻写作机器人的稿件之中(图3)。

2.如何解决新闻写作机器人的偏见:有道德的算法

智能写作机器人现阶段只体现在了功能性层面,而并非真正实现了“智能”,它们无法识别数据库中存在的偏见和错误。在技术层面,可以试图建构“有道德的算法”——对偏见内容予以识别与修正,通过一种“自上而下和自下而上相结合的学习路径”[12]。一方面,从伦理理论入手,将人类道德体系中已经成熟、公认的一些原则转换为算法的一套规则;另一方面,让人工智能循照孩童成长的路径,习得人的良善品德。要实现这种有道德的算法,首先需要人工智能相关研发人员具有一定的伦理道德,能够认识到人工智能可能存在的偏见,才可以对解决方法进行思考。东京奥运会期间,预计将有更多新闻机构采用机器人“记者”,如何避免人工智能的性别偏见应该予以重视。

图2. 男女运动员情绪类报道图片成分比较

图3.性别偏见影响过程