同志仍需努力

绘知堂科普馆

人工智能作为一个交叉学科,和计算机、数学(统计学、优化方法、图论等)、电子技术,以及脑科学等都有密不可分的关系,每个分支学科所遇到的问题也都会在人工智能的发展中出现。

2017年底,一个叫Deep-Fake图像合成技术落地了,它可以在视频中做人体图像合成。

简单来说,人们可以像使用Photoshop修图软件改动图像一样,用深度学习技术(一个人工智能算法分支)来改动视频了。

人们曾经对图像处理一无所知的时候,还秉持着“耳听为虚眼见为实”的逻辑,看到照片就会对它记录的信息深信不疑。

后来人们认识了Photoshop这个软件,以及某些操作更为简便的人像美化软件,改动图像成為了人人都能轻易做到的事情,以至于很少会有人再轻信通过改动图片扭曲的事实了。

相对静态图像而言,视频则是长篇的图像组合。由于技术局限,一帧一帧改动成本太高,因此人们普遍将视频所记录的信息认定为事件真相。

这项视频人体图像合成技术的出现,又ー次打破了人们的常规观念。居心叵测的人可能会利用这项技术捏造犯罪录像,或者杜撰他人的言论来进行诽谤。

仍然相信视频无法纂改的人们很容易被改过的视频蛊惑,而造成信谣传谣的恶劣局面。如果你在见到此类消息时保持清醒的头脑,仔细甄别消息来源,就不会轻易被迷惑。

科学家一直努力对图像合成技术进行改进,将“以假乱真”作为顶尖技术水平的标准,但是这也为一些邪恶的想法提供了温床,违法者甚至不惜伤害他人的感受,在道德和法律的边缘不断试探。

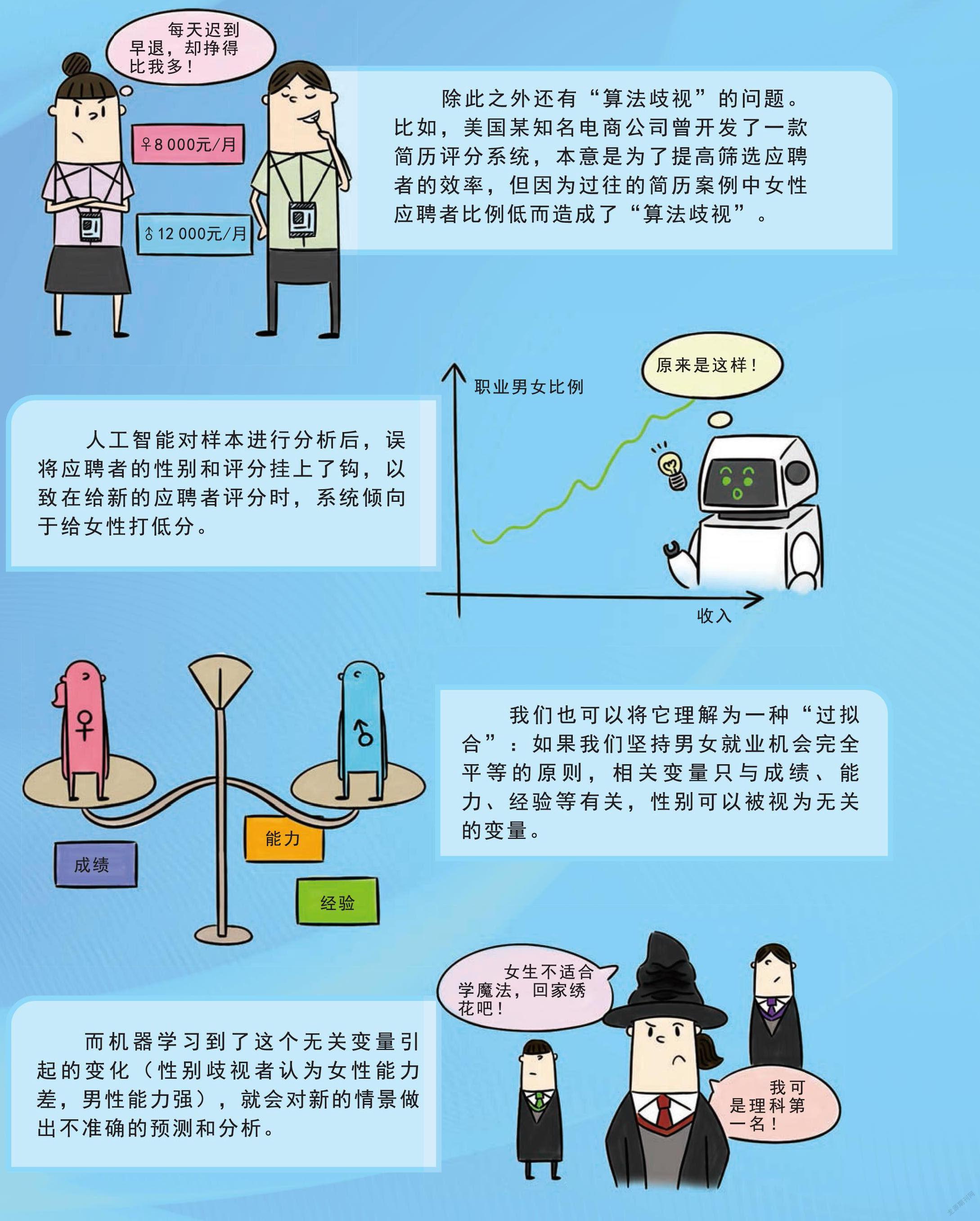

除此之外还有“算法歧视”的问题。比如,美国某知名电商公司曾开发了简历评分系统,本意是为了提高筛选应聘者的效率,但因为过往的简历案例中女性应聘者比例低而造成了“算法歧视”。

人工智能对样本进行分析后,误将应聘者的性别和评分挂上了钩,以致在给新的应聘者评分时,系统倾向于给女性打低分。

我们也可以将它理解为一种“过拟合”:如果我们坚持男女就业机会完全平等的原则,相关变量只与成绩、能力、经验等有关,性别可以被视为无关的变量。

而机器学习到了这个无关变量引起的変化(性别岐视者认为女性能力差,男性能力强),就会对新的情景做出不准确的预测和分析。

又比如在新冠肺炎疫情蔓延全球期间,美国某知名互联网公司推出的款计算机视觉服务在识别人手持测温枪的图像时,被曝出了有种族歧视的倾向。

当图像中的手肤色较浅时,系统更倾向于将图中的物品归类为“单目望远镜”,而当手肤色较深时,系统则更容易将物品归类为“枪支”。

这种严重带有主观色彩的判断,就来自于训练采集数据的不全面和不平衡。消息一经披露,此公司高管只得出面道歉,并修改了算法予以纠正。

还有更荒唐的例子:一些科学家设计了一种面部特征与曾否犯罪的预测模型,简而言之,就是“看脸抓贼”。这个课题概念很荒唐,准确率很低,并且充满了“外貌歧视”。

因此,就像化学家绝对不可以制造毒品一样,未来的人工智能小专家们,也要让这项技术在正确的方向上发挥更大的作用哦!

(选自中国石化出版社“我的科普漫画书”系列《你好!机器人——智能算法中的数学奥秘》)

- 青少年科技博览(中学版)的其它文章

- 庆祝中国共产党成立100周年

- 拜访达?芬奇

- 蛇形机器人

- 神探猎豹警长之小螳螂被杀案

- 声速最快是多少

- 睡觉不关灯会变胖