基于注意机制的短文本分类方法

侯玉兵

摘要:短文本分类是互联网文本数据处理领域的一项关键任务。计算机视觉和语音识别领域中的深度学习研究表明,神经网络模型中更深层次的学习能够更有效地表达数据特征。受此启发,本文设计了一种将CNN和RNN模型与注意机制相结合的方法,根据文本的关键信息提取出更复杂有效的特征。为了评估方法对深度短文本分类的有效性,进行了综合实验比较和分析。

关键词:短文本分类;长短期记忆网络;卷积神经网络;注意机制

中图分类号:TP311 文献标识码:A

文章编号:1009-3044(2020)28-0185-02

Abstract: Short text classification is a key task in the field of Internet text data processing. Research on deep learning in the field of computer vision and speech recognition has shown that deeper levels in a neural network model are more effective in expressing data features. Inspired by this, a model is proposed that integrates the CNN and RNN model with an attention mechanism to extract more complex and effective features according to the key information of the text. To evaluate these effects of these models for deep short text classification, comprehensive experiments are conducted to compare with LSTM, CNN, and their combinations.

Keywords: Short Text Classification; Long Short-Term Memory Networks; Convolutional Neural Networks; Attention Mechanism

短文本分类技术在信息检索、信息安全、个性化推荐系统、问答系统等领域发挥着重要作用[1]。基于深度学习的神经网络模型在语言建模、句子和文档建模等自然语言处理领域取得了巨大的成功,并在机器翻译、词性标注、情感分类等方面得到了有效的应用。词向量是语言模型的附加产物,能够更好地表达语义和语法信息,可以应用于多种模型。目前,Word2Vec[2,3]和GloVe[4]是应用最广泛的工具。

本文以短文本分类为重点,结合卷积神经网络(CNN)、长短期记忆(LSTM)网络模型、残差网络(ResNet)和注意机制四种深度学习技术的优点,捕捉时间和空间两个层次的文本特征,随着网络层次的加深,学习更复杂的特征。

1 基于注意力机制的分类方法

为了结合LSTM和CNN在特征获取方面的优势,本文利用多层LSTM对词向量进行优化,得到输入短文本向量的时序信息。通过卷积神经网络获得空间组合特征,通过残差层有效地解决了LSTM中第一层的参数更新问题。为了进一步提高模型的有效性,引入注意机制。注意机制可以看作是一种权值选择机制,通过注意资源辅助获取焦点,对连续文本信息的处理非常有帮助,通过增加外部的注意力资源来改进注意层的功能。

注意机制已经成功地集成到CNN和RNN模型中,在翻译、语音识别和图像字幕等许多应用领域都有了显著的改进。除了输入层和隐藏层之外,池化层和注意机制可以看作是帮助获得层的相关部分的特征的选择机制。针对注意力机制提出了注意力焦点(Attention Focus)和注意力资源(Attention Source)概念,本文对注意力焦点和注意力资源概念提出了新的解释,并用来介绍注意力机制应用过程。

注意力焦点focus是与注意力权重进行加权运算的数据,是注意力权重直接作用的数据,即图1中的输入x。它可以采用输入层的词向量,也可以是卷積神经网络或长短时记忆模型的隐藏层输出。注意力焦点与注意力资源进行匹配运算,进行归一化得到注意力权重。注意力焦点与注意力权重进行加权求和,得到注意力层的输出。

注意力权重的分配通常是基于内容的匹配度。注意力资源source,顾名思义,就是模型需要关注的重点信息,用来结合注意力焦点计算注意力权重。该数据可来源于内部,也可以来源于模型外部。

注意力资源来源于模型内部的计算方式见图1(a)和(b),(a)中注意力资源source等同于注意力焦点focus,(b)中source数据是由focus数据运算得到的。当前,图1(b)模式中获取source数据普遍的方法是,使用最后一层RNN隐藏层输出或者最大(或平均)池化RNN隐藏层或卷积层,得到一个简单的source数据向量表示。另外,RNN模型注意力机制中的记忆单元C,也可以当作由模型内部运算得到的注意力资源source。

外部提供的注意力资源source可以是词典中的词或短语(图1(c)),或由相关文本运算得到的特征信息(图1(d))。问答模型当中的问句与答案的匹配建模,可以参考图1(d)模式的注意力机制。

根据上述注意力焦点和注意力资源内容,为了区分focus与source的模式,本文改进了对应的打分函数,公式如下:

其中,[sj]是注意力资源[s]第[j]列的向量。如图2,将[xi]与每列注意力资源向量进行匹配,然后对所有结果求和,得到该输入[xi]对应的分数。该匹配使用全连接方式实现,[U1]、[U2]和[V]这些权重是在训练模型过程中学习的。

在处理文本任务的神经网络模型中,有些模型要求句子序列,即不能破坏句子序列。注意机制用于在不需要输入顺序的情况下获得输入特征的加权和。因此,在考虑注意机制时,最好将其应用到场景中,例如池层、卷积层等。

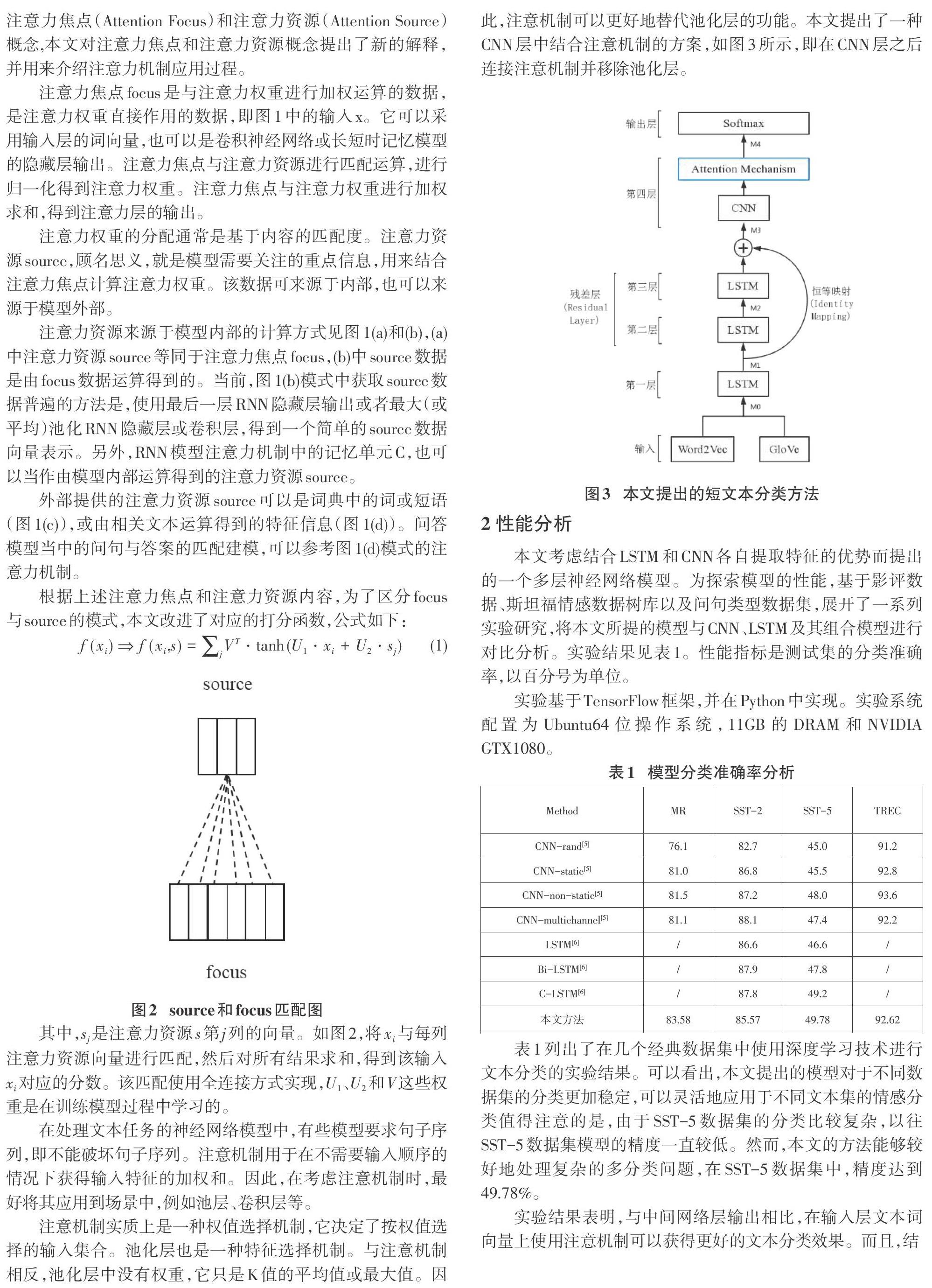

注意机制实质上是一种权值选择机制,它决定了按权值选择的输入集合。池化层也是一种特征选择机制。与注意机制相反,池化层中没有权重,它只是K值的平均值或最大值。因此,注意机制可以更好地替代池化层的功能。本文提出了一种CNN层中结合注意机制的方案,如图3所示,即在CNN层之后连接注意机制并移除池化层。

2 性能分析

本文考虑结合LSTM和CNN各自提取特征的优势而提出的一个多层神经网络模型。为探索模型的性能,基于影评数据、斯坦福情感数据树库以及问句类型数据集,展开了一系列实验研究,将本文所提的模型与CNN、LSTM及其组合模型进行对比分析。实验结果见表1。性能指标是测试集的分类准确率,以百分号为单位。

实验基于TensorFlow框架,并在Python中实现。实验系统配置为Ubuntu64位操作系统,11GB的DRAM和NVIDIA GTX1080。

表1列出了在几个经典数据集中使用深度学习技术进行文本分类的实验结果。可以看出,本文提出的模型对于不同数据集的分类更加稳定,可以灵活地应用于不同文本集的情感分类值得注意的是,由于SST-5数据集的分类比较复杂,以往SST-5数据集模型的精度一直较低。然而,本文的方法能够较好地处理复杂的多分类问题,在SST-5数据集中,精度达到49.78%。

实验结果表明,与中间网络层输出相比,在输入层文本词向量上使用注意机制可以获得更好的文本分类效果。而且,结 合注意机制可以提高SST-2、SST-5和TREC数据集的分类效果,进一步提高短文本分类的准确性。

3 结论

本文将长短记忆网络和卷积神经网络相结合,通过建立残差层来缓解梯度消失的问题。同时引入注意机制,提高了模型提取有效特征的能力。提出了一种基于注意力机制的短文本分类方法。并将该方法与CNN和RNN在各种数据集上进行实验分析和比较。

参考文献:

[1] Salton G,Wong A,Yang C.A vector space model for automatic indexing[J].Communications of the ACM,1975,18(11):613-620.

[2] Mikolov T,Chen K,Corrado G,et al.Efficient estimation of word representations in vector space[EB/OL].2013:arXiv:1301.3781[cs.CL].https://arxiv.org/abs/1301.3781.

[3] Mikolov T,Yih W T,Zweig G.Linguistic regularities in continuous spaceword representations[C]//2013:746-751.

[4] Pennington J,Socher R,Manning C.Glove:global vectors for word representation[C]//Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing (EMNLP).Doha,Qatar.Stroudsburg,PA,USA:Association for Computational Linguistics,2014: 1532-1543.

[5] Kim Y.Convolutional neural networks for sentence classification[C]//Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing (EMNLP).Doha,Qatar.Stroudsburg,PA,USA:Association for Computational Linguistics,2014: 1746-1751.

[6] Zhou C T,Sun C L,Liu Z Y,et al.A C-LSTM neural network for text classification[EB/OL].2015:arXiv:1511.08630[cs.CL].https://arxiv.org/abs/1511.08630.

【通聯编辑:唐一东】