基于局部和全局特征融合的显著性检测

张卫国,马静瑞

(西安科技大学 计算机科学与技术学院,陕西 西安 710054)

0 引 言

显著性检测旨在模拟人类视觉系统的选择性处理,识别图像中最重要和最显著的对象区域。作为预处理步骤,它可以有效地聚焦于与当前任务相关的图像区域,并且广泛应用于计算机视觉和图像处理工作,如图像分割[1]、图像压缩[2]以及目标识别[3]等领域。目前,国内外研究者提出了大量的显著性检测模型。主要分为自底向上目标驱动的模型[4,5]以及自顶向下任务驱动的模型[6-8]。自底向上的显著性检测方法倾向于检测图像细节信息并且具有较低的计算复杂度,但很难专注于全局形状信息。而自顶向下的显著性检测方法能够提取全局信息,但忽略局部显著性特征。为了更好地利用两种方法的优点并克服这两个方面的不足,本文从自底向上及自顶向下两种模型考虑,提出了一种结合局部特征和全局特征的方法,并且该方法有效地提高了显著性检测的准确性。

1 本文算法

本文提出了一种结合局部和全局特征的图像显著性检测方法。该方法的实现框架可分为3个阶段,如图1所示。第一阶段,为了保持显著区域的完整性,避免尺度分割对显著性结果的影响,将输入图像进行多尺度分割。再考虑颜色特征以及纹理特征的互补性,通过局部对比度计算得到局部显著图。第二阶段,以VGG16[9]网络为基础模型构建全卷积神经网络(FCNN),进行端到端的训练。通过训练好的模型,输出全局显著图。第三阶段,将前两个阶段生成的显著图进行融合,得到最终的显著图。

1.1 局部显著性检测模型

为了更好地捕获输入图像的结构信息并提高图像处理效率,对于任意输入图片,首先采用SLIC(simple linear iterative cluster)分割成4个尺度的超像素集,设定像素个数分别为100,150,200,250。对于每个尺度下的超像素集,均基于图像中心先验、对象先验以及暗道先验[10]等信息,通过计算不同区域的RGB、CIELab、LBP这3种特征的欧式距离,得到每个区域的显著值。即对于区域ri(i∈{1,2,…M})与边缘bj(j∈{1,2,…Mb},Mb是边缘超像素的个数),显著性值可通过式(1)计算

图1 显著性检测框架

(1)

其中,dF(ri,bj)是区域ri与边缘区域bj在F所对应特征下的欧式距离,F分别为RGB、CIELab及LBP特征。Ce(ri)是通过区域ri中心与图像中心归一化空间距离计算得到的中心先验权重。Dr(ri)的计算方法参考文献[10]。Ob(ri)计算每个窗口被判定为显著性目标的概率值Ob(q),计算公式为

(2)

通过式(1)可以得到每个区域的显著值,将该区域内的所有像素设定为该值,并得到像素水平的显著图。采用图割(graph cut)方法进行优化处理,得到初级显著图S0。对每个尺度上的初级显著图,表示为:{Ski},i=1,2,3,4进行多尺度融合,得到最终的显著图Sl,计算公式为

(3)

1.2 全局显著性检测模型

FCNN是一种特殊的卷积神经网络模型。与CNN不同,FCNN使用卷积层而不是全连接层来实现像素级预测,可以有效地捕获图像的语义信息。本文在VGG16网络结构的基础上将全连接层替换成卷积层,构建FCNN,其网络结构如图2所示。该模型对不同级别(从低级别到高级别)的显著性信息进行编码。前13层基于VGG16卷积网络,第14、15层各含有一个卷积层,同时引入Dropout层,对前13层的深度特征做进一步抽象,以提高网络的泛化能力。最后为了使输出图像具有与输入图像相同的尺寸并保留图像的全局信息,使用一个卷积层和一个反卷积层来生成显著图(通过sigmoid函数归一化为[0,1])。其中,前15层的每个卷积层都配备一个线性整流函数(ReLU)。

图2 FCNN网络结构

本文FCNN模型是在Caffe toolbox[11]的基础上实现的。实验中通过随机梯度下降法(SGD)进行网络训练,实现逐像素的预测。训练过程中动量设置为0.99,权重衰减系数设置为0.005,学习率为10-10。最后,通过训练好的FCNN输出全局显著图Sg。

1.3 局部显著图和全局显著图的结合

局部模型生成的显著图更趋向于图像的细节,而全局模型生成的显著图能够比较完整的突出整个显著性目标。本文基于局部、全局显著性检测模型优势互补的特性,将局部和全局两种显著图利用加和的方式结合起来,使得最终显著图Sf结果更优,计算公式如下

(4)

2 实验结果及分析

为了评估所提方法的性能,本文在3个公开的数据集上进行一系列的定性和定量实验。这些数据集均含有像素集的真值标注,分别为SED2[12]、ECSSD、PASCAL-S[13]。ECCSD数据集包含1000张具有来自互联网的复杂场景的图像。PASCAL-S数据集包含850张具有多个复杂对象和杂乱背景的自然图像,可以说是最具挑战性的显著性数据集之一。SED2共100张图片,是一个含有多显著性对象的数据集,通常在每个图像中包含两个显著对象。

将本文方法与比较经典的ITTI(IT)、RC[4]、LG[5]、DM[6]、LEGS[8]等方法进行定性和定量比较。由于作者并未提供LEGS方法在SED2数据集上的检测结果。因此,LEGS方法只在ECSSD、PASCAL-S数据集上进行评测。

2.1 定性评测

图3显示本文算法与其它算法生成的显著图的定性对比图。第一列为测试集中的原图,第二列为手工标记的二元真值图(ground truth,GT)。从图中可以看出,前面5种方法生成的显著图有漏检、对比度不明显、不完整的情况,而本文算法能够更加准确均匀的突出前景,并且生成的显著图中背景噪声较少,更接近人工标记结果。此外,由于采用了LBP纹理特征,本文算法在背景杂乱和前景背景对比度比较低的情况下仍然可以很好地工作。

图3 本文算法与现有5种算法生成的显著图对比

2.2 定量评测

为了更进一步验证本文算法的有效性,通过准确率-召回率(P-R)曲线、AUC(area under roc curve)、F-measure以及平均测量误差(MAE)4个指标来评价算法的性能。P-R曲线显示了不同阈值下显著图的平均准确率和召回率。MAE表示显著图和人工标注图之间像素的平均精度误差。F-measure用于评估准确性和召回率,公式如下

(5)

为赋予Precision值更大的权重,在本文中设置η2=0.3。

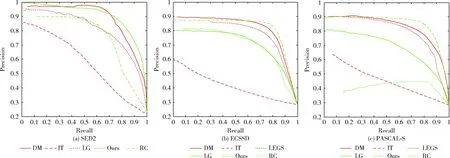

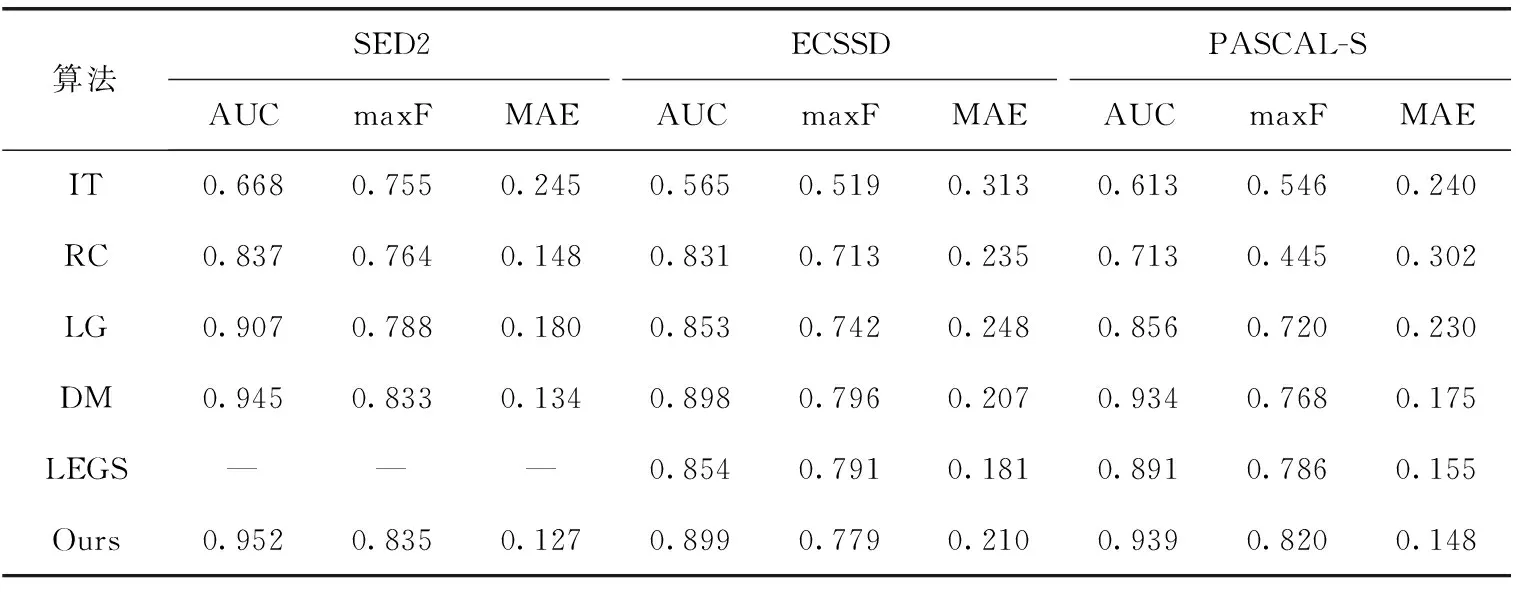

本文算法与5种算法分别在SED2、ECSSD以及PASCAL-S这3个数据集上的PR曲线如图4所示。由图4可知:在相同的召回率下,本文算法在SED2以及PASCAL-S数据集上均保持最好的P-R曲线,在ECSSD数据集上的P-R曲线较好。表1为不同算法的AUC值、F-measure值以及MAE值的对比结果。由表1可知:本文方法在SED2数据集上表现最好,获得最大的AUC值、F-measure值以及最低MAE值,在ECSSD以及PASCAL-S数据集上表现较佳。这进一步验证本文方法在3个复杂的数据集上均有较好的检测能力及鲁棒性。

图4 不同算法在3个数据集上的P-R曲线对比

表1 不同算法在3个数据库上的性能指标对比

3 结束语

本文从局部特征和全局特征出发,提出一种显著性检测方法。该方法通过构建局部模型和全局模型,并采用线性融合策略,得到最终的显著图。其中,局部模型从底层特征以及局部对比度的角度考虑,生成局部显著图。全局模型通过FCN捕获不同层次上的语义信息来预测全局显著图。3个公共数据集上的实验结果表明,本文方法在一定程度上得到了F-measure和MAE指标的改进,优于目前经典的方法,验证了本文方法的有效性。