基于红外可见光融合图像的车辆定位方法

周云飞,王晨霖

基于红外可见光融合图像的车辆定位方法

周云飞,王晨霖

(武汉理工大学 汽车工程学院,湖北 武汉 430070)

随着无人驾驶的发展,对车辆定位技术提出了更高的要求。基于视觉的车辆定位方法以其低成本、可扩展性,在近些年来发展迅速。仅仅依靠可见光图像很容易在光线恶劣的环境下产生较大误差,基于红外可见光融合图像的车辆定位方法则可以很好地解决这个问题,获得更准确的结果。

车辆;定位方法;视觉;融合图像

1 引言

视觉定位技术仅使用图像作为输入即可确定系统位置,不需要相关环境的任何先验知识。GPS、北斗等卫星定位技术容易被城市高楼众多的环境影响,导致定位误差很大,而基于视觉的车辆定位技术能够有效解决这些问题,可以实现自主定位,非常适合车辆这种移动平台使用,因此,视觉定位技术已成为当下移动车辆定位方法的研究热点,是计算机视觉的一个重要分支。传统的基于可见光图像的定位方法很容易在光照条件很差的地区失效,无法满足无人驾驶的全天候定位的需要。红外相机可以很好弥补这一点。本文拟实现一种基于红外可见光融合图像的车辆定位方法,以满足无人驾驶车辆定位的需要。

2 相关工作

在文献[1]中,作者利用红外和可见光的融合图像实现了车辆的定位。分别使用了两种图像融合方法,一种是基于离散小波变换的图像融合,另一种是基于单色阈值的图像融合方法。

2.1 基于离散小波变换的图像融合

基于离散小波变换的图像融合方法过程为:利用离散小波变换的方法分别将红外图像和可见光分解成高频子带和低频子带;对高频的红外子带和可见光子带使用取小原则,去除低频的红外子带和可见光子带;运用离散小波变换的反转换,从融合的高频子带中生成融合图像。

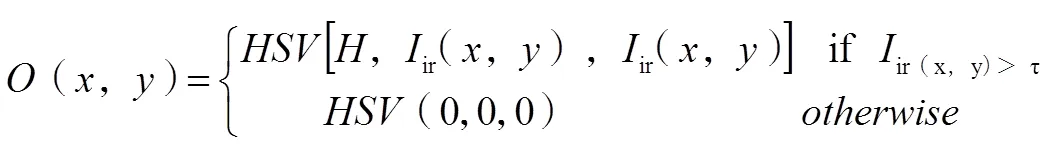

2.2 基于单色阈值的图像融合

基于单色阈值的图像融合方法可以在可见光图像中高亮显示红外图像中的发热物体,具体步骤如下。

将RGB图像转换为HSV图像。HSV是一种根据颜色的直观属性建立的颜色分类体系。

生成一个重叠图像(,):

式(1)中:为温度阈值。

根据可见光图像v(,)和重叠图像(,)生成最终的融合图像(,):

式(2)中:为不透明度值,它决定了融合图像中保存的可见光图像信息的大小。

在融合图像的基础上,笔者使用了开源的视觉定位算法LibVISO2,获取较为准确的相机的位置信息。但是,由于笔者使用的图像融合方法和视觉定位算法存在许多问题,比如LibVISO2是一个仅仅使用可见光图像的定位算法,不加任何修改就直接用于红外可见光融合图像,所以,无法满足车辆定位的需要。

3 本文方法介绍

总体结构如图1所示。

图1 总体结构

如图1所示,本文提出的方法的总体结构为:输入红外图像和可见光图像,然后对图像进行融合,最后基于融合图像实现车辆定位,得到车辆的位置信息。

3.1 图像融合方法

使用ZHANG等人[2]提出的图像融合方法,对红外和可见光图像进行融合。相比于基于离散小波变换和单色阈值的图像融合算法,它可以更好地融合红外和可见光图像中的有效信息,并且非常适合光照强度低的环境,具体步骤如下:取四叉树分解和贝塞尔插值的方法,重新构建红外图像的背景。从红外图像中减去上一步得到的重建背景,以减少冗余的背景信息,并提取出红外图像中的明亮特征,这些明亮特征对于车辆的定位是十分有用的;将提取出的红外图像中的明亮特征添加到可见光图像上,获得最终的融合图像。

通过这种方式,融合图像不仅可以通过融合红外亮特征来揭示不可见但重要的红外物体,而且还可以保存大量原始视觉信息,保持良好的视觉质量,很好地满足了车辆定位的要求。

3.2 视觉定位方法

基于融合图像的车辆定位方法如图2所示。

图2 基于融合图像的车辆定位方法

如图2所示,首先使用限制对比度自适应直方图均衡化算法对融合图像进行处理,它能够有效地改善图像的对比度,限制噪声放大,还能显示更多的图像细节信息。由于融合图像不可避免地带来了噪声,很有可能会影响定位的效果。使用FAST特征探测器进行特征检测,使用KLT光流法对检测到的特征点进行追踪。再使用Nister´s 5-point算法计算本质矩阵。在这个过程中,使用随机抽样一致算法去除误匹配点,以使计算的本质矩阵更准确。计算位置信息,本质矩阵的性质:

=[]x(3)

式(3)中:为旋转矩阵;[]x为与平移矩阵进行叉乘。

对本质矩阵使用SVD分解,得到每两帧图像之间的旋转矩阵和平移矩阵。再根据旋转矩阵和平移矩阵,算出每帧图像中相机的位置,即相对应的车辆的位置,实现车辆的定位要求。

4 实验

本文使用韩国科学技术院提高的公开数据集——《全天视觉位置识别数据集》进行测试,采用了其中的“EastAM02”图像序列。该数据集包含了韩国科学技术院校园内不同时间段拍摄的红外和可见光图像。其中,可见光图像的分辨率为1 280×960,红外图像的分辨率为320×256。红外图像进行了线性插值放大处理,分辨率变为了1 280×960。定位数据由GPS和惯性导航单元给出。

实验结果如表1所示。

表1 实验结果

图像类别可见光图像融合图像 总距离/m218.31 总误差/m22.0917.46

表1表明,相比于可见光图像,融合图像可以获得更准确的结果。

5 总结

本文提出了一个基于红外可见光图像融合的视觉定位方法,实验结果表明,仅仅使用可见光图像的效果差于使用红外和可见光融合图像的效果。未来,还会提出更加先进的方法,并和其他的传感器进行融合,以满足无人驾驶车辆的定位需要。

[1]POUJOL J,AGUILERA C A,DANOS E,et al.A visible-thermal fusion based monocular visual odometry[J].Proc Spie,2015(3):22.

[2]ZHANG Y,ZHANG L,BAI X,et al.Infrared and visual image fusion through infrared feature extraction and visual information preservation[J].Infrared Physics & Technology,2017(83):227-237.

U495

A

10.15913/j.cnki.kjycx.2020.09.041

2095-6835(2020)09-0102-02

周云飞(1999—),男,本科。

〔编辑:张思楠〕