多层特征与上下文信息相结合的光学遥感影像目标检测

陈 丁,万 刚,李 科

信息工程大学,河南 郑州 450001

光学遥感影像的目标检测,是遥感影像分析中一项极具挑战的研究内容,其广泛应用于土地规划、环境监测、城市安防、交通规划和军事指挥等众多领域,近年来受到越来越多的关注[1]。与此同时,深度学习作为大数据、高性能计算环境下快速发展的一门新兴机器学习技术,具备超强的数据学习能力和高度的特征抽象能力,如何将深度学习应用于遥感影像的目标检测成为新的研究热点。

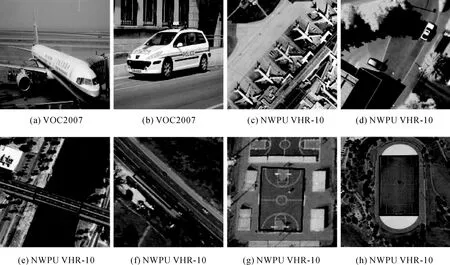

在自然图像领域,深度学习的应用极大地提升了目标检测的性能,并出现了许多优秀的算法,主要分为基于区域推荐(region proposals)的检测方法和基于回归的检测方法[2-6]。然而,与自然图像不同,深度学习应用于遥感影像的目标检测更具挑战性。如图1所示,对比VOC2007数据集[7]和NWPU VHR-10数据集[8],可以看出:

(1) 目标尺度多样。遥感影像拍摄高度从几百米到上万米,即使是同类目标成像也大小不一。

(2) 小目标居多。VOC数据集中目标占据图像的大部分区域,而遥感影像中多为小目标。小目标携带信息量较小,而CNN采样会让信息量进一步减少甚至无法区分。

(3) 目标外观相似性。如图1所示,道路和桥梁以及篮球场和田径场场地,相似外观增加了区分的难度,此时需要利用上下文(河流和跑道)辅助目标的判别。

(4) 目标背景复杂。光学遥感影像是对全空间全天候地物信息的真实反映,目标所处的背景信息十分复杂,因此要求检测算法具有较强的抗复杂背景干扰能力。

图1 VOC2007数据集与NWPU VHR-10数据集对比Fig.1 Comparison of VOC2007 dataset with NWPU VHR-10 dataset

利用深度学习解决遥感影像目标检测问题,学者们已经做了许多工作。文献[9]在CNN中添加反卷积层融合CNN网络深层和浅层特征,用于遥感影像中建筑物的检测;文献[10]引入优化的ResNet模型解决遥感影像的显著性检测问题;文献[11]依据影像中飞机成像大小选取感受野适中的CNN特征,并采样深层CNN特征和浅层CNN特征进行叠加融合;文献[12]引入了马尔可夫随机场和全卷积神经网络生成高质量的候选区域;文献[13]融合多层CNN特征来描述遥感影像中车辆目标,并改用层级boost分类器判别取得了较好的效果;文献[14]利用CNN不同层特征分别检测不同尺度的目标,并结合上下文信息改进了检测效果;文献[15]对样本数据进行扩充并且结合目标上下文特征用于遥感影像中飞机目标的检测。可以看出:针对遥感影像中目标尺度多样性和小目标问题,融合CNN网络中不同卷积层所对应的特征,即融合CNN中浅卷积层富含的细节信息和深卷积层富含的语义信息进行特征提取是一种很好的思路[16],但采用维度拼接或逐像素相加/乘的形式融合多层特征较少考虑不同层特征的分布及尺度差异,特征融合仍是研究的难点;另外,遥感影像中背景复杂性对目标检测干扰较大,需要重点关注上下文信息对目标检测的影响。

基于上述分析,本文参考区域卷积神经网络(region convolutional neural network,R-CNN)方法的两阶段检测框架,利用混合受限玻尔兹曼机(hybrid restricted boltzmann machine,HRBM)模型,提出一种能够融合CNN多层特征和上下文信息的目标检测方法。本文的主要工作包括:一是提出细节—语义特征融合网络,构建富含细节信息和语义信息的高级目标特征表示,强化特征描述能力;二是结合上下文信息,辅助补充目标特征表示,进一步提高特征判别能力;三是采用难负样本挖掘(hard negative mining)策略,加速SVM分类器训练,有效提升模型检测性能。

1 本文算法

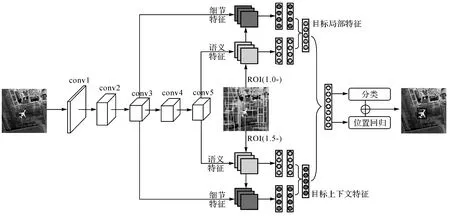

本文算法的整体结构如图2所示,算法实现主要分为4个步骤:给定一幅图像,首先利用选择性搜索(Selective Search)算法[17]生成一系列感兴趣区域(regions of interest,ROI);其次选取1.0×和1.5×的ROI区域,如图2中上下两个分支所示,作为目标局部(local)区域和目标上下文(context)区域,分别提取能够融合细节信息(conv3)和语义信息(conv5)的目标局部特征和目标上下文特征(与人类视觉类似,CNN自动学习的过程也呈分层特性,浅层如conv3学习到的特征反映物体形状、边缘、纹理等细节信息,而深层如conv5则能学习到对物体位置和尺度等敏感性更低的抽象特征,反映语义信息[18]);然后利用两层HRBM模型融合目标局部特征和目标上下文特征,获取最终用于检测的特征表示;最后将局部—上下文融合特征分别输入SVM分类器和位置回归模型,实现目标类别预测和边界框位置修正。

图2 本文目标检测模型架构示意Fig.2 The architecture of our geospatial object detection model

1.1 ROI提取

传统目标检测方法中通常利用不同尺度的滑动窗口实现“穷举”式检测目标,算法简单但存在大量冗余计算。显然,滑动窗口用于CNN目标检测,高昂的计算代价是无法接受的。因此,迫切希望能够采用一种高效的ROI提取方法。Selective Search算法是一种十分有效的ROI提取方法。算法首先通过图像分割获得超像素构成的子区域,然后利用颜色、纹理、大小等多种合并策略实现层次化的子区域合并,得到较少的可能存在目标的ROI[17]。Selective Search算法通过分割和层次化合并保证了ROI的多尺度,而多样化的合并策略则保证了ROI的多适应性。此外比较常用的ROI提取方法还有文献[19]提出的采用BING特征的Edge Box算法,以及最近提出的利用CNN特征的ROI提取方法[20-21]。本文选用Selective Search算法来生成遥感影像中的ROI。

1.2 混合受限波尔兹曼机

受限玻尔兹曼机(RBM)具有优秀的数据拟合能力,常用来描述变量间的高阶相互作用,研究人员常采用单层或多层RBM结构来提取特征。文献[22]中系统介绍了RBM模型的训练,将RBM表示为基于能量的模型,其数学形式如下

E(y,v,h;θ)=-hTWv-bTv-cTh-dTy-hTUy

(1)

式中,v=(v1,v2,…,vn)为可见层变量;h=(h1,h2,…,hm)为隐层变量;y表示样本的标签,采用独热(one-hot)编码;其余变量为系统构建参数θ=(W,U,b,c,d),W、U表示联结权重,b、c、d则分别表示可视层、隐层节点和标签层的偏差量。

那么,给定样本k,隐层和可见层变量的联合概率分布可定义为

(2)

式中,Z(θ)为归一化常量,代表整个模型系统的能量总和,用于确保将能量函数转化成有效的概率分布形式。

相应的,可以给出单个样本(v,h,y)的条件概率公式

(3)

(4)

(5)

式中,σ(x)=1/(1+exp(-x),代表sigmoid函数。

可知,RBM模型的训练目标就是通过最大化似然求解优化参数集θ。根据学习方式不同,RBM又可分为生成式模型(generative RBM,GRBM)和判别式模型(discriminative RBM,DRBM),对应目标函数定义如下

(6)

(7)

二者本质区别在于建模对象不同,GRBM可以增量学习,能够应付数据不完整的情况,而DRBM模型的优势在于容易学习且生成特征更能反映类间差异性[23]。为了结合两种模型的优点,本文采用HRBM模型,目标函数定义如下

Lhybrid(Dtrain)=αLgen(Dtrain)+Ldisc(Dtrain)

(8)

式中,α为权重参数,用来平衡Ldisc和Lgen在目标函数中的比重。

1.3 细节—语义特征融合网络

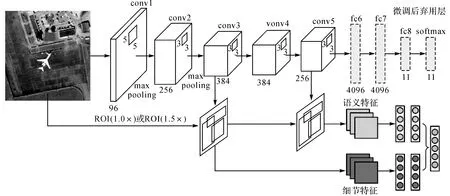

如前所述,CNN自动学习的过程呈分层特性,学习到的浅层特征反映细节信息,深层特征反映语义信息。而对于目标检测的两个子任务,分类任务希望特征更多反映语义信息,位置回归任务则希望特征更多反映细节信息,因此需要学习同时保留图像语义信息和细节信息的特征表示。如图3所示,本文设计了细节—语义特征融合网络(detail-semantic feature fusion network,D-SFN),利用HRBM模型的去噪和特征变换能力,实现CNN中细节特征和语义特征的融合。基础网络采用AlexNet模型[24],保留前5个卷积层(第1和第2卷积层后跟有池化层),各卷积层通道(channel)数分别为96、256、384、384、256。第1层卷积核尺寸(size)为5×5,其余各层卷积核size=3×3,卷积步长(stride)固定为1。池化层采用最大池化(max-pooling)方式,窗口size=2×2,stride=2。后续连接3个全连接层,用于对模型进行微调优化,在微调后将被弃用。最后一个全连接层(fc8)节点数由目标类别决定,本文为11(10类目标+背景)。

图3 细节—语义特征融合网络Fig.3 Detail-semantic feature fusion network

(9)

式中,C表示特征图的通道数,将特征重组成一维向量训练HRBM。

然后将式(9)得到的优化的conv3′和conv5′特征拼接作为可见层,训练HRBM模型ffuse,学习细节—语义融合特征Ffuse

(10)

1.4 结合上下文信息

遥感影像中的复杂背景信息对目标检测的影响是不容忽视的,本节将上下文信息引入目标检测模型以提高目标检测的精度。设图像大小w,h,ROI区域坐标(xmin,ymin,xmax,ymax),尺度比例s,定义对应上下文区域

(11)

如图2中上下两个分支所示,上面分支对应目标局部区域(1.0倍ROI),下面分支对应目标上下文区域(1.5倍ROI),分别提取融合细节—语义信息的目标局部特征和目标上下文特征。与1.3节类似,目标局部特征和上下文特征的融合也采用HRBM模型,不同之处是增加了对上下文影响的控制。将学习到的局部特征Flocal和上下文特征Fcontext拼接作为新的可见层数据训练HRBM模型,由于归一化操作会导致目标局部特征和上下文特征的激活响应相等,考虑到背景信息的复杂性,引入可学习抑制参数λ=(λ1,λ2…,λm),将上下文特征激活值分成m组分别对其进行约束(本文取m=14),得到最终的目标特征表示,本文称之为局部—上下文特征,如公式(12)所示

Fjoint=fjoint[normalize(Flocal⊕λ*Fcontext)]

(12)

式中,fjoint代表HRBM模型;λ*Fcontext表示组内逐元素(element-wise)相乘;⊕代表拼接操作。

1.5 目标分类预测与定位

本文使用线性SVM对目标特征进行判定,给出每个候选框的类别预测。对每类目标都训练一个线性SVM分类器,训练样本的采集以候选框与该类目标真实边界框的交并比(intersection over union,IoU)为依据,IoU大于0.9的候选框为正样本,IoU小于0.3的候选框为负样本,其余则忽略。由于采集到的负样本数量远远多于正样本,正负样本不均衡会导致训练的分类器产生较多误判,因此本文使用了难负样本挖掘(hard negative mining)策略[25],在训练过程中,保证正负样本比例1∶3,训练步骤如下:

(1) 使用所有的正样本,并从IoU小于0.1的负样本中随机挑选一部分训练分类器。

(2) 用训练好的分类器对所有负样本进行检测,挑出误判为目标的负样本作为难负样本。

(3) 使用所有正样本,从IoU小于0.1的负样本和步骤(2)获取的难负样本构成的集合中随机挑选一部分,重新训练分类器。

(4) 重复步骤(2)、(3),直到分类器性能不再提升。

使用难负样本挖掘策略,可以有效减少分类器误判情况,加快训练速度。同时为了提高目标定位的精度,本文利用最终获取的目标特征训练了一个线性回归模型来修正候选框的位置。

2 试验与分析

2.1 试验数据集及评价指标

本文使用试验数据来源于NWPU VHR-10遥感影像数据集,经过进一步整理得到。NWPU VHR-10由西北工业大学公开,共包含800张图像,图像采集自谷歌地球并由领域专家进行标注。数据集共包含10类目标:飞机、舰船、油罐、棒球场、网球场、篮球场、田径场、港口、桥梁和汽车。本文使用了其中650张含有目标的图像(另外150张图像为背景图像,用于半监督或弱监督学习),由于数据集中图像尺寸差异较大(最小533×597像素,而最大1728×1028像素),通过对图像进行裁剪得到仍然包含10类目标图像1172张(图像大小统一为400×400像素)。从中选取879张影像(约为数据集的75%)作为训练集,剩余的293张影像作为测试集,进行后续试验验证分析。试验环境主要包括Intel Core i7 CPU、NvidiaTitan X GPU和64 GB内存,操作系统为Ubuntu16.04 LTS。

为了定量评价试验结果,本文采用平均准确率(average precision,AP)和类别均值平均准确率(mean average precision,mAP)作为算法检测性能分析的主要指标。准确率计算的是在所有预测为正例的数据中,真正例所占的比例,如式(13)所示

(13)

式中,TP、FP分别代表预测结果中真正例、伪正例的数量,当候选框与真实框的IoU大于0.5为正例,反之为负例。

2.2 试验参数设置及优化

本文CNN特征提取模型在ImageNet数据集预训练的AlexNet模型基础上进行微调优化,最后一个全连接层节点数改为11,前面5个卷积层直接使用预训练参数,全连接层参数采用“xavier”策略进行初始化,偏置设为0。采用随机梯度下降法更新权值,并设置动量0.9,权值衰减0.000 5。设置最大迭代次数70 000次,学习率为0.001,迭代50 000次,然后学习率设为0.000 1,迭代10 000次,最后学习率设为0.000 01,再迭代10 000次。为扩充训练集,对所有训练样本图像进行旋转增强,旋转角度{20°,40°,…,340°}。

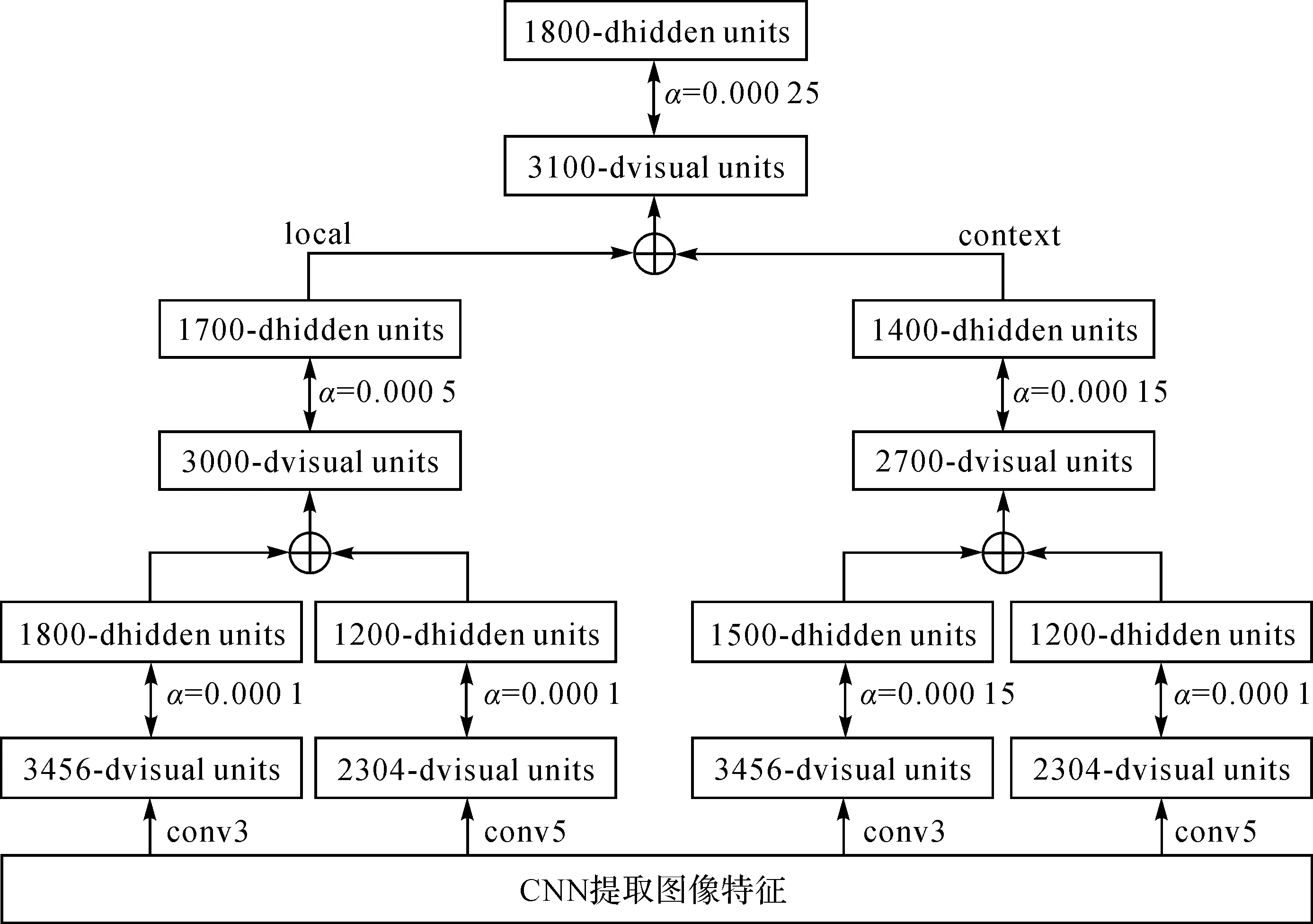

本文特征提取网络采用逐层贪婪预训练方式学习深度HRBM模型,隐层节点数量和平衡影响因子α采用交叉验证方式确定。经过试验,参数设置见图4。

图4 特征提取网络结构及参数设置Fig.4 Overall architecture and parameters of feature extraction network

2.3 算法可行性验证分析

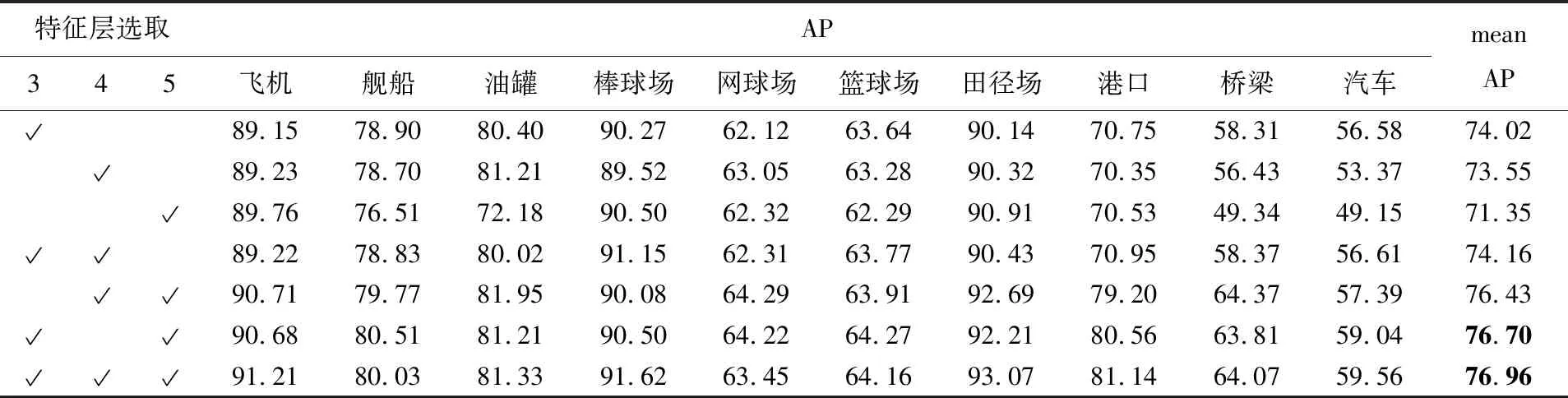

2.3.1 细节—语义特征融合试验及分析

为了验证细节—语义融合特征用于目标检测的有效性,如表1所示,设计了7组对比试验,分别选择CNN单层特征以及不同层融合特征作为目标特征表示,输入SVM分类器和回归模型进行训练,然后在测试集上测试。从测试结果可以发现,在飞机、棒球场、田径场、篮球场、网球场和港口等6类目标上使用CNN单层特征(conv3、conv4或conv5)检测精度(AP)差别不大;但在汽车、桥梁、舰船和油罐等4类目标上使用conv5层特征检测精度明显较差;相比单层特征,使用融合特征检测各类目标,检测精度有不同程度提升。表1最后一列给出了各组试验在测试集上的mAP,可以发现融合特征相比单层特征的mAP提升显著,说明多层特征融合能获得更好的特征表示。其中,融合3、4、5层特征的mAP最好,融合3、4层特征mAP提升不明显,融合3、5层特征相比融合4、5层特征检测精度有0.3的提升。考虑到多层特征融合的计算成本,本文选择融合3、5层特征,后续试验也都是基于融合3、5层特征的方式。

表1 不同层特征融合试验对比

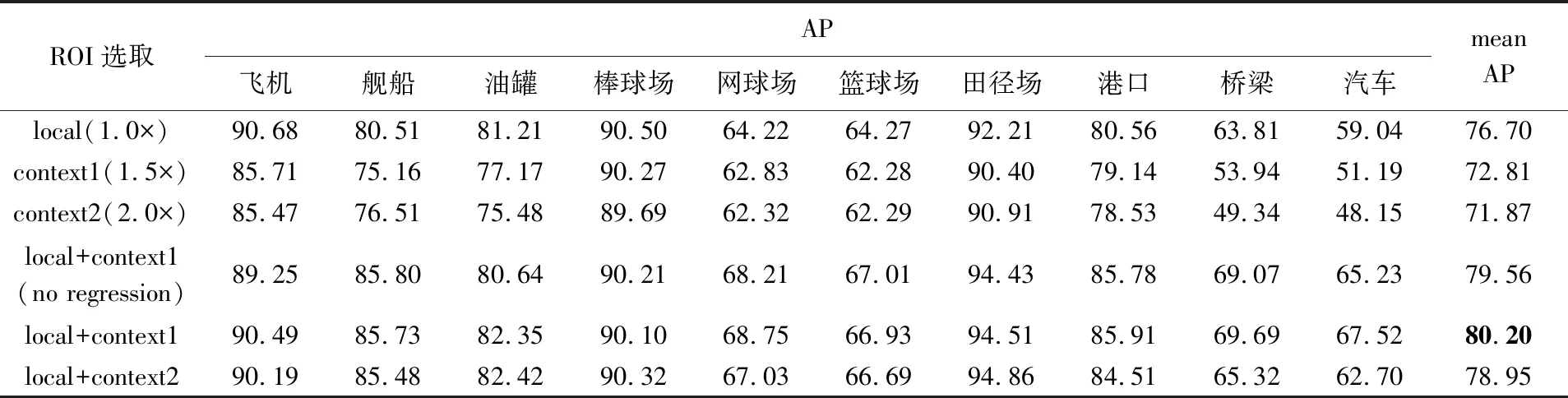

2.3.2 结合上下文试验及分析

本小节试验在2.3.1小节试验基础上进行,用于验证融合细节—语义特征后,结合上下文信息能否进一步提高算法检测精度。细节—语义特征融合采用conv3+conv5方式,如表2所示,分别取s=1.0,s=1.5和s=2.0倍的ROI进行特征采样,设计了6组对比试验。通过试验可以发现:

(1) 1、2、3组试验对比。扩大候选区域算法检测精度降低,表明候选区域过大会导致不能有效提取目标特征。此外,可以发现候选区域变化对油罐、汽车等小目标检测精度影响较大,表明上下文信息对小目标检测尤为重要。

(2) 1、2、5组试验对比。针对网球场、篮球场、田径场、港口、桥梁和汽车等目标,使用局部—上下文联合特征检测效果提升显著,表明引入上下文信息能进一步增强了目标特征表示的判别能力。

(3) 4、5组试验对比。试验差别在于边界框位置回归使用特征不同,第4组仅使用目标局部特征,而第5组使用局部—上下文特征。两组试验在测试集上检测精度相差只有0.7个百分点,说明本文算法提取的上下文信息对位置回归影响不大。

(4) 5、6组试验对比。上下文区域过大算法检测精度降低。说明由于目标背景的复杂性,目标特征表示中上下文信息占比不宜过大/过多,以免产生干扰。根据试验结果,本文选用上下文区域的比例s=1.5。

表2 结合上下文试验对比

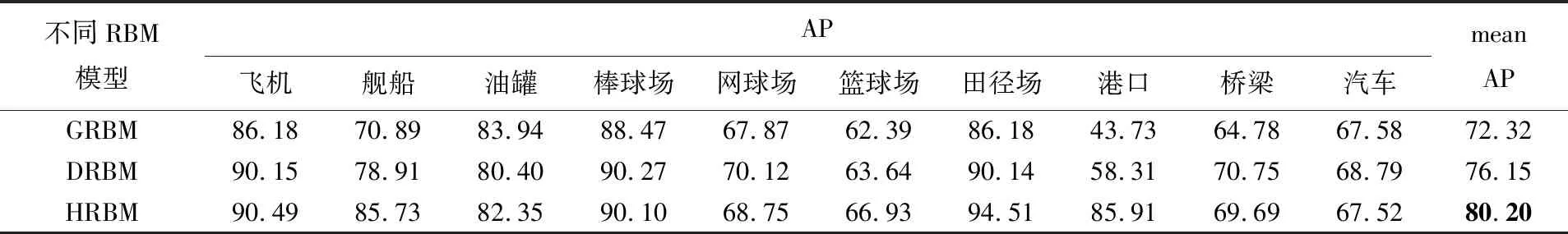

2.3.3 不同RBM模型对比

本节试验用于验证不同RBM模型对特征融合的影响,由于特征提取网络包含多个RBM模型,为了保证公平性,试验算法主干网络保持一致,仅修改目标局部特征和上下文特征融合RBM模型(即图2中最后一层RBM模型),分别使用GRBM、DRBM和HRBM模型。训练好的模型在测试集上的检测结果如表3所示,可以看出使用DRBM模型的检测精度要好于使用GRBM模型,而使用HRBM模型的检测精度要显著优于GRBM和DRBM模型。试验结果表明HRBM模型确实能够综合GRBM模型和DRBM模型各自的优势,更好地实现特征融合。

表3 不同RBM模型(局部—上下文特征融合)测试结果对比

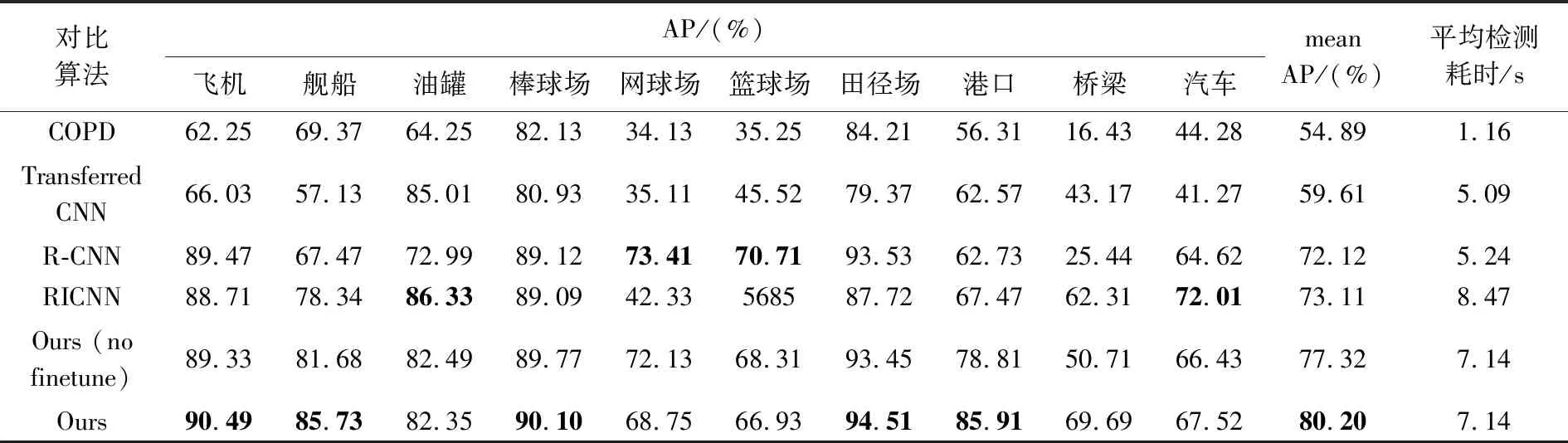

2.3.4 与其他方法对比试验

为进一步验证本文方法有效性,将本文方法与几种已有方法进行对比:COPD[8]、Transferred CNN[24]、RICNN[26]和R-CNN[2]。为保证试验可比性,几种方法参照原有训练参数设置,在本文的训练集上重新训练。如表4所示,是几种方法在测试集上的测试结果,其中文本加粗项代表本类目标最高检测精度。本文方法在飞机、舰船、棒球场、田径场、港口和桥梁等6类目标的AP值均为最高,特别是对舰船、港口和桥梁3类目标的检测效果相比对比方法提高显著。从整体看,本文方法mAP超过对比方法至少6个百分点,充分验证了本文方法的有效性。此外,试验6是未经过微调而直接使用预训练AlexNet模型提取特征的试验结果,与试验7的mAP相差近3个百分点,这也证明了自然图像和遥感影像数据存在较大差异,表明针对任务数据的微调十分必要。表中最后一列给出了几种方法检测单张图像所需时间,相比对比方法,本文方法由于利用多层RBM模型提取特征,检测耗时有所增加。

表4 对比算法和本文算法在测试集上性能比较

如图5所示,是本文方法在测试集部分图像上的检测结果,其中红色框代表真正例目标(正确检测),绿色代表伪正例目标(误判),黄色代表伪负例目标(漏判)。边界框左上角数字1—10代表预测类别,依次为:飞机、舰船、油罐、棒球场、网球场、篮球场、田径场、港口、桥梁和汽车。从图中可以看出:影像中10类目标的尺度差异很大(田径场等目标充满整幅图像,而汽车、舰船等目标仅占图像很小范围);同类目标纹理形状差异较大,而不同类目标却存在一定相似性;目标分布在复杂的背景中。面对这些挑战,本文方法能够成功检测出图像中大部分的目标,检测性能稳定,证明了本文方法的有效性。

3 结 论

本文设计了基于CNN和HRBM的一体化特征提取网络,用于生成融合细节—语义信息和上下文信息的目标特征表示,融合细节—语义特征解决目标尺度多样性和小目标问题,结合上下文信息解决目标外观相似和背景复杂问题。通过在10类目标构成的NWPU数据集上进行比较试验,验证了本文方法的有效性。尽管本文方法在测试集上检测效果提升显著,相比对比方法提高6个百分点以上,但仍存在一些问题没有解决:①检测较为耗时,本文方法虽然检测精度有了明显提高,但计算量相对较大;②上下文利用不够,如图5中飞机、油罐等目标的分布存在一定的线性、集聚特点,更好地利用这些特点可能进一步提高检测精度。后续工作中将研究候选区域生成方法,提高候选区域生成质量并减少计算量,同时深入挖掘上下文信息应用,探索目标间分布关联关系以及上下文信息在位置回归中的利用,进一步提高光学遥感影像目标检测的精度。