光学遥感图像目标检测技术综述

李晓斌 江碧涛 杨渊博 傅雨泽 岳文振

光学遥感图像目标检测技术综述

李晓斌1,2江碧涛1杨渊博1傅雨泽1岳文振1

(1 北京市遥感信息研究所,北京 100192)(2 清华大学电子工程系,北京 100084)

目标检测是光学遥感图像分析的重要内容,是将图像数据转化为应用成果的关键一环。文章重点针对光学遥感图像中常见的飞机、舰船等目标,对目标检测技术进行了系统总结,并对未来重点发展方向进行了展望。重点论述的内容包括目标检测方法、目标检测性能评价准则和数据集,其中对于目标检测方法,从候选区域选择、特征学习、分类和后处理等四个方面进行了详细介绍。期望这些技术成果的总结分析和展望对目标检测技术的应用提供一定的借鉴和参考。

目标检测方法 飞机检测 舰船检测 分类 遥感图像

0 引言

按成像谱段不同,光学遥感图像可分为可见光、红外和高光谱图像。光学遥感图像目标检测是指利用特定的算法从图像中搜索并标记出感兴趣的目标,包括建筑物、道路、飞机、舰船和车辆等。目标检测是光学遥感图像分析的重要内容,是城市规划、土地利用、机场和港口监测等应用的重要基础。近年来,光学遥感成像技术迅猛发展,Pleiades、WorldView-3、“高分二号”、“高景一号”等光学遥感卫星相继发射,源源不断地提供着海量高分辨率图像,为目标检测技术的发展带来了新的机遇和挑战。所谓机遇是指海量图像为目标检测技术的发展提供了重要的数据源;挑战是指图像分辨率越来越高,需要检测的目标越来越多,同时图像背景也越来越复杂,使得检测难度变大。

得益于应用前景的推动和海量数据的支持,近年来涌现了大量有关光学遥感图像目标检测技术的研究成果。其中不乏综述性的文献[1-5],但这些文献多是十年前的且主要针对单一目标。例如,文献[1]、[2]聚焦于建筑物目标,文献[3]、[4]则只针对道路目标。文献[5]是比较新的综述性文献,针对建筑物、道路、飞机、舰船和车辆等多类目标,但主要还是建筑物和道路。文献[5]重点对基于模板匹配、基于知识、基于目标分析和基于机器学习的目标检测方法进行了系统总结,但只将近年来兴起的基于深度学习的方法作为发展方向提出而未作详细介绍。

与以上研究不同的是,本文重点针对飞机、舰船等目标,从目标检测方法、检测性能评价准则和数据集等方面对目标检测技术的最新研究进展进行了系统综述。其中,对于目标检测方法中的最为关键的特征学习,从浅层特征、中层特征和深度特征三个方面进行了详细阐述,涵盖了基于深度学习的特征学习等最新技术。此外,对未来目标检测技术的发展方向进行了展望,期望能对该领域的后续研究提供借鉴和参考,并对目标检测技术发展起到促进作用。

1 目标检测方法

目标检测主要包括候选区域提取、特征学习、分类和后处理4个环节以及训练和测试两个阶段,如图1所示。

其中,候选区域提取为训练和测试两个阶段所共用,其主要作用是从输入图像中提取可能的目标区域,降低后续的特征学习和分类的工作量。特征学习的主要目的是训练特征学习器,提取目标和背景特征,用于准确区分目标和背景。在训练阶段,利用训练图像调整特征学习器的参数;在测试阶段,训练好的特征学习器用于提取目标和背景特征。分类所做的工作是根据特征区分目标和背景,当目标和背景被区分开时,相当于检测出了目标。在训练阶段,利用训练数据调整分类器的参数;在测试阶段,训练好的分类器被用于区分目标和背景。后处理环节有时包含在分类环节中,其主要作用是根据分类结果,将检测到的目标标记在输入图像上。在标记之前,一般需要去除重复的检测结果以降低虚警。

1.1 候选区域提取

在候选区域提取过程中,传统的滑窗(Sliding Window)方法已经很少使用,因为这种方法会产生大量的候选区域,这不仅会增加后续的计算量,还可能导致虚警的增加。目前常用的候选区域提取方法可分为三类:基于视觉显著性(Visual Saliency)[6]的方法、基于选择性搜索(Selective Search)[7]的方法和基于阈值分割的方法。严格意义上讲,前两种方法都属于基于阈值分割的方法,但考虑到这两种方法自成体系且应用广泛,本文将其单独归类。从发展趋势来看,前两种方法更有前途。

(1)基于视觉显著性的方法

人类视觉系统在面对大量信息时,会利用视觉显著性迅速聚焦到感兴趣的区域而忽略背景,这一原理被广泛应用于自然图像目标检测[6,8],并取得了良好的效果。在光学遥感图像目标检测领域,视觉显著性也被广泛使用[9-14],用于快速提取可能包含目标的候选区域。

文献[9]、[10]借鉴文献[8]的方法,利用二值化梯度幅值(Binarized Normed Gradients,BING)特征进行飞机检测。目标一般具有明确的边界,当目标图像被缩小到一个较小的尺寸(例如8像素×8像素)并计算其BING特征时,会表现出良好的相似性和鉴别性。相似性是指所有的目标的BING特征很相似,鉴别性是指目标和背景的BING特征不同。文献[8]利用BING特征计算目标的显著性,其基本原理为:先利用不同尺寸(大小和长宽比)的窗口扫描图像,然后利用式(1)计算每个窗口的分值,

式中s、g、、和(,)分别为窗口的分值、BING特征、索引、尺寸和位置;是一个通过训练得到的64维的线性模型,表征的是BING特征和分值之间的关系。利用非最大化抑制(Non-maximal Suppression,NMS),可以去掉一些尺寸不合常理(例如太大或太小、长宽差别太大)的窗口。最后,利用式(2)得到目标的显著性o,

式中k和t分别为训练得到的尺寸下的系数和偏置。得到o后,可以判断每个窗口包含的是目标还是背景,o越大,窗口中包含目标的可能性越大。

文献[11]综合利用颜色、方向和梯度等信息计算视觉显著性,并据此提取候选舰船目标。文献[12]-[14]在检测飞机、舰船和红外弱小目标时,本质上都是先使用了傅里叶变换提取候选区域。其中,文献[14]利用了傅里叶变换的相位谱计算视觉显著性,这种方法简单且有效。

(2)基于选择性搜索的方法

选择性搜索算法在自然图像目标检测中获得了广泛应用[15-16]。该方法是一种穷尽搜索方法,旨在搜索到图像中所有可能的目标,从而提取出候选区域。为实现这一目标,算法设计时遵循了以下原则[7]:搜索所有尺寸的目标、采用多样化的分割策略、力求快速搜索。在选择性搜索算法中,分割是最为核心的环节。分割时使用的相似性度量为

虽然选择性搜索算法广泛应用于自然图像目标检测,但在光学遥感图像目标检测中的应用还处于起步阶段。目前比较新的光学遥感图像目标检测方法已经开始使用选择性搜索进行候选区域提取[17-18]。从选择性搜索算法的良好性能和发展趋势来看,基于该算法的候选区域提取方法将会在光学遥感图像目标检测中得到越来越广泛的应用。

(3)基于阈值分割的方法

基于阈值分割方法的基本思想是利用目标和背景在灰度值、颜色、纹理等方面的差异,寻找合适的阈值将目标和背景区分开。文献[19]首先利用大津法进行水陆分割,然后使用边缘检测算子检测边缘,最后根据检测的边缘提取候选舰船目标。文献[20]同样利用大津法分割水陆,然后使用线分割检测器检测线状目标,并将这些目标作为候选舰船。为了克服大津法存在的分割阈值偏高的问题,文献[21]提出一种基于轮廓模型的能量函数,采用迭代全局优化的策略实现水陆分割。文献[22]、[23]分别利用统计高斯模型和类内类间方差获得最优阈值用于水陆分割。

从以上文献可以看出,基于阈值分割的方法的核心是利用特定的算法进行水陆分割,然后在此基础上检测舰船。总的来看,基于阈值分割的方法的应用场景受限,一般只用于舰船检测。

1.2 特征学习

特征学习是目标检测的核心环节,特征的好坏直接决定了目标检测性能的优劣。好的特征应具有鉴别性,即能更好地区分目标和背景,且应具有平移不变、旋转不变和尺度不变等鲁棒特性。

用于目标检测的特征可分为3类:浅层特征、中层特征和深度特征。浅层特征是像素级别的特征,从图像像素中直接提取,因此易受像素变化的影响,鲁棒性较差。当光照、大气、光学系统、传感器等条件发生变化时,目标图像的灰度值也会发生变化,进而引起特征的变化。中层特征是在浅层特征的基础上得到的,是浅层特征的组合。中层特征包含了更多的信息,除了包含浅层特征外,还会引入先验信息、上下文信息和稀疏信息等,因此具有更好的鉴别性和鲁棒性。深度特征是指通过深度神经网络学习得到的特征。在深度神经网络中,越深层提取的特征越全局、越抽象,包含的信息越多,从而越能表征目标。例如,网络的浅层提取的是目标局部的边缘等特征,深层提取的是目标部件特征,更深层提取的是目标全局的轮廓[24]。

1.2.1 浅层特征

浅层特征主要包括纹理特征和形状特征。文献[11]利用局部二值模式(Local Binary Pattern,LBP)检测舰船,本质上使用的是纹理特征。文献[19]、[20]基于舰船的形状,通过检测直线的方式检测舰船,利用的是形状特征,不同的是,前者使用的是改进的霍夫(Hough)变换,后者使用的是直线分割方法。文献[21]主要利用船头、船身宽度和长度等形状特征实现舰船检测。文献[23]同样使用形状和纹理特征检测舰船,所用形状特征包括紧凑度、偏心度和不变矩等,所用纹理特征包括小波基特征、多尺度高斯差分特征和局部多模式等。

浅层特征的表征能力有限,一般只适用于目标形状简单、背景单一的场合,例如舰船目标检测。

1.2.2 中层特征

在光学遥感图像目标检测中,常用的中层特征包括:方向梯度直方图(Histogram of Oriented Gradients,HOG)特征、稀疏表征和部件模型。稀疏表征是对特征(例如HOG特征)进行稀疏编码,提高其稀疏性;部件模型是对特征进行组合,引入先验信息和上下文信息。

(1)HOG特征

HOG特征最早被用于行人检测[25],后来在光学遥感图像目标检测中获得了广泛应用[26-28]。HOG特征集成了纹理信息和局部形状信息,其基本思想是:在一幅图像中,局部目标的表观和形状能够被梯度或边缘的方向密度分布很好地描述。HOG特征的主要提取步骤如下:1)图像灰度化;2)采用Gamma校正对图像进行颜色空间的标准化;3)计算图像每个像素的梯度;4)将图像划分成细胞;5)统计每个细胞的梯度直方图,形成特征描述符;6)将多个细胞组成一个块,一个块内所有细胞的特征描述符串联起来便得到该块的HOG特征;7)将图像内的所有块的HOG特征串联起来就可以得到该图像的HOG特征[25]。

文献[26]将圆频率特征和HOG特征组合在一起进行舰船目标检测,文献[27]联合HOG特征和LBP特征进行建筑物检测,文献[28]利用HOG特征检测车辆。HOG特征在光学遥感图像目标检测中有比较广泛的应用,但从其提取步骤可以看出,HOG特征不具备旋转不变性,将其应用于光学遥感图像目标检测时需要充分考虑这一点。

(2)稀疏表征

(3)部件模型

部件模型将目标表示为部件的组合,充分考虑了部件间的位置关系和空间布局,增加了特征的语义信息。文献[31]、[32]利用基于HOG特征的部件模型[33]实现飞机目标检测。由于部件模型还考虑了变形和旋转,因此在目标检测中表现出了较好的鲁棒性,在深度神经网络出现之前一度在目标检测领域占据了主导地位。

除了HOG特征、稀疏表征和部件模型之外,还有其它一些中层特征。例如,文献[34]、[35]提出了新颖的特征用于飞机检测,前者提出的旋转不变矩阵特征,充分利用了局部角度空间信息、径向空间信息和空间分布信息;后者提出的聚合通道特征聚合了颜色、归一化梯度幅值和方向梯度直方图三种信息。值得一提的是,对于建筑物检测,阴影是一种很重要的上下文特征[36-37]。

总的来看,中层特征通过对特征进行编码和组合,实现了对目标的有效表征,在光学遥感图像目标检测中表现出了比较优异的性能,目前仍是比较常用的检测特征。

1.2.3 深度特征

近年来,深度学习成为人工智能领域的研究热点[24],在自然语言处理、自然图像处理、棋牌游戏等领域取得了巨大成功。深度学习的本质是深度神经网络,包括深度信念网络(Deep Belief Network,DBN)、卷积神经网络(Convolutional Neural Network,CNN)、循环神经网络(Recurrent Neural Network,RNN)和生成式对抗网络(Generative Adversarial Network,GAN)等。从2012年开始,深度神经网络在自然图像分类[38]和目标检测[39]中获得了压倒性优势,并在光学遥感图像目标检测[9,17,18,40,43-45]中得到了越来越广泛的应用。光学遥感图像目标检测常用的深度神经网络主要是DBN和CNN。

(1)DBN

DBN由多个受限玻尔兹曼机(Restricted Boltzmann Machine,RBM)组成,在训练DBN时,需要先对各层RBM进行预训练,然后利用后向传播算法对整个DBN进行调优。在预训练RBM时,需要对其能量函数求导以便更新其权重。能量函数如下:

(2)CNN

CNN的主要组成部分是卷积层,以经典的AlexNet为例[41],它包括5个卷积层和2个全连接层,这些层使用的激活函数是校正线性单元(Rectified Linear Unit,ReLU),具体形式为:

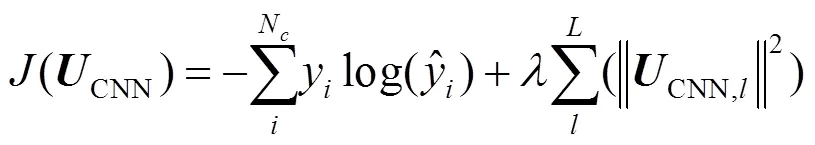

式中y和x分别为位置(,)处的神经元的输出和输入。在第1、第2和第5个卷积层后各跟一个最大池化层。CNN通过最小化目标函数来更新其权重CNN:

相比DBN,CNN在光学遥感图像目标检测中的应用更广泛。这些CNN有的是在经典网络的基础上改造的,有的是全新设计的。文献[17]在AlexNet的基础上,设计了一个旋转不变CNN用于目标检测,该CNN的前7层与AlexNet相同,在第7层的后面增加了一个旋转不变层。文献[18]的CNN是在AlexNet和GoogleNet[42]的基础上修改得到的,将AlexNet的第二个全连接层的维数由4096改为64,在GoogleNet的最后一个卷积层的后面增加了一个64维的层。文献[43]设计了一个混合CNN用于车辆检测,文献[44]利用AlexNet实现油罐检测。与其它文献不同的是,文献[45]在训练CNN时,不是采用监督训练而是弱监督训练。弱监督训练不需要在训练样本中标记出目标的准确位置,只需要知道样本中是否有目标,因此可以省掉样本标记这一繁重的工作,是一种很有前途的目标检测方法。

尽管CNN在光学遥感图像目标检测中应用广泛且性能较好,但现有方法大多是基于已有的经典CNN改造的。与自然图像相比,遥感图像有其自身的特点,包括幅面大、目标方向多变等。因此,如何针对光学遥感图像目标检测的特点有针对性地设计CNN,是研究者需要考虑的一个问题。

1.3 分类和后处理

分类的目的是将目标和背景区分开,从而实现目标检测。分类之前需要利用特征和标签数据训练分类器,建立目标特征和目标类别之间的关系。根据已有文献,光学遥感图像目标检测中使用的分类方法主要有3种:支持向量机(Support Vector Machine,SVM)、回归和自适应增强(Adaptive Boosting,AdaBoost)[23,26,31,32,40]。

(1)SVM分类

SVM是一种二类分类器,其分类策略是使待分类样本在特征空间上的间隔最大,可以转化为一个凸二次规划问题的求解。SVM良好的分类性能使其成为使用最广泛的分类器之一。SVM分类器在光学遥感图像目标检测中的应用比较广泛,且可以与不同的特征联合使用。例如,文献[23]将浅层特征输入到SVM分类器进行舰船检测,文献[31]、[32]利用中层特征和SVM进行飞机检测,而文献[17]利用深度特征和SVM进行目标检测。

(2)回归分类

为了进行监督学习,深度神经网络的最后一层是一个回归层,这个回归层跟随网络的其它层一起训练,训练完成后即成为一个分类器。在基于深度特征的光学遥感图像目标检测方法中,常用的回归有两种,即逻辑回归和软最大回归。例如,文献[40]、[43]使用的是逻辑回归,文献[46]使用的是软最大回归。

(3)AdaBoost分类

AdaBoost的核心思想是将多个弱分类器组合得到一个强分类器。具体做法是在每一轮训练中加入一个新的弱分类器,直到达到某个预定的足够小的错误率。在训练过程中,AdaBoost注重那些被错分的样本,如果某一个样本被错分,那么在下一轮训练中它会被以较高的概率选中。与SVM分类和回归分类不同,AdaBoost一般与浅层特征或中层特征联合使用,例如文献[26]利用AdaBoost进行舰船检测,未见其与深度特征联合使用。

2 检测性能评价准则和数据集

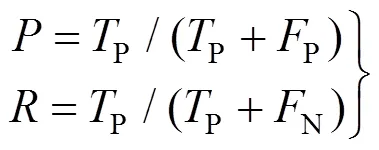

光学遥感图像目标检测常用的评价准则主要是精度和召回率,定义如下:

式中为精度;为召回率;p指本身是目标并被正确地检测为目标的目标的数量;p指本身不是目标但被错误地检测为目标的目标的数量;N指本身是目标但没有被检测为目标的目标的数量。以召回率为横坐标、精度为纵坐标画出的曲线称为精度–召回率曲线(Precision-Recall Curve,PRC),PRC下的面积称为平均精度(Average Precision,AP)。

光学遥感图像目标检测常用数据集包括:UCMerced 数据集[47]、NWPU VHR-10 数据集[48]、Aircraft 数据集[49]、SZTAKI-INRIA 数据集[50]、TAS 数据集[51]、OIRDS 数据集[52]等。除了使用这些数据集之外,多数研究者还使用自己从GoogleEarth收集的数据或购买的QuickBird等卫星数据。

UCMerced 数据集为土地利用数据集,主要用于遥感图像分类,也被用于目标检测。该数据集中的图像为机载图像,包含飞机、港口、建筑物、停车场等21类目标,每类目标有100幅图像,图像大小为256像素×256像素,空间分辨率30cm。NWPU VHR-10数据集主要收集自GoogleEarth,共有800幅图像,包含飞机、舰船、港口、桥梁、交通工具等10类目标。Aircraft 数据集收集自GoogleEarth,只包含飞机目标。训练集中包含500个正样本和5 000个负样本,测试集中共有26幅图像,其中含有453个飞机目标。SZTAKI-INRIA 数据集为建筑物数据集,其中的数据主要来自于GoogleEarth、IKONOS和QuickBird。TAS数据集收集自GoogleEarth,只包含车辆目标,共有30幅图像,其中含有1 319个车辆目标。OIRDS数据集为车辆数据集,共有900幅图像,空间分辨率为0.1~0.3m。研究者可根据自己的研究需要从以上数据集中进行选择。

3 结束语

近年来,在人工智能、机器学习以及自然图像目标检测相关技术的牵引下,涌现出了大量遥感图像目标检测方面的成果,但其中的绝大多数成果还停留在实验阶段,距离工程应用还有一定的差距。同时,遥感图像数据量的增大以及空间分辨率的提高,对目标检测提出了新的挑战。因此,光学遥感图像目标检测技术还有很大的发展空间,根据上述对众多研究成果的分析,本文认为在遥感图像目标检测技术领域有以下三个重点发展方向。

1)注重借鉴机器学习和自然图像目标检测领域的最新技术。纵观本文可以发现,遥感图像目标检测技术大量借鉴了机器学习,特别是自然图像目标检测领域的成果,例如视觉显著性、HOG特征、稀疏编码、深度学习等。以上技术起初均是应用于自然图像目标检测,由于自然图像和遥感图像存在很多相似之处,因此很多技术可以轻易移植过来。在光学遥感图像目标检测技术的后续发展过程中,应继续借鉴机器学习和自然图像目标检测领域的最新技术,同时根据遥感图像目标检测的特点进行方法创新。

2)加强基于弱监督学习、无监督学习和迁移学习的目标检测技术研究。深度神经网络在人工智能领域取得的巨大成功在很大程度上依赖于大量的训练样本,因为目前的深度神经网络主要是基于有监督学习的。有监督学习需要大量的训练样本,而训练样本的制作需要耗费大量人力物力,而且有时甚至是不可行的。基于弱监督[53]和无监督[54]的深度学习方法是未来的发展方向,目前已有基于弱监督学习和无监督学习的光学遥感图像目标检测方法[45]并取得了初步成果。另外,迁移学习也是一个重要的发展方向[55]。迁移学习的目标是让计算机像人一样具有思考和推理的能力,像人一样能够高效地将已经掌握的知识迁移到其它领域。尽管计算机在很多方面已经达到甚至超过人类的水平,但其迁移学习能力还远不及人类。近年来,迁移学习逐渐兴起并取得了初步成果,使计算机初步具备了推理[56]和“一眼”检测等能力。

3)建立权威的大规模数据集,促进目标检测技术的发展和应用。在自然图像分类和目标检测领域,存在多个权威的大规模数据集[57-58],这些数据集在技术发展过程中发挥了重要的推动作用。它们一方面为技术研究提供了充足的训练和测试数据,另一方面为算法性能的评价和比较提供了公开公平的平台。虽然已有部分光学遥感图像目标数据集,但这些数据集的规模、全面性和权威性还远远不够。多数研究者在评价光学遥感图像目标检测结果时使用的是自己收集的数据,而且研究者一般不公开这些数据,这严重影响了检测结果的可比性和可信性。另外,技术在投入实际应用之前,需要在大规模数据集上进行系统的测试和评价。为促进光学遥感图像目标检测技术的发展和应用,迫切需要相关大学或科研院所组织建立光学遥感图像目标检测方面的大规模数据集。

[1] MAYER H. Automatic Object Extraction from Aerial Imagery—A Survey Focusing on Buildings[J]. Computer Vision and Image Understanding, 1999, 74(2): 138-149.

[2] SHUFELT J A. Performance Evaluation and Analysis of Monocular Building Extraction from Aerial Imagery[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1999, 21(4): 311-326.

[3] MAYER H, HINZ S, BACHER U, et al. A Test of Automatic Road Extraction Approaches[C]//The International Archives of the Photogrammetry, Remote Sensing and Spatial Information Sciences 36 (Part3). 2006: 209-214.

[4] MENA J B. State of the Art on Automatic Road Extraction for GIS Update: A Novel Classification[J]. Pattern Recognition Letters, 2003, 24(16): 3037-3058.

[5] CHENG G, HAN J W. A Survey on Object Detection in Optical Remote Sensing Images[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2016, 117: 11-28.

[6] ITTI L, KOCH C. A Saliency-based Search Mechanism for Overt and Covert Shifts of Visual Attention[J]. Vision Research, 2000, 40(10-12): 1489-1506.

[7] UIJLINGS J R R, VAN DE SANDE K E A, GEVERS T, et al. Selective Search for Object Recognition[J]. International Journal of Computer Vision, 2013, 104(2): 154-171.

[8] CHENG M M, ZHANG Z M, LIN W Y, et al. BING: Binarized Normed Gradients for Objectness Estimation at 300fps[C]//2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus, OH, USA: IEEE, 2014: 3286-3293.

[9] DIAO W H, SUN X, ZHENG X W, et al. Efficient Saliency-based Object Detection in Remote Sensing Images Using Deep Belief Networks[J]. IEEE Geoscience and Remote Sensing Letters, 2016, 13(2): 137-141.

[10] ZHENG J B, XI Y, FENG M C, et al. Object Detection Based on BING in Optical Remote Sensing Images[C]//2016 9th International Congress on Image and Signal Processing, BioMedical Engineering and Informatics (CISP-BMEI). Datong, China: IEEE, 2016: 504-509.

[11] SONG Z N, SUI H G, WANG Y J. Automatic Ship Detection for Optical Satellite Images Based on Visual Attention Model and LBP[C]//2014 IEEE Workshop on Electronics, Computer and Applications. Ottawa, ON, Canada: IEEE, 2014: 722-725.

[12] ZHANG L B, ZHANG Y Y. Airport Detection and Aircraft Recognition Based on Two-layer Saliency Model in High Spatial Resolution Remote-sensing Images[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2017, 10(4): 1511-1524.

[13] DING Z H, YU Y, WANG B, et al. An Approach for Visual Attention Based on Biquaternion and its Application for Ship Detection in Multispectral Imagery[J]. Neurocomputing, 2012, 76(1): 9-17.

[14] QI S X, MA J, TAO C, et al. A Robust Directional Saliency-based Method for Infrared Small-target Detection under Various Complex Backgrounds[J]. IEEE Geoscience and Remote Sensing Letters, 2013, 10(3): 495-499.

[15] GIRSHICK R, DONAHUE J, DARRELL T, et al. Rich Feature Hierarchies for Accurate Object Detection and Semantic Segmentation[C]//2014 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Columbus, OH, USA: IEEE, 2014: 580-587.

[16] HE K M, ZHANG X Y, REN S Q, et al. Spatial Pyramid Pooling in Deep Convolutional Networks for Visual Recognition[J]//Computer Vision – ECCV 2014. [S.l.]: Springer International Publishing, 2014: 346-361.

[17] CHENG G, ZHOU P C, HAN J W. Learning Rotation-invariant Convolutional Neural Networks for Object Detection in VHR Optical Remote Sensing Images[J].IEEE Transactions on Geoscience and Remote Sensing, 2016, 54(12): 7405-7415.

[18] LONG Y, GONG Y P, XIAO Z F, et al. Accurate Object Localization in Remote Sensing Images Based on Convolutional Neural Networks[J]. IEEE Transactions on Geoscience and Remote Sensing, 2017, 55(5): 2486-2498.

[19] XU J, SUN X, ZHANG D B, et al. Automatic Detection of Inshore Ships in High-resolution Remote Sensing Images Using Robust Invariant Generalized Hough Transform[J]. IEEE Geoscience and Remote Sensing Letters, 2014, 11(12): 2070-2074.

[20] LIN J L, YANG X B, XIAO S J, et al. A Line Segment Based Inshore Ship Detection Method[C]//Future Control and Automation: Proceedings of the 2nd International Conference on Future Control and Automation (ICFCA 2012), Volume 2. Berlin Heidelberg: Springer, 2012: 261-269.

[21] LIU G, ZHANG Y S, ZHENG X W, et al. A New Method on Inshore Ship Detection in High-resolution Satellite Images Using Shape and Context Information[J]. IEEE Geoscience and Remote Sensing Letters, 2014, 11(3): 617-621.

[22] TANG J X, DENG C W, HUANG G B, et al. Compressed-domain Ship Detection on Spaceborne Optical Image Using Deep Neural Network and Extreme Learning Machine[J]. IEEE Transactions on Geoscience and Remote Sensing, 2015, 53(3): 1174-1185.

[23] ZHU C R, ZHOU H S, WANG R, et al. A Novel Hierarchical Method of Ship Detection from Spaceborne Optical Image Based on Shape and Texture Features[J]. IEEE Transactions on Geoscience and Remote Sensing, 2010, 48(9): 3446-3456.

[24] LECUN Y, BENGIO Y, HINTON G E. Deep Learning[J]. Nature, 2015, 521: 436-444.

[25] DALAL N, TRIGGS B. Histograms of Oriented Gradients for Human Detection[C]//2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Diego, CA, USA: IEEE, 2005: 886-893.

[26] SHI Z W, YU X R, JIANG Z G, et al. Ship Detection in High-resolution Optical Imagery Based on Anomaly Detector and Local Shape Feature[J]. IEEE Transactions on Geoscience and Remote Sensing, 2014, 52(8): 4511-4523.

[27] KONSTANTINIDIS D, STATHAKI T, ARGYRIOU V, et al. Building Detection Using Enhanced HOG–LBP Features and Region Refinement Processes[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2017, 10(3): 888-905.

[28] TUERMER S, KURZ F, REINARTZ P, et al. Airborne Vehicle Detection in Dense Urban Areas Using HOG Features and Disparity Maps[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2013, 6(6): 2327-2337.

[29] ZHANG Y X, DU B, ZHANG L P. A Sparse Representation-based Binary Hypothesis Model for Target Detection in Hyperspectral Images[J]. IEEE Transactions on Geoscience and Remote Sensing, 2015, 53(3): 1346-1354.

[30] ZHANG Y X, ZHANG L P, DU B, et al. A Nonlinear Sparse Representation-based Binary Hypothesis Model for Hyperspectral Target Detection[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2015, 8(6): 2513-2522.

[31] CHENG G, HAN J W, GUO L, et al. Object Detection in Remote Sensing Imagery Using a Discriminatively Trained Mixture Model[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2013, 85: 32-43.

[32] ZHANG W C, SUN X, WANG H Q, et al. A Generic Discriminative Part-based Model for Geospatial Object Detection in Optical Remote Sensing Images[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2015, 99: 30-44.

[33] FELZENSZWALB P F, GIRSHICK R B, MCALLESTER D, et al. Object Detection with Discriminatively Trained Part-based Models[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2010, 32(9): 1627-1645.

[34] WANG G L, WANG X C, FAN B, et al. Feature Extraction by Rotation-invariant Matrix Representation for Object Detection in Aerial Image[J]. IEEE Geoscience and Remote Sensing Letters, 2017, 14(6): 851-855.

[35] ZHAO A, FU K, SUN H, et al. An Effective Method Based on ACF for Aircraft Detection in Remote Sensing Images[J]. IEEE Geoscience and Remote Sensing Letters, 2017, 14(5): 744-748.

[36] OK A O, SENARAS C, YUKSEL B. Automated Detection of Arbitrarily Shaped Buildings in Complex Environments from Monocular VHR Optical Satellite Imagery[J]. IEEE Transactions on Geoscience and Remote Sensing, 2013, 51(3): 1701-1717.

[37] OK A O. Automated Detection of Buildings from Single VHR Multispectral Images Using Shadow Information and Graph Cuts[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2013, 86: 21-40.

[38] SIMONYAN K, ZISSERMAN A. Very Deep Convolutional Networks for Large-scale Image Recognition[C]//Proceedings of ICLR 2015. 2015: 1-13.

[39] REN S Q, HE K M, GIRSHICK R, et al. Faster R-CNN: Towards Real-time Object Detection with Region Proposal Networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 39(6): 1137-1149.

[40] CHEN X, XIANG S, LIU C L, et al. Aircraft Detection by Deep Belief Nets[C]//2013 2nd IAPR Asian Conference on Pattern Recognition. Naha, Japan: IEEE, 2013: 54-58.

[41] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. ImageNet Classification with Deep Convolutional Neural Networks[C]// Proceedings of the 25th International Conference on Neural Information Processing Systems, Volume 1. Lake Tahoe, Nevada: [s.n.], 2012: 1097-1105.

[42] SZEGEDY C, LIU W, JIA Y Q, et al. Going Deeper with Convolutions[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Boston, MA, USA: IEEE, 2015: 1-9.

[43] CHEN X Y, XIANG S M, LIU C L, et al. Vehicle Detection in Satellite Images by Hybrid Deep Convolutional Neural Networks[J]. IEEE Geoscience and Remote Sensing Letters, 2014, 11(10): 1797-1801.

[44] ZHANG L, SHI Z W, WU J. A Hierarchical Oil Tank Detector with Deep Surrounding Features for High-resolution Optical Satellite Imagery[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2015, 8(10): 4895-4909.

[45] ZHANG F, DU B, ZHANG L P, et al. Weakly Supervised Learning Based on Coupled Convolutional Neural Networks for Aircraft Detection[J]. IEEE Transactions on Geoscience and Remote Sensing, 2016, 54(9): 5553-5563.

[46] SEVO I, AVRAMOVIC A. Convolutional Neural Network Based Automatic Object Detection on Aerial Images[J]. IEEE Geoscience and Remote Sensing Letters, 2016, 13(5): 740-744.

[47] YANG Y, NEWSAM S. Bag-of-visual-words and Spatial Extensions for Land-use Classification[C]//Proceedings of the 18th ACM SIGSPATIAL International Conferences on Advances in Geographic Information Systems (ACM SIGSPATIAL GIS 2010). San Jose, CA, USA: [s.n.], 2010: 270-279.

[48] CHENG G, HAN J W, ZHOU P C, et al. Multi-class Geospatial Object Detection and Geographic Image Classification Based on Collection of Part Detectors[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2014, 98: 119-132.

[49] WU H, ZHANG H, ZHANG J F, et al. Fast Aircraft Detection in Satellite Images Based on Convolutional Neural Networks[C]//2015 IEEE International Conference on Image Processing (ICIP). Quebec City, QC, Canada: IEEE, 2015: 4210-4214.

[50] BENEDEK C, DESCOMBES X, ZERUBIA J. Building Development Monitoring in Multitemporal Remotely Sensed Image Pairs with Stochastic Birth-death Dynamics[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34(1): 33-50.

[51] HEITZ G, KOLLER D. Learning Spatial Context: Using Stuff to Find Things[M]//Computer Vision – ECCV 2008: 10th European Conference on Computer Vision. Marseille, France: Springer, 2008: 30-43.

[52] TANNER F, COLDER B, PULLEN C, et al. Overhead Imagery Research Data Set—An Annotated Data Library & Tools to Aid in the Development of Computer Vision Algorithms[C]//2009 IEEE Applied Imagery Pattern Recognition Workshop (AIPR 2009), Volume 1. Washington, DC, USA: IEEE, 2009: 1-8.

[53] SIVA P, RUSSELL C, XIANG T. In Defence of Negative Mining for Annotating Weakly Labelled Data[M]//Computer Vision – ECCV 2012, Part III, LNCS 7574. Berlin Heidelberg: Springer, 2012: 594-608.

[54] DOSOVITSKIY A, FISCHER P, SPRINGENBERG J T, et al. Discriminative Unsupervised Feature Learning with Exemplar Convolutional Neural Networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 38(9): 1734-1747.

[55] LAKE B M, ULLMAN T D, TENENBAUM J B, et al. Building Machines that Learn and Think Like People[J]. Behavioral and Brain Sciences, 2017, 40: e253.

[56] LAKE B M, SALAKHUTDINOV R, TENENBAUM J B. Human-level Concept Learning through Probabilistic Program Induction[J]. Science, 2015, 350(6266): 1332-1338.

[57] LIN T Y, MAIRE M, BELONGIE S, et al. Microsoft COCO: Common Objects in Context[M]//Computer Vision – ECCV 2014, Part V, LNCS 8693. Switzerland: Springer International Publishing, 2014: 740-755.

[58] DENG J, DONG W, SOCHER R, et al. ImageNet: A Large-scale Hierarchical Image Database[C]//2009 IEEE Conference on Computer Vision and Pattern Recognition. Miami, FL, USA: IEEE, 2009: 248-255.

A Survey on Object Detection Technology in Optical Remote Sensing Images

LI Xiaobin1,2JIANG Bitao1YANG Yuanbo1FU Yuze1YUE Wenzhen1

(1 Beijing Institute of Remote Sensing Information, Beijing 100192, China)(2 Department of Electronic Engineering, Tsinghua University, Beijing 100084, China)

Object detection is an important part in optical remote sensing image analysis and a crucial linking between images and their applications. Taking the aircraft and ship research object, this paper systematically summarizes the latest researches and looks forward to the future development direction of object detection. The main content of this paper includes object detection methods, evaluation criteria and datasets. While introducing object detection methods in detail, this paper focusses on candidate region proposal, feature learning, classification and post-processing. It is expected that this survey can provide some references for the application of object detection in optical remote sensing images.

object detection method; aircraft detection; ship detection; classification; remote sensing image

TP407.8

A

1009-8518(2019)04-0095-10

10.3969/j.issn.1009-8518.2019.04.011

李晓斌,男,1978年生,2004年12月获国防科技大学模式识别与智能系统专业硕士学位,目前为清华大学电子工程系信息与通信工程专业在读博士研究生,副研究员。研究方向为遥感图像目标检测识别。E-mail:xiaobin1119@163.com。

2019-03-09

(编辑:夏淑密)