基于CNN和迁移学习的农作物病害识别方法研究

李淼 王敬贤 李华龙 胡泽林 杨选将 黄小平 曾伟辉 张建 房思思

摘 要:互联网是一个巨大的资源库,也是一个丰富的知识库。针对农作物小样本引起的过拟合问题,本研究引入了知识迁移和深度学习的方法,采用互联网公开的ImageNet图像大数据集和PlantVillage植物病害公共数据集,以实验室的黄瓜和水稻病害数据集AES-IMAGE为对象开展相关的研究与试验。首先将批归一化算法应用于卷积神经网络CNN中的AlexNet和VGG模型,改善网络的过拟合问题;再利用PlantVillage植物病害数据集得到预训练模型,在改进的网络模型AlexNet和VGG模型上用AES-IMAGE对预训练模型参数调整后进行病害识别。最后,使用瓶颈层特征提取的迁移学习方法,利用ImageNet大数据集训练出的网络参数,将Inception-v3和Mobilenet模型作为特征提取器,进行黄瓜和水稻病害特征提取。本研究结合试验结果探讨了适用于农作物病害识别问题的最佳网络和对应的迁移策略,表明使用VGG网络参数微调的策略可获得的最高准确率为98.33%,使用Mobilenet瓶颈层特征提取的策略可获得96.8%的验证准确率。证明CNN结合迁移学习可以利用充分网络资源来克服大样本难以获取的问题,提高农作物病害识别效率。

关键词:CNN;农作物病害;过度拟合;迁移学习;参数微调;特征提取器

中图分类号:S-1 文献标志码:A 文章编号:201903-SA005

李 淼, 王敬贤, 李华龙, 胡泽林, 杨选将, 黄小平, 曾伟辉, 张 建, 房思思. 基于CNN和迁移学习的农作物病害识别方法研究[J]. 智慧农业, 2019, 1(3): 46-55.

Li M, Wang J, Li H, Hu Z, Yang X, Huang X, Zeng W, Zhang J, Fang S. Method for identifying crop disease based on CNN and transfer learning[J]. Smart Agriculture, 2019, 1(3): 46-55. (in Chinese with English abstract)

1 引言

根据《中国作物栽培简史》记录,农作物包括粮食作物和经济作物两大类。其种类繁多,仅粮食作物就有谷类作物、薯类作物及食用豆类作物等共110种。在农作物整个生长期内,存在许多病虫草等有害生物危害,通过对其病害正确识别和危害情况准确分析,进一步掌握其发生规律和动态,才能达到实时、准确的预测和防治[1]。近50多年来,研究人员利用信息技术在农作物病虫草害识别诊断、农作物缺素识别诊断、种子质量检验、农产品品质检测与分级等方面开展了广泛研究和应用,显示出很大应用潜力。由于农作物病害种类繁多,对某一种病害而言,图像数据积累困难。根据《中国农作物病虫害(第三版)》记录,农作物的病害根据侵染源可分为细菌性、病毒性、药物性以及营养性四类,农作物病害约有1820种病害,可分为30大类,110小类。農作物受害部分可分为根、茎、叶、花、穗、果等不同部位。一种病可以发生在叶片、茎杆、果实甚至根部,所以每一种病害的种类可能会有1000多种,发生场景很多(叶片、茎杆、果实),而每一种病在同一个场景下能够获得的典型图像数据却不多,俗称“小数据”集。

自50年代以来,研究者就利用图像处理技术来开展农作物病害识别的研究[2,3]。随着计算机技术的快速发展,出现了利用深度学习进行农作物病害识别的研究。卷积神经网络(Convolutional Neural Networks,CNN)是一种深度监督学习下的机器学习模型。卷积层是CNN的核心,层的参数由一组可学习的滤波器(filter)或内核(kernels)组成。该方法擅长处理图像特别是大图像的相关机器学习问题。它通过一系列方法,将数据量庞大的图像识别问题不断降维,最终使其能够被训练。2012年,Krizhevsky 等[4]设计的深度卷积神经网络(CNN)AlexNet模型,在大规模视觉识别挑战赛(ImageNet Large Scale Visual Recognition Challenge,ILSVRC 2012)上取得较好的成绩,很多研究者结合迁移学习(Transfer learning,TL)、深度学习(Deep Learning, DL)以及CNN对不同领域的图像分类识别问题进行研究。Brahimi等[5]使用9种番茄病害图像共14828幅比较微调 AlexNet 网络参数模型和传统支持向量机的识别效果,结果表明AlexNet 网络不仅在正确率上优于支持向量机,而且避免了病斑分割效果对识别的影响。Mohanty等[6]通过使用AlexNet和GoogleNet两个网络在ImageNet数据集训练的参数初始化模型对包含54306幅图像的PlantVillage数据集中14种作物的26种病害图像进行识别比较,取得了令人满意的结果。Lee等[7,8]针对多种高光谱图像研究出一种新的跨领域CNN,并在三组农业图像上进行试验,结果显示提出的方法相比使用独立卷积神经网络的方法正确率提升了1%~3%。Khamparia等[9]使用CNN和自动编码器的组合设计了一种用于检测作物叶病的混合方法,提供了一种利用作物叶片图像在卷积编码器网络的帮助下检测作物病害的新技术。Sun等[10]利用CNN识别算法有效提高了茶叶病害的识别效率,首先使用图像分割和数据增强对图像进行预处理,然后将这些图像输入网络进行训练,频繁调整学习率和迭代次数以达到更高的CNN识别准确率。

随着信息技术的快速发展,互联网涉及的范围日益扩大,形成了一个巨大的资源库,公布了许多农业病害图像。利用CNN技術将“先验知识”应用于学习过程中,有助于解决农作物病害小样本的问题[11]。其基本原理是:通过TL方法,利用从大量“非单一性”的数据集中获得的“先验知识”应用于特定领域识别的CNN训练中,以缓解特定领域数据量不足引起的过拟合问题。目前迁移学习在图像识别领域的应用研究大致分为三类[11]:第一类是使用与目标领域相关的图像集合来辅助图像的分类,这类应用多使用实例迁移的方法实现;第二类是使用文字辅助集合,通过建立文字与图像中内在语义信息之间的联系来实现对图像的分类,这类应用常使用特征迁移的方法实现;最后一类则是使用基于公共图像ImageNet数据集在AlexNet、GoogleNet等网络上训练出来的参数作为目标数据训练网络的初始值来实现目标领域的图像分类,这类方法可认为是基于参数迁移的一种。Sladojevic等[12]将15类4483幅植物叶片图像(包含13种病害、1种健康叶片和1种背景图像)通过数据增强技术扩充到30880幅,然后通过微调 CaffeNet参数模型进行识别,结果显示对于每一类别的识别正确率在91%以上。Srdjan等[13]对CaffeNet模型进行参数微调试验,结果证明该模型对13种植物病害的平均识别率达到了96.3%。

可以看出,大多数研究都是基于深度学习进行农作物病害识别的研究。此种方法需要大量的样本支持。本文利用迁移学习的方法对农作物病害进行分类研究,其目标是将一个或者多个辅助领域任务中学到的有用知识以及技能应用到新的目标任务中[14]。在迁移学习方法应用于农作物病害的识别研究中,大多数基于参数微调的迁移方法,本文在此基础上,应用了基于瓶颈层特征提取的迁移学习方法。轻量级卷积网络结合迁移学习进行农作物病害的识别研究不仅可以提高识别准确率,还可以提高病害识别的效率,能更好地应用于智能终端设备中。

在本研究过程中,首先将批归一化算法加入AlexNet网络和VGG两个网络中,提高了模型的泛化能力;在改进的网络上,大数据集ImageNet上获得的预训练模型使用实验室的小样本黄瓜和水稻病害数据集进行参数调整;将在大数据集ImageNet上训练好参数的Inception-v3模型和Mobilenet模型作为实验室小样本黄瓜和水稻病害的特征提取器,进行小数据集病害特征提取,代替人工设计的可视化特征提取方法,此方法只需在CPU上即可快速识别病害,不需要大量的训练时间。

2 研究方法

2.1 CNN网络改进

将批归一化算法引入Alexnet和VGG网络模型中的全连接层中进行改进。批归一化算法[15]能起到减少过拟合现象的作用。

CNN的成功得益于许多神经网络模型的结构。LeNet[16]是最早的CNN之一,它促进了深度学习的发展。AlexNet网络[2]架构遵循与LeNet-5架构相同的设计模式,有三个关键的技术点。

① AlexNet网络使用ReLU作为激活函数,成功解决了Sigmoid在网络较深时的梯度弥散问题。使用ReLU激活函数当输入信号小于等于0时,输出都是0,输入信号大于0时,输出等于输入。因此使用ReLU函数复杂度低,得到的收敛速度会比其他函数快很多。对于来自上一层神经网络的输入向量,使用线性整流激活函数的神经元输出,如公式(1)所示。

(1)

其中,f (x)是经过线性整流函数的输出,w是权重,x是输入向量,b是偏置。至下一层神经元或作为整个神经网络的输出。

②AlexNet网络将Dropout算法应用其中来避免模型过拟合,Dropout在前向传播时,让某个神经元的激活值以一定的概率p停止工作,如公式(2)所示,这样它不会太依赖某些局部特征,可以使模型泛化性更强。经过Dropout算法后,下一个网络层的输出如公式(3)所示。

(2)

(3)

其中,Bernoulli表示随机获取概率p,y是神经元的输出,w是连接神经元的权重,b是偏置值,i是代表第i个神经元节点。在Alexnet的最后几个全连接层中使用了Dropout。

③AlexNet网络首次提出LRN(Local Response Normalization)层[2]。对局部神经元的活动创建竞争机制,LRN层增强了模型的泛化能力。

VGG网络[17]探究了网络深度对模型精确度的影响。VGG网络所有卷积层有相同的配置,即卷积核大小为3×3,步长为1,填充为1;共有5个最大池化层,大小都为2×2,步长为2,这里的2表示像素点的个数;共有三个全连接层,前两层都有4096路通道,第三层共1000路通道即代表1000个标签类别;最后一层为softmax层;所有隐藏层后都带有ReLU非线性激活函数。VGG网络的每个卷积又包含了3个卷积层,因此计算量很大。

本研究对Alexnet和VGG网络模型进行了改进,将批归一化算法引入两个网络模型中的全连接层部分,其算法过程如下:

①根据公式(4)和公式(5)计算每个批次的n个样本x1-xn的均值和方差。

(4)

(5)

其中,μ为每个批次的均值,σ2为每个批次的方差。

②据公式(6)对每个批次的样本数据归一化。

(6)

是归一化后的数据,其均值为0,方差为1,是避免方差为0而加入的一个很小的常量。

③为避免归一化对原始数据特征分布的破坏,根据公式(7)~(9)恢复特征分布。

(7)

(8)

(9)

其中,γi和βi表示重构参数,是可以通过网络训练得到,Var和E分别是方差函数和均值函数。上述参数的维度均要求与输入图像的维度一致。

试验中,将批归一化算法引入两个网络模型中。批归一化算法不仅可以减少收敛所需的迭代次数,而且可起到正则化作用,减少过拟合现象。

2.2 CNN模型参数微调

对于AlexNet和VGG两个网络模型采用了参数微调的策略,并开展了从头开始训练与迁移学习参数微调之间的对比试验。

PlantVillage 数据集是一个开源的包含简单背景的植物健康叶片及叶片病害的图像数据集,与本研究的目标病害图像数据集有较大的相似性。而ImageNet数据集含有的图片数量较多,能更好地学习到图片的各种视觉特征。因此本研究使用了基于CNN参数迁移的农作物病害图像识别方法,如图1所示。通过将PlantVillage数据集和ImageNet数据集分别作为辅助领域数据集基于AlexNet和VGGNet网络训练预训练模型,采用数据增强策略对目标领域数据进行处理,然后实现对目标领域的农作物病害图像的识别。

在参数微调的训练策略中,采用大数据集PlantVillage和ImageNet[18]来获取预训练模型。在训练过程中,将预训练模型的低层网络参数进行冻结,只对全连接层的参数重新进行训练和更新,如图2所示。从大数据集学习得到的底层滤波器往往描述了各种不同的局部边缘和纹理信息,这些滤波器对一般的图像有较好的普适性。特征层越来越高,提取的特征也越来越复杂。因此,固定前面用于提取通用视觉特征的网络层,只通过CNN模型的再次训练来调整最后的全连接层的参数,以适应到本研究的黄瓜和水稻病害数据集。

2.3 CNN模型特征提取

Inception-v3模型[19]提出神经网络结构的设计和优化思路并改进了Inception结构。Inception-v3模型避免了网络表达瓶颈,在较低维度空间聚合,不会损失表达能力,而且平衡了网络的宽度和深度。它的主要特点是参数、内存和计算资源比传统网络小很多。Inception-v3模型将大的卷积核尺寸分解为不对称的小卷积核。这种方法节约了大量的参数增加一层非线性,提高模型的表达能力,还可以增加特征的多样性。

MobileNet网络[20]是为移动和嵌入式设备提出的高效模型。MobileNet使用深度可分离卷积来构建轻量级深度神经网络。深度可分离卷积把标准卷积分解成深度卷积和逐点卷积,此种结构可以大幅度降低参数量和计算量。MobileNet网络设计了α和β两个简单的全局超参数,这两个超参数允许我们依据约束条件选择合适大小的模型,可根据实际的需求,来控制识别速度或识别准确率,二者只能够取其一。

第一个超参数是宽度因子α,用于控制输入和输出的通道数。深度卷积和逐点卷积的计算量如公式(10)所示。

(10)

其中,DK是卷积核,DF是特征图,M是输入通道数,N是输出通道数。常用的α参数配置为1,0.75,0.5,0.25;当α =1时,它是标准的MobileNet。当选择0.75,0.5,0.25这些参数时,就是缩小版的MobileNet,这些缩小版可以提高识别速度,这种CNN网络模型可以牺牲准确率来换取速度,适用于小型移动设备,如手机等。

第二个控制模型大小的超参数是分辨率因子β,用于控制输入和内部层表示,即用分辨率因子控制输入的分辨率,此处深度卷积和逐点卷积的计算量如公式(11)所示。

(11)

其中,D、M、N、F意义同公式(10)。本研究选用了不同的α和β参数进行了试验。以寻求识别速度与准确率之间的平衡。

在Inception-v3和Mobilenet网络中,我们将最后一个全连接层之前的网络层称为瓶颈层,如图3所示。

首先,所有瓶颈层的参数都固定为在ImageNet数据集上训练的权重参数。然后通过Inception-v3和Mobilenet模型提取从原始图像计算的瓶颈层特征向量并保存。最后,识别模型重新定义了一个网络层,以解决农作物病害的训练图像(AES-IMAGE)识别问题。

3 数据采集与参数设置

3.1 试验数据准备

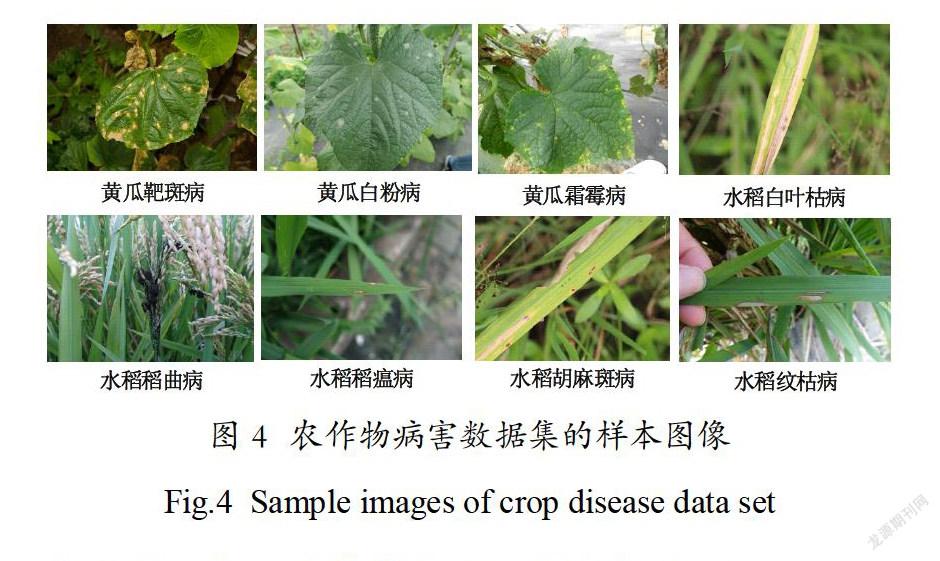

AES-IMAGE数据集包括3种黄瓜病害图像和5种水稻病害图像(如图4)。

该数据集由实验室人员采用Canon EOS 6D数码相机于田间在不同的自然条件下拍摄,具有不同的复杂图像背景。原始数据集共含有2430幅图像。由于此数据集中图像的尺寸不一致,且数量较少不足以训练规模较大的深度卷积神经网络,对此本研究提出边角裁剪方法实现图像集的扩充,具体方法如下:

(1)裁剪掉图像的512×512像素的中心

区域;

(2)将剩下的区域均分为四份,使每个区域为256×256像素;

(3)为了避免子区域无病斑出现,人工将无病斑出现的图像去除。

經过一系列操作,原始数据集数据量被扩充到9592 幅,并且无重复图像,表1给出了原始数据集在图像处理前后的各类作物病害图片数量列表。

病害图像的数据增强策略是通过图片剪裁扩充病害数据集的图片数量,如图5所示。

试验中由于AES-IMAGE数据集样本量较小,根据文献[18]中的大量对比试验,80%的数据用于训练,20%的数据用于验证获取的试验结果较好,因此本研究将训练集和验证集的比例设置为4∶1。

3.2 试验的超参数设置

试验之前将所有超参数标准化,超参数由一系列试验确定(表2)。

本研究使用表2中描述的超参数,在所有的CNN中使用小批量梯度下降法(mini-batch SGD)优化算法实现并行化。mini-batch SGD是batch SGD和随机梯度下降法(SGD)的一种平衡。SGD就是每一次随机选择一些样本迭代计算梯度进行更新,原理见公式(12)和公式(13)所示。

(12)

(13)

其中,θ是待更新的参数,η是学习率,gt是梯度。mini-batch SGD通过矩阵运算,每次在一个batch上优化神经网络参数并不会比单个数据慢太多。而且每次使用一个batch可以大大减小收敛所需要的迭代次数,同时可以使收敛到的结果更加接近梯度下降的效果。根据文献参考和试验确定学习率设置为0.01。学习率决定了权重更新的速度,学习速率过高会导致网络模型不稳定,学习速率过低会使模型的收敛过慢。在AlexNet和VGGNet识别模型中,每个试验运行200epochs。在Inception-v3和Mobilenet识别模型中运行了4000步结束。优化算法在训练集中随机选取一批样本进行训练,批样本大小设置为128,采用Tensorflow框架进行试验。

4 试验结果分析

4.1 AlexNet和VGG模型在ImageNet数

据集上的参数微调

图6展示了AlexNet和VGG两个网络从头开始训练和使用迁移学习进行参数微调的验证准确率曲线。

从曲线可以看出,使用微调的迁移学习策略比从头开始训练可以获取更高的初始训练准确率和验证准确率,并且使用迁移学习的训练过程曲线可以较好的平稳收敛。使用AlexNet和VGG两个网络采用从头开始训练的机制,在AES-IMAGE数据集上分别获得了90.29%和87.34%的准确率,其中VGG网络出现了较为严重的过拟合现象。使用AlexNet和VGG两个网络采用全连接层参数微调的迁移学习机制,在AES-IMAGE数据集上分别获得了96.43%和98.33%的准确率。相比与从头开始训练,分别提升了6.14%和10.99%。在AlexNet网络中,虽然使用迁移学习后病害的识别准确率有所提升,但是参数微调却比从头开始训练过拟合现象严重一AlexNet 网络上出现了负迁移的效果。这是因为AlexNet网络的层数较少,不能很好的从大数

据集中捕捉到更广泛全面的特征以迁移到小样本病害数据集中。本试验证明了在网络规模较大时,VGG网络迁移学习机制可以有效的缓解过拟合现象,并可以提高网络对小样本病害的识别准确率。

原始的AlexNet和VGGNet两个网络主要使用 Dropout层和L2正则化优化网络,本研究结合批归一化算法和DisturbLabel算法改善网络的测试结果。每种试验方法各进行了5次,取平均值作为最终的试验结果。表3比较了在改进的网络和原始网络上微调预训练模型的效果。

可以看出在目标数据集上改进网络的效果要优于原始网络,改进的AlexNet模型和VGG模型相比于原始网络病害识别率可以提高1.01%和9.26%。另外,表3给出了使用目标数据集从头训练两个网络的结果,可以看出,从头训练网络的结果最差,而借助于Plantvillage数据集进行预训练和参数微调可以获取较好的识别效果。相比于从头开始训练AES-IMAGE数据集,原始的AlexNet模型和VGG模型通过迁移学习策略病害识别率可以分别提高0.19%和0.93%,改进的AlexNet模型和VGG模型通过迁移学习策略病害识别率可以分别提高1.2%和10.22%。

4.2 Inception-v3和Mobilenet网络瓶颈

层特征提取器

表4展示了Inception-v3和Mobilenet网络的验证准确率。

本试验每种网络各进行了5次特征提取,取平均值作为最终的试验结果。Mobilenet虽然属

于轻量级CNN,训练时间短,占用内存空间很

小[28],但是使用这个网络在AES-IMAGE数据集上却可以获得比Inception-v3模型更高的准确率,使用Mobilenet-1.0-224网络进行特征提取可以获得96.8%的识别准确率。相比于参数微调和深度卷积网络模型,瓶颈层特征提取的策略和轻量级卷积神经网络的结合更利于对实时性和硬件有严格要求的终端应用。

5 结论

CNN模型可以避免图像的分割过程抽象信息丢失的问题,但需要强大的数据支持。因此本研究以公共数据集(ImageNet、Plantvillage)和实验室小样本病害图像(AES-IMAGE)为研究对象,开展了应用两种迁移学习的策略来解决病害识别小样本数据集引起的过拟合问题。主要结果如下:

(1)提出一种基于CNN参数迁移的图像识别方法。文中首先对具有复杂背景且尺寸大小不一的病害图像进行预处理,通过对图片进行两次裁剪操作实现目标数据数量上的扩充。基于AlexNet和VGGNet两种网络采用大数据集获取的预训练模型,结合批归一化算法优化两种网络模型,使用预处理后的目标数据集微调预训练模型得到全连接层。本文将提出的方法与无迁移学习的CNN训练方法进行对比,试验结果准确率分别提升了6.14%和10.99%,证明了迁移学习策略的有效性。

(2)将深度卷积神经网络作为特征提取器代替人眼可视设计的底层特征(颜色、纹理、形状等)。利用Inception-v3和不同参数的Mobilenet网络进行特征提取,然后通过分类层对黄瓜和水稻病害进行识别。试验结果表明Mobilenet属于轻量级卷积神经网络,训练时间短且占用很小的内存空间,其识别准确率却比较高,在Mobilenet-1.0-224網络进行特征提取可以获得96.8%的识别准确率。此模型和瓶颈层特征提取的策略可以在对实时性、存储空间和能耗有严格的要求的终端智能应用中发挥重要作用。

研究结果证明卷积神经网络结合迁移学习可以利用充分网络资源来克服大样本难以获取的问题,提高农作物病害识别识效率。后续我们将继续收集更多的农作物病害样本图像,利用深度卷积神经网络和迁移学习方法开发一套完整的农作物病害识别系统,应用于实际农业生产。

參考文献

[1] Mutka A M, Bart R S. Image-based phenotyping of plant disease symptom[J]. Frontiers in Plant Science, 2015, 5, article no.734.

[2] Pydipati R, Burks T F, Lee W S. Identification of citrus disease using color texture features and discriminant analysis[J]. Computers and Electronics in Agriculture, 2006, (52): 49-59.

[3] Lee W S, Burks T F, Pydipati R. Statistical and neural network classifiers for citrus disease detection using machine vision[J]. Transactions of the ASAE, 2005, 48(48): 2007-2010.

[4] Krizhevsky A, Sutskever I, Hinton G E. ImageNet classification with deep convolutional neural networks[C]. International Conference on Neural Information Processing Systems. Curran Associates Inc. 2012: 1097-1105.

[5] Brahimi M, Boukhalfa K, Moussaoui A. Deep learning for tomato diseases: classification and symptoms visualization[J]. Applied Artificial Intelligence, 2017: 1-17.

[6] Mohanty S P, Hughes D P, Salathé Marcel. Using deep learning for image-based plant disease detection[J]. Frontiers in Plant Science, 2016, 7:1-10.

[7] Lee H, Eum S, Kwon H. Cross-domain CNN for hyperspectral image classification[J]. arXiv:1802.00093v2 [cs.CV] 2 May 2018.

[8] Lee H, Kwon H. Going deeper with contextual CNN for hyperspectral image classification[J]. IEEE Trans Image Process, 2017, 26(10): 4843.

[9] Khamparia A, Saini G, Gupta D, et al. Seasonal crops disease prediction and classification using deep convolutional encoder network[J]. Circuits Systems and Signal Processing, 2019(May).

[10] Sun X, Mu S, Xu Y, et al. Image recognition of tea leaf diseases based on convolutional neural network[J]. 2019: arXiv:1901.02694.

[11] Pan S J, Yang Q. A survey on transfer learning[J]. IEEE Transactions on Knowledge & Data Engineering, 2010, 22(10): 1345-1359.

[12] Sladojevic S, Arsenovic M, Anderla A, et al. Deep neural networks based recognition of plant diseases by leaf image classification[J]. Computational Intelligence and Neuroscience, 2016, (6): 1-11.

[13] Srdjan S, Marko A, Andras A, et al. Deep neural networks based recognition of plant diseases by leaf image classification[J]. Computational Intelligence and Neuroscience, 2016, 2016:1-11.

[14] Torrey L, Shavlik J, Transfer learning[M]. Machine Learning Applications and Trends, 2009, 242–264. http://dx.doi.org/10.4018/978-1-60566-766-9.ch011.

[15] Ioffe S, Szegedy C. Batch normalization: accelerating deep network training by reducing internal covariate shift[C]. International Conference on International Conference on Machine Learning. JMLR.org, 2015: 448-456.

[16] Lecun Y, Boser B, Denker J S, et al. Backpropagation applied to handwritten zip code recognition[J]. Neural Computation, 1989, 1(4): 541-551.

[17] Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition[J/OL]. (2015-4-10)[2019-3-29]. https://arxiv.org/abs/1409.1556, 2014.

[18] Deng J, Dong W, Socher R, et al. Imagenet: A large-scale hierarchical image database[C]. 2009 IEEE Computer Society Conference on Computer Vision and Pattern Recognition(CVPR), 2009: 248-255.

[19] Szegedy C, Vanhoucke V, Ioffe S, et al. Rethinking the inception architecture for computer vision[C]. Computer Vision and Pattern Recognition. IEEE, 2016: 2818-2826.

[20] Howard A G, Zhu M, Chen B, et al. MobileNets: Efficient convolutional neural networks for mobile vision applications[J]. 2017: arXiv:1704.04861v1 [cs.CV], 2818-2826.

Method for identifying crop disease based on CNN

and transfer learning

Miao Li1, Jingxian Wang1,2, Hualong Li1, Zelin Hu1, XuanJiang Yang1,2, Xiaoping Huang1,2,Weihui Zeng1, Jian Zhang1*, Sisi Fang1,2

(1. Institute of Intelligent Machines, Chinese Academy of Sciences, Hefei 230031, China;

2. University of Science and Technology of China, Hefei 230026, China)

Abstract: The internet is a huge resource base and a rich knowledge base. Aiming at the problem of small agricultural samples, the utilization technology of network resources was studied in the research, which would provide an idea and method for the research and application of crop disease identification and diagnosis. The knowledge transfer and deep learning methods to carry out research and experiments on public data sets (ImageNet, PlantVillage) and laboratory small sample disease data (AES-IMAGE) were introduced: first the batch normalization algorithm was applied to the AlexNet and VGG of Convolutional Neural Network (CNN) models to improve the over-fitting problem of the network; second the transfer learning strategy using parameter fine-tuning: The PlantVillage large-scale plant disease dataset was used to obtain the pre-trained model. On the improved network (AlexNet, VGG model), the pre-trained model was adjusted by our small sample dataset AES-IMAGE to obtain the disease identification model of cucumber and rice; third the transfer learning strategy was used for the bottleneck feature extraction: using the ImageNet big dataset to obtain the network parameters, CNN model (Inception-v3 and Mobilenet) was used as feature extractor to extract disease features. This method requires only a quick identification of the disease on the CPU and does not require a lot of training time, which can quickly complete the process of disease identification on the CPU. The experimental results show that: first in the transfer learning strategy of parameter fine-tuning: the highest accuracy rate was 98.33%, by using the VGG network parameter fine-tuning strategy; second in the transfer learning strategy of bottleneck feature extraction, using the Mobilenet model for bottleneck layer feature extraction and identification could obtain 96.8% validation accuracy. The results indicate that the combination of CNN and transfer learning is effective for the identification of small sample crop diseases.

Key words: CNN; crop diseases; overfitting; transfer learning; parameter fine-tuning; feature extractor