普通高校下属院系自建机房运维管理实例探讨

周炜丹 郭传江

[摘 要]本文主要介绍了南京大学大气科学学院高性能计算及海量数据中心机房的建设和运维管理实例,对比讨论了当前普通高校下属院系自建机房的合理性,并对相关工作改进和发展做出了探讨,旨在为相关研究提供借鉴。

[关键词]高性能计算;自建机房;运维管理

doi:10.3969/j.issn.1673 - 0194.2019.14.103

[中图分类号]TP308[文献标识码]A[文章编号]1673-0194(2019)14-0-02

0 引 言

现代大气科学为实现对天气和气候过去状态的模拟及未来状态的预报或预估,需要将控制大气运动的动力学控制方程组数学模型离散化,借助计算机计算时间积分。自1950年ENIAC成功计算数值天气预报起,数值模式越来越精密和复杂,对计算和存储的需求越来越高。随着经济和技术条件进步,各单位自建机房变得更常见。本文结合校属学院自建机房建设及运维管理实例,讨论了近年来的使用经验,并与其他计算及存储解决方案进行对比,探讨了自建机房未来发展的前景。

1 学院机房建设概况

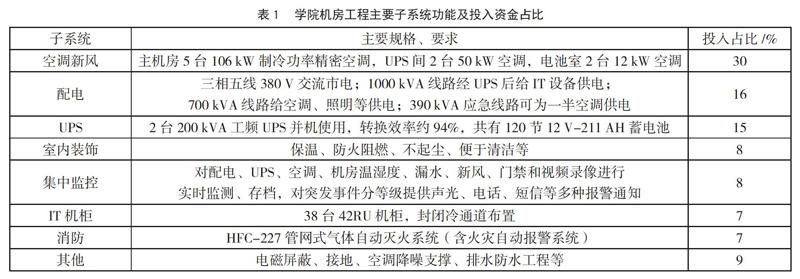

南京大学自2010年起建有校级高性能计算集群平台,大气科学学院自行购置科研用途的服务器、存储系统等专用IT设备更早。学院自建的高性能计算及海量数据中心机房(以下简称学院机房)工程自2013年参照国家标准开始实施,2014年暑期投入使用。机房正式运行面积232 m2,包括(79+69) m2主机房两间及UPS间、电池室、消防钢瓶室,另有68 m2作为二期工程预留。机房工程以学科建设经费为主,总投入约650万元人民币,主要子系统组成见表1,空调、UPS、集中监控等主要配套设备设计寿命8~10年,机房建设方提供3年免费质保。后续招标的配套设备维保每年支出在工程总价的5%以内。

2 机房使用及运维管理现状

目前,主机房内已经安装500余台IT设备,机柜空间利用率约85%。各种设备品牌型号多,采购途径及年代分散,少部分为全学院共享,其余为学院内各课题组自行购置。大多数机房服务器运行Linux系统,主要依靠开源、免费或自行编写的应用软件,用于科学计算及数据分析,多为双路CPU/2RU规格,另有数套高密度刀片式服务器,总计算能力约100 TFlops(双精度)。存储服务器主要为使用3.5英寸机械硬盘的SAN存储,绝大部分通过光纤或SAS通道直接连接至服务器HBA扩展卡,另有数套并行存储系统为中小型高性能集群服务,总容量约20 PB。机房网络对外由10 GbE光纤接入校园网,对内以GbE速率下行交换机居多,另有少量10 GbE设备。部分服务器通过40/56 Gbps IB高速低延迟互联组成高性能并行集群,目前有数套1 000左右CPU计算核心规模的集群和更小规模300左右CPU计算核心的集群。集群并行计算一般通过MPI,与本学科主流方案相同,运行成熟软件方便,同时也与学校平台环境类似,可以较方便地迁移程序至学校平台执行更大规模的任务。随着信息技术深入发展,网络安全形势日益严峻。为防范非法入侵、同时减少对高速数据传输的影响,机房还配备全并行处理的NGFW(Next Generation Fire Wall)防火墙和堡垒机系统。前者用于机房对外网络出入管控,后者用于学院公共平台等重要系统的访问认证与安全审计。目前,机房有两名工作人员,自2014年以来,突发意外需要大面积关机的情况平均每年不到一次,均为空调故障导致,因及时处置未造成IT设备损坏。

3 自建机房与其他购买服务方式的对比

笔者所在学院的各科研项目对并行计算和数据存储都有较大需求。一般中小规模的计算学院机房内设备可满足,较大规模的计算可交由学校大型平台或校外超算中心计算。大规模并行计算后期海量数据的长期存储和分析仍主要在学院机房内进行,以低成本、高可靠、大容量为主要需求。以学校计算平台为例,其计算能力是学院机房的总和,但存储系统以高速高性能为主,总容量仅有学院机房的1/10左右。

目前,高校机房常见的其他可选项包括自购硬件托管至校外商业机房,购买校外超算中心的计算服务,采购“云计算”服务等。学院机房目前平均运行功率约180 kW,PUE值约1.7。每年电费、配套维保和运维薪资合计后,每月维持费用约

100元/RU,仅为托管至校外商业机房的几分之一。与从校外超算中心购买机算服务相比,校内平台收费标准略低于校外,且数据经内部网络传输快,对产生海量数据应用非常重要。超算中心一般不提供大规模存储,与采购“云计算”服务相比,以阿里云ECS为例,零散付费计算机的单价较校外超算中心还要高约50%,即使按最大优惠5年整包,机时单价也仅与校内平台优惠后零散单价相当,同時校内包括学院内的集群内部高性能互联速率更快,更有利于大规模科学计算任务。在存储方面,阿里云32 TB高效云盘5年整包价34万余元,比学院机房采用的方案总费用高出一个数量级。

与已经规模化的商业方案比,对特定的计算和存储需求而言,学院自建机房仍有优势。究其原因,可解释为高校院系仍以公益类科研为主,成本投入占很大比例,包括机房建设、设备采购甚至人力成本等,并不以直接经营收入为考核出发点。

4 对学院机房相关工作进一步发展的探讨

学院机房按较高标准筹建,基本顺应了近年来技术发展、科研投入增加和需求快速增长的趋势。结合实际规划未来,在以下方面的工作可做进一步改善和提高。

(1)学校和学院的资源环境、机房规模等决定了可投入的人力物力无法与大型数据中心相比,但可考虑开发适用于本地软硬件环境、易于部署的运维自动化功能,提高机房运行的安全性和可靠性,使运维管理人员将更多精力转移到学习与研究如何提升各类设备利用效能上来。

(2)新的数据中心设计规范国家标准已于2018年开始实施,结合了数据中心发展趋势、经验以及新技术,修订了电气、空调、环境等方面的内容,对学院已建机房具有一定的参考借鉴意义。例如,可以参考新标准适度提高空调设定温度,同时监控各设备温度变化,在安全范围内降低空调系统负荷,节约能源。同时,还可考虑在空调室外机处加装水喷雾系统,以期同时达成节能和减少空调设备故障率。

(3)目前,各课题组设备分散,研究生自行管理水平参差不齐。高校应将公共平台为核心和范例,逐步推动全院设备管理与资源融合,减少闲置。

(4)虽然学院机房在运行成本、性能等方面有特定优势,但对于特定需求,如公开数据共享、下载数据预处理等,仍可考虑与商业“云计算”服务相结合,运维管理工作可从机房内向外拓展,充分利用和整合内外各种条件,满足未来需求。

主要参考文献

[1]游伟倩,盛乐标,张予倩.南京大学高性能计算集群系统管理与运维研究[J].中国设备工程,2018(22).

[2]中国电子工程设计院.电子信息系统机房设计规范:GB50174-2008[S].北京:中国计划出版社,2009.

[3]赵立成,沈文海,肖华东,等.高性能计算技术在气象领域的应用[J].应用气象学报,2016(5).

[4]游伟倩,盛乐标,张予倩.南京大学大型高性能计算集群平台建设研究[J].科技创新导报,2018(4).

[5]游伟倩,盛乐标,周庆林,等.高性能计算集群存储系统搭建方式的对比研究[J].电脑知识与技术,2018(9).

[6]湖南大学国家超级计算长沙中心.关于超算中心收费执行标准的通知[EB/OL].(2018-08-03)[2019-03-28].http://nscc.hnu.edu.cn/info/1004/1282.htm.

[7]中国电子工程设计院.数据中心设计规范:GB50174-2017[S].北京:中国计划出版社,2017.

[8]邱培刚.空调室外机水喷雾节能技术在大型通信局所的应用[J].电信技术,2010(8).