基于双层注意力循环神经网络的方面级情感分析

曾 锋,曾碧卿,韩旭丽,张 敏,商 齐

(1. 华南师范大学 计算机学院,广东 广州 510631;2. 华南师范大学 软件学院,广东 佛山 528225)

0 引言

方面级情感分析是情感分析的一个子任务,是一个细粒度的情感分类任务,目的是识别句子中不同方面的情感极性[1-3]。例如,“这家餐厅的食物非常美味,但是服务却不怎么好。”,在这句话中,“食物”和“服务”是两个不同的方面,方面级情感分析的目的就是识别“食物”和“服务”的情感极性,它们的情感极性分别为积极的和消极的。

方面级情感分析是自然语言处理的一项基本任务,近年来得到越来越多研究人员的关注。在早期的研究中,方面级情感分类被当作一般情感分类任务,采用支持向量机(Support Vector Machine: SVM))结合情感词典、文本语义等特征[4-5]来建立情感分类模型。但是传统的方法需要特征选择,花费大量的时间和精力,性能瓶颈却没有突破。随着深度学习技术的发展,研究人员设计了一系列的神经网络自动生成对象和内容的低维度表示方法,并且在方面级情感分类任务中得到了较好结果[6-8]。相对基于特征的支持向量机而言,神经网络可以更好地捕获方面与上下文内容之间的语义关系。

因神经网络具有较强的学习表示能力,故神经网络方法被应用于自然语言处理领域的各项任务中,比如情感分析、机器翻译[9]以及文本摘要[10]等。LSTM(Long Short-Term Memory)神经网络在方面级情感分析中得到广泛使用,Dong等[6]提出一种用于方面相关的自适应递归神经网络,方面的情感极性主要取决于语境和句法结构。Wang等[7]提出了两个基于注意力机制的LSTM模型,分别为AE-LSTM和ATAE-LSTM神经网络。AE-LSTM神经网络通过LSTM神经网络对上下文进行建模,然后将单词隐藏状态与方面嵌入相结合生成注意力向量,经过分类器分类最终得到方面的情感类别。ATAE-LSTM网络以AE-LSTM网络为基础,进一步增强了方面嵌入的效果,并附加了每个词嵌入向量的方面嵌入来表示上下文。Tang等[11]提出TD-LSTM和TC-LSTM模型,这两个模型利用与方面相关的两个LSTM网络来模拟方面的左、右上下文,且模型自动地利用方面的信息作为模型输入的一部分。Ma等[12]利用注意力机制捕获方面和上下文内容的重要特征,并利用方面和上下文内容之间的关系进行情感分类。

标准的LSTM神经网络是序列模型,不能明确表示不同的单词对方面词的重要程度,即使单层的注意力能捕获不同单词的重要性,但也不能捕获不同句子的重要性。因此,本文提出双层注意力循环神经网络模型,该模型在单词层面和句子层面添加注意力机制,分别捕获不同单词和不同句子的重要性。另外,模型还加入方面(Aspect)、词性信息(Part of Speech Information : POS)和位置信息(Location)作为模型的辅助信息,模型可以弥补仅依赖上下文内容的不足,获取更深层次的情感特征信息。为了验证该模型的性能,本文在Sem Eval 2014数据集和Twitter数据集进行实验,实验结果表明,该模型的预测准确率有不同的提升。

本文主要贡献总结如下:

• 提出一种基于双层注意力循环神经网络的模型,验证了该模型在方面级情感分析中的有效性,双层注意力在单词层面和句子层面分别捕获不同词语和不同句子的重要程度。

• 利用方面、词性信息、位置信息作为模型的辅助信息,模型通过辅助信息学习深层次的情感特征信息,有效地弥补了仅依赖上下文内容进行情感分类的不足。

• 在SemEval 2014数据集和Twitter数据集上的实验表明,基于双层注意力循环神经网络模型对不同数据集的预测准确率具有不同程度的提升。同时表明方面、词性信息和位置方面级情感分析的预测准确率具有辅助作用。

1 相关工作

方面级情感分类是一种更细粒度的分类任务。传统处理这个问题的方法是为模型建立特征工程,选择一系列良好的特征。早期的研究主要集中在建立情感分类特征,Rao等[13]利用丰富的情感词典设计情感分类模型。Mullen等[14]采用支持向量机结合词袋模型和情感词典进行分类。Vo等[15]利用了丰富的特征,包括特殊的情感词嵌入和情感词典等。虽然这些方法效果不错,但这些方法的效果好坏需要依靠良好的特征选择。

近年来,神经网络方法具备将句子编码成连续低维向量的能力,这种能力越来越受到人们的重视。在方面级情感分析中,由于LSTM能够以灵活的方式捕获方面及其上下文内容之间的语义关系,因此Tang等[11]提出了方面依赖的LSTM(TD-LSTM)和方面连接LSTM(TC-LSTM),通过考虑方面来扩展LSTM,他们将给定的方面与上下文内容相结合进行方面级情感分类。Ruder等[16]提出了使用层次化和双向的LSTM模型来进行方面级情感分类,利用单词嵌入作为句子级双向LSTM的输入。Wang等[7]提出一种基于注意力的方面嵌入LSTM方法,注意力机制被用来学习句子的权重,以响应特殊方面。Yang等[17]提出了两种基于注意力的双向LSTM用来提高分类性能。Ma等[12]提出一种兼顾关注方面和上下文内容的交互式注意力神经网络,使用两个注意力网络来交互地检测方面和上下文内容之间重要的信息。Tang等[8]引入了一种面向方面的情感分类的端到端存储网络模型,该模型使用具有外部存储器的注意力机制,来捕获相对于给定方面的每个上下内容单词的重要性。这种方法明确推断出每个上下文词语在推断该方面的情感极性时的重要性。

2 双层注意力循环神经网络模型

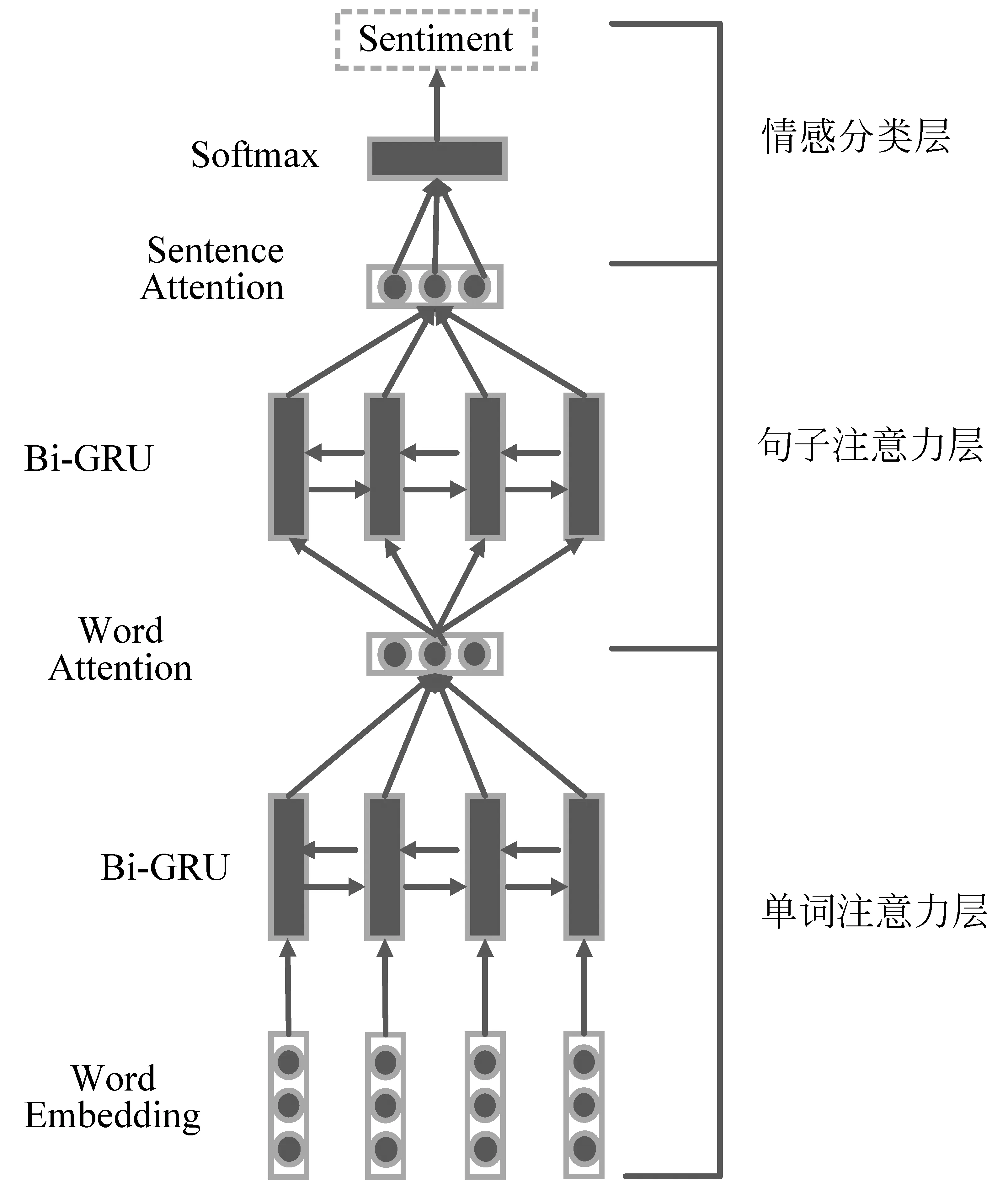

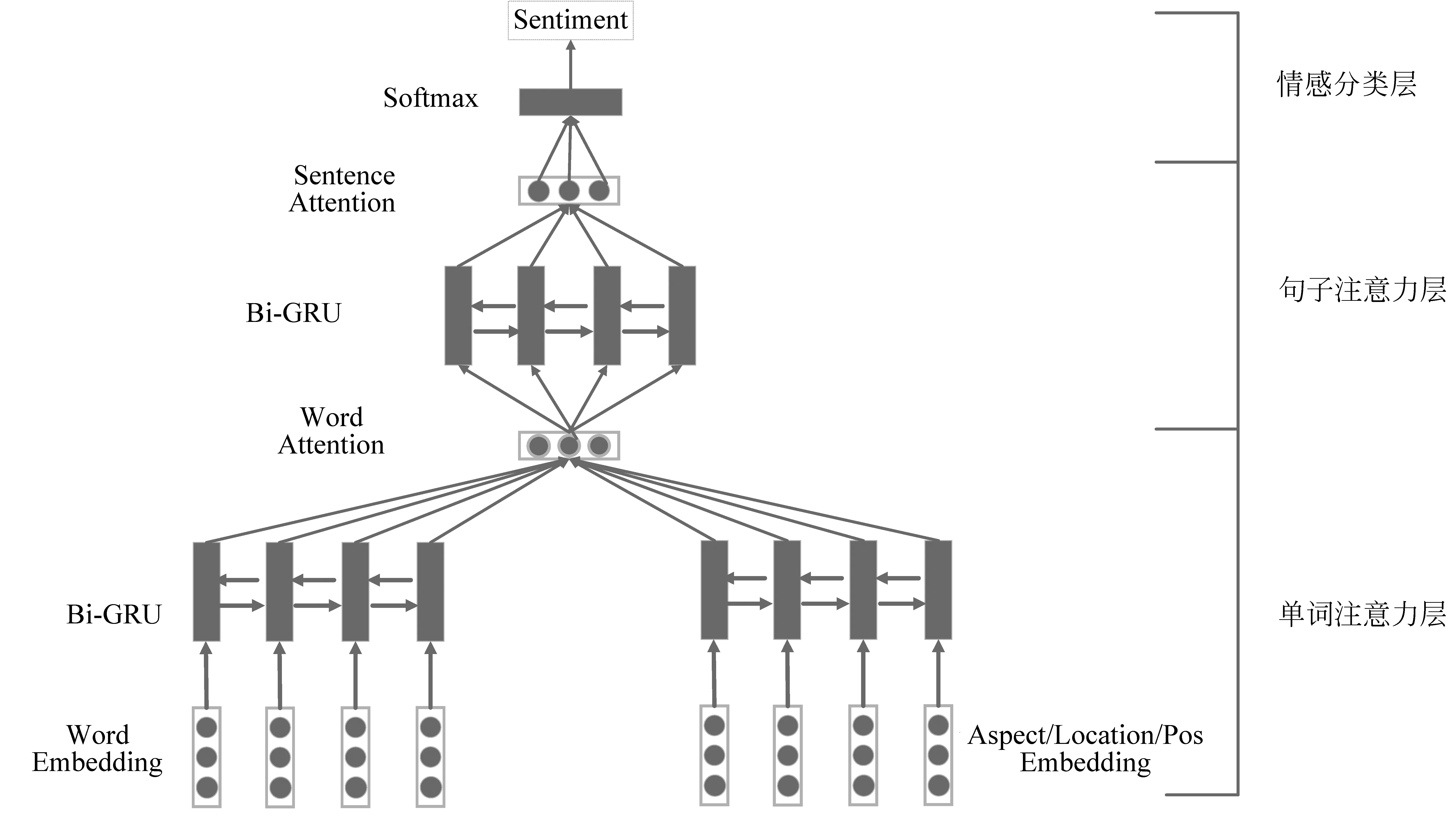

本节主要介绍双层注意力循环神经网络结构的相关细节,该模型的结构如图1和图2所示。图1为双层注意力循环神经网络基本模型,该网络结构只把上下文内容输入神经网络模型中,不添加辅助信息。图2为添加辅助信息的双层注意力循环神经网络模型。该网络结构除了输入上下文内容外,也将方面、位置、词性信息作为辅助信息输入神经网络模型中,左侧部分输入为词嵌入,右侧部分输入为辅助信息嵌入。双层注意力循环神经网络包括单词注意力层、句子注意力层、情感分类层。

图1 双层注意力循环神经网络基本模型

图2 添加辅助信息的双层注意力循环神经网络模型

2.1 辅助信息

本文将方面、词性信息以及位置作为辅助信息输入到模型中。

Jiang等[18]指出:40%的情感分类错误是由于不考虑情感分类中的方面而造成的,近年的研究工作往往在建模时特别加强方面的效果并已经充分验证了方面的重要性,在生成特定于方面的表示时可以精确对上下文内容建模,因此,本文将方面作为模型输入的一部分。

本文将词性信息作为另外一个辅助信息,它是文本的一个重要特征,而评价词是基于用户主观意识的,用于区分用户对方面的喜爱或者厌恶程度,表达用户对方面的情感极性。评价词在方面级情感分类中占有更高的权重比例。通过模型学习句子的不同词性信息,给予不同词语不同的权重,使评价词等比较重要词语占有更高的比重。

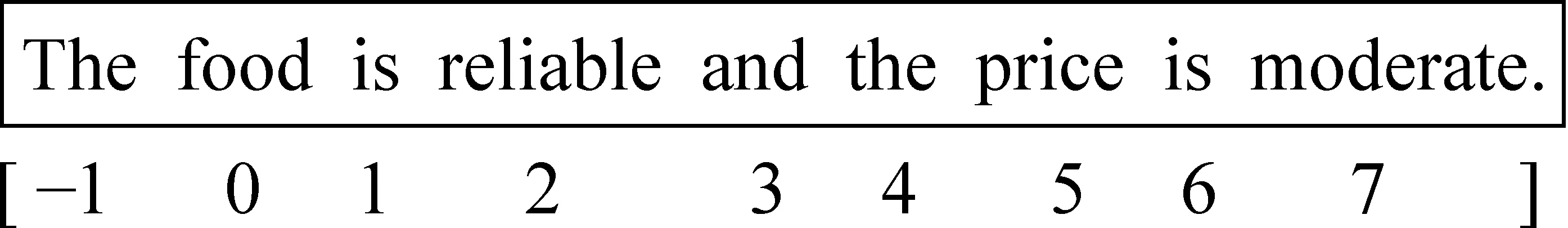

另外,在方面级情感分析任务中,词语和方面词之间的位置也隐含着重要的信息,从直观上看,距离方面词越近的情感词影响越大。一种简单的距离计算如图3和图4所示。

图3 方面“food”位置关系

图4 方面“price”位置关系

距离方面越近的情感词的权重影响越大,例如,图3中方面词“food”标注为“0”,离方面词“food”比较近的情感词“reliable”距离更短,位置标注为较小值,而修饰“price”方面的情感词“moderate”离方面词“food”更远,因此位置标注为较大值。在图4中情感词“moderate”离方面词“price”距离比情感词“reliable”的更短,位置标注为较小值。位置信息的距离计算方式如下:

(1) 以方面词为基点,将句子分割成左右两部分,方面词被标注为数字“0”。

(2) 左边部分的长度为L,右边部分的长度为R,以方面词为起点分别对左右部分进行扫描,左边部分以-1递减到-L进行标注,右边部分以1递增到R进行标注。如果分割的结果只有左边或者右边一部分,只对一边进行标注。

(3) 将左边部分的标注、方面词的标注、右边部分的标注进行连接,得到最终的标注结果。

2.2 单词注意力层

本文采用双向的GRU[19]获取两个方向的上下文内容信息,GRU有两个门,分别为更新门和重置门。更新门控制前一时刻的状态信息被输入到当前状态中的程度,更新门的值越大说明前一时刻的状态信息输入越多。重置门控制忽略前一时刻的状态信息的程度,重置门的值越小说明忽略的信息越多。在每一时刻,GRU的隐藏状态计算如式(1)~式(4)所示。

其中,rt表示更新门,zt表示重置门,ht-1表示为上一时刻隐藏状态,xt表示输入序列信息,Wt、Wz、W为权重参数,σ是sigmoid函数。

双向的GRU包含了向前的GRU和向后的GRU,GRU顺序获取句子信息,GRU反序获取句子的信息,图1网络结构单词注意力层双向的GRU最终输出的隐藏状态如式(5)~式(8)所示。

图2单词注意力层的左侧双向GRU的最终隐藏状态的计算过程与式(5)~式(8)一致,右侧辅助信息输入序列可以是方面、位置信息、词性信息,右侧双向GRU计算过程如式(9)~式(12)所示。

其中,FF表示辅助信息嵌入,即方面嵌入Tw、词性嵌入Pw、位置信息嵌入Lw。将上述隐藏层的输出作为注意力层的输入,图1单词注意力层输出计算过程如式(13)~式(15)所示。

其中,Wc为权重参数,bc为偏置参数,u为注意力层的输出。图2左侧的注意力层的计算过程与式(13)~式(15)一致。图2右侧的注意力层的计算过程如式(16)~式(18)所示。

(18)

其中,Wf为权重参数,bf为偏置参数,v为注意力层的输出。另外,图2单词注意层的输入包括上下文内容和辅助信息,因此,单词注意层的输出为左右侧注意力输出的连接,如式(19)所示。

a=u⊕v

(19)

其中,⊕代表连接操作,图2网络结构的单词注意层的输出a是左右部分输出的连接,代表在单词注意层不同单词和辅助信息的权重的连接。

2.3 句子注意力层

将单词注意力层的输出作为句子注意层的输入,则经过双向的GRU的输出如式(20)~式(22)所示。

其中,xs为单词注意层的输出,即图1的单词注意层的输出u和图2的单词注意层的输出a。

将双向GRU的输出输入到注意力层,句子注意层计算每个句子的重要程度,计算过程如式(23)~式(25)所示。

其中,Ws为权重参数,bs为偏置参数,S为句子注意层不同句子的权重大小。

2.4 情感分类层

方面级情感分类属于分类问题,情感分类层将句子注意力层的输出S输入到分类器中,并计算情感类别的概率,其计算过程如式(26)所示。

P=Softmax(WpS+bp)

(26)

其中,WP和bp分别为权重参数和偏置参数,S为句子注意力层的输出。

3 实验

3.1 数据集

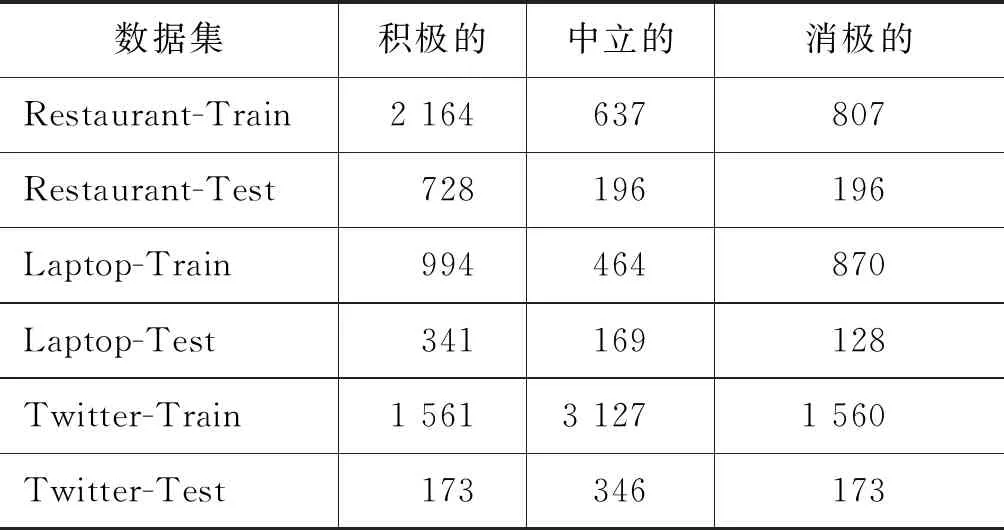

为了验证本文提出的模型性能,在三个数据上进行了实验,数据统计如表1所示。分别使用了SemEval 2014 Task4的Laptop和Restaurant数据集,另外一个数据集为Twitter数据集[6]。这三个数据集包含用户的评论信息、对象以及方面的情感极性标签,方面的情感极性分为三类,分别是积极的、消极的、中立的。

表1 三个数据集的统计数据

3.2 评价指标

为了验证方面级情感分类的性能,本文采用准确率作为评价指标,定义如式(27)所示。

(27)

其中,Acc是所有样品中正确预测样本的百分比,T是正确预测的样本数,N是样本总数,总的来说,Acc越大,准确性越大,模型的性能具有较高的精度。

3.3 目标函数

方面级情感分类是分类问题,使用交叉熵损失函数作为目标函数,如式(28)所示。

(28)

3.4 参数设置

模型的训练采用Adam[20]优化器进行优化,词嵌入和对象嵌入的维度大小为300,用Glove训练好的的词向量初始化词嵌入和方面嵌入,词性嵌入和位置关系嵌入的维度大小为100,随机初始化。偏置初始化为零,学习率设置为0.01,Dropout[21]设置0.5,激励函数为Relu,GRU的隐藏单元数为300,全连接层隐藏单元数为200。

3.5 对比模型

本文对比模型如下:

•Majority:是一种基线方法,它将训练集中的最大情感极性分配给测试集中的每个样本。

•LSTM[11]:采用一个标准的LSTM神经网络进行方面级情感分类。

•TD-LSTM[11]:采用两个LSTM分别对左对象和右上下文内容建立模型,以预测方面的情感极性。

•AE-LSTM[7]:先通过LSTM网络对上下文内容进行建模,再将单词隐藏状态与方面嵌入相结合,以监控注意力向量的生成,然后使用注意力向量生成面向方面的最终情感分类表示。

•ATAE-LSTM[7]:以AE-LSTM为基础。它进一步增强了方面嵌入的效果,将方面嵌入附加到每个单词隐藏向量,并利用注意力机制来获得每个隐藏向量的权重大小。

•IAN[12]:采用注意力机制学习上下文内容和方面的交互关系,并分别为上下文内容和方面生成表示。

本文模型如下:

在以下模型中,H是层次(Hierarchical)的缩写、C是内容(Content)的缩写、A是方面(Aspect)的缩写,P是词性(POS)的缩写,L是位置(Location)的缩写,模型的名称是这些单词的缩写组成。

•HC:采用双层注意力,模型的输入只考虑上下文内容。对上下文内容进行建模,在单词层和句子层添加注意力,分别捕获不同单词和不同句子的权重大小。

•HCA:在HC模型的基础上,考虑方面的重要性,分别对上下文内容和方面进行建模。

•HCP:在HC模型的基础上,将词性信息作为模型输入的一部分,分别对上下文内容和词性信息进行建模。

•HCL:在HC模型的基础上,考虑位置信息的影响,分别对上下文内容和位置信息进行建模。

3.6 实验结果

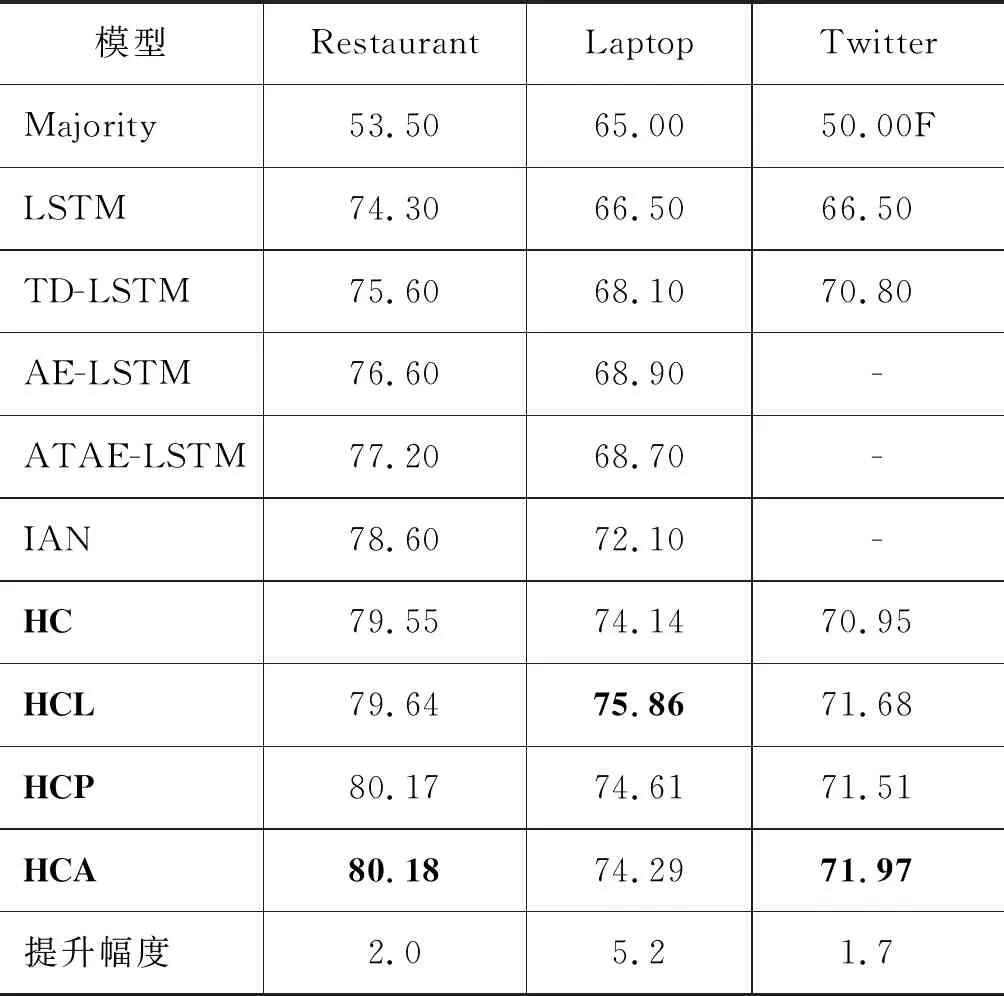

实验结果如表2所示,HC、HCL、HCP、HCA为本文模型。HC采用了双层注意力,HCL、HCP、HCA在双层注意力基础上,分别添加了位置、词性信息和方面辅助信息。表中加粗字体代表实验最好效果。

表2 不同方法在三个数据集上的ACC实验结果对比(%)

从表2可知,Majority方法效果最差,这个方法是将训练集中的最大情感极性分配给测试集中的每一条数据,这意味着在Restaurant、Laptop、Twitter数据上多数情感极性分别占53.50%、65.00%、50.00%。所有基于LSTM的方法的实验效果都比只用LSTM的好。TD-LSTM考虑了方面在实验中的影响,TD-LSTM实验结果比LSTM提高了1%~2%,说明方面确实对实验效果具有提升作用。AE-LSTM和ATAE-LSTM实验效果比TD-LSTM好,因为这两个模型添加了注意力机制。

IAN在不同的数据上表现不同。由于考虑了上下文内容和方面之间的交互作用,采用注意力分别对方面和上下文内容进行建模,在Restaurant和Laptop数据上实验效果均好于上述实验。实验结果表明考虑方面与上下内容之间的交互能影响模型的分类准确率。

在本文提出的模型中,HC模型在Restaurant和Laptop数据上的实验效果比IAN模型均有不同提升。在Twitter数据集上,HC模型的实验效果比在TD-LSTM略好,说明双层注意力能够获取深层次的情感特征信息,在单词层面和句子层面,不同的单词和不同的句子获取了不同的权重。

基于HC模型的HCL、HCP和HCA模型,在三个数据上的实验效果对比HC模型均有不同的提升。HCL模型在Laptop数据集上实验效果最好,比在IAN模型上的实验效果提升了5.2%。HCP模型实验效果在三个数据集上的效果均好于HC模型,在Restaurant数据上的实验效果比HCL模型的好,说明词性信息是影响方面级情感分类的重要因素,能提升模型实验效果。HCA模型在Restaurant和Twitter数据上的实验效果达到了最好,比IAN模型在Restaurant数据实验效果提升了2.0%,比TD-LSTM模型在Twitter数据集上的实验效果提升了1.7%。

综上所述分析,本文提出的模型实验结果表明,添加方面、词性信息、位置作为模型的辅助信息对模型的性能有较大影响,对方面级情感分类的准确率具有提升作用。

3.7 双层注意力和辅助信息的影响

为了更深入分析双层注意力和辅助信息对实验结果的影响,设计了多组实验进行分析比较。其中,实验名字中的W是Without的缩写,代表没有双层注意力。实验如下:

•WHC:模型的输入只考虑上下文内容,无双层注意力。

•WHCA:模型的输入只考虑上下文内容和对象,无双层注意力。

•WHCP:模型的输入只考虑上下文内容和词性信息,无双层注意力。

•WHCL:模型的输入只考虑上下文内容和位置关系信息,无双层注意力。

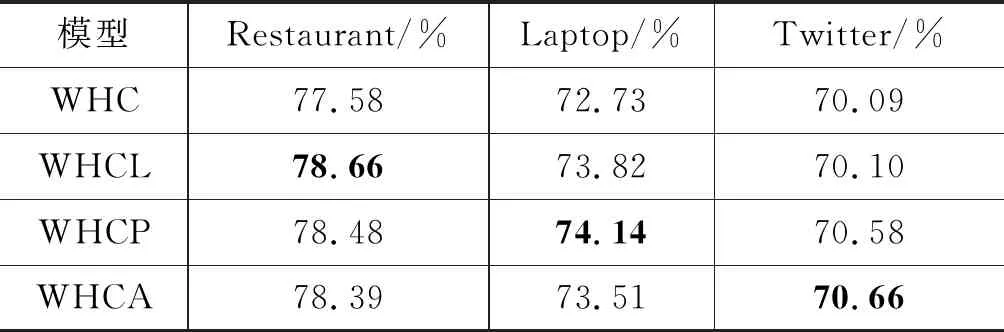

表3为上述四组实验在三个数据上的实验结果,加粗字体为本组实验中最好的结果。表3的实验结果表明,方面、位置信息、词性信息对不同的数据集的敏感程度不同。下面将表2和表3的实验结果对比,进行注意力和辅助信息对模型的影响分析。

表3 无双层注意力在三个数据集上ACC的实验结果对比

双层注意力的影响:实验HC与WHC、HCL与WHCL、HCP与WHCP、HCA与WHCA在三个数据上的实验结果进行对比,有双层注意力的HC、HCL、HCP、HCA的实验结果在三个数据集的效果比无双层注意力的WHC、WHCL、WHCP、WHCA的都好,说明双层注意力在单词层面和句子层面能捕获序列中深层次的情感特征信息,能够分配不同的权重给不同的信息,给予重要的单词和句子更高的权重。

辅助信息的影响:实验HCL、HCP、HCA与HC、实验WHCL、WHCP、WHCA与WHC这两组实验进行对比表明,有辅助信息的模型的实验结果在不同程度上都有提升。不同的辅助信息对同一数据集的实验效果的提升程度不同,相同的辅助信息对不同数据集的提升程度也不一样。实验HC与HCA、实验WHC与WHCA的对比表明,考虑方面的重要性,将方面与上下文内容进行建模能够提升模型的效果。实验HC与HCL、实验WHC与WHCL的对比表明,位置信息是影响模型的重要因素,离方面词距离越近的词,一般越重要,分配的权重越大。实验HC与HCP、实验WHC与WHCP的实验结果表明,添加词性信息也能提升模型的效果,不同词性的词对模型的贡献程度不一样,评价词是基于用户主观意识的,能区分用户对方面的喜爱或者厌恶程度,方面用的评价词占有更高的权重比例,因此评价词的词性占更高的权重比例。

4 总结

为了获取深层次的情感特征信息,本文提出一种基于双层注意力循环神经网络模型,并且将方面、词性信息、位置作为模型的辅助信息输入神经网络模型中。实验结果表明,基于双层注意力循环神经网络模型的学习能力更强,具备学习序列的深层次情感特征信息的能力,模型的预测性能更好,验证了方面、词性信息、位置作为辅助信息对方面级情感分类的准确率具有提升作用。

虽然本文提出的模型在三个数据集上的实验效果都取得了提升,但模型只考虑了单独的辅助信息对模型的影响,没有考虑方面、词性信息和位置共同对模型的影响。下一步的工作将研究多个辅助信息共同对方面级情感分类的作用,并设计实验进行验证分析。