基于特征融合的仿生SLAM算法研究

王 均,凌有铸*,王 静

(1.安徽工程大学 电气工程学院,安徽 芜湖 241000;2.巢湖学院 电子工程学院,安徽 巢湖 238000)

移动机器人在未知环境中运动时逐步构建环境地图,同时运用此地图对机器人进行位姿估计,即运动机器人的同时定位和地图创建(SLAM)。一般的地图构建和定位系统需要有环境的先验信息或者环境的模型,但是SLAM系统在地图信息和机器人位置不明确的情况下仍然可以工作,即使在环境改变的情况下仍然可以工作。对SLAM问题的解决方法运用最为广泛的是基于数学概率的方法[1]。数学概率方法的实现是建立在传感器平台上的,传感器虽然类型和能力各有不同,但是都存在使用限制和不同程度的噪声,因此使用精准的传感器是提高机器人SLAM的精度和可靠性的一个方法[2]。自然界中的生物采用完全不同的办法来解决这个问题,它们不需要高精度的传感设备就可以在复杂环境中进行地图构建和导航。这是因为动物具备同步地图构建和导航的能力[3]。受动物空间认知的启发,在过去的几十年里,许多研究者都在研究动物是如何感知、存储和维持空间认知的。生物的这种能力为SLAM在移动机器人中的应用指示了研究方向[4]。

澳大利亚学者Michael[5-7]等就提出一种啮齿动物海马区扩展模型(RatSLAM),该模型通过头方向细胞和位置细胞网络的融合构建位姿感知细胞网络,将路径积分和视觉关联过程集成到位姿细胞模型中。然而,位姿感知细胞矩阵中最终的空间表征是不连续的,RatSLAM表征也会出现两种附加现象:冲突和多冲表示。研究者们为解决这三个问题,在RatSLAM基础上根据机器人位姿表征和环境表征的对应关系,扩展出一种经历制图算法,该算法直接存储了环境空间、时间、机器人视觉、行为和变化等信息[8-9]。

RatSLAM算法的经验图中的活动具有一些几何属性,但仍然不能以人类可读的形式表示,文献[10]引入了一个“RatChat”的新系统,利用语言游戏范式构建空间概念作为交流基础,实现了人类与机器人的交流。文献[11]将RatSLAM算法的基本原理与标准的概率SLAM算法进行了比较,训练出一种新的非贝叶斯因果更新过滤器,并通过实验证明了它在功能上可以代替RatSLAM算法的核心。文献[12-13]在RatSLAM算法的基础上加入了多传感器融合,同时介绍了一种基于运动的自动校准技术,该技术可以校准位置识别和自动过程,并在室内和室外环境中都验证了方案的可行性。文献[14]通过调整给定的约束条件,将RatSLAM系统用于人形机器人平台。此外还引入了一种多重假设建图技术,这种算法在同一时间跟踪多个空间机器人的假设位置,并对它们的合理性进行加权,从而提高了开放空间建图的鲁棒性。文献[15]将RatSLAM系统中经验地图算法用于RGBD-SLAM算法,解决了RGBD-SLAM算法中需要连续的图像流的问题,克服了由无特征的表面生成的模糊数据的问题,并通过实验验证了算法融合的可行性。

近年来,基于特征的视觉SLAM方法在SLAM领域得到了广泛应用。SIFT[16-17]特征经过十几年的发展已取得巨大成功,是一种非常流行和实用的视觉处理算法。SIFT描述符由128维向量表示,使其具有旋转不变性等优良性能,对光线变化也有鲁棒性。同时其能够比较方便地与其他相关的特征向量进行融合。GIST[18-19]特征是模拟人的视觉特点提出的。利用多尺度多方向的Gabor滤波器组分别与图像进行卷积运算,得到图像的GIST特征。针对传统RatSLAM算法中局部场景的形成和匹配过程中,没有对场景的几何处理和特征提取,导致其对光线变化的敏感性,以及不能识别已有模板图像旋转后的图像的问题,研究在局部场景形成阶段,分别提取局部场景图像的GIST特征和SIFT特征,串行融合后形成局部场景特征模板存储入局部场景细胞,改进了原RatSLAM对光线变化敏感的问题,同时提高了检测的准确率。

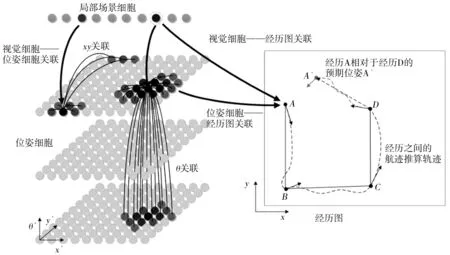

图1 RatSLAM模型

1 RatSLAM模型

RatSLAM模型包括位姿感知细胞网络、局部视图细胞以及局部场景细胞和位姿细胞共同作用形成的经历图,模型如图1所示。

1.1 位姿感知细胞网络内部动态过程

(1)兴奋度更新。创建兴奋度权重矩阵εabc:

(1)

式中,a、b、c为x′、y′、θ′的分布系数;θ′维和(x′,y′)平面方差常数分别是kθ′和kx′y′;位姿感知细胞活性因兴奋性致使的变化ΔPx′y′θ′:

(2)

式中,(x′,y′,θ′)空间中位姿感知细胞的三维矩阵元素分别为Nx′,Ny′,Nθ′。

(3)

式中,φ为抑制常数,控制全局抑制水平。

(4)

归一化可以使获得积分路径输入和视觉输入后的位姿细胞总活性在0~1之间。

1.2 场景学习

(5)

(6)

式中,Px′y′θ′为位姿感知细胞的活动水平;Vi为局部场景细胞的活动水平。

1.3 经历图的绘制

经历由位姿感知细胞和局部场景细胞中的活性驱动产生。当已有的经历集不足以描述机器人的活动状态时,就将产生一个新的经历。第i个经历如式(7)所示。

ei={Ei,Pi,Vi},

(7)

(8)

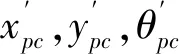

2 融合全局与局部特征的RatSLAM模型

RatSLAM中局部场景由一个一维细胞单元阵列组成,其中细胞单元对应存储着特征值模板。将照相机采集到的图像转换为灰度图像,分别提取图像的GIST特征和SIFT特征,并将向量标准化到(0,1)的范围内,串行融合组成局部场景特征模板。融合后的RatSLAM技术路线如图2所示。

图2 技术路线

2.1 GIST特征提取

GIST特征的核心是通过Gabor变换提取全局特征。先对输入图像预处理,之后利用多尺度多方向的Gabor滤波器组分别与图像进行卷积运算,得到图像的全局特征。二维Gabor变换核函数表达式为:

gmn(x,y)=a-mgσx′σy′ω(x′,y′),a>1,

(9)

(10)

x′=a-m(x·cosθ+y·sinθ),

(11)

y′=a-m(-x·sinθ+y·cosθ),

(12)

(13)

式中,x、y为像素点的位置信息;σx和σy分别为沿x和y方向上的高斯标准差;n为方向数;m为尺度数;a-m为尺度变换系数(尺度因子)。

将一幅灰度图像I(x,y)划分成大小相等的4×4个网格,每个小块图像大小为h×d,对每个小块图像用4个尺度8个方向的Gabor滤波器组进行卷积滤波,并将滤波后的结果级联起来,形成该小块的特征。将上述每一小块计算出的特征值取平均值,得到该小块的Gist特征:

(14)

式中,nc=m×n为滤波器个数。整幅图像的Gist特征由每一小块计算出的32个平均特征值级联得到,其维数为4×4×32=512维。

2.2 SIFT特征提取

SIFT算法在图像与高斯函数卷积生成的尺度空间中寻找极值点来确定关键点位置,然后计算关键点周围的梯度信息,进而生成SIFT特征描述子。SIFT特征描述子对旋转、尺度缩放、亮度变化等保持很好的不变性。

尺度空间L(x,y,σ)是由高斯函数G(x,y,σ)与二维图像I(x,y)卷积生成。

L(x,y,σ)=G(x,y,σ)·I(x,y),

(15)

(16)

式中,x、y为像素点的位置信息;σ是尺度空间因子。

构建高斯差分(Difference of Gaussian,DOG)金字塔D(x,y,σ),比较每个点与其相邻的尺度和上下相邻位置共计26个特征点的值,当某点为最大值或最小值时,则该点是该尺度下的一个特征点。DOG算子定义如下:

D(x,y,σ)=(G(x,y,kσ)-G(x,y,σ))·I(x,y)=L(x,y,kσ)-L(x,y,σ),

(17)

其中,k为相邻尺度空间的倍数。利用特征点相邻的邻域点梯度方向分布特性为每一个特征点确定方向信息,其中包括了特征点的梯度值m(x,y)与方向θ(x,y)。

(18)

(19)

以关键点为中心划分为16个子块,计算各子块8个方向的梯度累加值,并绘制梯度方向直方图,得到一个128维的描述子向量,最后将特征向量的模长做归一化处理。

2.3 局部场景特征模板匹配

设该图像的GIST特征向量为:Xgist=[X11,X12,…,X1n],SIFT特征向量为:Xsift=[X21,X22,…,X2m],串行融合后形成局部场景特征模板为:X=[Xgist,Xsift]。

使用欧氏距离来评估新的模板和之前学习的模板之间的相似程度。若超过阈值,就会学习到新的局部场景特征模板,否则,被认为是匹配的。一个新的局部场景特征模板只有在当前的局部场景特征模板没有匹配的情况下才会被学习。

3 实验与结果分析

实验采用移动机器人平台“旅行家Ⅱ号”,平台上搭载了编码器、视觉传感器、激光传感器、声呐传感器、电子罗盘。移动机器人实验平台如图3所示。实验场景选取9 m×6 m的会议室环境。实验内容为机器人在环境中行走两圈之后改变环境光线,同时通过摄像头采集图像并将采集信息传输至上位机,进行仿真实验。

图3 实验平台

3.1 特征提取

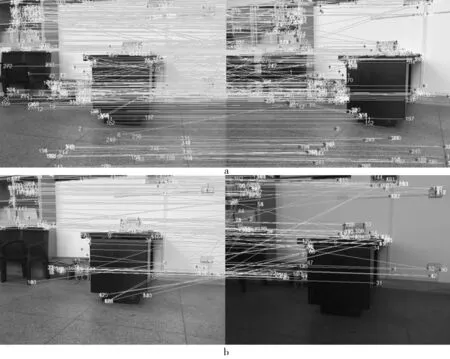

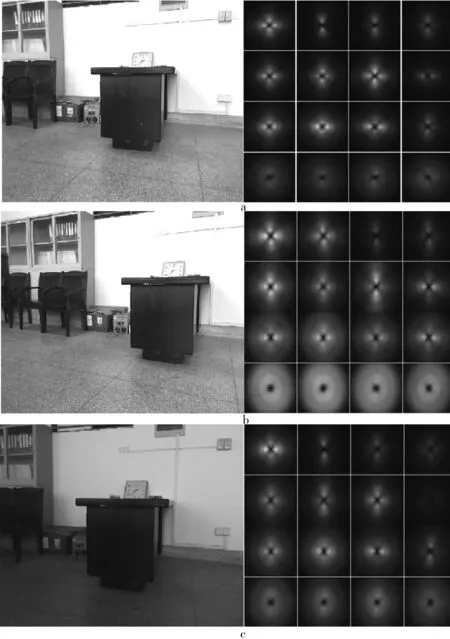

第一圈中相邻帧的SIFT特征提取与匹配如图4a所示。第一圈与改变光线之后的第三圈形成闭环位置的SIFT特征提取与匹配如图4b所示。SIFT特征旋转不变性能强,一定程度上也能对抗光线变化。第一圈中相邻帧的GIST特征如图5a、图5b所示。第三圈在与第一圈形成闭环处的GIST特征如图5c所示。

图4 SIFT特征提取与匹配

图5 GIST特征提取

3.2 经验节点匹配

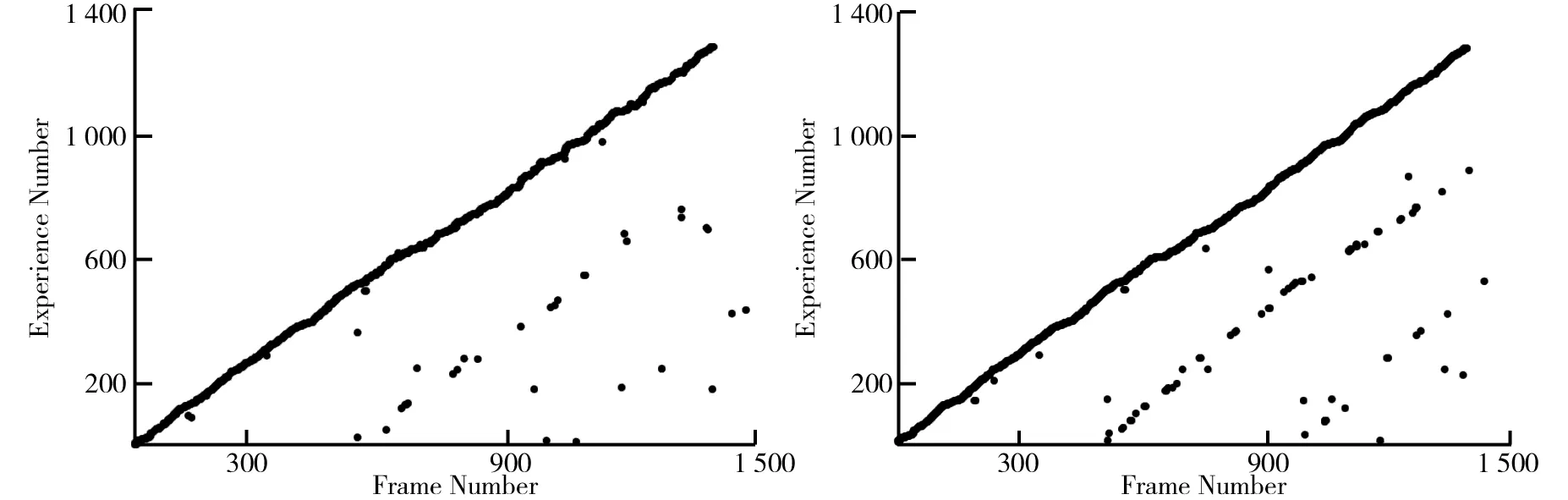

RatSLAM模型经验节点匹配图如图6所示。在前两圈的实验中,RatSLAM模型能够一定程度的匹配局部场景模板,但是第三圈改变环境光线之后,RatSLAM模型匹配局部场景模板数量降低,后续匹配效果变差。RatSLAM+SIFT模型经验节点匹配图如图7所示。RatSLAM+GIST模型经验节点匹配图如图8所示。相较于RatSLAM模型,两组实验中检测到的闭环数量都有所增加。其中,RatSLAM+SIFT模型第二圈实验效果较好,RatSLAM+GIST模型在改变环境光线之后的第三圈匹配效果较好。特征融合的RatSLAM模型经验节点匹配图如图9所示。在前两圈的实验中,特征融合的RatSLAM模型相较于前三组实验有更多的经验节点匹配到局部场景模板,第三圈改变环境光线之后,也能很好地完成闭环检测。

图6 RatSLAM模型经验节点匹配图图7 RatSLAM+SIFT模型经验节点匹配图

图8 RatSLAM+GIST模型经验节点匹配图图9 特征融合的RatSLAM模型经验节点匹配图

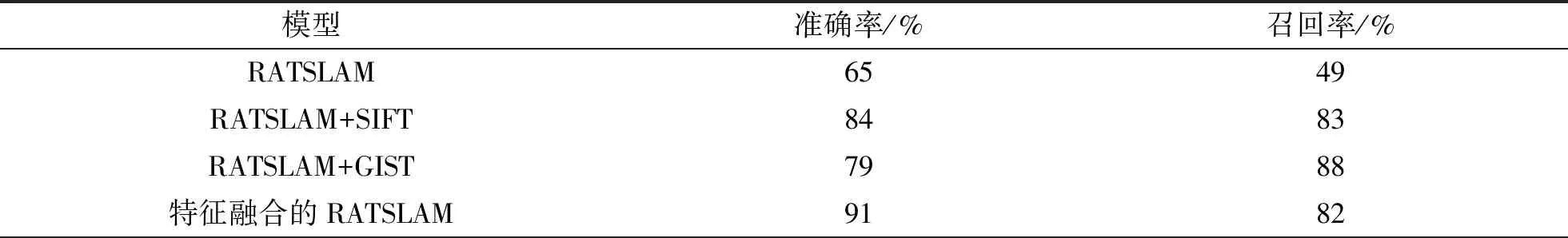

RatSLAM模型和特征融合的RatSLAM模型准确率与召回率的对比如表1所示。由表1可知,RatSLAM模型的准确率与召回率分别为65%和49%,RatSLAM+SIFT模型的准确率与召回率分别为84%和83%,RatSLAM+GIST模型的准确率与召回率分别为79%和88%,融合特征点的RatSLAM模型准确率和召回率分别为91%和82%。相较于RatSLAM模型,特征融合的RatSLAM模型准确率和召回率都得到提升。

表1 RatSLAM模型和特征融合的RatSLAM模型性能对比

3.3 经验地图

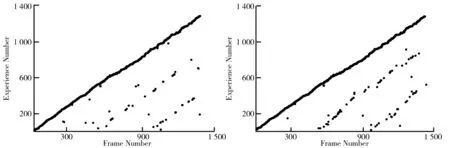

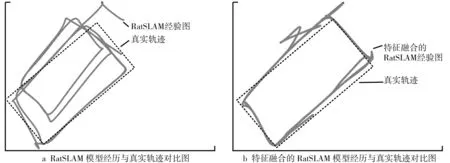

RatSLAM模型构建的经历图与真实轨迹对比如图10a所示,特征融合的RatSLAM模型经历图与真实轨迹对比如图10b所示。由图10可知,RatSLAM模型在第三圈光线变化之后,经历图产生了偏移,而特征融合的RatSLAM模型的经历图更符合实际轨迹。

图10 RatSLAM模型经历、特征融合的RatSLAM模型经历与真实轨迹对比图

4 结论

研究中提出的特征融合的RatSLAM算法改进了现有RatSLAM仿生算法下由于光线变换等状况造成的导航不稳定的问题,系统鲁棒性增强,同时提高了系统检测的准确率。当前的融合算法给定识别阈值,若系统自动调整识别阈值是否能够提高召回率,以及如何通过现有的图像处理技术与仿生算法相融合的手段处理复杂环境,这些仍值得进一步研究。