基于概率神经网络图像识别的移动机器人控制研究

黄 玉 钏

(国家安全生产监督管理总局通信信息中心,北京 100013)

1 引 言

应急物资物流管理是指原材料、产成品从起点至终点及相关信息有效流动的全过程.它将运输、仓储、装卸、加工、整理、配送、信息等方面有机结合、形成完整的供应链,为用户提供多功能、一体化的综合性服务,物流自动化是一个经常需要面对的棘手问题.传统的自动导引车系统 (AGV) 仍然是内部运输作业自动化成熟的解决方案.AGV移动机器人的轨迹控制过程,需要移动机器人持续不断地跟随设定路径,期望轨迹规划的目标点不断输入到移动机器人控制器中,并通过车载传感系统感知道路环境,自动规划行车路线并控制机器人到达预定目标.常用的轨迹导航控制有:磁导航、二维码导航、激光导航、视觉导航等[1,2].磁导航的缺点是磁条容易破损,需定期维护,路径变更需重新铺设磁带,改变或扩充路径较麻烦.二维码导航的缺点:如果场地复杂,则需要频繁更换二维码,对陀螺仪的精度及使用寿命要求严格,对场地平整度有一定要求,价格较高.激光导航的缺点:制造成本高,对光线、能见度等要求较高.视觉导航可以通过视觉形状标识符较为方便实现车辆加速、减速、直角转弯、特殊地点停车等运动状态控制.

本文着重讨论基于视觉导航的移动物流机器人轨迹控制,视觉导航通过摄像机采集收集近距离的环境信息,并利用图像分析处理获得输入信息,作为导航的起始目标位置.学者们对视觉导航的关键技术进行了大量研究[3,4],诸如D.L.Boley等研制的移动机器人,通过车载机器人和传感器实现基于路标的轨迹控制,比直接采用卡尔曼滤波器具有更好的实时性.A.Ohya等人利用移动机器人车载摄像机和超声传感器,解决了视觉导航的碰撞问题,C.Fermuller等利用车载摄像机实现了一种基于三维运动和景物形状描述的导航方法.P.I.Corke等利用车载摄像机实现了一种高精度路径跟踪的闭环系统.吴东晖定义了符合摄像机特点的局部规划用地图的数据结构,通过介绍如何融合彩色道路图像理解、立体视觉障碍物检测以及以前的历史数据,给出了一个利用地图数据结构来融合多传感器的示例,并完成局部路径规划.

本文改进的措施是:采用了便于图像识别的特征集,实现了输入图像的有效辨识,并完成了图像辨识结果和机器人控制器的融合.本文研究的路线是,首先根据图像标识库的特征集来训练概率神经网络,然后利用摄像头获取新的图像标识传递给概率神经网络进行辨识,最后利用辨识结果作为移动机器人控制器的输入,在移动机器控制器的基础上完成了特定轨迹自主控制.在移动机器人控制器设计中采用了鲁棒性较强、调整速度较快的抗积分饱和PID、MPC控制方法.

2 移动机器人轨迹控制建模

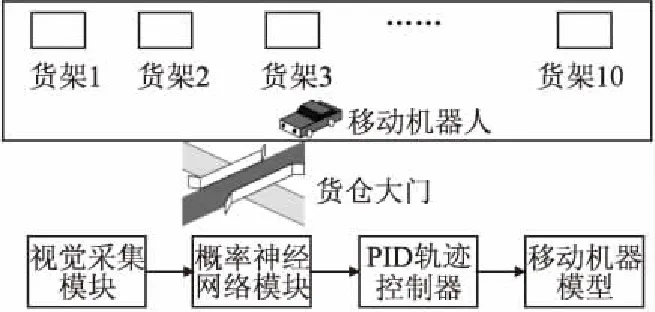

移动机器人控制流程如图1所示.其中,视觉采集模块采用摄像头实现外部信息的采集;概率神经网络模块实现采集处理结果的自动识别,识别结果传递给轨迹控制器转化为移动机器人的设定速度和转角,并根据控制算法控制移动机器人自主完成轨迹控制.

实际的应用场景:10个货架保存了不同类型应急物资,每个货架上由管理员手写的0-9中某一数字标识物资类别,数字标识安装在货架固定位置,由于物资货架的编号时常发生变化.当货仓大门处的移动机器人接收到外部信号,机器人会到相应的货架获取货物,并完成自主的路径规划,节约成本,提高效率.

图1 移动机器人控制流程Fig.1 Control flow of mobile robot

本采用的移动机器人采用四轮小车模型[5],后驱动的两轮子固定在车体上,前两个轮子可以绕水平轴旋转,以实现方位变换,其模型示意图如图2所示.根据移动机器人的几何模型,我们可以得到它的运动学关系,见公式(1).

图2 移动机器人模型示意图Fig.2 Mobile robot model schematic diagram

(1)

2.1 视觉采集模块

基于MATLAB平台获取外部标识信息,利用imaqhwinfo函数调取winvideo的信息获取摄像头的参数,然后将所获取的视频赋予到obj变量之中.通过摄像头获取一张图像,之后经过裁剪、滤波、二值图像转化和图片特征提取,通过概率神经网络进行计算得出最后结果,其主要步骤如下:

1)创建视频输入对象并命名为obj,obj=videoinput(adaptorname,deviceID,format)

其中,adaptorname为适配器名称,实验中使用的是‘winvideo’;deviceID为设备ID号,format使用DefaultFormat:‘B24_640x480’视频采集格式.

2)设置参数并打开图像预览

帧率设定为Inf,即 obj.FramesPerTrigger=Inf;每一帧的截取的时间隔设定为1秒,即obj.FrameGrabInterval=1;然后预览himage=preview(obj,himage) .

3)获取图像并进行预处理

使用getsnapshot函数获取图像,并利用imcrop函数进行图片格式统一化.使用imfilter、im2bw函数进行滤波和二值化处理,采用imhist函数统计直方图,若像素20%范围内有大于50%的像素量,则采用histeq进行图像均衡化.

4)提取图像特征进行识别

根据图像的14维特征向量进行辨识.特征向量分别是图像的8维的结构特征:1/4、1/2、3/4竖线与字符的交点数量; 1/4、1/2、3/4水平线与字符的交点数量;主对角线、次对角线与字符的交点数量.6维的统计特征:垂直方向1/3~2/3、水平方向1/3~2/3、左上角1/2、左下角1/2、右上角1/2、右下角1/2部分的字符像素.

2.2 概率神经网络模块

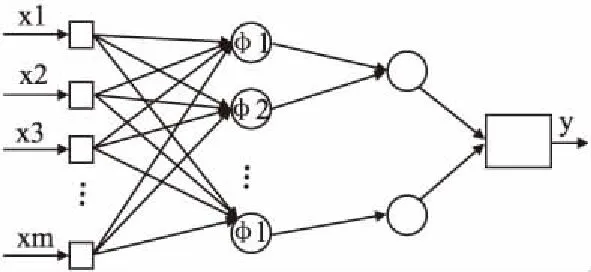

图像识别的采用概率神经网络[6-10](Probabilistic Neural Network,PNN),该网络是基于径向基神经网络(Radial Basis Function Neural Network,RBFNN)的一种拓展,具有的优点:逼近能力、分类能力强,学习收敛速度快、能克服局部极小值问题.PNN根据生物神经元具有局部响应的原理,将径向基函数引入到神经网络中设计而成的.三层前向网络,第一层为输入层,用于接受来自训练样本的值,神经元个数与输入向量长度相等;第二层为隐含层,是非线性的,采用径向基函数作为基函数,从而将输入向量空间转换到隐含层,每个神经元有一个中心,该层通过接受输入层的样本输入,计算输入向量与中心的距离,返回一个标量值,其个数为训练样本个数;第三层为输出层,节点个数等于输出数据的类数,把隐含层中属于同一类的二层神经元的输出做加权平均.本文采用的径向基函数为高斯函数.隐含层节点输出如公式(2)所示.

(2)

其中m为训练样本的总类数,d为样本空间数据的维数,xij为第i个类样本的第j个中心,∑为协方差矩阵.隐含层中属于同一类的神经元加权平均送到输出层,如公式(3)所示.

(3)

其中,vi表示i类,其神经元个数为L.求和层的神经元只与隐含层中对应的类别神经元有连接,与其他神经元无连接.用y表示PNN输出层结果,其值为arg max(vi) .概率神经网络构成示意图如图3所示.

图3 概率神经网络模型示意图Fig.3 Schematic diagram of PNN model

2.3 概率神经网络的训练

PNN训练集选取1000个学习样本,0-9图像样本库,每个数字有100张图片,每个图片样本特征属性为,输入的归一化矩阵如公式(4)所示.

(4)

待识别的样本矩阵为Dp×n,其中第i行,第j列的元素为dij.我们得到待识别元素与同类样本中心的欧式距离矩阵,如公式(5)所示.

(5)

我们计算网络的求和层求得的各个样本属于每类的概率和,其表达式如公式(6)所示.

(6)

第i样本属于第j类的概率为probij,如公式(7)所示.

(7)

PNN输出权值矩阵ω其元素为wij,dij第i个输入向量在第j个输出节点的期望输出,φij构成了Φ矩阵.权重更新策略如公式(8)所示.

ω=Φ+d,Φ=U×S×V,Φ+=V×S-1×U

(8)

其中,Φ+为Φ矩阵的伪逆矩阵,一般通过奇异值分析求得,[USV]=svd(Φ),其中U,S,V分别表示左奇异向量构成的矩阵,对角奇异值矩阵、右奇异向量构成的矩阵.

3 移动机器人轨迹控制仿真

3.1 移动机器人模型仿真

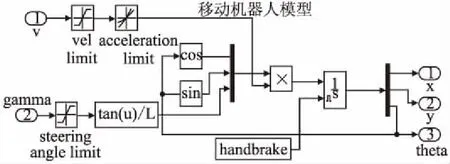

根据移动机器人运动学,利用Simulink完成移动模型建立[11-14],其中速度部分增加了速率限制器,转角部分增加了转角限制器,移动机器人模型如图4所示.

图4 移动机器人仿真模型示意图Fig.4 Schematic diagram of robot simulation model

3.2 移动机器人轨迹控制仿真

我们根据视觉模块识别结果作为机器人移动的目标位置x*,y*:位置控制过程中,移动机器人距离目标作为位置抗积分饱和PID控制器的误差输入,移动机器人转向角控制与转角差作为角度抗积分饱和PID控制器的误差输入,分别如公式(9)、公式(10)所示:

(9)

(10)

根据以上理论,容易得出移动机器人定点位置控制仿真模型,分别如图5所示.

图5 移动机器人定点位置控制仿真模型示意图Fig.5 Robot fixed-point position control schematic diagram

对于任意轨迹控制,采用预测控制实现机器人设定轨迹的跟踪控制.预测控制中所用的符号说明如公式(11)所示.

(11)

(12)

将设定值轨迹规划成一阶指数曲线的形式,从而得到柔化设定值序列.未来j时刻的柔化设定值记为wt+j,设定值记为spt+j,α称为柔化因子.公式(13)是柔化轨迹的形成公式.

wt+k+i=αwt+k+i-1+(1-α)spt

=α2wt+k+i-2+(1-α2)spt

=αiwt+k+(1-αi)spt

(13)

预测控制的目标是使实际输出值与期望输出值方差最小,且控制量的波动尽量小,目标函数及得到的控制率如下,λ为控制量变化量的权重,W=(wt+k,wt+k+1…wt+k+p-1)T.控制量的增量形式如公式(14)所示.

⟹min{(Yt+S*ΔU-W)T(Yt+S*ΔU-W)+λΔUTU}

ΔU=(STS+λI)-1ST(W-Yt)

(14)

不失一般性,这里将移动小车的控制量U与车轮转速近似线性关系n=knU+Cn,其kn,Cn为常数.可以得到车体角速度ω(t)和主动轮中点处的速度v0如公式(15)所示.

(15)

n2,n1分别表示主动轮的左右转速,D为小车的直径,W为两个车轮的距离.我们可以得到公式(16).

(16)

U2,U1分别表示左右轮的动力源控制量,容易得出关系ΔU=(U2-U1)=ω(t)W/Dπkn.我们用Ex,Ey表示机器人在X和Y轴方向的位移,则可以得到公式(17).

(17)

在限制机器人大转角和控制v0=v条件下,我们可以根据公式(17)得到公式(18).

(18)

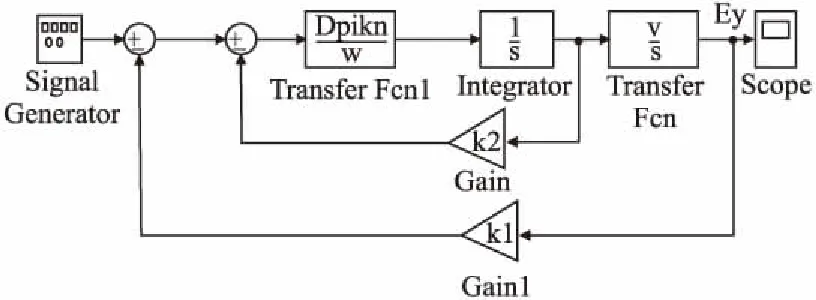

对公式(18)和动力源控制量关系进行拉氏变换,可以得到公式(19).

Ey(s)=v0θ(t)/s,θ(s)=ω(t)/s,ΔU=Wω(s)/Dπkn

(19)

这样可以得到位置、速度的反馈控制结构如图6所示.

图6 机器人反馈控制示意图Fig.6 Robot feedback control schematic diagram

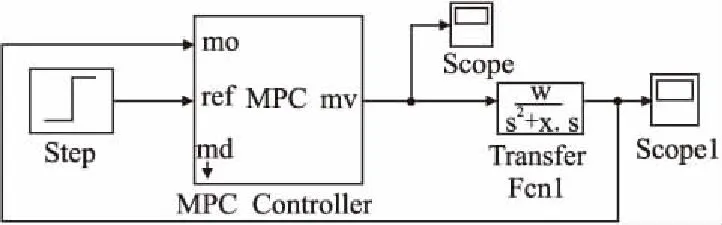

将图6的控制系统整理为单位反馈形式,并引入预测控制器(MPC)完成特定直线轨迹的控制,如图7所示.

图7 机器人预测控制示意图Fig.7 Robot MPC control schematic diagram

在图7中,w和x分别表示为(Dπknv0k1)/ω,k2[Dπkn/(4v0k1ω)]1/2w1/2.

4 实验结果

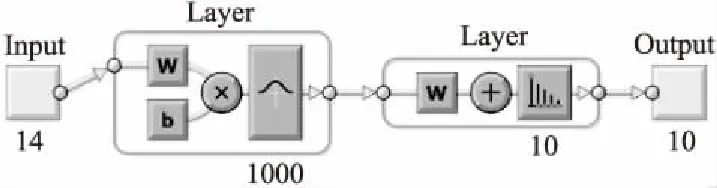

图8是PNN网络的生成图,输入层的数量14代表输入图像的14维特征,中间层1000个径向基函数由训练样本决定,输出层为10,由分类的数目决定.

图8 PNN生成图Fig.8 PNN schematic diagram

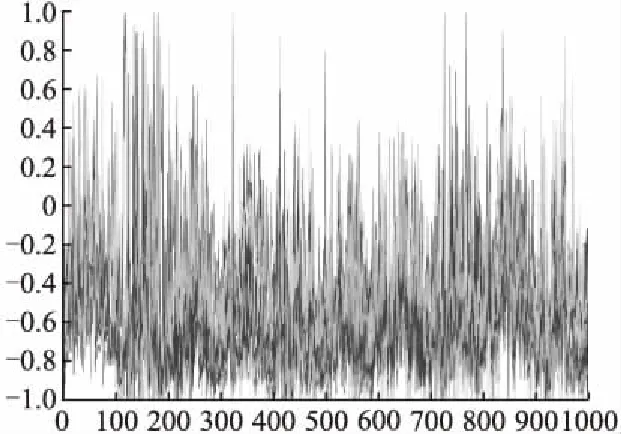

图7是PNN网络的IW参数(1000X14维矩阵)生成图,也就是输入特征到隐藏层的连接权重,我们可以看到均值为负,平均值,中值,标准差分别是-0.3812,-0.4483,0.3683,说明特征中心大多在特征左侧.

图9 PNN网络的IW参数Fig.9 Parameters IW of PNN

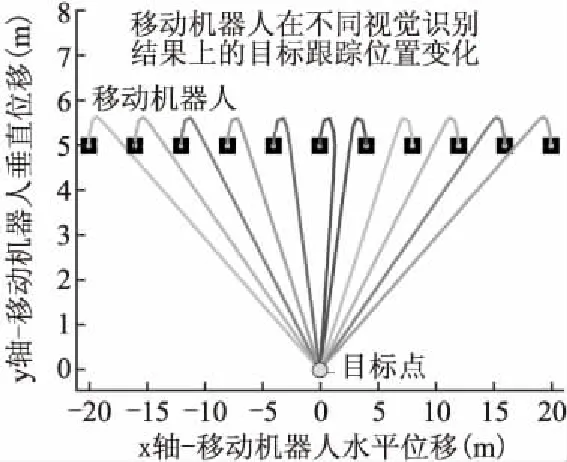

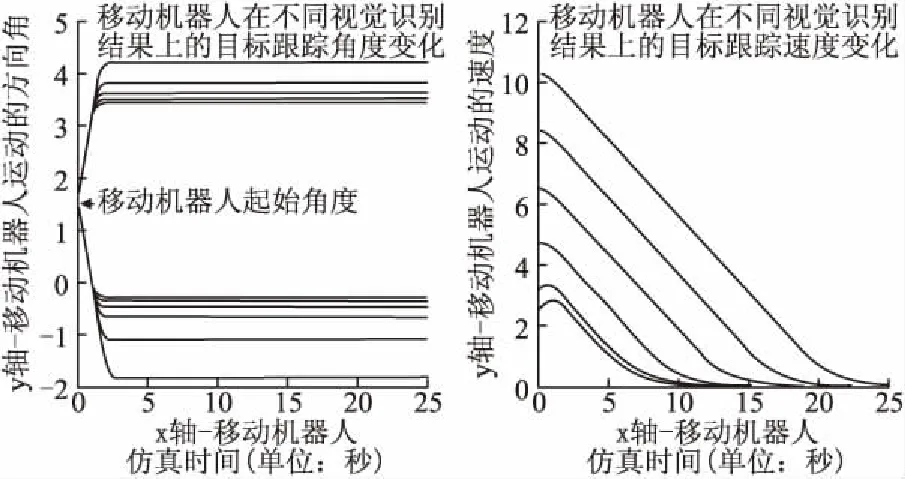

图10-图11,分别表示在不同识别结果基础上,移动机器人轨迹点控制仿真位置、角度、速度图,可以看到移动机器人很好的完成了自主轨迹控制,目标点坐标(0,0)代表了图1中货仓大门处.向实验图像加入0.4的椒盐噪声,统计实验结果,目标准确控制准确率在98%以上.

图10 移动机器人轨迹控制仿真位置变化图Fig.10 Position of trajectory control for robot

图11 移动机器人轨迹控制仿真角度和速度变化图Fig.11 Angle and velocity of robot trajectory control

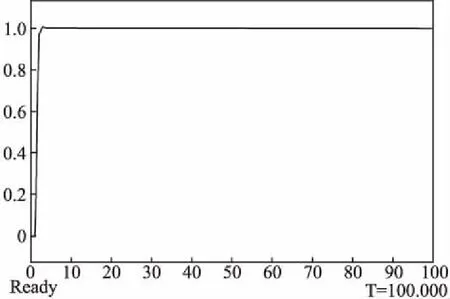

选择预测前景p为10,w和x分别表示为1和2,其余参数为MATLAB MPC预测控制器的默认参数,可以得到在阶跃输入情况下的机器人轨迹跟踪仿真图,如图12所示.可以看到该系统响应曲线具有较小的超调,较短的系统上升时间,并在较短的时间内使得机器人实际轨迹与理想轨迹控制在较小的误差内.

图12 移动机器人轨迹跟踪仿真速度变化图Fig.12 Schematic diagram of robot trajectory control

5 结 论

通过融合概率神经网络的分类模型和移动物流机器人轨迹控制模型,本文较好的实现了移动机器人基于图像识别结果的路径控制.为解决基于视觉的移动机器人轨迹自主控制的稳定问题提供了理论依据和应用基础.